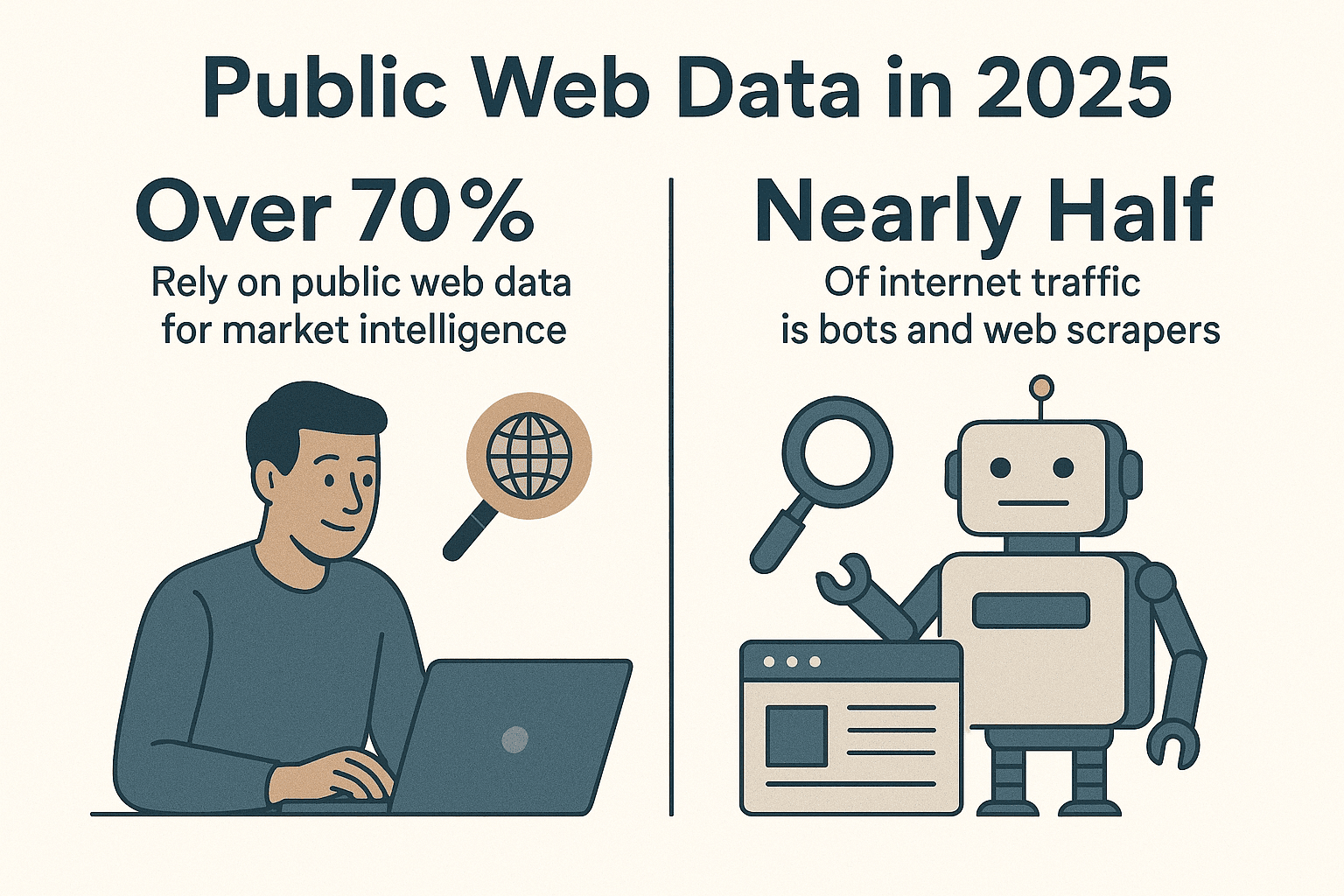

La web está llena de datos y las empresas están en una carrera constante por convertir ese desorden en información valiosa. De hecho, más del , y casi la mitad del tráfico en internet viene de bots y raspadores web, no de personas (). Después de años creando herramientas de automatización (y sí, algunos spiders que han recorrido más páginas que yo), te lo digo claro: si todavía no usas un spider web en Python para automatizar la recolección de datos, te estás perdiendo una oportunidad enorme de ser más eficiente.

Python se ha vuelto el lenguaje favorito para el web scraping, y no es casualidad. Ya sea que trabajes en ventas, marketing, operaciones o investigación, un spider web bien hecho en Python puede ahorrarte horas de trabajo y darte acceso a información que de otra forma sería imposible conseguir. En esta guía te voy a mostrar cómo crear un spider web eficiente en Python desde cero, te comparto mis librerías favoritas y mejores trucos, y te enseño cómo herramientas como pueden llevar tu flujo de trabajo al siguiente nivel—sobre todo cuando te enfrentas a sitios dinámicos que pueden volver loco hasta al programador más curtido.

Python se ha vuelto el lenguaje favorito para el web scraping, y no es casualidad. Ya sea que trabajes en ventas, marketing, operaciones o investigación, un spider web bien hecho en Python puede ahorrarte horas de trabajo y darte acceso a información que de otra forma sería imposible conseguir. En esta guía te voy a mostrar cómo crear un spider web eficiente en Python desde cero, te comparto mis librerías favoritas y mejores trucos, y te enseño cómo herramientas como pueden llevar tu flujo de trabajo al siguiente nivel—sobre todo cuando te enfrentas a sitios dinámicos que pueden volver loco hasta al programador más curtido.

¿Por qué elegir Python para crear un spider web?

Vamos directo al grano: Python manda en el mundo del web scraping. Según los últimos datos, casi , superando por mucho a JavaScript y otros lenguajes. En 2024, Python incluso superó a JavaScript como el lenguaje más popular en GitHub (), gracias sobre todo a su liderazgo en ciencia de datos y automatización.

¿Por qué Python es tan bueno para spiders web?

- Legibilidad y simpleza: Su sintaxis es clara y fácil de entender, perfecta tanto para quienes están empezando como para los que quieren avanzar rápido.

- Ecosistema gigante de librerías: Herramientas como , , , y cubren desde descargar páginas hasta analizar HTML y automatizar navegadores.

- Comunidad activa: Si te atoras, hay una comunidad enorme lista para ayudarte, además de miles de tutoriales y ejemplos para cualquier reto de scraping.

- Flexibilidad: Puedes arrancar con un script sencillo para una tarea puntual y escalar hasta spiders industriales que rastrean miles de páginas.

Comparado con otros lenguajes, Python logra el balance perfecto entre potencia y facilidad de uso. JavaScript (Node.js) es buenísimo para contenido dinámico, pero su modelo asíncrono puede ser complicado para quienes recién empiezan. Java y C# son robustos pero suelen ser más verbosos. Python te deja enfocarte en lo que importa: los datos.

Configurando tu entorno para spiders web en Python

Antes de empezar a tejer tu red, necesitas un entorno bien montado. Así preparo cada nuevo proyecto:

1. Instala Python 3

Descarga la última versión de Python 3.x desde o usa el gestor de paquetes de tu sistema. Asegúrate de que python o python3 funcione en tu terminal.

2. Crea un entorno virtual

Aísla las dependencias de tu proyecto con un entorno virtual:

1python3 -m venv .venv

2# En Unix/Mac

3source .venv/bin/activate

4# En Windows

5.venv\Scripts\activateAsí mantienes tus paquetes ordenados y evitas líos.

3. Instala las librerías clave

Con el entorno virtual activo, instala las librerías esenciales:

1pip install requests beautifulsoup4 lxml scrapy selenium pandas sqlalchemy¿Para qué sirve cada una?

- Requests: Descarga páginas web por HTTP.

- BeautifulSoup: Analiza y navega el HTML.

- lxml: Análisis rápido de HTML/XML (usado por BeautifulSoup para más velocidad).

- Scrapy: Framework completo para crawling a gran escala.

- Selenium: Automatiza navegadores para sitios con mucho JavaScript.

- pandas: Limpia y manipula datos.

- SQLAlchemy: Guarda datos en bases de datos.

¡Ya puedes crear desde scripts rápidos hasta una flota de spiders!

Eligiendo la mejor librería de spider web en Python

Python te da un abanico de herramientas para scraping. Así decido cuál usar:

| Librería/Herramienta | Facilidad de uso | Velocidad y escalabilidad | Ideal para |

|---|---|---|---|

| Requests + BeautifulSoup | Muy fácil | Moderada (una página a la vez) | Principiantes, páginas estáticas, tareas rápidas |

| Scrapy | Curva de aprendizaje más alta | Muy rápida (asíncrona, concurrente) | Crawling a gran escala, scraping de sitios completos |

| Selenium/Playwright | Moderada | Más lenta (por el navegador) | Sitios con mucho JS, páginas tras login |

| aiohttp + asyncio | Moderada (asíncrona) | Muy rápida (muchas URLs a la vez) | Scraping estático de alto volumen |

| Thunderbit (No-Code) | La más fácil (con IA) | Rápida (en la nube/local) | No programadores, sitios dinámicos, resultados rápidos |

Mi regla de oro:

- Para unas pocas páginas estáticas, Requests + BeautifulSoup es lo mejor.

- Para cientos o miles de páginas, o si quieres funciones de crawling integradas, Scrapy es tu mejor amigo.

- Si necesitas un navegador real (scroll infinito o login), Selenium o Playwright.

- Si necesitas los datos ya y no quieres programar, es la solución.

Cómo crear un spider web básico en Python: paso a paso

Vamos a armar un spider sencillo para sacar los títulos de las historias de Hacker News. Es mi "hola mundo" del scraping.

1. Descarga la página web

1import requests

2from bs4 import BeautifulSoup

3url = "https://news.ycombinator.com/"

4response = requests.get(url)

5if response.status_code == 200:

6 html_content = response.content2. Analiza el HTML

1soup = BeautifulSoup(html_content, "html.parser")3. Extrae los datos

1articles = soup.find_all("tr", class_="athing")

2for article in articles:

3 title_elem = article.find("span", class_="titleline")

4 title = title_elem.get_text()

5 link = title_elem.find("a")["href"]

6 print(title, "->", link)4. Maneja la paginación

Hacker News tiene un enlace “More” al final. Así puedes seguirlo:

1import time

2page_url = url

3while page_url:

4 resp = requests.get(page_url)

5 soup = BeautifulSoup(resp.text, 'html.parser')

6 # (extrae los artículos como antes)

7 next_link = soup.find("a", class_="morelink")

8 if next_link:

9 page_url = requests.compat.urljoin(resp.url, next_link["href"])

10 time.sleep(1) # ¡Sé buena onda!

11 else:

12 page_url = None5. Manejo de errores y buenas prácticas

- Siempre revisa

response.status_code. - Usa

time.sleep()para no saturar el servidor. - Configura un User-Agent personalizado:

1headers = {"User-Agent": "MyWebSpider/0.1 (+your_email@example.com)"}

2requests.get(url, headers=headers)Este spider básico se puede adaptar para sacar datos de casi cualquier sitio estático. Para tareas más complejas, es hora de subir de nivel con Scrapy.

Mejorando tu spider con Scrapy

Cuando tus necesidades de scraping superan los scripts simples, Scrapy es el siguiente paso. Así puedes empezar:

1. Crea un proyecto Scrapy

1scrapy startproject myspider2. Crea un spider

Dentro de myspider/spiders/quotes_spider.py:

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["http://quotes.toscrape.com/"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 'text': quote.css("span.text::text").get(),

9 'author': quote.css("small.author::text").get(),

10 'tags': quote.css("div.tags a.tag::text").getall()

11 }

12 next_page = response.css("li.next a::attr(href)").get()

13 if next_page:

14 yield response.follow(next_page, callback=self.parse)3. Ejecuta el spider

1scrapy crawl quotes -o quotes.jsonScrapy rastreará todas las páginas, gestionará la concurrencia, seguirá enlaces y exportará tus datos en JSON (o CSV, XML, etc.)—todo con muy poco código.

Por qué Scrapy me encanta:

- Soporte integrado para concurrencia, límites de velocidad y crawling responsable

- Manejo automático de robots.txt

- Exportación de datos y pipelines para limpiar o guardar información

- Escala desde unas pocas páginas hasta millones

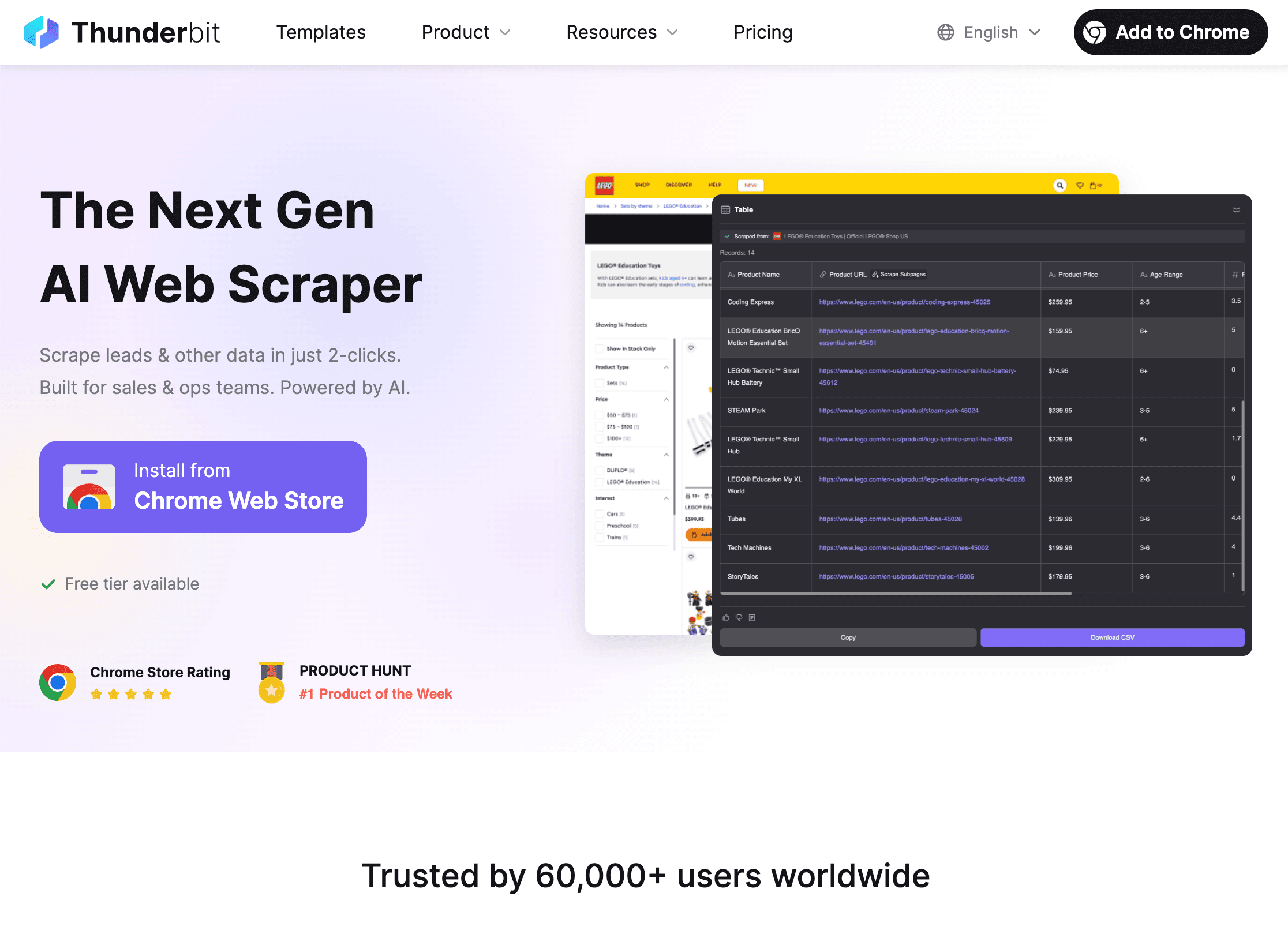

Cómo Thunderbit amplía las capacidades de tu spider web en Python

Ahora hablemos del elefante en la sala: los sitios web dinámicos. Por mucho que me guste Python, hay páginas que son un dolor de cabeza—JavaScript por todos lados, medidas anti-bots o diseños que cambian cada semana. Ahí es donde entra .

¿Qué hace especial a Thunderbit?

- Sugerencia de campos con IA: Abre la , haz clic en “AI Suggest Fields” y la IA de Thunderbit te recomienda automáticamente qué datos extraer—sin tener que inspeccionar HTML ni escribir selectores.

- Extracción en subpáginas: Thunderbit puede seguir enlaces a páginas de detalle (como productos o perfiles) y juntar esos datos en tu tabla principal.

- Manejo de contenido dinámico: Al ejecutarse en un navegador real, Thunderbit puede extraer datos de sitios con mucho JavaScript, scroll infinito e incluso rellenar formularios con AI Autofill.

- Sin código, lenguaje natural: Solo describe lo que necesitas (“Extrae todos los títulos de empleo y ubicaciones de esta página”) y Thunderbit hace el resto.

- Exportación instantánea: Exporta tus datos a CSV, Excel, Google Sheets, Airtable o Notion—gratis y sin límites.

- Raspado programado: Programa tareas recurrentes (“cada día a las 9am”) y deja que Thunderbit te entregue los datos frescos automáticamente.

Cómo Thunderbit complementa a Python

Mi flujo de trabajo favorito es:

- Usa Thunderbit para extraer datos de sitios complejos o dinámicos—sobre todo cuando necesitas resultados rápidos o no quieres mantener código frágil.

- Exporta los datos como CSV o Excel.

- Cárgalos en Python con pandas para limpiar, analizar o automatizar más procesos.

Así tienes lo mejor de los dos mundos: Thunderbit se encarga de la extracción complicada y Python del procesamiento avanzado.

¿Cuándo usar Thunderbit o un spider web en Python?

- Thunderbit: Perfecto para quienes no programan, sitios dinámicos, tareas puntuales o cuando quieres que usuarios de negocio obtengan datos por sí mismos.

- Python: Ideal para lógica personalizada, crawling a gran escala o programado, o cuando necesitas integración profunda con otros sistemas.

- Ambos: Usa Thunderbit para extraer y Python para analizar y automatizar. Yo lo llamo la combinación “mantequilla de maní y mermelada”—buenos por separado, mejores juntos.

Para más sobre flujos de trabajo híbridos, revisa .

Legalidad y buenas prácticas al hacer scraping

El web scraping es poderoso, pero conlleva responsabilidad (y, a veces, correos de admins molestos). Así te mantienes dentro de la ley y la ética:

1. Respeta robots.txt

La mayoría de los sitios publican un archivo robots.txt indicando qué se puede rastrear. Puedes revisarlo en Python:

1import urllib.robotparser

2rp = urllib.robotparser.RobotFileParser()

3rp.set_url("http://www.example.com/robots.txt")

4rp.read()

5if not rp.can_fetch("*", "http://www.example.com/target-page"):

6 print("Scraping no permitido por robots.txt")Scrapy respeta robots.txt por defecto (ROBOTSTXT_OBEY=True).

2. Sé considerado

- Usa pausas (

time.sleep()oDOWNLOAD_DELAYde Scrapy) para no sobrecargar los servidores. - Configura un User-Agent descriptivo con información de contacto.

- No extraigas datos personales o protegidos.

- Si un sitio te bloquea o pide que pares, respeta su decisión.

3. Maneja límites y CAPTCHAs

- Si recibes errores 429 (“Demasiadas solicitudes”), baja la velocidad o usa rotación de proxies.

- No intentes forzar CAPTCHAs—si aparecen, es momento de parar.

Para más sobre ética y cumplimiento, revisa .

Organización y almacenamiento de datos con Python

Una vez que tienes los datos, toca limpiarlos, transformarlos y guardarlos para analizarlos. Así lo hago yo:

1. Limpia y transforma con pandas

1import pandas as pd

2df = pd.DataFrame(scraped_data)

3df['price'] = df['price'].str.replace('£', '').astype(float)

4df = df.dropna()2. Exporta a CSV o Excel

1df.to_csv('output.csv', index=False)

2df.to_excel('output.xlsx', index=False)3. Guarda en una base de datos con SQLAlchemy

1from sqlalchemy import create_engine

2engine = create_engine('sqlite:///scraped_data.db')

3df.to_sql(name='products', con=engine, if_exists='replace', index=False)Así puedes montar un pipeline completo de datos—del spider al dashboard.

Automatiza tus pipelines de datos

Para tareas recurrentes, automatiza todo:

- Cron jobs: Programa tus scripts de Python para que se ejecuten a diario, cada hora, etc.

- Apache Airflow: Para flujos complejos, Airflow puede orquestar scraping, limpieza y reportes.

- Programación en Thunderbit: Deja que Thunderbit haga el scraping en horario y luego activa tu script de Python para procesar los datos nuevos.

Para más detalles, revisa .

Solución de problemas y optimización de tu spider web en Python

Hasta los mejores spiders se topan con obstáculos. Aquí mi lista rápida para los problemas más comunes:

- Solicitudes bloqueadas (403/429): Cambia el User-Agent, baja la velocidad o usa proxies. Revisa robots.txt.

- Datos faltantes: Checa tus selectores. El HTML puede haber cambiado.

- Contenido dinámico: Usa Selenium o Thunderbit para sitios con mucho JavaScript.

- Rendimiento: Usa async (aiohttp) o la concurrencia de Scrapy para más velocidad. Escribe los datos por partes para evitar problemas de memoria.

- Depuración: Imprime logs, usa las herramientas de desarrollo del navegador y revisa siempre tus resultados.

Para más consejos, revisa .

Conclusión y puntos clave

Crear un spider web eficiente en Python es un proceso que vale la pena—ahorrarás tiempo y conseguirás mejores datos. Resumamos:

- Python es la mejor opción para spiders web, por su simpleza, librerías y comunidad.

- Configura tu entorno con virtualenv y las librerías adecuadas (Requests, BeautifulSoup, Scrapy, Selenium, pandas, SQLAlchemy).

- Elige la herramienta adecuada para cada tarea—scripts simples para trabajos pequeños, Scrapy para escalar, Selenium para sitios dinámicos, Thunderbit para scraping sin código y con IA.

- Crea spiders limpios y responsables que respeten robots.txt y las reglas de los sitios.

- Almacena y procesa los datos con pandas y SQLAlchemy, y automatiza tu pipeline para tareas recurrentes.

- Combina Python y Thunderbit para máxima flexibilidad—deja que la IA se encargue de la extracción complicada y usa Python para analizar y automatizar.

¿Listo para llevar tu scraping al siguiente nivel? y descubre lo fácil que es extraer datos incluso de los sitios más complejos. Y si quieres profundizar, visita el para más guías, consejos y ejemplos reales.

¡Feliz scraping! Que tus spiders siempre traigan los datos que buscas (y nunca se queden atascados en un CAPTCHA).

Preguntas frecuentes

1. ¿Por qué Python es el mejor lenguaje para crear spiders web?

Por su sintaxis sencilla, su enorme ecosistema de librerías (Requests, BeautifulSoup, Scrapy) y una comunidad activa, Python facilita crear, escalar y mantener spiders web. Es fácil para principiantes pero lo suficientemente potente para proyectos profesionales a gran escala.

2. ¿Cuándo debería usar Thunderbit en vez de programar mi propio spider en Python?

Thunderbit es ideal para quienes no programan, sitios dinámicos o con mucho JavaScript, o cuando necesitas datos rápido sin escribir ni mantener código. Para proyectos muy personalizados, a gran escala o con integración profunda, los spiders en Python siguen siendo la mejor opción. Muchos equipos usan ambos: Thunderbit para extraer, Python para analizar.

3. ¿Cómo aseguro que mi spider web sea legal y ético?

Revisa y respeta siempre el robots.txt del sitio, usa crawling responsable (pausas, user-agent) y evita extraer datos personales o protegidos. Si un sitio te pide que pares, hazlo. Más información en .

4. ¿Cuál es la mejor forma de almacenar y procesar los datos extraídos?

Usa pandas para limpiar y transformar los datos, exporta a CSV/Excel para compartir y SQLAlchemy para guardar en bases de datos (como SQLite o PostgreSQL) si manejas grandes volúmenes o tareas recurrentes.

5. ¿Cómo puedo automatizar mi pipeline de web scraping?

Utiliza cron jobs o Apache Airflow para programar tus scripts de Python. Thunderbit también permite scraping programado, que puedes combinar con Python para un pipeline de datos totalmente automatizado.

¿Quieres más consejos prácticos de scraping? Revisa y suscríbete al para tutoriales y demostraciones.