La web en 2025 es como el lejano oeste digital: la mitad del tráfico ya no viene de personas. Así es, los bots ya representan casi , y los sistemas anti-bots están más afilados que nunca. Después de años creando herramientas de automatización y flujos de scraping, te puedo decir que un simple error—como elegir mal el user agent—puede tirar por la borda todo tu proyecto de datos. Para equipos de ventas, ecommerce y operaciones, que te bloquee una web no es solo un fastidio: puede ser la diferencia entre cerrar un trato, tener precios actualizados o perder ingresos.

Pero aquí va la buena: no necesitas ser un crack técnico para saltar estos obstáculos. En esta guía te cuento por qué la estrategia de user agent es clave para el scraping, cómo esquivar los errores más comunes y cómo hace que la gestión de user agents sea tan fácil que ni te enteras. Ya sea que busques leads, monitorees productos o solo quieras tener tus hojas de cálculo al día, aquí tienes el manual para ir siempre un paso adelante.

Por qué elegir el mejor User Agent para scraping es fundamental

Vamos a lo básico: ¿qué es un user agent? Es como la “cédula” de tu navegador. Cada vez que visitas una web—seas persona o bot—tu navegador manda una cadena User-Agent en las cabeceras de la petición. Es una mini presentación que dice: “Hola, soy Chrome en Windows” o “Soy Safari en iPhone” (). Así se ve un user agent típico de Chrome:

1Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36Las webs usan esta info principalmente para dos cosas:

- Mostrar el contenido correcto (por ejemplo, versión móvil o de escritorio).

- Detectar bots y raspadores web.

Si tu user agent dice “python-requests/2.28.1” o “Scrapy/2.9.0”, es como llevar un letrero que dice “¡Hola, soy un bot!”. Muchas webs tienen listas negras de estos identificadores y te bloquean antes de que puedas decir “403 Forbidden”. En cambio, usar un user agent de navegador real y actualizado te ayuda a pasar desapercibido.

En resumen: tu user agent es tu disfraz. Cuanto mejor sea, más fácil será conseguir los datos que buscas.

El papel del User Agent en el éxito del scraping web

¿Por qué la elección del user agent pesa tanto? Porque es la primera barrera de defensa de la mayoría de sistemas anti-bots. Esto es lo que puede salir mal si te equivocas:

- Bloqueos inmediatos (errores 403/429): Si usas el user agent por defecto de una librería de scraping, te bloquean antes de ver la página de inicio ().

- Datos vacíos o falsos: Algunas webs muestran páginas en blanco o de relleno a user agents sospechosos.

- CAPTCHAs o redirecciones: Un user agent de bot activa desafíos de “¿Eres humano?” o bucles de inicio de sesión.

- Limitaciones y baneos: Si usas el mismo user agent una y otra vez, puedes ser limitado o baneado por IP.

Así se comportan distintos user agents:

This paragraph contains content that cannot be parsed and has been skipped.

La moraleja: elige bien tu disfraz. Y ojo: los sistemas anti-bots modernos no solo miran el user agent. También revisan si el resto de cabeceras (como Accept-Language o Referer) son coherentes. Si dices ser Chrome pero tus cabeceras no cuadran, igual te pillan ().

Aquí es donde Thunderbit marca la diferencia. He hablado con muchos usuarios de negocio—comerciales, responsables de ecommerce, agentes inmobiliarios—que solo quieren los datos, no un curso de cabeceras HTTP. Por eso creamos Thunderbit: para que la gestión del user agent sea invisible y automática.

Thunderbit: gestión de User Agent simplificada para todos

Con el , no tienes que preocuparte por elegir el user agent. Nuestra IA lo hace por ti, seleccionando la firma de navegador más realista y actualizada para cada web. Ya uses la (que utiliza el user agent real de Chrome) o scraping en la nube (donde nuestra IA rota entre varios user agents actuales), siempre te camuflas entre el tráfico normal.

Y no es solo el user agent. Thunderbit manda un set completo y coherente de cabeceras—Accept-Language, Accept-Encoding, Client Hints, etc.—para que tus peticiones se vean y se comporten como un navegador real. Sin cabeceras raras, sin alertas de “bot”.

¿Lo mejor? No tienes que configurar nada. La IA de Thunderbit se encarga de todo lo técnico en segundo plano, para que tú solo te concentres en obtener datos fiables y de calidad.

Por qué la rotación dinámica de User Agent es imprescindible

Supón que encuentras el user agent perfecto. ¿Deberías usarlo siempre? Error. En 2025, repetir el mismo user agent es una señal clarísima de automatización. Los usuarios reales tienen distintos navegadores, versiones y dispositivos. Si tu raspador web accede 500 veces seguidas con el mismo user agent, es como mandar un ejército de clones—nadie se lo cree.

Por eso, rotar dinámicamente los user agents es la norma. La idea es simple: alternar entre una lista de user agents realistas y actualizados en cada petición o sesión. Así tu raspador web parece un grupo diverso de visitantes reales, no un solo script ().

La rotación inteligente de Thunderbit va más allá. Para rastreos de varias páginas o tareas programadas, Thunderbit rota automáticamente los user agents y los combina con diferentes IPs proxy. Si una web se pone quisquillosa, Thunderbit se adapta en tiempo real—cambia user agent, ajusta cabeceras o ralentiza las peticiones según haga falta. Todo esto ocurre en segundo plano, para que tu scraping pase desapercibido y los datos sigan llegando.

User Agent y cabeceras: la importancia de la coherencia

Un tip de experto: el user agent es solo una parte de la “huella digital” de tu petición. Los sistemas anti-bots modernos comprueban si tu user agent coincide con otras cabeceras como Accept-Language, Accept-Encoding y Referer. Si dices ser Chrome en Windows pero mandas Accept-Language en francés desde una IP de Seúl, saltan las alarmas ().

Buenas prácticas:

- Manda siempre un set completo de cabeceras coherentes con tu user agent.

- Mantén Accept-Language y Accept-Encoding acordes a tu user agent y, si puedes, a la geolocalización de tu IP.

- Usa las herramientas de desarrollador del navegador para inspeccionar peticiones reales y copiar el set completo de cabeceras para tu user agent elegido.

Thunderbit se encarga de todo esto por ti. Nuestra IA garantiza que cada petición sea coherente—user agent, cabeceras e incluso la huella digital del navegador. Así obtienes un perfil de petición humano sin esfuerzo.

Errores comunes: qué NO hacer con los User Agents

He visto muchos proyectos de scraping fracasar por los mismos motivos. Estos son los errores más habituales:

- Usar user agents por defecto de librerías de scraping: Cadenas como

python-requests/2.x,Scrapy/2.9.0oJava/1.8son bloqueadas al instante. - Versiones de navegador desactualizadas: Decir que eres Chrome 85 en 2025 es sospechoso. Usa siempre versiones actuales.

- Cabeceras incoherentes: No mandes un user agent de Chrome con cabeceras incompletas o que no cuadran.

- User agents de bots conocidos: Cualquier cosa que incluya “bot”, “crawler”, “spider” o nombres de herramientas (como AhrefsBot) es una alerta.

- User agents vacíos o sin sentido: A veces pasan, pero suelen levantar sospechas y no son fiables.

Lista rápida para user agents seguros:

- Usa user agents reales y actualizados de navegadores (Chrome, Firefox, Safari).

- Rota entre varios user agents.

- Mantén las cabeceras coherentes con tu user agent.

- Actualiza tu lista de user agents cada mes (los navegadores se actualizan rápido).

- Evita cualquier cosa que grite “automatización”.

Thunderbit en acción: casos reales para ventas y operaciones

Vamos a lo práctico. Así ayuda la gestión de user agents de Thunderbit a equipos reales:

| Caso de uso | Antes: scraping manual | Con Thunderbit | Resultado |

|---|---|---|---|

| Generación de leads | Bloqueos frecuentes, datos incompletos | IA elige el mejor user agent, rota y simula navegación real | Más leads, mayor calidad, menos rebotes |

| Monitorización ecommerce | Scripts fallan, baneos de IP | Scraping en la nube con rotación dinámica de user agent y proxy | Seguimiento fiable de precios/stock |

| Listados inmobiliarios | Ajustes tediosos, bloqueos | IA adapta user agent/cabeceras y gestiona subpáginas automáticamente | Listados completos y actualizados |

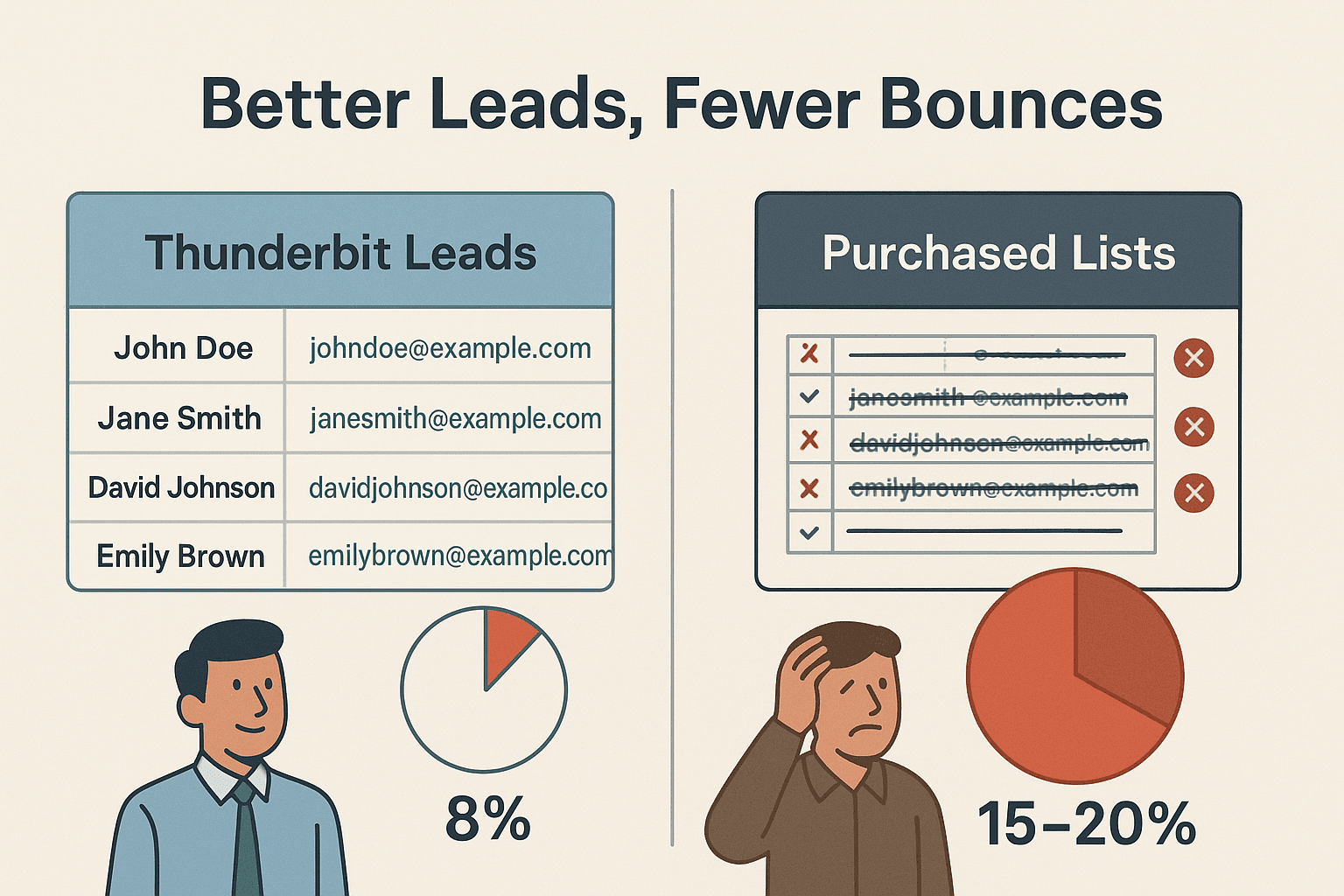

Un equipo de ventas que usó Thunderbit para extraer leads de miles de webs logró solo un ~8% de rebote de emails—frente al 15–20% de listas compradas (). Así de potente es el scraping fresco y con apariencia humana.

Paso a paso: cómo hacer scraping con el mejor User Agent usando Thunderbit

Así de fácil es empezar con Thunderbit—sin ser un genio técnico:

- Instala la .

- Entra a la web que te interesa. Inicia sesión si hace falta—Thunderbit funciona también en páginas privadas.

- Haz clic en “AI Suggest Fields”. La IA de Thunderbit analiza la página y sugiere las mejores columnas para extraer.

- Revisa y ajusta los campos si quieres. Renombra, añade o elimina columnas según lo que necesites.

- Haz clic en “Scrape”. Thunderbit extrae los datos, rotando user agents y cabeceras automáticamente.

- Exporta tus datos. Llévalos directo a Excel, Google Sheets, Airtable, Notion o descárgalos en CSV/JSON.

No tienes que elegir ni actualizar user agents—la IA de Thunderbit lo hace todo, adaptándose a cada web para maximizar el éxito.

Comparativa: Thunderbit vs. gestión manual de User Agents

Veamos cómo se compara Thunderbit con el enfoque manual de toda la vida:

| Función/Tarea | Scraping manual | Con Thunderbit |

|---|---|---|

| Configuración de User Agent | Investigar y programar | Automático, IA selecciona por web |

| Mantener UAs actualizados | Manual, fácil de olvidar | IA los actualiza según tendencias de navegadores |

| Rotación de UA | Programar lógica propia | Rotación inteligente integrada |

| Coherencia de cabeceras | Ajustar manualmente | IA garantiza set completo y coherente |

| Manejo de bloqueos/CAPTCHAs | Cambios manuales, mucho mantenimiento | IA adapta, reintenta y rota según sea necesario |

| Habilidad técnica necesaria | Alta (código, HTTP) | Ninguna—pensado para usuarios de negocio |

| Tiempo resolviendo problemas | Frecuente, frustrante | Mínimo—enfócate en los datos, no en el scraping |

Thunderbit está pensado para quienes buscan scraping fiable y escalable—sin complicaciones técnicas.

Conclusiones: cómo crear una estrategia de User Agent a prueba de futuro

Esto es lo que he aprendido (a veces a las malas) sobre la gestión de user agents en 2025:

- Nunca uses user agents por defecto o desactualizados. Son la causa #1 de bloqueos.

- Rota los user agents dinámicamente. La variedad es clave—no dejes que tu raspador web parezca un robot en serie.

- Mantén cabeceras coherentes y realistas. Tu user agent solo es creíble si el resto de la petición lo acompaña.

- Mantente actualizado. Los navegadores cambian rápido; tu lista de user agents también debe hacerlo.

- Deja que la IA se encargue de lo difícil. Herramientas como Thunderbit integran las mejores prácticas, para que tú te concentres en los resultados.

Si ya te cansaste de bloqueos, de ajustar scripts o simplemente quieres scrapear como un pro sin líos, . Nuestro AI Web Scraper lo usan miles de personas en todo el mundo y está pensado para que el acceso a datos web sea fácil para todos—sin dolores de cabeza técnicos.

Para más consejos, tutoriales y guías sobre scraping, pásate por el .

Preguntas frecuentes

1. ¿Qué es un user agent y por qué es importante para el scraping web?

Un user agent es una cadena que se manda con cada petición web e identifica tu navegador y sistema operativo. Las webs lo usan para mostrar el contenido correcto y detectar bots. Usar el user agent adecuado ayuda a que tu raspador web pase desapercibido y evite bloqueos.

2. ¿Por qué no debo usar el user agent por defecto de mi librería de scraping?

Los user agents por defecto como python-requests/2.x son firmas de bot muy conocidas y suelen ser bloqueados al instante. Usa siempre user agents realistas y actualizados de navegadores.

3. ¿Cómo gestiona Thunderbit la rotación de user agents?

La IA de Thunderbit rota automáticamente entre un grupo de user agents de navegadores actuales y realistas en cada petición o sesión. Así tu scraping parece tráfico real y diverso.

4. ¿Tengo que configurar manualmente cabeceras como Accept-Language o Referer en Thunderbit?

¡Para nada! La IA de Thunderbit se encarga de que todas las cabeceras sean coherentes y correspondan a tu user agent, para que tus peticiones se vean y se comporten como un navegador real.

5. ¿Qué pasa si una web empieza a bloquear mis peticiones igualmente?

Thunderbit detecta bloqueos o CAPTCHAs y se adapta en tiempo real—cambia user agent, ajusta cabeceras o reintenta según sea necesario. Así obtienes datos fiables sin tener que resolverlo manualmente.

¿Listo para scrapear de forma más inteligente? y deja que nuestra IA se encargue del juego del gato y el ratón de los user agents por ti. ¡Feliz scraping!

Más información