La web está llena de información, y si trabajas en ventas, marketing u operaciones, sabes que tener los datos correctos en el momento justo puede marcar la diferencia. Pero, seamos realistas: nadie quiere pasarse el día copiando y pegando filas de páginas web a hojas de cálculo. He visto equipos perder decenas de horas cada mes solo “sacando datos”, para acabar con listas desactualizadas y llenas de errores. ¿La buena noticia? Las herramientas modernas de screen scraping han cambiado el juego, permitiendo que cualquiera —no solo los desarrolladores— pueda recopilar, organizar y aprovechar datos web en minutos, no días.

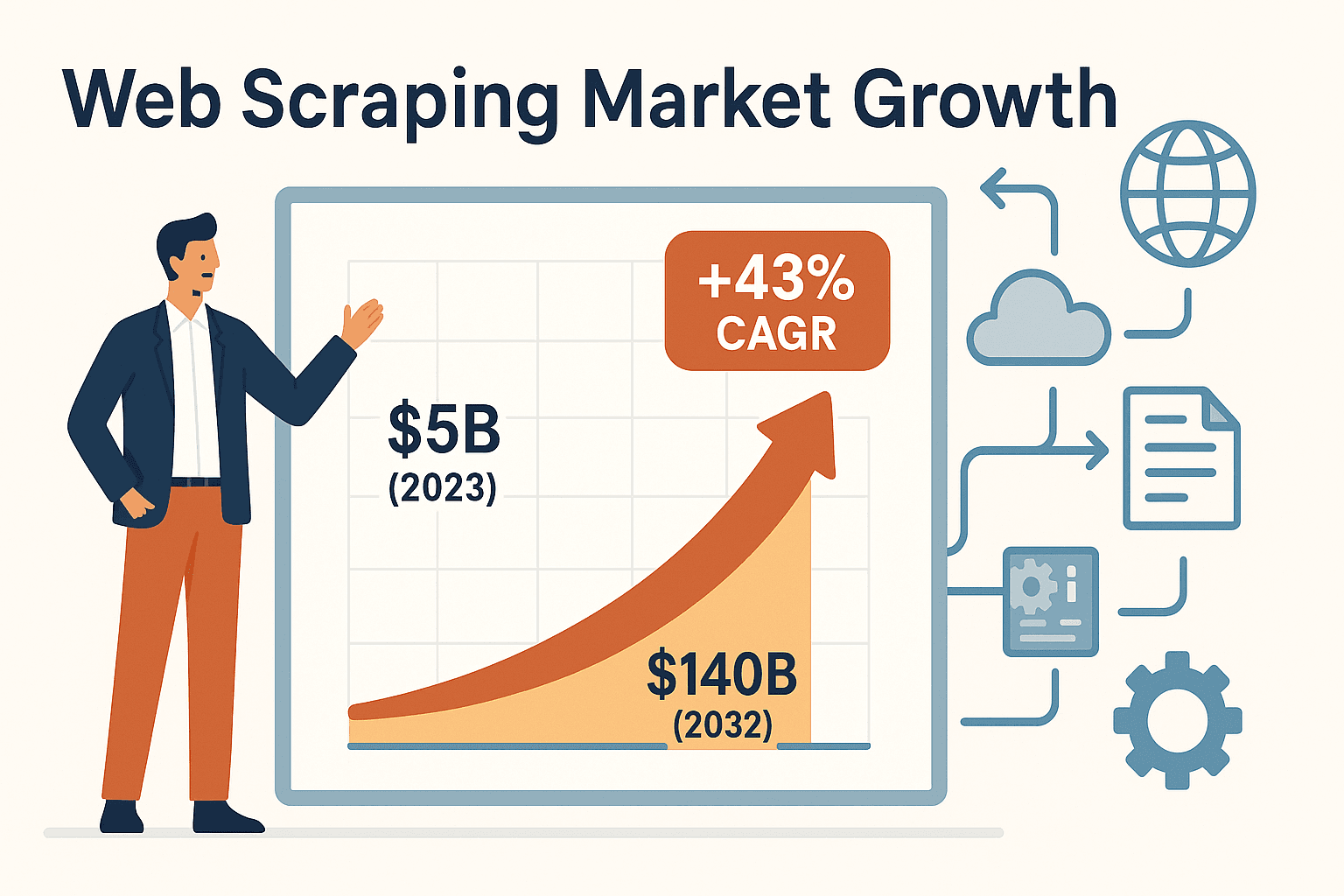

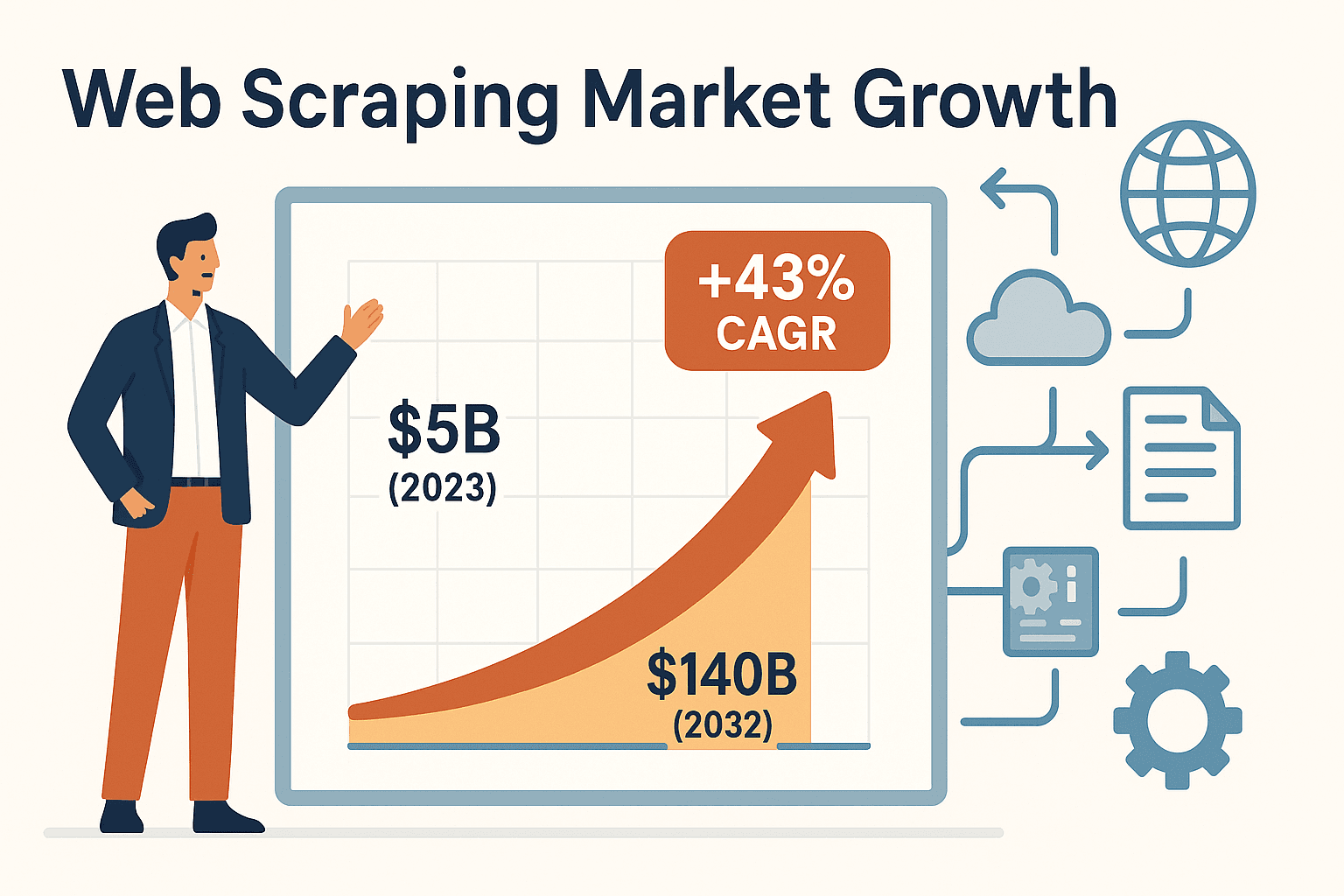

La demanda de herramientas de screen scraping está creciendo a un ritmo impresionante. El mercado global de web scraping se valoró en unos , con un crecimiento anual del 43%. ¿Por qué? Porque las empresas han entendido que la automatización ya no es un lujo, sino una necesidad para seguir siendo competitivas. Ya sea que estés armando listas de prospectos, monitoreando a la competencia o siguiendo anuncios inmobiliarios, la herramienta adecuada puede ahorrarte entre un 30% y 40% del tiempo dedicado a tareas de datos y reducir los costes de adquisición hasta en un 40% ().

Vamos a ver las seis mejores herramientas de screen scraping para recopilar datos de manera eficiente en 2025. Te contaré qué hace única a cada una, para quién están pensadas y cómo elegir la que mejor encaje con tu equipo, tanto si eres usuario sin experiencia técnica como si eres desarrollador experimentado.

¿Por qué las herramientas de screen scraping son clave para los negocios?

Si alguna vez intentaste mantener actualizada una lista de leads o seguir los precios de la competencia a mano, sabes lo frustrante que puede ser. Recopilar datos manualmente es lento, tedioso y propenso a errores. Para usuarios de negocio sin perfil técnico —como comerciales, marketers, agentes inmobiliarios o analistas de operaciones—, las herramientas de screen scraping son un salvavidas. Automatizan el trabajo repetitivo de copiar y pegar, transformando horas de esfuerzo en una tarea de un solo clic.

Así están cambiando los flujos de trabajo en las empresas:

- Generación de leads: Extrae al instante cientos de contactos de directorios o redes sociales, para que tu equipo de ventas dedique más tiempo a vender y menos a copiar datos.

- Monitoreo de la competencia: Programa extracciones automáticas de webs de la competencia para obtener listas de precios actualizadas o detectar lanzamientos de nuevos productos. Minoristas como John Lewis lograron un solo usando scraping de precios.

- Recopilación de datos inmobiliarios: Extrae anuncios de propiedades de sitios como Zillow en segundos, manteniendo tu inventario y base de clientes siempre al día.

- Automatización de flujos de trabajo: Exporta los datos extraídos directamente a Excel, Google Sheets, Airtable o Notion, e incluso automatiza el llenado de formularios o procesos en otros programas.

En resumen: las herramientas de screen scraping permiten a los usuarios de negocio acceder y actuar sobre datos web sin depender del equipo de IT. Eso se traduce en decisiones más rápidas, información más actualizada y una ventaja competitiva real.

Cómo elegir la mejor herramienta de screen scraping

Con tantas opciones en el mercado, elegir la herramienta adecuada puede sentirse como comprar un coche nuevo: ¿prefieres algo rápido y llamativo, o fiable y fácil de usar? Aquí tienes una lista rápida para ayudarte a decidir:

- Facilidad de uso: ¿Buscas una herramienta sin código, de apuntar y hacer clic, o te sientes cómodo programando?

- Personalización: ¿Necesitas trabajar con webs complejas, inicios de sesión o contenido dinámico (como scroll infinito)?

- Tipos de datos soportados: ¿Vas a extraer texto, imágenes, PDFs u otro tipo de datos?

- Escalabilidad: ¿Solo necesitas extraer unas pocas páginas o procesar miles cada día?

- Opciones de exportación: ¿Puedes enviar fácilmente los datos a Excel, Google Sheets o tu CRM?

- Precio: ¿Cuál es tu presupuesto? ¿Buscas una opción gratuita o estás dispuesto a invertir en automatización avanzada?

- Soporte y mantenimiento: ¿Prefieres un servicio gestionado o te encargas tú de mantener scripts y resolver problemas?

Ten en cuenta estos criterios mientras revisamos las seis mejores opciones. Recuerda: la mejor herramienta es la que tu equipo realmente va a usar.

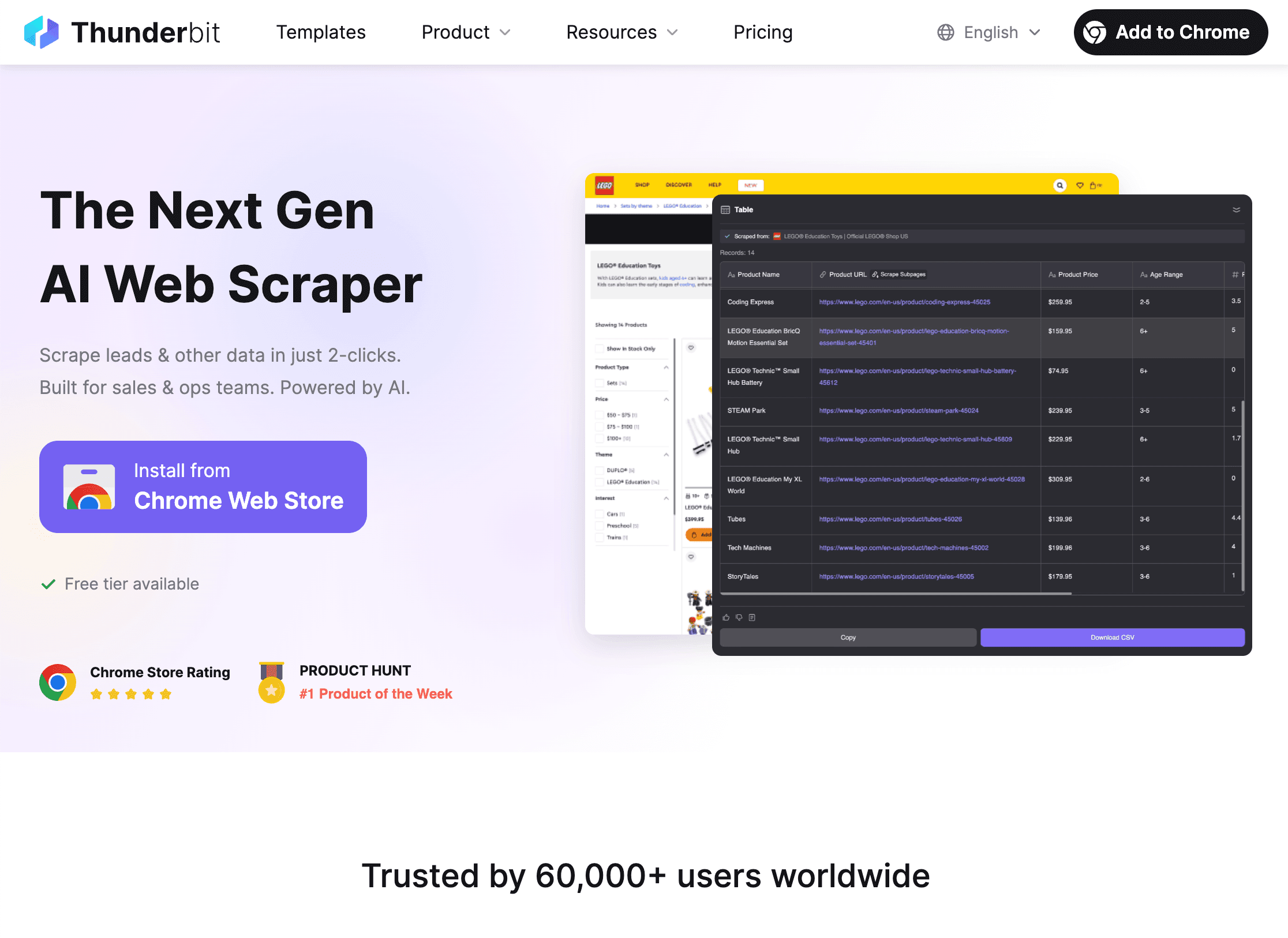

1. Thunderbit

es mi recomendación principal para equipos sin perfil técnico que quieren recopilar datos web de forma rápida, sin programar, sin plantillas y sin complicaciones. Como cofundador y CEO, puede que no sea imparcial, pero creé Thunderbit porque estaba cansado de ver a usuarios de negocio luchar con herramientas pensadas solo para desarrolladores.

¿Qué hace diferente a Thunderbit? Su sencillez y potencia:

- Sugerencia de campos con IA: Solo tienes que hacer clic en “Sugerir campos con IA” y la IA de Thunderbit analiza la página, recomienda las mejores columnas (como nombres, precios, emails) y configura los tipos de datos automáticamente.

- Extracción en dos clics: Entra en cualquier web, haz clic en “Extraer” y Thunderbit hace el resto, sin configuraciones ni selectores.

- Extracción en subpáginas y paginación: ¿Necesitas detalles de subpáginas (como fichas de producto o perfiles de LinkedIn)? Thunderbit visita cada subpágina y completa tu tabla automáticamente. También gestiona la paginación, incluso con scroll infinito.

- Plantillas instantáneas: Para webs populares como Amazon, Zillow o Instagram, Thunderbit ofrece plantillas de un solo clic: solo introduce tu búsqueda y exporta los datos.

- Exportación gratuita: Exporta tus resultados a Excel, Google Sheets, Airtable o Notion, sin coste alguno.

- Funciones avanzadas: Extrae datos de PDFs, imágenes e incluso automatiza el llenado de formularios con AI Autofill (también gratis). Programa extracciones automáticas usando instrucciones en lenguaje natural.

- Precios: Thunderbit funciona con un sistema de créditos: puedes extraer hasta 6 páginas gratis (o 10 con el impulso de prueba). Los planes de pago empiezan en solo $15/mes (o $9/mes con pago anual) para 500 filas, accesible para equipos de cualquier tamaño.

Thunderbit ya es utilizado por más de , desde equipos de ventas y marketing hasta agentes inmobiliarios y operadores de ecommerce. Lo que más me dicen: “No puedo creer cuánto tiempo ahorro; antes tardaba horas copiando leads de directorios, ahora lo hago en minutos”. Si quieres probarlo, y compruébalo tú mismo.

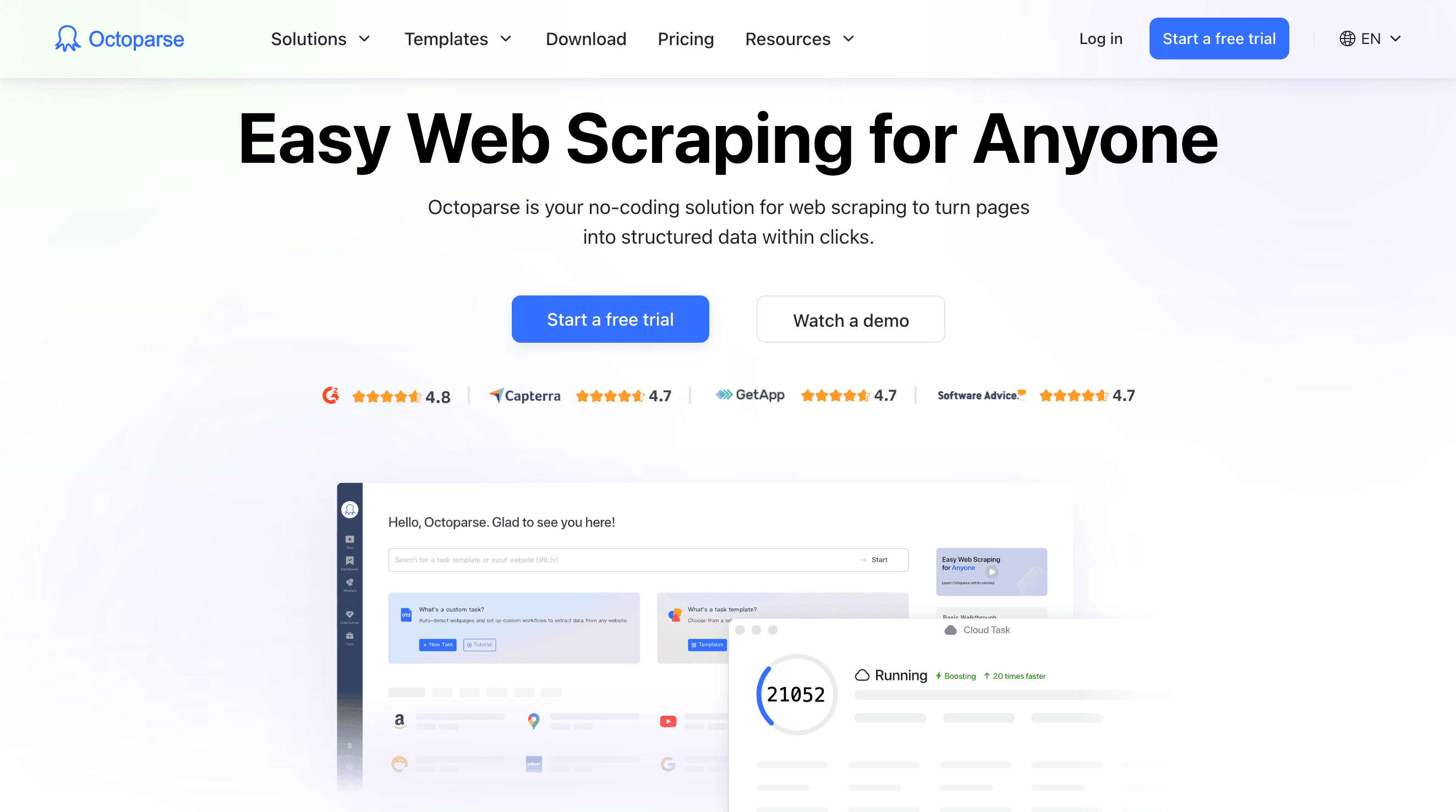

2. Octoparse

es un clásico en el mundo del scraping sin código, con una interfaz visual de arrastrar y soltar para crear flujos de extracción personalizados. Si eres usuario avanzado y necesitas trabajar con webs complejas —inicios de sesión, AJAX, scroll infinito, navegación por pasos— Octoparse te da todas las herramientas, sin necesidad de programar.

Características principales:

- Diseñador visual de flujos: Haz clic en una página de ejemplo y Octoparse detecta elementos similares, ayudándote a construir el flujo de extracción paso a paso.

- Soporta contenido dinámico: Funciona con webs cargadas con JavaScript, scroll infinito y páginas protegidas con login.

- Scraping en la nube: Ejecuta tareas en la nube (sin tener tu ordenador encendido), programa extracciones y procesa grandes volúmenes de datos 24/7.

- Biblioteca de plantillas: Acceso a más de 100 plantillas para sitios populares como Amazon, LinkedIn y Twitter.

- Opciones de exportación: Descarga resultados en CSV, Excel o JSON, o envía los datos directamente a tu base de datos.

- Precios: Plan gratuito con funciones limitadas; los planes de pago empiezan en unos $75/mes para el plan Standard, con opciones superiores para más concurrencia y funciones avanzadas.

Octoparse es ideal para analistas, investigadores y pequeñas empresas que necesitan scraping robusto sin código a escala media. Tiene cierta curva de aprendizaje, sobre todo para flujos avanzados, pero la interfaz visual y la documentación lo hacen accesible para usuarios con perfil técnico que no quieren programar.

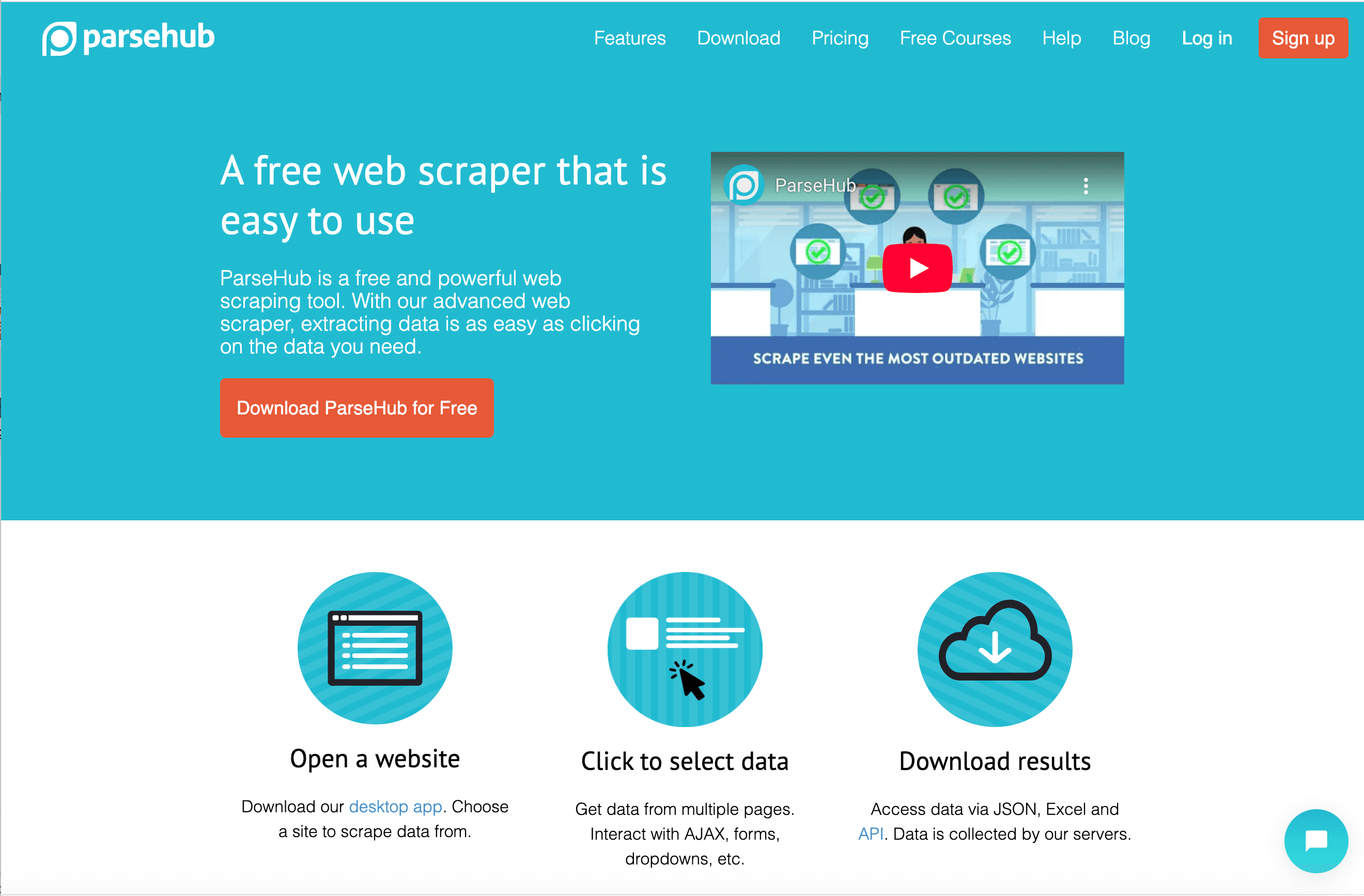

3. ParseHub

es otra herramienta visual de scraping, famosa por su capacidad para trabajar con webs complejas y dinámicas desde una app de escritorio. Si necesitas extraer datos de sitios con mucho JavaScript o elementos interactivos, el enfoque de navegador simulado de ParseHub es ideal.

Lo que destaca de ParseHub:

- Raspador visual de escritorio: Crea proyectos haciendo clic en la web desde el navegador integrado de la app. ParseHub detecta patrones y te permite seleccionar exactamente lo que necesitas.

- Soporta JavaScript y AJAX: Espera a que el contenido cargue, hace clic en botones, rellena formularios y navega por sitios interactivos.

- Integración con API: Lanza proyectos y recupera resultados de forma programática.

- Programación en la nube: Programa tareas para que se ejecuten en la nube (en planes superiores).

- Opciones de exportación: Descarga datos en CSV, Excel o JSON.

- Precios: El plan gratuito permite extraer hasta 200 páginas por ejecución; los planes de pago empiezan en $189/mes para Standard y $599/mes para Professional.

ParseHub es muy popular entre periodistas de datos, investigadores y pequeñas empresas que necesitan extraer datos de sitios dinámicos y prefieren trabajar en escritorio. El onboarding guiado ayuda a los principiantes, aunque el precio puede ser elevado para usuarios intensivos.

4. Scrapy

es la herramienta preferida por desarrolladores y equipos técnicos que buscan control total sobre sus proyectos de scraping. Es un framework open source basado en Python que permite crear rastreadores web personalizados, ideal para trabajos a gran escala, complejos o muy adaptados.

Por qué Scrapy es el favorito de los desarrolladores:

- Flexibilidad total: Escribe código Python para definir spiders, reglas de rastreo y pipelines de datos. Scrapy gestiona la concurrencia, reintentos y exportación de datos.

- Rendimiento: Diseñado para velocidad y escalabilidad: extrae miles o millones de páginas de forma eficiente.

- Extensible: Se integra con proxies, bases de datos, APIs y middleware personalizado.

- Open Source: Gratis; los costes dependen de tu propia infraestructura o servicios en la nube (como Scrapy Cloud de Zyte).

- Comunidad: Gran ecosistema, documentación madura y muchos tutoriales.

Scrapy no es para principiantes: tiene una curva de aprendizaje pronunciada y requiere mantener tu propio código. Pero si tienes desarrolladores en tu equipo y necesitas construir un pipeline de datos robusto y escalable, Scrapy es difícil de superar.

5. Diffbot

apuesta por un enfoque radicalmente distinto: utiliza IA y machine learning para analizar y extraer datos estructurados de cualquier página web de forma automática. En vez de crear raspadores, solo envías una URL a Diffbot (vía API) y te devuelve un JSON limpio y estructurado, sin necesidad de selectores ni configuración.

Lo que hace único a Diffbot:

- Extracción impulsada por IA: APIs preentrenadas para artículos, productos, foros y más. Diffbot “lee” la página como un humano y extrae los campos clave.

- Crawlbot: Rastrea sitios completos o sitemaps automáticamente.

- Knowledge Graph: Accede a la enorme base de datos de Diffbot, con más de 1.200 millones de webs y 246 millones de organizaciones.

- Escalabilidad: Pensado para recopilación de datos a nivel empresarial.

- Precios: Plan gratuito (10.000 créditos/mes); los planes de pago empiezan en $299/mes para 250.000 créditos, con opciones superiores para mayor volumen.

Diffbot es ideal para empresas, científicos de datos y quienes necesitan grandes volúmenes de datos estructurados sin crear ni mantener raspadores. No es tan personalizable como las herramientas basadas en código, pero para extracción masiva y automatizada con IA, no tiene rival.

6. DataMiner

es una extensión de navegador (para Chrome y Edge) que facilita la extracción rápida y puntual de datos. Si eres growth hacker, periodista o usuario de negocio que solo quiere copiar una tabla o lista de una web a Excel, DataMiner es tu mejor aliado.

Por qué los usuarios adoran DataMiner:

- Simplicidad de apuntar y hacer clic: Selecciona elementos en la página para crear una “receta” o usa una de las más de 60.000 recetas públicas para más de 15.000 webs.

- Extracción en un clic: Aplica una receta y exporta los datos al instante a CSV o Excel.

- Paginación y scraping masivo: Gestiona listas de varias páginas e incluso permite procesar lotes de URLs.

- Relleno de formularios: Automatiza el envío de formularios usando datos de un CSV.

- Plan gratuito: Extrae hasta 500 páginas al mes gratis; los planes de pago empiezan en $19,99/mes para 2.500 páginas.

DataMiner es perfecto para tareas puntuales, investigaciones rápidas y para quienes prefieren trabajar directamente en el navegador. No está pensado para grandes volúmenes, pero para proyectos pequeños y medianos es muy práctico.

Tabla comparativa rápida: Herramientas de screen scraping de un vistazo

| Herramienta | Facilidad de uso | Características clave | Ideal para | Modelo de precios | Punto fuerte |

|---|---|---|---|---|---|

| Thunderbit | Muy fácil (sin código) | Sugerencia IA, subpáginas/paginación, plantillas, exportación gratis | Usuarios de negocio sin perfil técnico (ventas, ops, inmobiliaria) | Gratis/Desde $9–$15/mes | Configuración más sencilla, IA, scraping rápido ad hoc |

| Octoparse | Media (sin código) | Flujos visuales, nube, sitios dinámicos, plantillas | Analistas técnicos, investigadores | Gratis/Desde $75/mes | Constructor visual, programación en la nube, lógica avanzada |

| ParseHub | Media (sin código) | App de escritorio, JS/AJAX, API, nube | Sitios dinámicos, principiantes técnicos | Gratis/Desde $189/mes | Maneja sitios complejos, control desde escritorio |

| Scrapy | Difícil (requiere Python) | Open source, escalable, control total, pipelines | Desarrolladores, equipos de ingeniería | Gratis (autoalojado) | Flexibilidad total, scraping personalizado a gran escala |

| Diffbot | Fácil (para devs) | Extracción IA, APIs, Knowledge Graph, crawlbot | Empresas, científicos de datos | Gratis/Desde $299/mes | Extracción IA sin intervención, datos web a gran escala |

| DataMiner | Muy fácil (navegador) | Extensión, 60k+ recetas, un clic, formularios | Tareas puntuales, periodistas, growth hackers | Gratis/Desde $19,99/mes | Más rápido en navegador, enorme biblioteca de plantillas |

¿Qué herramienta de screen scraping es la mejor para ti?

- ¿Buscas resultados instantáneos y sin código? Elige Thunderbit o DataMiner. Thunderbit es ideal para scraping estructurado, multipágina o en subpáginas con ayuda de IA; DataMiner es perfecto para tareas rápidas desde el navegador.

- ¿Prefieres flujos visuales y potencia en la nube? Octoparse es tu opción, sobre todo si trabajas con webs complejas o necesitas programar extracciones periódicas.

- ¿Necesitas extraer datos de sitios dinámicos con mucho JavaScript? ParseHub destaca aquí, especialmente para principiantes técnicos.

- ¿Tienes desarrolladores y buscas control total? Scrapy es el estándar de oro para scraping personalizado y a gran escala.

- ¿Requieres datos estructurados a escala empresarial y con IA? Diffbot ofrece extracción automatizada y acceso a un enorme knowledge graph.

Mi consejo: empieza con una prueba gratuita o el plan básico; la mayoría de estas herramientas te permiten probar antes de decidir. Ajusta la elección a tu nivel técnico, volumen de datos y necesidades de flujo de trabajo, y no dudes en experimentar.

Conclusión: Libera el potencial de los datos con la herramienta de screen scraping adecuada

Las herramientas de screen scraping han pasado de ser un recurso de nicho para desarrolladores a convertirse en aliados imprescindibles para la productividad empresarial. Ya seas comercial buscando leads, responsable de ecommerce monitorizando precios o agente inmobiliario recopilando anuncios, la herramienta adecuada puede convertir la web en tu propia base de datos. La clave está en elegir la que se adapte a las habilidades de tu equipo y a los objetivos de tu negocio, porque la mejor herramienta es la que realmente vas a usar.

¿Listo para dejar de copiar y pegar y empezar a recopilar datos como un profesional? o prueba cualquiera de las otras opciones de esta lista. Y si quieres más consejos, guías y tutoriales, visita el .

Preguntas frecuentes

1. ¿Qué es una herramienta de screen scraping y cómo funciona?

Una herramienta de screen scraping automatiza la extracción de datos de páginas web. En vez de copiar la información manualmente, te permite seleccionar lo que necesitas y exportarlo en formatos estructurados como Excel o CSV. Algunas usan IA o flujos visuales para facilitar la configuración a usuarios sin experiencia técnica.

2. ¿Quién debería usar herramientas de screen scraping?

Cualquier persona que necesite recopilar datos web de forma eficiente: equipos de ventas, marketing, agentes inmobiliarios, investigadores y analistas de operaciones. Ya sea para crear listas de leads, seguir a la competencia o agrupar anuncios, estas herramientas ahorran tiempo y reducen errores.

3. ¿Cuál es la diferencia entre herramientas de scraping sin código y con código?

Las herramientas sin código (como Thunderbit, Octoparse, ParseHub, DataMiner) ofrecen interfaces de apuntar y hacer clic, pensadas para usuarios sin perfil técnico. Las basadas en código (como Scrapy) requieren conocimientos de programación, pero ofrecen más flexibilidad y escalabilidad para proyectos complejos.

4. ¿Es legal usar herramientas de screen scraping?

El screen scraping es legal para datos públicos, pero siempre debes respetar los términos de uso de los sitios web y la legislación de privacidad. Evita extraer datos personales sin consentimiento y no sobrecargues los sitios con demasiadas solicitudes.

5. ¿Cómo elijo la mejor herramienta de screen scraping para mis necesidades?

Ten en cuenta tu nivel técnico, el volumen de datos, la complejidad de los sitios objetivo, las opciones de exportación y tu presupuesto. Empieza con una prueba gratuita, valida tu caso de uso y elige la que te resulte más intuitiva y eficaz.

¿Listo para aprovechar el poder de los datos web? Prueba alguna de estas herramientas y verás cómo aumenta tu productividad.