La web se ha vuelto el mayor terreno de juego de datos del planeta—y, siendo sinceros, todos queremos construir el castillo de arena más grande. Ya sea que trabajes en ventas, e-commerce, investigación, o simplemente seas un fanático de los datos como yo, el 웹 스크래퍼 es ese ingrediente secreto que te ayuda a tomar decisiones más inteligentes y a hacer todo más rápido. Para 2025, no solo las grandes tecnológicas están extrayendo datos; , y dicen que las decisiones basadas en datos son clave para su negocio. ¿El truco? Python es el motor de esta revolución, gracias a su ecosistema gigante de librerías y herramientas para 웹 스크래퍼.

Después de años metido en SaaS y automatización, he visto cómo la herramienta correcta de scraping en Python puede convertir horas de trabajo manual en una tarea de dos minutos. Pero con tantas opciones—librerías clásicas, automatización de navegadores, plataformas sin código y hasta herramientas con IA—¿cómo eliges la mejor? En esta guía te traigo las 12 mejores librerías de Python para automatizar el 웹 스크래퍼, desde opciones fáciles para quienes recién empiezan hasta soluciones avanzadas con IA como . Seas desarrollador, encargado de operaciones o usuario de negocio que solo quiere los datos (sin dolores de cabeza), aquí vas a encontrar la opción ideal.

Por qué es clave elegir bien tu herramienta de scraping en Python

Vamos al grano: no todos los proyectos de scraping son iguales. La herramienta que elijas puede ser la diferencia entre un flujo de trabajo automatizado y una semana entera peleando con errores. He visto agencias de reclutamiento multiplicar sus ventas por 10 en tres meses automatizando la captación de leads—ahorrando 8 horas semanales por comercial y generando miles de nuevos contactos (). Pero también he visto equipos perder días por elegir una librería que no puede con contenido dinámico o que es bloqueada por sistemas anti-bots.

Por eso tu elección importa:

- Impacto en el negocio: La herramienta correcta puede automatizar la generación de leads, el monitoreo de precios, el análisis de la competencia y la automatización de procesos—dándote ventaja en ventas, e-commerce e investigación ().

- Datos estáticos vs. dinámicos: Algunas webs son HTML simple; otras están llenas de JavaScript. Si tu herramienta no puede con contenido dinámico, te vas a perder datos clave.

- Escalabilidad y fiabilidad: ¿Solo necesitas raspar unas pocas páginas? Casi cualquier opción sirve. ¿Miles de páginas al día? Necesitas un framework robusto como Scrapy o una solución en la nube.

Tip de experto: —combinando, por ejemplo, Beautiful Soup para páginas estáticas y Selenium para las dinámicas. La mezcla adecuada es tu mejor aliada.

Cómo evaluamos las mejores librerías de scraping en Python

Con tantas librerías y plataformas, me enfoqué en lo que realmente importa para usuarios técnicos y de negocio:

- Facilidad de uso: ¿La puede usar alguien sin experiencia en código? ¿La API es intuitiva? Las opciones visuales o sin código suman puntos extra.

- Automatización y escalabilidad: ¿Permite rastrear muchas páginas, programar tareas y manejar grandes volúmenes de datos? ¿Funciona en la nube o local?

- Soporte para contenido dinámico: ¿Puede extraer datos de sitios con mucho JavaScript, scroll infinito o contenido tras login?

- Integración y exportación: ¿Qué tan fácil es llevar los datos a Excel, Google Sheets, bases de datos o tu flujo de trabajo?

- Comunidad y mantenimiento: ¿Sigue en desarrollo? ¿Hay tutoriales y soporte?

- Costo: ¿Es gratis, open source o de pago? ¿Qué valor aporta a equipos y empresas?

Probé estas herramientas, revisé opiniones de usuarios y analicé casos reales. Aquí va el top 12.

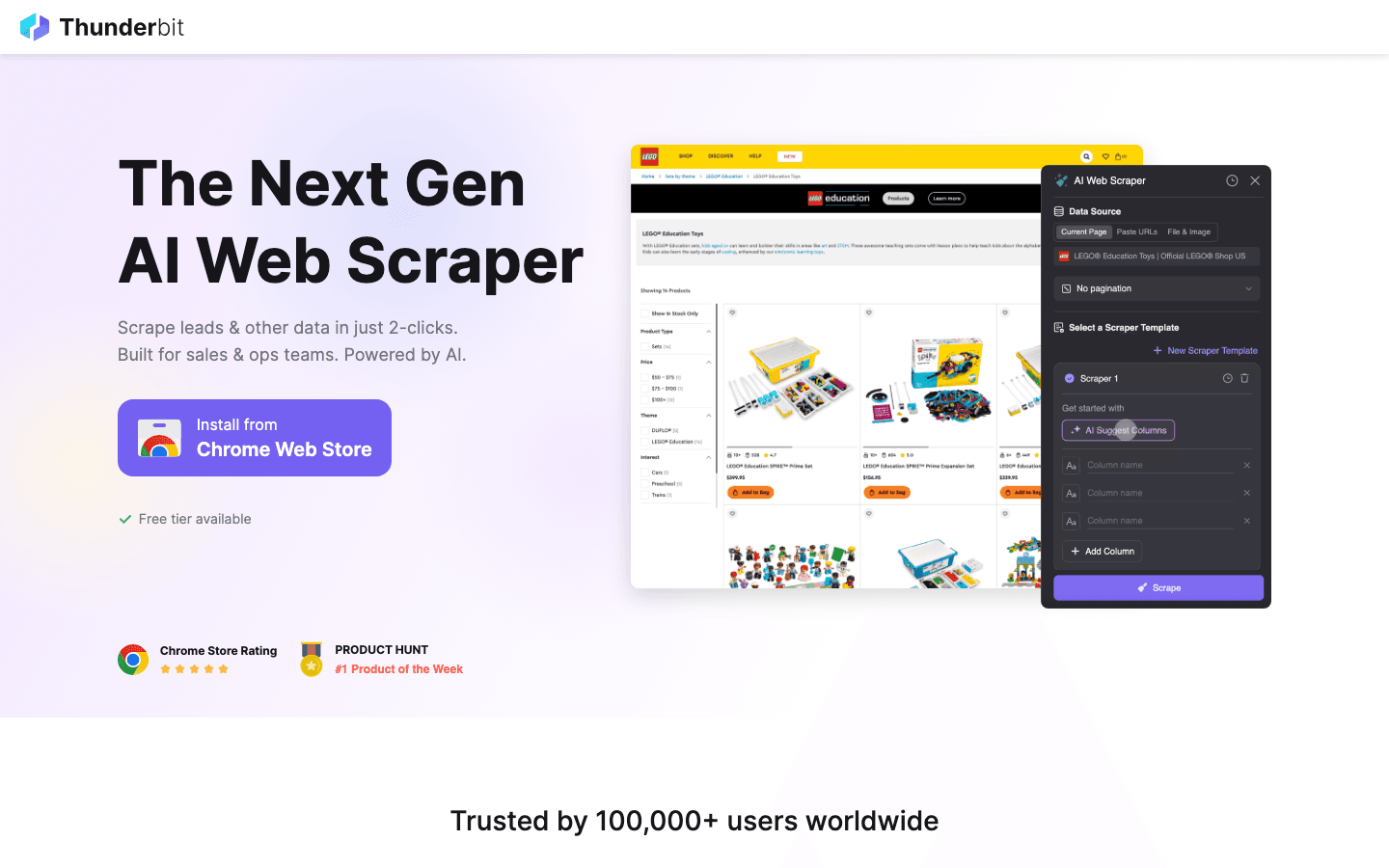

1. Thunderbit

es mi recomendación para quienes quieren raspar datos sin complicaciones. Es una que te deja extraer información de cualquier web en solo dos clics—sin código, sin plantillas, sin enredos.

es mi recomendación para quienes quieren raspar datos sin complicaciones. Es una que te deja extraer información de cualquier web en solo dos clics—sin código, sin plantillas, sin enredos.

Por qué me gusta: Thunderbit está pensado para usuarios de negocio—ventas, operaciones, e-commerce, inmobiliarias—que necesitan datos rápido pero no quieren lidiar con scripts de Python. Solo haz clic en “Sugerir campos con IA”, deja que la IA lea la página y pulsa “Raspar”. Thunderbit se encarga de subpáginas, paginación, contenido dinámico e incluso rellena formularios online por ti. Exporta gratis a Excel, Google Sheets, Airtable o Notion.

Lo mejor:

- Sugerencias de campos con IA: La IA de Thunderbit analiza la página y te recomienda qué extraer—nombres, precios, emails, lo que necesites.

- Raspado de subpáginas: ¿Necesitas más detalles? Thunderbit visita automáticamente subpáginas (como fichas de producto o contacto) y enriquece tu tabla.

- Plantillas instantáneas: Para sitios como Amazon, Zillow o Instagram, solo elige una plantilla y listo.

- Raspado en la nube o navegador: Extrae hasta 50 páginas a la vez en la nube, o usa tu navegador para sitios que requieren login.

- Exportación gratuita de datos: Sin barreras de pago para exportar tus datos.

Ideal para: Equipos no técnicos, operaciones de ventas, e-commerce y cualquiera que quiera resultados rápidos—sin programar.

Limitaciones: No es una librería de Python como tal, así que si necesitas integrarlo directo en tu código, tendrás que exportar e importar los datos. Pero para el 99% de las necesidades de scraping empresarial, es una solución que te salva la vida.

¿Quieres verlo en acción? Pásate por el o nuestro .

2. Beautiful Soup

es la librería clásica de Python para analizar HTML y XML. Fue mi primera herramienta de scraping y sigue siendo mi favorita para quienes recién empiezan.

es la librería clásica de Python para analizar HTML y XML. Fue mi primera herramienta de scraping y sigue siendo mi favorita para quienes recién empiezan.

Por qué destaca: Es sencilla, tolerante y perfecta para proyectos rápidos. Descargas la página con Requests, pasas el HTML a Beautiful Soup y usas su API intuitiva para encontrar y extraer datos. Se lleva bien con HTML desordenado.

Ideal para: Proyectos pequeños o medianos, limpieza de datos y quienes están aprendiendo scraping.

Limitaciones: No soporta contenido dinámico (JavaScript) de forma nativa. Para eso, deberás combinarla con Selenium u otra herramienta de automatización de navegadores.

3. Scrapy

es el framework de Python por excelencia para rastreos web a gran escala y automatizados. Si necesitas raspar miles (o millones) de páginas, construir pipelines de datos o programar tareas, Scrapy es tu mejor aliado.

es el framework de Python por excelencia para rastreos web a gran escala y automatizados. Si necesitas raspar miles (o millones) de páginas, construir pipelines de datos o programar tareas, Scrapy es tu mejor aliado.

Por qué es potente: Scrapy es asíncrono, rápido y pensado para escalar. Defines “spiders” para rastrear sitios, seguir enlaces, manejar paginación y procesar datos en pipelines. Es la base de muchos proyectos empresariales de scraping.

Ideal para: Desarrolladores que construyen rastreadores robustos y escalables; scraping de múltiples páginas o sitios; pipelines de datos en producción.

Limitaciones: Curva de aprendizaje más pronunciada que Beautiful Soup. De serie, no maneja JavaScript—pero puedes integrarlo con Splash o Selenium para sitios dinámicos.

4. Selenium

es la herramienta de automatización de navegadores que te permite controlar Chrome, Firefox y otros desde Python. Es imprescindible para raspar sitios dinámicos con mucho JavaScript o automatizar interacciones web complejas.

es la herramienta de automatización de navegadores que te permite controlar Chrome, Firefox y otros desde Python. Es imprescindible para raspar sitios dinámicos con mucho JavaScript o automatizar interacciones web complejas.

Por qué es esencial: Selenium puede simular acciones humanas—clics, envíos de formularios, scroll—y extraer lo que aparece en el navegador, igual que un usuario real.

Ideal para: Sitios dinámicos, scraping tras login, scroll infinito o cuando necesitas interactuar con la página.

Limitaciones: Más lento y consume más recursos que las librerías HTTP puras. No es ideal para raspar miles de páginas salvo que tengas buena infraestructura.

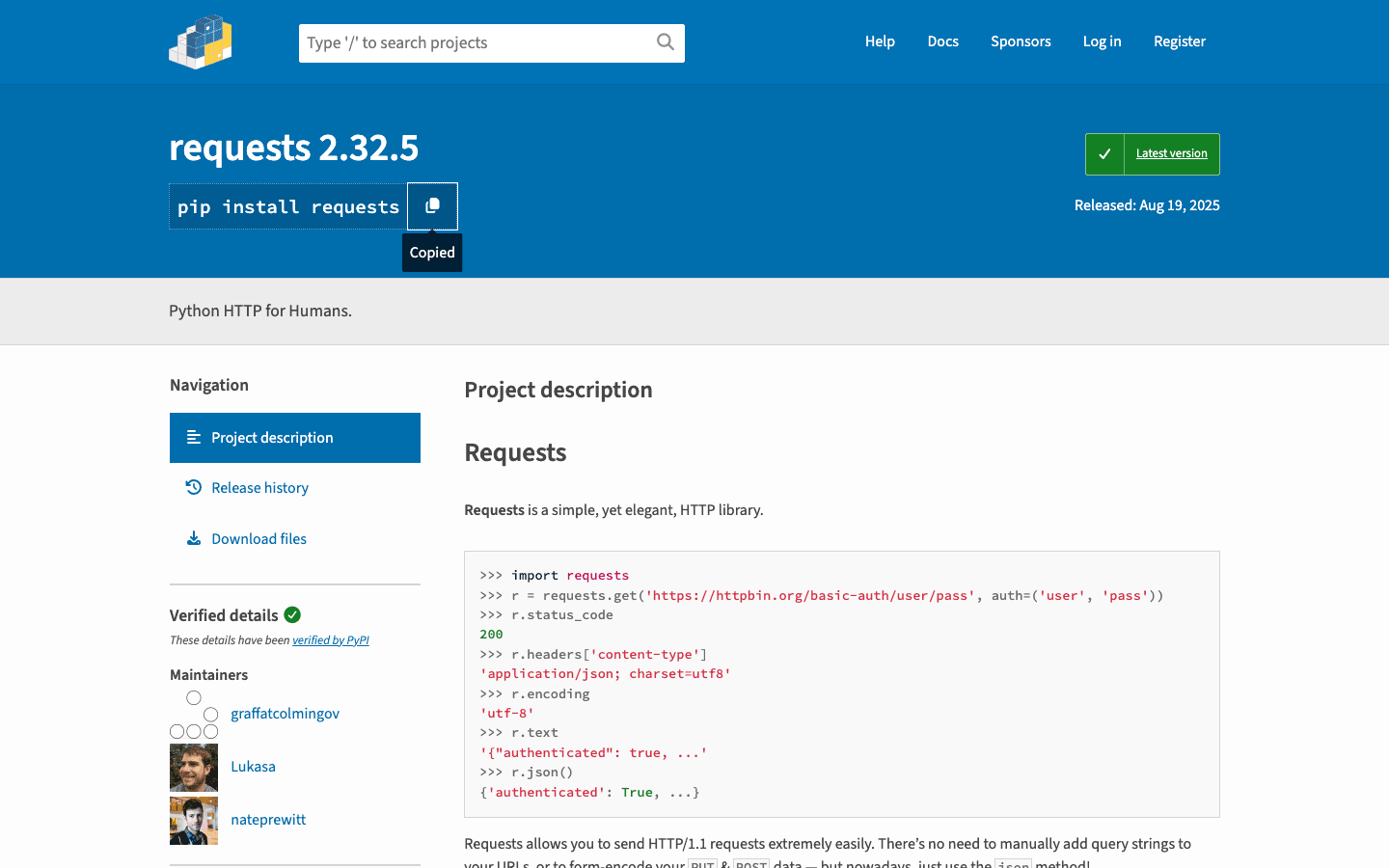

5. Requests

es la librería “HTTP para humanos”. Es la base de la mayoría de scripts de scraping en Python—descargando páginas, enviando formularios y gestionando cookies.

es la librería “HTTP para humanos”. Es la base de la mayoría de scripts de scraping en Python—descargando páginas, enviando formularios y gestionando cookies.

Por qué es imprescindible: API sencilla, fiable y se integra perfectamente con Beautiful Soup o lxml. Ideal para sitios estáticos y APIs.

Ideal para: Descargar HTML estático, llamar a APIs o como base para un raspador personalizado.

Limitaciones: No puede manejar contenido generado por JavaScript. Para sitios dinámicos, deberás combinarlo con Selenium u otra herramienta.

6. LXML

es el parser de HTML y XML de alto rendimiento para Python. Es rapidísimo y soporta selectores XPath y CSS muy potentes.

es el parser de HTML y XML de alto rendimiento para Python. Es rapidísimo y soporta selectores XPath y CSS muy potentes.

Por qué es favorito: Si necesitas raspar páginas enormes o hacer consultas avanzadas, lxml es tu opción. Scrapy lo utiliza internamente.

Ideal para: Proyectos donde el rendimiento es clave, grandes volúmenes de datos o cuando necesitas usar XPath para extracciones complejas.

Limitaciones: Curva de aprendizaje algo mayor y la instalación puede ser complicada en algunos sistemas.

7. PySpider

es un framework de scraping en Python con interfaz web. Es como Scrapy, pero con un panel para gestionar, programar y monitorizar tus tareas de scraping.

es un framework de scraping en Python con interfaz web. Es como Scrapy, pero con un panel para gestionar, programar y monitorizar tus tareas de scraping.

Por qué es único: Puedes escribir spiders en Python, programarlas y ver los resultados—todo desde el navegador. Ideal para equipos que buscan control y automatización.

Ideal para: Equipos que gestionan varios proyectos de scraping, rastreos programados o quienes prefieren una interfaz visual.

Limitaciones: No está tan mantenido como Scrapy y el soporte para sitios modernos con JavaScript es limitado.

8. MechanicalSoup

es una librería ligera de Python para automatizar tareas sencillas en el navegador—como rellenar formularios y seguir enlaces—sin la complejidad de Selenium.

es una librería ligera de Python para automatizar tareas sencillas en el navegador—como rellenar formularios y seguir enlaces—sin la complejidad de Selenium.

Por qué es útil: Combina Requests y Beautiful Soup, facilitando el login, envío de formularios y scraping de las páginas resultantes.

Ideal para: Automatizar logins, envíos de formularios o flujos web simples donde no se requiera JavaScript.

Limitaciones: No puede manejar sitios con mucho JavaScript o interacciones complejas.

9. Octoparse

es una herramienta de scraping sin código con interfaz de arrastrar y soltar. Es perfecta para usuarios de negocio que quieren extraer datos sin programar.

es una herramienta de scraping sin código con interfaz de arrastrar y soltar. Es perfecta para usuarios de negocio que quieren extraer datos sin programar.

Por qué es popular: Octoparse gestiona paginación, contenido dinámico e incluso permite programar extracciones en la nube. Ofrece plantillas para sitios comunes y exporta datos a Excel, CSV o Google Sheets.

Ideal para: Personas sin conocimientos de programación, estudios de mercado, generación de leads y equipos que buscan resultados rápidos.

Limitaciones: El plan gratuito es limitado; las funciones avanzadas requieren suscripción (desde unos $75/mes).

10. ParseHub

es otra herramienta visual que te permite crear flujos complejos haciendo clic en la web. Es ideal para raspar sitios dinámicos, manejar lógica condicional y programar tareas en la nube.

es otra herramienta visual que te permite crear flujos complejos haciendo clic en la web. Es ideal para raspar sitios dinámicos, manejar lógica condicional y programar tareas en la nube.

Por qué destaca: La lógica condicional y los flujos multi-paso de ParseHub lo hacen perfecto para webs con pop-ups, pestañas o datos ocultos.

Ideal para: Usuarios sin código que necesitan raspar webs complejas y dinámicas; recolección de datos programada.

Limitaciones: El plan gratuito tiene límites; los planes de pago pueden ser costosos para scraping de alto volumen.

11. Colly

es un framework de scraping ultrarrápido—escrito en Go, no en Python, pero merece mención por su rendimiento. Algunos equipos Python usan Colly como microservicio para rastreos intensivos y luego procesan los datos en Python.

es un framework de scraping ultrarrápido—escrito en Go, no en Python, pero merece mención por su rendimiento. Algunos equipos Python usan Colly como microservicio para rastreos intensivos y luego procesan los datos en Python.

Por qué es relevante: Colly puede extraer miles de páginas por segundo usando poca memoria. Si necesitas scraping a gran escala, es una gran opción multiplataforma.

Ideal para: Equipos de ingeniería que buscan velocidad y concurrencia; integración de rastreadores en Go con flujos Python.

Limitaciones: Requiere conocimientos de Go; no es una librería Python directa.

12. Portia

es un 웹 스크래퍼 visual de código abierto de Scrapinghub (ahora Zyte). Permite crear spiders de Scrapy haciendo clic en los elementos del navegador—sin programar.

es un 웹 스크래퍼 visual de código abierto de Scrapinghub (ahora Zyte). Permite crear spiders de Scrapy haciendo clic en los elementos del navegador—sin programar.

Por qué es interesante: Portia conecta el mundo sin código con la potencia de Scrapy. Puedes definir reglas de extracción visualmente y luego ejecutar el spider en Scrapy o en la nube de Zyte.

Ideal para: Usuarios de datos sin experiencia en programación, o quienes quieren prototipar spiders de Scrapy de forma visual.

Limitaciones: No está tan mantenido y tiene dificultades con sitios muy dinámicos o interactivos.

Tabla comparativa: Las mejores librerías de scraping en Python de un vistazo

| Herramienta/Librería | Facilidad de uso | Contenido dinámico | Automatización y escala | Ideal para | Precio |

|---|---|---|---|---|---|

| Thunderbit | ★★★★★ | ★★★★☆ | ★★★★☆ | No programadores, usuarios de negocio, rapidez | Gratis + créditos |

| Beautiful Soup | ★★★★★ | ★☆☆☆☆ | ★★★☆☆ | Principiantes, páginas estáticas, limpieza | Gratis |

| Scrapy | ★★★☆☆ | ★★★☆☆ | ★★★★★ | Desarrolladores, rastreos a gran escala | Gratis |

| Selenium | ★★☆☆☆ | ★★★★★ | ★★☆☆☆ | Sitios dinámicos, automatización de navegador | Gratis |

| Requests | ★★★★★ | ★☆☆☆☆ | ★★★☆☆ | HTML estático, APIs, scripts rápidos | Gratis |

| LXML | ★★★☆☆ | ★☆☆☆☆ | ★★★★☆ | Rendimiento, grandes volúmenes, XPath | Gratis |

| PySpider | ★★★★☆ | ★★★☆☆ | ★★★★★ | Equipos, rastreos programados, interfaz web | Gratis |

| MechanicalSoup | ★★★★☆ | ★☆☆☆☆ | ★★☆☆☆ | Automatización de formularios, logins, flujos | Gratis |

| Octoparse | ★★★★★ | ★★★★☆ | ★★★★☆ | Sin código, usuarios de negocio, scraping planificado | Gratis + pago |

| ParseHub | ★★★★★ | ★★★★☆ | ★★★★☆ | Sin código, sitios complejos/dinámicos | Gratis + pago |

| Colly | ★★☆☆☆ | ★☆☆☆☆ | ★★★★★ | Alta velocidad, multiplataforma, integración Go | Gratis |

| Portia | ★★★★☆ | ★★☆☆☆ | ★★★☆☆ | Spiders visuales de Scrapy, no programadores | Gratis |

Cómo elegir la mejor herramienta de scraping en Python para tu negocio

Entonces, ¿con cuál te quedas? Aquí va mi resumen:

- No programadores o usuarios de negocio: Empieza con , o . Son rápidas, visuales y no requieren programación.

- Desarrolladores, proyectos a gran escala: Elige o si necesitas rastreadores robustos y repetibles.

- Sitios dinámicos o con mucho JavaScript: Usa o una herramienta visual con automatización de navegador.

- Scraping rápido de páginas estáticas: + sigue siendo la forma más ágil de empezar.

- Rendimiento o multiplataforma: Considera para microservicios en Go, o combínalo con Python para lo mejor de ambos mundos.

- Prototipado visual para Scrapy: es un gran puente entre usuarios sin código y desarrolladores.

Mi consejo: Empieza con la herramienta más sencilla que cubra tus necesidades. Si tienes dudas, prueba para un resultado rápido, o lánzate con Scrapy si buscas escalar.

Recuerda: la mejor herramienta es la que te da los datos que necesitas—de forma fiable, eficiente y sin hacerte perder la paciencia.

Preguntas frecuentes

1. ¿Por qué Python es tan popular para el 웹 스크래퍼?

Python domina el 웹 스크래퍼 por su sintaxis sencilla, su enorme ecosistema de librerías y una comunidad muy activa. ), convirtiéndolo en el lenguaje preferido tanto para principiantes como para expertos.

2. ¿Cuál es la mejor librería de Python para raspar sitios dinámicos (con JavaScript)?

Para sitios dinámicos, es la opción clásica, ya que controla un navegador real. Para soluciones sin código, , y también gestionan páginas con mucho JavaScript.

3. ¿Cómo elijo entre Scrapy y Beautiful Soup?

Usa para proyectos rápidos y sencillos o si estás aprendiendo. Elige para rastreos grandes, proyectos multipágina o cuando necesitas pipelines robustos y programación de tareas.

4. ¿Puedo usar Thunderbit en mi flujo de trabajo con Python?

Por supuesto. te permite exportar datos a CSV, Excel o Google Sheets, que luego puedes importar en tus scripts de Python para análisis o procesamiento adicional.

5. ¿Cuál es la forma más fácil de empezar con el 웹 스크래퍼 si no soy desarrollador?

Prueba , o . Estas herramientas te permiten extraer datos de forma visual—sin programar. Para más guías y consejos, visita el .

¡Feliz scraping! Que tus datos siempre estén limpios, ordenados y a solo un clic de distancia.

Sigue aprendiendo