Gestionar una web en 2025 puede sentirse como una maratón llena de obstáculos. Un día estás arreglando enlaces caídos, al siguiente planeando una mudanza de contenido, y de repente te preguntas por qué Google sigue mostrando esa página de “pruebas” de hace años. Créeme, he pasado por ahí más veces de las que me gustaría. Y si eres como yo, seguro que alguna vez has buscado en Google “mejor raspador web gratis” a las tantas de la madrugada, esperando encontrar una herramienta que funcione sin tener que ser un crack de la informática.

Pero ojo: no todos los raspadores web son iguales y, spoiler, mucha gente confunde “raspador web” con “web scraper” como si fueran lo mismo. No lo son. En esta guía te explico la diferencia, por qué los raspadores web online son más importantes que nunca y te traigo el top 10 de herramientas gratuitas para 2025. Y como cofundador de , también te cuento cuándo es mejor dejar de complicarte la vida y apostar por una solución con IA que te entregue los datos listos para usar. ¿Listo? Vamos a rastrear.

¿Qué es un Raspador Web? Lo Básico

Primero, aclaremos: un raspador web no es lo mismo que un web scraper. Aunque mucha gente los usa como sinónimos, en realidad hacen cosas distintas. Piensa en el raspador como el explorador de tu web: recorre cada rincón, sigue todos los enlaces y te dibuja el mapa de todas tus páginas. Su trabajo es descubrir: encontrar URLs, mapear la estructura del sitio e indexar el contenido. Así es como Google y otras herramientas SEO exploran la web y auditan tu sitio ().

Un web scraper, en cambio, es el que va a por el dato concreto. No le interesa el mapa entero, solo busca el tesoro: precios, nombres de empresas, reseñas, emails, lo que sea. Los scrapers extraen campos específicos de las páginas que encuentran los raspadores ().

Para que quede claro:

- Raspador: Es como quien recorre todos los pasillos de un súper y apunta todo lo que hay.

- Scraper: Es quien va directo a la estantería del café y apunta solo los precios de las variedades orgánicas.

¿Y esto por qué importa? Porque si solo quieres encontrar todas las páginas de tu web (por ejemplo, para una auditoría SEO), necesitas un raspador. Si lo que buscas es extraer los precios de la competencia, necesitas un scraper, o mejor aún, una herramienta que haga las dos cosas.

¿Por Qué Usar un Raspador Web Online? Ventajas para tu Negocio

¿Y por qué molestarse en usar un raspador web online en 2025? Porque la web crece sin parar. De hecho, más del para optimizar sus webs, y algunas herramientas SEO rastrean .

Esto es lo que pueden hacer los raspadores web por ti:

- Auditorías SEO: Encuentra enlaces rotos, títulos que faltan, contenido duplicado, páginas huérfanas y más ().

- Revisión de Enlaces y QA: Detecta errores 404 y bucles de redirección antes que tus usuarios ().

- Generación de Sitemaps: Crea mapas XML para buscadores y planificación ().

- Inventario de Contenidos: Haz un listado de todas tus páginas, su jerarquía y metadatos.

- Cumplimiento y Accesibilidad: Revisa cada página para cumplir con WCAG, SEO y normativas legales ().

- Rendimiento y Seguridad: Señala páginas lentas, imágenes pesadas o problemas de seguridad ().

- Datos para IA y Análisis: Usa los datos rastreados en herramientas de análisis o IA ().

Aquí tienes una tabla rápida que relaciona casos de uso con roles de negocio:

| Caso de Uso | Ideal para | Beneficio / Resultado |

|---|---|---|

| SEO y Auditoría de Sitios | Marketing, SEO, Pequeñas Empresas | Detecta problemas técnicos, optimiza estructura, mejora rankings |

| Inventario de Contenidos y QA | Gestores de Contenido, Webmasters | Audita o migra contenido, detecta enlaces/imágenes rotas |

| Generación de Leads (Scraping) | Ventas, Desarrollo de Negocio | Automatiza prospección, llena el CRM con nuevos contactos |

| Inteligencia Competitiva | E-commerce, Product Managers | Monitorea precios, nuevos productos, cambios de stock |

| Clonado de Sitemaps y Estructura | Desarrolladores, DevOps, Consultores | Clona la estructura para rediseños o backups |

| Agregación de Contenidos | Investigadores, Medios, Analistas | Recopila datos de varios sitios para análisis o tendencias |

| Investigación de Mercado | Analistas, Equipos de IA | Reúne grandes volúmenes de datos para análisis o entrenamiento de IA |

()

Cómo Elegimos los Mejores Raspadores Web Gratuitos

He pasado muchas noches (y litros de café) probando herramientas de rastreo, leyendo documentación y haciendo pruebas. Esto es lo que tuve en cuenta:

- Capacidad Técnica: ¿Puede con webs modernas (JavaScript, logins, contenido dinámico)?

- Facilidad de Uso: ¿Es amigable para quienes no son técnicos o hay que saber comandos?

- Límites del Plan Gratuito: ¿Es realmente gratis o solo una demo?

- Accesibilidad Online: ¿Funciona en la nube, es de escritorio o es una librería de código?

- Funciones Especiales: ¿Tiene algo único como extracción con IA, mapas visuales o rastreo por eventos?

Probé cada herramienta, leí opiniones y comparé funciones. Si alguna me hizo querer tirar el portátil por la ventana, la descarté.

Tabla Comparativa: Los 10 Mejores Raspadores Web Gratuitos de un Vistazo

| Herramienta y Tipo | Funciones Principales | Mejor Caso de Uso | Requisitos Técnicos | Detalles del Plan Gratuito |

|---|---|---|---|---|

| BrightData (Cloud/API) | Rastreo empresarial, proxies, renderizado JS, resolución de CAPTCHA | Recolección masiva de datos | Útil tener conocimientos técnicos | Prueba gratis: 3 scrapers, 100 registros cada uno (300 en total) |

| Crawlbase (Cloud/API) | API de rastreo, anti-bot, proxies, renderizado JS | Devs que necesitan infraestructura backend | Integración API | Gratis: ~5,000 llamadas API por 7 días, luego 1,000/mes |

| ScraperAPI (Cloud/API) | Rotación de proxies, renderizado JS, rastreo asíncrono, endpoints predefinidos | Devs, monitoreo de precios, datos SEO | Configuración mínima | Gratis: 5,000 llamadas API por 7 días, luego 1,000/mes |

| Diffbot Crawlbot (Cloud) | Rastreo + extracción con IA, knowledge graph, renderizado JS | Datos estructurados a escala, IA/ML | Integración API | Gratis: 10,000 créditos/mes (unas 10k páginas) |

| Screaming Frog (Escritorio) | Auditoría SEO, análisis de enlaces/meta, sitemap, extracción personalizada | Auditorías SEO, gestores de sitios | App de escritorio, GUI | Gratis: 500 URLs por rastreo, solo funciones básicas |

| SiteOne Crawler (Escritorio) | SEO, rendimiento, accesibilidad, seguridad, exportación offline, Markdown | Devs, QA, migración, documentación | Escritorio/CLI, GUI | Gratis y open-source, 1,000 URLs en informe GUI (ajustable) |

| Crawljax (Java, OpenSrc) | Rastreo por eventos para sitios JS, exportación estática | Devs, QA para apps web dinámicas | Java, CLI/config | Gratis y open-source, sin límites |

| Apache Nutch (Java, OpenSrc) | Distribuido, plugins, integración Hadoop, búsqueda personalizada | Motores de búsqueda, rastreo a gran escala | Java, línea de comandos | Gratis y open-source, solo coste de infraestructura |

| YaCy (Java, OpenSrc) | Rastreo y búsqueda P2P, privacidad, indexación web/intranet | Búsqueda privada, descentralización | Java, interfaz web | Gratis y open-source, sin límites |

| PowerMapper (Escritorio/SaaS) | Sitemaps visuales, accesibilidad, QA, compatibilidad de navegadores | Agencias, QA, mapeo visual | GUI, fácil | Prueba gratis: 30 días, 100 páginas (escritorio) o 10 páginas (online) por escaneo |

BrightData: Raspador Web Empresarial en la Nube

BrightData es el peso pesado del rastreo web. Es una plataforma en la nube con una red enorme de proxies, renderizado JavaScript, resolución de CAPTCHAs y un IDE para rastreos a medida. Si necesitas recolectar datos a lo grande—como monitorizar cientos de tiendas online—la infraestructura de BrightData es difícil de igualar ().

Ventajas:

- Supera webs con bloqueos anti-bot

- Escalable para empresas grandes

- Plantillas listas para sitios populares

Desventajas:

- No tiene plan gratis permanente (solo prueba: 3 scrapers, 100 registros cada uno)

- Puede ser demasiado para auditorías sencillas

- Curva de aprendizaje para quienes no son técnicos

Si necesitas rastrear la web a lo grande, BrightData es como alquilar un Fórmula 1. Solo ten en cuenta que la prueba es limitada ().

Crawlbase: Raspador Web Gratuito vía API para Desarrolladores

Crawlbase (antes ProxyCrawl) está pensado para el rastreo programático. Llamas a su API con una URL y te devuelve el HTML, gestionando proxies, geolocalización y CAPTCHAs en segundo plano ().

Ventajas:

- Altísima tasa de éxito (99%+)

- Soporta webs con mucho JavaScript

- Perfecto para integrar en tus apps o flujos de trabajo

Desventajas:

- Requiere integración API o SDK

- Plan gratis: ~5,000 llamadas API por 7 días, luego 1,000/mes

Si eres desarrollador y quieres rastrear (y quizá extraer) a escala sin preocuparte por proxies, Crawlbase es una gran opción ().

ScraperAPI: Raspado Dinámico Simplificado

ScraperAPI es la API de “solo tráeme la página”. Le das una URL, gestiona proxies, navegadores sin cabeza y bloqueos anti-bot, y te devuelve el HTML (o datos estructurados en algunos casos). Es ideal para páginas dinámicas y tiene un plan gratuito generoso ().

Ventajas:

- Muy fácil para desarrolladores (solo una llamada API)

- Supera CAPTCHAs, bloqueos de IP, JavaScript

- Gratis: 5,000 llamadas API por 7 días, luego 1,000/mes

Desventajas:

- No tiene informes visuales

- Debes programar la lógica de rastreo si quieres seguir enlaces

Si quieres integrar el rastreo web en tu código en minutos, ScraperAPI es una apuesta segura.

Diffbot Crawlbot: Descubrimiento Automático de Estructura Web

Diffbot Crawlbot lleva el rastreo a otro nivel. No solo rastrea, sino que usa IA para clasificar páginas y extraer datos estructurados (artículos, productos, eventos, etc.) en JSON. Es como tener un becario robot que realmente entiende lo que ve ().

Ventajas:

- Extracción con IA, no solo rastreo

- Soporta JavaScript y contenido dinámico

- Gratis: 10,000 créditos/mes (unas 10k páginas)

Desventajas:

- Pensado para desarrolladores (integración API)

- No es una herramienta SEO visual, más para proyectos de datos

Si necesitas datos estructurados a gran escala, sobre todo para IA o análisis, Diffbot es una opción potente.

Screaming Frog: Raspador SEO Gratuito de Escritorio

Screaming Frog es el clásico de escritorio para auditorías SEO. Permite rastrear hasta 500 URLs por escaneo (versión gratuita) y te da todo: enlaces rotos, metadatos, contenido duplicado, sitemaps y más ().

Ventajas:

- Rápido, completo y muy valorado en SEO

- No necesitas programar: solo pones la URL y listo

- Gratis hasta 500 URLs por rastreo

Desventajas:

- Solo para escritorio (no hay versión en la nube)

- Funciones avanzadas (renderizado JS, programación) requieren licencia de pago

Si te tomas en serio el SEO, Screaming Frog es imprescindible, aunque no esperes rastrear un sitio de 10,000 páginas gratis.

SiteOne Crawler: Exportación Estática y Documentación

SiteOne Crawler es la navaja suiza para auditorías técnicas. Es open-source, multiplataforma y puede rastrear, auditar e incluso exportar tu web a Markdown para documentación o uso offline ().

Ventajas:

- Cubre SEO, rendimiento, accesibilidad y seguridad

- Exporta webs para archivado o migración

- Gratis y open-source, sin límites de uso

Desventajas:

- Más técnico que otras herramientas con GUI

- Informe GUI limitado a 1,000 URLs por defecto (ajustable)

Si eres desarrollador, QA o consultor y te gusta el open source, SiteOne es una joya oculta.

Crawljax: Raspador Web Open Source para Páginas Dinámicas

Crawljax es un especialista: está pensado para rastrear aplicaciones web modernas con mucho JavaScript simulando interacciones de usuario (clics, formularios, etc.). Es orientado a eventos y puede exportar una versión estática de un sitio dinámico ().

Ventajas:

- Ideal para rastrear SPAs y webs con AJAX

- Open-source y ampliable

- Sin límites de uso

Desventajas:

- Requiere Java y algo de programación/configuración

- No apto para usuarios no técnicos

Si necesitas rastrear una app en React o Angular como un usuario real, Crawljax es tu aliado.

Apache Nutch: Raspador Web Distribuido y Escalable

Apache Nutch es el veterano de los raspadores open-source. Está pensado para rastreos masivos y distribuidos—como crear tu propio buscador o indexar millones de páginas ().

Ventajas:

- Escala a miles de millones de páginas con Hadoop

- Muy configurable y ampliable

- Gratis y open-source

Desventajas:

- Curva de aprendizaje pronunciada (Java, línea de comandos, configs)

- No es para webs pequeñas o usuarios casuales

Si quieres rastrear la web a gran escala y no te asusta la terminal, Nutch es tu herramienta.

YaCy: Raspador Web y Buscador Peer-to-Peer

YaCy es diferente: un raspador y buscador descentralizado. Cada instancia rastrea e indexa webs, y puedes unirte a una red P2P para compartir índices con otros ().

Ventajas:

- Enfocado en la privacidad, sin servidor central

- Ideal para buscadores privados o intranets

- Gratis y open-source

Desventajas:

- Los resultados dependen de la cobertura de la red

- Requiere configuración (Java, interfaz web)

Si te interesa la descentralización o quieres tu propio buscador, YaCy es una opción interesante.

PowerMapper: Generador Visual de Sitemaps para UX y QA

PowerMapper se centra en visualizar la estructura de tu web. Rastrear tu sitio y genera sitemaps interactivos, además de revisar accesibilidad, compatibilidad de navegadores y aspectos básicos de SEO ().

Ventajas:

- Los sitemaps visuales son ideales para agencias y diseñadores

- Revisa accesibilidad y cumplimiento

- Interfaz fácil, sin conocimientos técnicos

Desventajas:

- Solo prueba gratuita (30 días, 100 páginas escritorio/10 online por escaneo)

- La versión completa es de pago

Si necesitas presentar un mapa del sitio a clientes o revisar cumplimiento, PowerMapper es muy útil.

¿Cómo Elegir el Mejor Raspador Web Gratuito para Ti?

Con tantas opciones, ¿cómo decidir? Aquí va una guía rápida:

- Para auditorías SEO: Screaming Frog (webs pequeñas), PowerMapper (visual), SiteOne (auditorías profundas)

- Para apps web dinámicas: Crawljax

- Para rastreos masivos o buscadores personalizados: Apache Nutch, YaCy

- Para desarrolladores que quieren API: Crawlbase, ScraperAPI, Diffbot

- Para documentación o archivado: SiteOne Crawler

- Para empresas con prueba gratuita: BrightData, Diffbot

Factores clave a tener en cuenta:

- Escalabilidad: ¿Qué tan grande es tu web o proyecto?

- Facilidad de uso: ¿Prefieres código o una interfaz visual?

- Exportación de datos: ¿Necesitas CSV, JSON o integración con otras herramientas?

- Soporte: ¿Hay comunidad o documentación si te atascas?

Cuando el Rastreo se Une al Scraping: Por Qué Thunderbit es la Opción Más Inteligente

La realidad es que la mayoría no rastrea webs solo para hacer mapas bonitos. El objetivo real suele ser conseguir datos estructurados—ya sean listados de productos, contactos o inventarios de contenido. Ahí es donde entra .

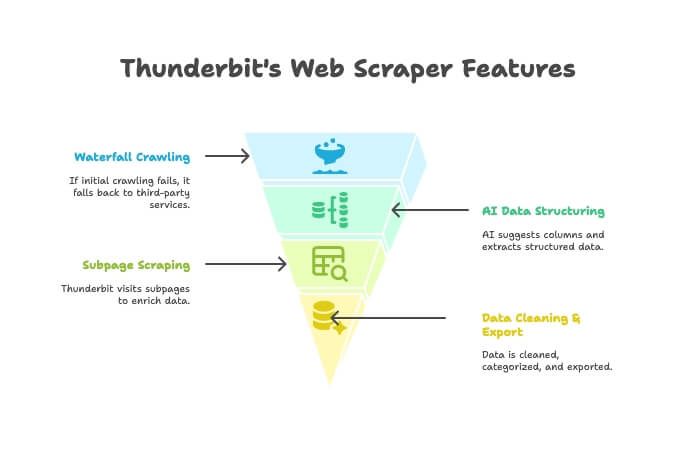

Thunderbit no es solo un raspador ni solo un scraper: es una extensión de Chrome con IA que hace ambas cosas. Así funciona:

- Raspador con IA: Thunderbit explora la web como un raspador tradicional.

- Rastreo en Cascada: Si el motor propio de Thunderbit no puede acceder a una página (por bloqueos anti-bot, por ejemplo), recurre automáticamente a servicios externos—sin que tengas que tocar nada.

- Estructuración de Datos con IA: Cuando obtiene el HTML, la IA de Thunderbit sugiere las columnas y extrae datos estructurados (nombres, precios, emails, etc.) sin que escribas ni un selector.

- Scraping de Subpáginas: ¿Necesitas detalles de cada producto? Thunderbit puede visitar automáticamente cada subpágina y enriquecer tu tabla.

- Limpieza y Exportación de Datos: Puede resumir, categorizar, traducir y exportar tus datos a Excel, Google Sheets, Airtable o Notion con un solo clic.

- Simplicidad Sin Código: Si sabes usar un navegador, sabes usar Thunderbit. Sin programación, sin proxies, sin líos.

¿Cuándo conviene usar Thunderbit en vez de un raspador tradicional?

- Cuando tu objetivo es una hoja de cálculo limpia y lista para usar, no solo una lista de URLs.

- Cuando quieres automatizar todo el proceso (rastreo, extracción, limpieza, exportación) en un solo sitio.

- Cuando valoras tu tiempo y tranquilidad.

Puedes y ver por qué tantos usuarios de negocio están cambiando.

Conclusión: Aprovecha el Poder de los Raspadores Web Gratuitos en 2025

Los raspadores web han evolucionado muchísimo. Seas marketer, desarrollador o simplemente quieras mantener tu web en forma, hay una herramienta gratuita (o al menos con prueba gratis) para ti. Desde plataformas empresariales como BrightData y Diffbot, hasta joyas open-source como SiteOne y Crawljax, pasando por mapeadores visuales como PowerMapper, nunca hubo tantas opciones.

Pero si buscas una forma más inteligente e integrada de pasar de “necesito estos datos” a “aquí está mi hoja de cálculo”, prueba Thunderbit. Está pensado para usuarios de negocio que quieren resultados, no solo informes.

¿Listo para empezar? Descarga una herramienta, haz un escaneo y descubre lo que te estabas perdiendo. Y si quieres pasar de rastrear a tener datos listos para usar en dos clics, .

Para más guías prácticas y análisis, visita el .

Preguntas Frecuentes

¿Cuál es la diferencia entre un raspador web y un web scraper?

Un raspador descubre y mapea todas las páginas de una web (como hacer una tabla de contenidos). Un scraper extrae datos concretos (precios, emails, reseñas) de esas páginas. El raspador encuentra, el scraper extrae ().

¿Cuál es el mejor raspador web gratuito para usuarios sin experiencia técnica?

Para webs pequeñas y auditorías SEO, Screaming Frog es muy fácil de usar. Para mapas visuales, PowerMapper es ideal (durante la prueba). Thunderbit es la opción más sencilla si buscas datos estructurados y una experiencia sin código, directamente en el navegador.

¿Existen webs que bloquean los raspadores?

Sí, algunas webs usan robots.txt o medidas anti-bot (CAPTCHAs, bloqueos de IP) para impedir el rastreo. Herramientas como ScraperAPI, Crawlbase y Thunderbit (con rastreo en cascada) suelen superar estos obstáculos, pero siempre rastrea de forma responsable y respeta las normas del sitio ().

¿Los raspadores web gratuitos tienen límites de páginas o funciones?

La mayoría sí. Por ejemplo, la versión gratuita de Screaming Frog está limitada a 500 URLs por rastreo; la prueba de PowerMapper a 100 páginas. Las herramientas API suelen tener límites mensuales de créditos. Las open-source como SiteOne o Crawljax no tienen límites estrictos, pero dependen de tu ordenador.

¿Es legal y cumple con la privacidad usar un raspador web?

En general, rastrear páginas públicas es legal, pero revisa siempre los términos de uso y el robots.txt de la web. Nunca rastrees datos privados o protegidos sin permiso y ten en cuenta las leyes de privacidad si extraes datos personales ().