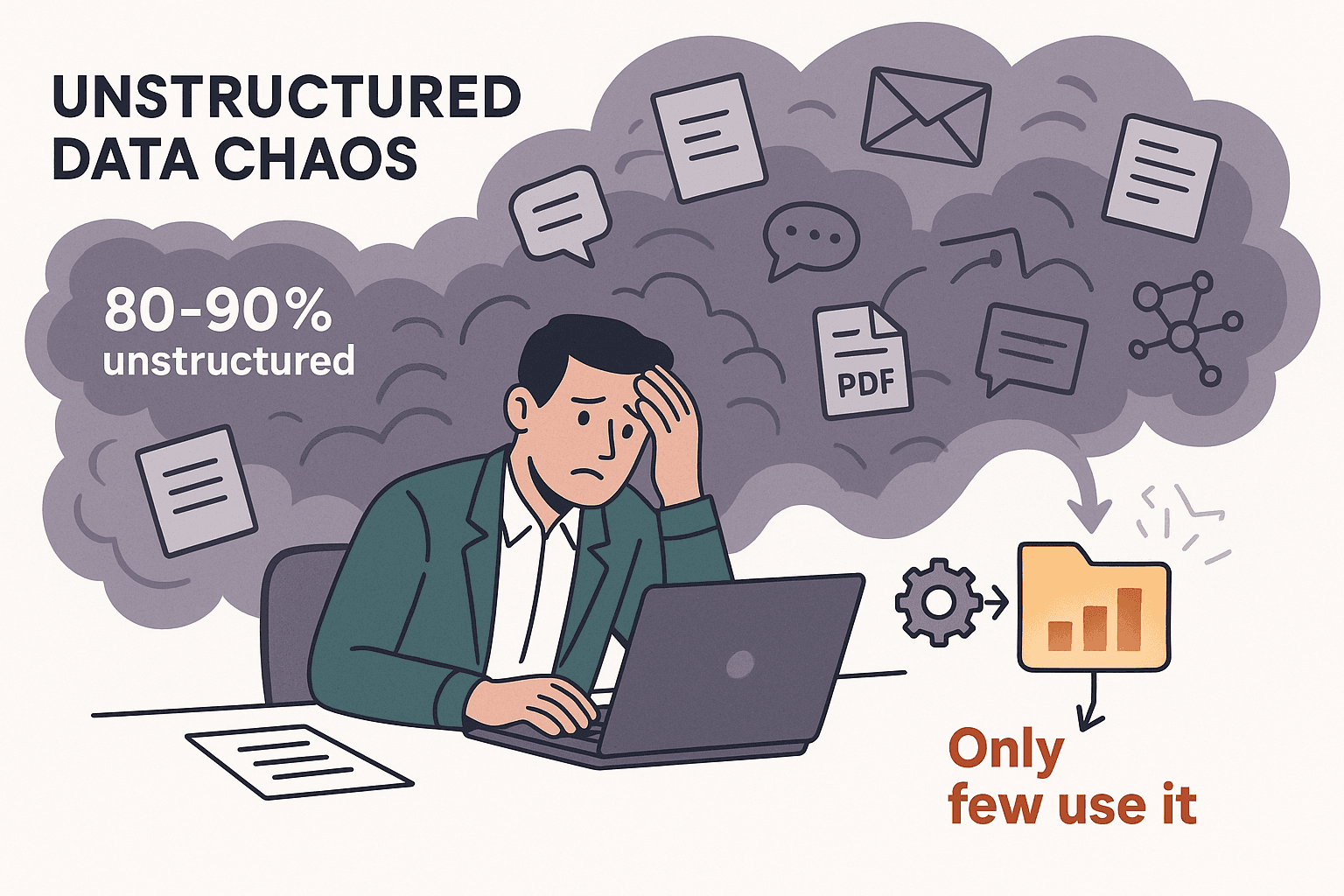

¿Alguna vez te has encontrado frente a un mar de páginas web, excels o PDFs y has pensado: “Tiene que haber una manera más sencilla de sacar estos datos”? Créeme, no eres el único. Llevo años armando herramientas de automatización y charlando con equipos de negocio que ya están hartos de copiar y pegar sin parar. Hoy en día, en 2025, la cantidad de datos no estructurados es brutal: el 80–90% de los datos nuevos en las empresas no están estructurados, y solo una minoría realmente los aprovecha (). Recopilar datos a mano no solo es una lata: también sale caro, es fácil cometer errores y frena la productividad de cualquier equipo.

Aquí es donde los extractores de datos se vuelven tus mejores aliados. Ya sea que trabajes en ventas, operaciones, eCommerce o investigación, la herramienta adecuada puede ahorrarte horas (o días), mejorar la precisión y dejar que tu equipo se enfoque en lo que realmente importa. Pero con tantas opciones—extensiones de Chrome con IA, plataformas sin código, frameworks para desarrolladores—¿cómo saber cuál te conviene? Me di a la tarea de analizar a fondo los 12 mejores extractores de datos para 2025, con sus pros, contras y los escenarios donde más rinden. Vamos al grano.

Por qué las empresas necesitan extractores de datos para ser más eficientes

Seamos realistas: el 94% de las empresas pierden tiempo en tareas repetitivas y manuales como la entrada de datos (). Y el costo no es solo tiempo perdido—recopilar datos manualmente puede costar $1,500 por empleado al mes (). Los extractores de datos automatizan ese trabajo pesado, permitiéndote:

- Ahorrar hasta un 77% del tiempo dedicado a recopilar datos ().

- Aumentar la eficiencia operativa en un 40% ().

- Reducir los tiempos de procesamiento en un 50% o más ().

- Alcanzar hasta un 99.9% de precisión en la captura de datos de documentos ().

¿El resultado? Decisiones más rápidas, datos de mejor calidad y equipos mucho más contentos. Ya sea que estés capturando leads, monitoreando precios de la competencia o alimentando tus herramientas de BI, un buen extractor es como tener un asistente digital que nunca se cansa (ni te pide aumento).

Cómo elegir el mejor extractor de datos: criterios clave

No todos los extractores de datos son iguales. Esto es lo que yo miro antes de recomendar uno:

- Facilidad de uso: ¿Alguien sin experiencia técnica puede arrancar rápido? ¿Incluye IA o configuración visual?

- Personalización y flexibilidad: ¿Permite trabajar con sitios complejos, logins o contenido dinámico? ¿Se puede programar para necesidades avanzadas?

- Tipos de datos soportados: ¿Extrae texto, números, imágenes, emails, teléfonos, PDFs, etc.?

- Escalabilidad y rendimiento: ¿Aguanta miles de páginas? ¿Ofrece scraping en la nube o multihilo?

- Integración y automatización: ¿Permite exportar directo a Excel, Google Sheets, Airtable, Notion o conectar vía API?

- Precio y valor: ¿Tiene plan gratis? ¿Los planes de pago se ajustan a tu caso?

- Soporte y comunidad: ¿Hay buena documentación, tutoriales y soporte rápido?

Cada equipo prioriza distinto. Por ejemplo, ventas suele valorar la facilidad de uso y exportación rápida, mientras que los desarrolladores buscan personalización y acceso vía API.

Extractores de datos para eCommerce e investigación de mercados

Los equipos de eCommerce e investigación de mercados viven de datos frescos—como seguimiento de precios, análisis de reseñas y monitoreo de la competencia. Para estos casos, necesitas herramientas que soporten scraping a gran escala, medidas anti-bots y programación de tareas.

- : Destaca por su interfaz sin código y cientos de plantillas para Amazon, eBay y más. Perfecta para monitoreo de precios y análisis de reseñas.

- : Se enfoca en integrar datos web en herramientas de BI, con programación y detección de cambios. Ideal para firmas de investigación que necesitan flujos de datos continuos.

- : Nivel empresarial, con automatización de flujos y transformación de datos. Usado por grandes minoristas para inteligencia competitiva y seguimiento de precios.

Estas herramientas están hechas para escalar y saltarse las barreras anti-scraping de los grandes sitios de eCommerce.

Extractores de datos para equipos técnicos y flujos personalizados

Si tienes desarrolladores en tu equipo (o te defiendes con algo de código), te interesan herramientas con máxima flexibilidad:

- : El estándar en scraping con Python. Open-source, súper personalizable y pensado para proyectos a gran escala. Perfecto para crear crawlers a medida o integrar scraping en tu app.

- : Constructor visual de flujos que soporta sitios con JavaScript dinámico. Permite lógica condicional, JS personalizado y acceso vía API.

- : Plataforma en la nube para ejecutar scripts personalizados (“Actors”) en JavaScript o Python. Ideal para automatizar flujos, scraping con navegador y escalar en la nube.

Estas son las opciones que recomiendo cuando necesitas extraer datos de sitios complejos, automatizar procesos de varios pasos o construir algo más allá de una simple herramienta visual.

Extractores de datos para integración y automatización de flujos

Algunos equipos necesitan más que datos en bruto—quieren automatizar todo el proceso, desde la extracción hasta el análisis:

- : Como mencioné, destaca integrando datos web en dashboards de BI, con programación y entrega vía API.

- : Pensado para automatización de extremo a extremo, incluyendo limpieza, transformación e integración con CRMs, bases de datos y más.

- : Plataforma empresarial con scripting, manejo de errores y opciones de integración avanzadas. Usada por grandes organizaciones para agregación de datos crítica.

Si tu flujo de trabajo implica varios pasos, o necesitas que los datos lleguen directo a tus sistemas, estos extractores son los que debes mirar.

Tabla comparativa: Los 12 mejores extractores de datos de un vistazo

Aquí tienes una comparación rápida para ayudarte a elegir:

| Nombre de la herramienta | Facilidad de uso | Mejor caso de uso | Precio | Personalización | Tipos de datos soportados |

|---|---|---|---|---|---|

| Thunderbit | ⭐ Muy fácil | Todos los sectores, no técnicos | Gratis y de pago | Prompts IA low-code | Texto, Números, Fechas, URLs, Emails, Teléfonos, Imágenes, PDFs |

| Octoparse | 🙂 Moderada | eCommerce, investigación de mercado | Gratis y de pago | Alta (visual, regex) | Texto, Números, URLs, Imágenes |

| ParseHub | 🙂 Moderada | Sitios dinámicos, usuarios técnicos | De pago | Alta (JS, lógica) | Texto, Números, URLs, Imágenes |

| Import.io | 😀 Fácil | Integración de datos, BI | De pago (Enterprise) | Media | Texto, Tablas, Listas |

| Scrapy | 😐 Difícil | Desarrollo a medida, gran escala | Gratis (Open-source) | Muy alta (código) | Cualquiera (definido por dev) |

| Apify | 😐 Difícil | Automatización de flujos, devs | Gratis y de pago | Muy alta (código) | Cualquier contenido web |

| Dexi.io | 🙂 Moderada | Empresas, automatización | De pago (Enterprise) | Alta (visual, script) | Texto, Imágenes, Archivos |

| WebHarvy | 😀 Fácil | Pymes, sitios estáticos | Licencia única | Baja-media | Texto, Números, URLs, Imágenes |

| Data Miner | 😀 Fácil | Web a hoja rápido, ventas | Gratis y de pago | Media (recetas) | Texto, Tablas, Listas |

| Visual Web Ripper | 🙂 Moderada | Grandes sitios estáticos, lógica compleja | Licencia única | Alta (plantillas, API) | Texto, Imágenes, Archivos |

| Helium Scraper | 🙂 Moderada | Lógica personalizada, datos relacionales | Licencia única | Alta (JS, SQL) | Texto, URLs, Imágenes, Archivos |

| Content Grabber | 🙂 Moderada | Empresas, automatización | De pago (Enterprise) | Muy alta (scripting) | Cualquier contenido, exportación estructurada |

Leyenda: 😀 Fácil (amigable para no técnicos), 🙂 Moderada (requiere aprendizaje), 😐 Difícil (requiere programación)

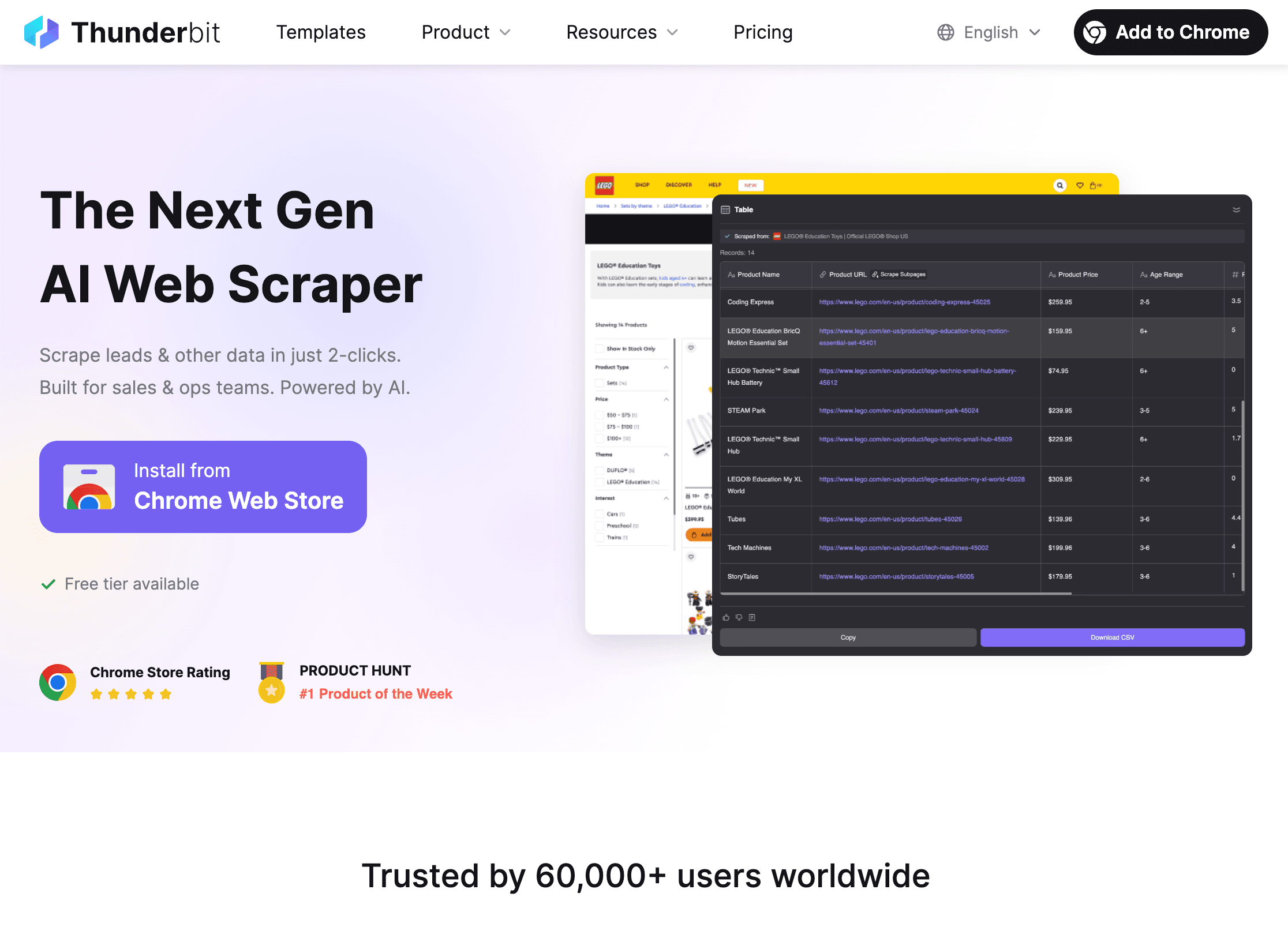

1. Thunderbit

es mi primera recomendación para quienes buscan eficiencia sin enredos técnicos. Como , está pensada para usuarios de negocio—ventas, operaciones, inmobiliarias, eCommerce—que solo quieren los datos, sin dolores de cabeza.

es mi primera recomendación para quienes buscan eficiencia sin enredos técnicos. Como , está pensada para usuarios de negocio—ventas, operaciones, inmobiliarias, eCommerce—que solo quieren los datos, sin dolores de cabeza.

Características principales:

- Sugerencia de columnas con IA: Haz clic y la IA de Thunderbit lee la página y te sugiere los mejores campos a extraer—sin configurar nada.

- Scraping en 2 clics: Confirmas los campos, pulsas “Extraer” y listo. Hasta mi mamá podría usarlo (y todavía me llama cuando se le cae el Wi-Fi).

- Extracción en subpáginas: ¿Necesitas más detalles? Thunderbit puede visitar automáticamente cada subpágina (como productos o perfiles) y enriquecer tu tabla.

- Exportación gratuita de datos: Manda tus resultados directo a Excel, Google Sheets, Airtable o Notion—sin pagar extra.

- Extracción de emails, teléfonos e imágenes en un clic: Perfecto para generación de leads o sacar contactos de cualquier web.

- Scraping en la nube o en el navegador: Elige scraping rápido en la nube para sitios públicos o modo navegador para páginas con login.

- Soporta 34 idiomas: Equipos globales, bienvenidos.

Ventajas: Súper fácil, sin código, maneja datos no estructurados y se adapta solo a los cambios en la web. Plan gratis para tareas pequeñas y precios accesibles para necesidades mayores.

Desventajas: No es tan personalizable como las herramientas para desarrolladores en sitios muy complejos. Precios por créditos para usuarios de alto volumen.

Ideal para: Equipos de ventas, operaciones eCommerce, agentes inmobiliarios y cualquiera que quiera pasar de “necesito estos datos” a “ya están en mi hoja de cálculo” en menos de cinco minutos. .

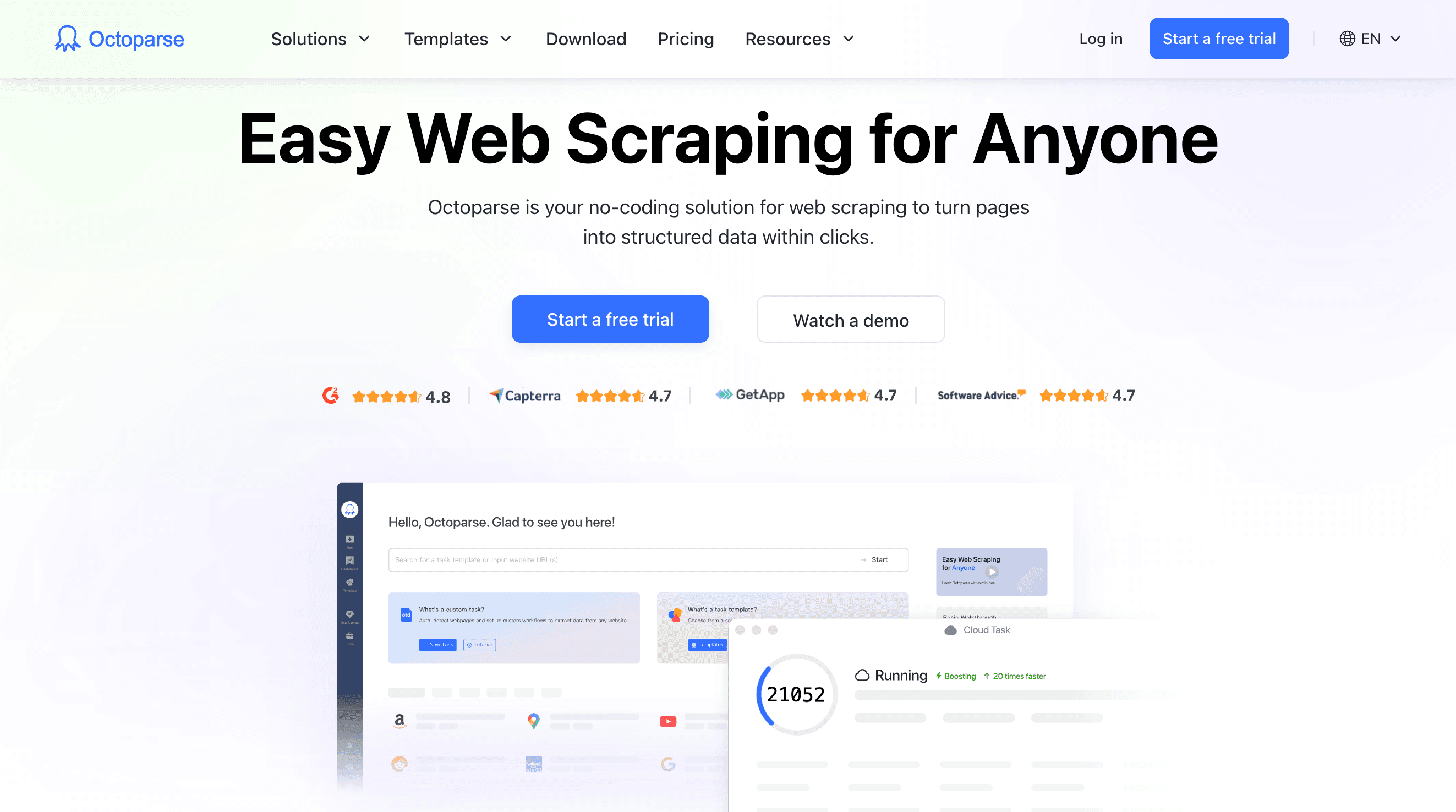

2. Octoparse

es una herramienta potente para equipos de eCommerce e investigación de mercados. Es una app de escritorio sin código (Windows) con constructor visual de flujos y cientos de plantillas para sitios como Amazon, eBay y Zillow.

es una herramienta potente para equipos de eCommerce e investigación de mercados. Es una app de escritorio sin código (Windows) con constructor visual de flujos y cientos de plantillas para sitios como Amazon, eBay y Zillow.

Características principales:

- Interfaz visual: Crea tareas de scraping haciendo clic en los elementos de la página.

- Scraping en la nube y programación: Los planes de pago permiten ejecutar trabajos en la nube y programar extracciones periódicas.

- Rotación de IP y anti-bot: Supera bloqueos con proxies y soluciones de captcha integradas.

- Biblioteca de plantillas: Más de 500 plantillas listas para usar en sitios populares.

- Scraping multinivel y paginado: Navegación compleja y extracción en páginas de detalle.

Ventajas: Ideal para seguimiento de precios a gran escala, análisis de reseñas y monitoreo de eCommerce. No requiere código para la mayoría de tareas.

Desventajas: Solo para escritorio, puede resultar costoso para uso intensivo y tiene curva de aprendizaje en flujos avanzados.

Ideal para: Analistas de eCommerce, investigadores de mercado y quienes necesitan monitorear muchos productos o competidores.

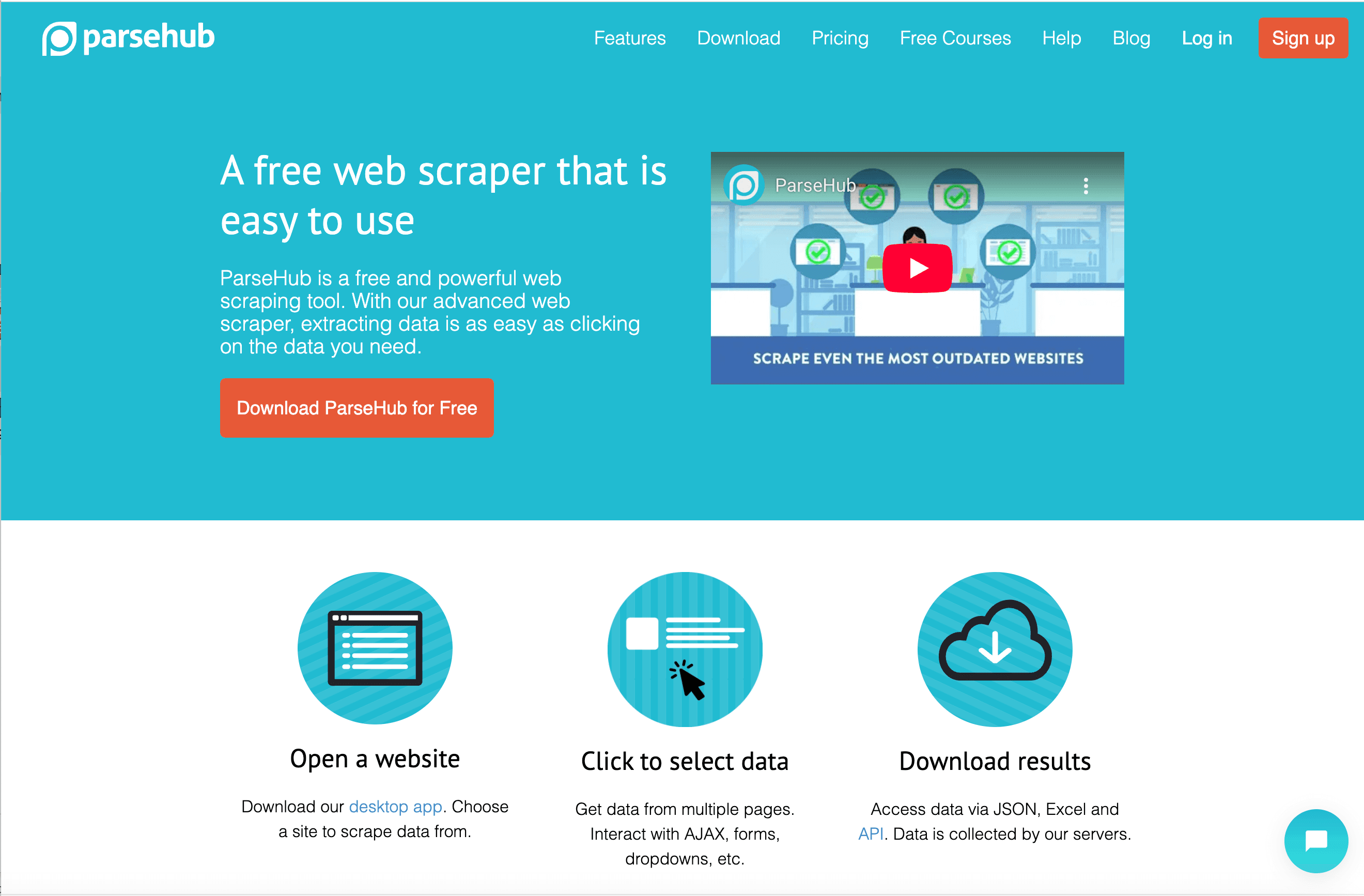

3. ParseHub

es un extractor visual flexible que destaca en sitios dinámicos y con mucho JavaScript. Es una app de escritorio (Windows, Mac, Linux) con constructor de flujos, lógica condicional, JS personalizado y acceso vía API.

es un extractor visual flexible que destaca en sitios dinámicos y con mucho JavaScript. Es una app de escritorio (Windows, Mac, Linux) con constructor de flujos, lógica condicional, JS personalizado y acceso vía API.

Características principales:

- Manejo de contenido dinámico: Funciona con apps de una sola página, AJAX y sitios interactivos.

- Flujos y scripting: Crea procesos de varios pasos, inserta JS personalizado y usa regex para afinar resultados.

- Ejecución local y en la nube: Ejecuta trabajos en tu equipo o en la nube (de pago).

- Acceso API: Integra el scraping en tus apps o automatiza con webhooks.

Ventajas: Muy personalizable para usuarios técnicos, soporta sitios complejos y lógica avanzada.

Desventajas: Más lento en trabajos grandes, curva de aprendizaje moderada y la nube tiene coste adicional.

Ideal para: Analistas técnicos, desarrolladores o quienes necesitan extraer datos de sitios muy interactivos.

4. Import.io

está orientado a integrar datos web en flujos de inteligencia de negocio. Es una plataforma web con interfaz visual, programación y potentes funciones API.

está orientado a integrar datos web en flujos de inteligencia de negocio. Es una plataforma web con interfaz visual, programación y potentes funciones API.

Características principales:

- Detección automática de tablas: Pega una URL y la herramienta intenta extraer datos estructurados automáticamente.

- Programación y detección de cambios: Ejecuta tareas periódicas y recibe alertas cuando los datos cambian.

- Integración API: Obtén datos de forma programática o envíalos a tus herramientas de BI.

- Transformación de datos: Limpia y da formato a los datos dentro de la plataforma.

Ventajas: Fácil de usar, ideal para analistas de negocio y gran integración con herramientas analíticas.

Desventajas: Precio empresarial, limitado en sitios muy interactivos y menos control para usuarios avanzados.

Ideal para: Equipos de investigación de mercado, analistas de negocio y operaciones que necesitan flujos de datos continuos.

5. Scrapy

es el framework open-source de Python favorito de los desarrolladores. Si buscas control total, escalabilidad y crear crawlers a medida, Scrapy es tu mejor aliado.

es el framework open-source de Python favorito de los desarrolladores. Si buscas control total, escalabilidad y crear crawlers a medida, Scrapy es tu mejor aliado.

Características principales:

- Crawling asíncrono: Rápido, eficiente y pensado para proyectos grandes.

- Control total por código: Escribe spiders en Python, personaliza cada paso e integra con cualquier sistema.

- Middleware y plugins: Rota proxies, gestiona logins y amplía funciones con plugins de la comunidad.

- Salida estructurada: Exporta a JSON, CSV, bases de datos o formatos personalizados.

Ventajas: Gratis, muy flexible y con una gran comunidad de soporte.

Desventajas: Requiere conocimientos de Python, sin interfaz gráfica y el mantenimiento depende de ti.

Ideal para: Desarrolladores, ingenieros de datos y quienes integran scraping en sus propias apps o pipelines.

6. Apify

es una plataforma en la nube para ejecutar y compartir scripts de scraping (“Actors”) en JavaScript o Python. Está pensada para automatización, encadenamiento de flujos y escalado en la nube.

es una plataforma en la nube para ejecutar y compartir scripts de scraping (“Actors”) en JavaScript o Python. Está pensada para automatización, encadenamiento de flujos y escalado en la nube.

Características principales:

- Actors y SDK: Escribe scripts personalizados o usa actores preconstruidos de la tienda Apify.

- Automatización con navegador: Extrae datos de sitios dinámicos, gestiona logins y automatiza tareas web.

- Encadenamiento de flujos: Ejecuta actores en secuencia y automatiza procesos de varios pasos.

- API e integraciones: Conecta con Zapier, Make, Google Drive, AWS y más.

Ventajas: Potente para desarrolladores, escalable y excelente para automatizar flujos complejos.

Desventajas: Requiere programación para tareas personalizadas, el precio por uso puede aumentar y tiene curva de aprendizaje.

Ideal para: Startups, equipos de desarrollo y quienes necesitan scraping automatizado y escalable en la nube.

7. Dexi.io

(antes CloudScrape) es una plataforma empresarial para automatizar la recopilación e integración de datos. Permite crear flujos de trabajo de extremo a extremo, desde la extracción hasta la transformación y entrega de datos.

(antes CloudScrape) es una plataforma empresarial para automatizar la recopilación e integración de datos. Permite crear flujos de trabajo de extremo a extremo, desde la extracción hasta la transformación y entrega de datos.

Características principales:

- Diseñador visual de robots: Crea flujos de varios pasos con lógica visual.

- Ejecución en la nube y programación: Ejecuta robots en la nube, programa tareas y gestiona grandes volúmenes.

- Procesamiento e integración de datos: Limpia, transforma y exporta datos a CRMs, bases de datos o APIs.

- Funciones empresariales: Gestión de usuarios, cumplimiento y opciones on-premise.

Ventajas: Escalable, potente para flujos complejos y gran capacidad de integración.

Desventajas: Precio empresarial, no apto para principiantes y requiere formación para uso avanzado.

Ideal para: Grandes organizaciones, equipos de inteligencia de retail y quienes automatizan pipelines de datos complejos.

8. WebHarvy

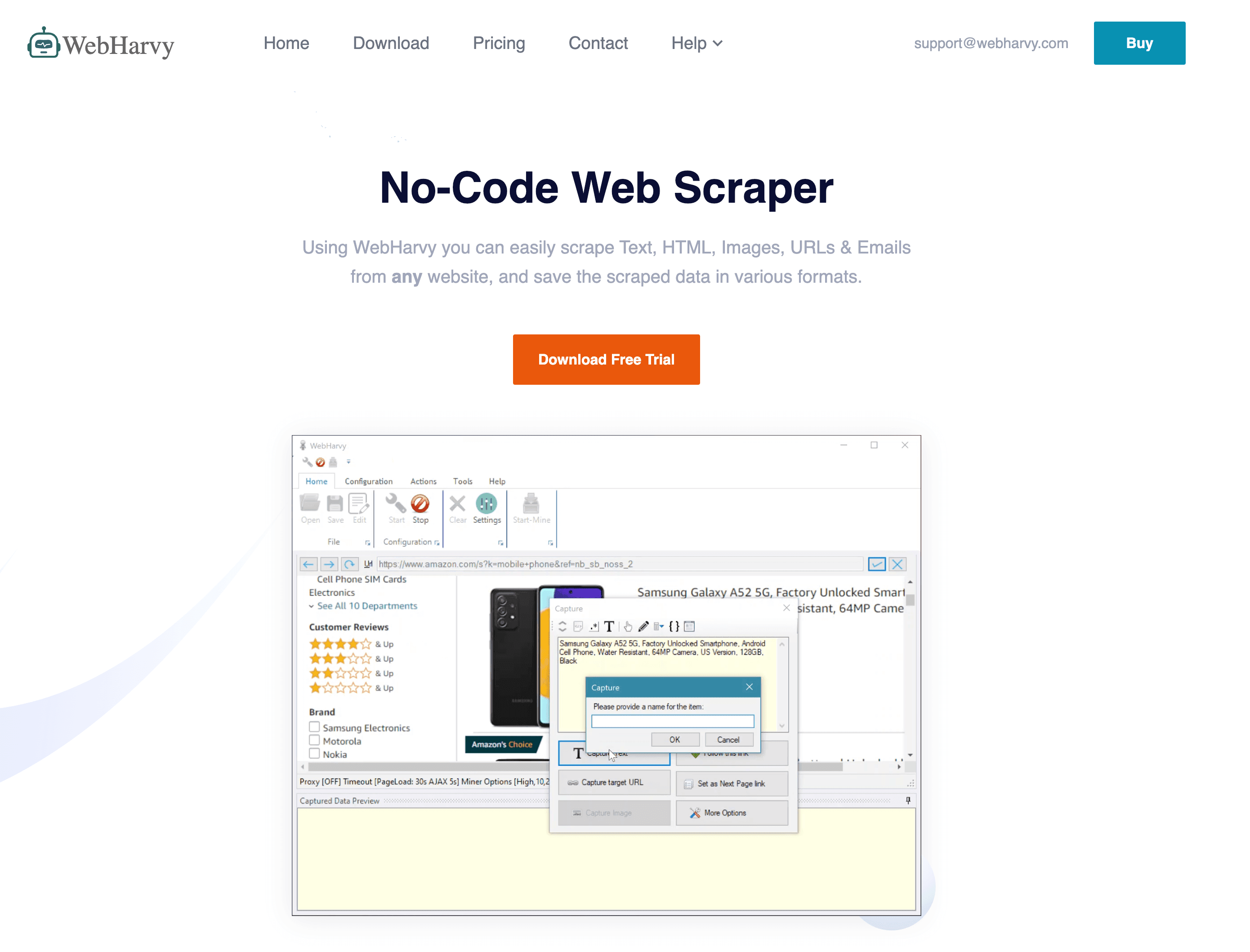

es un extractor de escritorio para Windows conocido por su simplicidad visual y modelo de licencia única.

es un extractor de escritorio para Windows conocido por su simplicidad visual y modelo de licencia única.

Características principales:

- Selección visual: Haz clic en los elementos del navegador integrado para definir los campos.

- Detección automática de patrones: Encuentra listas y tablas automáticamente.

- Descarga de imágenes y archivos: Extrae imágenes y documentos además de texto.

- Programación: Automatiza tareas con el programador de Windows.

Ventajas: Coste único asequible, fácil para sitios simples y funciona sin conexión.

Desventajas: Dificultad con sitios con mucho JavaScript o anti-bots, solo para Windows y personalización limitada.

Ideal para: Pymes, investigadores y quienes buscan una solución económica y sencilla para sitios estáticos.

9. Data Miner

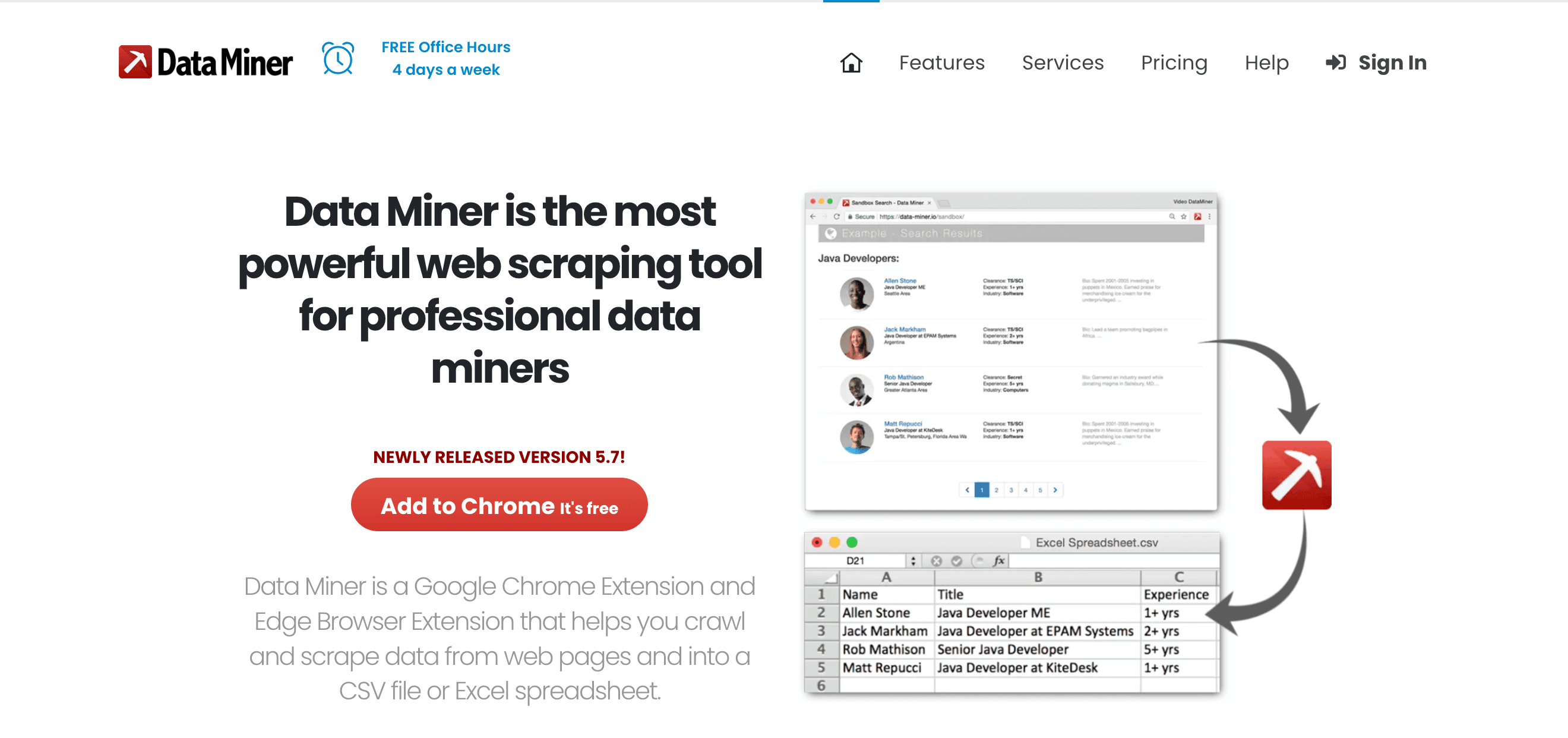

es una extensión para Chrome/Edge perfecta para extracciones rápidas y basadas en plantillas, especialmente para equipos de ventas y operaciones.

es una extensión para Chrome/Edge perfecta para extracciones rápidas y basadas en plantillas, especialmente para equipos de ventas y operaciones.

Características principales:

- Más de 60,000 recetas públicas: Scraping de un clic para sitios populares.

- Constructor visual de recetas: Crea tus propias reglas de extracción.

- Extracción instantánea de tablas: Captura tablas o listas HTML en segundos.

- Exportación directa: Envía datos a Google Sheets, Excel o CSV.

Ventajas: Rápido, basado en navegador, sin código y excelente para sitios con login.

Desventajas: Limitado por la velocidad del navegador, límites de páginas en planes gratuitos/pagos y no ideal para trabajos masivos.

Ideal para: Prospección de ventas, tareas de investigación rápidas y quienes quieren un botón de “Exportar a Excel” para la web.

10. Visual Web Ripper

(https://strapi.thunderbit.com/uploads/helium_1d0161c406.png)

es una solución de escritorio integral para extracción de datos web a gran escala, enfocada en proyectos basados en plantillas y automatización.

(https://strapi.thunderbit.com/uploads/helium_1d0161c406.png)

es una solución de escritorio integral para extracción de datos web a gran escala, enfocada en proyectos basados en plantillas y automatización.

Características principales:

- Sistema de plantillas y proyectos: Diseña crawls multinivel con plantillas.

- Opciones avanzadas: Regex, XPath y herramientas de depuración para sitios complejos.

- Exportación a bases de datos: Salida directa a SQL, Excel, XML y más.

- Automatización: Programa tareas y ejecuta extracciones multihilo.

Ventajas: Potente para sitios estáticos complejos, licencia única y soporta lógica avanzada.

Desventajas: Interfaz anticuada, solo para Windows y menos soporte para sitios dinámicos modernos.

Ideal para: Consultores, agencias y usuarios avanzados que gestionan grandes proyectos estructurados de scraping.

11. Helium Scraper

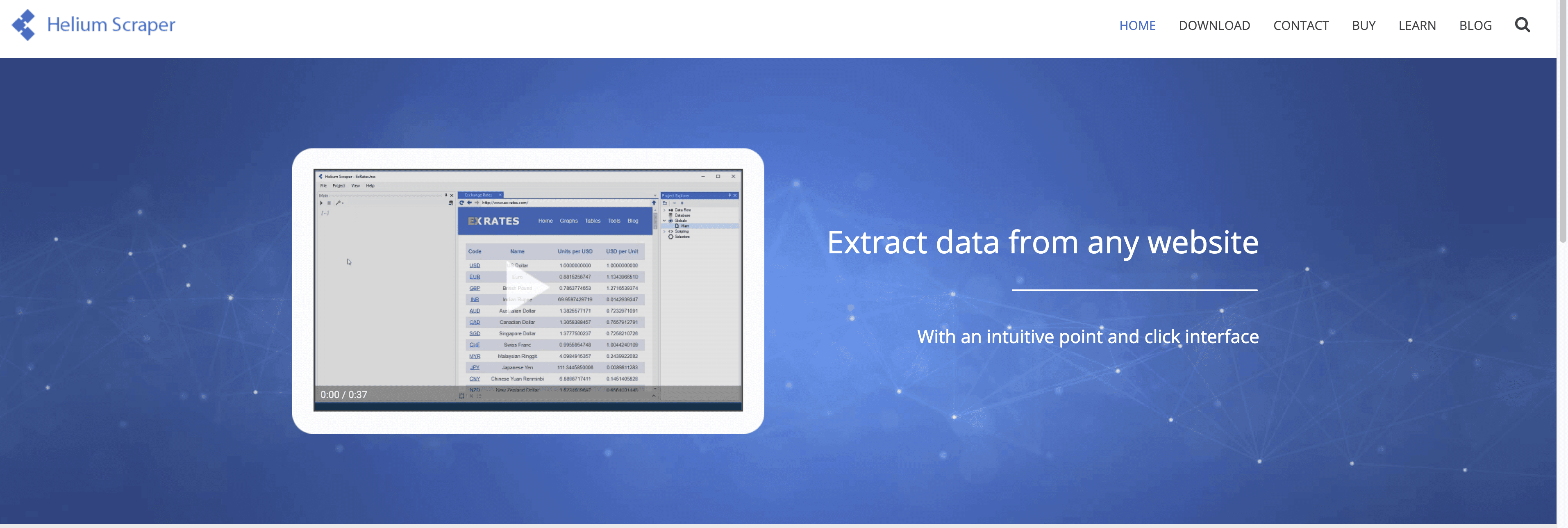

es una app para Windows que combina la simplicidad de arrastrar y soltar con una personalización profunda.

es una app para Windows que combina la simplicidad de arrastrar y soltar con una personalización profunda.

Características principales:

- Modelo de tipos y acciones: Define patrones de datos visualmente y configura acciones para extraerlos.

- Datos multinivel y relacionales: Exporta relaciones padre-hijo y ejecuta consultas SQL sobre los datos extraídos.

- Scripting personalizado: Inserta JavaScript o SQL para lógica avanzada.

- Multihilo: Extrae múltiples páginas en paralelo para mayor velocidad.

Ventajas: Flexible, soporta estructuras de datos complejas y precio único asequible.

Desventajas: Curva de aprendizaje para el concepto de “Tipos”, solo para Windows y menos soporte general.

Ideal para: Analistas y entusiastas técnicos que buscan más potencia que las herramientas básicas pero no quieren programar desde cero.

12. Content Grabber

es una plataforma empresarial para extracción y automatización de datos a gran escala.

es una plataforma empresarial para extracción y automatización de datos a gran escala.

Características principales:

- Editor visual de agentes: Crea agentes de scraping visualmente y añade lógica personalizada en C# o VB.NET.

- Programación y monitoreo empresarial: Control centralizado, manejo de errores y notificaciones.

- Implementación on-premise: Mantén los datos en tu infraestructura para cumplir normativas.

- API e integración: Exporta a bases de datos, APIs y colas de mensajes.

Ventajas: Extremadamente potente, escalable y diseñada para flujos críticos de negocio.

Desventajas: Costosa, compleja y pensada para organizaciones con recursos IT dedicados.

Ideal para: Grandes empresas, proveedores de datos y quienes consideran la extracción web como proceso central del negocio.

¿Qué extractor de datos es el adecuado para ti? Casos de uso y recomendaciones

- Generación de leads de ventas: (IA, exportación fácil), (en navegador, recetas rápidas).

- Monitoreo de eCommerce: (plantillas, programación), (empresarial, integración).

- Personalización técnica: (Python, open-source), (nube, automatización de flujos), (visual, sitios dinámicos).

- Integración y automatización de datos: (flujos BI), (empresarial, on-premise).

- Tareas rápidas y pequeñas: (visual, coste único), (drag-and-drop, lógica personalizada).

Tip: Casi todas las herramientas tienen prueba o plan gratis—prueba varias con tu caso real antes de decidirte.

Conclusión: maximiza tu eficiencia con el extractor de datos adecuado

Los días de pelearte con datos a mano están contados. Con el extractor de datos correcto, puedes automatizar horas de trabajo repetitivo, mejorar la precisión y tomar mejores decisiones—ya seas emprendedor, parte de un equipo de ventas o gerente de operaciones en una gran empresa. La clave está en elegir la herramienta que se adapte a tu caso, nivel técnico y presupuesto.

Si buscas el camino más rápido de “necesito estos datos” a “ya están en mi hoja de cálculo”, es un excelente punto de partida. Pero sea cual sea tu necesidad, en esta lista hay una herramienta que te ayudará a trabajar más inteligente.

¿Listo para llevar tus datos al siguiente nivel? Prueba algunos de estos extractores y descubre cuánto tiempo (y estrés) puedes ahorrarte.

Preguntas frecuentes

1. ¿Qué es un extractor de datos y por qué lo necesito?

Un extractor de datos es una herramienta que automatiza la recopilación de información estructurada desde sitios web, documentos o bases de datos. Te ahorra tiempo, reduce errores y te permite enfocarte en el análisis en vez de copiar y pegar manualmente.

2. ¿Cuál es el mejor extractor de datos para usuarios sin experiencia técnica?

destaca por su configuración con IA en dos clics y prompts en lenguaje natural. Está pensado para usuarios de negocio que quieren resultados sin programar ni configuraciones complejas.

3. ¿Pueden los extractores de datos manejar sitios dinámicos o con mucho JavaScript?

Sí—herramientas como , y (con soporte de navegador sin cabeza) son excelentes para extraer contenido dinámico e interactivo.

4. ¿Cómo elijo entre un extractor de datos gratuito y uno de pago?

Las herramientas gratuitas son ideales para tareas pequeñas y ocasionales. Para trabajos continuos, a gran escala o críticos, los planes de pago ofrecen más funciones, mayores límites y mejor soporte. Siempre prueba primero con la versión gratuita.

5. ¿Es legal usar extractores de datos?

En general, extraer datos públicos es legal, pero siempre revisa los términos de uso del sitio y respeta las leyes de privacidad. Para datos sensibles o personales, asegúrate de cumplir normativas como el GDPR.

¿Quieres más consejos sobre scraping web, automatización y productividad? Visita el para guías, tutoriales y lo último en extracción de datos con IA.

Más información