Seamos realistas: Amazon es como el gran hipermercado digital donde encuentras de todo, desde gadgets hasta productos de uso diario. Si trabajas en ventas, e-commerce o en operaciones, ya sabes que lo que pasa en Amazon termina afectando tus precios, tu stock y hasta el lanzamiento de ese producto que tienes en mente. Pero aquí viene el lío: toda esa información valiosa sobre productos, precios, valoraciones y reseñas está escondida detrás de una interfaz pensada para compradores, no para equipos que necesitan datos. Entonces, ¿cómo puedes acceder a esos datos sin pasarte el finde copiando y pegando como si estuviéramos en los 90?

Aquí es donde entra el web scraping. En esta guía te voy a mostrar dos caminos para sacar datos de productos de Amazon: el clásico, programando tu propio script en Python, y el moderno, dejando que la IA haga el trabajo pesado con un raspador web sin código como . Te voy a enseñar código Python real (con trucos y soluciones), y después te muestro cómo Thunderbit consigue los mismos datos en un par de clics, sin programar nada. Seas desarrollador, analista de negocio o simplemente alguien cansado de picar datos a mano, aquí tienes la solución.

¿Por qué extraer datos de productos de Amazon? (amazon scraper python, web scraping con python)

Amazon no es solo el gigante de las ventas online, también es el mayor mercado abierto para inteligencia competitiva. Con y , Amazon es una mina de oro para quienes buscan:

- Monitorizar precios (y ajustar los tuyos al vuelo)

- Analizar a la competencia (seguir lanzamientos, valoraciones y reseñas)

- Generar leads (encontrar vendedores, proveedores o socios)

- Prever la demanda (viendo stock y rankings de ventas)

- Detectar tendencias de mercado (analizando reseñas y resultados de búsqueda)

Y esto no es solo teoría: las empresas ya están viendo resultados. Por ejemplo, un minorista de electrónica usó datos de precios extraídos de Amazon para , mientras que otra marca logró tras automatizar el seguimiento de precios de la competencia.

Aquí tienes una tabla rápida de casos de uso y el tipo de retorno que puedes esperar:

| Caso de Uso | Quién lo usa | ROI / Beneficio típico |

|---|---|---|

| Monitorización de Precios | E-commerce, Operaciones | +15% margen, +4% ventas, -30% tiempo de análisis |

| Análisis de Competencia | Ventas, Producto, Operaciones | Ajustes de precio más rápidos, mayor competitividad |

| Investigación de Mercado (Reseñas) | Producto, Marketing | Iteración de producto más ágil, mejores anuncios, insights SEO |

| Generación de Leads | Ventas | 3.000+ leads/mes, 8+ horas ahorradas por comercial/semana |

| Inventario y Previsión de Demanda | Operaciones, Cadena de Suministro | -20% sobrestock, menos roturas de stock |

| Detección de Tendencias | Marketing, Dirección | Detección temprana de productos y categorías en auge |

Y aquí va el dato clave: ya reportan valor medible gracias al análisis de datos. Si no estás extrayendo datos de Amazon, estás dejando insights (y dinero) sobre la mesa.

Resumen: Amazon Scraper Python vs. Herramientas No Code de Raspado Web

Hay dos formas principales de sacar datos de Amazon del navegador y llevarlos a tus hojas de cálculo o dashboards:

-

Amazon Scraper Python (web scraping con python):

Escribe tu propio script usando librerías de Python como Requests y BeautifulSoup. Tienes control total, pero necesitas saber programar, lidiar con medidas anti-bot y mantener tu script cuando Amazon cambie su web.

-

Herramientas No Code de Raspado Web (como Thunderbit):

Usa una herramienta que te permite seleccionar y extraer datos con solo unos clics, sin programar. Herramientas modernas como incluso usan IA para identificar los datos, manejar subpáginas y paginación, y exportar directamente a Excel o Google Sheets.

Así se comparan:

| Criterio | Python Scraper | No Code (Thunderbit) |

|---|---|---|

| Tiempo de Configuración | Alto (instalar, programar, depurar) | Bajo (instalar extensión) |

| Habilidad Necesaria | Requiere programación | Ninguna (seleccionar y hacer clic) |

| Flexibilidad | Ilimitada | Alta para casos comunes |

| Mantenimiento | Lo haces tú | La herramienta se actualiza sola |

| Anti-bot | Tú gestionas proxies, headers | Integrado, lo gestiona la herramienta |

| Escalabilidad | Manual (hilos, proxies) | Raspado en la nube, paralelizado |

| Exportación de Datos | Personalizado (CSV, Excel, BD) | Un clic a Excel, Sheets |

| Coste | Gratis (tu tiempo + proxies) | Freemium, pagas por escala |

En las siguientes secciones te guío por ambos caminos: primero, cómo crear un raspador de Amazon en Python (con código real), y luego cómo hacer lo mismo con el Raspador Web IA de Thunderbit.

Primeros Pasos con Amazon Scraper Python: Requisitos y Configuración

Antes de meterte en el código, prepara tu entorno.

Vas a necesitar:

- Python 3.x (descárgalo de )

- Un editor de código (VS Code, o el que más te guste)

- Estas librerías:

requests(para peticiones HTTP)beautifulsoup4(para analizar HTML)lxml(parser HTML rápido)pandas(tablas/exportación de datos)re(expresiones regulares, incluida en Python)

Instala las librerías:

1pip install requests beautifulsoup4 lxml pandasConfigura tu proyecto:

- Crea una carpeta nueva para tu proyecto.

- Abre tu editor y crea un archivo Python (por ejemplo,

amazon_scraper.py). - ¡Listo para arrancar!

Paso a Paso: Web Scraping con Python para Datos de Productos de Amazon

Vamos a extraer datos de una página de producto de Amazon. (No te preocupes, luego veremos cómo hacerlo con múltiples productos y páginas).

1. Enviar Peticiones y Obtener el HTML

Primero, obtenemos el HTML de una página de producto. (Cambia la URL por cualquier producto de Amazon).

1import requests

2url = "<https://www.amazon.com/dp/B0ExampleASIN>"

3response = requests.get(url)

4html_content = response.text

5print(response.status_code)Ojo: Esta petición básica probablemente será bloqueada por Amazon. Puedes ver un error 503 o un CAPTCHA en vez de la página. ¿Por qué? Porque Amazon detecta que no eres un navegador real.

Cómo Evitar los Filtros Anti-Bot de Amazon

Amazon no quiere bots. Para evitar bloqueos, debes:

- Configurar un User-Agent (simular ser Chrome o Firefox)

- Rotar User-Agents (no uses siempre el mismo)

- Espaciar tus peticiones (añade retrasos aleatorios)

- Usar proxies (si vas a gran escala)

Así se añaden headers:

1headers = {

2 "User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64)... Safari/537.36",

3 "Accept-Language": "en-US,en;q=0.9",

4}

5response = requests.get(url, headers=headers)¿Quieres ir más allá? Usa una lista de User-Agents y rota en cada petición. Para grandes volúmenes, usa un servicio de proxies, pero para scraping pequeño, headers y retrasos suelen bastar.

Extrayendo los Campos Clave del Producto

Con el HTML en mano, toca analizarlo con BeautifulSoup.

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html_content, "lxml")Ahora, extrae lo importante:

Título del Producto

1title_elem = soup.find(id="productTitle")

2product_title = title_elem.get_text(strip=True) if title_elem else NonePrecio

El precio puede estar en varios lugares. Prueba esto:

1price = None

2price_elem = soup.find(id="priceblock_ourprice") or soup.find(id="priceblock_dealprice")

3if price_elem:

4 price = price_elem.get_text(strip=True)

5else:

6 price_whole = soup.find("span", {"class": "a-price-whole"})

7 price_frac = soup.find("span", {"class": "a-price-fraction"})

8 if price_whole and price_frac:

9 price = price_whole.text + price_frac.textValoración y Número de Reseñas

1rating_elem = soup.find("span", {"class": "a-icon-alt"})

2rating = rating_elem.get_text(strip=True) if rating_elem else None

3review_count_elem = soup.find(id="acrCustomerReviewText")

4reviews_text = review_count_elem.get_text(strip=True) if review_count_elem else ""

5reviews_count = reviews_text.split()[0] # ej: "1,554 valoraciones"URL de la Imagen Principal

A veces Amazon esconde imágenes en JSON dentro del HTML. Aquí un truco con regex:

1import re

2match = re.search(r'"hiRes":"(https://.*?.jpg)"', html_content)

3main_image_url = match.group(1) if match else NoneO bien, toma la etiqueta principal de imagen:

1img_tag = soup.find("img", {"id": "landingImage"})

2img_url = img_tag['src'] if img_tag else NoneDetalles del Producto

Especificaciones como marca, peso y dimensiones suelen estar en una tabla:

1details = {}

2rows = soup.select("#productDetails_techSpec_section_1 tr")

3for row in rows:

4 header = row.find("th").get_text(strip=True)

5 value = row.find("td").get_text(strip=True)

6 details[header] = valueO si Amazon usa el formato “detailBullets”:

1bullets = soup.select("#detailBullets_feature_div li")

2for li in bullets:

3 txt = li.get_text(" ", strip=True)

4 if ":" in txt:

5 key, val = txt.split(":", 1)

6 details[key.strip()] = val.strip()Imprime tus resultados:

1print("Título:", product_title)

2print("Precio:", price)

3print("Valoración:", rating, "basado en", reviews_count, "reseñas")

4print("URL imagen principal:", main_image_url)

5print("Detalles:", details)Scraping de Múltiples Productos y Paginación

Un producto está bien, pero seguro quieres una lista. Así se extraen enlaces de productos y varias páginas.

Obtener Enlaces de Productos de una Búsqueda

1search_url = "<https://www.amazon.com/s?k=bluetooth+headphones>"

2res = requests.get(search_url, headers=headers)

3soup = BeautifulSoup(res.text, "lxml")

4product_links = []

5for a in soup.select("h2 a.a-link-normal"):

6 href = a['href']

7 full_url = "<https://www.amazon.com>" + href

8 product_links.append(full_url)Manejar la Paginación

Las URLs de búsqueda de Amazon usan &page=2, &page=3, etc.

1for page in range(1, 6): # primeras 5 páginas

2 search_url = f"<https://www.amazon.com/s?k=bluetooth+headphones&page={page}>"

3 res = requests.get(search_url, headers=headers)

4 if res.status_code != 200:

5 break

6 soup = BeautifulSoup(res.text, "lxml")

7 # ... extraer enlaces como antes ...Recorrer Productos y Exportar a CSV

Guarda los datos en una lista de diccionarios y usa pandas:

1import pandas as pd

2df = pd.DataFrame(product_data_list) # lista de dicts

3df.to_csv("amazon_products.csv", index=False)O a Excel:

1df.to_excel("amazon_products.xlsx", index=False)Buenas Prácticas para Proyectos de Amazon Scraper Python

Seamos sinceros: Amazon cambia su web y pelea contra los scrapers. Así mantienes tu proyecto funcionando:

- Rota headers y User-Agents (usa librerías como

fake-useragent) - Usa proxies para scraping a gran escala

- Espacia las peticiones (retrasos aleatorios con

time.sleep()) - Gestiona errores (reintenta en 503, espera si te bloquean)

- Parsing flexible (busca varios selectores por campo)

- Monitorea cambios en el HTML (si tu script devuelve

None, revisa la página) - Respeta robots.txt (Amazon prohíbe scraping en muchas secciones: actúa responsablemente)

- Limpia los datos sobre la marcha (quita símbolos de moneda, comas, espacios)

- Conéctate con la comunidad (foros, Stack Overflow, Reddit r/webscraping)

Checklist para mantener tu scraper:

- [ ] Rotar User-Agents y headers

- [ ] Usar proxies si raspas a escala

- [ ] Añadir retrasos aleatorios

- [ ] Modularizar el código para actualizaciones fáciles

- [ ] Monitorizar bloqueos o CAPTCHAs

- [ ] Exportar datos regularmente

- [ ] Documentar selectores y lógica

Para profundizar, revisa mi .

Alternativa Sin Código: Extraer Datos de Amazon con Thunderbit AI Web Scraper

Ya viste cómo hacerlo con Python. Pero, ¿y si no quieres programar o solo quieres los datos en dos clics y seguir con tu día? Aquí es donde entra .

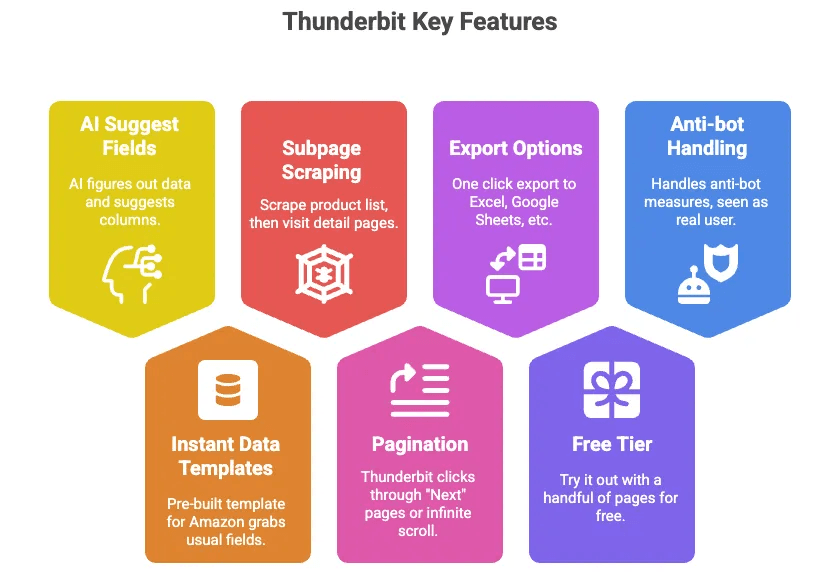

Thunderbit es una extensión de Chrome que funciona como un Raspador Web IA y te permite extraer datos de productos de Amazon (y de casi cualquier web) sin escribir código. ¿Por qué me mola tanto?

- Sugerencia de Campos con IA: Solo haz clic y la IA de Thunderbit detecta los datos de la página y sugiere columnas (como Título, Precio, Valoración, etc.).

- Plantillas Instantáneas: Para Amazon, hay una plantilla preconfigurada que extrae todos los campos habituales, sin configurar nada.

- Raspado de Subpáginas: Extrae una lista de productos y deja que Thunderbit visite cada página de detalle para obtener más información automáticamente.

- Paginación: Thunderbit puede avanzar por las páginas de resultados o hacer scroll infinito por ti.

- Exporta a Excel, Google Sheets, Airtable, Notion: Un clic y tus datos están listos para usar.

- Versión gratuita: Prueba con varias páginas sin coste.

- Gestión anti-bot automática: Al ejecutarse en tu navegador (o en la nube), Amazon lo ve como un usuario real.

Paso a Paso: Usar Thunderbit para Extraer Datos de Productos de Amazon

Así de sencillo es:

-

Instala Thunderbit:

Descarga la e inicia sesión.

-

Abre Amazon:

Ve a la página de Amazon que quieras extraer (resultados de búsqueda, detalle de producto, etc.).

-

Haz clic en “Sugerir Campos con IA” o usa una plantilla:

Thunderbit sugerirá columnas para extraer (o puedes elegir la plantilla de Producto de Amazon).

-

Revisa las columnas:

Ajusta las columnas si lo deseas (añade/elimina campos, renombra, etc.).

-

Haz clic en “Extraer”:

Thunderbit recoge los datos y los muestra en una tabla.

-

Gestiona Subpáginas y Paginación:

Si extrajiste una lista, haz clic en “Extraer Subpáginas” para que Thunderbit visite cada detalle de producto y obtenga más información. También puede avanzar automáticamente por las páginas.

-

Exporta tus datos:

Haz clic en “Exportar a Excel” o “Exportar a Google Sheets”. ¡Listo!

-

(Opcional) Programa extracciones:

¿Necesitas estos datos a diario? Usa el programador de Thunderbit para automatizarlo.

Eso es todo. Sin código, sin depurar, sin proxies, sin dolores de cabeza. Para ver cómo funciona, visita el o la .

Amazon Scraper Python vs. Raspador Web Sin Código: Comparativa Directa

Resumamos todo:

| Criterio | Python Scraper | Thunderbit (Sin Código) |

|---|---|---|

| Tiempo de Configuración | Alto (instalar, programar, depurar) | Bajo (instalar extensión) |

| Habilidad Necesaria | Requiere programación | Ninguna (seleccionar y hacer clic) |

| Flexibilidad | Ilimitada | Alta para casos comunes |

| Mantenimiento | Lo haces tú | La herramienta se actualiza sola |

| Anti-bot | Tú gestionas proxies, headers | Integrado, lo gestiona la herramienta |

| Escalabilidad | Manual (hilos, proxies) | Raspado en la nube, paralelizado |

| Exportación de Datos | Personalizado (CSV, Excel, BD) | Un clic a Excel, Sheets |

| Coste | Gratis (tu tiempo + proxies) | Freemium, pagas por escala |

| Mejor para | Desarrolladores, necesidades personalizadas | Usuarios de negocio, resultados rápidos |

Si eres desarrollador y necesitas algo muy personalizado, Python es tu mejor amigo. Si buscas rapidez, facilidad y cero código, Thunderbit es la opción ganadora.

¿Cuándo elegir Python, No Code o Raspador Web IA para Amazon?

Elige Python si:

- Necesitas lógica personalizada o integrar el scraping en sistemas propios

- Vas a extraer datos a gran escala (decenas de miles de productos)

- Quieres aprender cómo funciona el scraping por dentro

Elige Thunderbit (sin código, Raspador Web IA) si:

- Quieres datos rápido, sin programar

- Eres usuario de negocio, analista o marketer

- Quieres que tu equipo pueda extraer datos por sí mismo

- Quieres evitar líos con proxies, anti-bot y mantenimiento

Usa ambos si:

- Quieres prototipar rápido con Thunderbit y luego crear una solución Python para producción

- Usas Thunderbit para recolectar datos y Python para limpiar/analizar

Para la mayoría de usuarios de negocio, Thunderbit cubre el 90% de las necesidades de scraping de Amazon en una fracción del tiempo. Para el 10% restante—casos muy personalizados, a gran escala o integrados—Python sigue siendo el rey.

Conclusión y Puntos Clave

Extraer datos de productos de Amazon es una ventaja competitiva para cualquier equipo de ventas, e-commerce u operaciones. Ya sea para seguir precios, analizar a la competencia o ahorrar horas de copiar y pegar, hay una solución para ti.

- El scraping con Python te da control total, pero requiere aprendizaje y mantenimiento.

- Los raspadores web sin código como Thunderbit hacen que la extracción de datos de Amazon sea accesible para todos: sin código, sin complicaciones, solo resultados.

- ¿La mejor estrategia? Usa la herramienta que se adapte a tus habilidades, plazos y objetivos de negocio.

Si tienes curiosidad, prueba Thunderbit: es gratis para empezar y te sorprenderá lo rápido que puedes conseguir los datos que necesitas. Y si eres desarrollador, no dudes en combinar ambos enfoques: a veces lo más rápido es dejar que la IA haga el trabajo aburrido por ti.

Preguntas Frecuentes

1. ¿Por qué una empresa querría extraer datos de productos de Amazon?

Extraer datos de Amazon permite a las empresas monitorizar precios, analizar a la competencia, recopilar reseñas para investigación de productos, prever la demanda y generar leads de ventas. Con más de 600 millones de productos y casi 2 millones de vendedores, Amazon es una fuente inagotable de inteligencia competitiva.

2. ¿Cuáles son las principales diferencias entre usar Python y herramientas sin código como Thunderbit para extraer datos de Amazon?

Los scrapers en Python ofrecen máxima flexibilidad pero requieren conocimientos de programación, tiempo de configuración y mantenimiento. Thunderbit, un raspador web IA sin código, permite extraer datos de Amazon al instante desde una extensión de Chrome—sin programar, con anti-bot integrado y exportación directa a Excel o Sheets.

3. ¿Es legal extraer datos de Amazon?

Los términos de servicio de Amazon generalmente prohíben el scraping y aplican medidas anti-bot. Sin embargo, muchas empresas extraen datos públicos actuando de forma responsable, respetando límites de velocidad y evitando peticiones excesivas.

4. ¿Qué tipo de datos puedo extraer de Amazon con herramientas de web scraping?

Campos habituales incluyen títulos de productos, precios, valoraciones, número de reseñas, imágenes, especificaciones, disponibilidad e incluso información de vendedores. Thunderbit también permite extraer subpáginas y paginación para capturar datos de múltiples listados y páginas.

5. ¿Cuándo debería elegir scraping con Python frente a una herramienta como Thunderbit (o viceversa)?

Usa Python si necesitas control total, lógica personalizada o integrar el scraping en sistemas propios. Usa Thunderbit si quieres resultados rápidos sin programar, necesitas escalar fácilmente o buscas una solución de bajo mantenimiento para usuarios de negocio.

¿Quieres profundizar? Mira estos recursos:

¡Feliz scraping! Que tus hojas de cálculo siempre estén al día.