Το ίντερνετ πλέον δεν είναι απλά ένας χώρος για να χαζεύεις ή να περνάς την ώρα σου—είναι η μεγαλύτερη πηγή δεδομένων που υπάρχει, και όλοι, από πωλητές μέχρι αναλυτές αγοράς, προσπαθούν να το αξιοποιήσουν στο έπακρο. Ας το παραδεχτούμε: το να μαζεύεις δεδομένα από το διαδίκτυο με το χέρι είναι τόσο ευχάριστο όσο να προσπαθείς να φτιάξεις έπιπλα IKEA χωρίς οδηγίες και με βίδες που λείπουν. Καθώς οι εταιρείες βασίζονται όλο και περισσότερο σε δεδομένα σε πραγματικό χρόνο για να πάρουν αποφάσεις, να ρυθμίσουν τιμές ή να βρουν νέους πελάτες, η ανάγκη για γρήγορα και αξιόπιστα εργαλεία συλλογής δεδομένων είναι μεγαλύτερη από ποτέ. Μάλιστα, σχεδόν για να πάρει αποφάσεις, ενώ η παγκόσμια αγορά web scraping προβλέπεται να .

Αν έχεις βαρεθεί το ατελείωτο copy-paste, νιώθεις ότι χάνεις ευκαιρίες ή απλά θες να δεις τι μπορεί να κάνει η αυτοματοποίηση για σένα, είσαι στο σωστό μέρος. Έχω περάσει χρόνια φτιάχνοντας και δοκιμάζοντας εργαλεία συλλογής δεδομένων (και ναι, είμαι επικεφαλής της ομάδας του ), οπότε ξέρω από πρώτο χέρι πώς το σωστό εργαλείο μπορεί να μετατρέψει ώρες βαρετής δουλειάς σε υπόθεση δύο κλικ. Είτε είσαι αρχάριος χωρίς γνώσεις προγραμματισμού είτε developer που θέλει να έχει τον απόλυτο έλεγχο, αυτή η λίστα με τα 10 καλύτερα εργαλεία συλλογής δεδομένων θα σε βοηθήσει να βρεις αυτό που σου ταιριάζει.

Γιατί έχει σημασία να διαλέξεις το σωστό εργαλείο συλλογής δεδομένων

Ας το πούμε απλά: η διαφορά ανάμεσα σε ένα καλό και ένα μέτριο εργαλείο συλλογής δεδομένων δεν είναι μόνο η ευκολία—είναι το αν η επιχείρησή σου θα πάει μπροστά ή θα μείνει πίσω. Με την αυτοματοποίηση της συλλογής δεδομένων, δεν κερδίζεις μόνο χρόνο (ένας χρήστης στο G2 είπε ), αλλά μειώνεις τα λάθη, βρίσκεις νέες ευκαιρίες και εξασφαλίζεις ότι η ομάδα σου δουλεύει πάντα με τα πιο φρέσκα και ακριβή δεδομένα. Η χειροκίνητη έρευνα είναι αργή, γεμάτη λάθη και συχνά ξεπερασμένη πριν καν τελειώσεις. Με το σωστό εργαλείο, μπορείς να παρακολουθείς ανταγωνιστές, να ελέγχεις τιμές ή να φτιάχνεις λίστες leads σε λίγα λεπτά—όχι μέρες.

Για παράδειγμα, μια εταιρεία καλλυντικών χρησιμοποίησε web scraping για να παρακολουθεί αποθέματα και τιμές ανταγωνιστών, . Αυτό δεν το πετυχαίνεις με απλά Excel και χειροκίνητη δουλειά.

Πώς διαλέξαμε τα καλύτερα εργαλεία συλλογής δεδομένων

Με τόσες επιλογές εκεί έξω, το να βρεις το κατάλληλο εργαλείο μοιάζει με speed-dating σε τεχνολογικό event. Αυτά είναι τα βασικά κριτήρια που χρησιμοποίησα για να ξεχωρίσω τα κορυφαία:

- Ευκολία χρήσης: Μπορείς να ξεκινήσεις χωρίς να ξέρεις Python; Υπάρχει οπτικό περιβάλλον ή βοήθεια AI για όσους δεν είναι προγραμματιστές;

- Δυνατότητες αυτοματοποίησης: Διαχειρίζεται σελιδοποίηση, υποσελίδες, δυναμικό περιεχόμενο και προγραμματισμό; Μπορεί να τρέξει στο cloud για μεγάλα projects;

- Τιμολόγηση και κλιμάκωση: Υπάρχει δωρεάν πλάνο ή οικονομική αρχική επιλογή; Πόσο ανεβαίνει το κόστος όσο μεγαλώνουν οι ανάγκες σου;

- Λειτουργίες και ενσωμάτωση: Μπορείς να εξάγεις σε Excel, Google Sheets ή μέσω API; Υπάρχουν έτοιμα templates, προγραμματισμός ή ενσωματωμένος καθαρισμός δεδομένων;

- Για ποιον είναι κατάλληλο: Σε ποιους απευθύνεται—επαγγελματίες, developers ή μεγάλες ομάδες;

Στο τέλος θα βρεις έναν συγκριτικό πίνακα για να δεις πώς συγκρίνονται τα εργαλεία μεταξύ τους.

Πάμε να δούμε τα 10 καλύτερα εργαλεία συλλογής δεδομένων για αποδοτική εξαγωγή το 2025.

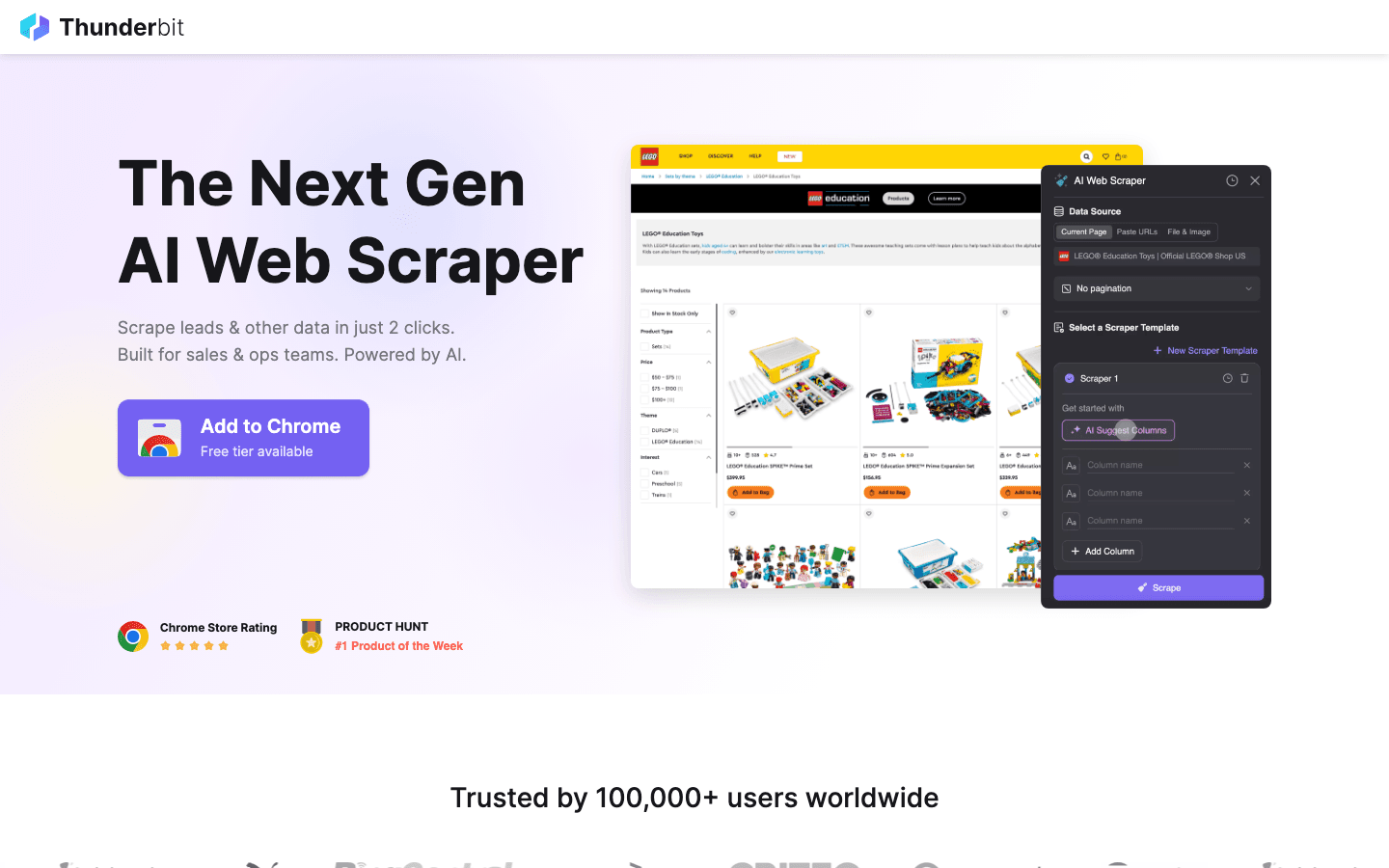

1. Thunderbit

Το είναι η πρώτη μου επιλογή για όσους θέλουν να μαζεύουν δεδομένα τόσο εύκολα όσο να παραγγέλνουν φαγητό από το κινητό. Ως επέκταση Chrome με τεχνητή νοημοσύνη, το Thunderbit προσφέρει εξαγωγή δεδομένων με 2 κλικ: πατάς "AI Προτείνει Πεδία" και η AI βρίσκει τα δεδομένα της σελίδας, μετά "Scrape" για να τα μαζέψεις. Χωρίς κώδικα, χωρίς μπελάδες—μόνο άμεσα αποτελέσματα.

Το είναι η πρώτη μου επιλογή για όσους θέλουν να μαζεύουν δεδομένα τόσο εύκολα όσο να παραγγέλνουν φαγητό από το κινητό. Ως επέκταση Chrome με τεχνητή νοημοσύνη, το Thunderbit προσφέρει εξαγωγή δεδομένων με 2 κλικ: πατάς "AI Προτείνει Πεδία" και η AI βρίσκει τα δεδομένα της σελίδας, μετά "Scrape" για να τα μαζέψεις. Χωρίς κώδικα, χωρίς μπελάδες—μόνο άμεσα αποτελέσματα.

Γιατί το προτιμούν ομάδες πωλήσεων, marketing και e-commerce; Είναι φτιαγμένο για πραγματικές επιχειρηματικές ανάγκες:

- AI Προτείνει Πεδία: Η AI διαβάζει τη σελίδα και προτείνει τις καλύτερες στήλες—ονόματα, τιμές, emails κ.ά.

- Συλλογή από Υποσελίδες: Θες περισσότερες λεπτομέρειες; Το Thunderbit μπαίνει αυτόματα σε υποσελίδες (όπως προφίλ LinkedIn ή λεπτομέρειες προϊόντων) και εμπλουτίζει τον πίνακά σου.

- Άμεση Εξαγωγή: Στείλε τα δεδομένα σου απευθείας σε Excel, Google Sheets, Airtable ή Notion. Όλες οι εξαγωγές είναι δωρεάν.

- Έτοιμα Templates: Για γνωστά sites (Amazon, Zillow, Instagram), χρησιμοποίησε έτοιμα templates για ακόμα πιο γρήγορα αποτελέσματα.

- Δωρεάν Εξαγωγή Δεδομένων: Δεν υπάρχει περιορισμός στην εξαγωγή των δεδομένων σου.

- Προγραμματισμένη Συλλογή: Ρύθμισε επαναλαμβανόμενες εργασίες με απλή γλώσσα (π.χ. "κάθε Δευτέρα στις 9πμ")—ιδανικό για παρακολούθηση τιμών ή εβδομαδιαία leads.

Το Thunderbit λειτουργεί με credits (1 credit = 1 γραμμή), με για έως 6 σελίδες (ή 10 με δοκιμαστική ενίσχυση). Τα επί πληρωμή πλάνα ξεκινούν από $15/μήνα για 500 credits, οπότε είναι προσιτό για κάθε ομάδα.

Αν θες να δεις το Thunderbit στην πράξη, μπες στο ή στο . Είναι το εργαλείο που θα ήθελα να είχα όταν πνιγόμουν στο χειροκίνητο data entry.

2. Octoparse

Το είναι από τα πιο δυνατά εργαλεία συλλογής δεδομένων, ειδικά για εταιρείες που χρειάζονται μεγάλη ισχύ. Προσφέρει οπτικό περιβάλλον (Windows και Mac) όπου μπορείς να φτιάξεις ροές εξαγωγής δεδομένων με απλά κλικ—χωρίς να γράψεις ούτε γραμμή κώδικα. Παρά το φιλικό UI, το Octoparse διαχειρίζεται logins, άπειρο scroll, proxies και ακόμα και CAPTCHA.

Το είναι από τα πιο δυνατά εργαλεία συλλογής δεδομένων, ειδικά για εταιρείες που χρειάζονται μεγάλη ισχύ. Προσφέρει οπτικό περιβάλλον (Windows και Mac) όπου μπορείς να φτιάξεις ροές εξαγωγής δεδομένων με απλά κλικ—χωρίς να γράψεις ούτε γραμμή κώδικα. Παρά το φιλικό UI, το Octoparse διαχειρίζεται logins, άπειρο scroll, proxies και ακόμα και CAPTCHA.

- 500+ Έτοιμα Templates: Ξεκίνα άμεσα με templates για Amazon, Twitter, LinkedIn κ.ά.

- Cloud-Based Scraping: Τρέξε εργασίες στους servers του Octoparse, προγραμμάτισε tasks και κλιμάκωσε για μεγάλα projects.

- API Access: Ενσωμάτωσε τα δεδομένα απευθείας στις εφαρμογές ή βάσεις σου.

- Προηγμένη Αυτοματοποίηση: Διαχειρίζεται δυναμικό περιεχόμενο, σελιδοποίηση και πολύπλοκες ροές.

Υπάρχει για έως 10 εργασίες, αλλά οι περισσότερες επιχειρήσεις θα χρειαστούν το Standard (~$83/μήνα) ή το Professional (~$299/μήνα). Η εκμάθηση είναι λίγο πιο απαιτητική από το Thunderbit, αλλά αν χρειάζεσαι μαζική συλλογή δεδομένων, το Octoparse είναι κορυφαία επιλογή.

3. Scrapy

Το είναι το απόλυτο εργαλείο για developers που θέλουν να έχουν τον πλήρη έλεγχο στα projects συλλογής δεδομένων. Είναι open-source Python framework που σου επιτρέπει να γράψεις custom spiders (crawlers) για οποιοδήποτε site. Αν μπορείς να το φανταστείς, μπορείς να το φτιάξεις με το Scrapy.

Το είναι το απόλυτο εργαλείο για developers που θέλουν να έχουν τον πλήρη έλεγχο στα projects συλλογής δεδομένων. Είναι open-source Python framework που σου επιτρέπει να γράψεις custom spiders (crawlers) για οποιοδήποτε site. Αν μπορείς να το φανταστείς, μπορείς να το φτιάξεις με το Scrapy.

- Πλήρης Προγραμματισμός: Γράψε Python για να ορίσεις ακριβώς πώς θα συλλέξεις και θα αναλύσεις κάθε site.

- Γρήγορο & Ασύγχρονο: Διαχειρίζεται χιλιάδες σελίδες ταυτόχρονα για μεγάλα projects.

- Επεκτάσιμο: Πρόσθεσε middleware για proxies, headless browsers ή custom λογική.

- Δυνατή Κοινότητα: Πολλά tutorials, plugins και υποστήριξη για δύσκολες περιπτώσεις.

Το Scrapy είναι δωρεάν και ανοιχτού κώδικα, αλλά θέλει γνώσεις προγραμματισμού. Αν έχεις τεχνική ομάδα ή θες custom pipeline, δύσκολα θα βρεις καλύτερο. Για μη προγραμματιστές, όμως, είναι απαιτητικό.

4. ParseHub

Το είναι ένα οπτικό, no-code εργαλείο web scraping, ιδανικό για όσους δεν είναι developers αλλά θέλουν να μαζέψουν δεδομένα από πολύπλοκα sites. Με το point-and-click interface, διαλέγεις στοιχεία, ορίζεις ενέργειες και φτιάχνεις ροές scraping—ακόμα και για δυναμικές ή δύσκολες σελίδες.

Το είναι ένα οπτικό, no-code εργαλείο web scraping, ιδανικό για όσους δεν είναι developers αλλά θέλουν να μαζέψουν δεδομένα από πολύπλοκα sites. Με το point-and-click interface, διαλέγεις στοιχεία, ορίζεις ενέργειες και φτιάχνεις ροές scraping—ακόμα και για δυναμικές ή δύσκολες σελίδες.

- Οπτικός Builder Ροών: Κλικ για επιλογή δεδομένων, σελιδοποίηση, διαχείριση pop-ups ή dropdowns.

- Διαχειρίζεται Δυναμικό Περιεχόμενο: Λειτουργεί με σελίδες γεμάτες JavaScript και διαδραστικά στοιχεία.

- Cloud & Προγραμματισμός: Τρέξε scrapes στο cloud και προγραμμάτισε επαναλαμβανόμενες εργασίες.

- Εξαγωγή σε CSV, Excel ή μέσω API: Εύκολη ενσωμάτωση με τα αγαπημένα σου εργαλεία.

Το ParseHub προσφέρει δωρεάν πλάνο (5 projects), με επί πληρωμή πλάνα από . Είναι λίγο πιο ακριβό από άλλα, αλλά η οπτική προσέγγιση το κάνει προσβάσιμο σε αναλυτές, marketers και ερευνητές που χρειάζονται κάτι παραπάνω από μια απλή επέκταση Chrome.

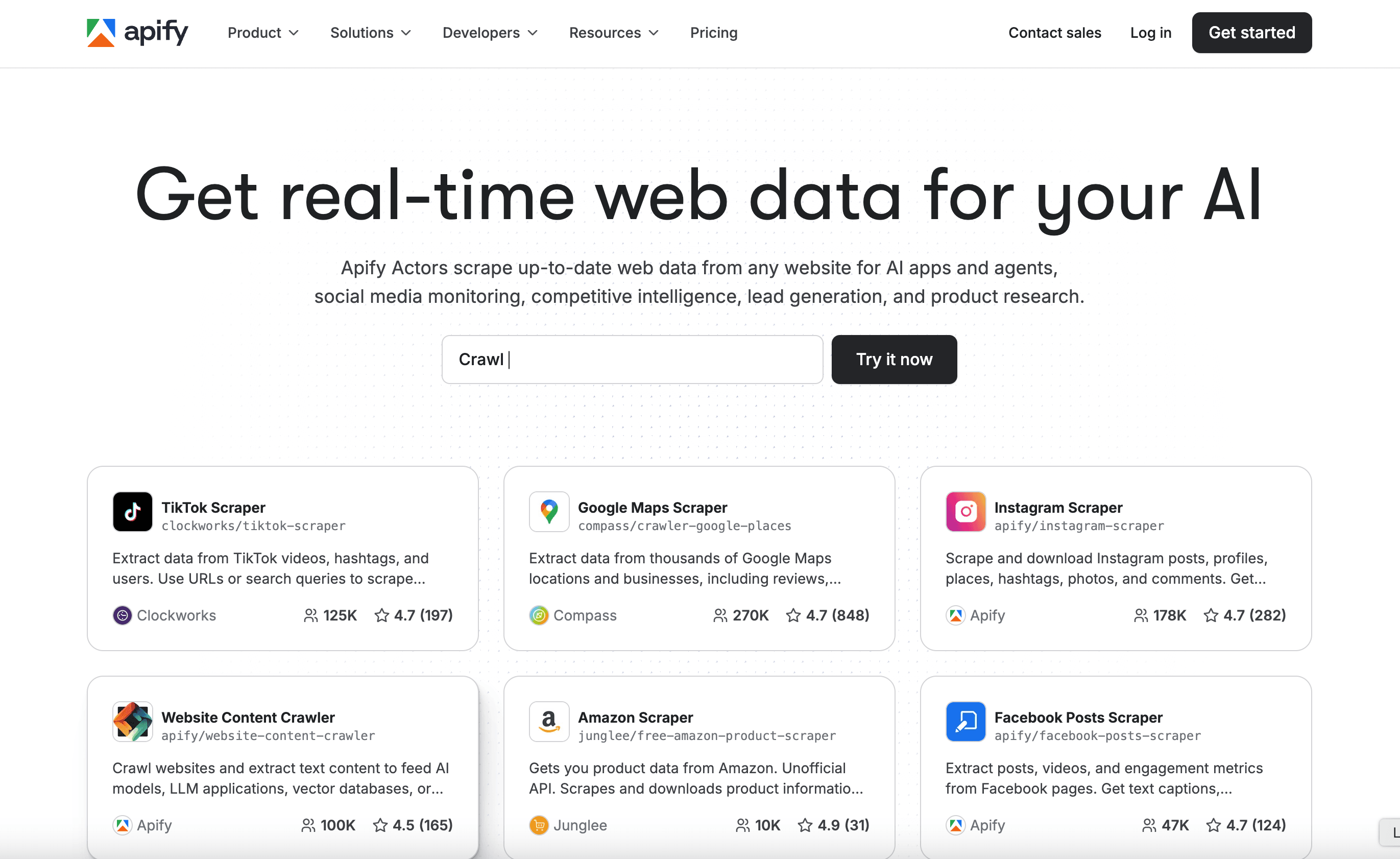

5. Apify

Το είναι ταυτόχρονα πλατφόρμα και marketplace για web crawling. Διαθέτει τεράστια βιβλιοθήκη με έτοιμους “Actors” (scrapers) για γνωστά sites, αλλά και δυνατότητα να φτιάξεις δικούς σου crawlers στο cloud.

Το είναι ταυτόχρονα πλατφόρμα και marketplace για web crawling. Διαθέτει τεράστια βιβλιοθήκη με έτοιμους “Actors” (scrapers) για γνωστά sites, αλλά και δυνατότητα να φτιάξεις δικούς σου crawlers στο cloud.

- 5.000+ Έτοιμοι Actors: Άμεση συλλογή από Google Maps, Amazon, Twitter κ.ά.

- Custom Scripting: Οι developers μπορούν να χρησιμοποιήσουν JavaScript ή Python για προηγμένους crawlers.

- Cloud Scaling: Τρέξε εργασίες παράλληλα, προγραμμάτισε tasks και διαχειρίσου δεδομένα στο cloud.

- API & Ενσωμάτωση: Σύνδεσε τα αποτελέσματα με εφαρμογές, ροές εργασίας ή pipelines.

Το Apify έχει ευέλικτο , με επί πληρωμή πλάνα από $29/μήνα (pay-as-you-go). Έχει μια μικρή καμπύλη εκμάθησης, αλλά αν θες και έτοιμες λύσεις και πλήρη παραμετροποίηση, είναι εξαιρετική επιλογή.

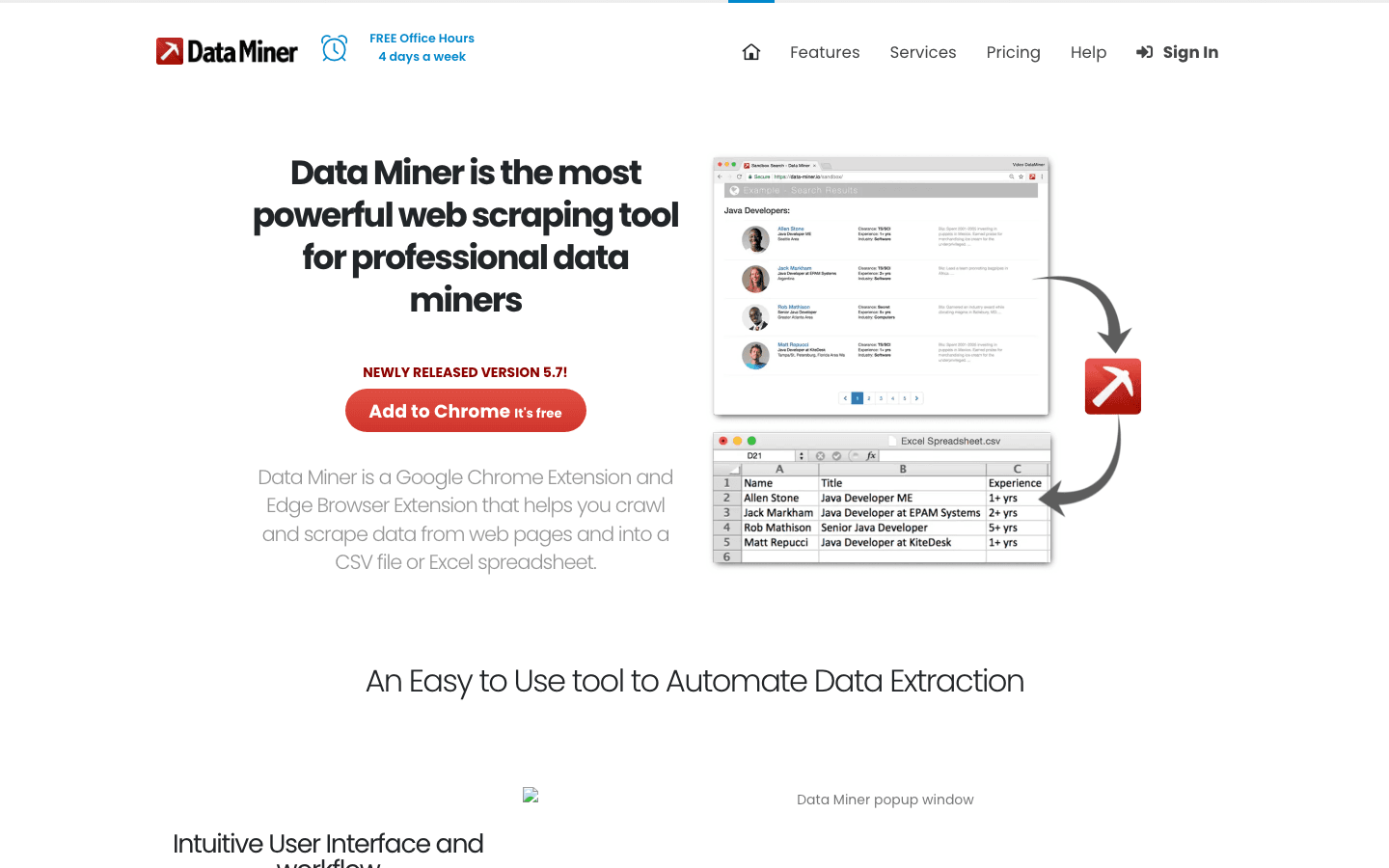

6. Data Miner

Το είναι επέκταση Chrome για γρήγορη, template-based συλλογή δεδομένων. Ιδανικό για επαγγελματίες που θέλουν να εξάγουν δεδομένα από πίνακες ή λίστες χωρίς να μπλέκουν με ρυθμίσεις.

Το είναι επέκταση Chrome για γρήγορη, template-based συλλογή δεδομένων. Ιδανικό για επαγγελματίες που θέλουν να εξάγουν δεδομένα από πίνακες ή λίστες χωρίς να μπλέκουν με ρυθμίσεις.

- Τεράστια Βιβλιοθήκη Templates: Πάνω από χίλιες συνταγές για γνωστά sites (LinkedIn, Yelp κ.ά.).

- Point-and-Click Εξαγωγή: Διάλεξε template, δες προεπισκόπηση και εξάγαγε άμεσα.

- Λειτουργεί στον Browser: Συμβατό με το session σου—ιδανικό για scraping πίσω από logins.

- Εξαγωγή σε CSV ή Excel: Τα δεδομένα σου σε φύλλο εργασίας σε δευτερόλεπτα.

Το καλύπτει 500 σελίδες/μήνα, με επί πληρωμή πλάνα από $20/μήνα. Ιδανικό για μικρές, γρήγορες εργασίες—μην περιμένεις να διαχειριστεί τεράστια projects ή πολύπλοκη αυτοματοποίηση.

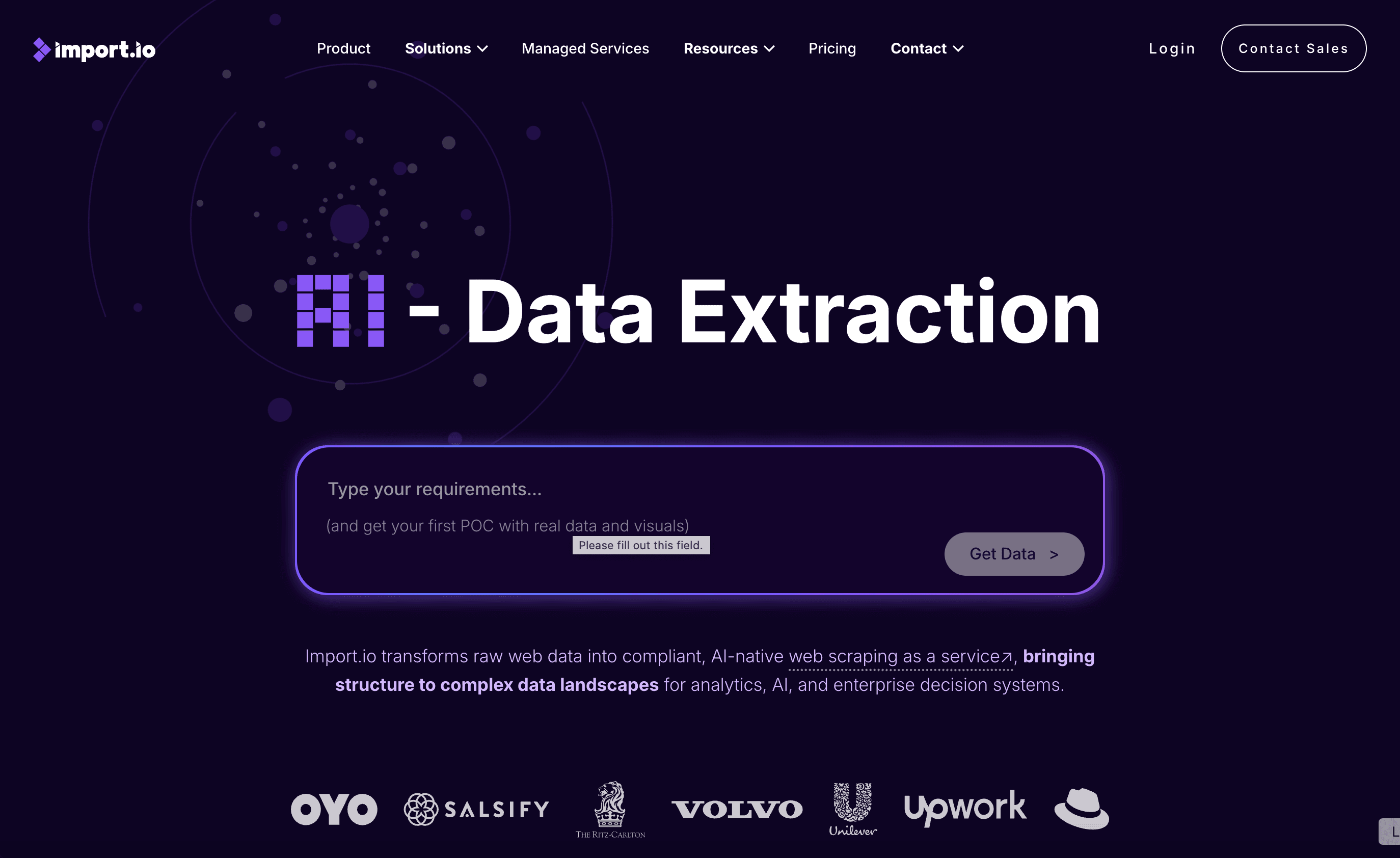

7. Import.io

Το είναι πλατφόρμα επιπέδου enterprise για οργανισμούς που χρειάζονται συνεχή, αξιόπιστη ενσωμάτωση web δεδομένων. Δεν είναι απλά crawler—είναι υπηρεσία που παραδίδει καθαρά, δομημένα δεδομένα απευθείας στα συστήματά σου.

Το είναι πλατφόρμα επιπέδου enterprise για οργανισμούς που χρειάζονται συνεχή, αξιόπιστη ενσωμάτωση web δεδομένων. Δεν είναι απλά crawler—είναι υπηρεσία που παραδίδει καθαρά, δομημένα δεδομένα απευθείας στα συστήματά σου.

- No-Code Εξαγωγή: Οπτική ρύθμιση για να ορίσεις τι δεδομένα θέλεις.

- Real-Time Data Feeds: Ροή δεδομένων σε dashboards, analytics ή βάσεις.

- Συμμόρφωση & Αξιοπιστία: Διαχειρίζεται IP rotation, anti-bot μέτρα και νομική συμμόρφωση.

- Διαχειριζόμενες Υπηρεσίες: Η ομάδα του Import.io μπορεί να στήσει και να συντηρεί τους scrapers σου.

Η τιμολόγηση είναι , με 14ήμερη δωρεάν δοκιμή. Αν η επιχείρησή σου εξαρτάται από συνεχώς φρέσκα δεδομένα (λιανική, χρηματοοικονομικά, έρευνα αγοράς), αξίζει να το δεις.

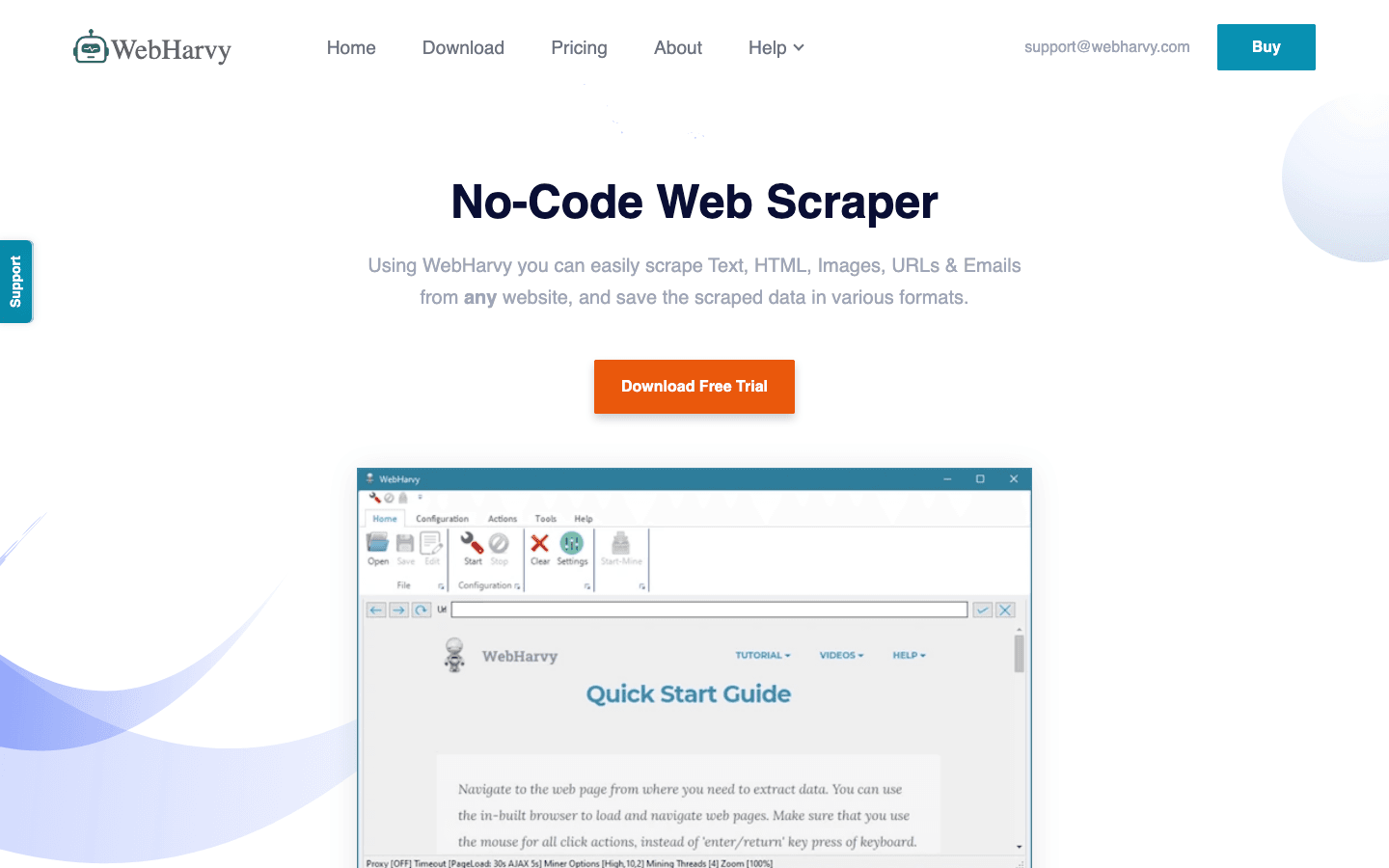

8. WebHarvy

Το είναι desktop εργαλείο για Windows, ιδανικό για όσους θέλουν λύση με απλά κλικ και χωρίς συνδρομή. Δημοφιλές σε μικρές επιχειρήσεις και ιδιώτες που προτιμούν εφάπαξ αγορά.

Το είναι desktop εργαλείο για Windows, ιδανικό για όσους θέλουν λύση με απλά κλικ και χωρίς συνδρομή. Δημοφιλές σε μικρές επιχειρήσεις και ιδιώτες που προτιμούν εφάπαξ αγορά.

- Οπτική Αναγνώριση Προτύπων: Κλικ στα δεδομένα και το WebHarvy βρίσκει αυτόματα επαναλαμβανόμενα μοτίβα.

- Διαχειρίζεται Κείμενο, Εικόνες κ.ά.: Εξάγει όλα τα βασικά δεδομένα, συμπεριλαμβανομένων emails και URLs.

- Σελιδοποίηση & Προγραμματισμός: Πλοήγηση σε πολλαπλές σελίδες και ρύθμιση προγραμματισμένων scrapes.

- Εξαγωγή σε Excel, CSV, XML, JSON, SQL: Ευέλικτη έξοδος για κάθε ανάγκη.

Η άδεια χρήσης κοστίζει , οπότε είναι οικονομική επιλογή για συχνή χρήση—απλά να ξέρεις ότι λειτουργεί μόνο σε Windows.

9. Mozenda

Το είναι cloud-based πλατφόρμα συλλογής δεδομένων για επιχειρήσεις με συνεχή ανάγκη για δεδομένα. Συνδυάζει desktop designer (Windows) με ισχυρή cloud εκτέλεση και αυτοματοποίηση.

Το είναι cloud-based πλατφόρμα συλλογής δεδομένων για επιχειρήσεις με συνεχή ανάγκη για δεδομένα. Συνδυάζει desktop designer (Windows) με ισχυρή cloud εκτέλεση και αυτοματοποίηση.

- Οπτικός Agent Builder: Φτιάξε ρουτίνες εξαγωγής με point-and-click περιβάλλον.

- Cloud Scaling: Τρέξε πολλαπλούς agents ταυτόχρονα, προγραμμάτισε εργασίες και διαχειρίσου δεδομένα κεντρικά.

- Κονσόλα Διαχείρισης Δεδομένων: Συνδύασε, φιλτράρισε και καθάρισε δεδομένα μετά την εξαγωγή.

- Υποστήριξη Επιχειρήσεων: Αφιερωμένοι account managers και διαχειριζόμενες υπηρεσίες για μεγάλες ομάδες.

Τα πλάνα ξεκινούν από , με υψηλότερα tiers για περισσότερους χρήστες και ισχύ. Το Mozenda είναι ιδανικό για εταιρείες που χρειάζονται αξιόπιστα, επαναλαμβανόμενα web δεδομένα στην καθημερινή λειτουργία τους.

10. BeautifulSoup

Το είναι η κλασική Python βιβλιοθήκη για ανάλυση HTML και XML. Δεν είναι πλήρης crawler, αλλά είναι αγαπητή στους developers για μικρές, custom εργασίες scraping.

Το είναι η κλασική Python βιβλιοθήκη για ανάλυση HTML και XML. Δεν είναι πλήρης crawler, αλλά είναι αγαπητή στους developers για μικρές, custom εργασίες scraping.

- Απλή Ανάλυση HTML: Εύκολη εξαγωγή δεδομένων από στατικές σελίδες.

- Συνεργάζεται με Python Requests: Συνδύασε με άλλες βιβλιοθήκες για λήψη και crawling.

- Ευέλικτο & Ελαφρύ: Ιδανικό για γρήγορα scripts ή εκπαιδευτικά projects.

- Μεγάλη Κοινότητα: Πολλά tutorials και απαντήσεις στο Stack Overflow.

Το BeautifulSoup είναι , αλλά θα χρειαστεί να γράψεις κώδικα και να διαχειριστείς μόνος σου το crawling. Ιδανικό για developers ή όσους θέλουν να μάθουν τα βασικά του web scraping.

Συγκριτικός Πίνακας: Εργαλεία Συλλογής Δεδομένων με μια Ματιά

| Εργαλείο | Ευκολία Χρήσης | Επίπεδο Αυτοματοποίησης | Τιμολόγηση | Επιλογές Εξαγωγής | Ιδανικό Για |

|---|---|---|---|---|---|

| Thunderbit | Πολύ εύκολο, χωρίς κώδικα | Υψηλό (AI, υποσελίδες) | Δωρεάν δοκιμή, από $15/μήνα | Excel, Sheets, Airtable, Notion, CSV | Πωλήσεις, marketing, e-commerce, μη προγραμματιστές |

| Octoparse | Μέτριο, οπτικό UI | Πολύ υψηλό, cloud | Δωρεάν, $83–$299/μήνα | CSV, Excel, JSON, API | Επιχειρήσεις, data teams, δυναμικά sites |

| Scrapy | Χαμηλό (απαιτεί Python) | Υψηλό (παραμετροποιήσιμο) | Δωρεάν, ανοιχτού κώδικα | Οποιοδήποτε (μέσω κώδικα) | Developers, μεγάλα custom projects |

| ParseHub | Υψηλό, οπτικό | Υψηλό (δυναμικά sites) | Δωρεάν, από $189/μήνα | CSV, Excel, JSON, API | Μη προγραμματιστές, πολύπλοκες δομές web |

| Apify | Μέτριο, ευέλικτο | Πολύ υψηλό, cloud | Δωρεάν, $29–$999/μήνα | CSV, JSON, API, cloud storage | Developers, επιχειρήσεις, έτοιμοι ή custom actors |

| Data Miner | Πολύ εύκολο, browser | Χαμηλό (χειροκίνητο) | Δωρεάν, $20–$99/μήνα | CSV, Excel | Γρήγορες, μεμονωμένες εξαγωγές, μικρά datasets |

| Import.io | Μέτριο, διαχειριζόμενο | Πολύ υψηλό, enterprise | Custom, ανά όγκο | CSV, JSON, API, direct integration | Επιχειρήσεις, συνεχή ενσωμάτωση δεδομένων |

| WebHarvy | Υψηλό, desktop | Μέτριο (προγραμματισμός) | $129 εφάπαξ | Excel, CSV, XML, JSON, SQL | Μικρές επιχειρήσεις, Windows users, τακτικό scraping |

| Mozenda | Μέτριο, οπτικό | Πολύ υψηλό, cloud | $250–$450+/μήνα | CSV, Excel, JSON, cloud, DB | Συνεχής, μεγάλης κλίμακας επιχειρησιακές λειτουργίες |

| BeautifulSoup | Χαμηλό (απαιτεί Python) | Χαμηλό (χειροκίνητος κώδικας) | Δωρεάν, ανοιχτού κώδικα | Οποιοδήποτε (μέσω κώδικα) | Developers, εκπαιδευόμενοι, μικρά custom scripts |

Πώς να διαλέξεις το κατάλληλο εργαλείο συλλογής δεδομένων για την ομάδα σου

Το καλύτερο εργαλείο συλλογής δεδομένων δεν είναι απαραίτητα το πιο δυνατό—αλλά αυτό που ταιριάζει στις δεξιότητες, τις ανάγκες και το budget της ομάδας σου. Η συμβουλή μου:

- Μη προγραμματιστές ή επαγγελματίες: Ξεκίνα με Thunderbit, ParseHub ή Data Miner για άμεσα αποτελέσματα και εύκολη ρύθμιση.

- Επιχειρήσεις ή μεγάλες ανάγκες: Δες Octoparse, Mozenda ή Import.io για αυτοματοποίηση, προγραμματισμό και υποστήριξη.

- Developers ή custom projects: Scrapy, Apify ή BeautifulSoup προσφέρουν πλήρη έλεγχο και ευελιξία.

- Οικονομικές ή μεμονωμένες εργασίες: WebHarvy (Windows) ή Data Miner (browser) είναι οικονομικές και απλές λύσεις.

Πάντα δοκίμασε τα εργαλεία που σε ενδιαφέρουν με δωρεάν δοκιμή στα sites που πραγματικά χρειάζεσαι—αυτό που δουλεύει τέλεια σε ένα site μπορεί να μην δουλεύει σε άλλο. Και μην ξεχνάς την ενσωμάτωση: αν χρειάζεσαι τα δεδομένα σου σε Sheets, Notion ή βάση δεδομένων, βεβαιώσου ότι το εργαλείο το υποστηρίζει.

Συμπέρασμα: Πάρε το μέγιστο από τα δεδομένα σου με τα κατάλληλα εργαλεία συλλογής

Τα web δεδομένα είναι το νέο πετρέλαιο—αρκεί να έχεις τα σωστά εργαλεία για να τα μαζέψεις και να τα αξιοποιήσεις. Με τα σύγχρονα εργαλεία συλλογής δεδομένων, μπορείς να μετατρέψεις ώρες βαρετής έρευνας σε λεπτά αυτοματοποιημένης πληροφόρησης—ενισχύοντας πωλήσεις, marketing και τη λειτουργία της επιχείρησής σου. Είτε φτιάχνεις λίστες leads, παρακολουθείς ανταγωνιστές ή απλά βαρέθηκες το copy-paste, υπάρχει εργαλείο σε αυτή τη λίστα που θα σου λύσει τα χέρια.

Δες τις ανάγκες της ομάδας σου, δοκίμασε μερικά από αυτά τα εργαλεία και ανακάλυψε πόσα περισσότερα μπορείς να πετύχεις όταν αφήνεις την αυτοματοποίηση να κάνει τη βαριά δουλειά. Και αν θες να δεις πώς είναι το AI-powered scraping με 2 κλικ, . Καλή συλλογή—και να έχεις πάντα φρέσκα, δομημένα και έτοιμα για χρήση δεδομένα!

Συχνές Ερωτήσεις

1. Τι είναι ένα εργαλείο συλλογής δεδομένων και γιατί το χρειάζομαι;

Ένα εργαλείο συλλογής δεδομένων αυτοματοποιεί τη διαδικασία εξαγωγής πληροφοριών από ιστοσελίδες. Σου γλιτώνει χρόνο, μειώνει τα λάθη και βοηθά τις ομάδες να συγκεντρώνουν ενημερωμένα δεδομένα για πωλήσεις, marketing, έρευνα και λειτουργίες—πολύ πιο αποδοτικά από το χειροκίνητο copy-paste.

2. Ποιο εργαλείο συλλογής δεδομένων είναι καλύτερο για μη τεχνικούς χρήστες;

Thunderbit, ParseHub και Data Miner είναι κορυφαίες επιλογές για όσους δεν είναι developers. Το Thunderbit ξεχωρίζει για τη ροή εργασίας με 2 κλικ και AI, ενώ το ParseHub προσφέρει οπτική προσέγγιση για πιο σύνθετα sites.

3. Πώς διαφέρουν τα μοντέλα τιμολόγησης στα εργαλεία συλλογής δεδομένων;

Η τιμολόγηση διαφέρει πολύ: κάποια εργαλεία (όπως Thunderbit και Data Miner) έχουν δωρεάν πλάνα και οικονομικές μηνιαίες συνδρομές, ενώ πλατφόρμες για επιχειρήσεις (όπως Import.io και Mozenda) έχουν custom ή ανά όγκο τιμολόγηση. Πάντα έλεγξε αν το κόστος ταιριάζει με τις ανάγκες σου.

4. Μπορώ να χρησιμοποιήσω αυτά τα εργαλεία για συνεχή, προγραμματισμένη εξαγωγή δεδομένων;

Ναι—εργαλεία όπως Thunderbit, Octoparse, Apify, Mozenda και Import.io υποστηρίζουν προγραμματισμένες ή επαναλαμβανόμενες συλλογές, ιδανικές για παρακολούθηση τιμών, leads ή έρευνα αγοράς.

5. Τι να προσέξω πριν διαλέξω εργαλείο συλλογής δεδομένων;

Σκέψου τις τεχνικές δεξιότητες της ομάδας σου, την πολυπλοκότητα των sites που θες να συλλέξεις, τον όγκο δεδομένων, τις ανάγκες ενσωμάτωσης και το budget. Δοκίμασε μερικά εργαλεία με πραγματικές εργασίες πριν δεσμευτείς σε συνδρομή.

Για περισσότερους οδηγούς και πρακτικές συμβουλές, δες το .

Μάθε περισσότερα