你有没有想过,企业是怎么把那些分散、杂乱的原始数据,变成一目了然的可视化报表和智能洞察的?其实,这一切的起点都离不开数据摄取——它就是每个数据驱动型业务背后那个低调但不可或缺的“幕后功臣”。在如今数据爆炸的时代,预计到(21个零,想想都头大),怎么高效、准确地把数据从A点搬到B点,并且变成能直接用的格式,比以往任何时候都更重要。

我在SaaS和自动化领域摸爬滚打了好些年,亲眼见证了数据摄取策略对企业成败的巨大影响。不管你是要整合销售线索、追踪市场动态,还是想让业务更高效,理解数据摄取的原理和发展趋势,都是释放数据价值的第一步。那么,数据摄取到底是啥?为啥它这么关键?又有哪些现代工具(比如)正在彻底改变数据摄取的玩法?一起来看看吧。

什么是数据摄取?数据驱动业务的底层基石

简单来说,数据摄取就是把来自不同渠道的数据收集、导入并加载到一个中心化系统(比如数据库、数据仓库或数据湖),方便后续分析、可视化或者业务决策。你可以把它想象成数据管道的“前门”:不管是表格、API、日志、网页还是传感器数据,所有原材料都得先进“厨房”,才能烹饪出有价值的洞察。

数据摄取是数据管道的第一步(),它打破信息孤岛,保证高质量、及时的数据能为分析、商业智能和机器学习提供支撑。没有数据摄取,宝贵的信息就会被困在各自的系统里——“对真正需要的人来说形同隐形”,业内专家就是这么说的。

它在整个数据流程中的角色大致是:

- 数据摄取:从各种来源收集原始数据,汇总到中心库。

- 数据集成:把不同来源的数据整合、对齐,实现协同。

- 数据转换:对数据进行清洗、格式化和丰富,方便后续分析。

你可以把摄取比作把不同超市的食材搬回家,集成是把它们分类放进橱柜,转换则是洗菜、切菜、做饭。

为什么数据摄取对现代企业这么重要?

说白了,在现在的商业环境下,及时且高效的数据摄取就是企业的核心竞争力。谁能搞定数据摄取,谁就能打破信息壁垒,实现实时洞察,做出更快、更明智的决策。反过来,摄取不畅就意味着报告滞后、机会流失,甚至可能因为用到过时或不完整的数据而做出错误决策。

高效的数据摄取能给企业带来哪些好处?来看几个典型场景:

| 应用场景 | 高效数据摄取的价值 |

|---|---|

| 销售线索获取 | 实时整合来自网页表单、社交媒体和数据库的线索,销售团队能更快响应,提升转化率。 |

| 运营看板 | 持续将生产系统数据导入分析平台,管理层随时掌握最新KPI,快速调整策略。 |

| 客户360°视图 | 融合CRM、客服、电商和社交媒体数据,构建统一客户档案,实现个性化营销和主动服务(Cake.ai)。 |

| 预测性维护 | 摄取大量传感器和物联网数据,分析模型可提前发现异常,预防故障,降低停机和成本。 |

| 金融风险分析 | 实时流式导入交易和市场数据,助力银行和交易员即时掌控风险,快速识别欺诈行为。 |

数据不会骗人:,但只有数据能被高效摄取和信任,这些投入才能真正变成价值。

数据摄取、数据集成和数据转换:别再傻傻分不清

各种术语容易搞混,下面帮你捋一捋:

- 数据摄取:第一步,从源系统收集和导入原始数据。就像“把所有食材搬进厨房”。

- 数据集成:把不同来源的数据整合、对齐,保证一致性和统一视图。就像“整理橱柜”。

- 数据转换:把原始数据变成可用数据——清洗、格式化、聚合和丰富。就像“备菜和做饭”。

很多人以为摄取和ETL(提取、转换、加载)是一码事。其实,摄取只是ETL里的“提取”环节——负责拉取原始数据。集成和转换是后续步骤,让数据真正能用()。

为啥要区分?如果你只是想快速抓取网页数据,一个轻量级摄取工具就够了。但如果要整合、清洗多个系统的数据,还得靠集成和转换。

传统数据摄取方式:ETL的局限

几十年来,**ETL(提取、转换、加载)**一直是数据摄取的主流方式。数据工程师写脚本或用专用软件,定期从源系统拉数据,清洗格式后加载到数据仓库。一般都是批量处理,比如每天夜里跑一次。

但随着数据量和类型越来越多,传统ETL的短板也越来越明显:

- 搭建复杂、耗时:ETL流程需要大量编码和专业技能,非技术团队只能干等IT慢慢搭建()。

- 批处理延迟:ETL多为批量作业,数据更新不及时。现在大家都追求实时洞察,等几个小时甚至几天根本不够用()。

- 扩展性和速度有限:面对海量数据,传统流程常常吃不消,需要不断调优和升级。

- 灵活性差:新增数据源或结构变动时,流程容易崩,维护成本高。

- 高维护负担:各种原因都可能导致流程中断,工程师得一直“救火”。

- 只适合结构化数据:传统ETL只适合规整的表格数据,面对现在(比如网页、图片)就无能为力了。

总之,ETL适合过去的数据环境,但面对现在数据的速度、规模和多样性,已经有点跟不上节奏了。

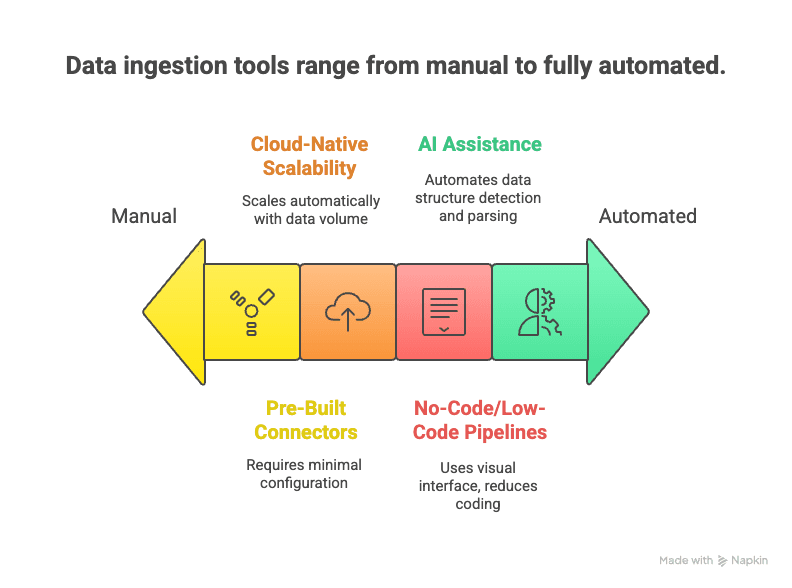

现代数据摄取崛起:AI加持,自动化来袭

新时代来了,现代数据摄取工具借助自动化、云原生和AI,让数据采集变得更快、更简单、更灵活。

它们的优势包括:

- 零代码/低代码流程:拖拽界面和AI助手,无需写代码就能搭建数据流()。

- 内置连接器:数百种主流数据源一键接入,账号一输就能用。

- 云原生弹性:云服务能实时处理海量数据流()。

- 支持实时和批量:既能流式摄取,也能批量导入,灵活适配业务需求()。

- AI智能辅助:AI能自动识别数据结构、推荐解析规则,甚至实时检测数据质量()。

- 支持非结构化数据:NLP和计算机视觉技术能把网页、PDF、图片等“杂乱”数据转成结构化表格。

- 低维护成本:托管服务自动监控、扩容和升级,让你专注用数据,不用天天盯着流程。

最终效果就是:数据摄取更快上手、更容易调整,能轻松应对现在多变的数据世界。

数据摄取的行业应用与挑战

来看看数据摄取在各行各业的实际用法,以及常见难题。

零售与电商

零售商要整合POS系统、线上商城、会员App、门店传感器等多渠道数据。通过汇总销售、点击流和库存日志,实时掌握库存和消费趋势。难点在于高并发大数据量(尤其促销高峰)和线上线下数据打通。

金融与银行

银行和券商要实时摄取交易、市场行情和客户交互数据。实时摄取对风控和反欺诈特别关键。但合规和安全要求极高,任何摄取环节出错都可能带来严重后果。

科技与互联网

科技公司要处理海量实时事件流(每一次点击、点赞、分享),用于用户行为分析和推荐系统。挑战在于数据规模巨大,怎么从“噪音”中提取有用信息,保证数据质量和一致性。

医疗健康

医院要整合电子病历、实验室系统和医疗设备数据,构建统一患者档案,实现预测性分析。难点在于系统间互通性差(“各说各话”)和患者隐私保护。

房地产

房产公司要汇总房源平台、官网和公开记录等多渠道数据,构建全面数据库。难点在于数据来源多样、格式杂乱,房源信息变动频繁,得保证数据新鲜。

各行业普遍遇到的挑战有:

- 数据类型多样(结构化、半结构化、非结构化)

- 实时和批量需求的平衡

- 数据质量和一致性保障

- 安全和合规要求

- 数据量持续增长的扩展性

只有攻克这些难题,才能实现更精准的分析、实时决策和合规运营。

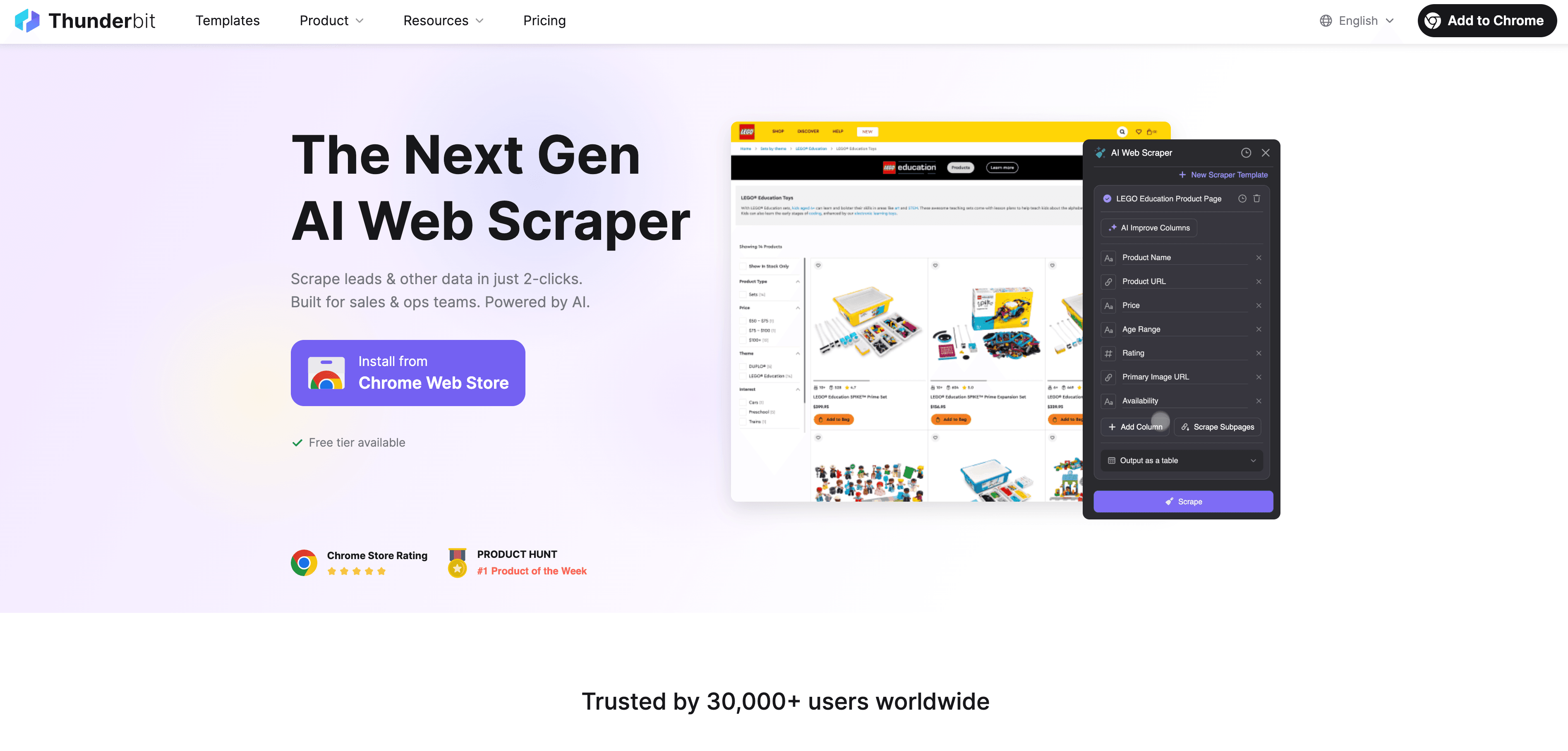

Thunderbit:用 AI 网页爬虫让数据摄取变简单

说到这里,Thunderbit在数据摄取领域到底有啥用? 是一款基于AI的网页爬虫 Chrome 插件,让任何人都能轻松采集网页数据,完全不需要编程基础。

Thunderbit为企业用户带来的革新包括:

- 2步网页采集:从杂乱网页到结构化数据集,只需两步。点“AI建议字段”,再点“抓取”,就搞定。

- AI智能字段推荐:Thunderbit的AI会自动识别页面内容,推荐最适合提取的字段,无论是企业名录、商品列表还是领英资料。

- 自动子页面采集:需要更多详情?Thunderbit能自动访问每个子页面(比如商品详情、个人资料),自动丰富数据表。

- 分页和无限滚动处理:支持分页列表和无限滚动页面,确保数据不遗漏。

- 内置模板:针对Amazon、Zillow、Shopify等热门网站,提供一键模板,无需配置。

- 免费数据导出:可直接导出到Excel、Google Sheets、Airtable或Notion,无需额外付费。

- 定时采集:可设置定时任务自动运行(比如每日监控竞品价格)。

- AI自动填表:还能自动填写表单、批量执行网页操作。

不管是销售团队采集线索、电商分析师监控价格,还是房产经纪人收集房源,Thunderbit都能让非结构化网页数据快速变成可用洞察。

想看Thunderbit实际操作?欢迎访问我们的或浏览获取更多教程。

数据摄取方案对比:传统VS现代

来看一张对比表,直观感受下差异:

| 对比维度 | 传统ETL工具 | 现代AI/云工具 | Thunderbit(AI网页爬虫) |

|---|---|---|---|

| 用户门槛 | 高(需编程/IT) | 中(低代码,需配置) | 低(2步,无需编程) |

| 数据来源 | 结构化(数据库、CSV) | 广泛(数据库、SaaS、API) | 任意网站,非结构化数据 |

| 部署速度 | 慢(数周/月) | 较快(数天) | 即时(几分钟) |

| 实时支持 | 有限(批量) | 强(流式/批量) | 按需&定时 |

| 扩展性 | 难度大 | 高(云原生) | 中高(云端爬取) |

| 维护成本 | 高(易出错) | 中(托管服务) | 低(AI自适应) |

| 数据转换 | 刚性,前置 | 灵活,后置 | 基础(AI字段提示) |

| 最佳场景 | 内部批量集成 | 分析型数据管道 | 网页数据、外部数据 |

结论很简单:选对工具很重要。对于网页或非结构化数据,Thunderbit往往是最快、最省心的选择。

数据摄取的未来:自动化和云优先

展望未来,数据摄取会越来越智能、自动化。主要趋势有:

- 实时为主流:传统批处理会被淘汰,更多流程转向实时、事件驱动()。

- 云优先和“零ETL”:云平台让数据源和目标系统无缝对接,无需手动搭建流程。

- AI自动化:机器学习会在流程配置、监控和优化中扮演更大角色,自动发现异常、纠错、数据增强。

- 零代码自助化:更多工具支持自然语言或可视化界面,业务人员也能轻松搭建数据流。

- 边缘和物联网摄取:数据在边缘侧就近处理,智能过滤和聚合。

- 治理和元数据管理:自动标签、数据溯源和合规会融入每一步。

总之,未来的数据摄取会更快、更易用、更可靠,让你专注于数据洞察,而不是基础设施。

总结:给企业用户的关键建议

- 数据摄取是数据驱动的第一步。想要洞察,先要高效、可靠地把数据导入。

- 现代AI工具如Thunderbit,让数据摄取不再是IT专属。2步采集、AI字段推荐、定时任务,让网页数据变成业务“金矿”。

- 选对工具很重要:内部结构化数据用传统ETL,广泛分析用云工具,网页和非结构化数据首选Thunderbit。

- 紧跟趋势:自动化、云和AI让数据摄取更智能、更简单。别被旧方法束缚,积极尝试新方案,为数据战略保驾护航。

常见问题解答

1. 通俗来说,什么是数据摄取?

数据摄取就是把来自不同来源(比如网站、数据库、文件)的数据收集并导入到中心系统,方便分析和业务决策。它是所有数据管道的起点。

2. 数据摄取和数据集成、转换有啥区别?

数据摄取是把原始数据带进来,数据集成是把不同来源的数据整合对齐,数据转换则是清洗、格式化,方便分析。简单说:摄取=收集,集成=整理,转换=加工。

3. 传统数据摄取方式最大难题是什么?

传统ETL流程搭建慢、需要大量编程,难以处理非结构化数据,也无法满足实时需求,维护成本高,灵活性差。

4. Thunderbit 怎么让数据摄取更简单?

Thunderbit用AI让任何人都能2步采集并结构化网页数据,无需编程。支持子页面、分页、定时任务,数据可直接导出到Excel、Google Sheets、Airtable或Notion。

5. 数据摄取的未来趋势是什么?

未来会以自动化、云优先和AI驱动为主。更多实时数据流、更智能的异常处理,以及让业务人员也能用自然语言或可视化界面搭建数据摄取流程。

延伸阅读: