说真的,互联网就像一片永远长不完的原始森林。每天都有超过 上线,仅 Google 的搜索索引就已经囊括了 。你有没有想过,搜索引擎是怎么跟得上这股信息洪流的?企业又是如何在这片信息海洋中精准定位目标的?其实很多人都有类似的疑惑。作为一名长期混迹在 SaaS 和自动化领域的从业者,我经常被问到:“网页爬取和网页抓取到底有啥区别?不都是一样的吗?”其实两者差别很大,搞混了反而会让你的项目走弯路。

不管你是销售在找客户,还是电商经理盯着价格,或者只是想在团队会议上显得更专业,接下来我们就来聊聊网页爬虫到底是干嘛的、它和爬虫工具有啥不同,以及为什么选对工具(比如 Thunderbit)能让你效率翻倍,甚至帮你省下加班的周末。

网页爬虫基础:什么是网页爬虫?

你可以把网页爬虫想象成一个超级细心的图书管理员,每天都在图书馆里巡视每个书架,看看有没有新书上架。网页爬虫的原理其实差不多——只不过它不是整理书本,而是在互联网上自动访问成千上万的网页。网页爬虫(有时也叫 spider 或 bot)是一种自动化程序,会系统性地浏览网页,顺着页面里的链接不断跳转,把发现的内容都记录下来。正是靠这些爬虫,Google、Bing 这样的搜索引擎才能建立庞大的索引库,让我们随时都能查到全网的信息。

你可能听说过“Googlebot”或“Bingbot”,这些其实就是最有名的网页爬虫。除此之外,还有像 这样的新工具,帮助开发者和企业批量爬取网站,把内容结构化,方便 AI 或数据分析用。

但要注意:爬虫的核心任务是发现——也就是找到并索引网页,而不是直接提取具体数据。至于数据提取,那是网页抓取(scraping)的活(后面会详细说)。

网页爬虫是怎么工作的?

我们来看看网页爬虫的“日常”。你可以把它想象成一个数字探险家,背包里装着一堆“种子网址”——也就是起点。它的工作流程大致如下:

- 种子网址(Seed URLs): 爬虫从一组已知的网址出发。

- 抓取与解析(Fetch & Parse): 访问每个网址,获取页面内容,并扫描里面的链接。

- 跟踪链接(Follow Links): 发现的新链接会被加入“待办清单”(URL 队列)。

- 索引(Indexing): 爬虫会记录每个页面的信息,有时是全部内容,有时只存元数据。

- 遵守规则(Politeness): 检查每个网站的 robots.txt 文件,确认是否允许爬取,并在请求之间适当等待,避免给服务器带来压力。

- 持续更新(Continuous Update): 网页内容经常变,爬虫会定期回访,保证索引是最新的。

这就像你在城市里走遍每条街道,记录每家新开的店铺,并不断更新你的地图。

网页爬虫的核心组成

即使你不是技术出身,了解下爬虫的基本结构也很有用:

- URL 队列(URL Frontier): 记录待访问的网址清单。

- 抓取器/下载器(Fetcher/Downloader): 负责实际获取网页内容。

- 解析器(Parser): 负责读取页面,提取链接和部分信息。

- 去重与过滤(Deduplication & URL Filter): 防止爬虫陷入死循环或重复访问同一页面。

- 数据存储/索引(Data Storage/Index): 用于保存已发现的内容,方便后续使用。

你可以把它想象成一条流水线:有人负责收集报纸,有人负责圈出头条,有人负责归档,还有人负责记录下一步要收集哪些报纸。

如何进行网页爬取:工具与方法

如果你是企业用户,可能会想自己搭建爬虫。我的建议是:没必要。除非你打算做下一个 Google,否则市面上已经有很多成熟工具能帮你搞定大部分工作。

常见网页爬虫工具:

- :开源,面向开发者,适合大型项目。

- :常用于大数据索引和学术研究。

- :Internet Archive 的网页归档工具。

- :SEO 专业人士常用的网站爬取和审查工具。

- :现代化、API 驱动,支持整站结构化数据提取。

友情提醒: 这些工具大多需要一定的技术基础。即使是“零代码”工具,也可能需要你选 HTML 元素、应对网页结构变化或处理动态内容。如果你只是想抓几个页面的数据,其实没必要用到完整的爬虫。

网页爬取 vs. 网页抓取:核心区别是什么?

很多人容易把爬取和抓取混为一谈。其实两者相关但不一样。

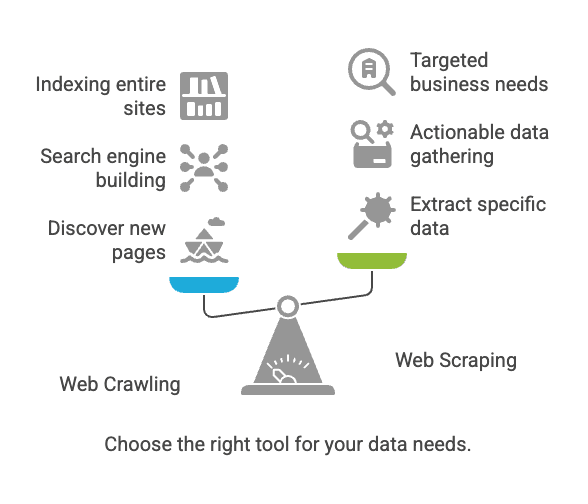

| 方面 | 网页爬取 | 网页抓取 |

|---|---|---|

| 目标 | 发现并索引网页 | 提取网页中的特定数据 |

| 类比 | 图书管理员为每本书建目录 | 从几本书中抄录关键信息 |

| 输出 | URL 列表、页面内容、网站地图 | 结构化数据(如 CSV、Excel、JSON 等) |

| 典型用户 | 搜索引擎、SEO 工具、归档机构 | 销售、电商、分析师、研究员 |

| 规模 | 数十亿页面(广覆盖) | 数十到数千页面(有针对性) |

一句话总结: 爬取是为了发现页面,抓取则是提取你需要的数据()。

网页爬取与抓取的常见挑战与最佳实践

常见挑战

- 网站结构变化: 哪怕页面小改动,也可能让你的工具失效()。

- 动态内容: 很多网站用 JavaScript 加载数据,基础爬虫抓不到。

- 反爬机制: 验证码、IP 封禁、登录限制等都可能拦住爬虫。

- 规模问题: 爬太多页面可能导致电脑卡顿,甚至被封 IP。

- 法律与合规: 抓取公开数据一般没问题,但一定要遵守网站条款和隐私法规()。

最佳实践

- 选对工具: 不会编程建议用零代码爬虫。

- 明确数据目标: 事先想好需要哪些数据、用来干嘛。

- 尊重网站政策: 一定要看 robots.txt 和网站条款。

- 避免高频请求: 请求间隔要合理,别给服务器添堵。

- 做好维护准备: 网站会变,定期调整你的设置。

- 数据安全与清洗: 妥善保存结果,去重并检查错误。

典型应用场景:爬取 vs. 抓取

网页爬取

- 搜索引擎索引: Googlebot、Bingbot 持续爬取网页,保证搜索结果实时更新()。

- 网页归档: Internet Archive 用爬虫为 Wayback Machine 采集网页。

- SEO 审查: 工具爬取你的网站,查找死链或缺失标签。

网页抓取

- 价格监控: 零售商抓取竞争对手商品页面,实时了解价格动态()。

- 线索收集: 销售团队抓取名录,批量获取联系方式。

- 内容聚合: 新闻或招聘网站抓取多渠道信息。

- 市场调研: 分析师抓取评论或社交媒体,做情感分析。

有趣数据: 超过 都在用网页抓取外部数据。如果你还没用,竞争对手可能早就开始了。

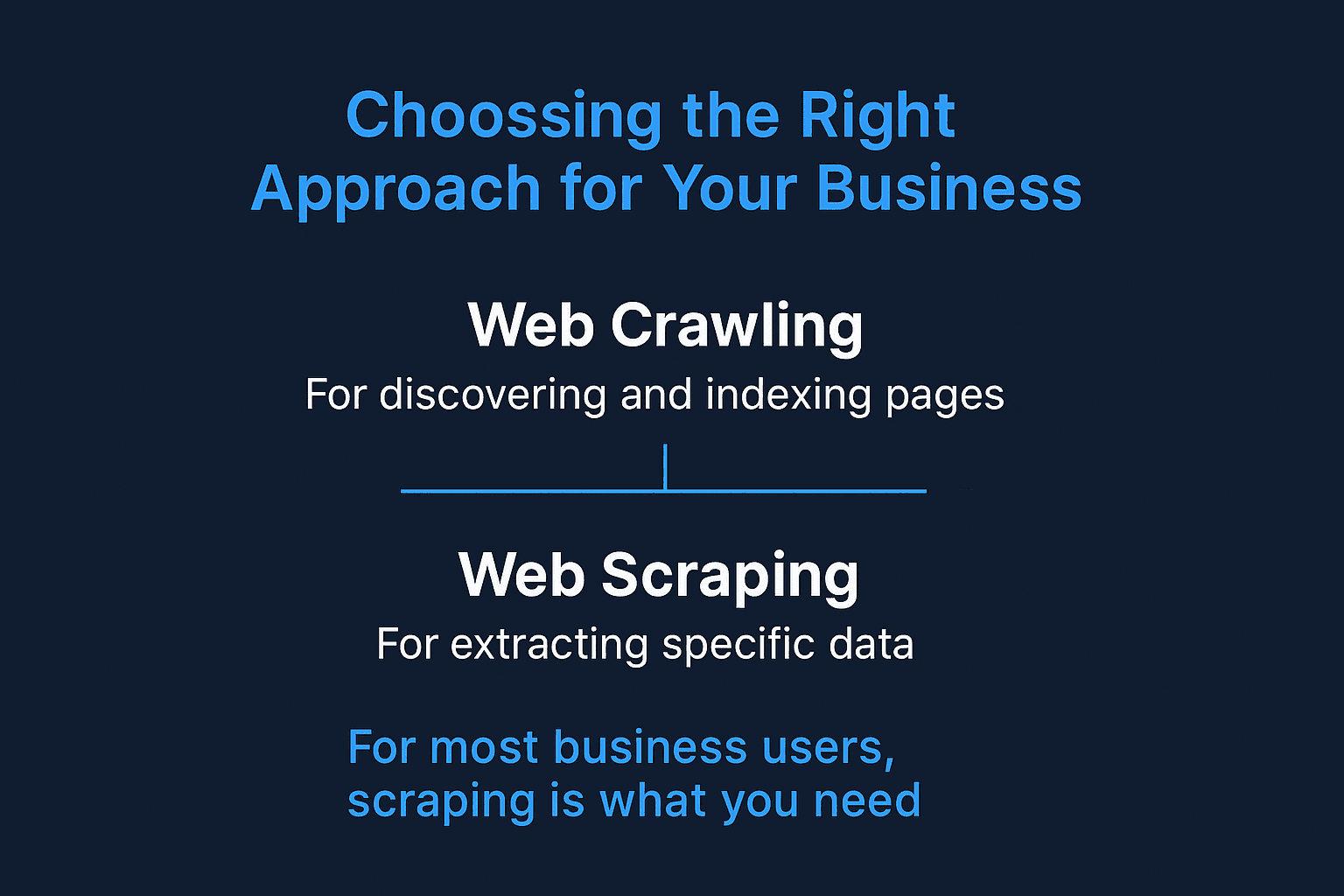

什么时候用网页爬取,什么时候用网页抓取?

这里有个简单决策清单:

-

需要发现新页面或索引整个网站?

→ 选网页爬取。

-

已经知道数据在哪些页面或板块?

→ 选网页抓取。

-

要做搜索引擎或网页归档?

→ 用爬取。

-

要收集销售、价格或调研数据?

→ 用抓取。

-

还不确定?

→ 先从抓取开始。大多数商业需求其实不需要全站爬取。

对大多数企业用户来说,抓取才是你真正需要的——直接拿到结构化数据,马上就能用。

面向企业用户的网页抓取:Thunderbit 的优势

接下来聊聊为什么大多数企业用户,尤其是非技术人员,更适合用抓取工具,以及 如何帮你省心省力。

我见过太多团队在“简单易用”的抓取工具上折腾好几天甚至几周,结果还不理想。Thunderbit 的初衷,就是让网页数据提取变得像点两下鼠标一样简单。

Thunderbit 的亮点:

- 两步操作: 点“AI 智能识别字段”,再点“抓取”,不用编程、不用手动选元素。

- 批量网址 & PDF 支持: 不管是网址列表还是 PDF 文件,Thunderbit 都能一键提取数据。

- 多平台导出: 数据可直接导入 Google Sheets、Airtable、Notion,或下载为 CSV/JSON,无额外费用。

- 子页面抓取: Thunderbit 能自动访问子页面(比如商品详情页),让你的数据表更丰富。

- AI 自动填表: 自动填写表单、批量处理重复性网页任务,像你的数字小助手。

- 免费邮箱 & 电话提取器: 一键抓取页面上的所有联系方式。

- 云端或本地抓取: 可选云端(速度快)或浏览器本地(适合登录页面)两种模式。

- 零学习门槛: 专为销售、电商、市场团队设计,操作直观。

想了解更多应用场景?可以参考我们的实用指南:、、。

Thunderbit 与传统网页爬虫对比

给企业用户做个直观对比:

| 功能/需求 | Thunderbit | 传统网页爬虫(如 Scrapy、Nutch) |

|---|---|---|

| 上手难度 | 两步操作,无需编程 | 需技术配置,常常要写脚本 |

| 学习曲线 | 极低 | 陡峭(尤其对非技术人员) |

| 子页面处理 | AI 自动识别 | 需手动脚本或复杂配置 |

| 批量网址/PDF | 内置支持 | 通常不支持或需自定义开发 |

| 导出格式 | Google Sheets、Airtable、Notion、CSV | CSV、JSON(集成需手动) |

| 适应性 | AI 自动适应网页变化 | 需手动维护和更新 |

| 业务场景 | 销售、电商、SEO、运营 | 搜索引擎、学术研究、归档 |

| 定时任务 | 自然语言调度 | 需写 cron 或外部调度器 |

| 价格 | 起步 $15/月,免费版可用 | 免费/开源,但配置和维护成本高 |

| 支持 | 用户友好,现代界面 | 社区支持,偏开发者 |

Thunderbit 的目标,就是让你从“我需要这些数据”到“数据已在表格里”只需几分钟,无需 IT 支持。

总结:为你的企业选择合适的方式

简单回顾一下:

- 网页爬取 适合发现和索引页面,比如搜索引擎和网站审查。

- 网页抓取 适合提取具体、可用的数据,比如销售线索、价格监控、内容聚合。

- 对大多数企业用户来说,抓取才是刚需,而且不需要编程基础。

互联网只会越来越庞大和复杂。但只要选对方法和工具,你就能从混乱中提炼出有价值的信息。如果你厌倦了复杂的抓取工具或总是等 IT 部门帮忙,不妨试试 。你会发现,数据抓取其实可以如此高效简单(说不定还能帮你把周末还回来)。

想亲自体验 Thunderbit?可以安装我们的 ,或者在 获取更多实用技巧和案例。

祝你抓取顺利(除非你要做下一个 Google,否则不用太纠结爬取)!

常见问题解答

1. 我的企业需要同时用爬虫和抓取工具吗?

不一定。如果你已经知道目标数据在哪些页面,像 Thunderbit 这样的网页爬虫就够了。只有在需要发现新页面(比如全站地图或 SEO 审查)时,才需要用到爬虫。

2. 网页抓取合法吗?

一般来说,抓取公开数据是合法的——只要你没有绕过登录、违反服务条款或收集敏感信息。但用于商业用途时,建议一定要看网站的 robots.txt 和隐私政策。

3. Thunderbit 和其他网页抓取工具有啥不同?

Thunderbit 专为不会编程的企业用户设计。和传统抓取工具需要 HTML 知识和手动配置不同,Thunderbit 利用 AI 自动识别字段、智能跳转子页面,还能一键导出所需格式,真正实现两步操作。

4. Thunderbit 能抓取动态网站和登录页面吗?

可以。Thunderbit 支持浏览器本地抓取(适合登录和动态内容),也支持云端抓取(速度快、适合大批量)。你可以根据数据类型灵活选择。