互联网到处都是有价值的数据——不管你是做销售、电商还是市场调研,网页爬虫都是获取线索、监控价格、分析竞品的神器。但问题也随之而来:越来越多公司加入爬虫大军,网站的反爬措施也变得越来越严。其实,, 已经成了家常便饭。如果你用 Python 脚本爬了 20 分钟突然全是 403 错误,那种崩溃感你一定懂。

我在 SaaS 和自动化领域混迹多年,深知爬虫项目从“太简单了”到“怎么哪都被封”只需要一瞬间。接下来我会用最实用的方式,教你怎么用 Python 做网页爬虫防封,分享一线技巧和代码片段,还会告诉你什么时候该考虑用 AI 网页爬虫(比如 )。不管你是 Python 老炮还是刚入门,都能拿到一套稳定、抗封的爬虫方案。

什么是 Python 网页爬虫防封?

所谓“防封网页爬虫”,就是用一种不容易被网站识别为机器人的方式去抓数据。在 Python 领域,这绝不是简单写个 requests.get() 循环就能搞定的——你得学会伪装成真人用户,巧妙避开各种检测。

为什么选 Python?,因为语法简单、生态丰富(比如 requests、BeautifulSoup、Scrapy、Selenium),既能写小脚本,也能做分布式爬虫。但流行也有副作用:很多反爬系统专门针对 Python 爬虫特征做了升级。

所以,想要稳定爬取,必须跳出基础操作,深入了解网站是怎么识别爬虫的,以及如何巧妙绕过——当然,前提是合法合规。

为什么 Python 爬虫防封这么重要?

被封绝对不是小问题,甚至会影响整个业务流程。来看几个典型场景:

| 应用场景 | 被封的影响 |

|---|---|

| 潜在客户挖掘 | 客户名单不全或过时,销售机会流失 |

| 价格监控 | 漏掉竞争对手调价,定价决策失误 |

| 内容聚合 | 新闻、评论、调研数据出现缺口 |

| 市场情报 | 行业或竞品监控出现盲区 |

| 房产信息采集 | 房源数据不准或滞后,错失商机 |

爬虫被封,意味着数据缺失、资源浪费,甚至可能因为合规风险导致决策失误。在 的今天,稳定性就是生命线。

网站是怎么识别并封禁 Python 网页爬虫的?

现在的网站反爬手段越来越高明,常见的有(参考 、):

- IP 黑名单: 同一个 IP 请求太多,直接拉黑。

- User-Agent 和请求头检测: 用默认或通用请求头(比如 Python 默认的

python-requests/2.25.1)一眼就能识破。 - 限流: 短时间内请求太多会被限速或封号。

- 验证码(CAPTCHA): “证明你是人类”的谜题,难倒大部分爬虫。

- 行为分析: 检查有没有机械化操作,比如每次都点同一个按钮、间隔完全一致。

- 蜜罐陷阱: 隐藏的链接或表单,只有爬虫才会点。

- 浏览器指纹识别: 收集浏览器和设备信息,识别自动化工具。

- Cookie 和会话跟踪: 不处理 Cookie 或 Session 的爬虫很容易被发现。

就像过安检一样:你和大家一样低调就能顺利通过,穿风衣戴墨镜就会被重点盘查。

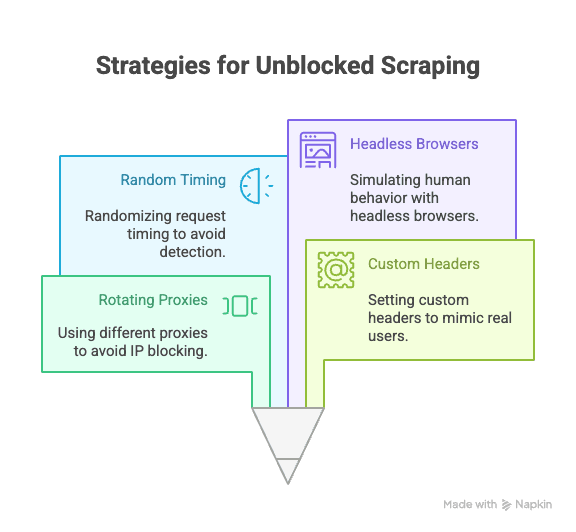

Python 爬虫防封核心技巧

下面进入实操环节,教你用 Python 规避封禁的关键方法:

代理池与 IP 轮换

原理: 所有请求都来自同一个 IP,分分钟被封。代理池能让请求分散到多个 IP,大大降低被封概率。

Python 示例:

1import requests

2proxies = [

3 "<http://proxy1.example.com:8000>",

4 "<http://proxy2.example.com:8000>",

5 # ...更多代理

6]

7for i, url in enumerate(urls):

8 proxy = {"http": proxies[i % len(proxies)]}

9 response = requests.get(url, proxies=proxy)

10 # 处理响应建议用付费住宅代理或动态代理,稳定性更高(参考 )。

设置 User-Agent 和自定义请求头

原理: Python 默认请求头很容易暴露身份。模仿真实浏览器请求头能有效伪装。

代码示例:

1headers = {

2 "User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/124.0.0.0 Safari/537.36",

3 "Accept-Language": "en-US,en;q=0.9",

4 "Accept-Encoding": "gzip, deflate, br",

5 "Connection": "keep-alive"

6}

7response = requests.get(url, headers=headers)多准备几个 User-Agent 随机切换,效果更好(参考 )。

随机化请求间隔与行为模式

原理: 机器人请求速度快且规律,人工操作则慢且随机。加点延迟、打乱访问顺序更像真人。

Python 示例:

1import time, random

2for url in urls:

3 response = requests.get(url)

4 time.sleep(random.uniform(2, 7)) # 随机等待 2-7 秒用 Selenium 时,还可以随机点击、滚动页面。

管理 Cookie 和会话

原理: 很多网站需要 Cookie 或 Session 才能访问内容,忽略这些很容易被封。

Python 示例:

1import requests

2session = requests.Session()

3response = session.get(url)

4# session 会自动管理 Cookie复杂流程可以用 Selenium 抓 Cookie 再复用。

用无头浏览器模拟真人操作

原理: 有些网站会检测 JS 执行、鼠标移动、滚动等行为。Selenium、Playwright 等无头浏览器能模拟这些动作。

Selenium 示例:

1from selenium import webdriver

2from selenium.webdriver.common.action_chains import ActionChains

3import random, time

4driver = webdriver.Chrome()

5driver.get(url)

6actions = ActionChains(driver)

7actions.move_by_offset(random.randint(0, 100), random.randint(0, 100)).perform()

8time.sleep(random.uniform(2, 5))这样能绕过行为分析和动态内容加载(参考 )。

进阶技巧:Python 如何绕过验证码和蜜罐

验证码(CAPTCHA) 主要用来阻挡机器人。简单验证码可以用 Python 库破解,但大多数场景还是得靠第三方服务(比如 2Captcha、Anti-Captcha,需付费,参考 )。

集成示例:

1# 伪代码,调用 2Captcha API

2import requests

3captcha_id = requests.post("<https://2captcha.com/in.php>", data={...}).text

4# 等待结果,再提交请求蜜罐陷阱 是网站专门设置的隐藏字段或链接,只有爬虫才会点。用 Selenium 等工具模拟真实浏览器操作,避免点击页面上看不到的内容(参考 )。

用 Python 库设计更真实的请求头

除了 User-Agent,还可以随机切换 Referer、Accept、Origin 等请求头,进一步伪装。

Scrapy 示例:

1class MySpider(scrapy.Spider):

2 custom_settings = {

3 'DEFAULT_REQUEST_HEADERS': {

4 'User-Agent': '...',

5 'Accept-Language': 'en-US,en;q=0.9',

6 # 更多请求头

7 }

8 }Selenium 可以通过浏览器配置或 JS 注入设置请求头。

建议用浏览器开发者工具抓包,模仿真实请求头。

当传统 Python 爬虫遇到瓶颈:反爬技术升级

现实情况是:爬虫越普及,反爬技术也越强。。AI 检测、动态限流、浏览器指纹等手段让再高级的 Python 脚本也难以长期稳定运行(参考 )。

有时候,无论代码多巧妙,还是会被封。这时就该考虑换一种方式了。

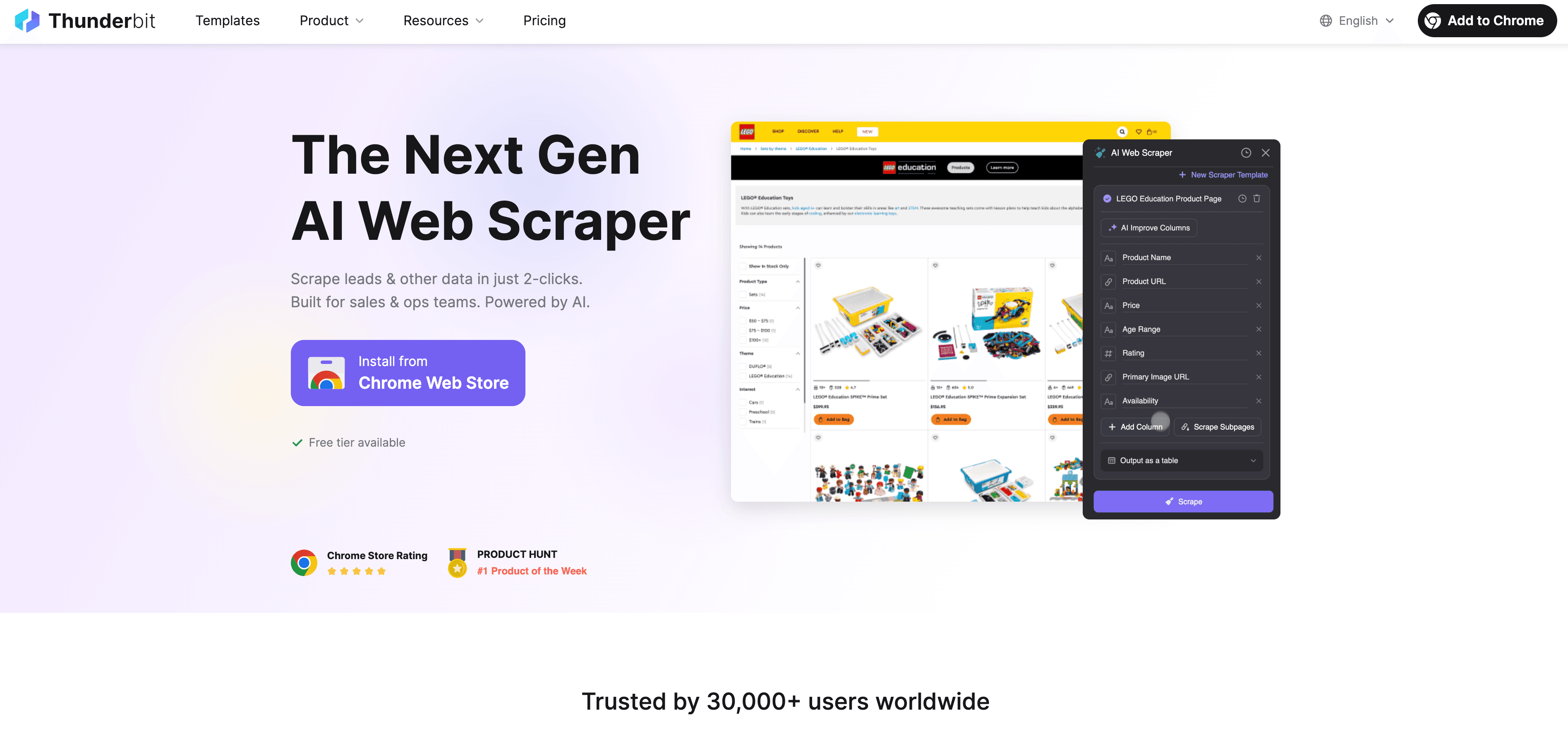

Thunderbit:AI 网页爬虫,Python 之外的新选择

当 Python 爬虫遇到瓶颈, 作为一款零代码、AI 驱动的网页爬虫,为非开发者量身打造。无需折腾代理、请求头、验证码,Thunderbit 的 AI 智能识别网页、自动推荐字段、支持子页面采集和数据导出。

Thunderbit 有哪些亮点?

- AI 字段推荐: 一键“AI 推荐字段”,自动识别页面结构,生成采集指令。

- 子页面采集: 可自动访问详情页(比如商品详情、领英个人页),让数据更丰富。

- 云端/本地双模式: 公共网页用云端,登录页面用本地浏览器,速度和兼容性都兼顾。

- 定时爬取: 支持定时任务,数据实时更新。

- 一键模板: 针对热门网站(亚马逊、Zillow、Shopify 等)有现成模板,无需配置。

- 免费导出: 支持导出到 Excel、Google Sheets、Airtable、Notion,无额外费用。

Thunderbit 已获得 ,无需写代码即可上手。

Thunderbit 如何帮你防封、自动化采集?

Thunderbit 的 AI 不只是模拟人工操作,更能实时适应每个网站,降低被封风险:

- AI 动态适应页面变动: 网站改版也不用担心脚本失效。

- 自动处理子页面与分页: 像真人一样自动点击详情、翻页。

- 云端高效批量采集: 一次可抓取 50 个页面,速度极快。

- 零代码、免维护: 你只需关注数据分析,无需调试脚本。

想了解更多?推荐阅读 。

Python 爬虫 vs Thunderbit:如何选择?

对比一下两者:

| 功能 | Python 爬虫 | Thunderbit |

|---|---|---|

| 上手难度 | 中高(需写脚本、配置代理等) | 极低(2 步操作,AI 全自动) |

| 技术门槛 | 需编程基础 | 无需代码 |

| 稳定性 | 易受网站变动影响 | 高(AI 自动适应) |

| 被封风险 | 中高 | 低(AI 模拟用户,动态调整) |

| 扩展性 | 需自建云端/批量处理 | 内置云端批量采集 |

| 维护成本 | 频繁(网站变动、被封需修复) | 极低(AI 自动调整) |

| 导出方式 | 手动(CSV、数据库) | 直接导出到 Sheets、Notion、Airtable、CSV |

| 成本 | 免费(但耗时) | 免费基础版,进阶功能付费 |

适合用 Python 的场景:

- 需要高度自定义、复杂逻辑或与其他 Python 流程集成。

- 目标网站反爬措施较弱。

适合用 Thunderbit 的场景:

- 追求速度、稳定、零配置。

- 目标网站结构复杂、经常变动。

- 不想折腾代理、验证码、代码维护。

实战教程:Python 防封网页爬虫搭建流程

以采集商品数据为例,结合防封技巧实操:

1. 安装依赖库

1pip install requests beautifulsoup4 fake-useragent2. 编写基础脚本

1import requests

2from bs4 import BeautifulSoup

3from fake_useragent import UserAgent

4import time, random

5ua = UserAgent()

6urls = ["<https://example.com/product/1>", "<https://example.com/product/2>"] # 替换为目标网址

7for url in urls:

8 headers = {

9 "User-Agent": ua.random,

10 "Accept-Language": "en-US,en;q=0.9"

11 }

12 response = requests.get(url, headers=headers)

13 if response.status_code == 200:

14 soup = BeautifulSoup(response.text, "html.parser")

15 # 数据提取逻辑

16 print(soup.title.text)

17 else:

18 print(f"{url} 被封或出错: {response.status_code}")

19 time.sleep(random.uniform(2, 6)) # 随机延迟3. 可选:添加代理池

1proxies = [

2 "<http://proxy1.example.com:8000>",

3 "<http://proxy2.example.com:8000>",

4 # 更多代理

5]

6for i, url in enumerate(urls):

7 proxy = {"http": proxies[i % len(proxies)]}

8 headers = {"User-Agent": ua.random}

9 response = requests.get(url, headers=headers, proxies=proxy)

10 # ...后续处理4. 管理 Cookie 和会话

1session = requests.Session()

2for url in urls:

3 response = session.get(url, headers=headers)

4 # ...后续处理5. 常见问题排查

- 出现大量 403/429 错误,建议降低请求频率或更换代理。

- 遇到验证码,可以尝试 Selenium 或验证码识别服务。

- 一定要查看目标网站的 robots.txt 和服务条款。

总结与要点回顾

用 Python 做网页爬虫很强大,但反爬技术天天升级,被封风险始终存在。想要稳定采集,必须结合多种技术手段(代理池、智能请求头、随机延迟、会话管理、无头浏览器)并遵守网站规则和道德底线。

但有时候,即使用尽 Python 技巧也难以突破。这时,AI 网页爬虫如 就能帮你轻松搞定——无需代码,抗封稳定,特别适合商业用户。

想体验更简单的网页采集? 试试,或者访问我们的 获取更多爬虫技巧和教程。

常见问题解答

1. 为什么网站会封禁 Python 网页爬虫?

网站封禁爬虫主要是为了保护数据、避免服务器压力过大,以及防止自动化滥用。Python 脚本如果用默认请求头、不处理 Cookie 或请求过快,很容易被识别。

2. Python 爬虫防封最有效的方法有哪些?

建议使用代理池、设置真实的 User-Agent 和请求头、随机化请求间隔、管理 Cookie/Session,并用 Selenium、Playwright 等工具模拟人工操作。

3. Thunderbit 如何比 Python 脚本更好地防封?

Thunderbit 利用 AI 动态适应网页结构,模拟人工浏览,自动处理子页面和分页。无需代码和代理,实时调整策略,大幅降低被封风险。

4. 什么时候该用 Python 爬虫,什么时候用 Thunderbit?

需要自定义逻辑、与 Python 代码集成或目标网站反爬弱时,适合用 Python。追求高效、稳定、批量采集,或面对复杂、易变网站时,推荐 Thunderbit。

5. 网页爬虫合法吗?

只要采集公开数据,遵守网站服务条款、隐私政策和相关法律,网页爬虫是合法的。切勿抓取敏感或私人数据,务必合规、负责任地使用爬虫。

想让网页采集更高效?不妨试试 Thunderbit,轻松告别被封困扰。

延伸阅读:

- 用 Python 抓取 Google News 全流程指南

- 用 Python 打造 Best Buy 价格监控工具

- 14 种网页爬虫防封技巧

- 10 个网页爬虫防封实用建议