网页爬虫已经悄悄成为现代企业团队的“王牌工具”。不管你是做销售、运营,还是想随时掌握竞品动态,能自动从网站提取数据,已经成了必备本领。过去几年,发生了哪些变化?首先,互联网变得越来越“活”——比如各种交互式仪表盘、无限下拉、点按钮才显示的内容。而让这些网页动起来的核心,就是 JavaScript 这门语言。

作为一个长期混迹在 SaaS 和自动化领域的老兵,我亲眼见证了 JavaScript 和 Node.js 从开发者的“加分项”,变成了企业数据采集的主力引擎。数据不会骗人:,而全球网页爬虫市场预计到 2030 年还会保持两位数增长()。这篇指南,我会带你详细了解用 JavaScript 和 Node.js 做网页爬虫到底怎么玩、为什么值得学,以及——最重要的——就算你不会写代码,也能用 这类工具轻松搞定。无论你是不是技术出身,现在都是把互联网“杂乱”变成商业价值的最佳时机。

什么是 JavaScript 网页爬虫?原理一看就懂

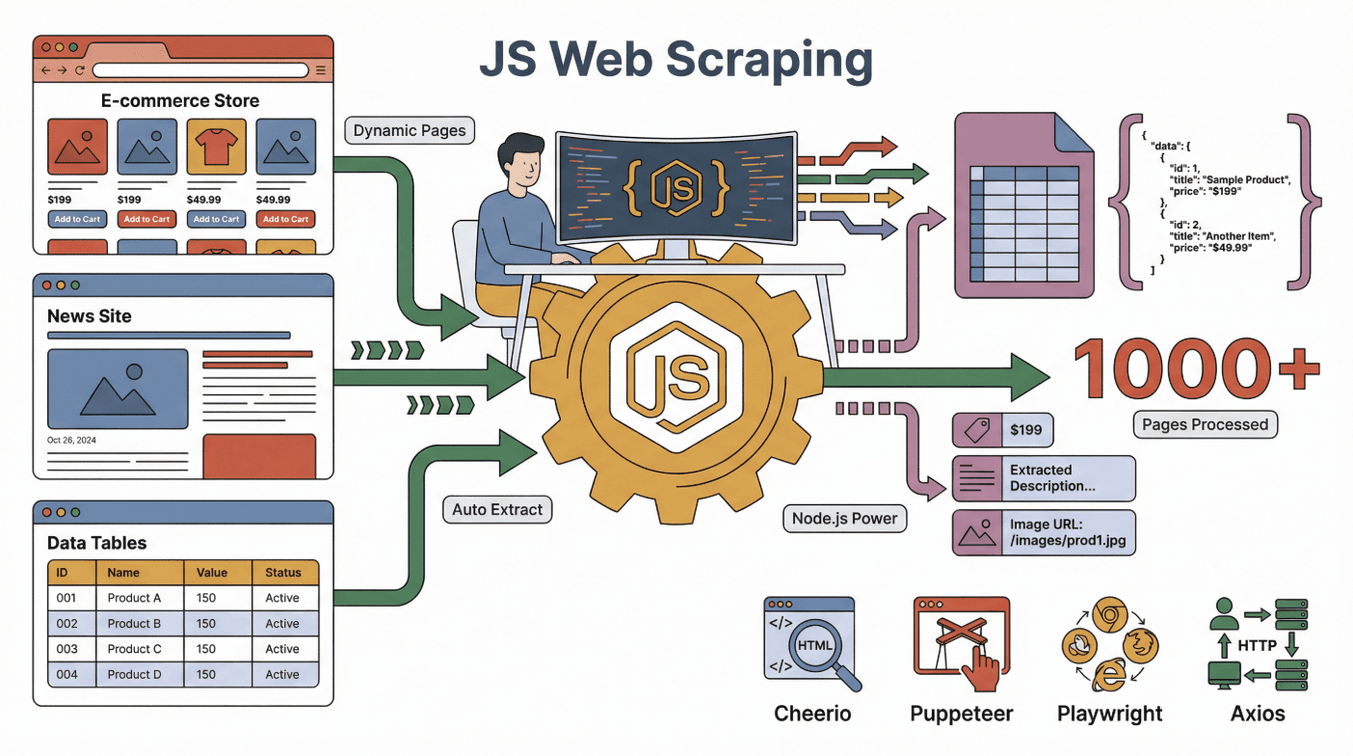

先来点基础。用 JavaScript 做网页爬虫,就是用 JavaScript(通常配合 Node.js)自动从网页里提取数据。你可以把它想象成派了个“数字小助手”去网站,把你关心的信息读出来、整理进表格——而且这个助手能同时处理成千上万的页面,永远不喊累,还能自动点按钮、填表单。

先来点基础。用 JavaScript 做网页爬虫,就是用 JavaScript(通常配合 Node.js)自动从网页里提取数据。你可以把它想象成派了个“数字小助手”去网站,把你关心的信息读出来、整理进表格——而且这个助手能同时处理成千上万的页面,永远不喊累,还能自动点按钮、填表单。

JavaScript 在这里有天然优势,因为它本来就是浏览器构建和刷新网页的核心语言。Node.js 则让你能在浏览器外跑 JavaScript,实现自动化操作,比如:

- 加载网页(哪怕页面是动态的、交互式的)

- 自动点按钮、滚动页面、等内容加载出来

- 抓取页面上的文本、图片、价格、邮箱等各种信息

常见的 JavaScript 网页爬虫工具有:

- : 适合解析和提取静态 HTML 页面数据(有点像服务器端的 jQuery)。

- : 能自动操作真实的 Chrome 浏览器,适合需要交互的动态网站。

- : 跟 Puppeteer 类似,但支持多浏览器自动化,功能更强。

- : 用来发 HTTP 请求,抓网页或 API 数据。

这些工具搭配起来效果最好:Axios 或 Puppeteer 负责抓页面,Cheerio 解析 HTML,Node.js 负责整体流程调度。

静态页面 vs 动态页面:JavaScript 的独特作用

- 静态页面:内容一开始就全在页面上,用简单工具就能抓。

- 动态页面:内容是后面通过 JavaScript 动态渲染出来的。要用浏览器自动化(比如 Puppeteer)才能看到和提取数据()。

现在很多网站都用动态内容(比如 Amazon、LinkedIn、Zillow),JavaScript 网页爬虫已经成了抓核心数据的“标配”。

为什么选 JavaScript 做网页爬虫?和其他语言比有啥优势

如果你经常泡开发者社区,肯定见过无休止的争论:JavaScript、Python、Ruby、Go,哪种语言更适合做爬虫?结合多年实战,我的观点是:

JavaScript 的独家绝活

- 原生支持动态内容:JavaScript 是浏览器的“母语”,天生适合和现代动态网站打交道()。

- 浏览器自动化超强:Puppeteer、Playwright 等工具能像真人一样点、滚、填表单。

- 前端经验直接复用:团队有前端基础,做爬虫几乎零门槛()。

- 高并发高效率:Node.js 能同时处理大量任务,抓取速度快()。

- 生态庞大:开源库、教程、社区资源丰富。

JavaScript 和 Python、Ruby、Go 的对比

| 语言 | 动态内容支持 | 浏览器自动化 | 社区规模 | 速度 | 最佳应用场景 |

|---|---|---|---|---|---|

| JavaScript | 极佳 | 极佳 | 超大 | 快速 | 交互式网站、前端团队 |

| Python | 良好(配合 Selenium/Playwright) | 良好 | 超大 | 快速 | API、静态站、数据分析 |

| Ruby | 一般 | 有限 | 小众 | 中等 | 简单静态抓取 |

| Go | 有限 | 有限 | 逐步增长 | 非常快 | 大规模后端爬虫 |

对于现代、交互性强的网站,JavaScript(配合 Node.js)往往是最强武器()。Python 也很强,但遇到大量 JavaScript 渲染的页面,JavaScript 还是更胜一筹()。

JavaScript 和 Node.js 网页爬虫的主力工具

来看看 JavaScript 网页爬虫工具箱里的“主力阵容”:

- Node.js:让 JavaScript 能在浏览器外跑,相当于你的“指挥中心”。

- Cheerio:解析 HTML,像“帮我找出所有商品名”这样选页面元素。

- Puppeteer/Playwright:自动化真实浏览器,搞定动态内容、登录、复杂交互。

- Axios/Fetch:直接抓网页或 API。

- 其他辅助库:比如导出数据(CSV、Excel)、代理管理、定时任务等。

它们怎么配合? 可以把 Puppeteer 想成“机器人浏览器”,Cheerio 是“数据侦探”,Node.js 则是“项目经理”,保证流程顺畅。

JavaScript 网页爬虫的工作流程:一步步拆解

来拆解下典型的 JavaScript 网页爬虫流程:

- 发请求:用 Axios 或 Puppeteer 加载网页。

- 等内容加载:如果页面是动态的,要等 JavaScript 渲染完(Puppeteer 能“看到”最终页面)。

- 提取数据:用 Cheerio 或浏览器 API 选取并复制需要的数据。

- 处理分页/子页面:自动点“下一页”或跟进链接,抓更多数据。

- 导出数据:把结果保存成 CSV、Excel、Google Sheets 或数据库。

打个比方: 就像派了个超能实习生,帮你访问每个页面、做笔记、整理成表格。

静态内容 vs 动态内容:有啥区别?

- 静态站点例子:博客文章都直接写在 HTML 里。Cheerio + Axios 就够了。

- 动态站点例子:电商网站价格要滚动后才加载。必须用 Puppeteer 或 Playwright 才能“看到”最终价格()。

小贴士: 如果爬虫抓到的是空白页面,十有八九是动态内容——这时候就要用 Puppeteer 了。

Thunderbit:让 JavaScript 级网页爬虫零代码上手

这部分特别适合非技术用户。我们在 的目标,就是让每个人都能用上 JavaScript 级别的网页爬虫,完全不用写代码。

我们的理念: 网页爬虫应该像实习生一样“听得懂任务”——你只要描述需求,AI 自动帮你搞定。

Thunderbit 如何让人人都能用上 JavaScript 爬虫

- AI 智能字段识别:只需点一下,Thunderbit 的 AI 就能扫描页面,自动推荐可提取的数据,并帮你配置好爬虫。

- 子页面采集:需要更详细信息?Thunderbit 能自动访问每个子页面(比如商品页、个人资料页),自动补全表格。

- 一键模板:热门网站(如 Amazon、Zillow、Shopify)直接选模板,无需配置。

- 免费数据导出:数据可直接导出到 Excel、Google Sheets、Airtable 或 Notion,无需额外付费。

真实案例: 很多销售团队用 Thunderbit 从动态目录一键抓取数百条潜在客户信息(含邮箱、电话),不用写代码,几分钟搞定。就像团队里多了个 JavaScript 开发者,但你不用招人。

热门应用场景:JavaScript 网页爬虫在销售与运营中的实战

JavaScript 网页爬虫早就不是技术宅的专利。现实中,很多团队每天都在用它:

| 团队 | 应用场景 | 效果 |

|---|---|---|

| 销售 | 从目录网站批量获取潜在客户 | 线索量提升 10 倍,直接导入 CRM |

| 电商 | 监控竞争对手价格 | 实时动态定价,市场反应更快 |

| 运营 | 汇总多供应商库存信息 | SKU 一站式管理 |

| 房地产 | 聚合房源信息 | 市场数据实时更新,一表尽览 |

| 市场营销 | 评论与情感分析 | 洞察更快,精准投放 |

举个例子: 有电商团队反馈,用 Thunderbit 抓竞争对手价格,每周能省 20 小时以上,定价调整更及时()。

JavaScript 网页爬虫的合规与法律问题

必须正视一个问题:网页爬虫合法吗? 简单说,只要抓的是公开数据并遵守网站规则,通常是合法的()。但有几点要注意:

- 遵守 robots.txt:网站明确禁止爬虫时要尊重。

- 遵守服务条款:有些网站明令禁止抓取。

- 保护隐私:不要收集或滥用个人数据。

- 避免高频访问:合理控制抓取速度,别给服务器添堵。

近年法院普遍支持抓取公开数据,但版权和隐私法规依然适用()。有疑问建议咨询专业律师。

最佳实践: 只抓取你愿意公开分享的数据,并注明数据来源。

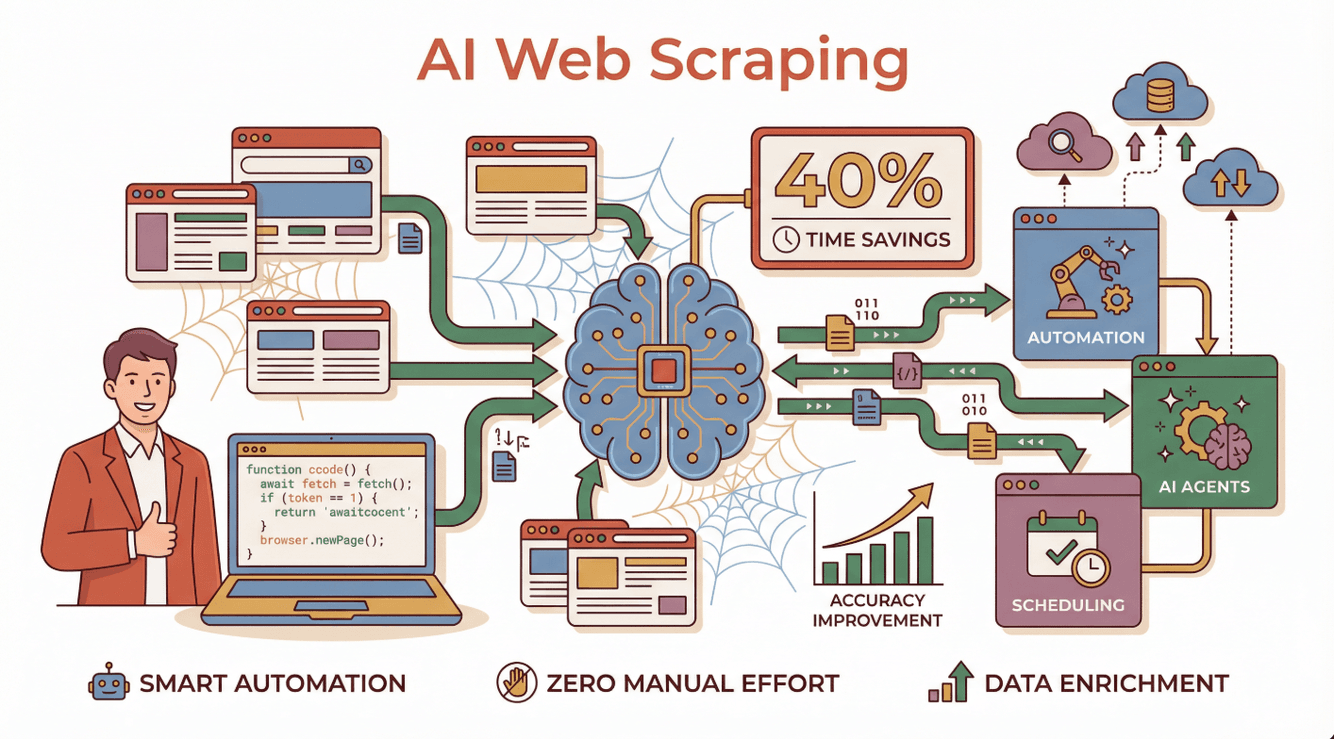

JavaScript 网页爬虫的未来:AI 与自动化趋势

未来已来。AI 正在把网页爬虫从繁琐、重代码的活,变成智能、自动化的流程。用 AI 驱动爬虫的企业普遍反馈 ,数据更准,连最复杂的动态网站也能轻松搞定()。

未来已来。AI 正在把网页爬虫从繁琐、重代码的活,变成智能、自动化的流程。用 AI 驱动爬虫的企业普遍反馈 ,数据更准,连最复杂的动态网站也能轻松搞定()。

实际应用有哪些?

- AI 智能代理:能用自然语言理解指令,自动适应网站变化,遇到错误还能自我修复()。

- 自动定时采集:每天自动获取最新数据,无需人工干预。

- 数据智能加工:AI 可自动分类、摘要,甚至实时翻译采集到的数据。

Thunderbit 就是这股趋势的代表,让任何人都能零代码搭建和运行 AI 网页爬虫,无需维护。

想了解 AI 网页爬虫的未来? 推荐阅读我们的深度指南:。

入门指南:给企业用户的实用建议

想试试用 JavaScript 做网页爬虫(或用 Thunderbit 的零代码方案)?可以这样开始:

- 明确目标:你需要什么数据?打算怎么用?

- 选工具:会技术可以用 Node.js + Puppeteer/Cheerio,不会代码直接,让 AI 自动帮你搞定。

- 小规模试水:先在少量页面测试,逐步扩展。

- 导出与分析:数据可导入 Google Sheets、Excel 或 Notion 进一步分析。

- 合规优先:始终尊重隐私、服务条款和抓取频率。

想深入学习? 推荐看 的新手教程,或加入 Stack Overflow、Reddit r/webscraping 等社区交流。

总结:用 JavaScript 网页爬虫释放商业价值

一句话总结:JavaScript 和 Node.js 已经成为现代网页爬虫的核心,尤其适合动态、交互性强的网站。不管你是开发者还是业务用户,结合浏览器自动化、庞大生态和 AI 工具,你都能更快、更准地拿到想要的数据。

有了像 这样的零代码方案,你不用写一行代码,也能体验 JavaScript 级爬虫的强大。只要描述需求,点几下,数据就能自动到手——不管是分析、获客,还是其他业务场景。

如果你也想把互联网的“杂乱”变成结构化、可用的数据,现在就是最佳时机。祝你爬虫顺利,数据合规、干净,永远快人一步!

常见问题解答

1. 什么是用 JavaScript 和 Node.js 做网页爬虫?

就是用 JavaScript 代码(通常跑在 Node.js 上)自动从网站提取数据。这种方式对动态内容网站特别有效。

2. 为什么 JavaScript 比 Python 或 Ruby 更适合抓取动态网站?

JavaScript 是浏览器渲染和更新网页的核心语言,能更自然地和动态内容互动。Puppeteer、Playwright 等工具能自动操作真实浏览器,轻松抓取依赖 JavaScript 的网站。

3. 不懂技术也能用 JavaScript 做网页爬虫吗?

当然可以。像 这样的零代码工具,让每个人都能用自然语言描述需求,AI 自动搞定技术细节。

4. 网页爬虫合法吗?

一般来说,抓取公开数据是合法的,但必须遵守网站服务条款、robots.txt 和隐私法规。不要抓取个人或受版权保护的数据。

5. AI 如何改变 JavaScript 网页爬虫?

AI 让网页爬虫更智能、更易用。它能自动适应网站变化、处理异常,甚至实时加工和丰富数据,大幅提升效率和准确率。Thunderbit 就是 AI 网页爬虫的代表。

想获取更多实用指南和技巧,欢迎访问 或订阅我们的 。

延伸阅读