让我带你回到不久前的某一天:我坐在工位前,手里端着咖啡,盯着一张比周日晚上冰箱还要空的表格。销售团队急着要竞争对手的价格数据,市场部想要最新的潜在客户名单,运营同事还催着要十几个网站的商品信息——最好昨天就给到。我明明知道这些数据都在网上,但怎么高效搞到手才是真正的难题。如果你也曾为复制粘贴数据而头大,别担心,你绝对不是一个人在战斗。

现在,数据采集早就不是极客的小玩意,而是企业的核心武器。JavaScript 和 Node.js 也从幕后走到台前,撑起了从简单脚本到复杂数据管道的各种需求。但说实话,虽然工具越来越强大,入门门槛依然不低,很多人还是觉得像穿着拖鞋爬珠峰。所以,不管你是业务人员、数据爱好者,还是已经厌倦了手动录入数据,这份指南都能帮你理清思路:从生态全景、核心库、常见难题,到为什么有时候让 AI 自动化才是最聪明的选择。

为什么用 JavaScript 和 Node.js 做网页爬虫对企业很关键

先聊聊“为什么”。到了 2025 年,网络数据早已不是“锦上添花”,而是企业决策的命脉。最新研究显示,,而大约 已经专门用于网络数据采集。另类数据市场(包括网页爬虫)如今已是 ,而且还在飞速增长。

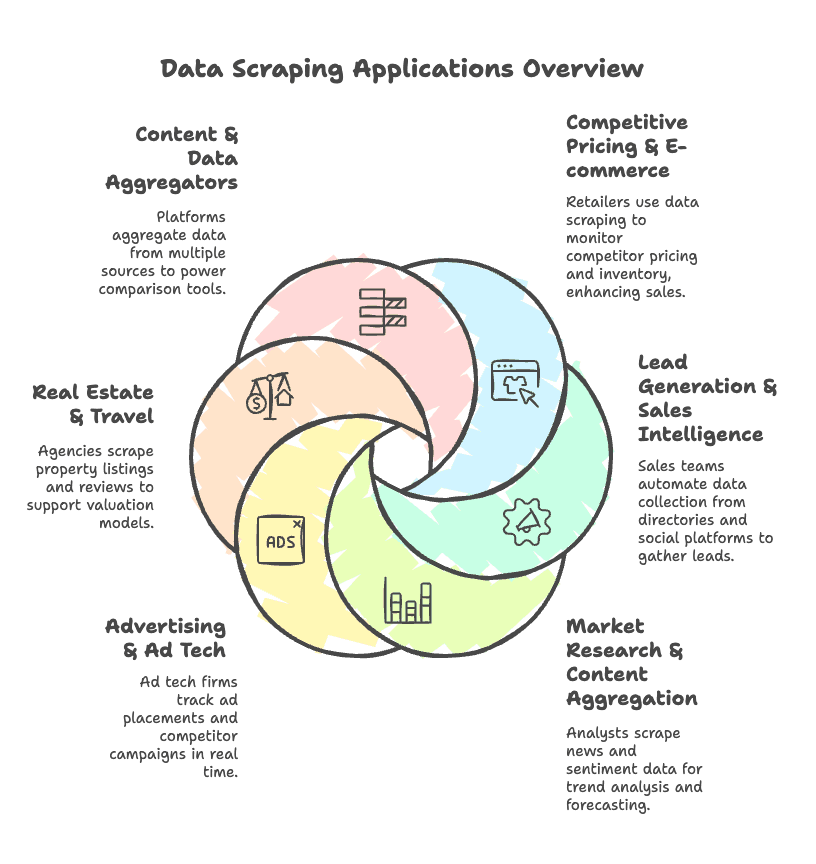

是什么推动了这场“数据淘金热”?下面这些商业场景最常见:

- 竞品价格监控 & 电商分析: 零售商自动抓取竞争对手网站的价格和库存,有时能让销量提升 。

- 线索挖掘 & 销售情报: 销售团队自动收集邮箱、电话、公司信息,来源包括黄页和社交平台。

- 市场调研 & 内容聚合: 分析师抓取新闻、评论和舆情数据,用于趋势洞察和预测。

- 广告投放 & 广告技术: 广告科技公司实时追踪广告位和竞品投放。

- 房产 & 旅游: 中介机构抓取房源、价格和评论,辅助估值和市场分析。

- 内容 & 数据聚合平台: 多渠道采集数据,驱动比价工具和数据看板。

随着越来越多网站采用 JavaScript 渲染,JavaScript + Node.js 已经成了数据采集的首选技术栈。Node.js 擅长异步操作,天生适合大规模并发爬取。加上丰富的生态库,无论是临时脚本还是企业级爬虫,都能轻松搞定。

核心流程:JavaScript 和 Node.js 网页爬虫怎么工作

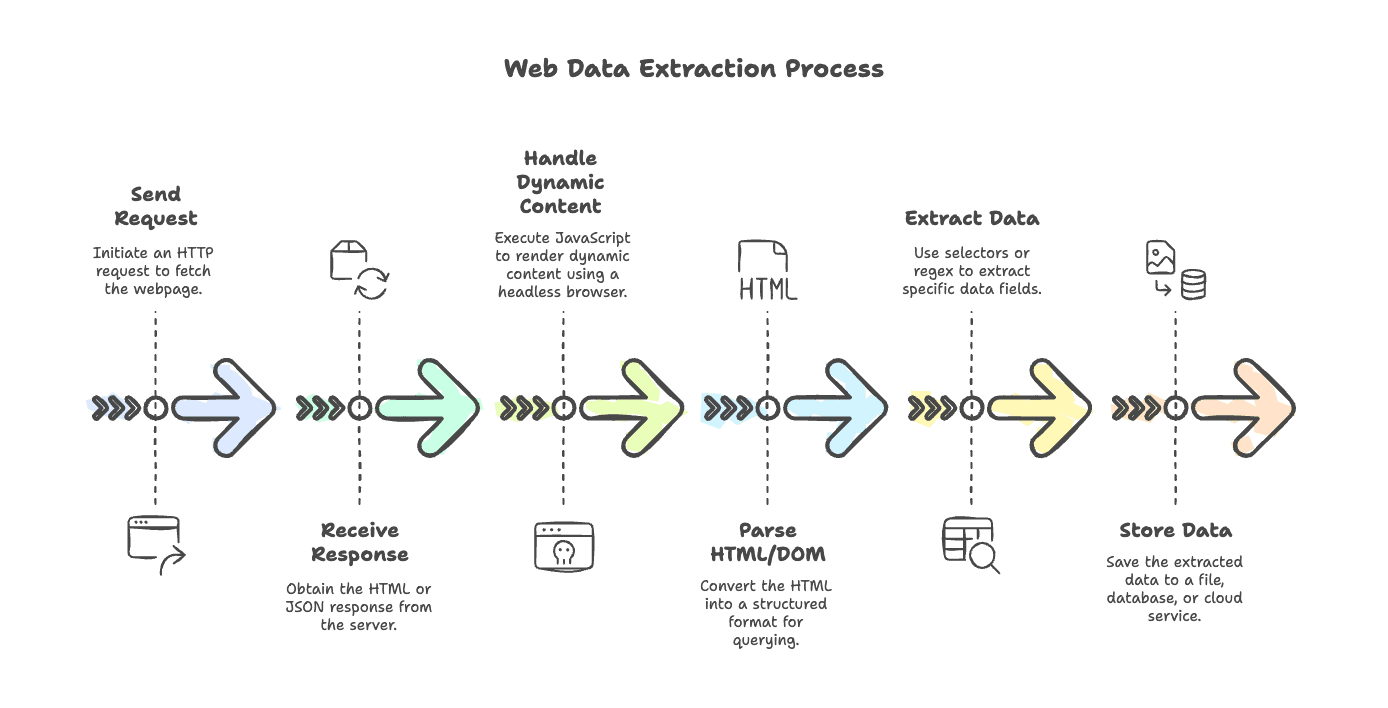

我们来拆解一下典型的网页爬虫流程。不管你是抓简单博客,还是 JS 动态渲染的电商网站,基本步骤都差不多:

- 发起请求: 用 HTTP 客户端获取网页(比如

axios、node-fetch、got)。 - 接收响应: 拿到 HTML(有时是 JSON)内容。

- 处理动态内容: 如果页面由 JavaScript 渲染,用无头浏览器(如 Puppeteer、Playwright)执行脚本,拿到最终内容。

- 解析 HTML/DOM: 用解析器(

cheerio、jsdom)把 HTML 变成可查询的结构。 - 提取数据: 用选择器或正则抓取你要的字段。

- 存储数据: 保存到文件、数据库或云端。

每一步都有专属工具和最佳实践,下面详细聊聊。

JavaScript 网页爬虫常用 HTTP 请求库

爬虫的第一步就是发 HTTP 请求。Node.js 这块选择很多,有经典的,也有新潮的。下面是主流库的简要盘点:

1. Axios

基于 Promise 的 HTTP 客户端,支持 Node 和浏览器。几乎是爬虫界的“瑞士军刀”。

1const axios = require('axios');

2const response = await axios.get('https://example.com/api/items', { timeout: 5000 });

3console.log(response.data);优点: 功能全,支持 async/await,自动解析 JSON,拦截器、代理等一应俱全。

缺点: 体积稍大,部分数据处理有点“魔法”。

2. node-fetch

Node.js 版的浏览器 fetch API。简洁现代。

1import fetch from 'node-fetch';

2const res = await fetch('https://api.github.com/users/github');

3const data = await res.json();

4console.log(data);优点: 轻量,前端开发者用起来很顺手。

缺点: 功能精简,错误处理和代理配置要自己动手。

3. SuperAgent

老牌 HTTP 库,链式 API。

1const superagent = require('superagent');

2const res = await superagent.get('https://example.com/data');

3console.log(res.body);优点: 稳定成熟,支持表单、文件上传、插件。

缺点: API 风格偏老,依赖较大。

4. Unirest

简单、跨语言的 HTTP 客户端。

1const unirest = require('unirest');

2unirest.get('https://httpbin.org/get?query=web')

3 .end(response => {

4 console.log(response.body);

5 });优点: 语法简单,适合快速写脚本。

缺点: 功能有限,社区活跃度一般。

5. Got

Node.js 下高性能、功能强大的 HTTP 客户端。

1import got from 'got';

2const html = await got('https://example.com/page').text();

3console.log(html.length);优点: 速度快,支持 HTTP/2、重试、流式处理。

缺点: 只支持 Node,API 对新手稍复杂。

6. Node 原生 http/https

最原始的方式:

1const https = require('https');

2https.get('https://example.com/data', (res) => {

3 let data = '';

4 res.on('data', chunk => { data += chunk; });

5 res.on('end', () => {

6 console.log('Response length:', data.length);

7 });

8});优点: 不用装额外依赖。

缺点: 代码啰嗦,回调多,不支持 Promise。

。

如何选 HTTP 客户端?

我的选型标准:

- 易用性: Axios、Got 语法简洁,支持 async/await。

- 性能: Got、node-fetch 轻量高效,适合高并发。

- 代理支持: Axios、Got 代理配置简单。

- 错误处理: Axios 默认抛 HTTP 错误,node-fetch 需手动判断。

- 社区活跃度: Axios、Got 社区庞大,资料丰富。

我的建议:

- 快速脚本/原型: node-fetch 或 Unirest。

- 生产级爬虫: Axios(功能全)或 Got(性能优)。

- 浏览器自动化: Puppeteer、Playwright 内置请求。

HTML 解析与数据提取:Cheerio、jsdom 等

拿到 HTML 后,下一步就是解析成可操作的结构。这就需要用到解析器。

Cheerio

Cheerio 就像服务器端的 jQuery,速度快、体积小,适合处理静态 HTML。

1const cheerio = require('cheerio');

2const $ = cheerio.load('<ul><li class="item">Item 1</li></ul>');

3$('.item').each((i, el) => {

4 console.log($(el).text());

5});优点: 极速,API 类 jQuery,能处理杂乱 HTML。

缺点: 不支持 JS 执行,只能看到 HTML 里的内容。

。

jsdom

jsdom 在 Node.js 里模拟浏览器 DOM,能执行简单脚本,更接近真实浏览器。

1const { JSDOM } = require('jsdom');

2const dom = new JSDOM(`<p id="greet">Hello</p><script>document.querySelector('#greet').textContent += ", world!";</script>`);

3console.log(dom.window.document.querySelector('#greet').textContent);优点: 可运行脚本,支持完整 DOM API。

缺点: 比 Cheerio 慢且重,不是完整浏览器。

。

什么时候用正则或其他解析方式?

正则在爬虫里就像辣椒酱——用得好很香,滥用容易翻车。适合:

- 从文本中提取特定模式(如邮箱、电话、价格)。

- 清洗或校验抓取数据。

- 从文本块或 script 标签中提取数据。

示例:从文本中提取数字

1const text = "Total sales: 1,234 units";

2const match = text.match(/([\d,]+)\s*units/);

3if (match) {

4 const units = parseInt(match[1].replace(/,/g, ''));

5 console.log("Units sold:", units);

6}但千万别用正则解析整个 HTML,结构化内容还是交给 DOM 解析器。。

动态网站处理:Puppeteer、Playwright 与无头浏览器

现代网站大量依赖 JavaScript,很多数据并不在初始 HTML,而是页面加载后由脚本渲染。这时就需要无头浏览器。

Puppeteer

Google 出品的 Node.js 库,可自动化控制 Chrome/Chromium,相当于让机器人帮你点页面、滚动、抓数据。

1const puppeteer = require('puppeteer');

2const browser = await puppeteer.launch();

3const page = await browser.newPage();

4await page.goto('https://example.com');

5const title = await page.$eval('h1', el => el.textContent);

6console.log(title);

7await browser.close();优点: 完整 Chrome 渲染,API 简单,动态内容处理能力强。

缺点: 只支持 Chromium,资源消耗较大。

。

Playwright

微软推出的新一代自动化库,支持 Chromium、Firefox、WebKit。可以说是 Puppeteer 的“多浏览器进阶版”。

1const { chromium } = require('playwright');

2const browser = await chromium.launch();

3const page = await browser.newPage();

4await page.goto('https://example.com');

5const content = await page.textContent('h1');

6console.log(content);

7await browser.close();优点: 跨浏览器,支持并发上下文,自动等待元素。

缺点: 学习曲线略高,安装包更大。

。

Nightmare

基于 Electron 的老牌自动化工具,API 简单,但已不再维护,仅适合老项目。

无头浏览器方案对比

| 方面 | Puppeteer (Chrome) | Playwright (多浏览器) | Nightmare (Electron) |

|---|---|---|---|

| 浏览器支持 | Chrome/Edge | Chrome、Firefox、WebKit | 旧版 Chrome |

| 性能与扩展性 | 快但资源重 | 快,支持高并发 | 慢,稳定性差 |

| 动态内容抓取 | 表现优异 | 优秀且功能更多 | 适合简单页面 |

| 维护情况 | 持续更新 | 活跃 | 已弃用 |

| 适用场景 | Chrome 抓取 | 复杂跨浏览器 | 简单、遗留任务 |

建议: 新项目优先选 Playwright,复杂场景表现更佳。Puppeteer 适合只需 Chrome 的任务。Nightmare 只适合老旧脚本。

辅助工具:定时调度、环境管理、命令行与数据存储

实际项目中,爬虫远不止“抓-解析”这么简单。下面这些辅助工具很常用:

定时调度:node-cron

让爬虫自动定时运行。

1const cron = require('node-cron');

2cron.schedule('0 9 * * MON', () => {

3 console.log('每周一上午 9 点自动抓取');

4});。

环境变量管理:dotenv

把密钥和配置从代码里分离出来。

1require('dotenv').config();

2const apiKey = process.env.API_KEY;命令行工具:chalk、commander、inquirer

- chalk: 控制台输出彩色文本。

- commander: 解析命令行参数。

- inquirer: 交互式命令行输入。

数据存储

- fs: 写入文件(JSON、CSV)。

- lowdb: 轻量级本地 JSON 数据库。

- sqlite3: 本地 SQL 数据库。

- mongodb: 适合大项目的 NoSQL 数据库。

示例:保存数据为 JSON 文件

1const fs = require('fs');

2fs.writeFileSync('output.json', JSON.stringify(data, null, 2));传统 JavaScript/Node.js 爬虫的痛点

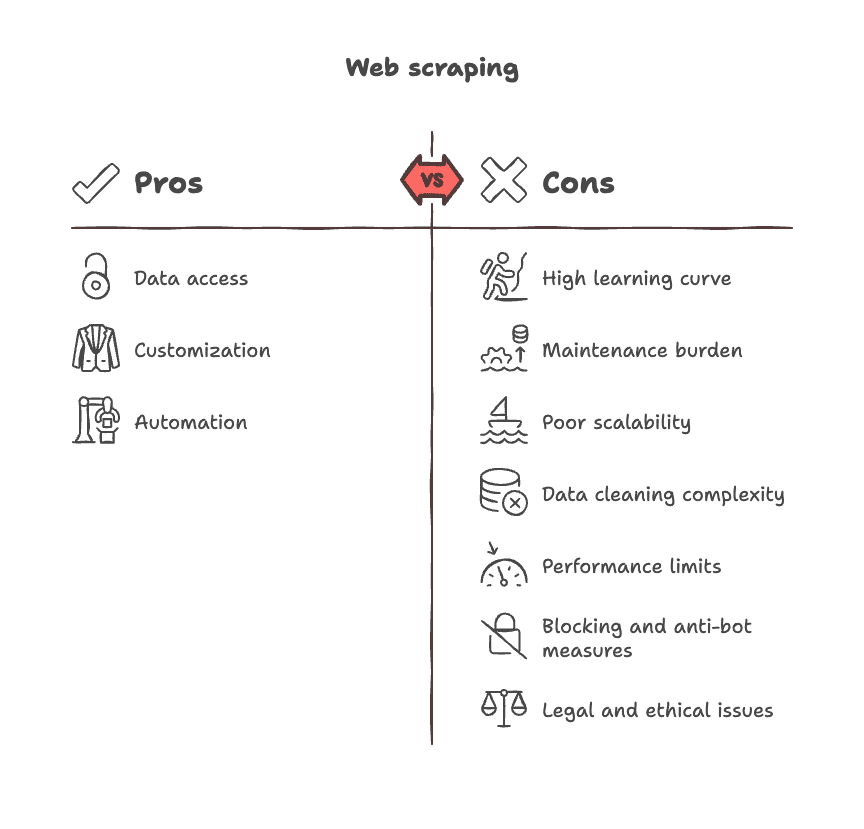

说实话,传统爬虫并不总是“美好体验”。常见难题包括:

- 学习曲线陡峭: 需要理解 DOM、选择器、异步逻辑,甚至浏览器兼容性。

- 维护压力大: 网站结构变动,选择器失效,代码要不断修补。

- 扩展性差: 每个网站都要单独写脚本,难以通用。

- 数据清洗繁琐: 抓到的数据杂乱无章,清洗、格式化、去重都很耗时。

- 性能瓶颈: 浏览器自动化资源消耗大,大规模任务效率低。

- 反爬与封锁: 网站会封 IP、弹验证码、数据藏在登录后。

- 法律与合规风险: 需注意服务条款、隐私和合规问题。

。

Thunderbit 与传统爬虫对比:效率革命

说到这里,不得不提一个关键问题:如果你能跳过写代码、选选择器、维护脚本这些繁琐步骤,会怎样?

这正是 的价值所在。作为联合创始人兼 CEO,我当然有点偏爱,但请听我说完——Thunderbit 专为需要数据、但不想折腾技术的业务用户而生。

Thunderbit 对比传统爬虫

| 对比维度 | Thunderbit(AI 无代码) | 传统 JS/Node 爬虫 |

|---|---|---|

| 上手难度 | 两步搞定,无需写代码 | 手写脚本,调试排错 |

| 动态内容 | 浏览器内自动处理 | 需写无头浏览器脚本 |

| 维护成本 | AI 自动适应页面变化 | 需手动更新代码 |

| 数据提取 | AI 智能字段推荐 | 手动写选择器 |

| 子页面抓取 | 内置一键支持 | 需循环编写每站脚本 |

| 导出方式 | Excel、Sheets、Notion 等 | 需手动集成文件/数据库 |

| 后处理 | 自动摘要、打标签、格式化 | 需额外写代码或用工具 |

| 适用人群 | 任何浏览器用户 | 仅限开发者 |

Thunderbit 的 AI 能自动识别页面、推荐字段,几步就能抓取数据。支持子页面、自动适应页面结构变化,还能边抓边摘要、打标签、翻译。数据可一键导出到 Excel、Google Sheets、Airtable、Notion,无需技术配置。

Thunderbit 适用场景:

- 电商团队监控竞品 SKU 和价格

- 销售团队批量抓取客户线索和联系方式

- 市场调研人员聚合新闻、评论

- 房产中介批量采集房源和楼盘信息

对于高频、业务关键的数据采集,Thunderbit 能极大节省时间。对于需要高度定制、深度集成的大型项目,传统脚本依然有用武之地——但对大多数团队来说,Thunderbit 是从“我要数据”到“数据到手”最快的选择。

,或在 了解更多应用案例。

快速参考:2025 年主流 JavaScript & Node.js 网页爬虫库

一张表看懂 2025 年 JavaScript 爬虫生态:

HTTP 请求

- :功能丰富的 Promise HTTP 客户端。

- :Node.js 版 Fetch API。

- :高性能 HTTP 客户端。

- :成熟的链式请求库。

- :简单易用的跨语言客户端。

HTML 解析

- :极速、类 jQuery 的 HTML 解析器。

- :Node.js 下的浏览器级 DOM。

动态内容处理

- :无头 Chrome 自动化。

- :多浏览器自动化。

- :Electron 老牌自动化。

定时调度

- :Node.js 下的定时任务。

命令行与工具

- :终端字符串美化。

- :命令行参数解析。

- :交互式命令行输入。

- :环境变量加载。

数据存储

- :内置文件系统。

- :本地 JSON 数据库。

- :本地 SQL 数据库。

- :NoSQL 数据库。

框架

- :高级爬取与抓取框架。

(建议随时查阅官方文档和 GitHub 获取最新信息)

进阶学习资源推荐

想进一步提升爬虫技能?这里有一份精选学习资源清单:

官方文档 & 指南

教程 & 课程

开源项目 & 示例

社区 & 论坛

书籍 & 深度指南

- O’Reilly《Web Scraping with Python》(跨语言通用思路)

- Udemy/Coursera:《Node.js 网页爬虫》课程

(建议关注最新版本和更新)

总结:为你的团队选择合适的爬虫方案

一句话总结:JavaScript 和 Node.js 让网页爬虫变得强大又灵活,从小脚本到企业级爬虫都能胜任。但“能力越大,维护越多”。如果你需要高度定制、工程化的项目,传统脚本依然是首选,但要做好持续维护的准备。

而对于业务人员、分析师、市场营销等非技术团队,现代无代码工具如 则是高效利器。Thunderbit 的 AI Chrome 插件让你几分钟内就能抓取、结构化并导出数据,无需写代码、无需选选择器、无需头疼维护。

所以,哪种方式适合你?如果你有开发资源、需求复杂,Node.js 工具箱值得深入。如果你追求速度、简单、专注于数据洞察而非技术细节,Thunderbit 会让你事半功倍。无论如何,互联网就是你的数据宝库——大胆去挖掘吧!

如果你遇到难题,别忘了:每个高手都曾从一张空白页面和一杯咖啡开始。祝你爬虫顺利!

想了解更多 AI 网页爬虫或体验 Thunderbit?

有问题、经验或爬虫“翻车”故事,欢迎留言或联系我。很高兴看到大家把网络变成自己的数据乐园。

保持好奇,保持咖啡,聪明抓数据,别再苦干!

常见问题解答:

1. 为什么 2025 年还要用 JavaScript 和 Node.js 做网页爬虫?

因为大多数现代网站都用 JavaScript 构建。Node.js 性能高、异步友好,生态丰富(如 Axios、Cheerio、Puppeteer),无论简单抓取还是大规模动态内容采集都能胜任。

2. 用 Node.js 抓取网站的典型流程是什么?

通常流程如下:

请求 → 处理响应 →(可选 JS 执行)→ 解析 HTML → 提取数据 → 保存或导出

每一步都可用专用工具如 axios、cheerio、puppeteer 实现。

3. 如何抓取动态、JavaScript 渲染的页面?

用无头浏览器如 Puppeteer 或 Playwright。它们能加载完整页面(包括 JS),抓取用户实际看到的内容。

4. 传统爬虫最大挑战有哪些?

- 网站结构变动

- 反爬检测

- 浏览器资源消耗

- 手动数据清洗

- 长期维护成本高

这些都让大规模、非开发者友好的爬虫难以持续。

5. 什么时候该用 Thunderbit 这类工具而不是写代码?

如果你追求速度、简单,不想写或维护代码,Thunderbit 是理想选择。特别适合销售、市场、调研等团队,能快速从复杂或多页面网站提取并结构化数据。