如果你平时用终端,肯定对 cURL 这把“互联网瑞士军刀”不陌生。它低调地存在于全球数十亿台设备上,随时能帮你抓取、提交或调试任何带 URL 的内容。cURL 的创始人估算,全球大约有 。没错,二百亿,数字相当夸张。

那为什么到了 2025 年,开发者和不少企业用户还在用 cURL?明明现在各种 AI 网页爬虫工具层出不穷。其实,有时候我们只想高效、灵活地搞定任务——不用折腾复杂配置,脚本一跑就完事,省心省力。今天就带你看看 cURL 网页爬虫为什么还这么香,适合哪些场景,怎么用才高效,以及如何结合 ,让 AI 网页爬虫带你玩转数据采集新时代。

为什么 2025 年 cURL 依然是网页爬虫利器

说句实话,我真的很爱用 cURL。一行命令,数据就能直接飘到你面前,爽感拉满。而且我不是一个人在战斗。根据 ,去年参与人数暴涨 28%,Stack Overflow 上关于“curl”的。开发者们都说它“久经沙场”、“超级好用”、“网络请求的通用语言”。即使新工具不断冒出来,cURL 也在持续进化——现在连 HTTP/3 都支持了。

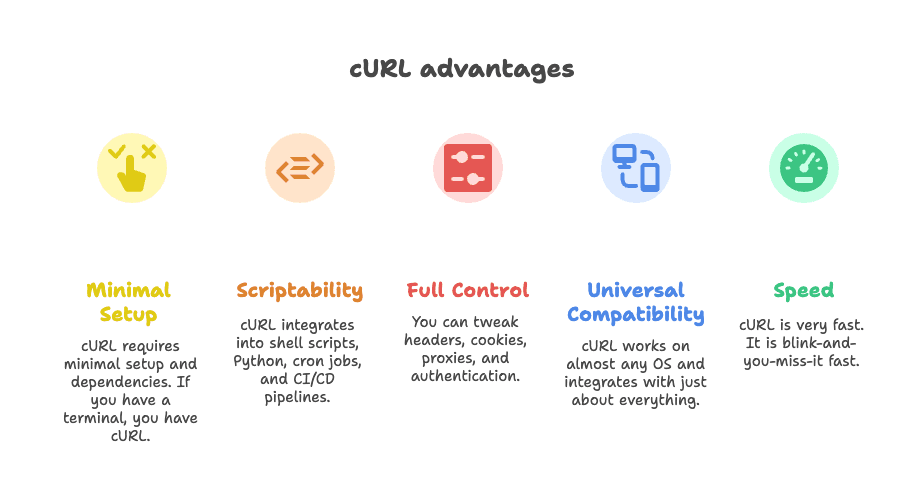

那 cURL 为什么能在网页爬虫圈子里屹立不倒?

- 几乎零配置: 不用装一堆依赖,有终端就能直接用。

- 脚本友好: 轻松嵌入 shell、Python、定时任务、CI/CD 流程。

- 高度可控: 请求头、Cookie、代理、认证……你想怎么调就怎么调。

- 兼容性超强: 几乎所有操作系统都支持,能和各种工具无缝配合。

- 速度快: 真正的“眨眼就搞定”。

正如一位开发者在 上说的:“你想做的事,cURL 都能帮你搞定。”

cURL 网页爬虫的典型应用场景:什么时候选 cURL 最合适?

说实话,cURL 不是万能钥匙。但在某些场景下,它的表现真的无敌。下面这些就是 cURL 最拿手的活:

1. 抓取 REST API 的 JSON 数据

现在很多网站内容都是通过后台 API 加载的。只要你能找到接口(小技巧:浏览器 Network 面板),cURL 一行命令就能把 JSON 数据拉下来。适合快速采集、API 测试或自动化脚本集成。

2. 提取静态或结构清晰页面的数据

如果你要的数据直接写在 HTML 里,比如新闻、目录、产品分类页,cURL 能一秒抓取。配合 grep、sed 或 jq 做基础解析,效率很高。

3. 调试和复现复杂 HTTP 请求

需要模拟登录、测试 webhook 或排查 API 问题?cURL 让你完全掌控请求头、Cookie、数据包,是开发者调试网络请求的首选。

4. 脚本化快速采集

cURL 非常适合嵌入 shell、Python 脚本,甚至 Zapier webhook。它是很多自动化流程背后的“万能胶”。

下面这张表总结了 cURL 的适用场景和局限:

| 应用场景 | cURL 优势 | 不足之处 | 可选替代方案 |

|---|---|---|---|

| 抓取 JSON API | 快速、脚本化、支持自定义头/令牌 | 无内置 JSON 解析,复杂认证需手动处理 | Python Requests、Postman、Thunderbit |

| 静态 HTML 页面 | 轻量、易与命令行工具集成 | 无 HTML 解析,无法处理 JS | Scrapy、BeautifulSoup、Thunderbit |

| 会话认证爬取 | 支持 Cookie、头部、基础认证 | 多步登录繁琐,无 JS 支持 | Requests sessions、Selenium、Thunderbit |

| Shell/Python 集成 | 通用,适合各种脚本 | 解析和错误处理需手动 | 原生 HTTP 库、Thunderbit |

想深入了解这些场景,可以看看 。

2025 年必学的 cURL 网页爬虫实用技巧

下面进入实战,分享一些 2025 年用 cURL 抓网页的实用招数。

设置请求头和 User-Agent

很多网站会屏蔽默认的 cURL 请求。想“伪装”成正常用户,记得设置真实的 User-Agent 和必要的头部:

1curl -A "Mozilla/5.0 (Windows NT 10.0; Win64; x64)" -H "Accept: application/json" https://api.example.com/data或者加多个头部:

1curl -H "User-Agent: Mozilla/5.0" -H "Accept: application/json" https://api.example.com/data伪造头部往往决定你能不能顺利拿到数据。更多细节可以参考 。

管理 Cookie 和会话

需要登录或保持会话?用 cURL 的 cookie jar:

1# 登录并保存 Cookie

2curl -c cookies.txt -d "username=me&password=secret" https://example.com/login

3# 后续请求复用 Cookie

4curl -b cookies.txt https://example.com/dashboard也可以直接传 Cookie:

1curl -b "SESSIONID=abcd1234" https://example.com/page遇到重定向(比如登录后跳转),加上 -L 保持 Cookie 有效。

用代理防止被封

遇到 IP 被封?可以用代理转发请求:

1curl --proxy 198.199.86.11:8080 https://target.com想用轮换代理,可以让 cURL 从列表循环读取。注意,免费代理经常不稳定,遇到“连接被拒绝”别怪 cURL。

保存和解析响应内容

cURL 拿到的是原始数据。要进一步处理,可以结合命令行工具:

-

处理 JSON: 用

jq美化或提取字段。1curl -s https://api.github.com/repos/user/repo | jq .stargazers_count -

处理 HTML: 用

grep或sed匹配简单内容。1curl -s https://example.com | grep -oP '(?<=<title>).*?(?=</title>)' -

复杂解析: 可以用

htmlq(支持 CSS 选择器),或者转到 Python 用 BeautifulSoup。

想看 cURL 搭配 jq 的实战案例,推荐 。

cURL 处理认证与限流

认证方式:

-

基础认证:

1curl -u username:password https://api.example.com/data -

Bearer Token:

1curl -H "Authorization: Bearer <token>" https://api.example.com/data -

会话 Cookie: 如上文所示,使用

-c和-b。

更复杂的认证(比如 OAuth)需要自己写脚本搞定,cURL 也能做,但门槛会高一些。

限流与重试:

-

加延迟:

1for url in $(cat urls.txt); do 2 curl -s "$url" 3 sleep $((RANDOM % 3 + 2)) # 随机延迟 2-4 秒 4done -

自动重试:

1curl --retry 3 --retry-delay 5 https://example.com/data

记得文明爬取,别高频刷,遇到 429 Too Many Requests 就要注意了。

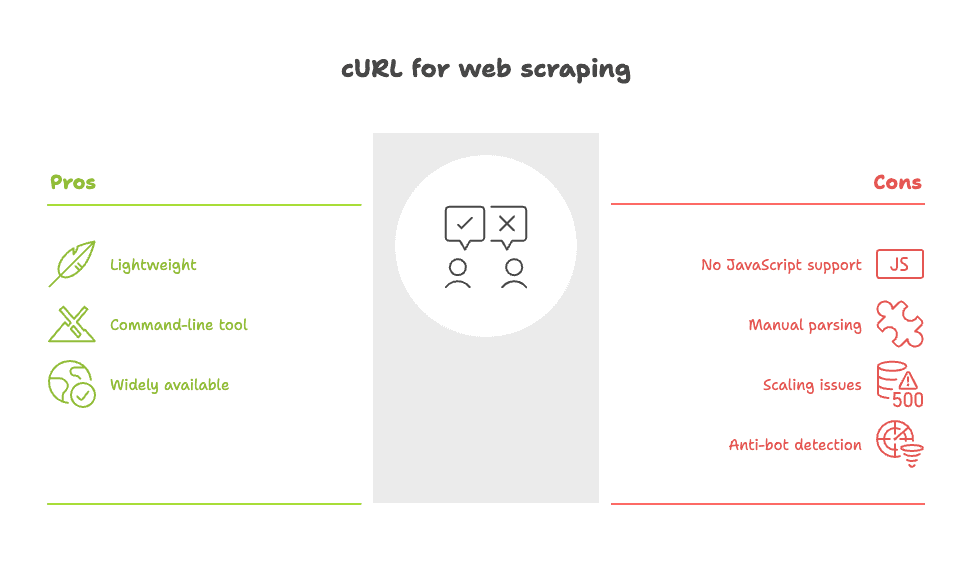

cURL 网页爬虫的短板:你要注意哪些坑?

说句实话,cURL 不是万能的。它的短板主要有:

- 搞不定 JavaScript: cURL 不能执行脚本或渲染动态内容。数据如果是页面加载后才出现,cURL 抓不到。你得找底层 API 或用浏览器型工具。

- 解析全靠自己: 拿到的是原始 HTML 或 JSON,结构化全靠自己写脚本。

- 扩展性有限: 批量抓取成百上千页面时,错误处理、重试、数据清洗会变得很繁琐。

- 容易被反爬识别: 很多网站能识别 cURL 的网络特征,就算伪装头部也可能被封。

正如一位 Reddit 用户说的:“curl 或 wget 适合简单爬取,但遇到复杂网站就很难搞了。”()

想了解 cURL 的所有痛点,推荐 。

用 Thunderbit 让 cURL 网页爬虫更强大

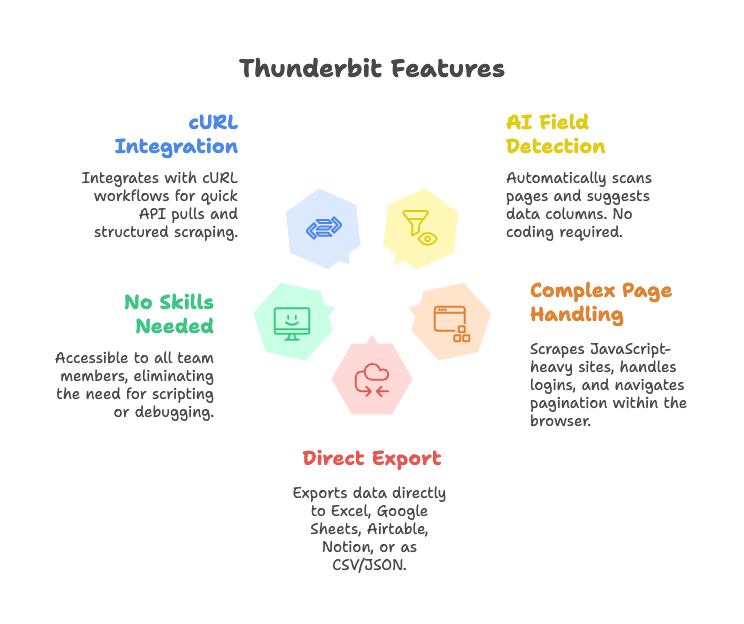

如果你想要 cURL 的速度和灵活,但又不想自己手动解析数据,Thunderbit 就是你的理想搭档。

Thunderbit 是一款基于 AI 的网页爬虫 Chrome 插件,让数据采集变得又快又省心。它怎么补足 cURL 的短板?

- AI 字段识别: 一键“AI 智能识别字段”,Thunderbit 自动扫描页面、建议表头、结构化数据,无需写选择器、无需编码。

- 支持复杂页面: Thunderbit 在浏览器内运行,能抓取 JavaScript 动态页面、处理登录、自动翻页、点击子页面等。

- 一键导出: 数据可直接导出到 Excel、Google Sheets、Airtable、Notion,或下载为 CSV/JSON。

- 零技术门槛: 团队任何成员都能用,无需写脚本或调试 HTTP。

- 可与 cURL 流程结合: 开发者可用 cURL 快速拉 API 或原型,后续用 Thunderbit 做结构化、批量爬取。

想看 Thunderbit 实际效果,可以试试我们的 ,或者逛逛 看更多案例。

Thunderbit + cURL:企业团队的高效数据采集范例

实际工作中,团队可以这样组合 cURL 和 Thunderbit:

1. 快速市场调研

- 用 cURL 测试竞争对手网站有没有开放 API 或静态 HTML。

- 有的话,脚本化拉取快照数据。

- 需要深度分析(比如多页产品列表)时,切换到 Thunderbit,让 AI 自动识别字段、处理翻页、导出到表格。

2. 潜在客户挖掘

- 用 cURL 拉取简单目录 API 的联系方式。

- 对于复杂网站(比如 LinkedIn 风格的个人页、房产信息),用 Thunderbit 提取姓名、邮箱、电话、图片等,无需手动解析。

3. 监控产品列表或价格

- 定时用 cURL 脚本监控 REST API 的价格变动。

- 没有 API 的网站,交给 Thunderbit 自动爬取、结构化数据,并推送到 Airtable 或 Notion。

下面是一个简化流程图(脑补一下小人和箭头):

1[浏览器/终端] --(cURL 测试)--> [快速数据拉取]

2 |

3 v

4[Thunderbit Chrome 插件] --(AI 提取)--> [结构化数据] --> [Sheets/Airtable/Notion]Thunderbit 和手写 cURL 脚本对比优势

一图胜千言:

| 功能 | Thunderbit(AI 网页爬虫) | cURL(命令行工具) |

|---|---|---|

| 上手速度 | 可视化操作,AI 自动识别字段 | 需手动写脚本,懂 HTML |

| 易用性 | 任何人都能用,所见即所得 | 仅限命令行,学习曲线陡峭 |

| 结构化输出 | 支持表格、列、导出到表/CRM | 原始 HTML/JSON,需手动解析 |

| 动态页面支持 | 支持浏览器内 JS、子页、翻页 | 仅抓静态 HTML |

| 维护成本 | 低,AI 自动适应页面变化 | 高,页面变动需重写脚本 |

| 集成能力 | 内置导出到业务工具 | 需自定义代码 |

| 多语言/翻译 | 支持 AI 翻译和字段标准化 | 仅手动处理 |

| 扩展性 | 适合中小规模任务 | 大规模需自建脚本体系 |

| 成本 | 免费版+付费计划(约 $9/月起) | 免费,但耗费开发时间 |

更多对比细节,欢迎阅读我们的 。

Thunderbit 的 AI 驱动方式,让你少写脚本,多拿结果。不管你是开发者还是业务用户,都能快速把网页数据变成业务价值。

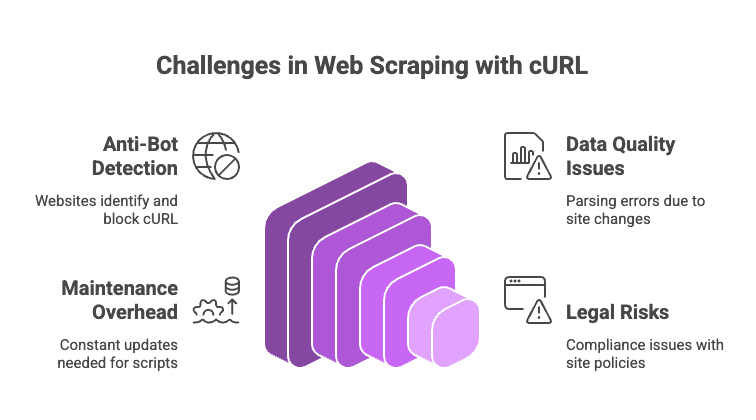

2025 年用 cURL 网页爬虫可能遇到的挑战

网页爬虫不是一帆风顺,下面这些坑你一定要注意:

- 反爬机制: Cloudflare、Akamai、DataDome 等能轻松识别 cURL。就算伪装头部,也可能因为缺少 JS 执行、TLS 指纹等被拦截。遇到验证码,cURL 也没辙。

- 数据质量和一致性: 用正则或 grep 解析 HTML 很脆弱,网站结构一变脚本就失效。

- 维护成本高: 网站每次改版都要重新调整解析逻辑。

- 法律和合规风险: 一定要遵守目标网站的服务条款和隐私政策。能爬不代表应该爬。

实用建议:

- 多切换 User-Agent 和 IP,降低被封概率。

- 请求间加随机延迟。

- 处理 JSON 用

jq,处理 HTML 用htmlq。 - 动态或受保护网站,建议用 Thunderbit 或爬虫 API。

更多避坑指南,推荐 。

总结:2025 年怎么选网页爬虫方案最合适?

我的建议是:cURL 依然是快速、精准采集 API、静态页面或调试的利器。想试试网站能不能采集,cURL 是最快的选择。

但如果你需要结构化数据、动态内容或团队协作,Thunderbit 这样的 AI 网页爬虫能帮你省去大量手动工作,轻松应对复杂场景。

所以,按需选工具。小型、脚本化任务用 cURL,大型、动态或团队需求就交给 Thunderbit。

常见问题:2025 年用 cURL 网页爬虫

1. cURL 能抓取 JavaScript 渲染的数据吗?

不能。cURL 只能获取初始 HTML,动态加载的数据需要找 API 或用 Thunderbit 这类浏览器型工具。

2. 如何避免 cURL 爬虫被封?

设置真实的请求头(User-Agent、Accept),轮换 IP 和 UA,添加请求间隔,复用 Cookie。遇到强反爬(比如 Cloudflare),可以试试 ,或者用无头浏览器/爬虫 API。

3. cURL 输出怎么转成结构化数据?

JSON 可以用 jq 处理,HTML 可以用 grep、sed 或 htmlq。复杂需求建议用 Python + BeautifulSoup,或者直接用 Thunderbit 的 AI 智能提取。

4. cURL 适合大规模爬取吗?

可以,但需要自己处理重试、错误、代理、数据清洗等。大规模任务通常用 Scrapy 或浏览器型工具更高效。

5. Thunderbit 怎么提升传统 cURL 爬虫体验?

Thunderbit 自动识别字段,支持动态页面、会话、子页,数据可直接导出到业务工具,无需写脚本、无需维护选择器。

想让网页爬虫更简单?欢迎试用 ,或者安装我们的 ,体验 AI 驱动的数据采集新方式。

如果你还是喜欢在终端敲命令,也没关系,cURL 依然会陪你走下去。只是别忘了善待服务器,也别忘了请运维同事喝杯咖啡。

想获取更多网页爬虫、自动化和 AI 效率工具的实用技巧?欢迎关注 。