说真的,我以前从没想到“网页爬虫”会变成销售和运营团队日常聊天的热门话题。但现在都 2025 年了,从房产中介到电商经理,大家讨论数据采集的热情就像分享烧烤配方一样高涨。这些年我一直在开发和用各种 SaaS 自动化工具,深刻体会到这种变化——网页数据早就不是 IT 部门的专属资源,而是现代企业的核心动力,支撑着获客、价格监控等各类业务。如果你还没用上网页爬虫,或者更智能的 AI 网页爬虫,那你可能还停留在“复制粘贴的原始社会”。

不过,随着工具越来越多,挑选合适的网页爬虫就像在超市货架前选早餐麦片——种类太多,选错了还可能后悔好几个月。接下来,我就带你盘点一下 2025 年最值得关注的网页爬虫软件,从零代码 AI 方案到专业开发者框架,无论你是销售、运营、电商,还是想自动化日常琐事,这里都能找到适合你的工具。

2025 年企业为什么离不开网页爬虫?

先聊聊“为什么”。为什么现在大家都在热议网页爬虫和数据采集?数据不会骗人:。这不是小趋势,而是大风口。而且推动增长的不只是科技公司,销售、市场、运营团队也都加入了进来,得益于新一代低代码、零代码爬虫工具,让非技术用户也能轻松采集数据()。

企业常见应用场景

- 获客线索挖掘: 销售团队可以自动采集公开名录、社交媒体和公司官网,精准构建潜在客户名单——再也不用买过时名单或盲目打冷电话。

- 市场调研与价格监控: 电商和零售团队用爬虫追踪竞品价格、库存变化、商品组合。比如 John Lewis 就靠智能定价和数据采集实现了 。

- 流程自动化: 运营团队通过自动采集数据,省下了大量手动复制粘贴的时间。

- 房产情报收集: 经纪人和投资者可以批量抓取房源、业主联系方式和市场动态,一站式掌握关键信息。

更重要的是,,而招聘信息等市场情报数据也增长了 50%。在这个速度和精准度决定成败的时代,网页爬虫已经成为领先团队的秘密武器。

AI 网页爬虫的崛起

传统爬虫虽然功能强大,但配置选择器就像写论文一样麻烦,还得有耐心。现在,像 这样的 AI 网页爬虫彻底改变了游戏规则——只需点几下,任何人都能采集结构化数据。结果就是:更多团队能自主获取数据,流程不再卡壳,数据真正成为竞争优势。

如何选择合适的网页爬虫或 AI 网页爬虫?

那怎么为团队挑选合适的工具?以下是我评估网页爬虫软件时的标准(相信我,从“连奶奶都会用”的到“需要专门看文档的”,我都试过)。

关键考量点

- 易用性: 非技术用户能否快速上手,无需长时间培训?

- 数据采集准确性: 网站结构变化时,能否依然稳定抓取所需数据?

- 支持平台: 是浏览器插件、云服务还是代码库?

- 集成能力: 能否直接导出到 Google Sheets、Excel、Airtable、Notion 或 CRM?

- 价格模式: 有免费版吗?按行、按次还是按月计费?

- 自动化与定时: 能否定时自动运行,还是每次都要手动操作?

- AI 功能: 是否用 AI 简化配置、智能推荐字段或处理复杂网页?

下面这张对比表可以帮你快速入门(后面会详细介绍每款工具):

| 工具 | 是否需编程 | AI 功能 | 定时功能 | 导出选项 | 亮点优势 |

|---|---|---|---|---|---|

| Thunderbit | 否 | 有 | 有 | Sheets、Excel、Airtable、Notion | 上手最快,AI 字段识别 |

| Web Scraper | 否 | 无 | 有限 | CSV、JSON、Sheets(云端) | 可视化配置,灵活性高 |

| BeautifulSoup | 是 | 无 | 无 | 自定义(CSV、JSON、数据库) | 简单易用,解析能力强 |

| Scrapy | 是 | 无 | 有 | CSV、JSON、XML、API | 可扩展性强,适合大规模爬取 |

| Playwright | 是 | 无 | 无 | 自定义 | 适合 JS 动态网页 |

| Apify | 否/是 | 部分 | 有 | CSV、JSON、Sheets、API | 云端扩展,预置模板丰富 |

Thunderbit:最适合企业用户的 AI 网页爬虫

是一款 Chrome 扩展,把 AI 网页爬虫带给每一位用户——尤其适合需要快速获取数据、又不想依赖 IT 的销售、电商和房产团队。

核心亮点

![]()

- AI 字段推荐: 一键点击“AI 推荐字段”,Thunderbit 会自动分析页面,推荐要提取的列,还能为每个字段生成专属提示词。再也不用猜怎么选。

- 子页面采集: 不止抓列表,Thunderbit 还能自动访问每个详情页,丰富你的数据表。

- 即用爬虫模板: 针对热门网站(如亚马逊、Zillow、Instagram、Shopify 等)直接选模板即可,无需消耗 AI 点数。

- 定时爬虫: 用自然语言描述时间(如“每周一上午 9 点”),Thunderbit 会自动按时运行。

- 邮箱、电话、图片提取与 AI 自动填表: 一键抓取联系方式或图片,AI 还能帮你自动填写表单、批量操作网页。

- 云端与本地采集: 可选云端(高效,支持同时采集 50 页)或本地浏览器(适合需要登录的网站)。

当然,Thunderbit 还提供,可采集 6 个页面,试用期可达 10 个页面。对于大多数企业用户来说,足以体验 AI 爬虫的高效与便捷。

想看实际演示?欢迎访问我们的 ,或阅读我们关于、、的深度教程。

Web Scraper:灵活的浏览器数据采集工具

Web Scraper(来自 )是一款经典的 Chrome 扩展,深受“公民数据分析师”青睐——无需编程,但需要一定的动手能力。它通过构建“站点地图”来指导爬虫如何导航和采集数据。

- 可视化操作界面: 无需写代码,但要学会选择元素和设置导航路径。

- 支持子页面和分页: 适合多层级网站,但每一步都需手动配置。

- 导出选项: 默认支持 CSV、JSON,云端用户可导出到 Google Sheets 或 Dropbox。

- 定时功能: 仅限付费云端计划。

- 社区支持: 文档和论坛丰富,但实时帮助有限。

最大优点是灵活,最大缺点是上手门槛。正如一位用户评价:“只有技术达人才能玩转这款工具”()。如果你愿意多尝试,几乎可以采集任何网站;但如果不喜欢反复试错,建议选择更简单的方案。

详细对比可参考。

BeautifulSoup:Python 开发者的定制化数据采集利器

接下来进入开发者领域。 是一款广受欢迎的 Python 库,专注于解析 HTML 和 XML。如果你会 Python,就能用脚本灵活采集所需数据。

- 无界面: 全部通过代码操作。

- 轻量灵活: 适合中小型项目,或集成到更大的 Python 流程中。

- 部分分页支持: 需要自己写循环和逻辑处理分页或跳转。

- 无内置定时: 如需自动化,可结合 cron 或任务调度器。

- 自定义输出: 可导出为 CSV、JSON、数据库等任意格式。

BeautifulSoup 适合快速、定向采集,或作为数据管道的一环。它不适合大规模多页面爬取(那是 Scrapy 的强项),但对 Python 爱好者来说是极佳的入门选择。

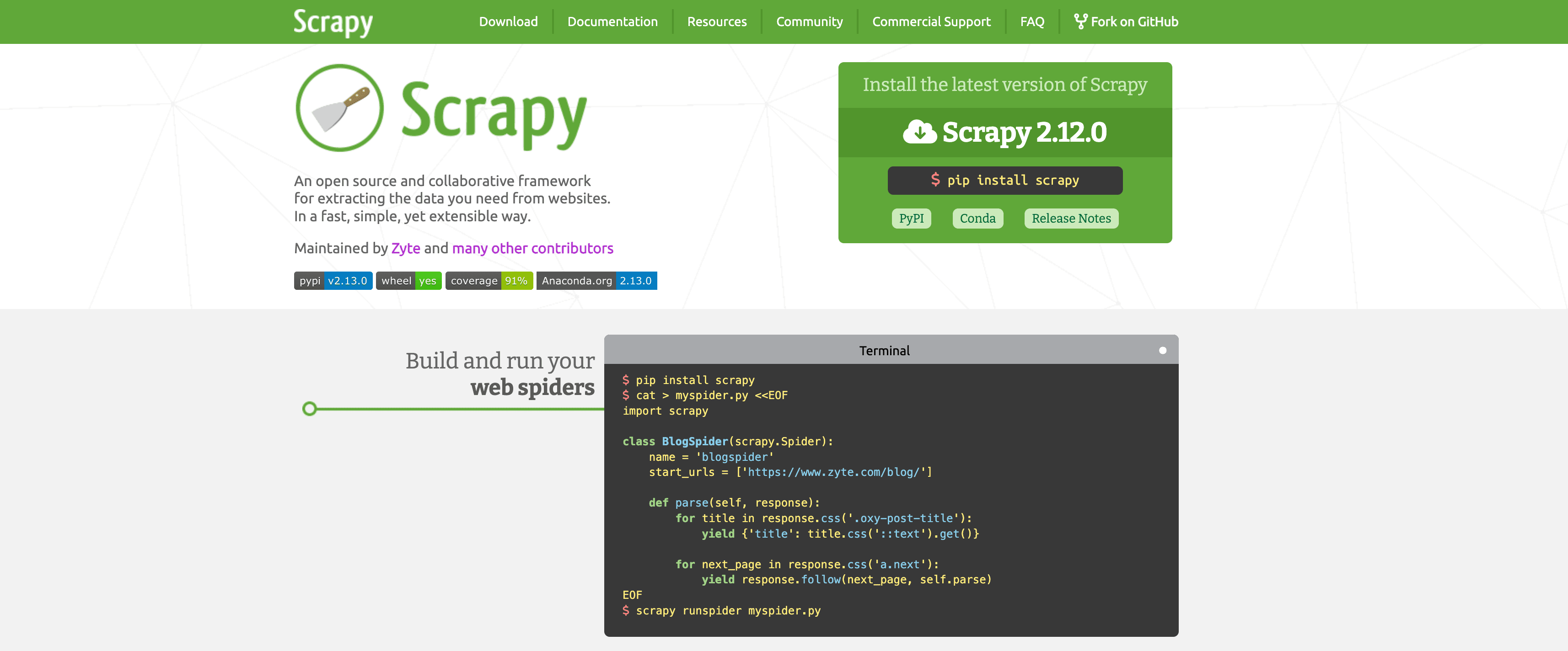

Scrapy:大规模数据采集的强大框架

如果说 BeautifulSoup 是瑞士军刀, 就是专业级电动工具。Scrapy 是专为大规模网页爬取设计的 Python 框架。

- 面向开发者: 命令行配置、Python 类和结构化项目管理。

- 深度爬取能力: 自动跟踪链接、分页,遵守 robots.txt。

- 高性能: 支持异步请求、自动限速、缓存和重试。

- 可定制数据管道: 可导出为 CSV、JSON、XML,或推送到 API、数据库。

- 定时功能: 可用 Scrapy Cloud 或结合 cron 实现自动运行。

- 高度可扩展: 支持代理轮换、UA 伪装,甚至集成无头浏览器(适合 JS 动态网站)。

缺点是学习曲线较陡,但如果你需要稳定采集成千上万页面,Scrapy 几乎无可替代。

Playwright:现代化网页自动化与爬取

有些网站就是不想让你爬——数据藏在 JavaScript 后面、需要登录、还要点一堆按钮。这时,()就派上用场了。它是一款现代浏览器自动化库(支持 Python、JavaScript 等),可以像真人一样操控浏览器。

- 动态内容处理: 适合 React、Angular 等 JS 重度网站。

- 模拟用户操作: 可点击按钮、填写表单、滚动页面、等待元素加载。

- 无内置定时: 需手动运行脚本或结合外部调度。

- 自定义输出: 数据去向由你决定。

- 资源消耗大: 每个浏览器实例占用较多内存,适合中等规模任务。

Playwright 就像网页爬取的“万能钥匙”,能破解各种复杂网站。但它不适合非技术用户,速度也比 Scrapy 这类网络爬虫慢。

Apify:云端网页爬虫,轻松扩展大规模采集

是网页爬取领域的“瑞士军刀”平台,既支持零代码,也能自定义开发,非常适合需要大规模采集、又不想自己维护服务器的团队。

- 预置“Actor”: 数千个现成爬虫模板,支持 Google 地图、LinkedIn、Zillow 等主流网站,参数一填即可用。

- 自定义爬虫: 开发者可用 JavaScript 或 Python 构建专属 Actor。

- 云端定时与扩展: 支持并行多任务、定时运行,Apify 自动处理服务器和代理。

- 集成能力: 可导出为 CSV、JSON、Excel、Google Sheets,或通过 API 获取。支持 Webhook、n8n、Make 等自动化工具。

- AI 集成: 部分 Actor 已支持 AI 智能提取和数据分类。

- 学习曲线: 界面和概念(如 Actor、数据集、代理)对新手略有挑战,但文档详尽。

Apify 适合技术水平不一的团队,或任何想大规模采集又不想操心服务器的人。注意:功能强大,复杂度和按量计费也随之而来。

横向对比:哪款网页爬虫或 AI 网页爬虫最适合你?

下面这张详细对比表,帮你快速锁定最适合的工具:

| 工具 | 零代码友好 | 子页面/分页 | 定时功能 | 可扩展性 | 最佳适用场景 |

|---|---|---|---|---|---|

| Thunderbit | ⭐⭐⭐⭐⭐ | 自动(AI) | 内置 | 中等 | 销售、运营、房产 |

| Web Scraper | ⭐⭐ | 手动配置 | 仅云端 | 中等 | 数据分析师、耐心用户 |

| BeautifulSoup | ⭐ | 手动(代码) | 无 | 低 | Python 开发、小型项目 |

| Scrapy | ⭐ | 自动(代码) | 有 | 高 | 开发者、大规模爬取 |

| Playwright | ⭐ | 手动(代码) | 无 | 中等 | 开发者、动态 JS 网站 |

| Apify | ⭐⭐⭐ | 视 Actor 而定 | 内置 | 高 | 团队、大型项目 |

- Thunderbit:最适合非技术用户,快速上手,AI 自动化省心省力。

- Web Scraper:适合愿意学习的用户,灵活但不够“即插即用”。

- BeautifulSoup/Scrapy/Playwright:适合开发者,追求极致定制和控制。

- Apify:适合需要云端扩展、预置方案、能接受一定复杂度的团队。

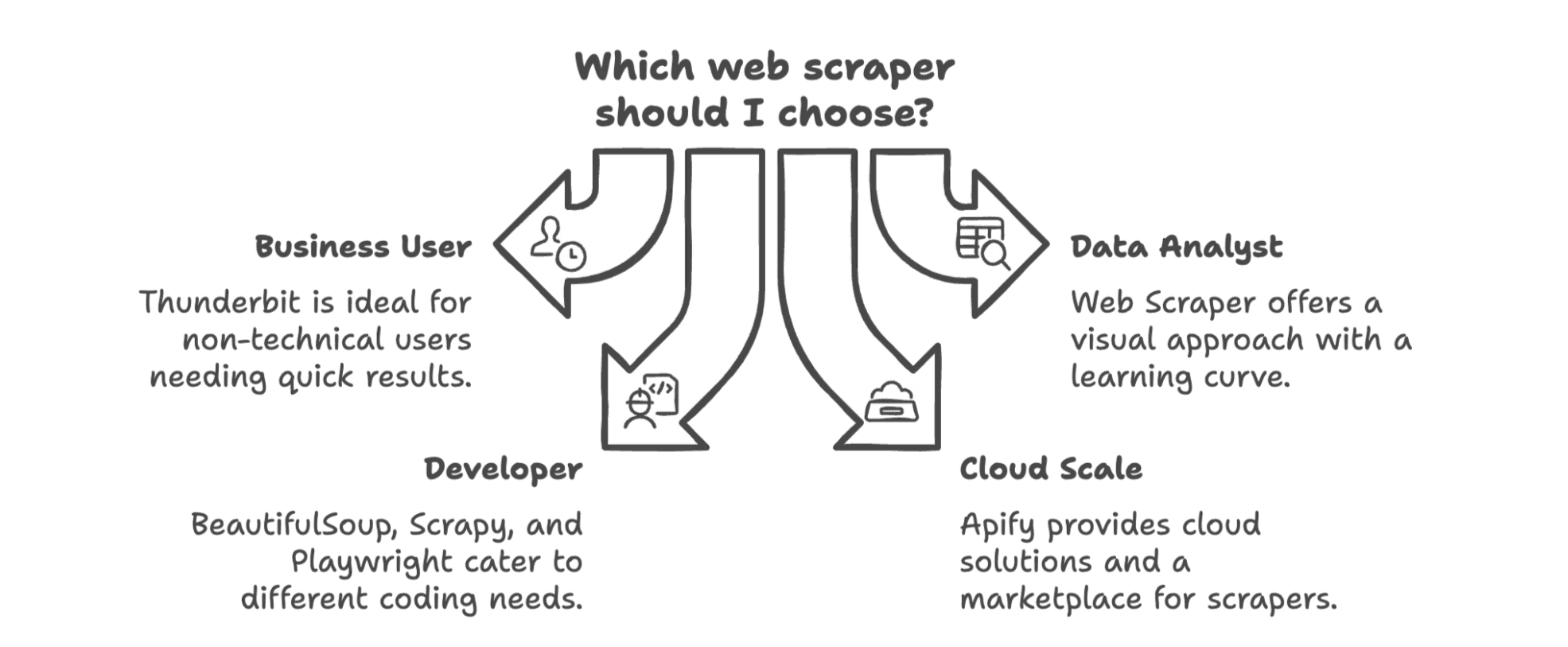

2025 年如何为企业选择最佳网页爬虫?

总结一下:最适合你的网页爬虫,取决于团队构成、技术能力和数据需求。

- 如果你是业务用户(销售、市场、运营),不想写代码, 是首选。专为你设计,几分钟就能采集数据。

- 如果你是数据分析师或不怕学习新工具,Web Scraper 的可视化方案很强大,但要做好试错准备。

- 如果你是开发者,BeautifulSoup 和 Scrapy 是经典之选——小项目用 BS4,大规模用 Scrapy,动态网站用 Playwright。

- 如果你需要云端扩展或想用现成爬虫模板,Apify 非常适合,尤其适合多技能团队。

别忘了:趋势正向 AI 驱动、零代码、与业务流程无缝集成的方向发展。“采集-下载-导入-清洗-重复”那一套正在被淘汰,现在只需几步就能把网页数据导入表格、CRM 或 Notion。

想体验网页爬虫的便捷?不妨试试 。如果你想深入了解更多爬虫技巧,欢迎访问我们的 ,有实用教程,也有我的冷笑话。

让 2025 成为你彻底告别复制粘贴、让 AI 替你搞定数据的元年吧!

常见问题

Q1:2025 年用网页爬虫还需要编程吗? A:现在已经不需要了。像 Thunderbit 这样的 AI 工具,让非技术用户也能几步采集数据——无需写代码,无需复杂配置。开发者依然偏爱 Scrapy 或 Playwright 这类工具做深度定制。

Q2:AI 网页爬虫能采集哪些类型的数据? A:文本、数字、链接、邮箱、电话、图片,甚至 PDF 或动态网站里的结构化数据。有些工具还能自动定时、翻译或分类数据。

Q3:企业用网页爬虫合法吗? A:只要采集公开数据、用于合法商业用途(如调研、获客),一般都是允许的。请勿在未授权情况下抓取受限或有版权的数据。

Q4:用 AI 做网页爬虫最大优势是什么? A:速度和易用性。AI 能自动识别字段、处理分页、甚至自动化流程,让你少花时间配置,多花时间用数据。

延伸阅读