网页爬虫 java 教程

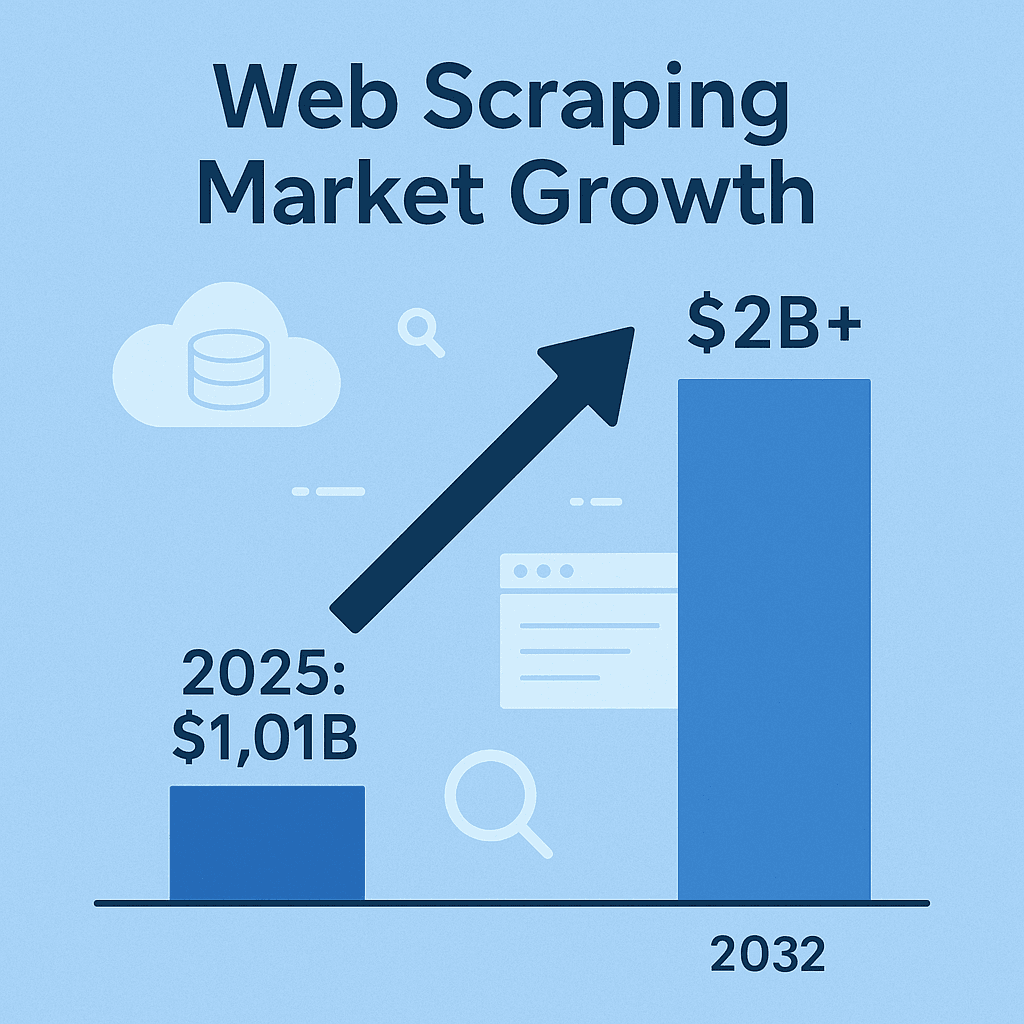

网页爬虫已经悄悄成为现代商业智能、销售运营和市场调研的“标配神器”。现在这个时代,如果你还没开始收集网页数据——比如竞品价格、产品列表、市场舆情或者潜在客户信息——那你很可能已经被那些早早布局的同行甩在身后了。实际上,网页爬虫软件市场在,预计到 2032 年还会翻一倍。这不仅仅是技术潮流,更是一场数据洪流。虽然 Python 很火,但对于追求高可靠性、高性能和企业级集成的团队来说,Java 依然是首选。

我在 SaaS 和自动化领域摸爬滚打多年,可以很负责任地说:基于 Java 的网页爬虫依然活跃,尤其是在对稳定性、多线程和大数据系统集成有高要求的企业环境里。但要注意,爬虫绝不是“随便抓点数据”这么简单,更要高效、规范、合规地搞定任务(不然法务电话分分钟打过来)。接下来,我们就一起深入聊聊怎么用 Java 玩转网页爬虫的最佳实践——不管你是想自研爬虫,还是想借助 这样的 AI 工具提升效率。

Java 网页爬虫入门:核心知识一网打尽

说到底,网页爬虫就是用代码自动从网站上提取信息。典型流程很简单:你的程序发 HTTP 请求,拿到 HTML 响应,然后解析出你想要的数据(比如价格、产品名、评论),最后导出成团队能用的格式——比如 CSV、JSON,或者直接写进数据库()。

为什么选 Java? 虽然 Python 适合写脚本、快速试错,但 Java 更适合企业级、大规模、长时间运行的爬虫任务。Java 静态类型、健壮可靠,网络、HTML 解析和并发处理的库也很丰富。如果你的数据管道或分析系统本身就是 Java 技术栈,集成起来就像拼乐高一样顺滑,无需跨语言折腾()。

一句话总结:Java 爬虫能长时间稳定跑,轻松处理海量数据,还能和企业现有系统深度集成。但前提是你得选对工具,用对方法。

主流 Java 网页爬虫工具与库大盘点

下面给大家盘点几款最常用的 Java 网页爬虫库,各有千秋:

| 工具 | 适用场景 | 优势 | 局限 |

|---|---|---|---|

| Jsoup | 静态 HTML 页面,快速提取 | 轻量级,API 简单,速度快,适合简单任务 | 无法处理 JavaScript 或动态内容 |

| Selenium | 动态、交互性强的网站 | 可自动化真实浏览器,支持 JS,能模拟用户操作,社区庞大 | 占用资源多,速度慢,UI 变动易导致脚本失效,需要浏览器驱动 |

| HtmlUnit | 无头浏览,适度 JS 支持 | 纯 Java 实现,可执行部分 JS,无需外部浏览器 | 比 Jsoup 慢,对现代 JS 框架支持有限,无内置反屏蔽机制 |

| Playwright | 现代 JS 密集型网站,自动化 | 快速高效,支持多浏览器,能处理弹窗和多页面流程,自动等待机制 | 生态较新,仍需浏览器资源,Java 支持不如 Selenium 原生 |

(参考:, )

Jsoup:静态 HTML 抓取的利器

是 Java 爬虫处理静态网页的“瑞士军刀”。它就像 Java 版的 jQuery:用 Jsoup.connect(URL).get() 抓页面,再用 CSS 选择器提数据。比如要抓所有 <h1> 标题,或者所有 <div class="product-name"> 下的产品名,一行代码就能搞定。

示例:从电商页面提取产品名称

1Document doc = Jsoup.connect("https://example.com/products").get();

2Elements products = doc.select("div.product-name");

3for (Element product : products) {

4 System.out.println(product.text());

5}Jsoup 速度快、用法简单,非常适合抓博客、商品列表、新闻等静态内容。但要注意,它不会执行 JavaScript。如果数据不是直接写在 HTML 里,Jsoup 就抓不到。

Selenium 与 HtmlUnit:动态内容的好帮手

有时候,目标数据是通过 JavaScript 加载的,或者需要用户操作(比如点“加载更多”按钮)才能显示。这时, 就派上用场了。Selenium 能让 Java 代码自动打开真实浏览器(如 Chrome、Firefox),模拟人类操作页面,抓取动态内容。

HtmlUnit 是更轻量的纯 Java 方案,能处理部分 JavaScript,但遇到现代 JS 框架(如 React、Angular)就有点吃力。简单动态内容可以用 HtmlUnit,复杂页面建议用 Selenium 或 Playwright。

什么时候用无头浏览器: 如果需要登录、点击、或者抓取脚本渲染后才出现的数据,浏览器自动化是最佳选择。但要有心理准备——速度慢、维护成本高,网站结构一变脚本就容易挂。

Playwright:现代自动化新宠

是微软推出的新一代自动化框架,主打速度和稳定性。比 Selenium 快 40–50%,支持多种浏览器引擎,能轻松应对弹窗、无限滚动、多页面流程等复杂场景。如果你要抓现代前端渲染的网站,Playwright 值得一试。

如何为你的项目选对 Java 网页爬虫工具

不是所有项目都要“用大炮打蚊子”。选型建议如下:

- 网站复杂度: 静态 HTML 用 Jsoup,动态 JS 用 Selenium 或 Playwright,部分 JS 可试试 HtmlUnit。

- 数据量与频率: 一次性抓取可选简单方案,定期大规模任务建议用支持多线程和健壮错误处理的工具。

- 易用性 vs 灵活性: Jsoup 上手快,Selenium/Playwright 功能强但配置复杂、维护成本高。

- 项目需求与预算: 开源库免费但要自己维护,付费 API 或云爬虫省心但有成本。

选型对比表:

| 对比维度 | Jsoup | Selenium | HtmlUnit | Playwright |

|---|---|---|---|---|

| 静态 HTML | ✔️ | ✔️ | ||

| 动态 JS | ✔️ | (部分) | ✔️ | |

| 速度 | ✔️ | ✔️ | ||

| 易用性 | ✔️ | |||

| 支持登录/点击 | ✔️ | (基础) | ✔️ | |

| 大规模/并发 | ✔️ | (较难) | (一般) | ✔️ |

| 经济实用 | ✔️ | ✔️ | ✔️ | ✔️ |

建议从简单做起,只有确实需要时再升级工具。不同工具组合用也很常见。

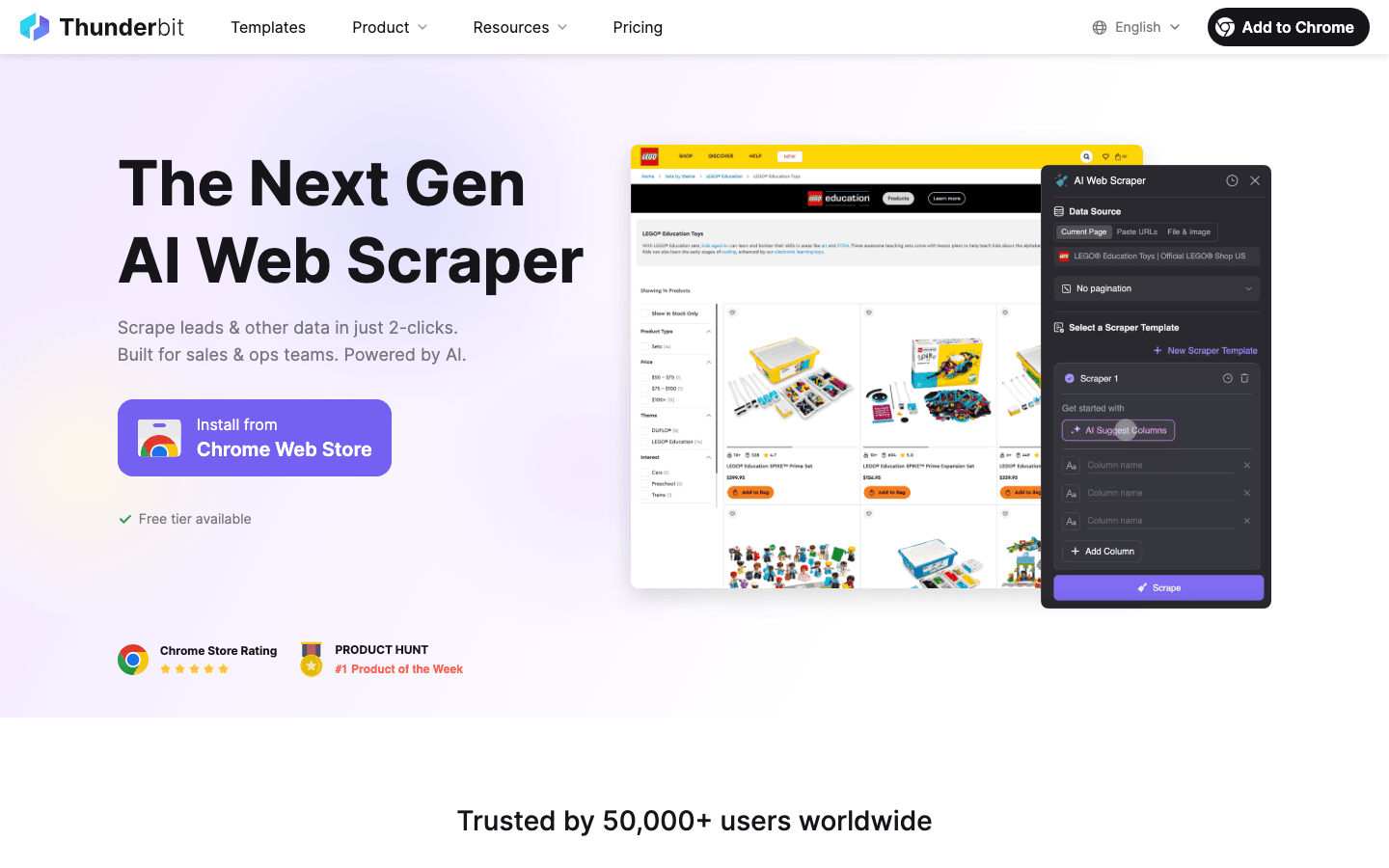

Thunderbit:让 Java 开发者轻松搞定网页爬虫

再来说说我身边很多团队都在用的“神器”:。Thunderbit 是一款基于 AI 的网页爬虫 Chrome 插件,只需点几下就能从任意网站提取结构化数据——不用写代码、不用模板、不用折腾。

Thunderbit 如何帮 Java 开发者和业务用户:

- AI 智能字段识别: Thunderbit 的 AI 能自动识别页面结构,推荐最佳提取字段,无需手动找 CSS 选择器或写解析代码。

- 子页面自动跳转: 需要抓详情页?Thunderbit 可自动点击子链接,补全数据集(比如商品列表+详情页信息)。

- 支持分页与无限滚动: 能自动滚动页面、点“下一页”,直到抓全所有数据。

- 结构化导出: 可直接导出到 Excel、Google Sheets、Airtable 或 Notion,也能下载为 CSV/JSON,方便对接 Java 应用。

- 云端/本地双模式: 支持云端批量爬取(一次最多 50 页,速度快),也能在本地浏览器运行,适合需要登录的网站。

- 定时任务: 可设置每日、每周或自定义时间自动爬取,AI 还能理解自然语言调度(比如“每周一上午 9 点”)。

对于 Java 开发者来说,Thunderbit 是原型开发、快速数据采集甚至生产流程的高效助手,尤其适合让非技术同事也能自主采集数据。

Thunderbit 如何助力销售与运营团队

Thunderbit 不只是开发者的工具。销售、市场、电商运营、地产团队每天都在用它:

- 线索采集: 不用写代码,从目录、领英、活动名单等抓联系方式。

- 竞品监控: 定时抓竞品价格、产品列表、营销策略等。

- 信息整合: 把多站点的商品、房源、招聘信息汇总成结构化表格。

我见过很多团队从“要是有这些数据就好了”到“10 分钟后表格已到手”。有了子页面抓取和 AI 字段识别,哪怕是结构混乱的网站也能轻松应对。

Java 网页爬虫项目中的数据质量保障

数据采集只是第一步。如果数据杂乱、缺失或过时,分析就会失真。我的经验是:

- 校验与清洗: 检查数据准确性、完整性和一致性。用 Java 强类型机制过滤异常值(比如价格字段为“N/A”),统一日期、货币、电话等格式,确保数据能直接分析()。

- 去重处理: 爬虫数据常有重复。用唯一键(如 URL 或 ID)和 Java 的 Set 集合去重。

- 自动化质量检查: 每次爬取后自动检测——数量是否异常、字段是否为空,异常及时记录和告警。

- 合理存储: 大规模任务建议直接写入数据库(如 Postgres、MongoDB),便于结构化管理和去重()。

错误处理与健壮性:让爬虫更稳定

网页爬虫是“高危运动”——网站宕机、结构变动、反爬机制随时可能让你的脚本崩溃。我的建议:

- 优雅的错误处理: 捕获 HTTP 错误(如 404、500)、超时、解析异常。失败时采用指数退避重试,别一味猛刷()。

- 适应页面变动: 用更稳健的选择器、空值判断和兜底逻辑。页面结构变了要记录原始 HTML 方便排查。

- 日志与告警: 记录每次请求、成功与失败,关键异常及时告警(比如本应抓 100 条却一条没抓到)。

- 断点续爬: 长时间任务要定期保存进度,崩溃后能断点恢复。

- 请求限速: 合理设置间隔、并发数,轮换 User-Agent,避免被封。

Java 重试逻辑示例:

1Document doc = null;

2for (int attempt = 1; attempt <= MAX_RETRIES; attempt++) {

3 try {

4 doc = Jsoup.connect(url).timeout(5000).get();

5 break;

6 } catch (IOException e) {

7 log("第" + attempt + "次尝试失败: " + e.getMessage());

8 Thread.sleep(1000 * attempt); // 指数退避

9 }

10}(参考:)

合规与道德:网页爬虫的法律底线

网页爬虫不是“法外之地”,合规很重要。忽视规则可能导致账号被封、法律诉讼甚至更严重后果。

- 尊重数据所有权: 抓取公开、非敏感数据通常没问题,但涉及个人信息(如姓名、邮箱)受 GDPR、CCPA 等法规保护。没有合法依据,千万别采集个人数据()。

- 遵守服务条款与 robots.txt: 网站明令禁止爬虫时要谨慎,最好遵守 robots.txt 和访问频率限制。

- 避免过度抓取: 控制请求速率和并发,别影响网站正常运行()。

- 不抓取受版权或登录保护内容: 未经授权不要抓取并发布受版权保护的内容,也不要采集登录后数据。

- 数据安全与匿名化: 涉及敏感信息要安全存储,支持用户删除请求。

实用合规建议

- 抓取前先查网站服务条款和 robots.txt

- 设置有意义的 User-Agent(别用默认“Java/1.8.0_201”)

- 控制请求频率和并发数

- 优先用 API 或公开数据集

- 记录抓取内容和用途

- 关注最新法律法规和最佳实践()

性能优化:让 Java 网页爬虫高效扩展

当爬虫需求升级,性能就成了关键。以下是我的扩展建议:

- 并发抓取: 用 Java 的 ExecutorService 或线程池同时抓多个页面,合理控制并发,避免被封()。

- 流式写入: 边抓边写入数据库或文件,避免内存爆掉。

- 高效解析: 用 Jsoup 选择器精准提取,超大任务可考虑流式或更轻量的解析方式。

- 云端资源: 在云服务器上跑爬虫,带宽和稳定性更好。或者用 Thunderbit 云端模式应对大批量任务。

- 网络优化: 启用压缩、靠近目标网站部署爬虫、合理缓存响应。

Java 多线程爬取示例:

1ExecutorService pool = Executors.newFixedThreadPool(10);

2for (String url : urlList) {

3 pool.submit(() -> scrapePage(url));

4}

5pool.shutdown();(参考:)

总结:Java 网页爬虫成功的关键要点

回顾一下,想玩转 Java 网页爬虫,你需要:

- 选对工具: 静态页面用 Jsoup,动态页面用 Selenium/Playwright,无头 Java 用 HtmlUnit。

- 善用自动化与 AI: 利用 等工具提升字段识别、子页面抓取和数据导出效率,尤其适合业务用户和原型开发。

- 重视数据质量: 校验、清洗、去重、合理存储。

- 合规为先: 遵守法律和道德底线,只抓取公开数据,遵守网站规则,个人信息需合法依据。

- 高效扩展: 利用 Java 并发、优化存储和云资源应对大规模任务。

网页爬虫不仅是技术能力,更是数据驱动业务的“超级武器”。无论你是开发者打造高可用 Java 爬虫,还是销售/运营用 Thunderbit 自动化数据采集,掌握这些最佳实践都能让你和团队如虎添翼。

想体验 AI 网页爬虫的便捷?,感受一键将网页变成结构化数据的高效。想深入学习,欢迎访问 ,获取更多实用教程、工具对比和真实案例。

常见问题解答

1. 为什么 Java 依然适合做网页爬虫?

Java 具备高可靠性、强大的多线程能力,并能与企业系统无缝集成。对于大规模、长时间、高性能的爬虫任务,尤其是数据管道本身用 Java 的场景,Java 是理想选择()。

2. Jsoup、Selenium、HtmlUnit 和 Playwright 有什么区别?

Jsoup 适合静态 HTML,Selenium 和 Playwright 能处理动态、JS 密集型网站,HtmlUnit 是纯 Java 的无头浏览器,适合中等 JS 复杂度。根据网站复杂度和项目需求选择()。

3. Thunderbit 如何帮助 Java 开发者和业务用户?

Thunderbit 利用 AI 自动识别字段、导航子页面、结构化数据,无需写代码。适合业务用户或开发者快速原型、赋能非技术同事自主采集数据()。

4. 如何保障网页爬虫数据质量?

校验和清洗数据、去重、自动化质量检查,大规模任务建议存入数据库。始终把爬取数据当作“原材料”,需进一步加工()。

5. 如何合规、道德地抓取网页数据?

只抓取公开、非敏感数据,遵守 robots.txt 和网站条款,避免高频抓取,不采集个人信息(除非有合法依据)。关注 GDPR、CCPA 等法规动态()。

想提升你的网页爬虫技能?免费试用 Thunderbit,或用这些最佳实践自研 Java 爬虫。祝你爬虫顺利——记得规范开发、合规抓取,数据决策前多做校验。

延伸阅读