你有没有过这样的时刻:盯着竞争对手的网站,恨不得一键把他们的产品价格、联系方式全都扒下来,而不是傻傻地花一下午复制粘贴?其实你不是一个人在战斗。现在,不管公司大小,大家对网页数据的需求都在飞速增长——价格、评论、客户线索、市场趋势,样样都想要。随着互联网信息量爆炸(据说到 2037 年,网页爬虫市场规模会超过 ),自动化工具,尤其是基于 Javascript 的工具,已经成了销售、运营、调研团队的“标配神器”。

那“web scraper javascript”到底是啥?为啥它能从 Chrome 扩展到后端服务器无处不在?普通人(不用会写代码)怎么用它把杂乱的网页数据变成企业能用的信息?接下来,我结合自己开发 的经验和一堆真实案例,带你深入了解。

Web Scraper Javascript:入门扫盲

简单说,web scraper javascript 工具就是用 Javascript 自动帮你从网页上提取数据的软件。你不用再手动点点点、复制粘贴,工具帮你全搞定——不管是表格、价格、邮箱,还是其他你想要的信息,都能把乱七八糟的网页内容变成结构化数据。

为啥选 Javascript?因为 Javascript 是网页的“通用语言”,既能在浏览器(比如 Chrome)里跑,也能在服务器端(靠 Node.js)执行,特别适合和网页互动、模拟用户操作,还能搞定那些点一下才显示的动态内容()。

通俗点说:Javascript 网页爬虫就像一个永远不喊累的虚拟小助手,帮你在网上浏览、点击、复制数据,效率爆表。

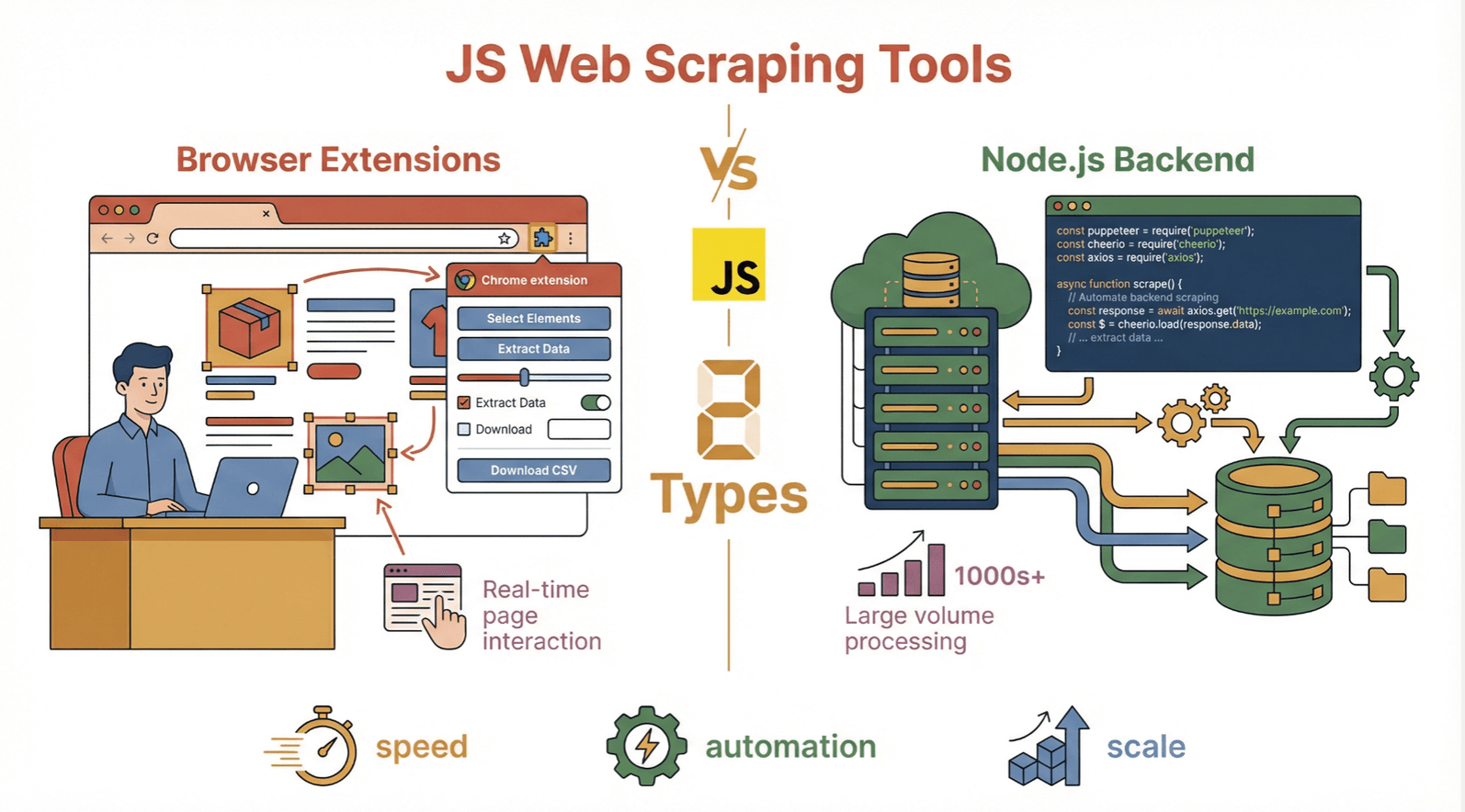

Javascript 网页爬虫工具主要分两类:

- 基于浏览器的工具(比如 Chrome 扩展):直接在浏览器里用,适合抓你眼前看到的数据。

- Node.js 后端工具:在服务器上跑,适合大批量自动化和自定义流程。

这两种方式各有千秋,下面详细聊聊。

两大主流路线:浏览器扩展 vs. Node.js 工具

在 Javascript 网页爬虫圈子里,主流玩法有两种:

基于浏览器的 Web Scraper Javascript 工具

这类工具一般是 Chrome 扩展(或者 Firefox 插件),直接在浏览器里操作。你只要打开网页,点一下按钮,数据就能抓下来——完全不用写代码。特别适合业务、销售、追求效率的同学。

- 工作原理: 扩展会“读取”你当前浏览的网页,自动识别表格、列表、产品卡片等结构,把数据导出成表格或数据库。

- 适用场景: 非技术用户、临时任务、抓取可见内容、需要登录的网站。

- 局限性: 不适合一次性抓成千上万页面,通常只能抓浏览器里能看到的数据。

典型代表就是 ,后面会详细说。其他常见的还有 Data Miner、Web Scraper Chrome Extension()。

Node.js 后端网页爬虫工具

这类工具在服务器端运行,用 Javascript(Node.js)批量抓取和处理网页。虽然更偏技术,但搞大规模、自动化需求时特别给力。

- 工作原理: Node.js 脚本给网站发 HTTP 请求,下载 HTML 内容,用各种库解析和提取数据——有时候还会模拟浏览器,搞定动态内容。

- 适用场景: 开发者、数据工程师、大批量抓取、定时任务、系统集成。

- 常用库: 、、、。

一句话总结: 浏览器工具适合“所见即所得”的快速抓取,Node.js 工具适合“批量、定时、定制化”的复杂任务。

Javascript 网页爬虫工具的热门商业场景

Javascript 网页爬虫可不是极客专属玩具,反而是各种业务场景的秘密武器。下面这些应用,我几乎每周都能遇到:

| 应用场景 | 解决的问题 | 实际案例 |

|---|---|---|

| 市场调研 | 手动跟踪竞争对手效率低下 | 批量抓取竞品产品列表和价格 |

| 价格监控 | 价格每天变动,难以及时掌握 | 实时监控电商网站价格变化 |

| 潜在客户挖掘 | 查找联系方式耗时费力 | 从企业名录中提取邮箱和电话 |

| 数据清洗与补全 | 数据分散且杂乱 | 汇总并清洗多渠道产品信息 |

| 内容聚合 | 新闻、评论、列表分布在不同网站 | 收集文章或评论用于分析 |

| 自动化操作 | 重复性网页任务浪费大量时间 | 自动填写表单、下载报告或触发工作流 |

网页爬虫能帮企业省时间、提准确率、优化决策——不管你是独立创业者还是世界 500 强团队()。

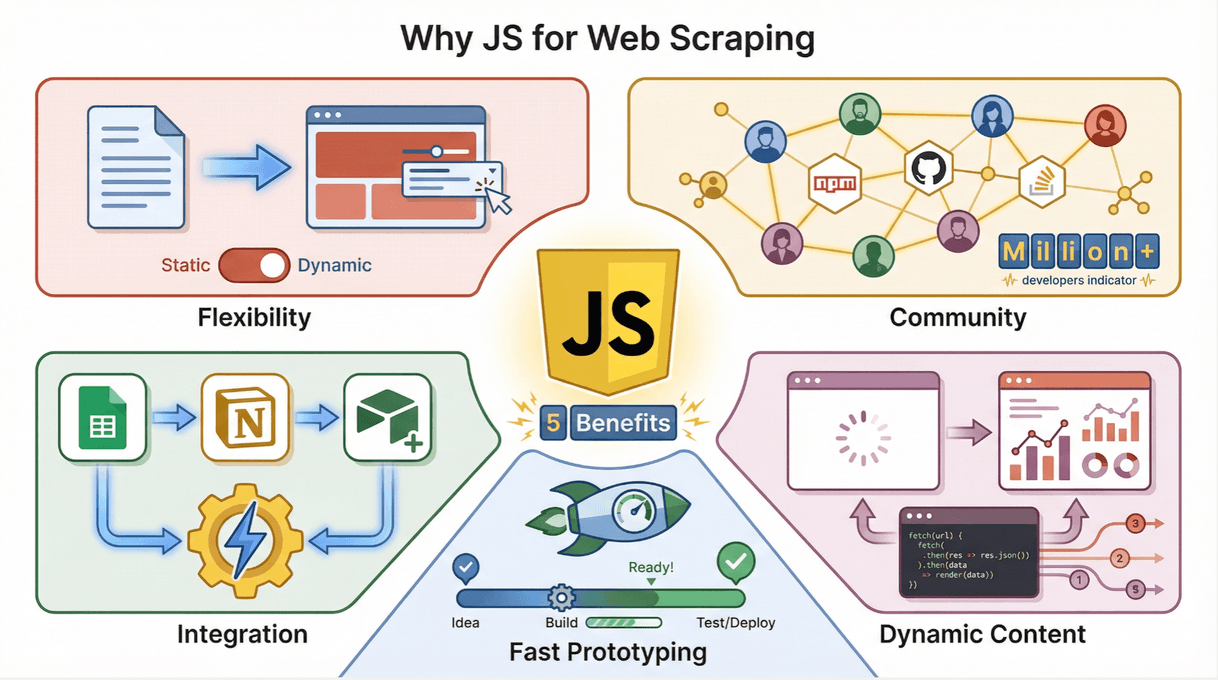

为什么越来越多人用 Javascript 做网页爬虫?

为啥现在大家都爱用 Javascript 做网页爬虫?我总结了几点亲身体验和行业共识:

- 灵活性爆棚: Javascript 能搞定静态和动态内容,模拟真实用户操作,适应各种网页结构()。

- 社区超活跃: 开发者多、开源库多,遇到问题很容易找到解决办法()。

- 集成超方便: Javascript 爬虫能无缝对接业务流程,比如导出到 Google Sheets、Notion、Airtable,或者自动触发后续操作。

- 动态内容处理能力强: 现在很多网站用 Javascript 加载数据,用 Javascript 抓取自然更顺手()。

- 原型开发快: 尤其是浏览器工具,搭建和测试都特别快。

和 Python(另一大主流爬虫语言)比起来,Javascript 在模拟用户操作、直接在浏览器跑时优势更明显()。

Javascript 网页爬虫的挑战和坑

当然,实际操作时也会遇到不少“坑”,下面是我常见的挑战和应对建议:

- 反爬机制: 很多网站会用验证码、IP 封禁、访问频率限制等手段防爬。Javascript 工具有时能模拟人类行为,但还是要小心()。

- 动态/交互内容: 有些网站用无限滚动、弹窗等复杂加载方式。这时候可以用 Puppeteer 或浏览器扩展等高级工具搞定()。

- 网页结构变动: 网站一改版,爬虫脚本可能就失效。AI 驱动的工具(比如 Thunderbit)能自动适应,传统代码就得手动维护()。

- 法律和合规: 一定要遵守网站的

robots.txt和服务条款,别碰隐私数据()。

实用建议: 先小规模试水,降低抓取频率,优先选合规且能自动规避风险的工具()。

Thunderbit 如何让 Web Scraper Javascript 变得超简单

说到这里,必须“安利”一下 Thunderbit。我们做 Thunderbit,就是想让网页爬虫像点外卖一样简单——不用写代码、不用模板、零门槛。

- AI 智能字段识别: 只要点一下,Thunderbit 的 AI 就能自动识别页面内容,推荐可提取的数据,还能自动生成操作指令。

- 两步抓取: 选好字段,点“抓取”,数据立马到手。就像和助手聊天一样轻松()。

- 子页面和分页支持: Thunderbit 能自动跟踪子页面(比如商品详情)和分页内容。

- 一键模板: 针对热门网站(亚马逊、Zillow、Shopify 等)内置模板,点一下就能导出数据。

- 免费数据导出: 支持导出到 Excel、Google Sheets、Notion、Airtable、CSV、JSON,无需额外付费,也不用折腾格式()。

- AI 数据结构化: Thunderbit 的 AI 能自动标注、格式化、翻译和整理数据。

最爽的是?你完全不用懂技术。连我那些“电脑小白”朋友都能用 Thunderbit 快速建客户名单、抓竞品价格、自动化调研()。

Thunderbit 的核心亮点

- AI 驱动的极简体验: 只要说出需求,Thunderbit 自动帮你搞定剩下的事。

- 多语言支持: 支持 34 种语言,全球团队都能轻松抓数据()。

- 批量和子页面抓取: 能自动抓数百页面,或跟踪子页面数据。

- 定时任务: 支持定时抓取,数据实时更新。

- 免费套餐: 免费体验 6 个页面,升级套餐只要 $15/月起。

Thunderbit 已经被 ,覆盖销售、电商、地产等多个行业。

Javascript 网页爬虫工具:真实案例速览

来看看实际应用,Javascript 网页爬虫怎么帮企业搞定难题:

- 电商价格监控: 某线上零售商用浏览器爬虫每天跟踪竞品价格,实时调整自家售价,结果销售额提升 15%,定价错误大幅减少()。

- 销售线索挖掘: 某 B2B 团队批量抓行业名录联系方式,再结合领英数据补全,客户回复率提升 30%()。

- 市场调研: 某咨询公司汇总几十家竞品网站的评论和产品参数,每周省下 20 小时人工调研()。

这些案例,Thunderbit 用户只需点几下就能搞定。

Web Scraper Javascript 的未来:更智能、更自动

未来趋势超有看头。新一代 Javascript 网页爬虫正朝着 AI 和自动化 疯狂进化:

- AI 智能提取: Thunderbit 等工具用机器学习自动识别、理解、结构化数据,网站改版也能适应()。

- 自然语言交互: 不用写代码,只要用自然语言描述需求(比如“抓取本页所有邮箱和价格”),工具自动帮你搞定。

- 智能定时和提醒: 爬虫能自动运行,价格变动、新线索出现或趋势变化时自动提醒你()。

- 多模态数据采集: 不只抓文本,AI 还能提取图片、PDF、音频等多种内容()。

总之,Web Scraper Javascript 工具正变得更智能、更高效、更好用——让每个人都能轻松获取网页数据,不再是开发者的专利。

总结:如何选对 Javascript 网页爬虫工具

一句话总结:Javascript 网页爬虫工具已经是现代网页数据采集的核心。不管你是做销售、市场调研,还是厌倦了手动复制粘贴,这些工具都能帮你把混乱网页变成有价值的洞察。

- 浏览器工具(比如 )适合非技术用户和追求效率的业务场景。

- Node.js 后端工具更适合开发者和大规模自动化需求。

- AI 驱动方案让网页爬虫变得前所未有的简单和强大。

想快速上手? 这里有一份简明清单:

- 明确目标: 你需要什么数据?多久抓一次?

- 选择工具: 对大多数业务用户来说,Chrome 扩展如 是最快捷的选择——不用写代码,不用配置。

- 小规模测试: 先用免费套餐抓几页,看看适不适合你的工作流。

- 按需扩展: 如果需要更大规模或自动化,可以考虑 Node.js 工具或高级功能(比如定时、子页面抓取)。

- 合规操作: 一定要遵守网站条款和隐私法规。

想深入了解?欢迎访问 看详细教程,或者直接体验 Thunderbit 免费试用。你会发现,省下的不只是时间,还有精力和烦恼。

祝你抓取顺利,愿你的表格永远数据满满、准确无误!

常见问题解答

1. 什么是 web scraper javascript 工具?

web scraper javascript 工具就是用 Javascript 自动从网页提取数据的软件。它可以作为 Chrome 扩展在浏览器里用,也可以通过 Node.js 在服务器端跑,把杂乱网页内容变成结构化、可用的数据。

2. Javascript 网页爬虫工具主要有哪些类型?

主要分两类:基于浏览器的工具(比如 Chrome 扩展,例如 Thunderbit),适合抓取所见内容;Node.js 后端工具(比如 Puppeteer、Cheerio 等库),适合大规模自动化抓取。

3. Javascript 网页爬虫常见的商业用途有哪些?

常见用途有市场调研、竞品价格监控、潜在客户挖掘、数据清洗、内容聚合和自动化网页操作等。

4. Javascript 网页爬虫有哪些优势?

Javascript 灵活、社区活跃、能处理动态内容,还能方便集成到业务流程。特别适合抓现代交互式网站。

5. Thunderbit 如何让非技术用户也能轻松用 web scraper javascript?

Thunderbit 提供 AI 驱动的 Chrome 扩展,只需两步就能抓数据,无需编程。AI 字段推荐、子页面抓取、免费数据导出等功能,让任何人都能高效收集和整理网页数据。

想进一步了解?欢迎阅读 或 亲自体验。

延伸阅读