想象一下:早上8:30,你刚泡上一杯咖啡,老板(或者老板的老板)突然让你整理一份竞争对手所有产品的价格、客户评价,甚至还要查CEO最喜欢的披萨口味。你可以花好几个小时复制粘贴,也可以让Python帮你一键搞定。但如果你不会编程,或者不想一大早就在调试HTML怎么办?这篇指南就是为你量身定制的。

我是Thunderbit联合创始人兼CEO关帅,长期专注SaaS、自动化和AI,帮助团队把杂乱的网页数据变成有价值的洞察。今天就带你了解2025年最值得关注的10大python网页爬虫库——它们的功能、用法、优缺点和适用场景。如果你觉得“这些都挺好,但我还是不会写Python”,别急,后面我还会介绍Thunderbit的无代码AI网页爬虫,让你两步搞定数据采集,无需编程、无需折腾、也不用靠咖啡续命。

为什么python网页爬虫库对企业团队很重要

- 获客与销售线索: 批量采集名录、社交网络或论坛,自动生成精准客户名单,包括姓名、邮箱、社交账号等。销售团队再也不用手动挨个找客户了()。

- 价格监控与竞品分析: 电商团队实时追踪竞争对手的价格、库存和促销,灵活调整自家策略()。

- 市场调研与趋势分析: 批量抓取评论、社交媒体或新闻,帮助市场和产品团队提前洞察行业动态和用户情绪()。

- 房产与地产数据: 经纪人和分析师可以整合多平台的房源、价格和详细信息,轻松完成市场分析。

- 电商运营: 从供应商数据到商品目录核查,爬虫让数据更准确,团队不再陷入无休止的复制粘贴。

一句话总结,。但问题是,大多数python网页爬虫库默认你会写代码。对于非技术用户来说,这门槛可不低。所以,像这样的无代码AI工具才越来越受欢迎,后面会详细介绍。

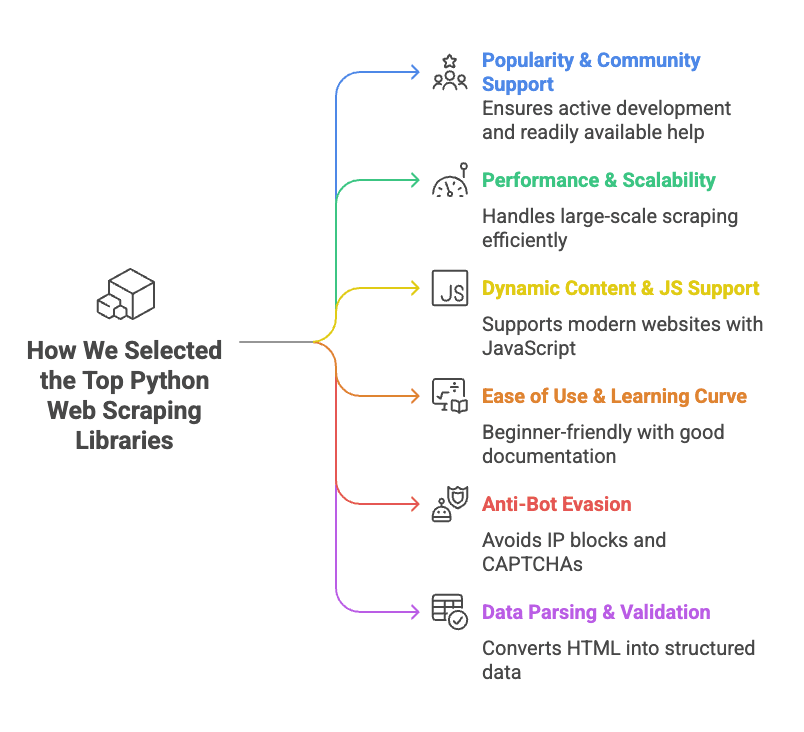

我们如何筛选python网页爬虫库

- 流行度与社区活跃度: 选GitHub星标多、开发活跃、教程丰富的库。遇到问题时,能在Stack Overflow找到答案而不是没人理。

- 性能与扩展性: 能不能高效处理成千上万页面?支持并发或异步请求吗?速度快不快?

- 动态内容与JS支持: 现代网站大量依赖JavaScript加载数据,能不能处理动态内容(比如浏览器自动化或API集成)是加分项。

- 易用性与学习曲线: 有些工具开箱即用,有些让人头大。我们更偏向新手友好、文档完善的库。

- 反爬能力: 能不能应对IP封禁、验证码或限流?否则可能刚爬五分钟就被封五天。

- 数据解析与校验: 不只是抓HTML,还要能转成结构化数据。支持解析和校验的库更受欢迎。

每个库我们都会介绍其定位、用法、优缺点和最佳应用场景。

快速对比:主流python网页爬虫库一览

下面这张表帮你快速锁定适合自己的工具(顺便还能用专业术语惊艳老板):

| 库 | 易用性 | JS支持 | HTTP请求 | HTML解析 | 反爬功能 | 数据校验 | 最佳用途 |

|---|---|---|---|---|---|---|---|

| ZenRows | 非常简单(API) | ✅(浏览器) | ✅(API) | ✅ | ✅(代理、验证码绕过) | ❌ | 大规模抓取受保护网站 |

| Selenium | 中等 | ✅(浏览器) | ✅(浏览器) | 部分 | ❌ | ❌ | 动态、交互性强的网站 |

| Requests | 非常简单 | ❌ | ✅ | ❌ | ❌ | ❌ | 静态页面、API |

| Beautiful Soup | 简单 | ❌ | ❌ | ✅ | ❌ | ❌ | 解析静态页面HTML |

| Playwright | 中等 | ✅(浏览器) | ✅(浏览器) | DOM访问 | ❌ | ❌ | 现代Web应用,多浏览器支持 |

| Scrapy | 中等/偏难 | 部分(插件) | ✅(异步) | ✅ | ❌ | 有限 | 大规模结构化爬取 |

| urllib3 | 简单(底层) | ❌ | ✅ | ❌ | ❌ | ❌ | 自定义HTTP,高并发 |

| HTTPX | 简单/中等 | ❌(异步IO) | ✅(异步) | ❌ | ❌ | ❌ | 高性能异步爬取 |

| lxml | 中等 | ❌ | ❌ | ✅(快) | ❌ | ❌ | 快速解析复杂HTML/XML |

| Pydantic | 中等 | N/A | N/A | N/A | N/A | ✅ | 爬取后数据校验 |

注:“JS支持”指能否处理JavaScript渲染内容;“反爬功能”指内置能力,不包括你自己手动加的。

ZenRows:一站式python网页爬虫API

简介:

是一个网页爬虫API,帮你搞定代理轮换、验证码绕过、浏览器指纹、JS渲染等繁琐环节。你只需发起API请求,ZenRows就能返回完整页面。

用法示例:

注册API Key后,用Python的requests库调用ZenRows:

1import requests

2url = "<https://example.com>"

3apikey = "<YOUR_ZENROWS_API_KEY>"

4params = {

5 "url": url,

6 "apikey": apikey,

7 "js_render": "true",

8 "premium_proxy": "true"

9}

10response = requests.get("<https://api.zenrows.com/v1/>", params=params)

11print(response.text[:500])优点:

- 自动绕过大部分反爬机制(代理、验证码等)

- 支持JS渲染,适合动态网站

- API简单,无需自己管理浏览器或代理

- 适合大规模任务

缺点:

- 付费服务(有免费试用,长期用需付费)

- 依赖第三方API

适用场景:

大规模抓取、反爬严格或需要JS渲染的网站。如果你经常被封或被验证码困扰,ZenRows值得一试()。

Selenium:自动化浏览器,轻松抓取动态网页

简介:

是浏览器自动化的“鼻祖”,可以用Python控制Chrome、Firefox等浏览器,模拟点击、填写表单、滚动等操作。只要人能在浏览器里做的,Selenium都能自动化。

用法示例:

安装Selenium和浏览器驱动(如ChromeDriver):

1from selenium import webdriver

2from selenium.webdriver.chrome.options import Options

3options = Options()

4options.add_argument("--headless=new")

5driver = webdriver.Chrome(options=options)

6driver.get("<https://example.com>")

7html = driver.page_source

8print(html[:200])

9driver.quit()优点:

- 能处理任何浏览器能访问的网站(动态内容、登录、弹窗等)

- 可模拟用户操作(点击、输入等)

- 支持多种浏览器

缺点:

- 占用资源大(每个浏览器实例都消耗内存和CPU)

- 速度慢于HTTP请求方式

- 并发处理难度较高

- 易被高级反爬检测

适用场景:

需要模拟用户操作的动态网站,比如LinkedIn、仪表盘、登录后页面等()。

Requests:Python最常用的HTTP客户端

简介:

是“为人类设计的HTTP库”,用Python抓取网页或API的首选,简单、稳定、应用广泛。

用法示例:

抓取静态页面:

1import requests

2response = requests.get("<https://www.example.com>")

3if response.status_code == 200:

4 html_text = response.text

5 print(html_text[:300])优点:

- API极其简单

- 速度快、体积小

- 支持Cookies、重定向等常见HTTP需求

- 社区庞大,教程丰富

缺点:

- 不能执行JavaScript,无法处理动态内容

- 不自带HTML解析(需配合Beautiful Soup或lxml)

- 无内置反爬功能(需手动设置headers、代理等)

适用场景:

静态页面、API或数据直接在HTML里的网站。新手入门首选Requests+Beautiful Soup组合()。

Beautiful Soup:python网页爬虫的HTML解析利器

简介:

(BS4)是Python的HTML/XML解析库。它本身不抓网页,需配合Requests或Selenium,但能让你轻松提取HTML中的数据。

用法示例:

解析商品名称:

1from bs4 import BeautifulSoup

2import requests

3html = requests.get("<https://example.com/products>").text

4soup = BeautifulSoup(html, "html.parser")

5product_names = [tag.get_text() for tag in soup.find_all("h2", class_="product-name")]

6print(product_names)优点:

- 新手友好,能容忍格式混乱的HTML

- 支持多种查找方式(标签、类名、CSS选择器、正则)

- 轻量、速度快

- 文档和案例丰富

缺点:

- 不抓网页、不支持JS

- 处理超大文档时速度不如lxml

- 复杂查询能力有限(高级XPath建议用lxml)

适用场景:

将原始HTML转为结构化数据,比如商品列表、表格、链接等。只要有HTML,Beautiful Soup都能帮你提取()。

Playwright:现代浏览器自动化新秀

简介:

由微软开发,是新一代浏览器自动化工具。和Selenium类似,但速度更快,支持多引擎(Chromium、Firefox、WebKit),API更现代。

用法示例:

抓取页面内容:

1from playwright.sync_api import sync_playwright

2with sync_playwright() as p:

3 browser = p.chromium.launch(headless=True)

4 page = browser.new_page()

5 page.goto("<https://example.com>")

6 content = page.content()

7 print(content[:200])

8 browser.close()优点:

- 支持动态、JS密集型网站

- 多浏览器支持(Chromium、Firefox、WebKit)

- 自动等待元素,稳定性高

- 支持异步和并行

缺点:

- 依然占用较多资源(浏览器自动化)

- 学习曲线较陡,尤其是异步用法

- 也可能被反爬检测

适用场景:

现代Web应用、不同浏览器下表现不同的网站,或需要拦截网络请求时()。

Scrapy:高效可扩展的python爬虫框架

简介:

是功能强大的网页爬虫框架,专为大规模抓取设计,内置并发、数据管道、导出等功能。如果你要抓成千上万页面,Scrapy是首选。

用法示例:

定义一个爬虫:

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["<http://quotes.toscrape.com>"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 'text': quote.css("span.text::text").get(),

9 'author': quote.css("small.author::text").get()

10 }在Scrapy项目目录下用scrapy crawl quotes运行。

优点:

- 性能高,内置并发

- 项目结构清晰(爬虫、管道、中间件)

- 支持导出CSV、JSON、数据库

- 社区活跃,插件丰富

缺点:

- 新手上手难度较大

- 需项目初始化(不适合临时小任务)

- 原生JS支持有限(需插件)

适用场景:

大规模、可重复的抓取任务,比如整合多平台房源、批量采集商品目录等()。

Urllib3:底层稳定的Python HTTP库

简介:

是Requests等库的底层HTTP客户端。如果你需要精细控制连接、重试、连接池等,urllib3是理想选择。

用法示例:

抓取页面:

1import urllib3

2http = urllib3.PoolManager()

3resp = http.request("GET", "<http://httpbin.org/html>")

4if resp.status == 200:

5 html_text = resp.data.decode('utf-8')

6 print(html_text[:100])优点:

- 高效的连接池管理

- 线程安全,适合并发爬取

- 可精细控制HTTP行为

缺点:

- 用法比Requests更底层,需手动处理细节

- 不支持HTML解析和JS

- 新手教程较少

适用场景:

自定义HTTP、高并发爬取或极致性能需求()。

HTTPX:现代异步Python HTTP库

简介:

是新一代Python HTTP客户端,支持异步和HTTP/2。想要并发抓取成千上万页面,HTTPX是你的好帮手。

用法示例:

同步用法:

1import httpx

2response = httpx.get("<https://httpbin.org/get>")

3if response.status_code == 200:

4 data = response.json()

5 print(data)异步用法:

1import httpx, asyncio

2urls = ["<https://example.com/page1>", "<https://example.com/page2>"]

3async def fetch(url, client):

4 resp = await client.get(url)

5 return resp.status_code

6async def scrape_all(urls):

7 async with httpx.AsyncClient(http2=True) as client:

8 tasks = [fetch(u, client) for u in urls]

9 results = await asyncio.gather(*tasks)

10 print(results)

11asyncio.run(scrape_all(urls))优点:

- 支持异步,高并发爬取

- 支持HTTP/2(更快)

- API风格与Requests类似,迁移简单

- 错误处理更完善

缺点:

- 新库,教程较少

- 异步用法需理解事件循环

- 不自带HTML解析

适用场景:

高吞吐量爬取、API或需要极快速度的场景()。

lxml:高效强大的HTML/XML解析库

简介:

是高性能的HTML/XML解析库,支持XPath和CSS选择器。很多工具(如Scrapy的选择器)都用它做底层引擎。

用法示例:

提取名言和作者:

1import requests

2from lxml import html

3page = requests.get("<http://quotes.toscrape.com>").content

4tree = html.fromstring(page)

5quotes = tree.xpath('//div[@class="quote"]/span[@class="text"]/text()')

6authors = tree.xpath('//div[@class="quote"]/small[@class="author"]/text()')

7print(list(zip(quotes, authors)))优点:

- 解析速度极快,适合大文档

- 支持强大的XPath查询

- 内存占用低

缺点:

- XPath语法有学习门槛

- 文档不如BS4友好

- 某些系统下安装略复杂

适用场景:

解析大体量或结构复杂的HTML/XML,或需要高级查询时()。

Pydantic:让python爬虫数据更干净可靠

简介:

并不是爬虫库,而是数据校验和建模工具。爬取完数据后,Pydantic能帮你确保数据类型正确、格式规范,方便后续分析和业务使用。

用法示例:

校验爬取数据:

1from pydantic import BaseModel, validator

2from datetime import date

3class ProductItem(BaseModel):

4 name: str

5 price: float

6 listed_date: date

7 @validator('price')

8 def price_must_be_positive(cls, v):

9 if v <= 0:

10 raise ValueError('price must be positive')

11 return v

12raw_data = {"name": "Widget", "price": "19.99", "listed_date": "2025-02-15"}

13item = ProductItem(**raw_data)

14print(item.price, type(item.price))

15print(item.listed_date, type(item.listed_date))优点:

- 严格校验,提前发现数据问题

- 自动类型转换(字符串转数字、日期等)

- 声明式数据模型,代码清晰易维护

- 支持复杂嵌套数据

缺点:

- 需学习模型语法

- 会增加部分处理开销

适用场景:

确保爬取数据干净、规范,便于分析或导入业务系统()。

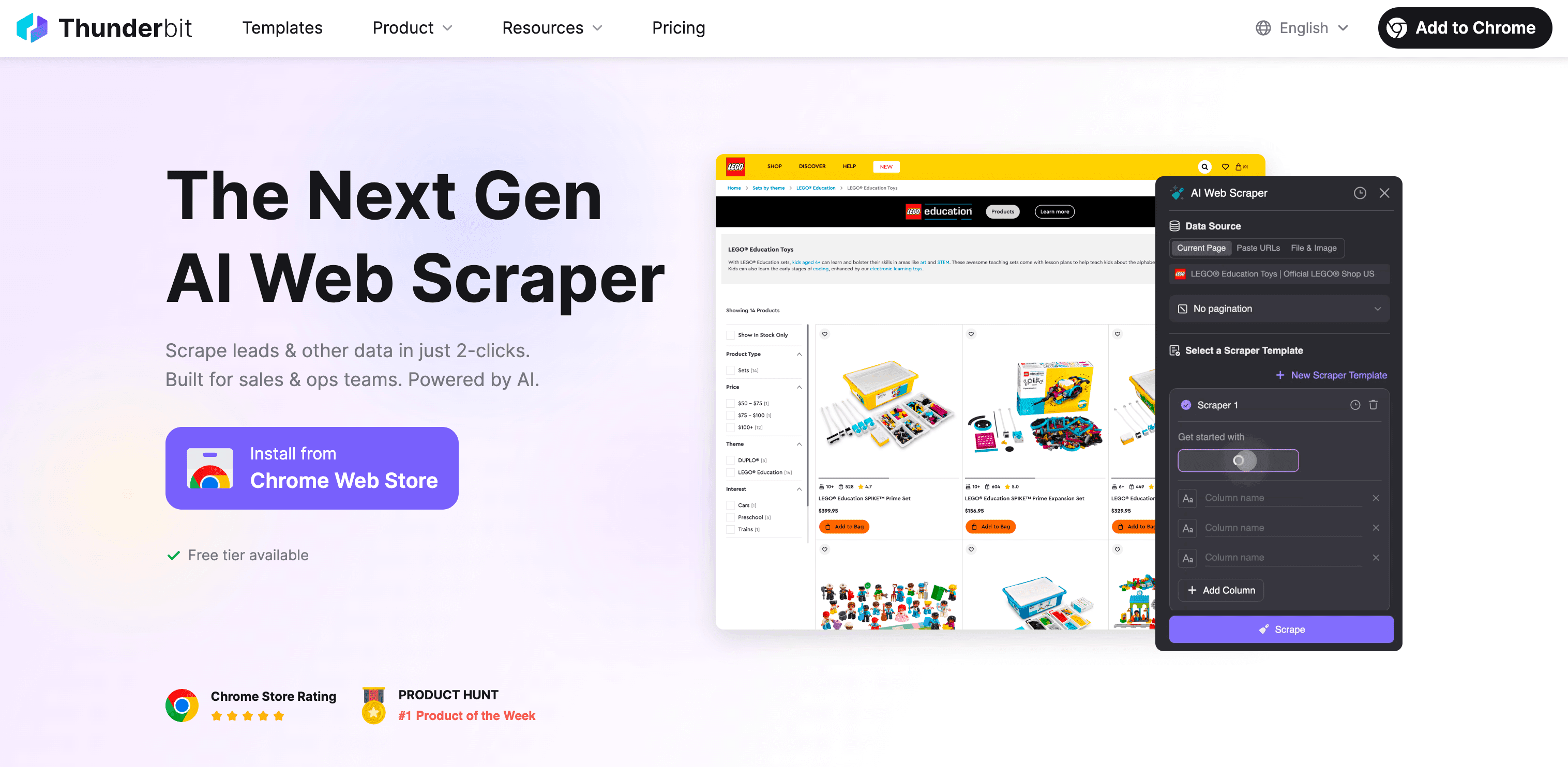

无代码替代方案:Thunderbit AI网页爬虫,专为业务用户打造

说实话,如果你看到这里还在想“Python很强大,但我真不想花周末学XPath”,你绝不是一个人。这正是我们打造的初衷。

Thunderbit是什么?

Thunderbit是一款AI驱动的无代码网页爬虫Chrome插件。专为业务用户设计——无论你是销售、电商运营、市场、房产中介,只要需要网页数据,不用写代码、不用折腾代理,也不用担心反爬。

Thunderbit为何比python库更适合非技术用户:

- 无需编程: 只需点击“AI智能识别字段”,Thunderbit的AI自动读取页面,点“抓取”即可。两步搞定,支持任意网站、PDF、图片。

- 支持动态内容: Thunderbit在浏览器或云端运行,能抓取JS渲染、无限滚动、登录后等复杂页面。

- 子页面批量抓取: 需要采集每个商品或个人主页的详细信息?Thunderbit可自动访问子页面并补全表格。

- AI智能结构化: 自动推荐字段名、数据类型,还能自定义AI提示词,随时标注、格式化、翻译和整理数据。

- 抗反爬能力强: 无需自己配置代理,Thunderbit利用真实浏览器和AI,轻松绕过大部分反爬机制。

- 多平台导出: 数据可一键导出到Excel、Google Sheets、Airtable、Notion、CSV、JSON等,免费不限量。

- 内置模板: 针对热门网站(如Amazon、Zillow、Instagram、Shopify等)直接选模板即用,无需配置。

- 免费功能丰富: 邮箱、电话、图片提取器完全免费,AI自动填表也免费。

与python库对比:

| 功能 | Python库 | Thunderbit |

|---|---|---|

| 是否需编程 | 需要 | 不需要 |

| 动态内容支持 | 部分(需浏览器工具) | 支持(浏览器/云端) |

| 反爬处理 | 手动(代理、headers) | 内置(浏览器会话+AI) |

| 数据结构化 | 手动(写代码解析) | AI自动结构化 |

| 子页面抓取 | 需自定义代码 | 一键批量 |

| 导出选项 | 代码导出CSV/JSON | Excel、Google Sheets、Airtable、Notion等 |

| 模板 | 自己写或社区分享 | 内置热门网站模板 |

| 维护 | 需自己维护脚本 | Thunderbit团队自动更新 |

Thunderbit适合谁?

如果你是销售、电商运营、市场、房产等业务人员,需要采集网页数据(如客户、价格、商品、房源等),但没有技术背景,Thunderbit就是为你量身打造的。最快速的方式,从“我要数据”到“表格已生成”,全程无需Python。

想亲自体验?免费试用,或访问获取更多技巧。

总结:如何选择合适的python网页爬虫库(或无代码工具)

最后总结一下:python网页爬虫库功能强大、灵活,几乎能应对所有场景——前提是你会写代码并愿意投入时间。简要回顾:

- ZenRows: 适合大规模抓取受保护网站,内置反爬功能。

- Selenium & Playwright: 动态、交互性强的网站首选,但配置和资源消耗较大。

- Requests & HTTPX: 静态页面和API利器,HTTPX适合高并发异步爬取。

- Beautiful Soup & lxml: HTML解析首选,BS4适合新手,lxml速度快、功能强。

- Scrapy: 大型结构化爬取的框架。

- urllib3: 高并发自定义HTTP场景。

- Pydantic: 保证数据干净、规范,便于后续分析。

但如果你不会编程,或者只想高效完成任务,就是你的捷径。无需写代码、无需维护,直接拿到结果。

我的建议:

- 如果你热爱Python,追求极致控制,选适合自己场景和技能的库。

- 如果你只想要数据(还想多睡会儿),就让Thunderbit的AI帮你搞定吧。

无论你是Python高手,还是只想高效拿到数据的业务用户,2025年总有一款工具适合你。如果你想聊聊爬虫、自动化,或者CEO最爱的披萨口味,随时欢迎来找我。

祝你抓数愉快!

常见问题

1. 最受欢迎的python网页爬虫库有哪些?

常用的python网页爬虫库有:抓取静态页面的Requests,处理动态JS网站的Selenium,以及适合大规模爬取的Scrapy。选择哪种库,主要看数据复杂度、并发需求和页面动态程度。

2. 如何抓取大量JavaScript动态网站?

对于JS动态网站,Selenium和Playwright是不错的选择,它们能模拟真实用户操作,加载动态内容。ZenRows也是好选择,API简单,自动处理JS和反爬机制,无需额外配置。

3. Thunderbit如何帮助企业高效网页爬取?

Thunderbit是一款无代码AI网页爬虫,业务用户无需编程即可采集网页数据。不论是竞品价格、获客线索还是商品信息,Thunderbit都能通过AI自动化、动态内容处理、反爬机制和多种导出方式,帮你两步完成数据采集。

了解更多: