还记得我第一次尝试从电商网站抓取商品数据的情景吗?那会儿我手里只有 Python、一杯咖啡,还有个小目标:做个亚马逊价格追踪器。结果几个小时过去,我的“简单项目”变成了满屏的 XPath 选择器、翻页难题,还有无数次的调试。只要你用代码抓过网页数据,肯定懂那种又兴奋又头大的感觉——“怎么会这么折腾?”

其实,网页爬虫早就不只是数据科学家或工程师的专属技能了。现在,销售、运营、电商经理、市场人员,甚至任何想把互联网信息变成商业洞察的人,都需要会用。根据,而且还在持续增长。虽然 Python 和 Scrapy 依然是大规模、定制化爬取的首选,但对新手来说门槛并不低。所以这篇教程,我会用亚马逊的真实案例,手把手带你入门 Scrapy——同时,也会介绍一个更简单、无需写代码的 AI 网页爬虫替代方案:。

什么是 Scrapy Python?你的网页爬虫神器

先来点基础知识。Scrapy 是专为网页爬取和数据抓取设计的开源 Python 框架。你可以把它当成一站式工具箱,用来搭建自定义“蜘蛛”(Scrapy 对爬虫的称呼),自动浏览网站、跟踪链接、处理翻页,还能批量提取结构化数据。

那 Scrapy 和 Python 的 requests、BeautifulSoup 有啥区别?简单说,后者适合小型、一次性的爬取,而 Scrapy 则专为大规模、复杂项目打造,比如:

- 批量爬取成千上万页面(比如整个电商商品库)

- 自动跟踪链接、处理多页数据

- 异步处理,速度飞快

- 数据结构化、清洗、导出一条龙

总之,Scrapy 就像网页爬虫界的瑞士军刀——功能强大、灵活,但对新手来说也有点“劝退”。

为什么用 Scrapy Python 做网页爬虫?

那为啥开发者和数据团队都爱用 Scrapy?简单总结下它的优势:

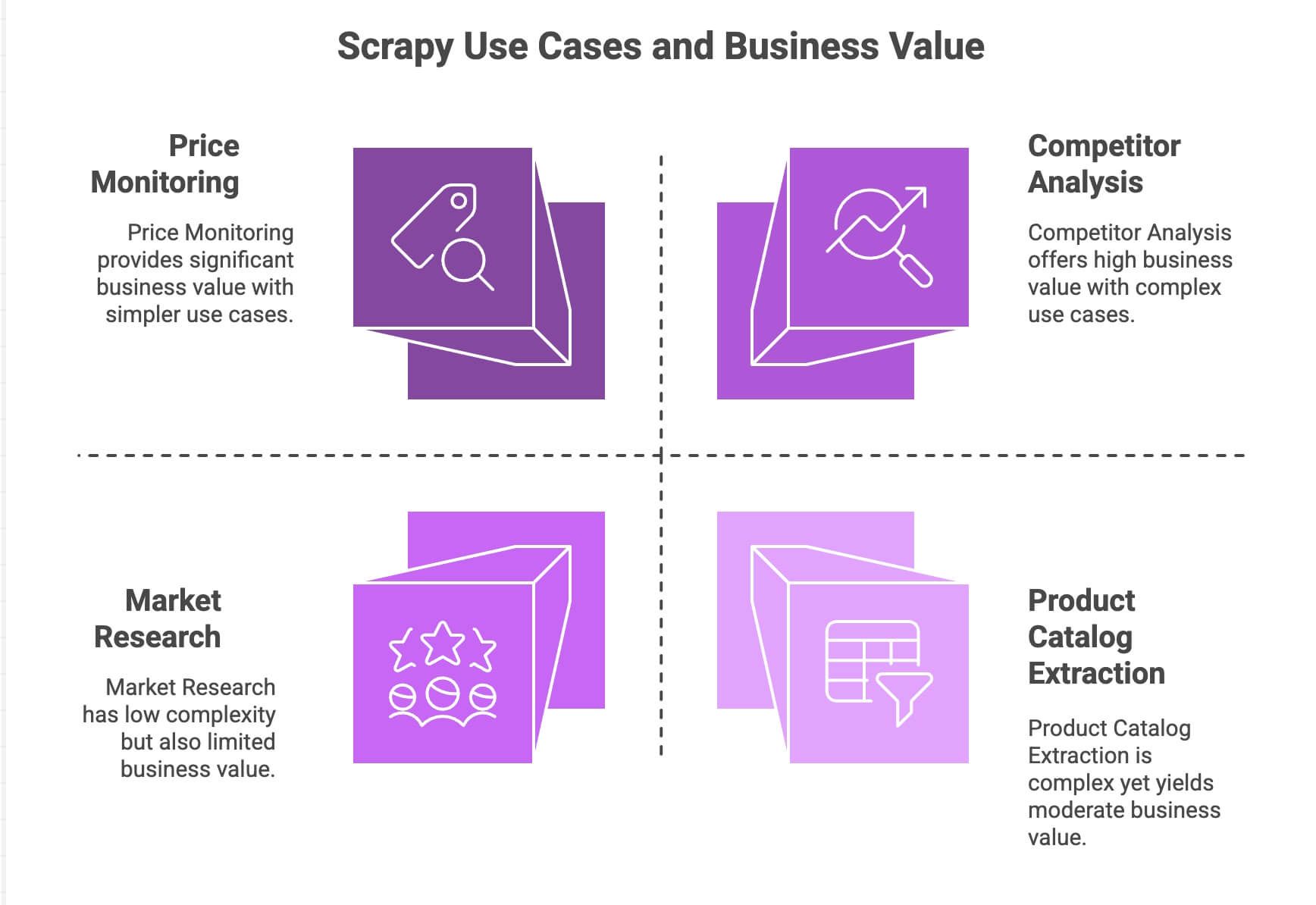

| 应用场景 | Scrapy 优势 | 业务价值 |

|---|---|---|

| 价格监控 | 自动翻页、异步请求、定时调度 | 抢先掌握市场动态,灵活定价 |

| 商品库采集 | 跟踪链接、结构化提取 | 构建商品数据库,助力数据分析 |

| 竞品分析 | 可扩展、抗网站结构变化 | 跟踪新品、库存、市场趋势 |

| 市场调研 | 模块化数据清洗与转换 | 聚合评论,情感分析 |

Scrapy 的异步引擎(基于 Twisted)让它能同时抓取多个页面,效率非常高。模块化设计支持自定义逻辑(比如代理、UA、数据清洗等)。通过管道(pipelines),你可以灵活处理、校验、导出数据,无论是 CSV、JSON 还是数据库都能轻松搞定。

如果你有 Python 基础,Scrapy 是生产力神器。但对大多数业务用户来说,入门门槛确实不低。

Scrapy Python 环境搭建

准备好动手了吗?下面是 Scrapy 的基础安装流程:

1. 安装 Scrapy

确保你已经装好 Python 3.9 及以上版本。然后在终端输入:

1pip install scrapy检查安装是否成功:

1scrapy version如果你用的是 Windows 或 Anaconda,建议先建个虚拟环境,避免依赖冲突。Scrapy 支持 Windows、macOS 和 Linux。

2. 创建 Scrapy 项目

新建一个叫 amazonscraper 的项目:

1scrapy startproject amazonscraper你会看到这样的目录结构:

1amazonscraper/

2├── scrapy.cfg

3├── amazonscraper/

4│ ├── __init__.py

5│ ├── items.py

6│ ├── pipelines.py

7│ ├── middlewares.py

8│ ├── settings.py

9│ └── spiders/这些文件都干嘛用?

scrapy.cfg:项目配置(基本不用动)items.py:定义数据结构(比如商品名、价格等)pipelines.py:数据清洗、校验、导出middlewares.py:进阶用法(比如代理、定制请求头)settings.py:调整 Scrapy 行为(并发、延迟等)spiders/:你的爬虫代码都放这里

如果你已经有点晕,其实很多非技术用户到这一步就开始头疼了。

实战:用 Scrapy 抓取亚马逊商品数据

我们来做个真实案例:抓取亚马逊搜索结果的商品信息。(友情提示:亚马逊禁止爬虫,且反爬很强,本文仅供学习参考!)

1. 创建 Spider

在 spiders/ 文件夹下新建 amazon_spider.py:

1import scrapy

2class AmazonSpider(scrapy.Spider):

3 name = "amazon_example"

4 allowed_domains = ["amazon.com"]

5 start_urls = ["https://www.amazon.com/s?k=smartphones"]

6 def parse(self, response):

7 products = response.xpath("//div[@data-component-type='s-search-result']")

8 for product in products:

9 yield {

10 'name': product.xpath(".//span[@class='a-size-medium a-color-base a-text-normal']/text()").get(),

11 'price': product.xpath(".//span[@class='a-price-whole']/text()").get(),

12 'rating': product.xpath(".//span[@aria-label]/text()").get()

13 }

14 next_page = response.xpath("//li[@class='a-last']/a/@href").get()

15 if next_page:

16 yield scrapy.Request(url=response.urljoin(next_page), callback=self.parse)这里做了什么?

- 从亚马逊“智能手机”搜索结果页开始

- 用 XPath 提取每个商品的名称、价格、评分

- 检查是否有“下一页”,有的话自动翻页继续抓取

2. 运行爬虫

在项目根目录下运行:

1scrapy crawl amazon_example -o products.jsonScrapy 会自动翻页抓取,并把数据保存为 JSON 文件。

处理翻页和动态内容

Scrapy 原生支持自动跟踪链接和翻页,这也是它的强项。但如果遇到 JavaScript 动态加载的内容(比如无限滚动、弹窗评论),Scrapy 默认只能看到静态 HTML。这时就需要结合 Selenium 或 Splash 等工具,难度会提升不少。

Scrapy Python 的数据处理与导出

数据抓取完,通常还需要清洗和导出:

- 管道(Pipelines): 在

pipelines.py里写 Python 类,做数据清洗、校验、补充(比如价格转数字、去除不完整数据、调用翻译 API 等) - 数据导出: Scrapy 支持用

-o参数直接导出 CSV、JSON、XML。想导入 Google Sheets 等,还需额外写代码或用第三方库。

如果你想做情感分析或自动翻译,也得自己集成外部 API 或 Python 库,Scrapy 并不自带这些功能。

隐形成本:Scrapy Python 对业务用户的挑战

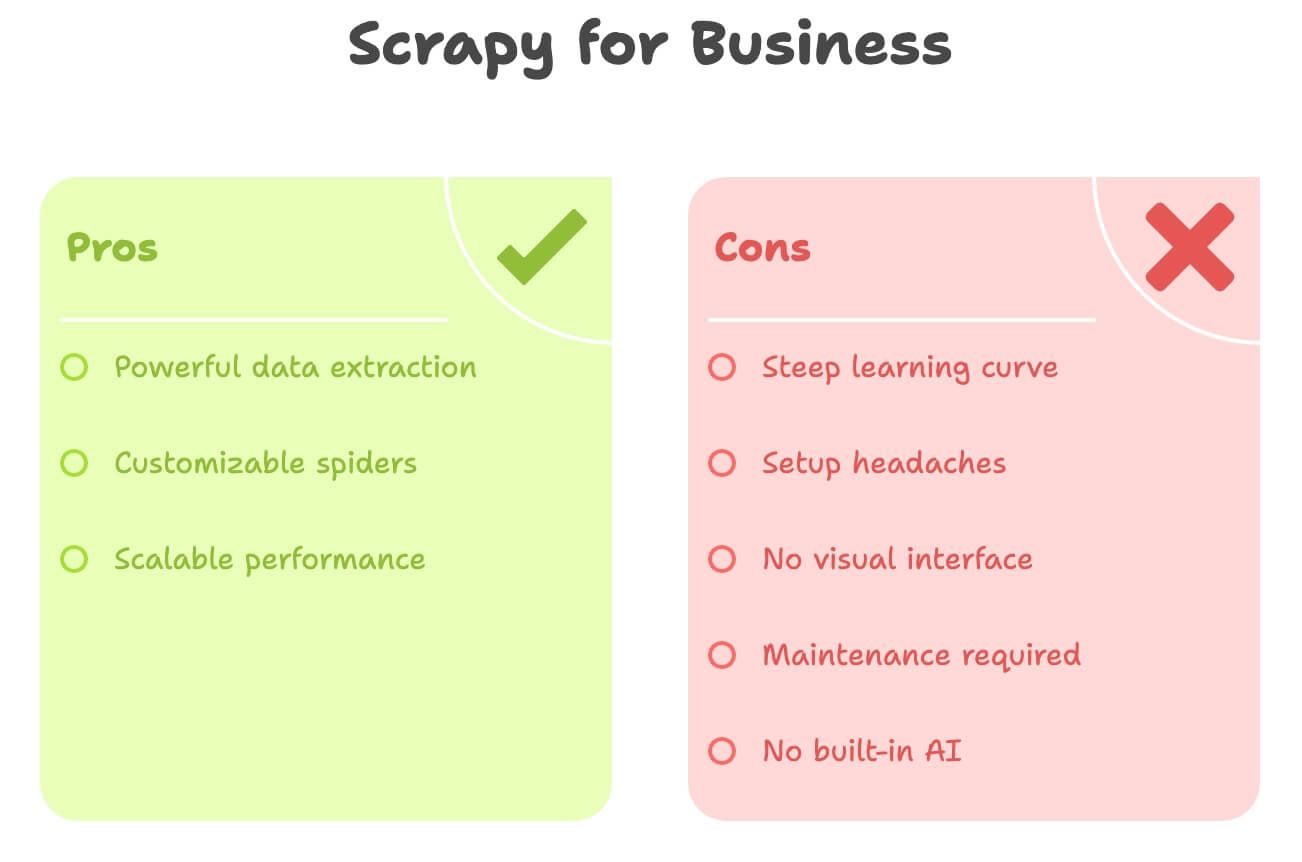

说实话,Scrapy 虽然强大,但对非开发者并不友好。常见难点有:

- 学习曲线陡峭: 需要懂 Python、HTML、XPath/CSS 选择器和 Scrapy 项目结构,上手周期长

- 环境配置繁琐: 安装 Python、管理依赖、排查报错,尤其在 Windows 下容易踩坑

- 无可视化界面: 全靠写代码,不能像点选那样直接抓取数据

- 维护成本高: 网站结构一变,爬虫就挂了,得自己修

- 无内置 AI 能力: 翻译、摘要、情感分析等都要自己写代码集成

简单对比一下:

| 难点 | Scrapy (Python) | 业务用户需求 |

|---|---|---|

| 是否需要写代码 | 需要 | 最好不用写代码 |

| 配置耗时 | 数小时甚至数天 | 几分钟即可上手 |

| 维护 | 持续维护(网站变动需改代码) | 维护极简 |

| 数据导出 | CSV/JSON(需手动导入 Excel/Sheets) | 直接导出到 Excel/Sheets/Notion |

| AI 能力 | 无(需自己集成) | 内置翻译/情感分析 |

如果你是市场、销售、运营等非技术岗位,Scrapy 就像用大炮打水漂,太重了。

Thunderbit:Scrapy Python 的零代码替代方案

这时, 就派上用场了。作为多年自动化工具开发者,我深知大多数业务用户并不想写代码——他们只想快速拿到数据。

Thunderbit 是一款AI 网页爬虫,以 Chrome 插件形式提供,专为非技术用户设计,支持:

- 几次点击即可抓取任意网站数据

- 用自然语言描述需求(比如“商品名、价格、评分”)

- 自动处理翻页和子页面

- 一键导出到 Excel、Google Sheets、Airtable 或 Notion

- 实时翻译、摘要、情感分析

无需 Python,无需选择器,无需维护。

Thunderbit 让业务用户高效获取数据,AI 自动搞定繁琐细节。

Thunderbit 与 Scrapy Python 对比

来看下两者的差异:

| 对比维度 | Scrapy (Python) | Thunderbit (AI 工具) |

|---|---|---|

| 所需技能 | Python、HTML、选择器 | 无需技术,点选+自然语言 |

| 上手时间 | 数小时(安装、写代码、调试) | 几分钟(装插件、登录) |

| 数据结构化 | 手动定义(items、pipelines) | AI 自动识别字段,智能推荐 |

| 翻页/子页面 | 需写代码 | 一键开启,AI 自动处理 |

| 翻译 | 需自定义代码或 API | 内置,直接切换“翻译” |

| 情感分析 | 需外部库/API | 内置,添加“情感”列即可 |

| 导出方式 | CSV/JSON(需手动导入) | 一键导出到 Excel、Sheets、Airtable、Notion |

| 维护 | 网站变动需手动改代码 | AI 自动适应小变动 |

| 适用规模 | 适合大规模、持续项目 | 适合快速任务、中小规模(数百/上千行) |

| 成本 | 免费(但耗时/需开发资源) | 免费版+付费(起步 $9/月,极省时间精力) |

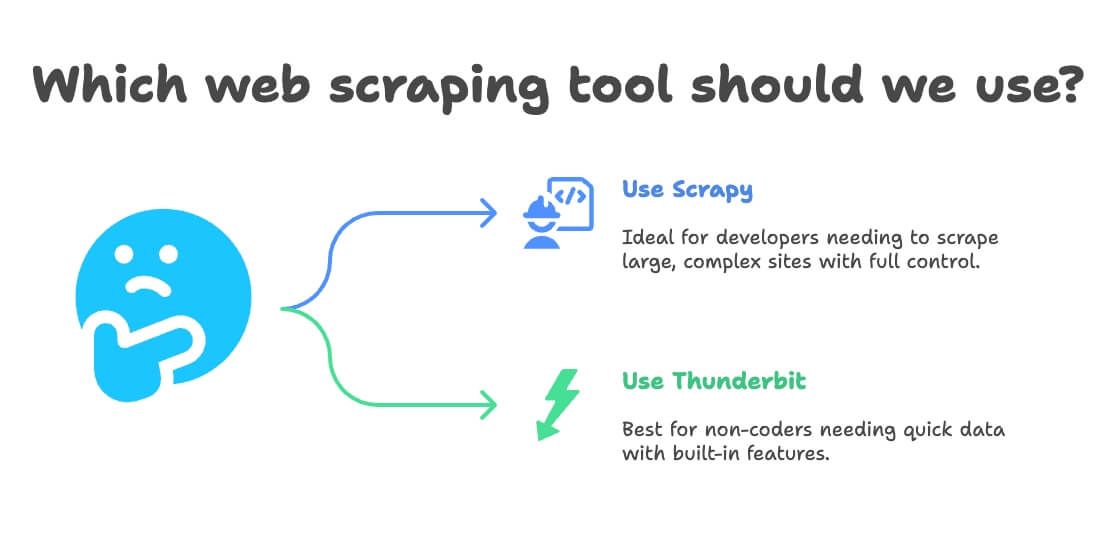

什么时候选 Scrapy Python,什么时候选 Thunderbit?

我的建议:

- 适合用 Scrapy 的场景:

- 你是开发者或有技术团队

- 需要抓取数万页面,或搭建长期定制化数据管道

- 网站结构复杂,需要高级逻辑

- 追求极致自定义,能接受维护成本

- 适合用 Thunderbit 的场景:

- 不会写代码,或不想写代码

- 需要快速获取数据,满足一次性或周期性业务需求

- 需要内置翻译、情感分析、数据增强

- 更看重效率和灵活性,而非极致定制

决策流程可以这样参考:

- 会 Python 吗?

- 会 → Scrapy 或 Thunderbit(快速搞定)

- 不会 → Thunderbit

- 项目规模大且长期吗?

- 是 → Scrapy

- 否 → Thunderbit

- 需要翻译或情感分析吗?

- 需要 → Thunderbit

- 不需要 → 都可以

实操演示:用 Thunderbit 无代码抓取亚马逊商品数据

我们再用亚马逊案例,这次用最简单的方法。

1. 安装 Thunderbit

- 注册账号(有免费版)

2. 打开亚马逊,搜索目标商品

- 进入 ,搜索“laptops”或任意商品

3. 启动 Thunderbit

- 点击浏览器中的 Thunderbit 图标

- 侧边栏会自动识别亚马逊页面

4. 使用 AI 智能字段推荐

- 点击 “AI 智能推荐字段”

- Thunderbit AI 扫描页面,自动推荐“商品名”、“价格”、“评分”、“评论数”等字段

- 可按需增删字段(比如“商品链接”、“Prime 是否可用”等,直接输入即可)

5. 开启翻页和子页面抓取

- 打开 翻页:Thunderbit 会自动点击“下一页”,抓取所有结果

- 打开 子页面抓取:Thunderbit 会进入每个商品详情页,采集更多信息(如描述、ASIN 编号等)

6. 开始抓取

- 点击 抓取

- Thunderbit 实时采集数据,自动翻页

7. 翻译与情感分析(可选)

- 想翻译商品描述?只需切换“翻译”

- 想分析评论情感?添加“情感”列,AI 自动填充

8. 导出数据

- 点击 导出

- 选择 Excel、Google Sheets、Airtable 或 Notion

- 数据即刻可用,无需手动导入或处理 CSV

9. 定时自动抓取(可选)

- 设置定时任务(比如每天早上 8 点)

- Thunderbit 会自动抓取并更新到指定位置

就是这么简单,无需写代码,无需维护,数据即刻到手。

实用技巧:让网页爬虫项目更高效

不管你用 Scrapy、Thunderbit 还是其他工具,下面这些经验都值得借鉴:

- 数据校验: 检查缺失或异常值(比如价格为 $0、商品名为空等)

- 合规合规再合规: 遵守网站服务条款,尊重

robots.txt,避免高频抓取 - 自动化要适度: 合理设置定时,保持数据新鲜,但别过度抓取

- 善用免费工具: Thunderbit 内置邮箱、电话、图片提取器,适合线索收集或内容整理

- 数据结构化: 直接导出到 Sheets/Excel,方便后续筛选、透视、可视化

更多实用技巧,欢迎访问 或查阅。

更多实用技巧,欢迎访问 或查阅。

总结:网页爬虫不再难,选对工具事半功倍

一句话总结:**Scrapy 是开发者的利器,但对大多数业务用户来说太重了。**如果你精通 Python,需要定制化、大规模爬虫,Scrapy 非常适合。但如果你追求高效、无需写代码、还想要内置翻译和情感分析, 会让你事半功倍。

我亲眼见证了 Thunderbit 为非技术团队节省了大量时间和精力。从“我想要这些数据”到“数据已在表格里”,只需几分钟,不再是几小时或几天。AI 智能字段、子页面抓取、一键导出等功能,让网页数据转化为商业洞察变得前所未有的简单。

下次你需要抓取商品数据、监控价格或整理线索时,不妨问问自己:你想写 Python,还是想直接拿到结果?试试 Thunderbit 免费版,感受网页爬虫的全新体验。

想了解更多?欢迎访问 、,或在 深入学习网页爬虫最佳实践。

延伸阅读:

免责声明:请确保你的网页爬虫行为符合网站条款及当地法律法规。如有疑问,建议咨询法律顾问——没人想因为一个表格收到律师函。

作者:Shuai Guan,Thunderbit 联合创始人兼 CEO。多年深耕 SaaS、自动化与 AI,只为让你少走弯路。