全世界都在热议各种话题,而这些讨论大多都集中在 Twitter(或者说 X,如果你跟进了它的改名)。,。对于企业、研究者,甚至任何想要洞察实时趋势、情绪或舆论的人来说,Twitter 数据简直就是一座宝藏。但问题来了:现在想获取这些数据,远没有以前那么简单。Twitter 的 API 越来越严格(而且价格不低),让不少人不得不另辟蹊径来获取所需数据。

这时候,Python 网页爬虫工具,比如 ,就成了救星。不管你是想自动化数据收集的开发者,还是只想为下次营销活动找点热门话题的“小白”,都能找到适合自己的解决方案。本文就带你看看,怎么用 Python 抓取 Twitter 数据(不用 API),怎么合规操作,以及 Thunderbit 如何让整个流程变得更轻松。

什么是 Twitter 数据抓取?为什么值得关注?

简单来说,Twitter 数据抓取就是直接从 Twitter 的公开网页(比如推文、用户资料、话题标签和趋势)收集信息,而不是通过官方 API。你可以手动复制粘贴,但更高效的方式当然是用自动化工具或脚本来搞定。

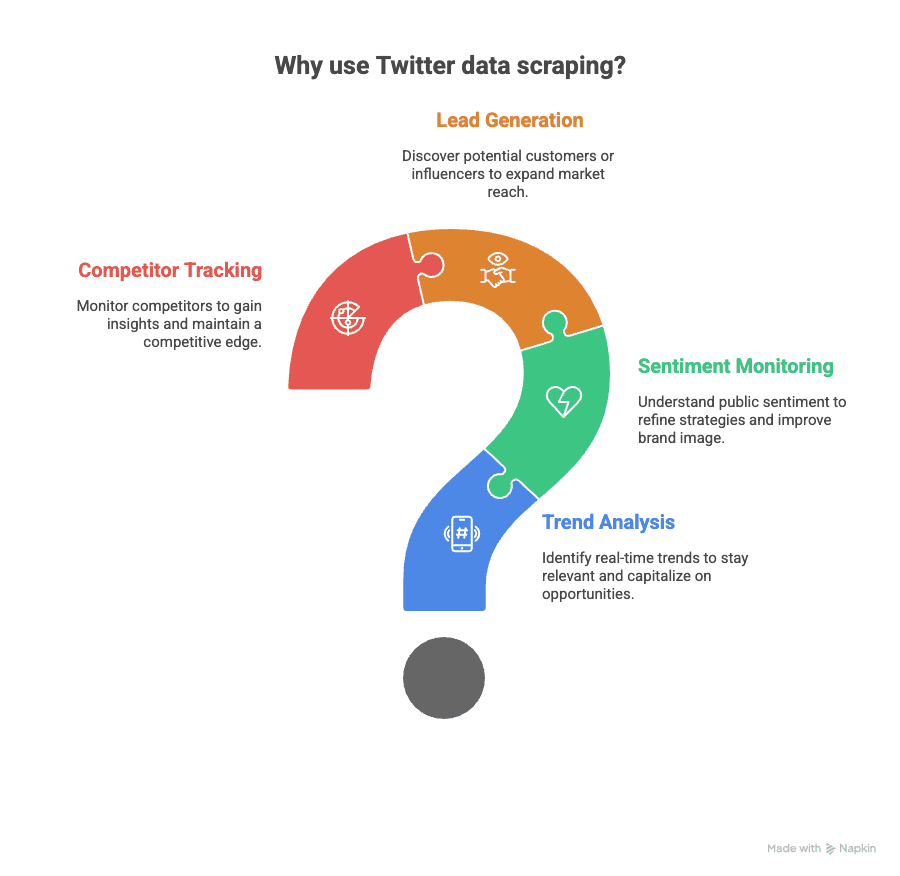

为什么这很重要?因为 Twitter 数据在商业和学术领域都能派上大用场:

- 趋势分析: 实时捕捉热点话题,从爆款梗到突发新闻都能第一时间掌握。

- 情感监测: 了解大众对产品、品牌或社会事件的态度。

- 潜在客户挖掘: 找到正在讨论你行业的潜在客户或关键影响者。

- 竞品追踪: 监控竞争对手的动态,以及外界对他们的评价。

以前, 是首选工具。但自 2024 年起,免费访问已经取消,哪怕是最基础的套餐,每月也可能要花几百甚至上千美元。API 还、采集速度,并且通常需要复杂的身份验证。

所以,不管是用 Python 还是无代码工具,网页爬虫已经成了想要更灵活、更广泛获取数据,或者想绕开 API 限制用户的新宠。

用 Python 爬取 Twitter:轻松绕过 API 限制

稍微技术一点说,用 Python 抓取 Twitter 数据,其实就是自动化浏览器访问 Twitter 页面,读取 HTML,然后提取你关心的信息。这样你就不用担心 API 配额,也不用为访问权限买单——只是在读取公开网页内容。

常用 Python Twitter 爬虫库

下面这些 Python 库都能帮你不用 API 抓取 Twitter:

- :适合解析静态 HTML,速度快、轻量,但对动态内容(比如无限滚动)支持有限。

- :可以自动化真实浏览器(比如 Chrome、Firefox),非常适合处理 Twitter 这种动态网站。能搞定 JavaScript、点击和滚动等操作。

- :新一代自动化工具,和 Selenium 类似,但速度更快、稳定性更高,特别适合现代 Web 应用。

用这些工具,你可以采集:

- 公开推文(文本、时间、点赞、转发数)

- 用户资料(简介、粉丝数、注册时间)

- 热门话题

- 话题标签和搜索结果

注意:你只能抓取公开网页上能看到的信息,私密账号和私信内容是无法获取的。

Python 爬虫库对比

优缺点一目了然:

| 库 | 适用场景 | 支持 JavaScript? | 速度 | 易用性 | 备注 |

|---|---|---|---|---|---|

| BeautifulSoup | 静态 HTML 解析 | 否 | 快 | 简单 | 适合配合 requests 抓取简单页面 |

| Selenium | 动态内容、界面操作 | 是 | 中等 | 中等 | 适合大量 JS 的网站 |

| Playwright | 现代动态网站 | 是 | 最快 | 中等 | 支持异步,比 Selenium 更稳定 |

对于大量动态加载和无限滚动的 Twitter,Selenium 和 Playwright 通常是更优选(参考 )。

合规抓取:怎么合法采集 Twitter 数据

在动手写 Python 脚本之前,先了解下合规要点:

- 遵守 Twitter 条款: 截至 2024 年,。但如果只是个人、研究或非商业目的,且只采集公开数据,通常是被默许的(但官方并不鼓励)。

- 避免高频访问: 每次请求间隔 2–5 秒,限制每小时采集页面数量,避免 24 小时不间断运行。这样能降低被识别为机器人或 IP 被封的风险(参考 )。

- 只抓取公开数据: 不要尝试访问私密账号、私信或绕过登录限制。

- 注意法律合规: 如果采集了个人信息(比如邮箱、姓名),要遵守 GDPR 等隐私法规,敏感信息要做匿名化或汇总处理。

更多合规建议可以参考 。

实操演练:用 Python 抓取 Twitter 数据的步骤

下面以 Selenium 为例,演示怎么抓取某个公开 Twitter 账号的推文。

1. 环境准备

先安装需要的库:

1pip install selenium pandas webdriver-manager2. 编写爬虫脚本

下面是一个简单的入门脚本:

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3from selenium.webdriver.chrome.service import Service

4from webdriver_manager.chrome import ChromeDriverManager

5import pandas as pd

6import time

7# 初始化浏览器驱动

8driver = webdriver.Chrome(service=Service(ChromeDriverManager().install()))

9# 访问目标 Twitter 主页(替换为你想抓取的账号)

10profile_url = '<https://twitter.com/nytimes>'

11driver.get(profile_url)

12time.sleep(5) # 等待页面加载

13# 滚动页面加载更多推文

14for _ in range(3): # 可调整加载更多推文

15 driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")

16 time.sleep(3)

17# 提取推文内容

18tweets = driver.find_elements(By.CSS_SELECTOR, '[data-testid="tweetText"]')

19tweet_texts = [tweet.text for tweet in tweets]

20# 提取时间戳

21timestamps = driver.find_elements(By.CSS_SELECTOR, 'time')

22tweet_times = [ts.get_attribute('datetime') for ts in timestamps]

23# 整理为 DataFrame

24df = pd.DataFrame({'Tweet': tweet_texts, 'Timestamp': tweet_times})

25# 导出为 Excel

26df.to_excel('twitter_scrape.xlsx', index=False)

27driver.quit()小贴士:

- 调整滚动次数可以采集更多推文。

- 还可以通过 CSS 选择器提取点赞、转发、评论数(参考 )。

- 如果脚本报错,可能是 Twitter 页面结构变了,需要更新选择器。

数据解析与导出

上面脚本已经支持导出 Excel,也可以:

1df.to_csv('twitter_scrape.csv', index=False)建议整理好列:推文内容、时间、用户名、点赞、转发、评论等,方便后续在 Excel、Google Sheets 或 Python 里分析。

Thunderbit:Twitter 数据抓取的无代码神器

如果你不会写代码,或者想节省时间, 就是你的理想选择。Thunderbit 是一款 AI 驱动的 Chrome 插件,只需几步点击就能抓取 Twitter 数据——不用 Python,不用配置,零门槛。

Thunderbit 抓取 Twitter 的流程

- 在 Chrome 浏览器打开 Twitter。

- 点击 Thunderbit 插件。

- 用自然语言描述需求: 比如“提取本页所有推文、日期和用户名”。

- AI 自动识别字段: Thunderbit 会扫描页面,智能推荐列(推文内容、时间、点赞等)。

- 点击抓取: Thunderbit 自动采集数据,支持子页面采集。

- 导出数据: 一键导出到 Excel、Google Sheets、Airtable、Notion 或 CSV,免费且即时。

Thunderbit 还提供,无需配置,直接分析。

为什么值得推荐? 你不用折腾代码、驱动或 CSS 选择器。Thunderbit 的 AI 能自动适应 Twitter 页面变化,还能在采集时对数据进行摘要、分类、翻译等智能处理(参考 )。