还记得我第一次用网页爬虫抓商业数据的场景吗?那会儿我坐在厨房餐桌边,一边喝咖啡,一边敲着还没写完的 Python 脚本,想从竞争对手网站扒点产品价格。当时我还挺自信:“这能有多难?”结果最后只导出了一堆空白的 CSV 表格,从此对那些说“用 Python 自动化很简单”的人肃然起敬。转眼到了 2025 年,网页爬虫已经成了数据驱动企业的标配——无论是销售、电商、市场还是运营团队,都靠它实时获取那些人工根本搞不定的信息。

但重点来了:虽然 Python 网页爬虫比以前更强大,整个行业也在悄然变革。网页爬虫市场正以惊人速度扩张——。几乎有 ,希望用数据做更聪明的决策。但真正的难点其实不是写代码,而是怎么选对工具、实现规模化、还能不被一堆脚本的维护拖垮。接下来这份终极指南,我会带你全面了解主流 Python 网页爬虫库(含代码示例)、真实商业场景,以及为什么虽然我很爱 Python,但对大多数企业来说, 这种无代码方案才是 2025 年的首选。

什么是 Python 网页爬虫?一听就懂的解释

简单来说,网页爬虫其实就是“自动化复制粘贴”。与其雇一堆实习生去收集产品价格、联系人或评论,不如用软件自动访问网页,提取你需要的数据,然后导出到表格或数据库。Python 网页爬虫,就是用 Python 脚本来完成这些工作——获取网页、解析 HTML、提取你关心的信息。

你可以把它想象成一个 24 小时不打烊的数字小助手,帮你逛遍全网。企业最常抓取的数据类型包括:价格信息、产品详情、联系人、评论、图片、新闻文章,甚至房产信息。虽然有些网站会提供 API,但大多数要么没有,要么限制一堆。这时候,网页爬虫就能帮你大规模获取公开数据,哪怕页面上没有“下载”按钮也不怕。

为什么 Python 网页爬虫对企业团队这么重要

说实话,到了 2025 年,如果你的企业还没用上网页爬虫,那真的可能已经错过不少机会。原因很简单:

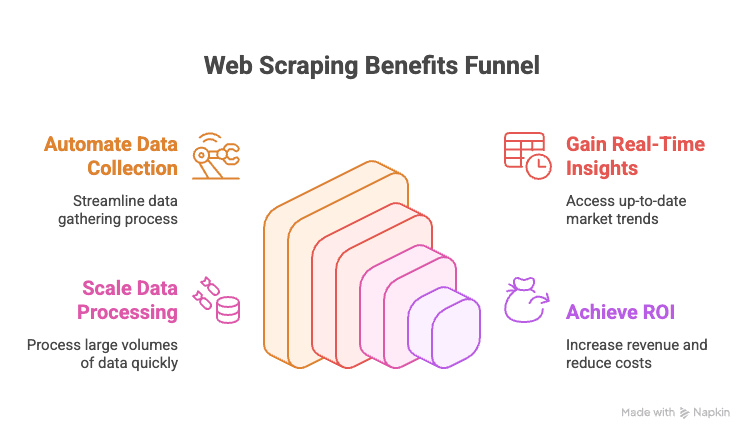

- 自动化数据采集: 再也不用手动从竞争对手网站或在线目录复制粘贴。

- 实时洞察: 随时掌握最新的价格、库存或市场动态。

- 高效扩展: 抓取上千个页面的速度,比你热个饭还快。

- 投资回报高: 数据驱动的企业。

下面这张表总结了各部门的高价值应用场景:

| Department | Use Case Example | Value Delivered |

|---|---|---|

| Sales | Scrape leads from directories, enrich with emails | Bigger, better-targeted lead lists |

| Marketing | Track competitor prices, promotions, reviews | Smarter campaigns, faster pivots |

| Ecommerce | Monitor product prices, stock, and reviews | Dynamic pricing, inventory alerts |

| Operations | Aggregate supplier data, automate reporting | Time savings, fewer manual errors |

| Real Estate | Collect property listings from multiple sites | More listings, faster client response |

总之,网页爬虫就是让企业决策更快、更聪明、更有竞争力的秘密武器。

全面盘点:主流 Python 网页爬虫库(含代码示例)

说到实操,下面带你系统梳理下 Python 网页爬虫生态。无论是简单页面下载,还是复杂的浏览器自动化,Python 都有对应的库。以下是主流工具及代码示例:

urllib 和 urllib3:基础 HTTP 请求

这是 Python 自带的 HTTP 请求工具,功能基础但稳定,适合简单任务。

1import urllib3, urllib3.util

2http = urllib3.PoolManager()

3headers = urllib3.util.make_headers(user_agent="MyBot/1.0")

4response = http.request('GET', "<https://httpbin.org/json>", headers=headers)

5print(response.status) # HTTP 状态码

6print(response.data[:100]) # 前 100 字节内容如果你想要零依赖或需要精细控制,可以用它。但大多数场景,requests 更友好。

requests:最受欢迎的 Python 网页爬虫库

如果 Python 爬虫有吉祥物,那一定是 requests。它简单、强大,能处理所有 HTTP 细节。

1import requests

2r = requests.get("<https://httpbin.org/json>", headers={"User-Agent": "MyBot/1.0"})

3print(r.status_code) # 200

4print(r.json()) # 解析后的 JSON 内容为什么这么受欢迎?它能自动管理 cookies、会话、重定向等,让你专注于数据本身。不过,requests 只负责获取 HTML,想要提取数据还需要配合 BeautifulSoup。

BeautifulSoup:简单易用的 HTML 解析与数据提取

BeautifulSoup 是解析 HTML 的首选,宽容、易上手,常与 requests 搭配使用。

1from bs4 import BeautifulSoup

2html = "<div class='product'><h2>Widget</h2><span class='price'>$19.99</span></div>"

3soup = BeautifulSoup(html, 'html.parser')

4title = soup.find('h2').text # "Widget"

5price = soup.find('span', class_='price').text # "$19.99"适合小型或中等项目,或者刚入门时使用。数据量大或查询复杂时,可以考虑 lxml。

lxml 和 XPath:高效强大的 HTML/XML 解析

如果你追求速度或想用 XPath(HTML/XML 查询语言),lxml 是不错的选择。

1from lxml import html

2doc = html.fromstring(page_content)

3prices = doc.xpath("//span[@class='price']/text()")XPath 能精准定位数据。lxml 性能高,但学习曲线比 BeautifulSoup 稍陡峭。

Scrapy:大规模网页爬取的框架

Scrapy 是大项目的利器,堪称网页爬虫界的 Django。

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["<http://quotes.toscrape.com/>"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 "text": quote.css("span.text::text").get(),

9 "author": quote.css("small.author::text").get(),

10 }Scrapy 支持异步请求、自动跟踪链接、数据管道、多格式导出。小脚本用它有点大材小用,但大规模爬取无可替代。

Selenium、Playwright、Pyppeteer:动态网页爬取

遇到用 JavaScript 加载数据的网站,就需要浏览器自动化。Selenium 和 Playwright 是主流选择。

Selenium 示例:

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3driver = webdriver.Chrome()

4driver.get("<https://example.com/login>")

5driver.find_element(By.NAME, "username").send_keys("user123")

6driver.find_element(By.NAME, "password").send_keys("secret")

7driver.find_element(By.ID, "submit-btn").click()

8titles = [el.text for el in driver.find_elements(By.CLASS_NAME, "product-title")]Playwright 示例:

1from playwright.sync_api import sync_playwright

2with sync_playwright() as p:

3 browser = p.chromium.launch(headless=True)

4 page = browser.new_page()

5 page.goto("<https://website.com>")

6 page.wait_for_selector(".item")

7 data = page.eval_on_selector(".item", "el => el.textContent")这些工具能处理人类能看到的所有内容,但速度比纯 HTTP 爬取慢。只有必要时才用。

MechanicalSoup、RoboBrowser、PyQuery、Requests-HTML:其他实用工具

-

MechanicalSoup:自动化表单提交和页面跳转,基于 Requests 和 BeautifulSoup。

1import mechanicalsoup 2browser = mechanicalsoup.StatefulBrowser() 3browser.open("<http://example.com/login>") 4browser.select_form('form#loginForm') 5browser["username"] = "user123" 6browser["password"] = "secret" 7browser.submit_selected() 8page = browser.get_current_page() 9print(page.title.text) -

RoboBrowser:类似 MechanicalSoup,但维护较少。

-

PyQuery:jQuery 风格的 HTML 解析。

1from pyquery import PyQuery as pq 2doc = pq("<div><p class='title'>Hello</p><p>World</p></div>") 3print(doc("p.title").text()) # "Hello" 4print(doc("p").eq(1).text()) # "World" -

Requests-HTML:集成 HTTP 请求、解析,甚至支持 JS 渲染。

1from requests_html import HTMLSession 2session = HTMLSession() 3r = session.get("<https://example.com>") 4r.html.render(timeout=20) 5links = [a.text for a in r.html.find("a.story-link")]

适合需要表单、CSS 选择器或轻量 JS 渲染的场景。

Asyncio 和 Aiohttp:加速大规模爬取

如果要抓取成百上千个页面,同步请求太慢。用 aiohttp 和 asyncio 可以并发爬取。

1import aiohttp, asyncio

2async def fetch_page(session, url):

3 async with session.get(url) as resp:

4 return await resp.text()

5async def fetch_all(urls):

6 async with aiohttp.ClientSession() as session:

7 tasks = [fetch_page(session, url) for url in urls]

8 return await asyncio.gather(*tasks)

9urls = ["<https://example.com/page1>", "<https://example.com/page2>"]

10html_pages = asyncio.run(fetch_all(urls))这种方式能同时抓取大量页面,大幅提升效率。

专用库:PRAW(Reddit)、PyPDF2 等

-

PRAW:用于通过 API 抓取 Reddit。

1import praw 2reddit = praw.Reddit(client_id='XXX', client_secret='YYY', user_agent='myapp') 3for submission in reddit.subreddit("learnpython").hot(limit=5): 4 print(submission.title, submission.score) -

PyPDF2:提取 PDF 文本。

1from PyPDF2 import PdfReader 2reader = PdfReader("sample.pdf") 3num_pages = len(reader.pages) 4text = reader.pages[0].extract_text() -

其他:还有 Instagram、Twitter、OCR(Tesseract)等专用库。只要你有特殊需求,基本都能找到对应的 Python 库。

对比表:主流 Python 爬虫库

| Tool / Library | Ease of Use | Speed & Scale | Best For |

|---|---|---|---|

| Requests + BeautifulSoup | Easy | Moderate | Beginners, static sites, quick scripts |

| lxml (with XPath) | Moderate | Fast | Large-scale, complex parsing |

| Scrapy | Hard | Very Fast | Enterprise, big crawls, pipelines |

| Selenium / Playwright | Moderate | Slow | JavaScript-heavy, interactive sites |

| aiohttp + asyncio | Moderate | Very Fast | High-volume, mostly static pages |

| MechanicalSoup | Easy | Moderate | Login, forms, session management |

| PyQuery | Moderate | Fast | CSS-selector fans, DOM manipulation |

| Requests-HTML | Easy | Variable | Small jobs, light JS rendering |

实战演练:如何用 Python 构建网页爬虫(含示例)

下面以抓取某电商网站的产品列表为例,演示如何处理分页并导出为 CSV。

1import requests

2from bs4 import BeautifulSoup

3import csv

4base_url = "<https://example.com/products>"

5page_num = 1

6all_products = []

7while True:

8 url = base_url if page_num == 1 else f"{base_url}/page/{page_num}"

9 print(f"Scraping page: {url}")

10 response = requests.get(url, timeout=10)

11 if response.status_code != 200:

12 print(f"Page {page_num} returned status {response.status_code}, stopping.")

13 break

14 soup = BeautifulSoup(response.text, 'html.parser')

15 products = soup.find_all('div', class_='product-item')

16 if not products:

17 print("No more products found, stopping.")

18 break

19 for prod in products:

20 name_tag = prod.find('h2', class_='product-title')

21 price_tag = prod.find('span', class_='price')

22 name = name_tag.get_text(strip=True) if name_tag else "N/A"

23 price = price_tag.get_text(strip=True) if price_tag else "N/A"

24 all_products.append((name, price))

25 page_num += 1

26print(f"Collected {len(all_products)} products. Saving to CSV...")

27with open('products_data.csv', 'w', newline='', encoding='utf-8') as f:

28 writer = csv.writer(f)

29 writer.writerow(["Product Name", "Price"])

30 writer.writerows(all_products)

31print("Data saved to products_data.csv")这里做了什么?

- 循环遍历页面,获取 HTML,解析产品信息,收集名称和价格,直到没有新产品为止。

- 最后将结果导出为 CSV,方便后续分析。

想导出到 Excel?用 pandas 就行:

1import pandas as pd

2df = pd.DataFrame(all_products, columns=["Product Name", "Price"])

3df.to_excel("products_data.xlsx", index=False)处理表单、登录和会话

很多网站需要登录或表单提交。可以这样做:

用 requests 管理会话:

1session = requests.Session()

2login_data = {"username": "user123", "password": "secret"}

3session.post("<https://targetsite.com/login>", data=login_data)

4resp = session.get("<https://targetsite.com/account/orders>")用 MechanicalSoup:

1import mechanicalsoup

2browser = mechanicalsoup.StatefulBrowser()

3browser.open("<http://example.com/login>")

4browser.select_form('form#login')

5browser["user"] = "user123"

6browser["pass"] = "secret"

7browser.submit_selected()会话能帮你保持登录状态,方便批量抓取。

动态内容和 JS 渲染页面的爬取

如果数据不在 HTML 里(查看源代码发现是空的),就需要用浏览器自动化。

Selenium 示例:

1from selenium.webdriver.support.ui import WebDriverWait

2from selenium.webdriver.support import expected_conditions as EC

3driver.get("<http://examplesite.com/dashboard>")

4WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.ID, 'stats-table')))

5html = driver.page_source或者,直接找到 JS 调用的 API,用 requests 获取 JSON,速度更快。

数据导出:CSV、Excel、数据库等

-

CSV: 用 Python 的

csv模块(见上文)。 -

Excel: 用 pandas 或 openpyxl。

-

Google Sheets: 用

gspread库。1import gspread 2gc = gspread.service_account(filename="credentials.json") 3sh = gc.open("My Data Sheet") 4worksheet = sh.sheet1 5worksheet.clear() 6worksheet.append_row(["Name", "Price"]) 7for name, price in all_products: 8 worksheet.append_row([name, price]) -

数据库: SQL 用

sqlite3、pymysql、psycopg2或 SQLAlchemy,NoSQL 用pymongo。

Python 网页爬虫 vs. 现代无代码方案:2025 年为什么 Thunderbit 更适合企业

说到这里,必须提一下“维护”这个大坑。自己写爬虫很酷,直到你要同时抓 100 个不同网站,每个都有自己的小毛病,而且它们总是在你要交报告的前夜集体崩溃。亲身经历,头发都白了。

这也是我极力推荐 的原因。2025 年,企业用户首选它的理由有:

- 无需写代码: Thunderbit 提供可视化界面。点击“AI 智能识别字段”,调整列,点“抓取”就搞定。无需 Python,无需调试,也不用刷 Stack Overflow。

- 轻松扩展到上万页面: 想抓 1 万条产品?Thunderbit 云端引擎帮你搞定,无需盯着脚本跑。

- 零维护压力: 如果你要监控 100 个电商竞争对手,维护 100 个 Python 脚本简直噩梦。用 Thunderbit,只需选模板或微调,AI 会自动适应页面变化。

- 支持子页面和分页: Thunderbit 能自动跟进子页面、处理分页,甚至能访问每个产品详情页补充数据。

- 一键模板: 针对热门网站(如 Amazon、Zillow、LinkedIn 等)有现成模板,一键获取数据。

- 免费数据导出: 可导出到 Excel、Google Sheets、Airtable 或 Notion,无需额外付费。

简单说,如果你只想要数据,Thunderbit 就像你的专属数据管家。如果你喜欢折腾,Python 依然是乐园——但有时候,效率才是王道。

Python 网页爬虫的合规与道德最佳实践

网页爬虫很强大,但也要负责任。如何合法合规地抓取数据?

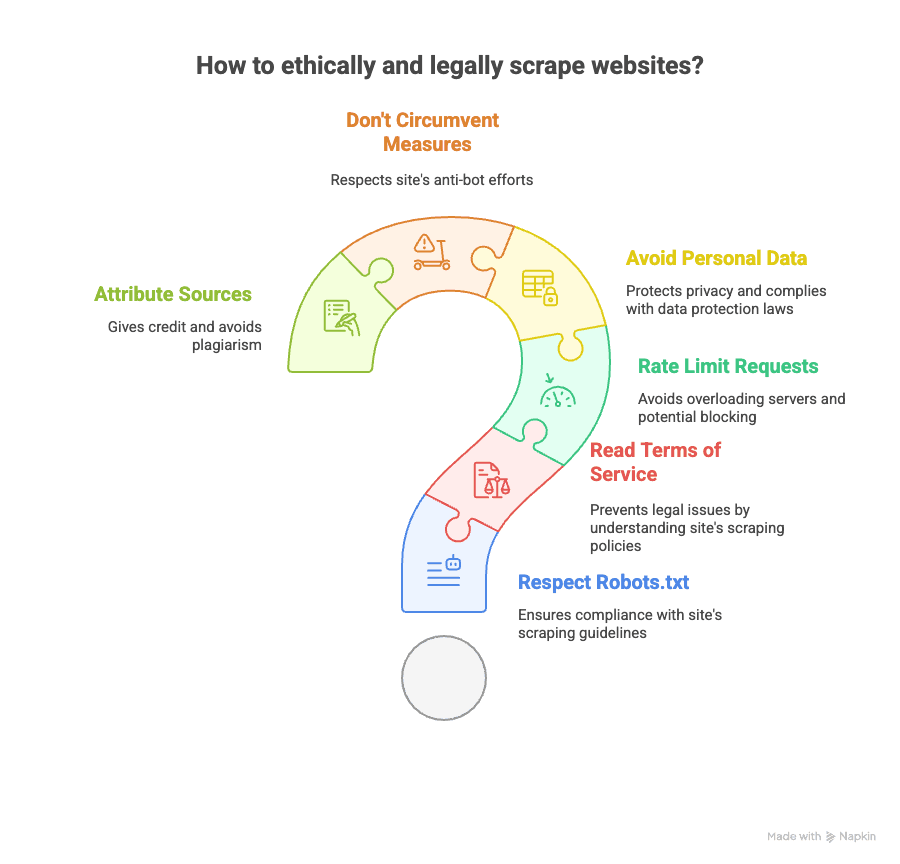

- 查看 robots.txt: 尊重网站允许抓取的范围。

- 阅读服务条款: 有些网站明令禁止爬虫,违规可能被封号甚至被起诉。

- 限速抓取: 不要高频请求,适当加延时。

- 避免抓取个人信息: 邮箱、手机号等涉及隐私的数据要谨慎,注意 GDPR、CCPA 等法规。

- 不要绕过反爬措施: 如果遇到验证码或强力封锁,建议三思。

- 注明数据来源: 公开分析时请标注数据出处。

想了解更多法律细节,可参考 和 。

进阶学习资源推荐(课程、文档、社区)

想深入学习?这里有我精选的优质资源:

- 官方文档:

- 书籍推荐:

- 《Web Scraping with Python》Ryan Mitchell 著

- 《用 Python 自动化办公》Al Sweigart 著

- 在线教程:

- 视频教程:

- Corey Schafer 的 YouTube 频道

- 技术社区:

当然,如果你想体验无代码爬虫,欢迎关注 或 。

总结与建议:2025 年如何选择合适的网页爬虫方案

- Python 网页爬虫 功能强大且灵活。如果你喜欢编程、追求极致控制力,并不介意维护工作,这是很棒的选择。

- 针对不同需求,Python 有丰富的库可选——无论是静态页面、动态内容、表单、API 还是 PDF。

- 但对大多数企业用户来说,维护一堆脚本实在太累。 如果你想高效、批量、无门槛地获取数据, 是更优解。

- Thunderbit 的 AI 无代码界面,让你几步就能抓取任意网站,支持子页面、分页,数据导出也很方便——无需 Python。

- 合规与道德同样重要: 一定要遵守网站政策,尊重隐私,负责任地抓取数据。

无论你是 Python 老手,还是只想轻松拿到数据,2025 年的工具都比以往更好。我的建议?两种方式都试试,找到最适合你的工作流,让机器人帮你搞定繁琐任务——但记得让它们“有礼貌”。

如果你厌倦了修修补补的脚本,不妨试试 。你的未来自己(还有咖啡库存)一定会感谢你。

想了解更多?可以阅读 或 ,获取实操指南和最新策略。