还记得我刚入行做 SaaS 和自动化那会儿,“网页爬虫”这词听起来就像是周末无聊的蜘蛛在网上溜达。现在,网页爬虫已经成了 Google 搜索、比价网站等平台的核心技术。互联网就像个不断进化的巨型生物,无论是技术宅还是销售小伙伴,都想从中挖到有用的数据。虽然 Python 让网页爬虫开发变得简单不少,但大多数人其实只想拿到数据,根本不想去研究什么 HTTP 协议、JavaScript 渲染这些技术细节。

故事的转折点就在这里。作为 的联合创始人,我亲眼见证了各行各业对网页数据需求的爆发式增长。销售团队需要最新的客户线索,电商运营想要实时监控竞品价格,市场人员则关注内容和趋势。但并不是每个人都愿意(或有时间)成为 Python 高手。那么,python 网页爬虫到底是什么?它为何重要?AI 工具如 Thunderbit 又如何让企业用户和开发者都能轻松获取数据?下面我们一探究竟。

Python 网页爬虫:是什么?为什么重要?

先来澄清一个常见误区:网页爬虫和网页爬虫(Web Scraper)其实不是一回事。虽然很多人会混用这两个词,但它们的分工就像扫地机器人和吸尘器——都能清理,但方式完全不同。

- 网页爬虫更像是互联网的侦查兵,负责系统性地发现和索引网页,沿着链接一页页地爬行——比如 Googlebot 就是在为整个网络绘制地图。

- 网页爬虫则像经验丰富的采集者,专门提取网页上的特定数据,比如商品价格、联系方式或文章内容。

当大家说“网页爬虫 python”,通常指的是用 Python 写自动化机器人,遍历甚至采集网页数据。Python 之所以成了首选,是因为它简单易学、生态丰富,而且——说实话——没人愿意用汇编写爬虫。

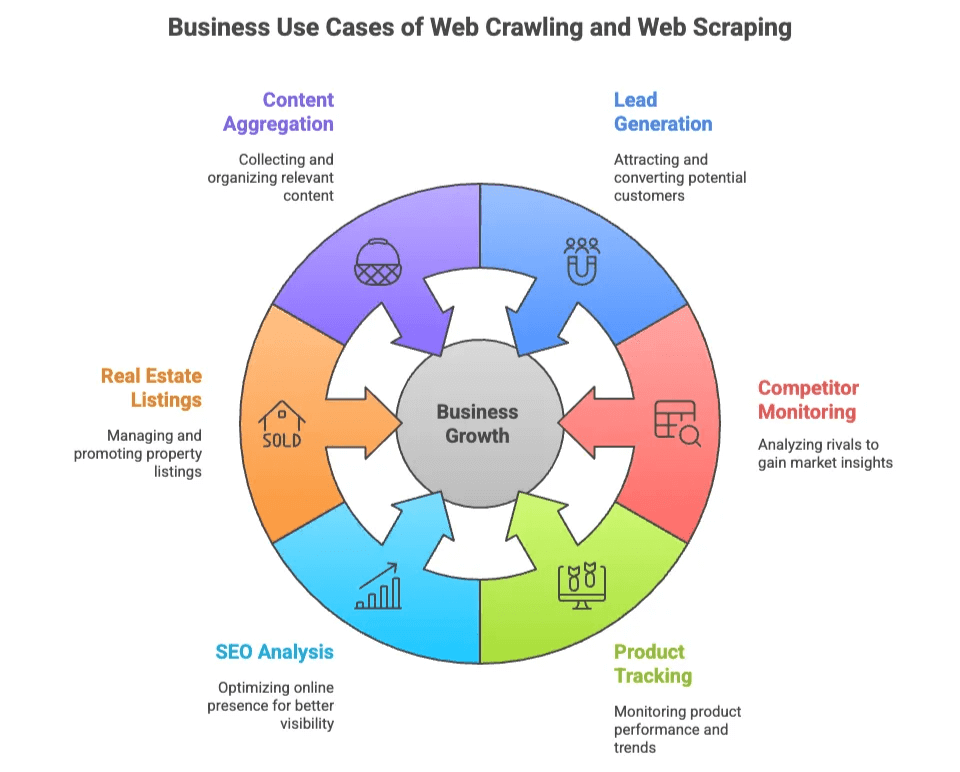

网页爬虫与网页爬虫的商业价值

为什么这么多团队关注网页爬虫和网页数据采集?因为网页数据就是新时代的“石油”——而且你不用钻井,只要写点代码(或者,点几下按钮)。

以下是常见的商业应用场景:

| 应用场景 | 需求方 | 带来的价值 |

|---|---|---|

| 潜在客户挖掘 | 销售、市场 | 从目录、社交网站批量获取目标客户名单 |

| 竞品监控 | 电商、运营 | 实时追踪竞品价格、库存和新品 |

| 商品追踪 | 电商、零售 | 监控商品目录变动、评论和评分 |

| SEO 分析 | 市场、内容 | 分析关键词、元标签和外链,优化排名 |

| 房产信息聚合 | 中介、投资人 | 整合多平台房源及业主联系方式 |

| 内容聚合 | 研究、媒体 | 收集文章、新闻或论坛帖子,洞察趋势 |

不管是技术团队还是业务部门都能从中受益。开发者可以定制深度爬虫,业务用户则希望快速、准确地拿到数据——最好不用了解什么是 CSS 选择器。

Python 主流网页爬虫库:Scrapy、BeautifulSoup 和 Selenium

Python 在网页爬虫领域的火爆不是偶然,三大主流库各有特色,也各有粉丝。

| 库名称 | 易用性 | 速度 | 动态内容支持 | 可扩展性 | 适用场景 |

|---|---|---|---|---|---|

| Scrapy | 中等 | 快 | 有限 | 高 | 大规模自动化爬取 |

| BeautifulSoup | 简单 | 中等 | 无 | 低 | 小型项目、简单解析 |

| Selenium | 较难 | 慢 | 优秀 | 低-中 | JS 动态、交互性强的页面 |

下面详细说说各自的特点。

Scrapy:全能型 Python 网页爬虫框架

Scrapy 就像 Python 爬虫界的瑞士军刀,专为大规模自动化爬取设计——比如同时抓取成千上万页面、并发请求、数据导出等。

开发者喜欢它的原因:

- 集爬取、解析、数据导出于一体。

- 内置并发、调度、数据管道等功能。

- 适合需要大规模爬取和采集的项目。

但…… Scrapy 上手有门槛。正如一位开发者所说,如果只是抓几页数据,Scrapy 可能有点“大材小用” ()。你需要理解选择器、异步处理,甚至代理和反爬机制。

Scrapy 基本流程:

- 定义 Spider(爬虫逻辑)。

- 配置数据管道(处理数据)。

- 启动爬取并导出数据。

如果你要像 Google 一样全网爬取,Scrapy 是好帮手;如果只是想抓个邮箱列表,可能有点“杀鸡用牛刀”。

BeautifulSoup:轻量级网页解析利器

BeautifulSoup 是网页解析的“入门神器”,专注于解析 HTML 和 XML,适合新手或小型项目。

受欢迎的原因:

- 学习曲线极低,上手快。

- 适合静态页面的数据提取。

- 灵活,适合快速脚本开发。

但…… BeautifulSoup 只负责解析,不负责爬取。你需要配合 requests 等库获取网页,还要自己写逻辑处理翻页、跟踪链接 ()。

如果你刚接触网页爬虫,BeautifulSoup 是不错的起点。但它不支持 JS 渲染,也不适合大规模项目。

Selenium:动态页面与 JS 内容的终极利器

Selenium 是浏览器自动化的王者。它能操控 Chrome、Firefox、Edge,模拟点击、填写表单,甚至渲染 JavaScript 动态内容。

强大之处:

- 能像真人一样“看见”并操作网页。

- 支持动态内容和 AJAX 数据加载。

- 必不可少于需要登录或模拟用户操作的场景。

但…… Selenium 速度慢、资源消耗大。每爬一页都要启动完整浏览器,大规模爬取时容易拖垮系统 ()。维护也麻烦——要管理浏览器驱动,还要等待动态内容加载。

如果你要爬的站点对普通爬虫“铜墙铁壁”,Selenium 就是你的秘密武器。

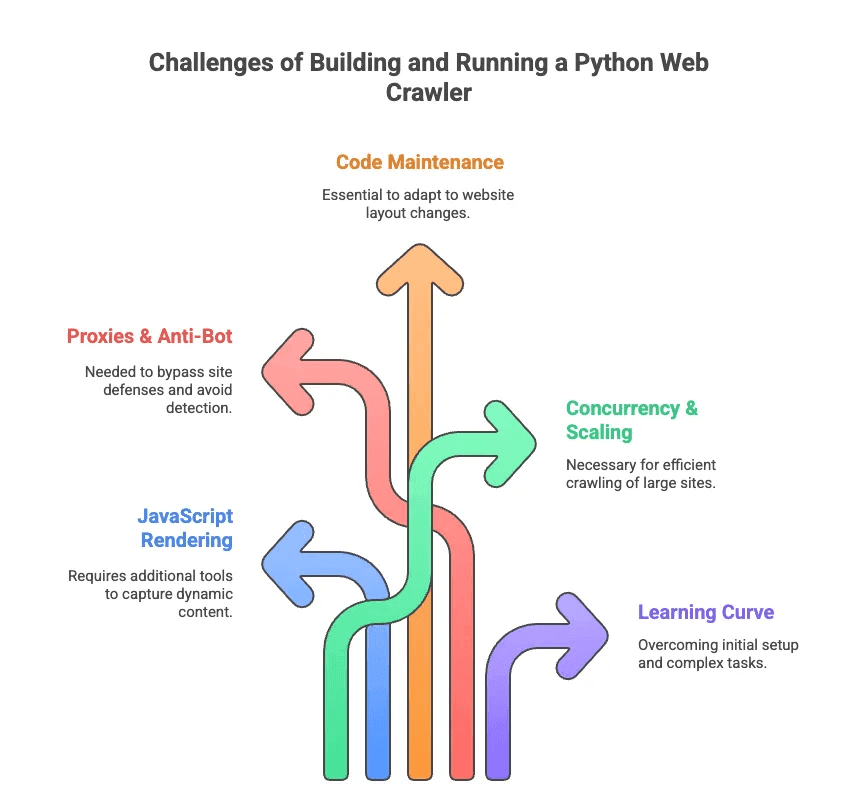

用 Python 写网页爬虫的常见挑战

说完优点,也得聊聊“坑”。我曾花无数时间调试选择器、对抗反爬机制。主要难点有:

- JavaScript 渲染: 现在的网站很多内容都是动态加载的,Scrapy 和 BeautifulSoup 直接看不到,得用额外工具。

- 代理与反爬: 很多网站不欢迎爬虫,需要轮换代理、伪装浏览器、甚至破解验证码。

- 代码维护: 网站结构经常变动,爬虫脚本容易失效,需要频繁更新选择器和逻辑。

- 并发与扩展: 大规模爬取要处理异步请求、错误重试、数据管道等。

- 学习门槛: 对非开发者来说,光是配置 Python 环境就够头疼,更别说分页、登录等复杂流程。

有工程师调侃,写自定义爬虫有时候像是在“考选择器博士”——这可不是普通销售或市场人员想要的体验 ()。

AI 网页爬虫 vs. Python 网页爬虫:面向业务用户的新选择

如果你只想要数据,不想折腾技术?那就试试 AI 网页爬虫。这类工具(比如 )专为业务用户设计,无需写代码。AI 会自动识别网页内容、推荐提取字段,后台还会自动处理分页、子页面、反爬等繁琐细节。

简单对比一下:

| 功能 | Python 网页爬虫 | AI 网页爬虫(Thunderbit) |

|---|---|---|

| 搭建方式 | 代码、库、配置 | 两步安装 Chrome 插件 |

| 维护 | 手动更新、调试 | AI 自动适应网页变化 |

| 动态内容 | 需 Selenium 或插件 | 内置浏览器/云端渲染 |

| 反爬处理 | 代理、伪装 | AI+云端自动绕过 |

| 扩展性 | 高(需投入) | 高(云端并发爬取) |

| 易用性 | 面向开发者 | 人人可用 |

| 数据导出 | 需写代码 | 一键导出到 Sheets、Airtable、Notion |

用 Thunderbit,你不用管 HTTP 请求、JS 渲染或代理。只需点击“AI 智能识别字段”,AI 自动分析页面结构,点“抓取”就行。就像请了个专属数据助理——而且不用发工资。

Thunderbit:人人可用的下一代 AI 网页爬虫

具体来说,Thunderbit 是一款 ,让网页数据采集像点外卖一样简单。它的亮点包括:

- AI 智能字段识别: Thunderbit 的 AI 能自动读取页面,推荐要提取的字段(列),不用再猜 CSS 选择器 ()。

- 动态页面支持: 不管是静态还是 JS 动态页面,都能轻松搞定,支持浏览器和云端双模式爬取。

- 子页面与分页: 需要每个商品或用户详情?Thunderbit 能自动点击子页面并采集详细信息 ()。

- 模板自适应: 一个爬虫模板能适配多种页面结构,网站改版也不用重建。

- 反爬绕过: AI+云端架构,轻松突破常见反爬机制。

- 数据导出: 数据可直接导入 Google Sheets、Airtable、Notion,或下载为 CSV/Excel——免费版也不设导出门槛 ()。

- AI 数据清洗: 支持数据自动摘要、分类、翻译,告别杂乱表格。

实际应用举例:

- 销售团队 可以几分钟内批量采集目录或领英上的客户名单。

- 电商运营 无需手动监控竞品价格和商品变动。

- 房产中介 能整合多平台房源和业主联系方式。

- 市场团队 能分析内容、关键词和外链,助力 SEO——全程不用写代码。

Thunderbit 的操作简单到连我身边不懂技术的朋友都能用——而且他们真的在用。只需安装插件,打开目标网站,点“AI 智能识别字段”,马上就能开始采集。对于 Amazon、LinkedIn 等热门网站,还有现成模板,一键即可用 ()。

什么时候用 Python 网页爬虫,什么时候选 AI 网页爬虫?

那到底什么时候该自己写 python 网页爬虫,什么时候直接用 Thunderbit?我的建议如下:

| 场景 | Python 网页爬虫 | AI 网页爬虫(Thunderbit) |

|---|---|---|

| 需要自定义逻辑或超大规模 | ✔️ | 视情况(云端模式) |

| 深度集成到其他系统 | ✔️(需开发) | 有限(通过导出) |

| 非技术用户、追求效率 | ❌ | ✔️ |

| 网站频繁改版 | ❌(需手动维护) | ✔️(AI 自动适应) |

| 动态/JS 页面 | ✔️(配合 Selenium) | ✔️(内置支持) |

| 预算有限、小型项目 | 视情况(免费但耗时) | ✔️(免费版无门槛) |

适合用 Python 爬虫的情况:

- 你是开发者,需要完全自定义。

- 需要大规模爬取或自建数据管道。

- 能接受持续维护和调试。

适合用 Thunderbit 的情况:

- 你想立刻拿到数据,不想花一周写代码。

- 你是销售、电商、市场或房产从业者,只关心结果。

- 不想折腾代理、选择器或反爬机制。

还拿不定主意?可以参考:

- 熟悉 Python 和网页技术?可以试试 Scrapy 或 Selenium。

- 只想快速、干净地拿到数据?Thunderbit 更适合你。

总结:用对工具,轻松解锁网页数据

在数据驱动的时代,网页爬虫和网页数据采集已经成了必备技能。但说实话,并不是每个人都想成为爬虫专家。Scrapy、BeautifulSoup、Selenium 等 Python 工具功能强大,但学习和维护成本不低。

这也是我对 AI 网页爬虫(比如 )充满期待的原因。我们做 Thunderbit,就是希望让每个人都能轻松获取网页数据。AI 智能识别字段、动态页面支持、零代码操作,让任何人都能在几分钟内完成数据采集。

无论你是喜欢折腾代码的开发者,还是只想拿到数据的业务用户,总有一款工具适合你。评估自己的需求、技术水平和时间成本。如果想体验网页数据采集的极致便捷,——你的未来自己(和表格)都会感谢你。

想深入了解?欢迎阅读 的更多指南,比如 或 。祝你爬虫顺利,数据满满!

常见问题

1. Python 网页爬虫和网页爬虫有何区别?

Python 网页爬虫主要用于系统性地遍历和索引网页,沿着超链接发现网站结构,适合大范围数据发现。而网页爬虫则专注于提取页面上的特定数据,比如价格或邮箱。爬虫负责“扫街”,爬虫负责“采集”。在 Python 生态中,两者常常结合使用,实现端到端的数据采集。

2. 构建网页爬虫,Python 有哪些主流库?

常用的有 Scrapy、BeautifulSoup 和 Selenium。Scrapy 适合大规模、自动化项目;BeautifulSoup 上手简单,适合静态页面;Selenium 擅长处理 JS 动态页面,但速度较慢。选择哪种工具,取决于你的技术水平、内容类型和项目规模。

3. 有不用写 Python 网页爬虫也能采集网页数据的简单方法吗?

当然有——Thunderbit 是一款 AI 驱动的 Chrome 插件,人人都能两步采集网页数据,无需写代码、无需配置。它能自动识别字段,处理分页和子页面,并一键导出到 Sheets、Airtable 或 Notion。非常适合销售、市场、电商或房产团队,快速获得干净数据。

了解更多: