2025 年的互联网就像一片充满未知的荒野——上一秒你还在盯着竞争对手的价格,下一秒就被动态 JavaScript 和反爬虫机制绕得头晕。作为一个长期为销售和运营团队开发自动化工具的从业者,我可以很负责任地说:网页爬虫早就不是“可有可无”的技能,而是企业的核心竞争力。现在, 都靠数据分析做决策,网络数据量在短短四年里暴涨了 。能不能把杂乱的网页内容变成有价值的洞察,直接决定了企业能不能跑在前面。

但现实很骨感:网页爬虫早已不是几行 Python 代码就能搞定的事。静态 HTML 时代一去不复返,现在你要面对动态内容、无限滚动,还有让特工都头疼的反爬虫机制。不管你是刚入门的小白,还是想升级技术栈的老司机,这份指南都会带你系统掌握 2025 年 Python 网页爬虫的最佳实践、工具和工作流,还会教你怎么用 这样的 AI 工具让项目提速。

从入门到进阶:Python 网页爬虫的底层逻辑

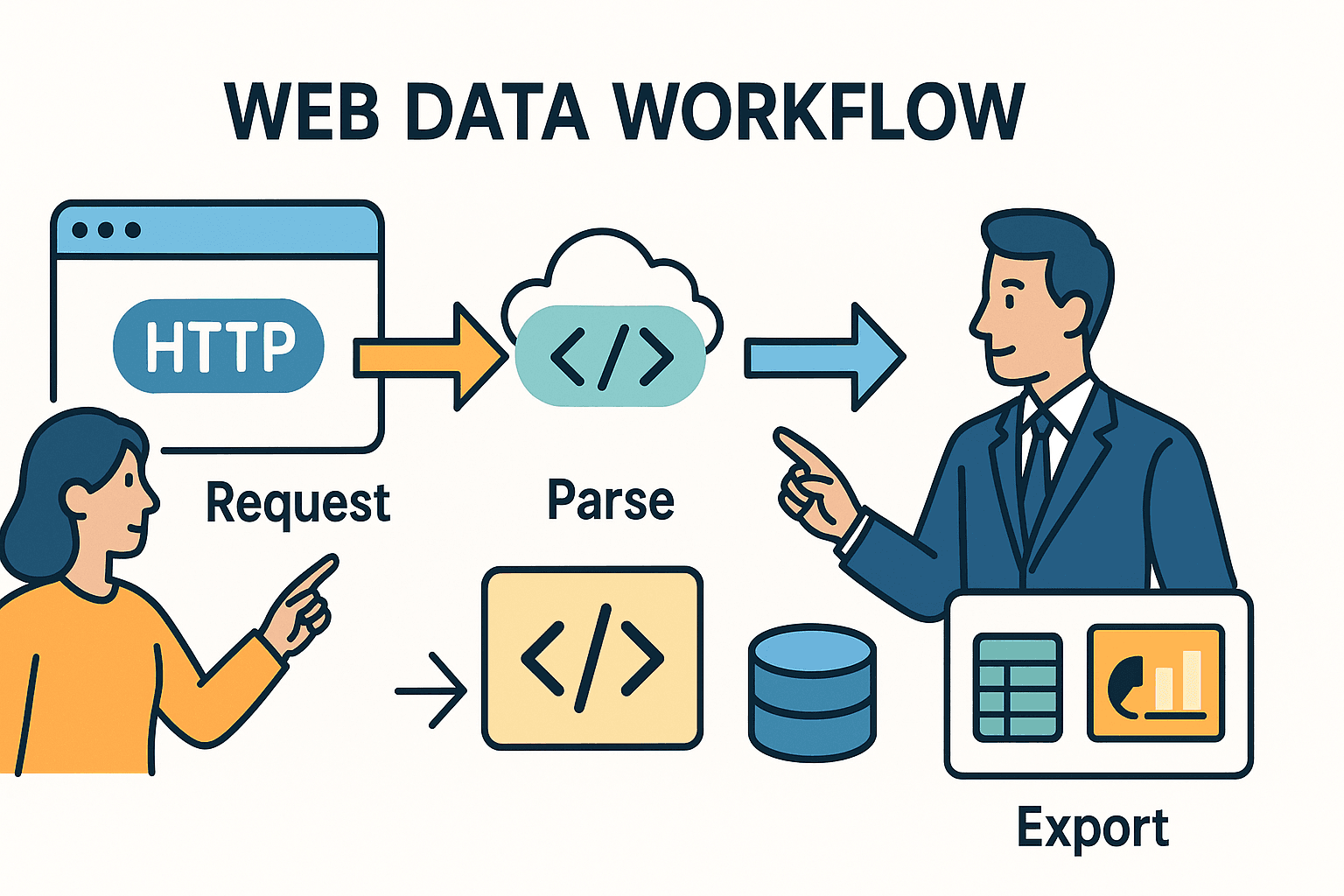

先从最基础的说起。网页爬虫的本质,其实就是自动化你在浏览器里的操作:打开网页、找到目标数据、保存下来。在 Python 里,通常分三步:

- 发送 HTTP 请求(就像你用浏览器访问网页一样)。

- 解析 HTML,定位你要的数据。

- 导出或处理这些数据——比如存到表格、数据库或者仪表盘。

但不同网站的复杂度和你的目标不同,选用的工具和遇到的坑也会完全不一样。

Python 网页爬虫入门:工作原理

你可以把爬虫想象成:你派图书馆管理员去取报纸,然后用剪刀剪下你关心的文章。Python 的 requests 库就是你的“管理员”——帮你把 HTML 拿回来;BeautifulSoup 就是“剪刀”——帮你精准提取想要的内容。

但如果报纸用“隐形墨水”写(比如 JavaScript 渲染),或者内容分散在几十页上呢?这时候你就得用更高级的工具,或者直接上 AI。

主流工具对比

下面是主流 Python 网页爬虫工具的简要对比,以及各自适合的场景:

| 工具/库 | 适用场景 | 优点 | 缺点 |

|---|---|---|---|

| Requests + BeautifulSoup | 抓取静态页面、小型任务 | 简单、快速、易上手,完全可控。 | 不支持 JavaScript,难以大规模爬取。 |

| Scrapy | 大型项目、批量抓取多站点 | 性能高,内置爬取、异步、数据管道、错误处理强大。 | 学习曲线较陡,项目搭建有门槛。 |

| Selenium/Playwright | 需要模拟用户操作、登录、动态内容的页面 | 能抓取浏览器可见的所有内容,支持动态加载、登录、无限滚动。 | 速度慢、资源消耗大、部署复杂。 |

| Thunderbit (AI) | 非结构化数据、PDF、图片、无需写代码的场景 | AI 自动识别字段,支持子页面抓取,导出 Excel/Sheets,无需编程。 | 个别极端场景自定义性较弱,按用量计费。 |

大多数业务场景下,静态网站用 requests + BeautifulSoup 就够了。复杂或大规模任务推荐 Scrapy。遇到动态内容、反爬虫或非结构化数据时, 这样的 AI 工具能让效率飞起来。

实战流程:复杂网页爬取的最佳套路

那怎么从“我想要这些数据”到做出一个健壮、易维护的爬虫?下面是我的实战流程:

1. 分析目标网站结构

写代码前,先用浏览器开发者工具(F12 或右键检查)定位你要的数据。是在表格里?还是一堆 <div>?有没有隐藏的 API 返回 JSON?有时候最简单的路就在眼前。

小技巧:如果你在“下一页”或“加载更多”时看到有网络请求返回 JSON,通常可以直接用 Python 调这个接口,根本不用解析 HTML。

2. 单页原型测试

先从一页开始。用 requests 抓一页,用 BeautifulSoup 提取几个字段,打印出来。如果被拦截或者数据没抓到,试试加请求头(模拟浏览器 User-Agent),或者看看是不是 JavaScript 加载的(如果是,见第 3 步)。

3. 处理动态内容与分页

如果数据不在 HTML 里,可能是 JavaScript 动态加载。这时候可以:

- 浏览器自动化: 用 或 打开页面,等内容加载完再抓。

- API 抓取: 在 Network 面板找 XHR 请求,有返回 JSON 的接口就直接用

requests模拟。 - 分页处理: 多页数据可以循环页码或跟“下一页”链接。无限滚动可以用 Selenium 模拟下拉,或者模拟滚动触发的 API 请求。

4. 错误处理与反爬虫礼仪

网站不一定欢迎爬虫。想不被封号:

- 遵守 robots.txt: 先看

example.com/robots.txt,哪些路径不能爬、有没有限速。 - 限速请求: 用

time.sleep()控制频率。如果 robots.txt 有Crawl-delay: 5,每次至少等 5 秒。 - 自定义 User-Agent: 礼貌地标识你的爬虫(比如

"MyScraper/1.0 (your@email.com)")。 - 重试机制: 用 try/except 包裹请求,失败时重试,遇到 HTTP 429(请求太多)要适当延迟。

5. 数据解析与清洗

用 BeautifulSoup 或 Scrapy 选择器提取字段。去掉多余空格、价格转数字、日期格式化、校验完整性。数据量大可以用 pandas 做清洗和去重。

6. 子页面抓取

很多有价值的信息都藏在详情页。先抓链接列表,再逐个访问详情页提取更多内容。Python 里就是循环 URL 抓取。在 里,可以用“抓取子页面”功能,AI 自动访问并补全数据。

7. 数据导出与自动化

把清洗好的数据导出成 CSV、Excel、Google Sheets 或数据库。定时任务可以用 cron、Airflow 调度,或者(用 Thunderbit 时)直接用自然语言设置云端定时爬取(比如“每周一上午 9 点”)。

Thunderbit:AI 如何助力 Python 网页爬虫

有时候,就算你 Python 写得再溜,也搞不定那些杂乱、非结构化或者受保护的数据。这时候, 就能帮你省大把时间。

Thunderbit 如何和 Python 配合

Thunderbit 是一款 AI 驱动的 Chrome 插件,能读取网页、PDF、图片等内容,自动输出结构化数据,完全不用写代码。我的常用场景:

- 非结构化数据: 遇到 PDF、图片或 HTML 结构混乱的网站,让 Thunderbit 的 AI 自动解析。它能从 PDF 提取表格、识别图片文字,甚至自动推荐字段。

- 子页面与多步抓取: Thunderbit 的“抓取子页面”功能极大节省时间。先抓列表页,再让 AI 自动访问详情页并合并结果,无需手写嵌套循环或管理状态。

- 数据导出: Thunderbit 可直接导出到 Excel、Google Sheets、Notion 或 Airtable。之后我再用 Python 处理分析。

实战案例:Python + Thunderbit 联合应用

比如我要追踪房地产房源。我用 Python + Scrapy 抓取多个网站的房源链接,但有个网站的详细信息只在可下载的 PDF 里。与其写 PDF 解析器,不如直接上传到 Thunderbit,让 AI 提取表格并导出为 CSV,最后用 Python 合并分析。

又比如做销售线索列表。我用 Python 抓公司网址,再用 Thunderbit 的邮箱、电话提取器(免费功能!)批量获取联系方式——完全不用写正则。

构建可维护的爬虫工作流:从脚本到数据管道

一次性脚本适合临时需求,但大多数企业爬虫都是长期运行。我的可扩展爬虫架构如下:

CCCD 框架:抓取、收集、清洗、监控

- 抓取(Crawl): 收集所有目标 URL(来自 sitemap、搜索页或列表)。

- 收集(Collect): 用 Python、Thunderbit 或两者结合提取数据。

- 清洗(Clean): 规范化、去重、校验数据。

- 监控(Debug/Monitor): 记录每次运行日志,处理错误,设置异常或数据异常的告警。

你可以把它想象成一条流水线:

URL → [爬虫] → [提取器] → [清洗器] → [导出器] → [业务平台]

定时与监控

- Python 脚本: 用 cron、Airflow 或云调度定时运行,记录日志,出错时邮件或 Slack 通知。

- Thunderbit: 内置定时器——只需输入“每周一上午 9 点”,Thunderbit 就会自动云端爬取并导出数据。

文档与交接

代码用 Git 管理,流程写好文档,确保至少有一人能接手或维护。混合 Python/Thunderbit 流程时,注明各工具负责哪些网站、数据输出到哪里(比如“Thunderbit 抓取 C 站到 Google Sheets,Python 每周合并分析”)。

合规与道德:2025 年负责任地爬取数据

能力越大,责任越大。合规和道德不能忽视:

robots.txt 与限速

- 检查 robots.txt: 总是先看 robots.txt,了解禁止路径和抓取延迟。可以用 Python 的

robotparser自动检测。 - 礼貌爬取: 按要求延迟请求,尤其有 Crawl-delay 时。千万别高频轰炸网站。

- User-Agent: 真实标识你的爬虫,别冒充 Googlebot 或其他浏览器。

数据隐私与合规

- GDPR/CCPA: 如果抓取个人信息(姓名、邮箱、电话),一定要遵守隐私法规。只抓必要数据,妥善存储,用户要求删除时要配合。

- 服务条款: 未经许可别抓登录后内容。很多网站禁止自动访问,违规可能被封号甚至追责。

- 只抓公开数据: 不要试图抓取私密、受版权保护或敏感信息。

合规自查清单

- [ ] 检查 robots.txt 规则与延迟

- [ ] 设置合理限速与自定义 User-Agent

- [ ] 仅抓取公开、非敏感数据

- [ ] 个人数据合规处理

- [ ] 不违反网站 ToS 或版权

常见错误与调试技巧:让爬虫更稳健

再强的爬虫也会遇到问题。下面是常见故障和我的应对方法:

| 错误类型 | 表现/报错信息 | 调试建议 |

|---|---|---|

| HTTP 403/429/500 | 被封、限流、服务器报错 | 检查请求头、降低频率、切换 IP 或用代理,遵守抓取延迟。 |

| 数据缺失/NoneType | HTML 里找不到数据 | 打印并检查 HTML,可能结构变了,或被拦截到反爬页面。 |

| JavaScript 渲染数据 | 静态 HTML 没有目标数据 | 用 Selenium/Playwright 或找底层 API。 |

| 解析/编码问题 | Unicode 错误、乱码 | 设置正确编码,用 .text 或 html.unescape()。 |

| 重复/不一致 | 数据重复或字段不匹配 | 用唯一 ID 或 URL 去重,校验字段完整性。 |

| 反爬虫/CAPTCHA | 出现验证码或需登录 | 降低频率、用浏览器自动化,或用 Thunderbit/AI 处理复杂场景。 |

调试流程建议:

- 出错时打印原始 HTML。

- 用浏览器 DevTools 对比脚本和浏览器看到的内容。

- 每一步都记录日志——URL、状态码、抓取条数。

- 先用小样本测试,确认没问题再大规模跑。

进阶项目实战:Python 网页爬虫能力提升

想把这些最佳实践用起来?可以试试这些真实项目:

1. 电商价格监控仪表盘

抓取 Amazon、eBay、Walmart 的价格和库存,处理反爬虫和动态内容,每天导出到 Google Sheets 做趋势分析。用 快速上手。

2. 招聘信息聚合器

汇总 Indeed 及垂直招聘网站的职位,解析职位、公司、地点、发布时间,处理分页并按职位 ID 去重,每天导出到 Airtable。

3. 销售线索联系方式提取器

给定公司网址列表,批量提取首页和联系页的邮箱、电话。可以用 Python 正则或 Thunderbit 免费提取器一键获取,导出 Excel 给销售团队。

4. 房产信息对比分析

抓取 Zillow、Realtor.com 某地区房源,规范地址和价格,趋势对比,结果可视化到 Google Sheets。

5. 社交媒体品牌提及追踪

用 Reddit 的 JSON API 追踪品牌被提及次数,聚合发帖量、情感分析,导出时间序列数据供市场分析。

总结:2025 年 Python 网页爬虫的核心要点

回顾一下重点:

- 网页爬虫对商业智能、销售、运营比以往更重要。 网络是数据金矿,关键在于怎么高效挖掘。

- Python 是你的万能工具箱: 静态页面用 requests + BeautifulSoup,复杂任务用 Scrapy,动态网站用浏览器自动化。

- AI 工具如 Thunderbit 是你的秘密武器, 处理非结构化、复杂或无需代码的场景,Python + AI 组合效率更高。

- 最佳实践很重要: 先分析、模块化编写、健壮处理错误、清洗数据、自动化流程。

- 合规不能忽视: 检查 robots.txt,遵守隐私法规,负责任地抓取。

- 保持灵活: 网络环境变化快,定期监控、调试、及时调整策略。

未来的网页爬虫一定是混合型、合规且以业务为导向。不管你是新手还是老司机,持续学习、保持好奇,让数据帮你拿下下一个突破。

附录:Python 网页爬虫学习资源与工具

以下是我常用的学习和排错资源:

- – 人性化的 HTTP 库,功能丰富。

- – 学习如何高效解析 HTML。

- – 适合大规模、生产级爬取。

- / – 浏览器自动化与动态内容处理。

- – 商业用户最易用的 AI 网页爬虫。

- – AI 爬虫教程、案例与最佳实践。

- – 及时了解合规与道德问题。

- / ** – 社区问答与排错。

想知道 Thunderbit 怎么让你的爬虫更高效?欢迎访问我们的 看演示和深度解析。

常见问题解答

1. 2025 年最推荐的 Python 网页爬虫库是什么?

静态页面和小型任务,requests + BeautifulSoup 依然是首选。大规模或多页爬取推荐 。动态内容用 或 。遇到非结构化或复杂数据,AI 工具如 非常有用。

2. 如何应对 JavaScript 渲染或动态网站?

用 Selenium 或 Playwright 等浏览器自动化工具渲染页面后提取数据。或者在 Network 面板找返回 JSON 的 API,通常更简单可靠。

3. 网页爬取合法吗?

抓取公开数据在美国通常是合法的,但一定要检查 ,遵守网站条款,并符合 GDPR/CCPA 等隐私法规。千万别抓私密、受版权保护或敏感信息。

4. 如何自动化和定时运行爬虫?

Python 脚本可以用 cron、Airflow 或云调度。无需代码的自动化, 内置定时功能——用自然语言描述时间,云端自动运行。

5. 爬虫失效怎么办?

先检查网站结构是不是变了,或者是不是被封(HTTP 403/429)。检查 HTML、更新选择器、降低请求频率、排查反爬虫机制。持续遇阻可以试试 Thunderbit 的 AI 功能或切换到浏览器自动化。

祝你爬取顺利,数据始终干净、合规、可用!想体验 Thunderbit 如何融入你的工作流, 试试看。如果想获取更多技巧, 随时欢迎你的到访。