说真的,谁会一大早醒来就兴奋地把 500 行商品价格一条条复制进表格?(如果你真喜欢这样,佩服你的毅力,记得多备几个护腕。)不管你是做销售、运营,还是想让公司在激烈竞争中抢占先机,几乎都遇到过整理网页数据的痛苦。现在,网络数据已经成了企业的“生命线”,自动化采集的需求也在飞速增长——。

我在 SaaS 和自动化圈子里混了不少年,见过各种“骚操作”:从 Excel 宏到凌晨两点还在调试的 Python 脚本。这篇教程会带你用 Python html 解析器实战抓取真实网页数据(没错,我们要一起爬 IMDb 电影评分),同时也会聊聊,为什么到了 2025 年,像 这样的 AI 工具能让你完全不用写代码,直接拿到想要的洞察。

什么是 html 解析器?为什么选 Python?

先说本质:html 解析器到底是干嘛的?你可以把它想象成网页世界的“图书管理员”。它能把乱七八糟的 HTML 代码整理成清晰的树状结构,让你轻松提取需要的信息——比如标题、价格、链接——不用在一堆标签和 div 里迷路。

Python 是做这件事的首选语言,原因很简单:语法简单易懂、上手快,还有庞大的网页爬虫和解析库生态。事实上,,新手友好,社区活跃。

Python html 解析器主力阵容

常见的 Python html 解析库有:

- BeautifulSoup:经典入门首选,语法简单。

- lxml:速度快、功能强大,支持高级查询。

- html5lib:对“脏”HTML 超级包容,解析方式和浏览器一样。

- PyQuery:可以用 jQuery 风格选择器,前端转后端的开发者会很喜欢。

- HTMLParser:Python 自带的解析器,轻量但功能有限。

每个库都有自己的特色,但都能帮你把原始 HTML 变成结构化数据。

典型应用场景:企业如何用 Python html 解析器获益

网页数据采集早就不是技术宅或者数据科学家的专利,尤其在销售和运营领域,已经成了核心业务流程。原因很简单:

一句话总结:还在手动复制粘贴数据?你已经在浪费时间和钱了。

Python html 解析器工具箱:主流库对比

下面我们实际对比下主流 Python html 解析库,帮你选对工具:

| 库 | 易用性 | 速度 | 灵活性 | 维护难度 | 适用场景 |

|---|---|---|---|---|---|

| BeautifulSoup | ⭐⭐⭐⭐⭐ | ⭐⭐ | ⭐⭐⭐ | 中等 | 新手、杂乱 HTML |

| lxml | ⭐⭐ | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐ | 中等 | 速度、XPath、大型文档 |

| html5lib | ⭐⭐⭐ | ⭐ | ⭐⭐⭐⭐⭐ | 低 | 类浏览器解析、破损 HTML |

| PyQuery | ⭐⭐⭐ | ⭐⭐⭐⭐ | ⭐⭐⭐ | 中等 | jQuery 用户、CSS 选择器 |

| HTMLParser | ⭐⭐⭐ | ⭐⭐⭐ | ⭐ | 低 | 简单内置任务 |

BeautifulSoup:新手友好型

BeautifulSoup 是 html 解析的“入门神器”,语法直观、文档丰富,对格式混乱的网页也能轻松搞定()。缺点是处理大型或复杂页面时速度一般,且不原生支持 XPath 等高级选择器。

lxml:速度与强大兼备

如果你追求速度或者需要用 XPath 查询,lxml 是首选()。它基于 C 语言库,性能非常棒,但安装稍微麻烦点,上手门槛也高一些。

其他选择:html5lib、PyQuery、HTMLParser

- html5lib:解析方式和浏览器一致,适合处理结构混乱的网页,但速度较慢()。

- PyQuery:支持 jQuery 风格选择器,前端转后端的开发者会很喜欢()。

- HTMLParser:Python 自带,轻量、随时可用,但功能有限。

第一步:搭建 Python html 解析环境

在解析网页前,先把环境配好:

-

安装 Python:去 下载。

-

安装 pip:Python 3.4+ 一般自带 pip,终端输入

pip --version检查下。 -

安装相关库(本教程用 BeautifulSoup 和 requests):

1pip install beautifulsoup4 requests lxmlbeautifulsoup4:html 解析器。requests:用来抓取网页内容。lxml:高性能解析器,BeautifulSoup 可调用。

-

检查安装是否成功:

1python -c "import bs4, requests, lxml; print('All good!')"

常见问题排查:

- 权限报错可以用

pip install --user ... - Mac/Linux 可能要用

python3和pip3 - “ModuleNotFoundError” 多半是拼写或环境问题

第二步:用 Python 解析你的第一个网页

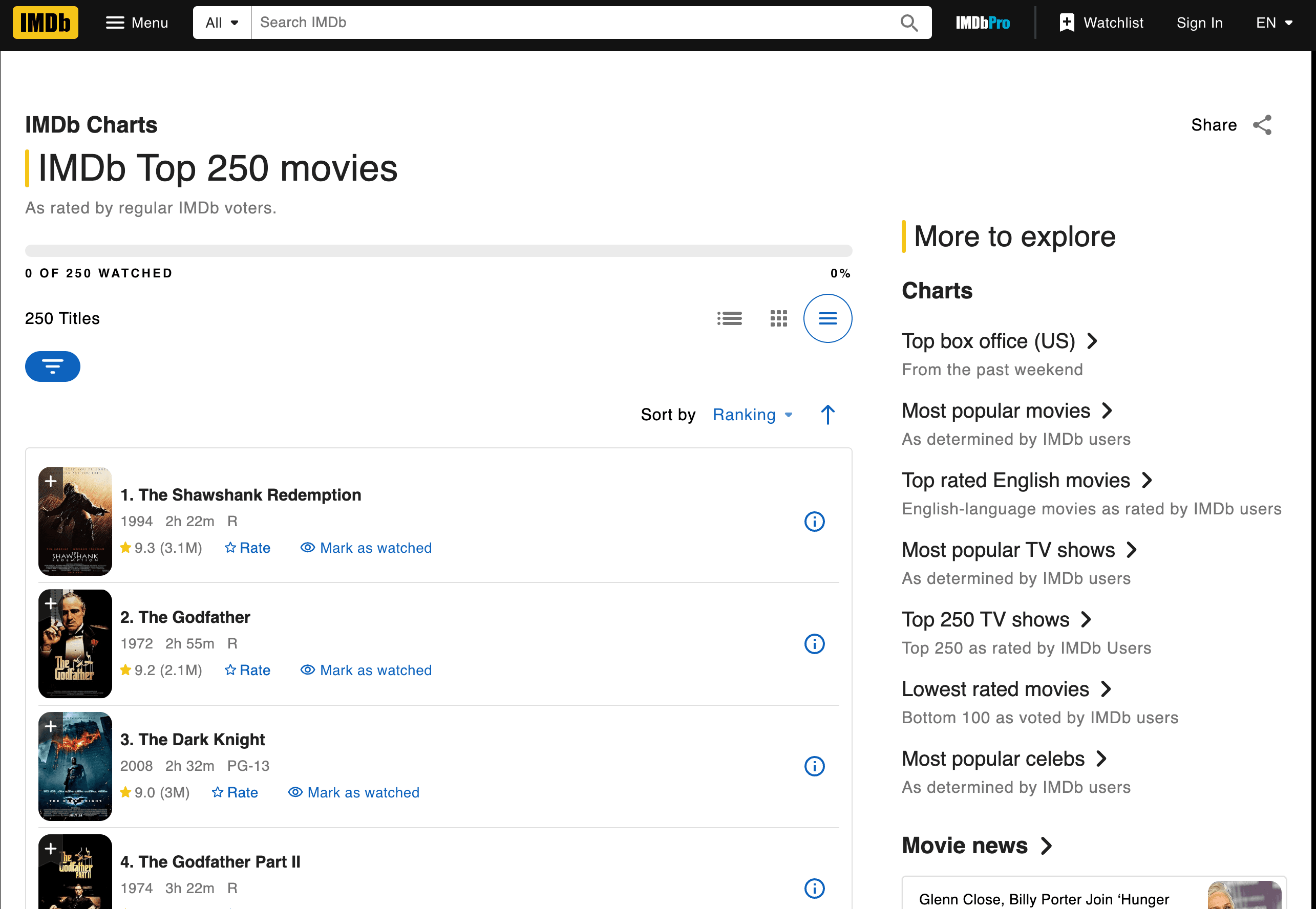

下面我们动手爬取 IMDb Top 250 电影榜,提取电影名、年份和评分。

抓取并解析网页

示例脚本如下:

1import requests

2from bs4 import BeautifulSoup

3url = "<https://www.imdb.com/chart/top/>"

4resp = requests.get(url)

5soup = BeautifulSoup(resp.text, 'html.parser')

6# 找到所有标题和评分单元格

7title_cells = soup.find_all('td', class_='titleColumn')

8rating_cells = soup.find_all('td', class_='ratingColumn imdbRating')

9# 以前三部电影为例

10for i in range(3):

11 title_cell = title_cells[i]

12 rating_cell = rating_cells[i]

13 title = title_cell.a.text

14 year = title_cell.span.text.strip("()")

15 rating = rating_cell.strong.text if rating_cell.strong else rating_cell.text

16 print(f"{i+1}. {title} ({year}) -- Rating: {rating}")代码说明:

- 用

requests.get()获取网页内容 BeautifulSoup解析 HTML- 通过 class 名找到对应

<td>元素 - 提取标题、年份和评分文本

输出示例:

11. The Shawshank Redemption (1994) -- Rating: 9.3

22. The Godfather (1972) -- Rating: 9.2

33. The Dark Knight (2008) -- Rating: 9.0数据提取:如何定位标签和类名

怎么知道用哪些标签和 class?其实就是在 IMDb 页面右键“检查元素”,找出规律——比如每部电影都在 <td class="titleColumn">,评分在 <td class="ratingColumn imdbRating">()。

小技巧: 换网站时,先用浏览器检查 HTML 结构,找独特的 class 或标签。

保存和导出结果

把数据保存为 CSV 文件:

1import csv

2movies = []

3for i in range(len(title_cells)):

4 title_cell = title_cells[i]

5 rating_cell = rating_cells[i]

6 title = title_cell.a.text

7 year = title_cell.span.text.strip("()")

8 rating = rating_cell.strong.text if rating_cell.strong else rating_cell.text

9 movies.append([title, year, rating])

10with open('imdb_top250.csv', 'w', newline='', encoding='utf-8') as f:

11 writer = csv.writer(f)

12 writer.writerow(['Title', 'Year', 'Rating'])

13 writer.writerows(movies)数据清洗建议:

- 用

.strip()去掉多余空格 - 用

if判断处理缺失数据 - 想导出 Excel,可以直接用 pandas 写

.xlsx文件

第三步:应对 HTML 结构变化与维护难题

现实中,网站经常改版——有时候感觉就是专门“反爬虫”。比如 IMDb 把 class="titleColumn" 改成 class="movieTitle",你的脚本立马失效。相信我,这种情况太常见了。

脚本失效:常见问题

- 找不到选择器:指定的标签或 class 不存在

- 结果为空:页面结构变了,或者内容用 JavaScript 动态加载

- HTTP 错误:网站加了反爬虫措施

排查思路:

- 检查解析的 HTML 和浏览器里看到的是不是一样

- 更新选择器,适配新结构

- 如果内容是动态加载,可能要用 Selenium 这类浏览器自动化工具,或者找 API 接口

最大难点? 如果你要爬 10、50、甚至 500 个网站,光修脚本就能让你头大()。

第四步:手写 Python html 解析的隐藏成本

假如你不仅要爬 IMDb,还要抓 Amazon、Zillow、LinkedIn 等一堆网站。每个都要单独写脚本,网站一变又得重写。

隐藏成本包括:

- 维护人力:

- 基础设施:需要代理、异常处理、监控等

- 性能压力:大规模采集要考虑并发、限流等

- 质量保障:脚本越多,出错点越多

对于非技术团队来说,这种方式很快就难以为继。就像雇了一堆实习生天天复制粘贴——只不过这些“实习生”是 Python 脚本,网站一变就“罢工”。

超越 Python html 解析器:AI 网页爬虫 Thunderbit

现在,真正高效的方式来了。如果你能跳过写代码、跳过维护,直接拿到想要的数据,无论网站怎么变都不怕?

这正是我们打造 的初衷。它是一款 AI 网页爬虫 Chrome 插件,只需两步就能从任意网页提取结构化数据。无需 Python,无需脚本,无需头疼。

Python html 解析器 vs. Thunderbit:对比一览

| 对比维度 | Python HTML 解析器 | Thunderbit (查看价格) |

|---|---|---|

| 配置时间 | 高(安装、写代码、调试) | 低(装插件、点两下) |

| 易用性 | 需编程基础 | 无需代码,所见即所得 |

| 维护成本 | 高(脚本易失效) | 低(AI 自动适配) |

| 扩展性 | 复杂(脚本、代理、基础设施) | 内置(云端爬取、批量任务) |

| 数据增强 | 手动写代码 | 内置(标签、清洗、翻译、子页面) |

与其重复造轮子,不如用 AI 一步到位。

为什么用 AI 做网页数据采集?

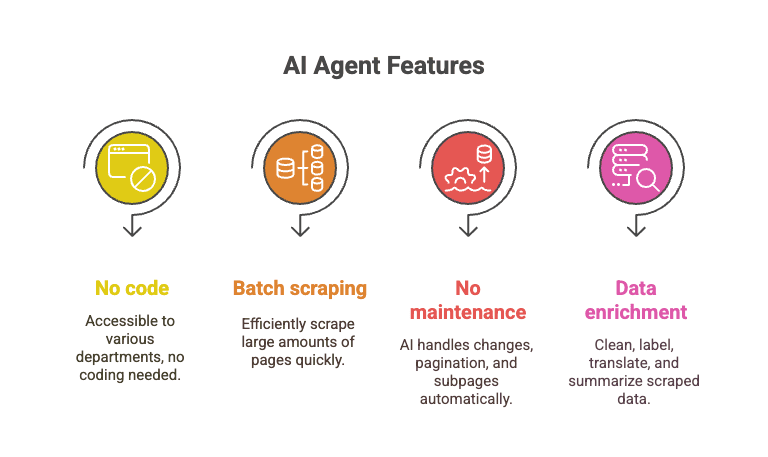

Thunderbit 的 AI 智能体会自动识别网页结构,遇到变化也能自适应。就像有个永远不喊累、不会抱怨 class 变了的“超级实习生”。

- 无需编程:任何人都能用,销售、运营、市场都适用

- 批量采集:1 万页数据,几分钟搞定,远超手写脚本

- 免维护:AI 自动应对页面变动、翻页、子页面等

- 数据增强:采集时自动清洗、标注、翻译、摘要

想象一下,几步就能爬下 IMDb Top 250 全部电影、每部的详情页和评论,而 Python 脚本还卡在第 12 行报错。

实操演示:用 Thunderbit 抓取 IMDb 电影评分

Thunderbit 如何搞定 IMDb 任务?

- 安装 。

- 打开 。

- 点击 Thunderbit 图标。

- 点击“AI 智能识别字段”。 Thunderbit 会自动识别并推荐字段(标题、年份、评分)。

- 如有需要可调整字段。

- 点击“开始爬取”。 Thunderbit 会瞬间提取全部 250 条数据。

- 可导出到 Excel、Google Sheets、Notion 或 CSV。

就是这么简单。无需写代码,无需调试,也不会遇到“列表怎么是空的?”的尴尬。

想看实际操作?欢迎访问 或阅读我们的。

总结:如何选择适合你的网页数据采集工具?

像 BeautifulSoup、lxml 这样的 Python html 解析器功能强大、灵活还免费,适合喜欢编程、追求极致定制的开发者。但它们学习曲线陡峭,维护成本高,需求一多就容易“踩坑”。

对于业务用户、销售团队,或者只想拿到数据又不想写代码的人来说,AI 工具如 无疑是高效利器。无需编程、无需维护,轻松实现大规模数据采集、清洗和增强。

我的建议? 如果你热爱写脚本、喜欢折腾,Python 解析器值得一试。但如果你更看重效率和省心,不妨体验下 Thunderbit,让 AI 替你搞定繁琐的工作。

想了解更多网页爬虫、数据采集和 AI 自动化的实用技巧?欢迎浏览 ,比如或。