2026 年的互联网可以说是“野性满满”——现在全球一半的网络流量都被机器人占据,而开源网页爬虫正是背后默默发力的主角。不管是做价格监控,还是给 AI 喂数据,这些工具都少不了。作为一个一直在 SaaS 和自动化领域摸爬滚打的老兵,我太清楚选对自建爬虫工具有多重要了。选得好,团队能少踩很多坑,晚上也不用熬夜调 bug。无论你只是偶尔采集几个产品页面,还是要批量抓取上百万网址搞研究,这份开源 firecrawl 替代方案清单都能帮你搞定——不管你的技术栈、团队规模还是对复杂度的容忍度如何。

不过要记住:没有哪款工具能“通吃”所有场景。有的团队看重 Scrapy 的强大,有的更喜欢 Heritrix 的归档能力,也有不少人觉得维护开源库太费劲。所以,接下来我会详细拆解 2026 年最值得关注的 9 款开源 firecrawl 替代方案,帮你快速锁定最适合自己业务的工具,省去反复试错的烦恼。

如何为你的业务挑选最佳开源 firecrawl 替代方案?

在正式进入榜单前,先聊聊选型思路。现在开源网页爬虫的生态比以前更丰富,选的时候建议重点考虑这几个方面:

- 易用性: 你喜欢点点鼠标搞定,还是能接受用 Python、Go 或 JavaScript 写代码?

- 扩展性: 只采集一个网站,还是要大规模抓取成千上万页面、覆盖上百个域名?

- 内容类型: 目标站点是静态 HTML,还是大量依赖 JavaScript 动态加载?

- 集成需求: 数据采集后是导出到 Excel、写入数据库,还是要对接分析系统?

- 维护成本: 团队有能力长期维护自定义代码,还是更希望工具能自动适应网站变化?

这里有一份速查表,帮你快速定位适合的工具:

| 场景 | 最佳工具 |

|---|---|

| 无代码、离线浏览 | HTTrack |

| 大规模多域名爬取 | Scrapy, Apache Nutch, StormCrawler |

| 动态/JS 密集型网站 | Puppeteer |

| 表单自动化/需登录 | MechanicalSoup |

| 静态网站下载/归档 | Wget, HTTrack, Heritrix |

| Go 开发者、高性能需求 | Colly |

接下来,一起看看 2026 年最值得关注的 9 款开源 firecrawl 替代方案。

1. Scrapy:大规模 Python 爬取首选

在开源网页爬虫圈绝对是“扛把子”。它基于 Python,特别适合需要大规模抓取的开发者——不管是百万级页面、频繁更新还是复杂网站逻辑都能轻松搞定。

推荐理由:

- 超强扩展性: 支持自定义爬虫、代理中间件、登录处理,数据能导出成 JSON、CSV 或直接写数据库。

- 高并发高性能: 每秒能处理上千请求,很多企业每月都靠它抓取数十亿页面( 就是典型代表)。

- 社区活跃: 插件多,文档全,Stack Overflow 上一堆解答。

- 成熟稳定: 全球电商、新闻、科研等团队都在用。

不足之处: 入门门槛有点高,非开发者上手不太友好,而且需要持续维护爬虫代码来适应网站变化。但如果你追求极致可控和扩展性,Scrapy 绝对值得一试。

2. Apache Nutch:企业级搜索引擎利器

是开源爬虫界的“老炮”,专为企业级、互联网规模的爬取任务设计。如果你想自建搜索引擎或批量抓取海量域名,Nutch 是理想选择。

推荐理由:

- Hadoop 集群支持: 基于 Hadoop,可横向扩展到数十亿页面( 就用它抓全球网页)。

- 批量爬取: 支持批量种子 URL,适合定时大规模任务。

- 强大集成: 能和 Solr、Elasticsearch 及大数据管道无缝对接。

不足之处: 部署比较复杂(要 Hadoop 集群、Java 配置),更偏向“原始爬取”而不是结构化数据提取。小项目用它有点“大材小用”,但大规模爬取它无可替代。

3. Heritrix:网页归档与合规首选

是 Internet Archive 官方爬虫,专为网页归档和数字保存打造。

推荐理由:

- 归档级完整性: 能抓取每个页面、资源和链接,适合合规存档或历史快照。

- 标准 WARC 输出: 所有内容以 Web ARChive 格式保存,方便后续回放和分析。

- 可视化管理: 支持网页端配置和监控爬取任务。

不足之处: 占用资源大(需要大量磁盘和内存),不支持 JavaScript 执行,输出为原始归档文件而不是结构化表格。更适合图书馆、档案馆或有合规需求的行业。

4. Colly:Go 开发者的高性能利器

是 Go 语言开发者的心头好——轻量、并发高、速度快。

推荐理由:

- 极致性能: 利用 Go 的并发优势,Colly 能以极低资源消耗抓取海量页面( 有详细评测)。

- 简洁 API: 支持 HTML 元素回调、自动处理 cookies 和 robots.txt。

- 静态站点友好: 适合服务端渲染页面、API 或 Go 后端集成。

不足之处: 不支持内置 JS 渲染(需要配合 Chromedp 等工具),需要有 Go 语言基础。

5. MechanicalSoup:表单自动化首选

是一款 Python 库,介于简单 HTTP 请求和完整浏览器自动化之间。

推荐理由:

- 表单自动化: 轻松实现登录、表单填写、会话保持,适合采集需要认证的网站。

- 轻量易用: 基于 Requests 和 BeautifulSoup,安装配置简单。

- 交互型网站友好: 适合需要提交搜索表单或登录后采集数据的场景( 有详细教程)。

不足之处: 不支持 JavaScript 执行,无法处理 JS 动态页面。更适合静态或服务端渲染页面。

6. Puppeteer:动态 JS 网站采集神器

是现代 JS 网站采集的“瑞士军刀”,基于 Node.js,可以全方位操控无头 Chrome 浏览器。

推荐理由:

- 动态内容无压力: 能抓取 SPA、无限滚动、AJAX 加载页面( 有详细指南)。

- 用户行为模拟: 支持点击、表单填写、截图,甚至可以配合插件自动识别验证码。

- 强大自动化: 适合测试、监控、采集任何用户可见内容。

不足之处: 资源消耗大(需要运行完整 Chrome 实例),速度慢于纯 HTTP 爬虫,扩展需要强大硬件或云端编排。

7. Wget:命令行快速下载利器

是经典命令行工具,适合批量下载静态网站和文件。

推荐理由:

- 极简高效: 一行命令就能下载整站或目录,无需编程。

- 速度快: C 语言编写,性能优异。

- 静态内容友好: 适合文档站、博客或批量文件下载( 有实用脚本)。

不足之处: 不支持 JS 执行或表单处理,下载为原始页面(非结构化数据)。更像是静态站点的“数字吸尘器”。

8. HTTrack:离线浏览(零代码)首选

是 Wget 的“可视化兄弟”,有图形界面,方便镜像网站。

推荐理由:

- 操作简单: 向导式界面,零技术门槛。

- 离线浏览: 自动调整链接,支持本地浏览镜像站点。

- 归档利器: 适合研究人员、市场人员或需要网站快照的用户( 有用户对比)。

不足之处: 不支持动态内容,处理大型网站速度较慢,不适合结构化数据提取。

9. StormCrawler:实时分布式爬取首选

是现代分布式爬虫,适合需要实时、持续抓取大规模网页的团队。

推荐理由:

- 实时爬取: 基于 Apache Storm,数据流式处理,适合新闻监控或搜索引擎( 有详细介绍)。

- 模块化可扩展: 可按需添加解析、索引、定制处理模块。

- 大规模应用: Common Crawl 新闻数据集就是靠它驱动。

不足之处: 需要 Java 开发和 Storm 集群经验,小型项目用它有点“杀鸡用牛刀”。

开源 firecrawl 替代方案横向对比:哪款免费竞品最适合你?

这里为你整理了 9 款工具的对比表:

| 工具 | 最佳场景 | 主要优点 | 不足之处 | 语言/部署方式 |

|---|---|---|---|---|

| Scrapy | 大规模、频繁爬取 | 强大、可扩展、社区活跃 | 入门难度高,需 Python | Python 框架 |

| Apache Nutch | 企业级、互联网规模爬取 | Hadoop 支持,超大规模 | 部署复杂,批量为主 | Java/Hadoop |

| Heritrix | 归档、合规爬取 | 全站抓取,WARC 输出 | 资源占用大,无 JS,输出为归档 | Java 应用,网页 UI |

| Colly | Go 开发者、高性能采集 | 快速、API 简洁、高并发 | 无 JS,需 Go 语言 | Go 库 |

| MechanicalSoup | 表单自动化、登录采集 | 轻量、会话管理 | 无 JS,扩展性有限 | Python 库 |

| Puppeteer | 动态/JS 密集型网站 | 全浏览器控制、自动化 | 资源消耗大,需 Node.js | Node.js 库 |

| Wget | 静态站点下载、离线访问 | 简单、快速、命令行 | 无 JS,下载原始页面 | 命令行工具 |

| HTTrack | 零技术用户、网站归档 | 图形界面、离线浏览 | 无 JS,大站点慢 | 桌面应用(GUI) |

| StormCrawler | 实时、分布式爬取 | 可扩展、模块化、实时 | 需 Java/Storm 经验 | Java/Storm 集群 |

自建爬虫 vs. 直接用开源 firecrawl 替代方案?

说实话:自己造轮子听起来很酷,但一旦陷入维护、代理和反爬虫的泥潭,你会发现开源工具其实凝聚了社区多年的经验和智慧。用现有开源方案,往往是最快、最稳妥、最省心的选择( 有详细分析)。

- 适合用开源方案: 需求和现有工具高度契合,想节省开发时间,重视社区支持。

- 适合自研: 需求特别特殊,团队有深厚技术积累,而且爬虫是核心业务。

但要注意,开源不等于“零成本”——工程师时间、服务器运维、反爬更新等都要持续投入。如果你想要强大爬虫能力又不想写代码,其实还有更简单的选择。

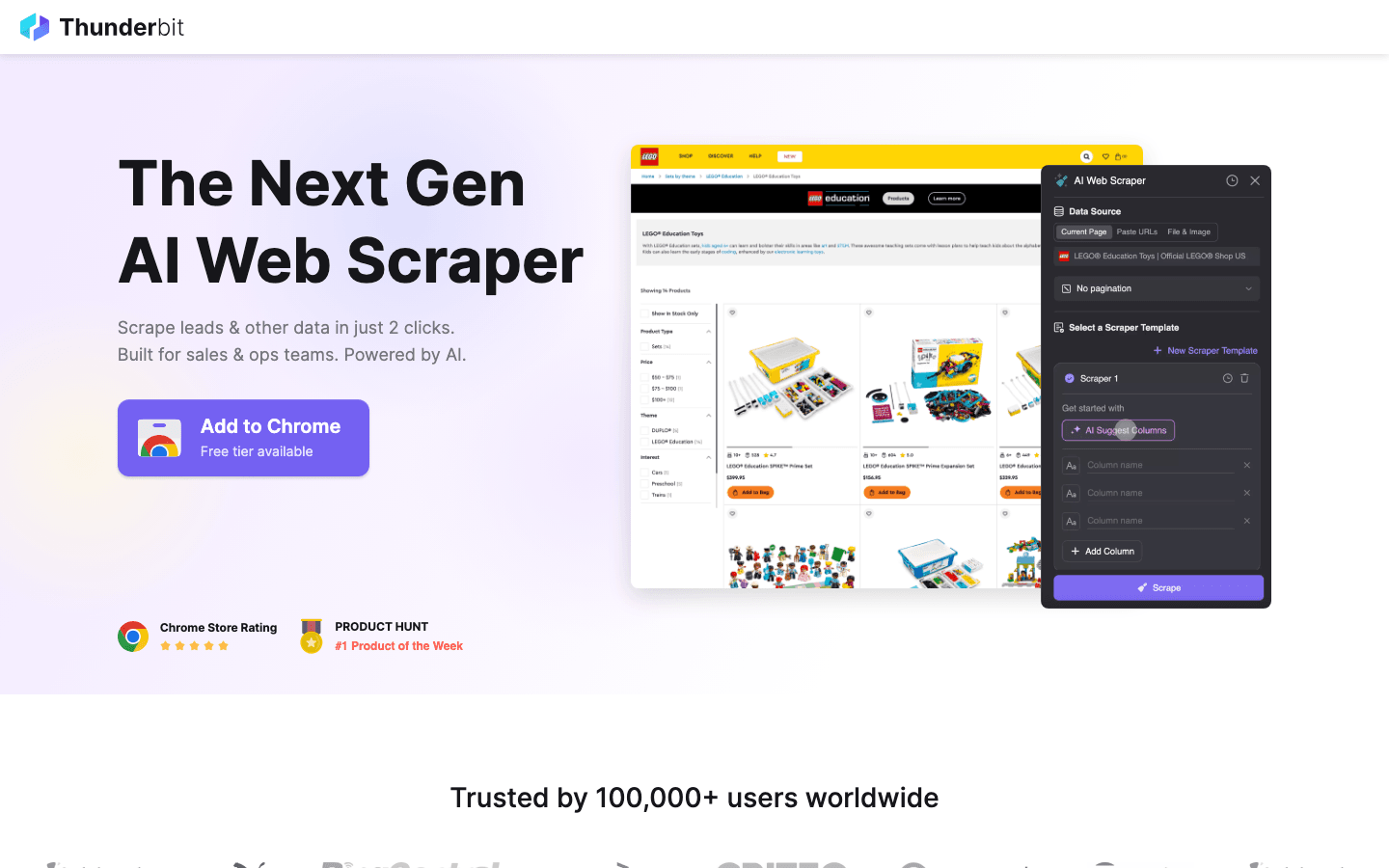

彩蛋推荐:开源太复杂?试试 Thunderbit

上面这些工具虽然很强,但都需要一定的编程基础,面对动态反爬和持续维护也有不小挑战。

是我极力推荐的“无代码”解决方案,完美补齐了开源工具的短板。

为什么选 Thunderbit?

- 零代码上手: 不像 Scrapy 或 Puppeteer,Thunderbit 是一款 AI 网页爬虫 Chrome 插件,只要点“AI 智能识别字段”,爬虫就自动生成。

- 动态内容全自动: AI 自动搞定动态加载、无限滚动、分页等复杂场景,完全不用写脚本。

- 一键导出: 两步就能把数据导出到 Excel、Google Sheets 或 Notion。

- 无需维护: 网站结构变了也不用手动改代码,Thunderbit 的 AI 会自动适配。

如果你是销售、市场或研究人员,想快速拿到数据又不想学 Python 或 Go,Thunderbit 是开源工具的绝佳补充。

想亲自体验? 就能免费试用。

总结:2026 年自建网页爬虫选型指南

开源 firecrawl 替代方案比以往更丰富,无论你需要 Scrapy、Nutch 的大规模能力,还是 Heritrix 的归档精度,都能找到适合自己业务的工具。关键是根据实际需求选型——只需简单采集就别用“重型武器”,要大规模爬取也别吝啬投入。

如果觉得开源方案太技术化或维护成本高,AI 工具如 Thunderbit 也能帮你轻松搞定。

准备好了吗?下一个大数据项目可以用 Scrapy 起步,或者 ,享受 AI 驱动的极简采集。如果想了解更多网页爬虫技巧,欢迎访问 深入学习。

常见问题解答

1. 使用开源 firecrawl 替代方案的最大优势是什么? 开源方案灵活可定制、节省成本,支持自建部署,避免厂商锁定,还能获得社区持续支持和更新。

2. 哪款工具适合非技术用户快速采集? 是离线浏览的开源好选择。如果需要结构化数据(比如 Excel 表格),建议用 AI 能力更强的 。

3. 如何采集动态、JS 密集型网站? 最适合这类场景——它能控制真实浏览器,采集 SPA、AJAX 等所有用户可见内容。

4. 什么时候该用 Apache Nutch 或 StormCrawler 这类“重型”爬虫? 如果需要跨多个域名抓取数百万页面,或需要实时、分布式采集(比如搜索引擎、新闻监控),这些工具最适合大规模和高可靠性需求。

5. 是自研爬虫好,还是用现有开源方案好? 大多数团队直接用并定制开源工具更快、更省钱、更靠谱。只有在需求极为特殊且有长期维护能力时才建议自研。

祝你采集顺利,数据永远新鲜、结构清晰、随时可用!

延伸阅读