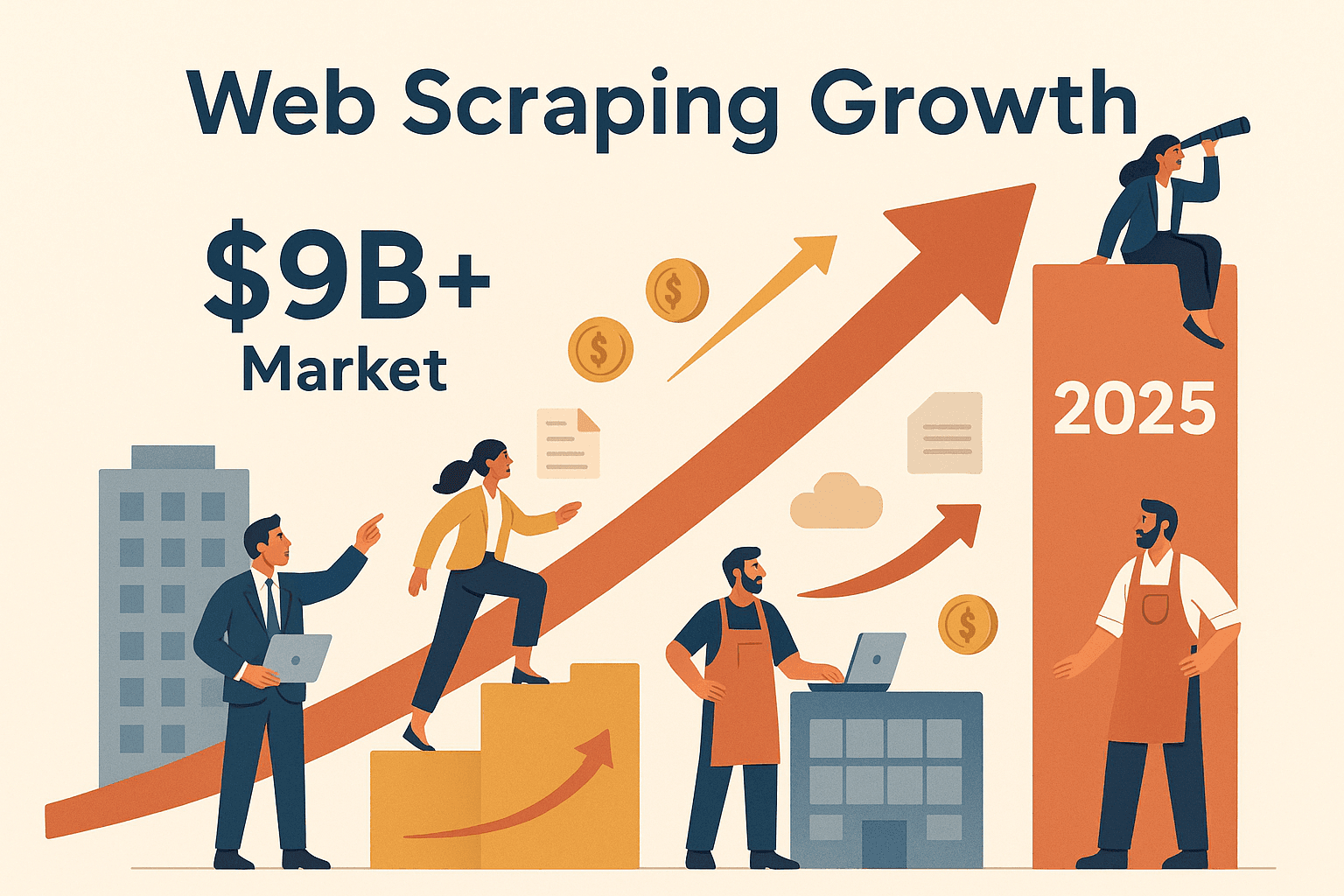

互联网的数据量大到让人眼花缭乱,谁都想从中挖点“金子”。但说真的,手动从成百上千个网页复制粘贴信息,既枯燥又低效。node 网页爬虫就是为了解决这个痛点而诞生的。最近几年,不管是销售、运营还是市场调研团队,都越来越依赖自动化工具,批量从网页中提取有价值的数据。其实,全球网页爬虫市场到 2025 年预计会突破 ,而且用的不只是科技大厂。无论是电商价格监控还是销售线索挖掘,node 网页爬虫已经成了提升竞争力的必备技能。

如果你想搞清楚怎么用 Node.js 从网页提取数据,或者为什么 Node.js 能轻松搞定动态、JavaScript 密集型网站,这篇指南就是为你量身定制的。我会带你了解 node 网页爬虫到底是什么、它对企业用户有啥用,以及如何从零搭建自己的爬虫流程。如果你更喜欢“立竿见影”,我还会介绍像 这样的工具,如何帮你一键自动化整个流程,省时又省力。准备好把互联网变成你的数据宝库了吗?那就跟我一起出发吧!

什么是 node 网页爬虫?自动化数据提取的入门钥匙

简单来说,node 网页爬虫就是用 Node.js(超火的 JavaScript 运行环境)自动从网站抓取信息。你可以把它想象成一个高速机器人,自动访问网页、读取内容,并精准提取你想要的数据——不管是商品价格、联系方式还是最新新闻。

基本流程其实很简单:

- 你的 Node.js 脚本像浏览器一样向网站发起 HTTP 请求;

- 拿到网页的原始 HTML;

- 用 Cheerio 这样的库解析 HTML,像 jQuery 一样“查找”页面内容;

- 如果遇到内容由 JavaScript 动态加载的网站(比如现在很多交互式网页),可以用 Puppeteer 控制真实浏览器后台渲染页面,等所有脚本跑完再提取数据。

为啥选 Node.js?因为 JavaScript 本来就是网页的“母语”,Node.js 让你在浏览器外也能用它。这样你既能搞定静态页面,也能应对动态网站,甚至能自动化登录、点击等复杂操作,数据处理速度还特别快。而且 Node 的事件驱动、非阻塞架构让你能同时抓取一大堆页面,非常适合大规模数据采集。

node 网页爬虫常用工具:

- Axios: 负责网页请求(HTTP 请求)

- Cheerio: 解析和查询静态页面 HTML

- Puppeteer: 自动化真实浏览器,专治 JavaScript 动态或交互性强的网站

如果你脑海里浮现出一群“浏览器机器人”在后台默默帮你采集数据——没错,这就是现实。

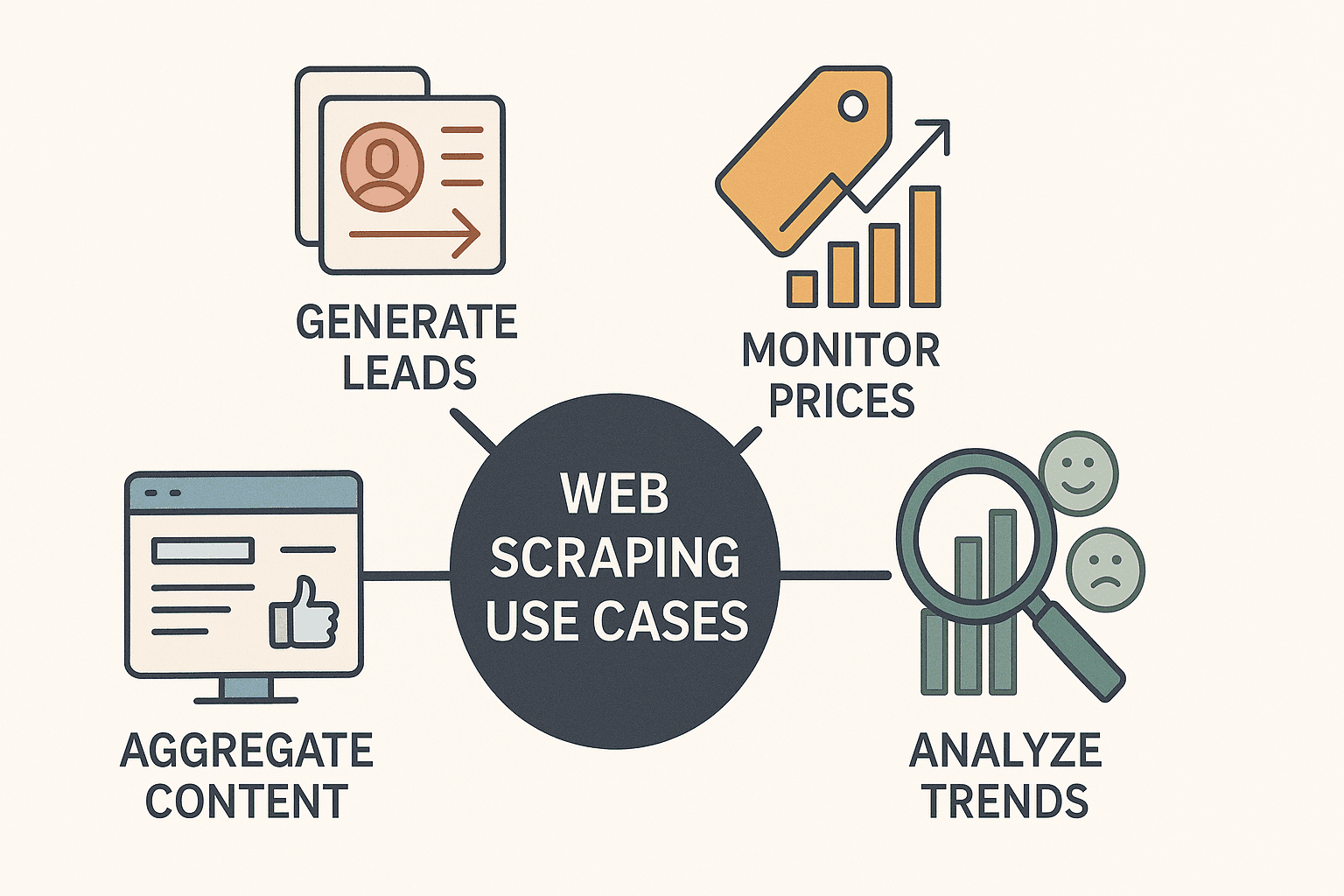

node 网页爬虫对企业团队的价值

说到底,网页爬虫早就不是黑客或者数据科学家的专属技能,而是企业的“数据神器”。各行各业的公司都在用 node 网页爬虫来:

- 获取销售线索: 从企业名录或 LinkedIn 批量提取联系方式,助力销售拓展。

- 监控竞品价格: 实时跟踪商品价格,灵活调整自家定价(每天都在抓取竞品价格)。

- 内容聚合: 自动汇总新闻、评论或社交媒体提及,搭建信息看板。

- 市场趋势分析: 抓取评论、论坛或招聘信息,洞察行业动态和机会。

更重要的是,Node.js 让这些流程变得更快、更灵活、更容易自动化。异步特性让你能同时处理几十甚至上百个页面,JavaScript 生态也让它成为现代网站爬取的首选。

来看几个典型应用场景:

| 应用场景 | 描述与示例 | Node.js 优势 |

|---|---|---|

| 销售线索挖掘 | 批量抓取企业名录中的邮箱、姓名、电话等信息。 | 并发抓取速度快,易与 CRM/API 集成。 |

| 价格监控 | 跟踪电商网站竞品价格,及时调整自家商品定价。 | 异步请求批量处理,易于定时自动化(如每日/每小时)。 |

| 市场趋势研究 | 聚合评论、论坛、社交媒体内容,做情感分析和趋势洞察。 | 数据处理灵活,文本清洗和分析生态丰富。 |

| 内容聚合 | 自动抓取新闻、博客等内容,统一展示在信息面板。 | 实时更新,易与通知工具(如 Slack、邮件)集成。 |

| 竞品分析 | 抓取竞品网站的产品目录、描述、用户评分等信息。 | 可解析复杂 JavaScript 页面,模块化代码支持多页面爬取。 |

Node.js 尤其适合需要处理大量 JavaScript 的网站,这点是 Python 等语言经常搞不定的。有了合适的配置,从“我想要这些数据”到“数据表格已到手”,只需要几分钟。

node 网页爬虫必备工具与库

在动手写代码前,先熟悉下 node 网页爬虫的主力工具:

1. Axios(HTTP 客户端)

- 作用: 发送 HTTP 请求,获取网页内容。

- 适用场景: 需要获取页面原始 HTML 时。

- 优点: API 简洁,基于 Promise,轻松处理重定向和请求头。

- 安装命令:

npm install axios

2. Cheerio(HTML 解析器)

- 作用: 解析 HTML,支持 jQuery 风格选择器查找数据。

- 适用场景: 静态页面,数据直接在 HTML 里。

- 优点: 轻量、速度快,jQuery 用户上手无压力。

- 安装命令:

npm install cheerio

3. Puppeteer(无头浏览器自动化)

- 作用: 后台控制真实 Chrome 浏览器,模拟用户操作。

- 适用场景: JavaScript 动态加载或交互性强的网站(如无限滚动、登录、弹窗等)。

- 优点: 可自动点击、填表、滚动,等脚本执行完再提取数据。

- 安装命令:

npm install puppeteer

补充: 还有像 Playwright(多浏览器自动化)、Apify 的 Crawlee 框架等进阶工具,但对于新手来说,Axios、Cheerio、Puppeteer 就够用了。

前提条件: 请确保你已经装好 Node.js。新建项目可以用 npm init -y,然后安装上面这些库。

实战演练:用 Node 从零搭建你的第一个网页爬虫

现在我们来动手写一个简单爬虫,用 Axios 和 Cheerio 抓取 这个演示站点的图书数据。

步骤 1:获取页面 HTML

1import axios from 'axios';

2import { load } from 'cheerio';

3const startUrl = 'http://books.toscrape.com/';

4async function scrapePage(url) {

5 const resp = await axios.get(url);

6 const html = resp.data;

7 const $ = load(html);

8 // ...后续提取数据

9}步骤 2:解析并提取数据

1$('.product_pod').each((i, element) => {

2 const title = $(element).find('h3').text().trim();

3 const price = $(element).find('.price_color').text().replace('£', '');

4 const stock = $(element).find('.instock').text().trim();

5 const ratingClass = $(element).find('p.star-rating').attr('class') || '';

6 const rating = ratingClass.split(' ')[1];

7 const relativeUrl = $(element).find('h3 a').attr('href');

8 const bookUrl = new URL(relativeUrl, startUrl).href;

9 console.log({ title, price, rating, stock, url: bookUrl });

10});步骤 3:处理分页

1const nextHref = $('.next > a').attr('href');

2if (nextHref) {

3 const nextUrl = new URL(nextHref, url).href;

4 await scrapePage(nextUrl);

5}步骤 4:保存数据

数据采集完后,可以用 Node 的 fs 模块写入 JSON 或 CSV 文件。

1import fs from 'fs';

2// 爬取结束后:

3fs.writeFileSync('books_output.json', JSON.stringify(booksList, null, 2));

4console.log(`共抓取了 ${booksList.length} 本书。`);这样,一个基础的 Node.js 网页爬虫就搞定了!这种方式适合静态网站,但遇到 JavaScript 动态加载页面怎么办?

动态页面爬取:Node + Puppeteer 实战

有些网站喜欢把数据藏在 JavaScript 里,用 Axios 和 Cheerio 抓取时可能啥都拿不到。这时候就得用 Puppeteer。

为啥用 Puppeteer? 它能启动一个真实(无头)浏览器,加载页面、等所有脚本跑完,再抓取渲染后的内容,就像真人操作一样。

Puppeteer 示例脚本

1import puppeteer from 'puppeteer';

2async function scrapeWithPuppeteer(url) {

3 const browser = await puppeteer.launch({ headless: true });

4 const page = await browser.newPage();

5 await page.goto(url, { waitUntil: 'networkidle2' });

6 await page.waitForSelector('.product_pod'); // 等待数据加载

7 const data = await page.evaluate(() => {

8 let items = [];

9 document.querySelectorAll('.product_pod').forEach(elem => {

10 items.push({

11 title: elem.querySelector('h3').innerText,

12 price: elem.querySelector('.price_color').innerText,

13 });

14 });

15 return items;

16 });

17 console.log(data);

18 await browser.close();

19}什么时候用 Cheerio/Axios,什么时候用 Puppeteer?

- Cheerio/Axios: 速度快、资源占用低,适合静态内容。

- Puppeteer: 速度慢点,但能搞定动态或交互页面(比如登录、无限滚动等)。

小建议:优先试试 Cheerio/Axios,抓不到数据再上 Puppeteer。

进阶技巧:分页、登录与数据清洗

基础搞定后,可以挑战更复杂的场景。

分页处理

通过检测“下一页”链接循环抓取,或者根据 URL 规律自动生成。

1let pageNum = 1;

2while (true) {

3 const resp = await axios.get(`https://example.com/products?page=${pageNum}`);

4 // ...提取数据

5 if (!hasNextPage) break;

6 pageNum++;

7}自动化登录

用 Puppeteer 可以像用户一样自动填写登录表单:

1await page.type('#username', 'myUser');

2await page.type('#password', 'myPass');

3await page.click('#loginButton');

4await page.waitForNavigation();数据清洗

爬取后可以这样清洗数据:

- 去重(用 Set 或按唯一键过滤)

- 格式化数字、日期、文本

- 处理缺失值(用 null 填充或跳过不完整记录)

正则表达式和 JavaScript 字符串方法会很有用。

node 网页爬虫最佳实践:避坑与高效建议

网页爬虫虽然强大,但也有不少坑。下面这些建议能帮你高效避雷:

- 遵守 robots.txt 和网站协议: 先查查目标站是否允许爬虫,别抓到不该抓的地方。

- 控制请求频率: 别一秒钟发几百个请求,适当加延迟、随机化,模拟真人访问()。

- 轮换 User-Agent 和 IP: 用真实请求头,大规模爬取时可以切换 IP 防止被封。

- 异常处理: 捕获错误、重试失败请求、记录日志方便排查。

- 数据校验: 检查缺失或异常字段,及时发现网页结构变化。

- 代码模块化: 把抓取、解析、保存逻辑分开,选择器和 URL 用配置文件管理。

最重要的是——请文明爬取,互联网是大家的资源,没人喜欢“野蛮”爬虫。

Thunderbit 与自建 node 爬虫对比:何时自研,何时用工具?

最后聊聊自建爬虫和用 这类工具的区别。

自建 Node.js 爬虫:

- 优点: 完全自主,灵活定制,能深度集成到任意业务流程。

- 缺点: 需要有编程基础,开发和维护都挺花时间,网站结构一变就容易失效。

Thunderbit AI 网页爬虫:

- 优点: 无需写代码,AI 自动识别字段,支持子页面和分页,一键导出到 Excel、Google Sheets、Notion 等()。不用自己维护,AI 会自动适应网页变化。

- 缺点: 极少数高度定制或复杂场景灵活性略低(但已经能覆盖 99% 商业需求)。

对比一览:

| 对比维度 | 自建 Node.js 爬虫 | Thunderbit AI 网页爬虫 |

|---|---|---|

| 技术门槛 | 需编程能力 | 无需代码,点选即可 |

| 搭建时间 | 数小时到数天 | 几分钟(AI 自动推荐字段) |

| 维护成本 | 持续维护(网页变动) | 极低(AI 自动适配) |

| 动态内容处理 | 需手动配置 Puppeteer | 内置支持 |

| 分页/子页面 | 需手动编码 | 一键支持 |

| 数据导出 | 需手写导出代码 | 一键导出到 Excel、Sheets、Notion |

| 成本 | 免费(但需开发/代理等成本) | 免费套餐,按量付费 |

| 适合人群 | 开发者、需自定义逻辑 | 商业用户、追求高效 |

Thunderbit 对于销售、市场、运营等需要快速获取数据的团队来说,绝对是省时省力的利器。对于开发者,也能用它快速原型或处理日常爬取任务,省得重复造轮子。

总结与要点回顾:开启你的 node 网页爬虫之旅

node 网页爬虫能帮你解锁互联网隐藏的数据宝藏——不管是构建销售名单、监控价格,还是驱动下一个创新项目。记住这些要点:

- Node.js + Cheerio/Axios 适合静态页面,Puppeteer 是动态/JS 密集型页面的利器。

- 商业价值显著: 用网页爬虫做数据驱动决策,企业能获得实实在在的提升,比如 甚至国际市场翻倍。

- 从简单做起: 先搭建基础爬虫,逐步加上分页、登录自动化、数据清洗等功能。

- 选对工具: 想要快速、无代码爬取和即时结果, 是首选;需要深度定制和集成,自己写 Node.js 脚本更灵活。

- 负责任地爬取: 遵守网站规则,合理控制爬虫,保持代码整洁易维护。

准备好了吗?试着自己写个 Node.js 爬虫,或者,体验网页数据采集的高效与便捷。如果想了解更多实用技巧,欢迎访问 ,获取更多 AI 爬虫深度教程和最新资讯。

祝你爬取顺利,数据新鲜、结构清晰,始终领先一步!

常见问题解答

1. 什么是 node 网页爬虫,为什么 Node.js 适合做爬虫?

node 网页爬虫就是用 Node.js 自动化从网站提取数据。Node.js 擅长处理异步请求,配合 Puppeteer 等工具,能高效抓取 JavaScript 动态页面。

2. 什么时候用 Cheerio/Axios,什么时候用 Puppeteer?

静态页面、数据直接在 HTML 里的,用 Cheerio 和 Axios 更快更省资源。遇到内容由 JavaScript 加载、需要交互(比如登录、滚动)时,用 Puppeteer 更合适。

3. node 网页爬虫的常见商业应用有哪些?

主要包括销售线索挖掘、竞品价格监控、内容聚合、市场趋势分析、产品目录采集等。Node.js 能让这些任务高效且易扩展。

4. node 网页爬虫常见的坑有哪些,如何规避?

常见问题有被反爬封禁、网页结构变动、数据质量难控等。建议控制请求频率、轮换 User-Agent/IP、校验数据、代码模块化等方式规避。

5. Thunderbit 和自建 Node.js 爬虫有何区别?

Thunderbit 提供无代码、AI 驱动的网页爬虫,自动识别字段、支持子页面和分页,适合追求效率的商业用户。自建 Node.js 爬虫适合需要高度定制或深度集成的开发者。

想获取更多实用教程和灵感,欢迎访问 ,并订阅我们的 获取实操演示。

延伸阅读