到了 2025 年,网页数据早已不是“可有可无”的资源,而是企业战略的核心动力。从电商巨头实时盯紧竞品价格,到销售团队自动挖掘最新潜在客户,大家都把公开网页数据当成数字时代的“石油”。数据也很能说明问题:,而超过 。虽然 Python 很火,但,特别是在对稳定性和系统集成要求极高的企业环境里。

作为一个长期混迹在 SaaS 和自动化领域的老兵,我太清楚 Java 网页爬虫对企业运营的推动力了。但我也见过不少团队被底层代码拖慢节奏,或者被动态网页和反爬机制搞得焦头烂额。所以我想带来一份实用的 2025 Java 网页爬虫进阶指南,重点讲讲怎么把传统代码和现代 AI 工具(比如 )结合起来。不管你是开发者、运营负责人,还是只想高效拿数据的业务同学,这份指南都能帮你少踩坑。

作为一个长期混迹在 SaaS 和自动化领域的老兵,我太清楚 Java 网页爬虫对企业运营的推动力了。但我也见过不少团队被底层代码拖慢节奏,或者被动态网页和反爬机制搞得焦头烂额。所以我想带来一份实用的 2025 Java 网页爬虫进阶指南,重点讲讲怎么把传统代码和现代 AI 工具(比如 )结合起来。不管你是开发者、运营负责人,还是只想高效拿数据的业务同学,这份指南都能帮你少踩坑。

什么是 Java 网页爬虫?一听就懂的解释

简单来说,Java 网页爬虫就是用 Java 代码自动帮你从网站上抓数据。你可以把它想象成一个超级高效的虚拟实习生,能在极短时间内刷成千上万网页,把你要的数据整整齐齐搬进表格——而且永远不喊累、不出错,速度只看你的网速。

它的基本流程其实很直观:

- 向目标网站发请求(就像你用浏览器打开网页一样)。

- 下载网页的 HTML 内容(也就是页面的源代码)。

- 解析 HTML,让程序能看懂网页结构。

- 提取你关心的数据(比如商品名、价格、邮箱等)。

- 保存结果,可以导出成 CSV、Excel、数据库,甚至 Google Sheets。

其实你不用是资深程序员也能明白这些原理。有了合适的工具和一点点指引,业务同学一样可以自动化采集数据,把杂乱网页变成有价值的洞察。

2025 年 Java 网页爬虫的企业价值

网页爬虫早就不是极客的玩具,而是企业必备的生产力神器。来看看企业怎么用 Java 网页爬虫抢占先机,以及它带来的实际回报。

| 网页爬虫应用场景 | 业务收益(ROI) | 典型行业 |

|---|---|---|

| 竞品价格监控 | 实时掌握市场价格动态,快速反应带来20%+ 销售增长 | 电商、零售 |

| 潜客挖掘与销售情报 | 自动生成最新客户名单,人工调研时间减少 70% | B2B 销售、市场、招聘 |

| 市场调研与趋势分析 | 抢先发现行业趋势,5–15% 收入提升,10–20% 市场投放 ROI 增长 | 消费品、营销机构 |

| 金融与投资数据 | 获取另类数据辅助决策,网页“另类数据”市场规模超50 亿美元 | 金融、对冲基金、金融科技 |

| 流程自动化与监控 | 日常数据采集自动化,成本降低 73%,部署速度提升 85% | 房地产、供应链、政府 |

()

为什么选 Java?因为它天生适合大规模、稳定和系统集成。很多企业的数据管道本来就是 Java 写的,直接接入网页爬虫毫无障碍。而且,Java 的多线程和异常处理能力让它在大批量任务(比如每天抓上千网页)时表现特别稳。

Java 网页爬虫的原理和独特优势

我们来拆解下典型 Java 网页爬虫的核心流程:

- HTTP 请求: Java 常用 JSoup 或 Apache HttpClient 这类库来抓网页。你可以自定义请求头、用代理,甚至模拟真实浏览器,降低被封风险。

- HTML 解析: JSoup 这类库能把原始 HTML 变成“DOM”树结构,方便用 CSS 选择器精准定位数据。

- 数据提取: 你可以设定规则(比如“抓所有

<span class='price'>元素”)来拿到目标信息。 - 数据存储: 支持导出成 CSV、Excel、JSON 或直接写数据库。

Java 在网页爬虫领域的独特优势

- 多线程并发: Java 能同时抓和处理大量网页,效率直接拉满。相比之下,Python 的 GIL 机制在高并发场景下容易卡脖子。

- 高性能: Java 是编译型语言,处理大规模和高内存任务时更稳定。

- 企业级集成: Java 爬虫能无缝对接现有 CRM、ERP、数据库等系统,省去各种适配麻烦。

- 健壮的异常处理: Java 的强类型和异常机制让爬虫更好维护,适合长期跑的项目。

如果你要搭建关键数据管道,Java 的稳定性和可扩展性绝对是首选。

Java 网页爬虫常用库和框架推荐

Java 生态里有不少好用的网页爬虫库,最常见的三款是 JSoup、HtmlUnit 和 Selenium。各有各的强项:

| 库/框架 | 支持 JavaScript? | 易用性 | 性能表现 | 适用场景 |

|---|---|---|---|---|

| JSoup | ❌(不支持 JS) | 非常简单 | 高 | 静态页面、快速任务、轻量级爬取 |

| HtmlUnit | ⚠️ 部分支持 | 中等 | 一般 | 简单 JS、表单提交、无头爬取 |

| Selenium | ✅ 完全支持 | 中等/略难 | 单页性能较低 | JS 密集型网站、交互/动态页面 |

()

JSoup:静态网页解析首选

是我最常用的爬虫库。它轻量、易上手,非常适合数据直接写在 HTML 里的静态页面。

示例:

1Document doc = Jsoup.connect("https://www.scrapingcourse.com/ecommerce/").get();

2String bannerTitle = doc.select("div.site-title").text();

3System.out.println("Banner: " + bannerTitle);就是这么简单。如果你要抓博客、商品列表或目录类页面,JSoup 是理想选择。

HtmlUnit:模拟浏览器,搞定简单动态内容

是一款 Java 实现的无头浏览器。它能处理部分 JavaScript、表单填写和按钮点击,无需打开真实浏览器窗口。

适用场景: 需要登录、处理基础动态内容但不想用 Selenium 时。

示例:

1WebClient webClient = new WebClient();

2HtmlPage page = webClient.getPage("https://example.com/login");

3// ... 填表并提交 ...Selenium:对付 JS 密集和交互型网站

是重量级选手。它能驱动真实浏览器(比如 Chrome、Firefox),几乎能搞定所有人类用户能访问的网站,包括全 JS 构建的页面。

适用场景: 现代 Web 应用、无限滚动、需要模拟点击和等待等复杂交互。

示例:

1WebDriver driver = new ChromeDriver();

2driver.get("https://www.scrapingcourse.com/ecommerce/");

3List<WebElement> products = driver.findElements(By.cssSelector("li.product"));

4// ... 提取数据 ...

5driver.quit();Thunderbit 助力 Java 网页爬虫:可视化自动化+代码双剑合璧

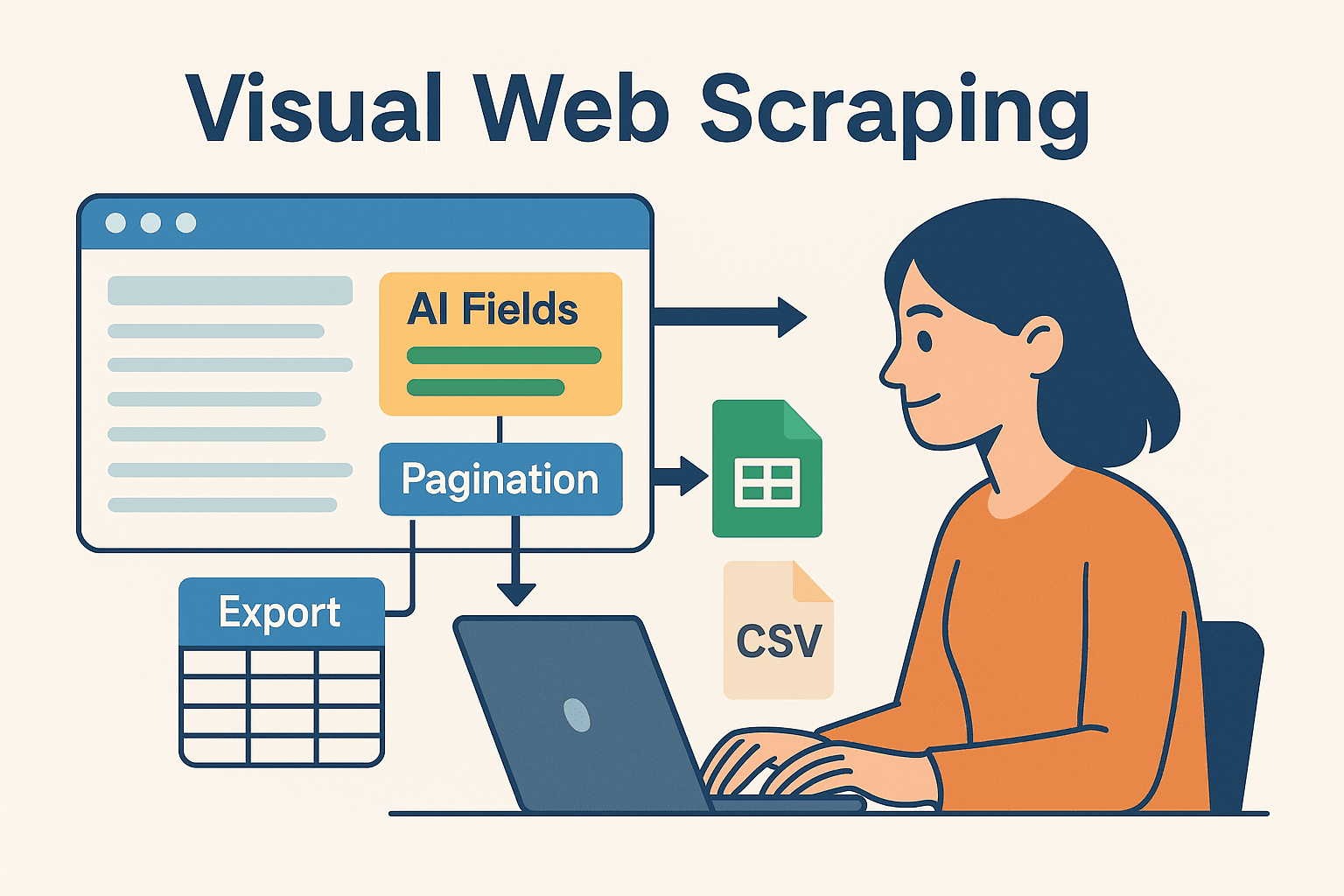

对于不想天天写代码的业务团队和个人用户, 是一款 AI 驱动的零代码网页爬虫。你可以直接在浏览器里可视化配置爬取任务,数据一键导出到 Excel、Google Sheets、Airtable 或 Notion。

为什么要把 Thunderbit 和 Java 结合?

- AI 智能字段推荐: Thunderbit 的“AI 智能识别”能自动分析网页,推荐最有价值的数据字段,无需手动查 HTML 或写选择器。

- 子页面自动爬取: 需要更详细的数据?Thunderbit 能自动访问每个子页面(比如商品详情页),让你的数据更丰富。

- 一键模板: 针对热门网站(如亚马逊、Zillow、LinkedIn)内置模板,开箱即用。

- 便捷导出: 数据爬取后可秒级导出,方便 Java 程序后续处理、分析或集成。

Thunderbit 能大大提升原型开发效率,轻松搞定复杂网页,也让非开发者能自己动手拿数据。对开发者来说,它还能帮你省去重复、易碎的爬虫环节,把精力集中在业务逻辑上。

Thunderbit + Java:复杂项目的高效组合

我常用的高效流程:

- 用 Thunderbit 快速原型: 通过 Chrome 插件可视化配置爬虫,AI 自动识别字段、处理分页,数据导出到 Google Sheets 或 CSV。

- Java 处理数据: 用 Java 代码读取导出的数据(Sheets、CSV 或 Airtable),做后续处理、分析或和企业系统集成。

- 自动化与定时: 利用 Thunderbit 内置定时功能保持数据实时更新,Java 流水线自动获取最新数据。

这种混合模式让你既能享受 AI 零代码爬虫的灵活和速度,又能用 Java 后端做强力处理。

这种混合模式让你既能享受 AI 零代码爬虫的灵活和速度,又能用 Java 后端做强力处理。

实战教程:手把手写第一个 Java 网页爬虫

下面我们来实操一下,搭建一个简单的 Java 网页爬虫。

Java 环境准备

- 安装 Java(JDK): 推荐用 Java 17 或 21。

- 配置 Maven: 方便管理依赖。

- 选择开发工具: IntelliJ IDEA、Eclipse 或 VSCode 都很合适。

- 在

pom.xml里加上 JSoup 依赖:1<dependency> 2 <groupId>org.jsoup</groupId> 3 <artifactId>jsoup</artifactId> 4 <version>1.16.1</version> 5</dependency>

编写并运行你的爬虫

我们以抓一个电商演示站的商品名称和价格为例。

1import org.jsoup.Jsoup;

2import org.jsoup.nodes.Document;

3import org.jsoup.select.Elements;

4import org.jsoup.nodes.Element;

5public class ProductScraper {

6 public static void main(String[] args) {

7 String url = "https://www.scrapingcourse.com/ecommerce/";

8 try {

9 Document doc = Jsoup.connect(url)

10 .userAgent("Mozilla/5.0")

11 .get();

12 Elements productElements = doc.select("li.product");

13 for (Element productEl : productElements) {

14 String name = productEl.selectFirst("h2").text();

15 String price = productEl.selectFirst("span.price").text();

16 System.out.println(name + " -> " + price);

17 }

18 } catch (Exception e) {

19 e.printStackTrace();

20 }

21 }

22}小贴士: 一定要设置 user-agent 模拟真实浏览器,不然有些网站会屏蔽默认的 Java 请求。

数据导出与应用

- 导出为 CSV: 用

FileWriter或 OpenCSV 库写 CSV 文件。 - 导出为 Excel: 用 Apache POI 处理 .xls/.xlsx 文件。

- 数据库集成: 用 JDBC 直接写数据库。

- Google Sheets: 从 Thunderbit 导出后,用 Java 的 Google Sheets API 读取。

Java 网页爬虫常见难题与解决办法

网页爬虫并不是一路顺风,常见挑战和应对方法如下:

- IP 封禁与限流: 降低请求频率(用

Thread.sleep()),轮换代理,随机延迟。大规模任务建议用代理服务。 - 验证码与反爬机制: 用 Selenium 模拟真实用户,或接入第三方反爬 API。有时候用 Thunderbit 云端爬取也能绕过这些障碍。

- 动态内容抓不到: 如果 JSoup 抓不到数据,说明内容是 JS 动态加载的。可以换 Selenium 或 HtmlUnit,或者直接分析网站的 API。

- 网页结构变动: 代码要写得灵活,定期监控爬虫并及时调整。Thunderbit 的 AI 能快速适应页面变化,只需重新跑“AI 智能识别”就行。

- 登录与会话管理: 登录后抓取要妥善管理 cookie 和 session。Selenium 和 Thunderbit(登录 Chrome 后)都能搞定需要认证的页面。

进阶技巧:让 Java 网页爬虫更高效

想进一步提升效率?可以试试这些高级玩法:

- 多线程并发: 用 Java 的

ExecutorService并行抓多个页面,但别太激进以免被封。 - 定时调度: Java 可以用 Quartz Scheduler,或者直接用 Thunderbit 云端自然语言定时(比如“每周一上午 9 点”)。

- 云端扩展: 大型任务可以在云端跑无头浏览器,或者分布式部署多台机器。

- 混合工作流: 难搞的网站用 Thunderbit,常规网站用 Java 代码,最后统一汇总到数据仓库。

- 监控与日志: 用 Java 日志框架实时监控爬虫健康,及时发现和处理异常。

总结与核心要点

网页数据就是新一代的“黄金”,而 Java 依然是企业级爬虫的利器,特别适合追求稳定性、扩展性和系统集成的团队。核心流程其实很简单:抓取、解析、提取、输出。借助 JSoup、HtmlUnit、Selenium 等库,既能搞定基础目录,也能拿下复杂的 JS 网站。

但你完全不用事事亲力亲为。像 这样的 AI 可视化工具,让你能更快原型、灵活适应和大规模扩展爬虫项目。我的建议是:大胆结合代码和零代码工具。用 Thunderbit 快速搭建和维护,用 Java 流水线做深度处理。

想体验 Thunderbit 如何提升你的数据采集效率?,几分钟内就能爬第一个网站。如果想了解更多干货,欢迎访问 ,获取深度教程和最新自动化资讯。

祝你爬虫顺利,数据永远新鲜、结构化、可用!

常见问题解答

1. 2025 年 Java 还适合做网页爬虫吗?

当然适合。虽然 Python 适合写脚本,但 Java 依然是企业级、大规模、长期稳定爬虫项目的首选,特别是在集成和多线程场景下优势明显。

2. JSoup、HtmlUnit、Selenium 怎么选?

静态页面用 JSoup,简单动态内容或表单用 HtmlUnit,JS 密集或交互型网站用 Selenium。根据目标网站复杂度灵活选。

3. 如何避免爬虫被封?

降低请求频率、轮换代理、设置真实 user-agent、模拟人类行为。遇到难搞的网站,可以用 Thunderbit 云端爬取或接入反爬 API。

4. Thunderbit 和 Java 能协同工作吗?

完全没问题。用 Thunderbit 可视化配置和定时爬取,导出数据后用 Java 代码处理或集成,业务和开发都能受益。

5. Java 网页爬虫最快的入门方式?

搭建 Java 和 Maven 环境,添加 JSoup,先试着抓简单网站。复杂任务或快速原型可以用 ,AI 自动采集后再用 Java 处理。

想获取更多技巧、代码示例或自动化干货?欢迎浏览 ,或订阅我们的 ,获取实战教程和最新爬虫技术。 延伸阅读