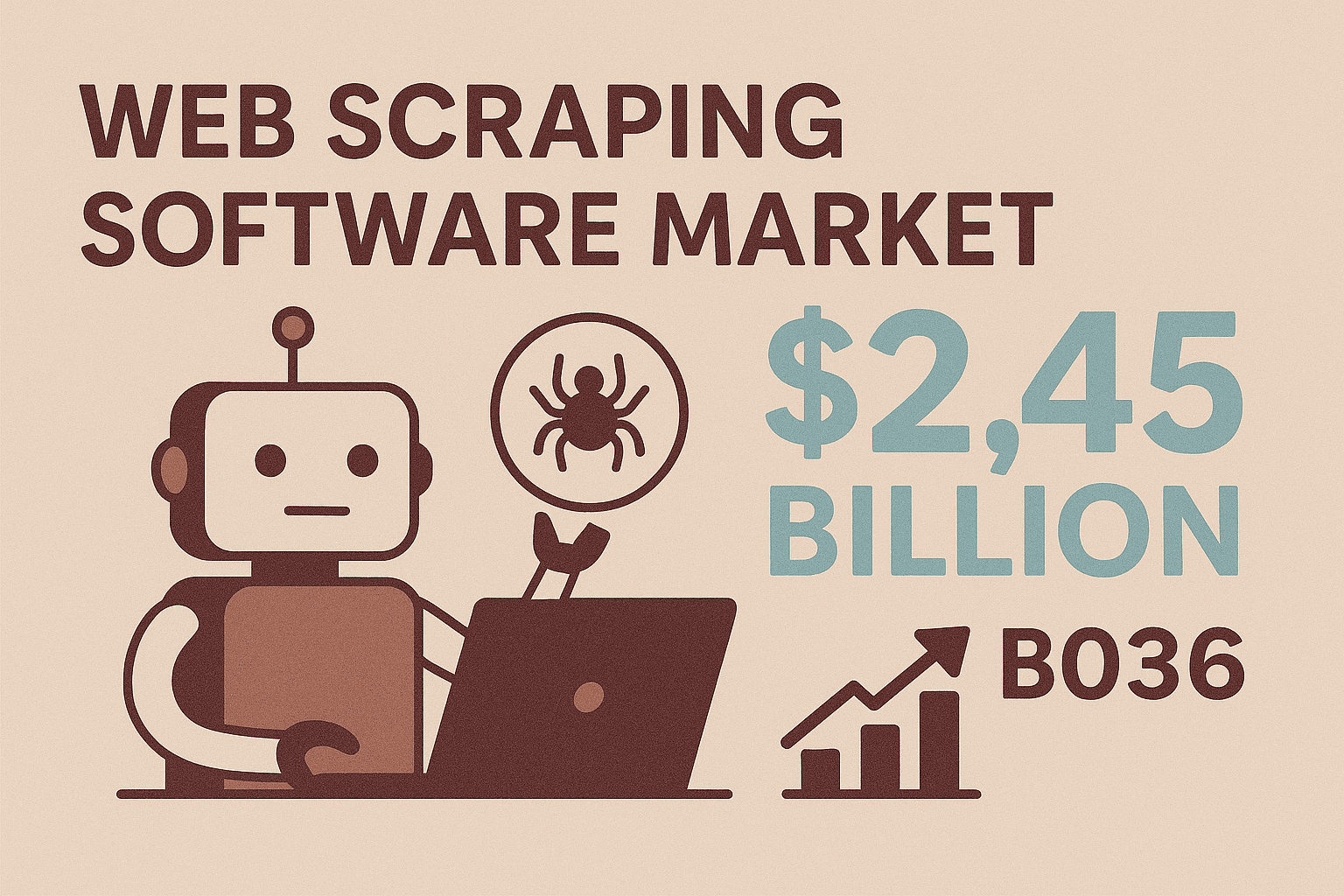

想象一下,脚本在网页上飞速采集数据,而你只需要轻松喝着咖啡,是不是很有成就感?以前,“屏幕爬取”还意味着不停地复制粘贴,或者总是找 IT 帮忙导出数据。现在,java 屏幕爬取已经被广泛用在销售线索挖掘、实时价格监控等场景,而且早就不只是开发者的专利。随着网页爬虫软件市场预计到 ,越来越多企业都在寻找自动化、灵活的数据获取方式,把开放网络变成有用的信息。

不管你是业务、销售还是开发,只要想从没有 API 的网站提取结构化数据,java 屏幕爬取都是一项值得掌握的技能。本文会带你了解基本原理,介绍主流 Java 库的用法,解决常见难题,还会展示像 这样的无代码工具如何大幅提升效率。不管你是想自己写爬虫,还是希望用 AI 自动完成繁琐工作,这里都能找到实用建议和落地方法,帮你更聪明地采集数据。

Java 屏幕爬取基础:什么是 Screen Scraping?为什么重要?

先来聊聊基本概念。java 屏幕爬取,就是用 Java 代码自动化地从网页上提取信息——本质上就是模拟人类浏览网页并获取所需数据。和 API 不同,API(如果有的话)一般直接给你结构化数据,而屏幕爬取则是直接和网页前端打交道,就像你用 Chrome 或 Firefox 浏览一样。

为什么这很重要?因为大多数网站——尤其是电商、房产、B2B 行业目录——根本不提供公开 API 或批量导出功能。屏幕爬取就是解锁这些“被困住”的数据的最佳方式。Java 作为开发语言,工具丰富又灵活:你可以自定义规则、处理登录、模拟点击,甚至解析复杂的动态内容。所以当现成工具搞不定,或者你需要针对业务场景定制采集逻辑时,java 屏幕爬取就是首选。

而且市场需求还在持续增长。采用现代爬取工具(尤其是 AI 驱动的工具)的企业,数据采集效率可提升 ,准确率高达 99%。这意味着大量重复劳动都能被自动化释放出来。

Java 屏幕爬取的核心业务场景

那 java 屏幕爬取在实际业务中到底能干啥?下面这些场景最常见:

| 应用场景 | 业务价值 | 示例场景 |

|---|---|---|

| 销售线索挖掘 | 自动收集潜在客户信息,拓展销售渠道,节省大量时间 | 从 LinkedIn 或行业目录批量采集姓名、职位、邮箱、电话 |

| 价格监控 | 实时跟踪竞争对手价格,支持动态定价,减少分析师工作量 | 爬取电商网站每日价格和库存变动 |

| 产品数据采集 | 聚合多渠道商品信息,保持商品目录实时更新 | 从供应商或竞品网站抓取商品名称、参数、图片、评价 |

| 市场调研 | 批量获取实时数据,助力趋势分析 | 爬取数百条产品评价或房产信息用于市场洞察 |

| 竞品分析 | 发现行业动态,监控新功能,分析用户口碑 | 聚合竞品产品页、客户评价或相关新闻 |

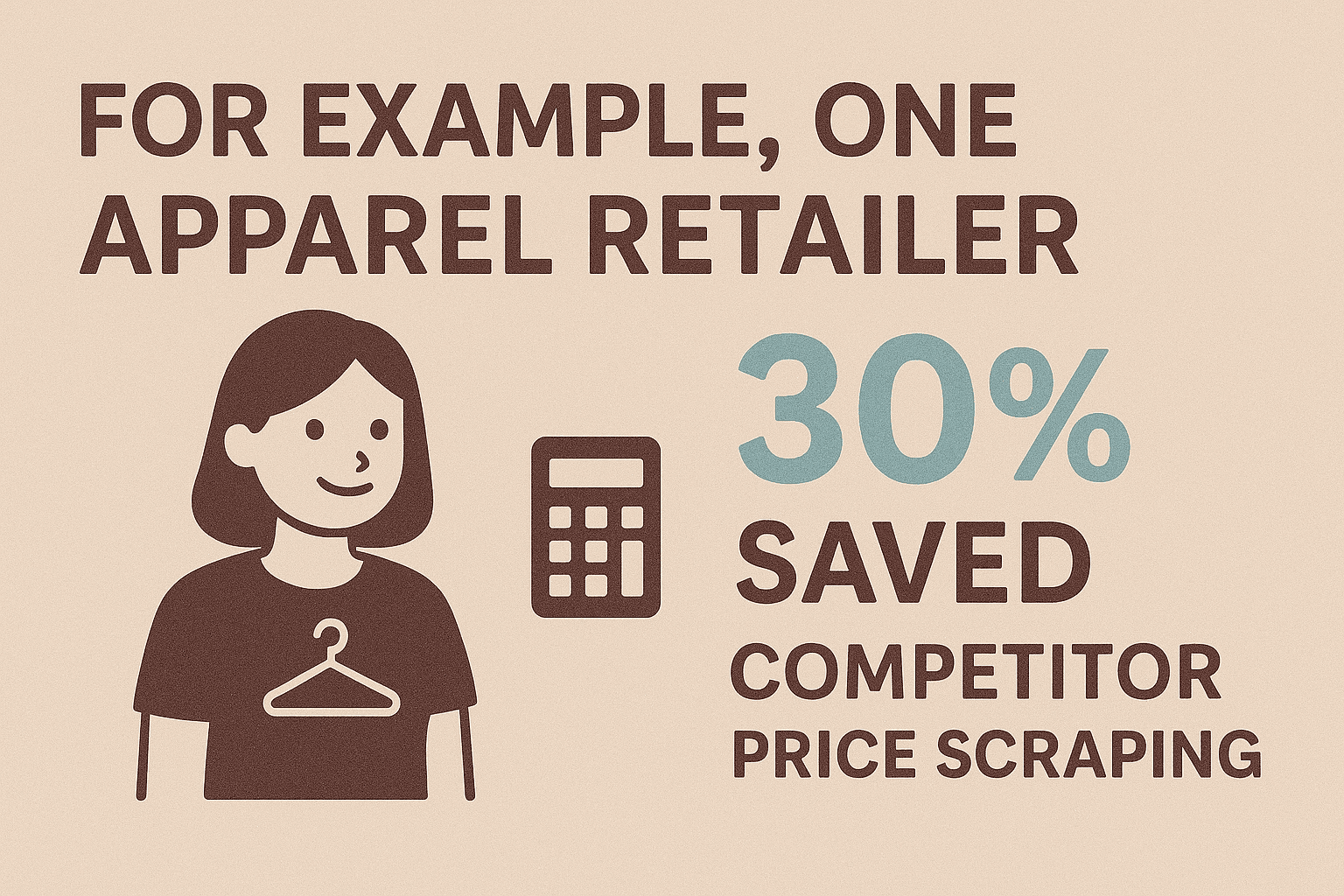

比如,某服装零售商通过自动化竞品价格爬取,,并获得了实时定价洞察。销售团队用爬虫快速构建客户名单,原本需要几周才能手动整理。而全球 的背景下,电商运营者更是离不开高效的数据采集。

总之,只要你需要网页数据而又没有 API,屏幕爬取往往是唯一可行的解决方案。

入门指南:Java 屏幕爬取常用工具与库

Java 生态有很多好用的爬取库,就算不是专业开发者也能轻松上手。下面这些是最受欢迎的:

1. Selenium WebDriver

- 功能简介: 自动化真实浏览器(如 Chrome、Firefox),能和动态、JS 密集型网站交互。

- 适用场景: 需要登录、点击、模拟用户操作的网站。

- 优点: 能处理人眼可见的所有内容,适合复杂流程。

- 缺点: 速度较慢,占用资源多,需要安装浏览器驱动。

示例代码:

1WebDriver driver = new ChromeDriver();

2driver.get("https://example.com/page");

3String title = driver.getTitle();

4System.out.println("Page title: " + title);

5driver.close();2. Jsoup

- 功能简介: 通过简单的 API 抓取并解析静态 HTML。

- 适用场景: 快速采集静态页面、博客、新闻、商品列表等。

- 优点: 轻量、速度快、易用,对不规范 HTML 兼容性好。

- 缺点: 无法执行 JavaScript,不能处理 AJAX 加载内容。

示例代码:

1Document doc = Jsoup.connect("https://example.com/products").get();

2Elements names = doc.select(".product-name");

3for (Element name : names) {

4 System.out.println(name.text());

5}3. HtmlUnit

- 功能简介: Java 实现的无头浏览器,支持部分 JavaScript。

- 适用场景: 需要浏览器行为但不想用 Selenium 的中等动态网站。

- 优点: 无需外部浏览器,支持 HTTP、Cookie、简单脚本。

- 缺点: 对现代 JS 框架支持不如 Selenium。

示例代码:

1WebClient webClient = new WebClient(BrowserVersion.CHROME);

2HtmlPage page = webClient.getPage("https://example.com");

3DomElement button = page.getElementById("next-btn");

4page = button.click();

5String content = page.asText();4. 其他推荐

- WebMagic、Gecco: 适合大规模爬取和数据抽取的高级框架。

- Htmleasy: 极简易用,适合快速原型开发。

Java 屏幕爬取库对比

| 库名称 | 动态内容支持 | 易用性 | 最佳应用场景 |

|---|---|---|---|

| Selenium | 支持 | 中等 | JS 密集型网站、登录、交互流程 |

| Jsoup | 不支持 | 简单 | 静态页面、快速原型 |

| HtmlUnit | 部分支持 | 中等 | 轻量无头爬取、简单 JS |

| Htmleasy | 不支持 | 非常简单 | 静态页面、快速数据采集 |

| WebMagic/Gecco | 不支持(JS) | 中等 | 大规模爬取、多页面抽取 |

快速上手清单:

- 选好库(动态用 Selenium,静态用 Jsoup)。

- 配置 Java 项目(Maven/Gradle 添加依赖)。

- 用浏览器开发者工具分析网页结构。

- 编写测试爬虫,抓取并打印简单元素。

- 完善数据提取逻辑,处理分页等。

- 导出数据(CSV、JSON 或直接写入数据库)。

实战演练:用 Java 构建你的第一个屏幕爬虫

下面用 Jsoup 举个例子,教你如何从电商演示页面提取商品名称和价格。

步骤 1:项目配置

在 Maven pom.xml 里加上 Jsoup 依赖:

1<dependency>

2 <groupId>org.jsoup</groupId>

3 <artifactId>jsoup</artifactId>

4 <version>1.16.1</version>

5</dependency>步骤 2:抓取网页

1String url = "https://www.scrapingcourse.com/ecommerce/";

2Document doc = Jsoup.connect(url).get();步骤 3:解析并提取数据

1Elements productElements = doc.select("li.product");

2for (Element productEl : productElements) {

3 String name = productEl.selectFirst(".woocommerce-loop-product__title").text();

4 String price = productEl.selectFirst(".price").text();

5 System.out.println(name + " -> " + price);

6}步骤 4:处理分页

1Element nextLink = doc.selectFirst("a.next");

2while (nextLink != null) {

3 String nextUrl = nextLink.absUrl("href");

4 doc = Jsoup.connect(nextUrl).get();

5 // 重复数据提取逻辑

6 nextLink = doc.selectFirst("a.next");

7}步骤 5:导出数据(以 CSV 为例)

1FileWriter csvWriter = new FileWriter("products.csv");

2csvWriter.append("Product Name,Price\n");

3for (Element productEl : productElements) {

4 String name = ...;

5 String price = ...;

6 csvWriter.append("\"" + name + "\",\"" + price + "\"\n");

7}

8csvWriter.flush();

9csvWriter.close();或者导出为 JSON:

1List<Product> products = new ArrayList<>();

2// 在循环中填充 products

3Gson gson = new Gson();

4String jsonOutput = gson.toJson(products);

5Files.write(Paths.get("products.json"), jsonOutput.getBytes());数据输出格式选择:JSON、CSV 及更多

- CSV: 适合表格分析、快速查看或和非技术团队共享。

- JSON: 适合程序处理、API 或嵌套数据存储。

- Excel: 需要原生

.xlsx文件可以用 Apache POI。 - 数据库: 通过 JDBC 直接写入,实现持久化存储。

根据后续需求选合适格式。大多数业务用户推荐用 CSV 或 Excel。

常见难题与解决方案:Java 屏幕爬取实战经验

屏幕爬取并不是一帆风顺,常见问题和应对方法如下:

1. 动态内容(JavaScript/AJAX)

- 问题: 数据页面渲染后才加载,Jsoup 抓不到。

- 解决: 用 Selenium 控制真实浏览器,或者分析 AJAX 请求用 Java 模拟。

2. 反爬机制

- 问题: 网站封禁或限制自动请求。

- 解决: 合理设置抓取频率,随机 User-Agent,轮换 IP,模拟人类行为。大规模爬取可以用代理服务或 Selenium 隐身插件。

3. 网站结构变动

- 问题: HTML 布局变化导致选择器失效。

- 解决: 统一管理选择器,优先用稳定的 CSS 类或 data 属性,记录错误方便排查,及时更新爬虫。

4. 数据清洗与质量

- 问题: 格式不统一、缺失值或文本杂乱。

- 解决: 用 Java 字符串处理和正则表达式实时清洗,规范格式(如电话、价格),优雅处理空值。

5. 性能与扩展性

- 问题: 大量页面爬取速度慢。

- 解决: 利用 Java 并发工具(ExecutorService、线程池)并行请求,但注意不要压垮目标网站。结果流式写入文件,避免内存溢出。

更多最佳实践可以参考 。

为什么 Thunderbit 是 Java 屏幕爬取的最佳拍档?

说到痛点,维护绝对是大难题。用 Java 写爬虫,遇到网页结构变动或反爬机制时,维护和更新都很耗时。这时候, 就能帮你大大减轻负担。

Thunderbit 是一款 AI 驱动的无代码网页爬虫 Chrome 扩展,专为业务、销售、市场和任何想自动化网页数据采集的人设计,无需写一行代码。它对 Java 开发者和非技术用户都非常友好:

- AI 智能字段识别: 一键“AI 推荐字段”,Thunderbit 自动分析页面,智能推荐最佳采集列(如商品名、价格、邮箱等)。

- 两步采集: 一键让 AI 找数据,再点一次即可采集,无需手动设置选择器或写脚本。

- 子页面采集: Thunderbit 可自动跟进链接(如商品详情页),补充更多信息,无需手动编码。

- 即用模板: 针对热门网站(如 Amazon、Zillow、Shopify)提供一键模板,结构化采集立刻完成。

- 数据类型识别: 自动识别邮箱、电话、日期、图片等,导出即用。

- 无代码易用: 团队任何成员都能上手,开发者可以专注更高价值工作。

- 免维护: 网站变动时,只需再次点击“AI 推荐字段”,Thunderbit AI 自动适配。

Thunderbit 非常适合快速项目、原型开发,或者你需要高效采集数据又不想花时间写代码时,作为 Java 工作流的有力补充。

Thunderbit + Java:打造完整数据管道

把 Thunderbit 的易用性和 Java 的强大处理能力结合起来,才能真正释放数据价值。你可以这样搭建高效的数据管道:

- 用 Thunderbit 采集数据: 通过 Thunderbit 抓取目标网站数据,可以定时采集或用即用模板。

- 导出数据: 输出为 CSV、Excel、、Airtable 或 Notion,Java 轻松读取。

- 用 Java 处理: 编写 Java 程序读取导出数据(比如通过 Google Sheets API 或直接读取 CSV),进行清洗、补充,并集成到内部系统(CRM、数据库、分析平台)。

- 自动化流程: 定时运行 Thunderbit 采集,并在每次采集后自动触发 Java 处理脚本,实现全流程自动化。

举个例子: 假如销售团队每周一需要最新的行业客户名单,Thunderbit 采集网站并导出到 Google 表格,Java 程序读取表格,去重并导入 CRM。如果网站结构变了,只需调整 Thunderbit 配置,无需重写 Java 代码。

这种混合模式兼顾了灵活性和高效性:Thunderbit 负责应对网页变化,Java 负责业务逻辑和系统集成。

进阶技巧:Java 屏幕爬取的自动化与扩展

随着需求增长,你可以这样实现自动化和扩展:

- 并行处理: 用 Java 线程池并发爬取多页面,但要限制并发数,避免被封禁。

- 定时调度: 用 Java Quartz 库自动定时爬取,或者用 Thunderbit 内置调度器(直接用自然语言描述时间)。

- 错误处理: 实现重试、超时、失败通知(如邮件、Slack)。

- 云端爬取: Thunderbit 云端模式可同时采集 50 个页面,适合大批量任务且不占用本地资源。

- 维护优化: 统一管理爬虫、集中选择器、记录异常,便于快速排查。用 Thunderbit,大多数更新只需再次点击“AI 推荐字段”。

如果需要大规模(百万级页面)采集,可以考虑 Apache Nutch 等分布式框架或云端爬取 API。但对大多数企业来说,Thunderbit + Java 的组合已经能高效应对绝大多数场景。

总结与要点回顾

java 屏幕爬取是解锁网页数据的利器,无论是构建客户名单、监控竞品,还是市场调研都能大显身手。核心要点如下:

- Java 赋予你灵活性和掌控力,适合定制化、复杂的爬取任务,尤其是需要登录、动态内容或特殊业务逻辑时。

- Thunderbit 带来 AI 驱动的无代码极简体验,让任何人都能轻松采集网页数据,部署速度从数小时缩短到几分钟。

- 两者结合,可快速搭建高效、稳定的数据管道:Thunderbit 采集,Java 处理与集成。

- 自动化与扩展,通过并发、调度和云端爬取,轻松应对大规模需求,无需为维护发愁。

- 未来趋势是混合模式: 随着 Thunderbit 等 AI 工具不断进化,最强大的爬虫将是代码与无代码的结合体。

准备好提升你的数据采集能力了吗?,试试写第一个 Java 爬虫,看看能为你节省多少时间和精力。更多实用技巧和深度解析,欢迎访问 。

常见问题解答

1. 什么是 java 屏幕爬取?和网页爬取有啥区别?

java 屏幕爬取就是用 Java 代码直接从网页前端(也就是用户看到的页面)提取数据,特别适合没有 API 的场景。它其实属于网页爬取的一种,但“屏幕爬取”更强调模拟用户视角的数据获取,而不是从后端结构化接口抓数据。

2. 什么时候应该用 Java 而不是无代码工具爬取?

当你需要自定义逻辑、处理复杂登录、动态内容,或者需要和业务系统深度集成时,建议用 Java。Thunderbit 这类无代码工具适合快速任务、原型开发,或者让非技术人员也能参与数据采集。

3. java 屏幕爬取常见难题有哪些?怎么解决?

常见问题包括动态内容(用 Selenium 解决)、反爬机制(加延迟、用代理、模拟真实请求头)、网站结构变动(集中管理选择器)、数据清洗(用 Java 字符串和正则处理)。大规模任务建议用并发和健壮的错误处理。

4. Thunderbit 如何和 java 屏幕爬取互补?

Thunderbit 的 AI Chrome 扩展让你无需写代码就能采集任何网页,非常适合快速任务、原型开发,或者为 Java 工作流补充数据采集环节。数据可导出为 Java 易于处理的格式,实现无缝集成。

5. 可以用 Thunderbit 和 Java 实现全自动数据管道吗?

当然可以!用 Thunderbit 定时采集,导出到 Google 表格或 CSV,Java 程序自动读取、处理并集成数据。这种混合模式兼具 Thunderbit 的高效与 Java 的灵活。