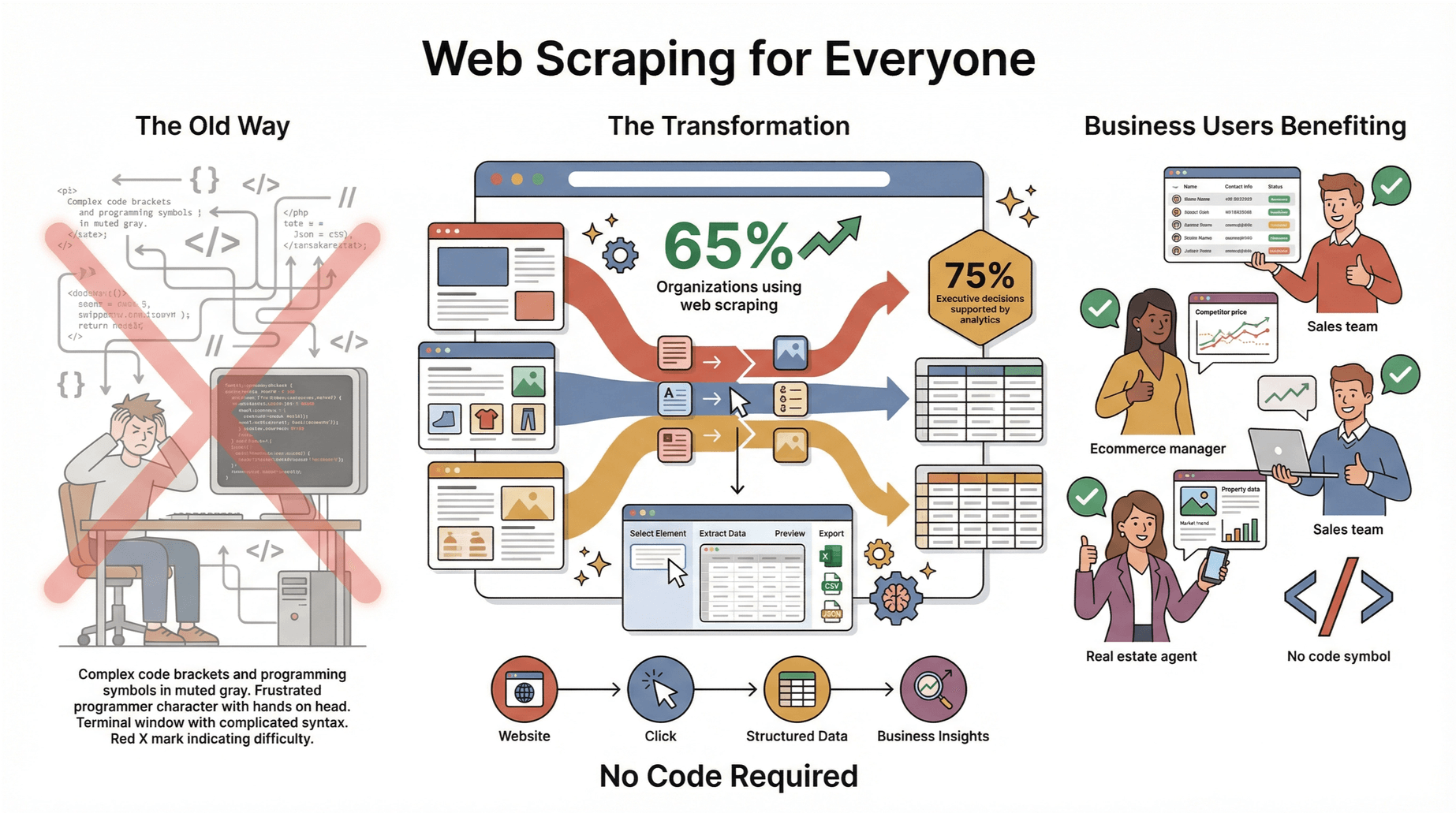

过去,网页爬虫这个词总让人觉得神秘,好像只有黑客或者技术大牛才玩得转——仿佛是技术圈的“暗号”。但到了2025年,网页爬虫已经成了每个想提升工作效率、节省时间、摆脱重复复制粘贴烦恼的人的必备技能。我亲眼看到销售、运营、电商、房产中介等各行各业都在用网页爬虫快速搞定客户名单、盯紧竞争对手、收集市场情报——而且完全不用写代码。

数据也很能说明问题:已经把网页爬虫用在AI项目和日常运营上,今年都要靠数据分析和自动化做决策。更棒的是,像这样的工具,让零基础小白也能轻松上手。如果你也想把互联网变成自己的数据宝库,这份新手网页爬虫指南就是为你准备的。

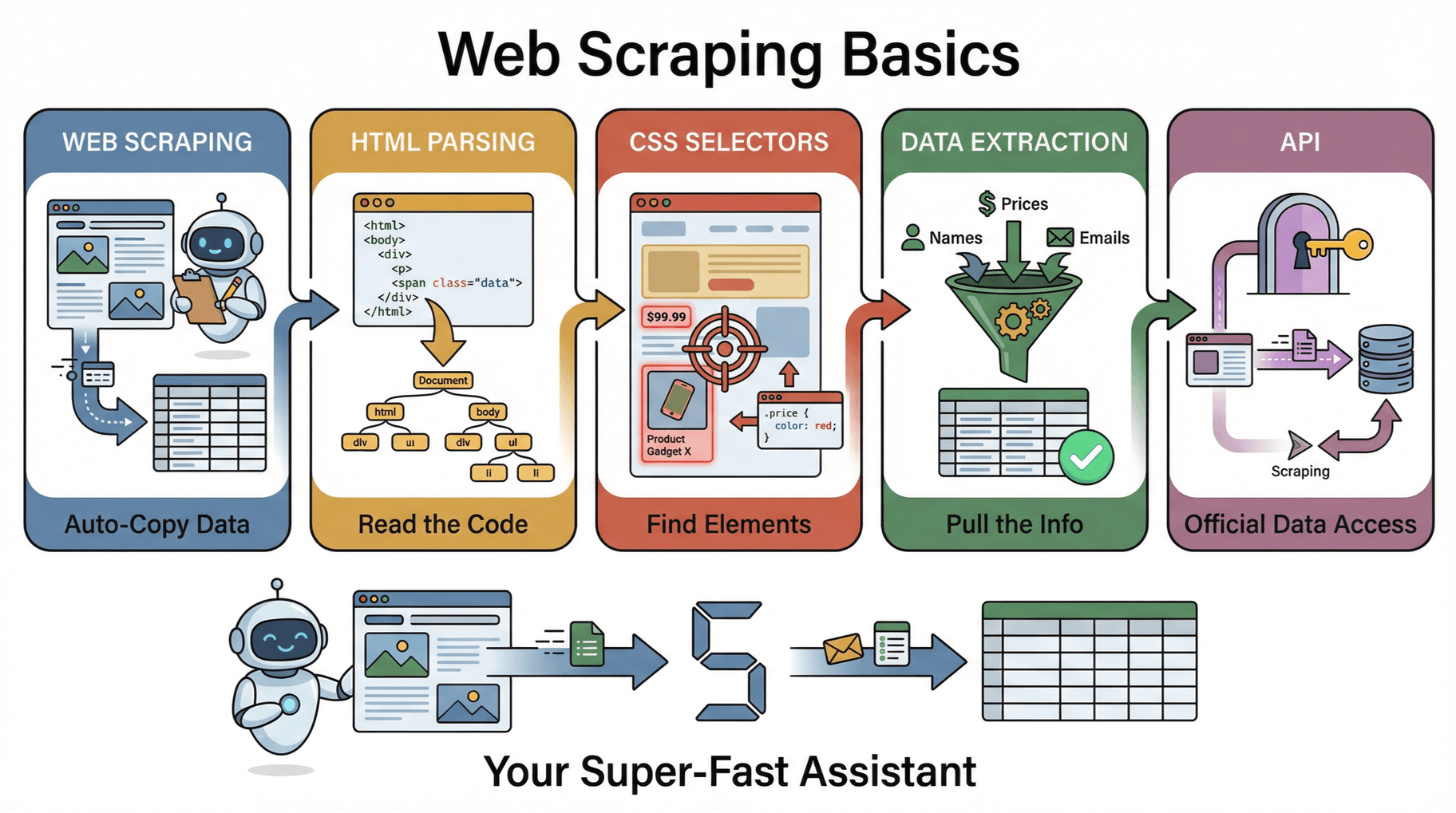

新手入门:网页爬虫核心概念

先来点基础知识。刚接触网页爬虫时,可能会碰到一些看起来很“高大上”的词,其实理解起来很简单。

-

网页爬虫(Web Scraping): 就是用软件自动批量采集网页上的信息,然后整理成表格或数据库。这样就不用手动复制粘贴,几分钟搞定原本要花好几个小时的活()。

-

HTML 解析(HTML Parsing): 每个网页都是HTML代码堆起来的,解析就是把这些代码“看懂”,生成一个结构化的页面地图(DOM),方便爬虫精准定位你要的数据()。

-

CSS 选择器(CSS Selectors): 就像网页上的“门牌号”,告诉爬虫去哪找数据。比如要抓商品价格,CSS选择器能直接定位到价格的那一块。

-

数据提取(Data Extraction): 这就是最终目的——把你关心的信息(比如姓名、价格、邮箱等)提取出来,整理成结构化数据。

-

API(应用程序接口): 有些网站会提供官方API,直接用API通常更简单、稳定。但不是所有网站都有API,这也是网页爬虫流行的原因之一()。

一句话总结: 网页爬虫就像给你配了个超级快的助手,自动帮你逛网页、采集信息、整理表格,省时省力。

为什么新手也需要学会网页爬虫?

你可能会想:我又不是程序员,学网页爬虫干嘛?其实它能帮你省下大把时间,还能让你在业务上更有竞争力。下面这些场景,都是新手用网页爬虫的真实例子:

| 应用场景 | 业务价值 |

|---|---|

| 销售线索挖掘 | 几分钟内从目录或领英等平台批量获取潜在客户名单。 |

| 电商价格监控 | 自动跟踪竞争对手价格和库存,及时调整自家定价,保持竞争力。 |

| 客户评价收集 | 汇总多平台的用户评价,洞察客户反馈,优化产品和服务。 |

| 市场调研 | 实时监控行业新闻、招聘信息或竞争对手动态,获取战略洞察。 |

比如,英国有家零售商就是靠爬取竞争对手价格并快速调整,销售额直接涨了4%()。而盈利能力高出19倍,对客户的理解也提升了52%。

一句话总结:网页爬虫能帮你自动化繁琐流程,做更聪明的决策,把精力用在真正能让业务增长的地方。

新手常见误区:保持简单,避免踩坑

和很多刚入门的小伙伴聊过,发现大家经常会踩这些坑,提前知道就能轻松避开:

-

目标不明确: 没想清楚到底要什么数据,结果爬了一堆杂乱无章的东西,白忙活。建议动手前先想清楚要哪些数据、用来干嘛()。

-

一次性爬太多: 新手容易贪心,想一口气爬成千上万页,结果容易出错。建议先从一页开始,保证准确再慢慢扩展。

-

数据重复或格式混乱: 比如“$1,299”和“1299 USD”混在一起,或者有很多重复数据。建议边爬边检查,及时去重和标准化()。

-

遗漏分页或详情页: 只爬了第一页,后面内容全漏掉。要确保工具能自动翻页,还能跟进详情页。

-

忽视网站规则: 不看robots.txt或服务条款,可能被封号甚至惹上法律麻烦。一定要遵守网站规定()。

实用建议: 选用像这样专为新手设计的工具,能帮你自动避开大部分常见问题,效率直接拉满。

零代码网页爬虫:Thunderbit 让一切变简单

市面上网页爬虫工具不少,但我最推荐给非技术用户和商业人士的还是。理由很简单:它就是为追求结果、完全不想折腾技术细节的人设计的。

Thunderbit 有哪些亮点?

-

AI 两步爬取: 装好 ,点“AI 智能识别字段”,AI 自动扫描页面并推荐最合适的字段(比如“商品名”、“价格”、“评分”)。再点“开始爬取”,数据立刻到手,完全不用写代码,也不用自己设置选择器,省心又高效()。

-

自动爬取详情页: 想要更多细节?Thunderbit 能自动访问每个子页面(比如商品详情页),一键采集补充信息,全部整合进表格()。

-

智能分页处理: 自动识别“下一页”按钮和无限滚动,确保一条数据都不漏()。

-

即用模板: 针对 Amazon、Zillow、LinkedIn 等热门网站,Thunderbit 提供现成模板,一键导出数据,无需自己配置()。

-

免费数据导出: 支持导出到 Excel、Google Sheets、Airtable 或 Notion,完全免费,无导出限制()。

-

AI 数据清洗: Thunderbit 能在爬取时自动标注、格式化、翻译甚至总结数据,让你的表格一开始就整整齐齐()。

-

云端/本地双模式: 支持云端批量爬取(一次最多50页),也能用本地浏览器模式搞定需要登录的网站。

一句话,Thunderbit 就像一个永远不累、自动整理数据的AI小助手。

实操演练:用 Thunderbit 完成你的第一个网页爬虫项目

准备好上手了吗?下面是用 Thunderbit 完成首次爬取的详细步骤——全程不用写代码:

-

安装 Thunderbit: 在浏览器里添加 ,注册免费账号(每月可免费爬6页,试用期还能提升到10页)。

-

打开目标网站: 进入你想采集数据的网页(比如房源列表、商品页或企业名录)。

-

启动 Thunderbit: 点浏览器工具栏里的 Thunderbit 图标,弹出操作面板。

-

点击“AI 智能识别字段”: Thunderbit 的 AI 会自动扫描页面并推荐最合适的字段,你也可以自己编辑或添加。

-

点击“开始爬取”: Thunderbit 会自动采集页面数据,还能处理分页内容。

-

(可选)爬取子页面: 如果想采集每条数据的更多细节,点“爬取子页面”,Thunderbit 会自动访问并补充信息。

-

导出数据: 点“导出”,选 Excel、Google Sheets、Airtable 或 Notion,数据立刻可用。

-

检查结果: 浏览表格,确认数据完整无误。如果有遗漏或格式问题,可以调整字段后重新爬取。

就这么简单,你已经完成了人生第一个网页爬虫项目——全程不用写一行代码。

常见问题排查: 如果遇到数据缺失或需要登录的页面,可以试试切换云端/本地模式,或者检查网页结构有没有变化。Thunderbit 的和客服也都很靠谱。

新手必知:网页爬虫的合规与道德边界

在大展拳脚之前,先了解下行业规范。爬取公开数据一般是合法的,但有些红线一定要守住:

-

查看 robots.txt 和服务条款: 大约明确禁止未经授权的爬取。一定要查 robots.txt(网址后加/robots.txt)和服务条款,如果被禁止,优先找官方API或主动申请授权。

-

避免采集个人或敏感信息: 除非信息公开且有正当理由,否则不要采集邮箱、手机号等个人数据。GDPR、CCPA 等隐私法规很严格。

-

勿转载受版权保护内容: 爬取数据只限分析或内部用,未经许可不要转载别人的文章或图片。

-

文明爬取: 不要高频请求影响网站正常运行,建议适当延时,避开高峰时段。

-

数据安全: 如果采集到敏感商业信息,一定要妥善保存,防止泄露。

合规爬虫清单:

- [ ] 检查 robots.txt 和服务条款

- [ ] 避免采集个人/隐私数据

- [ ] 不转载受版权保护内容

- [ ] 控制请求频率

- [ ] 优先使用API

- [ ] 数据安全存储

只要守住这些原则,你就能合法合规地做网页爬虫,也让网络环境更友好()。

新手友好型爬虫策略:从小做起,逐步进阶

给新手的最大建议:从小项目开始,慢慢积累信心和技能。推荐这样一步步来:

-

单页爬取: 先试着采集一页产品或联系人,熟悉工具和数据结构。

-

分页处理: 熟练后,试试采集多页内容(让 Thunderbit 自动翻页)。

-

爬取子页面: 进阶后可以采集详情页(比如商品详情、人员简介等)。

-

多样化数据类型: 试试采集文本、图片甚至PDF,Thunderbit 都能搞定()。

-

自动化调度: 熟练后可以设置定时爬取,保持数据实时更新。

每一次小小的成功,都是技能和信心的积累。别忘了给自己点个赞——爬出第一百行数据就是里程碑!

如何整理和规范你的爬取数据

干净的数据才有用。下面这些方法能帮你保持数据整洁:

-

统一字段命名: 用清晰一致的字段名,比如“价格”、“邮箱”,Thunderbit 的 AI 推荐能帮你省不少事。

-

标准化格式: 保证数字、日期、文本格式统一,Thunderbit 能自动格式化和翻译数据()。

-

去重处理: 用 Excel 或 Google Sheets 删除重复行。

-

边爬边校验: 采集过程中随时抽查,及时发现并修正问题。

-

记录数据来源: 备注数据来源、采集日期和处理过程,方便后续追溯和团队协作。

整理好的表格能让你直接进入分析或分享环节,省去后续清理的麻烦。

进阶扩展:如何应对更复杂的网页爬虫项目

基础掌握后,你可能想挑战更大规模的项目。怎么判断自己准备好了?又该怎么扩展?

你已准备好的信号:

- 已经成功做过几次爬取,想进一步提升。

- 需要定期监控数据(比如每天监控价格)。

- 目标网站页面多、结构复杂。

扩展方法:

- 用云端爬取: Thunderbit 云端模式一次能爬50页,适合大批量任务()。

- 定时自动化: 设置定时任务,让数据自动更新。

- 应对登录和动态内容: 对需要登录或结构复杂的网站,切换到本地浏览器模式。

- 持续监控与调整: 定期检查结果,网站结构有变化时及时调整设置。

扩展项目的关键就是稳扎稳打,经验慢慢积累。

总结:新手网页爬虫最佳实践

来个小结:

- 从简单做起: 目标明确,先爬一页,保证准确再扩展。

- 选对新手友好工具: Thunderbit 让网页爬虫变得简单、高效、准确,完全不用编程。

- 避开常见误区: 提前规划,保持数据整洁,遵守网站规则。

- 规范整理数据: 字段清晰、格式统一、过程有记录。

- 科学扩展: 自动化、定时、持续监控,随着经验提升逐步扩展。

网页爬虫早就不是技术圈的专利。只要方法对、工具选得好,谁都能轻松挖掘网页数据,为业务决策加分。

准备好试试了吗?,开启你的第一个网页爬虫项目。如果想要更多技巧、教程或灵感,欢迎逛逛 。

常见问题解答

1. 新手做网页爬虫合法吗?

只要采集的是公开数据,网页爬虫一般都是合法的。但一定要遵守每个网站的 robots.txt、服务条款和隐私法规。不要采集个人或受版权保护的内容,优先用官方API()。

2. 做网页爬虫一定要会编程吗?

完全不用!像 这样的工具就是为零基础用户设计的,点几下鼠标就能采集数据,根本不用写代码。

3. 新手做网页爬虫最常见的错误有哪些?

最常见的问题有目标不明确、一次性爬太多、遗漏分页或详情页、数据混乱,还有忽视网站规则。建议从小项目做起,选用新手友好型工具,轻松避开这些坑。

4. 如何让爬取的数据更整洁规范?

统一字段命名、标准化格式、去重处理、边爬边校验。Thunderbit 的 AI 能帮你自动标注、格式化,还能一键导出到 Excel 或 Google Sheets。

5. 技能提升后,如何扩展网页爬虫项目?

熟练后可以用 Thunderbit 的云端爬取、子页面采集和定时调度功能,轻松搞定更大规模或复杂任务。记得定期检查结果,及时调整设置。

祝你爬虫顺利,数据常新,表格永远整洁!

延伸阅读