想象一下这样的场景:周一一大早,你还没喝完手里的咖啡,邮箱里已经塞满了各种警报。又有一家AI工具因为数据泄露上了热搜。CEO等着你给说法,法务部门如临大敌,客户也开始质疑你们的“智能”系统到底怎么处理他们的数据。欢迎来到2026年,ai数据隐私已经不再是技术部门的专属难题,而是直接影响公司口碑、甚至你职业生涯的核心议题。

现实情况是,AI已经渗透到各行各业,无论是销售、市场、地产还是电商都离不开它。但AI普及的同时,风险也在飞速增加。仅过去一年,AI相关的隐私事件就暴涨了56%,而全球只有**47%**的人信任AI公司能保护他们的个人数据——而且这个数字还在持续下滑(, )。作为一个长期深耕SaaS和自动化平台的从业者(现为联合创始人),我可以很负责任地说:掌握最新的ai数据隐私统计,绝不是合规打卡那么简单,而是企业能否在数字时代活下去的分水岭。

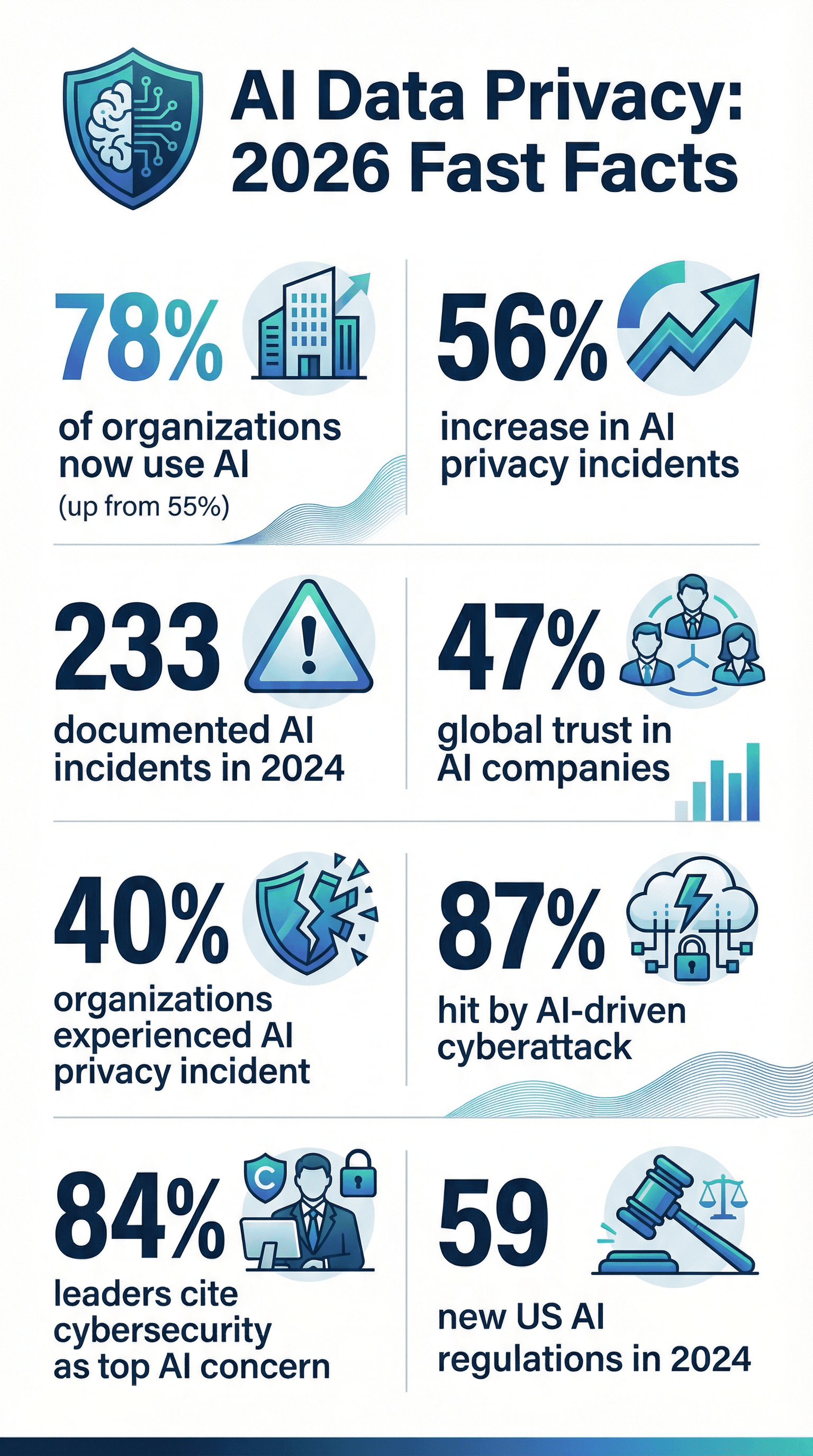

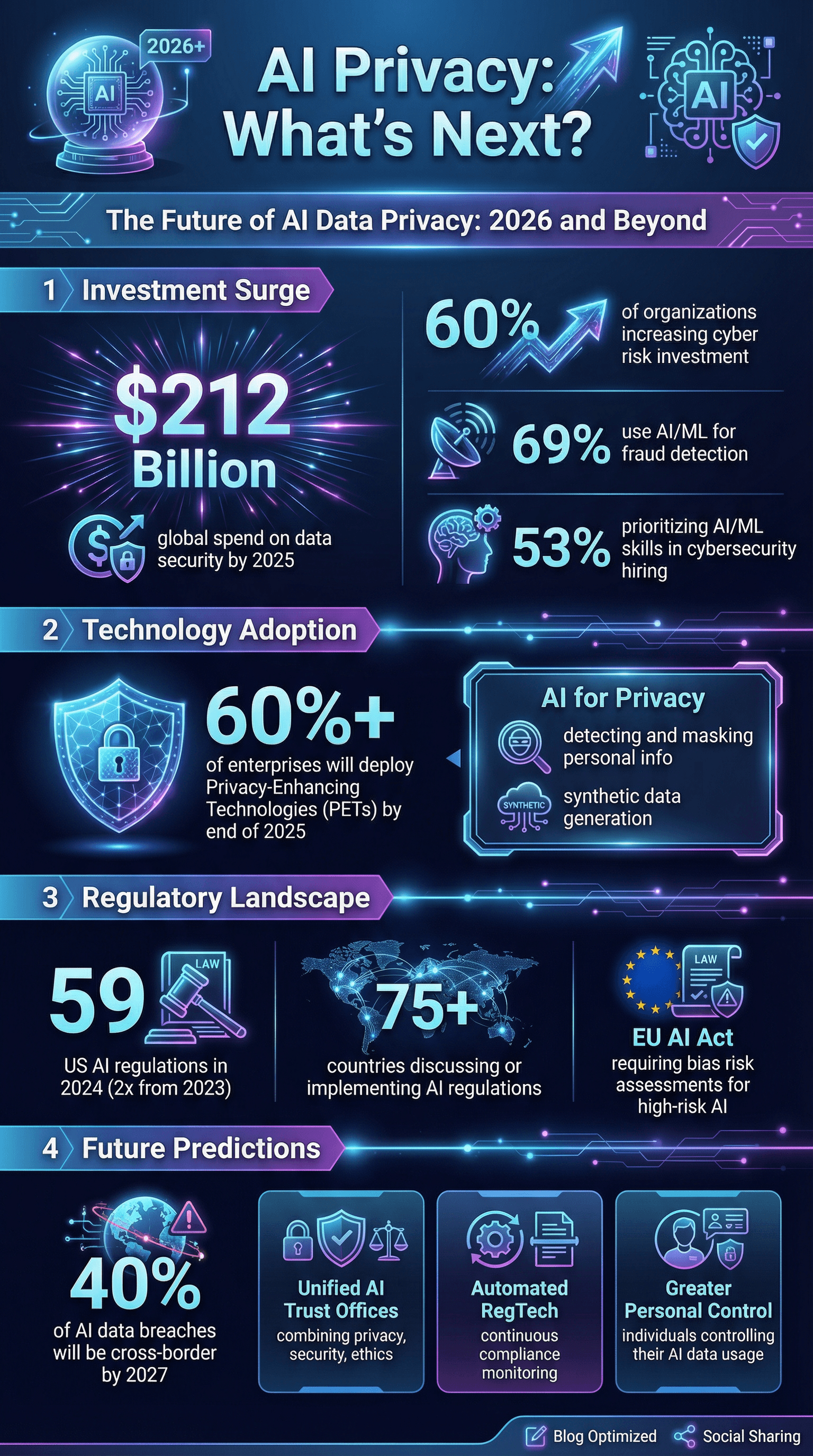

2026年ai数据隐私现状:核心数据一览

直接上重点。如果你需要在董事会或客户演示中引用关键数据,下面这些2026年ai数据隐私统计值得收藏:

- AI普及率: 2024年有78%的企业在用AI,比上一年(55%)大幅提升()。

- 事件激增: AI相关隐私与安全事件一年内暴涨56%,2024年有233起已记录案例()。

- 泄露频发: 40%的企业已遭遇AI相关隐私事件,**21%**在过去一年遭受网络攻击(,)。

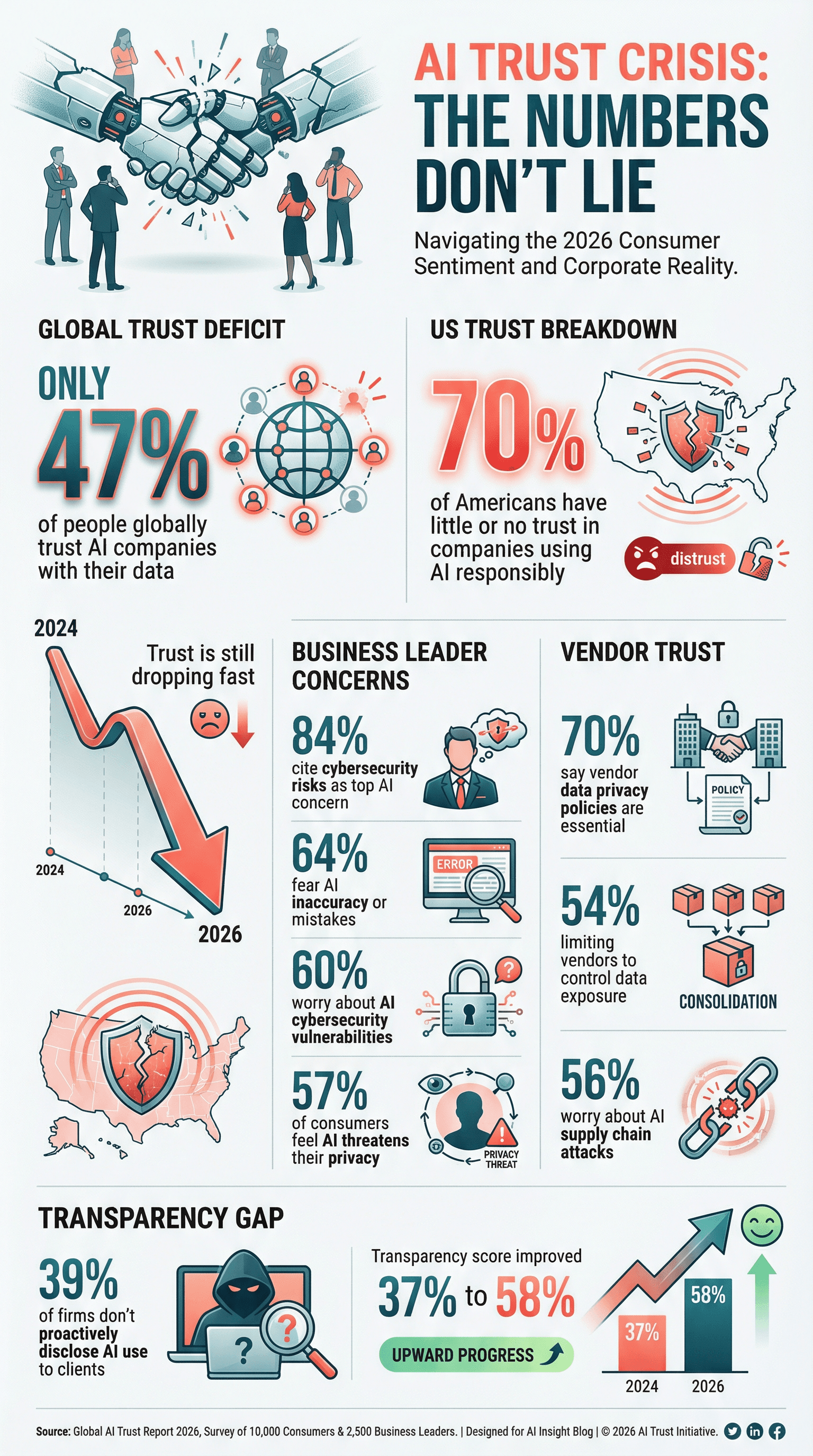

- 信任危机: 全球仅有**47%的人信任AI公司能妥善处理数据,美国有70%**的人对企业负责任使用AI缺乏信心()。

- 隐私成重中之重: 61%的企业把网络安全(包括ai数据隐私)列为三大战略重点之一()。

- 供应商审查更严: 70%的企业在选AI及技术合作伙伴时,把数据隐私政策当作硬性条件()。

- 高管焦虑: 84%的企业领导者认为AI带来的网络安全风险是最大担忧()。

- 监管加码: 2024年美国联邦机构出台了59项AI相关法规,是2023年的两倍多()。

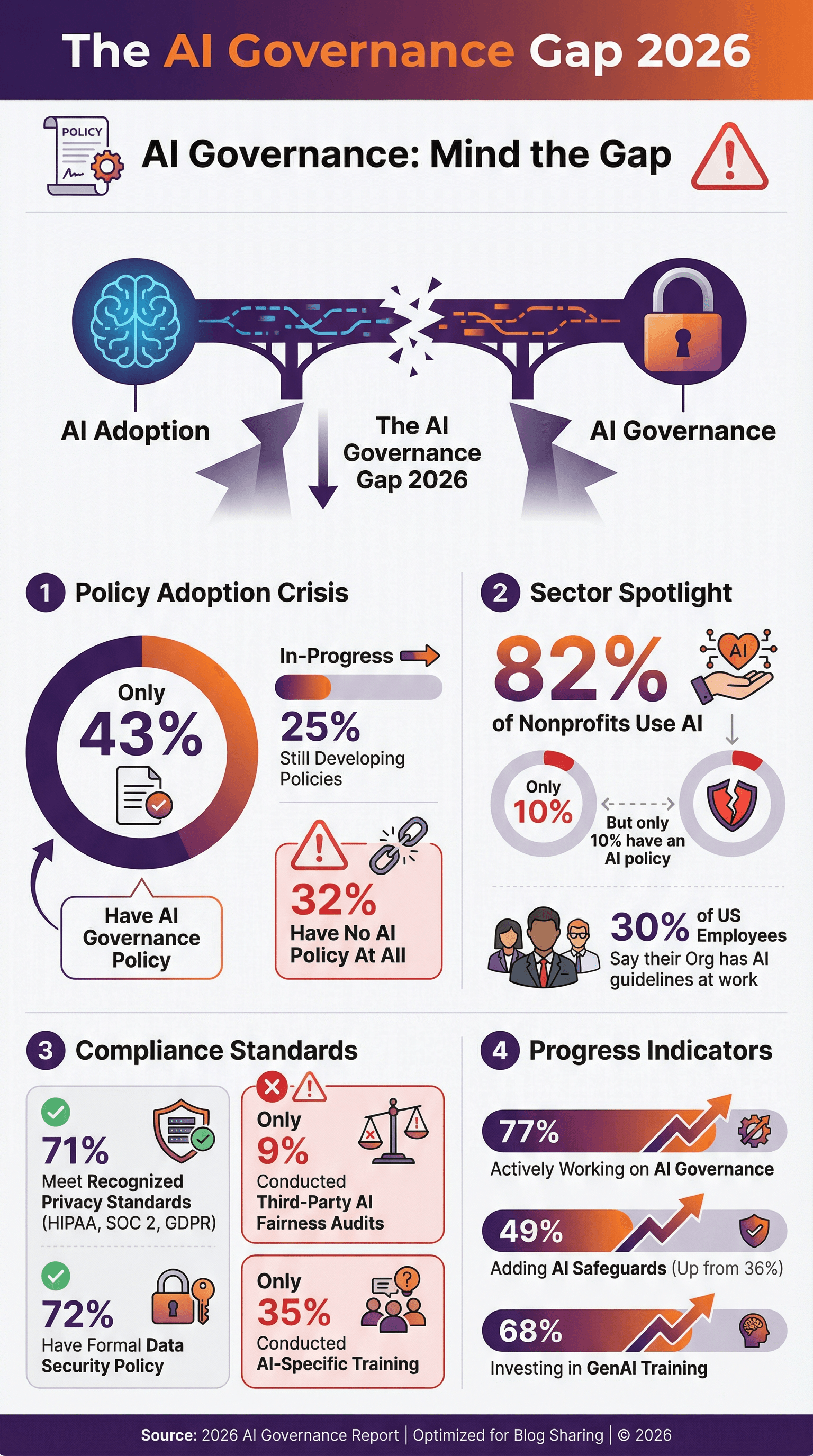

- 政策滞后: 只有43%的企业已制定AI治理政策,**77%**正在积极推进(,)。

- AI驱动攻击成常态: 87%的企业在过去一年遭遇AI驱动的网络攻击()。

这些数据不是冷冰冰的数字,而是给所有负责数据、合规或数字化转型的人敲响的警钟。

为什么ai数据隐私比以往更重要

AI早已不是普通的IT升级,而是彻底改变了企业收集、处理和利用数据的方式。和传统软件不同,AI系统往往依赖庞大且杂乱的数据集,里面可能有客户邮件、医疗记录等敏感信息。更麻烦的是,AI模型有时会“记住”并意外泄露原本不该公开的内容()。

AI模型的处理规模大得惊人,单个模型可能处理上百万条记录,甚至自动抓取全网数据——有时还没获得明确授权。这让数据保护的风险和挑战前所未有。AI决策速度极快(比如贷款审批、招聘筛选),一旦出错,隐私风险和合规问题会被迅速放大,甚至引发民权争议。

如果你还觉得“我们有隐私政策就没事”,那就太天真了。AI带来了数据投毒、模型反演、对抗攻击等新型风险,传统防控手段根本不够用。一旦AI隐私出事,声誉受损、客户流失、监管重罚,品牌恢复可能要好几年。2026年,ai数据隐私已经不只是合规问题,更关乎企业能不能活下去。

ai数据隐私统计:应用、担忧与合规现状

AI应用已成主流

说实话,AI早就不是“新兴技术”,而是主流。2024年,78%的企业已在用AI,比上一年(55%)大幅提升()。在法律、金融等行业,AI渗透率更高——2025年42%的律所已用AI工具,几乎翻倍()。AI普及意味着数据收集、分析和暴露的风险同步上升。

隐私担忧持续升温

能力越大,责任越大,焦虑也随之增加。全球57%的消费者认为AI对隐私构成重大威胁()。在美国,70%熟悉AI的人对企业负责任使用AI数据缺乏信任()。连企业高管也不安:**64%**担心AI不准确或出错,**60%**明确表示AI相关的网络安全漏洞是主要隐忧()。

能力越大,责任越大,焦虑也随之增加。全球57%的消费者认为AI对隐私构成重大威胁()。在美国,70%熟悉AI的人对企业负责任使用AI数据缺乏信任()。连企业高管也不安:**64%**担心AI不准确或出错,**60%**明确表示AI相关的网络安全漏洞是主要隐忧()。

合规:不断变化的目标

企业正努力跟上GDPR、CCPA、HIPAA、SOC 2等法规步伐,但AI总能带来新挑战。71%的企业表示已符合主流数据隐私标准(),**72%有正式的数据安全政策。但问题是:不到一半企业有专门的AI治理或伦理政策。只有43%**已制定AI治理政策,另有25%还在推进中(,)。剩下的企业则还在“盲飞”。

ai数据隐私政策采纳现状

ai数据隐私政策正从“可选项”变成“必选项”,但数据表明还有很大差距:

- 只有43%的企业有AI治理政策,另有25%正在制定中()。

- 在美国,仅30%的员工表示公司有AI使用相关政策或指引()。

- 非营利组织中,82%已用AI,但只有10%有AI政策()。

- 好消息是,77%的企业正积极推进AI治理措施,AI重度用户中这一比例接近90%()。

先行者们已经把禁止AI滥用、人为审核、算法公平与透明等条款写进政策。如果你们公司还没开始,建议赶紧行动,别等出事或新法规来了才被动补救。

ai数据隐私审计与认证

政策重要,审计和认证更能证明你真的做到了。

- 71%的企业已符合HIPAA、SOC 2、GDPR等主流标准()。

- 51%要求供应商健康数据需HIPAA合规,45%要求端到端加密()。

- 只有9%的企业做过AI公平性或偏见的第三方审计,预计随着监管加强,这一比例会提升()。

SOC 2、ISO 27001、HITRUST等认证正成为竞争利器。作为供应商,客户会要求你出示证明;作为采购方,也要确保合作伙伴达标。

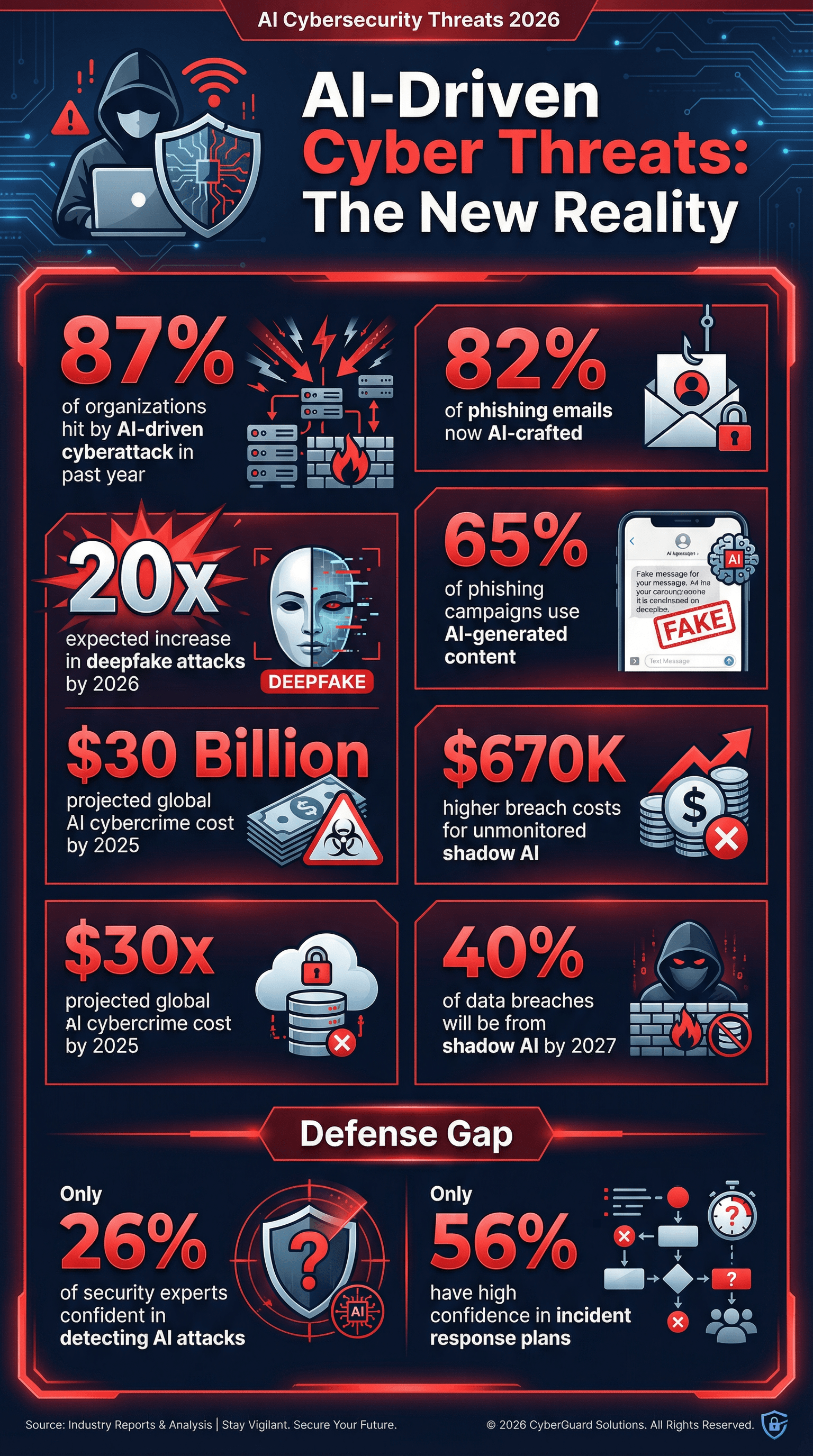

ai网络安全:威胁、事件与应对

说说“服务器里的大象”:AI不仅是攻击目标,也成了攻击者的利器。相关数据真的很扎心。

- 87%的企业在过去一年遭遇AI驱动的网络攻击()。

- 65%的钓鱼攻击已用AI生成内容伪装成可信通信()。

- 82%的钓鱼邮件预计由AI辅助生成()。

- 深度伪造攻击预计到2026年增长20倍()。

- 影子AI(员工私自用AI)风险上升,Gartner预测到2027年40%的数据泄露将归因于AI滥用或“影子AI”系统()。

更让安全负责人头疼的是:只有26%的安全专家对检测AI驱动攻击有高度信心()。这就像和魔术师玩捉迷藏。

AI驱动的网络攻击:数据解读

- 87%的企业在过去12个月遭遇AI增强型攻击()。

- 钓鱼更智能: 到2025年底,82%以上的钓鱼邮件由AI生成()。

- 深度伪造激增: 深度伪造音视频攻击到2026年将增长20倍。

- 影子AI风险: 到2027年,40%的数据泄露将因AI滥用或“影子AI”导致()。

- 泄露成本更高: 未监控或影子AI导致的泄露,平均损失比严格管控企业高出67万美元()。

- 全球损失: AI驱动的网络犯罪预计到2025年将造成300亿美元损失()。

如果你还没用AI生成的钓鱼邮件做演练,或者没测试过防御深度伪造攻击,那就是在裸奔。

企业在ai网络安全上的投入

好消息是,企业在ai网络安全上的投入持续增加:

- 60%的企业正在加大网络风险防控投入,AI是主要驱动力()。

- 69%已用AI/机器学习进行欺诈检测与防范()。

- 53%在网络安全招聘中优先考虑AI/ML技能()。

- 全球数据安全与风险管理支出预计到2025年将达2120亿美元()。

但短板也很明显:只有56%的企业对自身应对网络攻击的应急预案有高度信心,针对AI场景的更少。

ai数据治理:培训、监督与偏见防控

技术再牛,如果人和流程跟不上,风险还是会爆发。

- 只有35%的企业为团队开展过AI隐私、安全或伦理专项培训()。

- 68%的企业为员工提供生成式AI培训()。

- 30%依赖人工监督作为AI安全防控措施()。

- 只有9%采用独立审计评估AI公平性()。

- 49%正在完善AI治理措施,比去年(36%)大幅提升。

偏见也是隐私风险。AI如果因为种族、性别等差异处理个人数据,可能导致隐私不公甚至法律风险。46%的高管把“负责任AI”(包括公平性)列为AI投资重点()。但大多数企业在偏见检测和缓解上还在摸索。

AI偏见与公平性:隐私影响

- 涉及偏见或安全问题的AI事件每年大幅增加()。

- 部分企业通过偏见缓解,性别推荐差距减少25%。

- 监管压力加大:欧盟GDPR及即将出台的AI法案将要求“高风险”AI系统进行偏见风险评估。

如果你还没检测AI偏见,不仅会有公关危机,还可能面临诉讼和业务损失。

供应商与生态风险:整合与第三方暴露

没有企业是孤岛。大多数公司都依赖供应商、云服务和合作伙伴,这些都可能带来隐私风险。

- 54%的企业通过减少供应商数量来控制成本和降低数据暴露()。

- 70%的公司在筛选技术供应商时把数据隐私政策当作硬性条件。

- 56%担心AI驱动的供应链攻击()。

趋势很明显:整合供应商、强化隐私管控,把合作伙伴当作自己安全防线的延伸。

监管与客户压力:ai数据隐私的透明与披露

监管和客户的要求越来越高。2024年,美国出台了59项AI相关监管措施,是前一年的两倍。全球至少75个国家已讨论或实施AI监管()。

- 透明成新常态: 客户希望企业披露AI使用情况,但39%的企业坦言没主动告知客户()。

- 审计准备必不可少: 需要随时准备出示合规证明——比如HIPAA、SOC 2、AI工具清单和数据处理措施。

- 主流AI模型开发者的透明度评分半年内从37%提升到58%()。

如果你还没准备好应对审计或客户问询,那就还没准备好迎接2026年。

ai数据隐私的未来:趋势与预测

展望未来,以下是我和业内专家们看到的趋势:

- 隐私成竞争力: 能证明AI安全、隐私友好、合规的企业会赢得客户()。

- 统一治理: “AI信任办公室”将整合隐私、安全与伦理管理。

- 隐私增强技术(PETs): 超过60%的企业计划在2025年底前部署PETs()。

- 自动化合规: AI合规监管科技(RegTech)将成为标配,持续监控AI系统合规性。

- 跨境数据挑战: 到2027年,40%的AI相关数据泄露将源于跨境数据滥用()。

- 个人数据自主权提升: 未来会有更多工具让个人掌控自己数据在AI中的使用方式。

- AI助力隐私保护: AI将用于检测、脱敏个人信息,生成合成数据等。

- 应急与韧性: 企业将从单纯防御转向提升韧性,包括购买AI相关保险、演练数据投毒或模型损坏后的恢复。

作为一个热衷自动化和AI、同时对数据隐私高度警觉的从业者,我坚信,未来十年,只有把隐私和安全当作核心能力的企业,才能真正立于不败之地。

2026年ai数据隐私统计对企业的启示与行动建议

最后,给你一些实用建议,别等明年上新闻才后悔:

- 把ai数据隐私纳入企业战略核心。 别等出事才补救,要从一开始就融入设计。

- 全面评估AI风险。 弄清楚你的AI系统、数据流和风险点。

- 加大AI专项培训和治理投入。 别让团队成为短板。

- 用AI对抗AI,强化技术防御。 部署先进监控和检测工具。

- 严格管理供应商。 精简、审查并要求合规证明。

- 主动透明。 主动告知客户和用户AI的使用方式和场景。

- 部署隐私增强技术。 尽量实现数据匿名化、加密和最小化。

- 做好最坏打算。 制定并定期演练AI应急响应方案。

- 紧跟法规与标准变化。 监管环境变化快,务必保持敏锐。

- 以信任为核心。 2026年及以后,信任是企业最宝贵的资产。

参考资料与延伸阅读

想深入了解或需要权威数据做演示?以下是本篇内容引用的核心资源:

- )

想获取更多AI、自动化与数据隐私洞察,欢迎访问,或阅读我们的与。