互联网的数据量正在以惊人的速度膨胀——2024 年,全球数字信息总量已经飙升到 。更有意思的是,全球 90% 以上的数据其实都是最近两年才产生的。对于企业来说,这意味着下一个关键洞察、潜在客户或者竞争优势,可能就藏在某个网页的角落——只要你能把它抓出来。

这正是网页爬虫大展拳脚的时刻。不管你是做销售、电商还是市场调研,自动化收集和整理网站数据都能让效率飞升。如果你是编程小白也不用慌——Python 让网页爬虫变得超级简单易用。这篇教程会带你从环境搭建到数据清洗,手把手演示每一步。甚至还会介绍一个完全不用写代码、几步就能搞定数据抓取的 AI 网页爬虫工具。

什么是 Python 网页爬虫?

简单来说,网页爬虫就是自动化地从网站批量提取数据。比如你想收集网店的商品价格、整理潜在客户名单,或者监控竞争对手的新闻动态。与其手动复制粘贴(谁有那么多时间?),不如用爬虫脚本一键批量搞定。

Python 网页爬虫就是用 Python 语言来实现自动抓取。Python 语法简洁,配合强大的第三方库,就算是零基础也能很快上手。你可以轻松获取网页内容、解析数据,并把它们结构化保存下来。

企业常见的网页爬虫应用场景有:

- 潜在客户挖掘: 从黄页、点评网站等批量收集客户名单。

- 价格监控: 跟踪竞争对手的价格或商品库存变化。

- 市场调研: 汇总新闻、评论或社交媒体上的提及。

- 运营管理: 收集供应商信息、招聘岗位或房源信息等。

总之,只要数据在网页上,Python 都能帮你高效批量搞定。

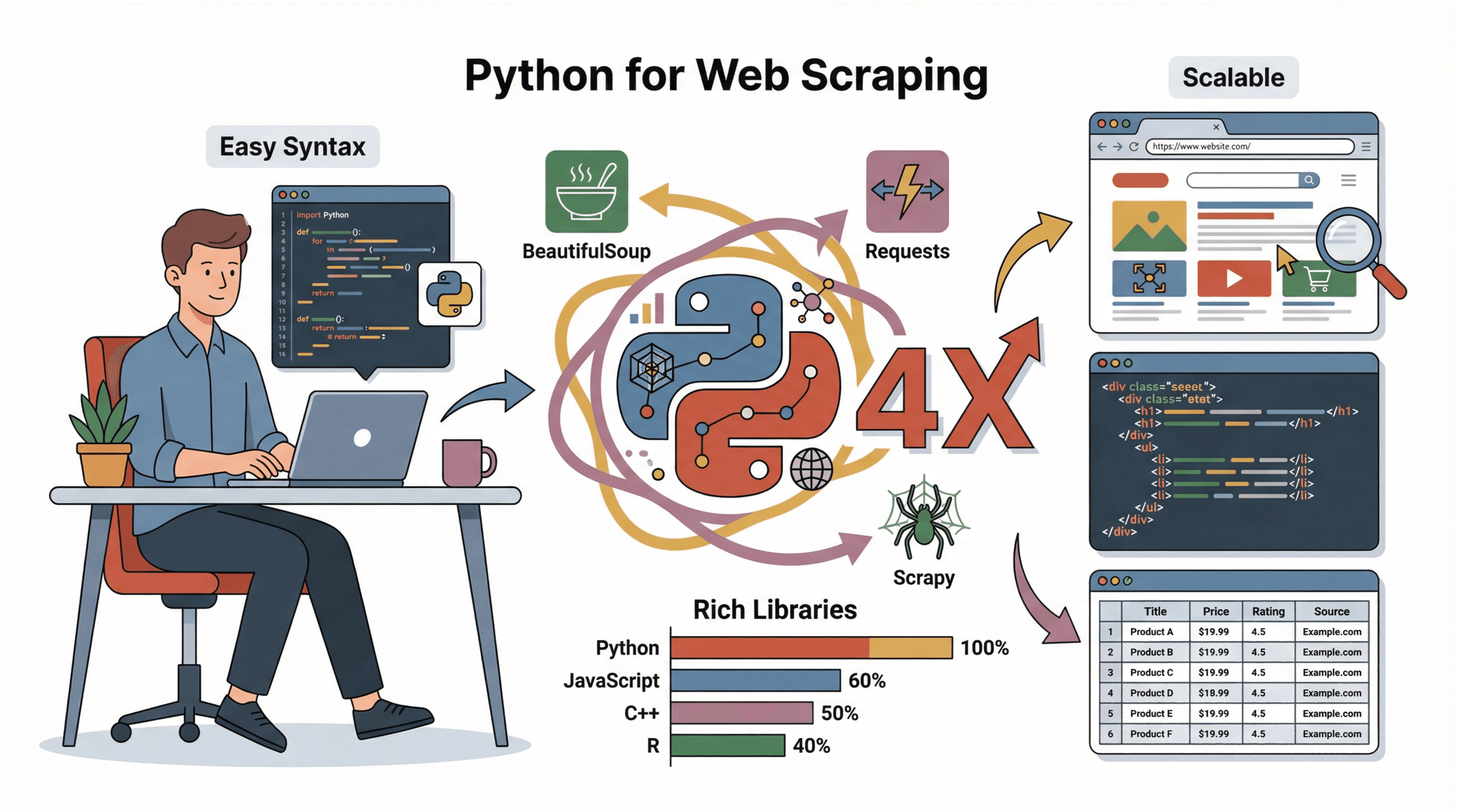

为什么 Python 是网页爬虫的首选

我自己试过不少编程语言来做爬虫(也踩过不少坑),但 Python 的优势真的很突出:

我自己试过不少编程语言来做爬虫(也踩过不少坑),但 Python 的优势真的很突出:

- 新手友好: 语法直观,零基础也能很快入门。

- 生态丰富: 、、 等库让抓取、解析、保存数据变得非常简单。

- 社区活跃: 各种教程、论坛、代码示例一应俱全,遇到问题很容易找到答案。

- 可扩展性强: 不管是一次性小脚本还是大规模定时爬取项目,Python 都能轻松应对。

和 JavaScript、C++ 或 R 相比,Python 更容易上手,也更适合快速原型开发和数据分析(参考 )。这也是为什么无论是新手还是大公司都首选 Python。

入门指南:搭建 Python 爬虫环境

在正式开爬之前,你需要先装好 Python 和相关库。就算你完全没用过 Python,也能很快搞定:

-

安装 Python:

- 去 下载最新版。

- Windows 用户安装时记得勾选“Add Python to PATH”。

- Mac 用户可以用 执行

brew install python3。 - Linux 用户用包管理器:

sudo apt install python3 python3-pip。

-

安装 pip(Python 包管理器):

- 大部分 Python 安装包自带 pip。用

pip --version检查下。 - 没装的话可以重新运行安装程序,或者用

python -m ensurepip --upgrade。

- 大部分 Python 安装包自带 pip。用

-

创建虚拟环境(推荐):

- 在你的项目文件夹下运行:

python -m venv env - 激活虚拟环境:

- Windows:

.\env\Scripts\activate - Mac/Linux:

source env/bin/activate

- Windows:

- 在你的项目文件夹下运行:

-

安装所需库:

- 激活虚拟环境后,运行:

1pip install requests beautifulsoup4 pandas scrapy - 如果要抓取动态网页,可以额外装个

selenium。

- 激活虚拟环境后,运行:

-

选择编辑器:

- 新手推荐 、、或者 。

常见问题排查:

- 如果

pip命令不识别,试试python -m pip install ...。 - 遇到权限问题,Windows 下用管理员权限打开终端,Mac/Linux 用

sudo。 - Windows 装完 Python 后,记得重启下终端。

抓取前如何分析网页结构

写代码前,先要搞清楚目标网页的数据结构。我的常用套路如下:

-

打开开发者工具:

- Chrome 浏览器右键元素点“检查”,或者直接按

F12。 - 在“Elements”标签页能看到完整 HTML 结构。

- Chrome 浏览器右键元素点“检查”,或者直接按

-

定位目标数据:

- 用“选择元素”工具(鼠标指针图标)点你想要的数据(比如商品名、价格)。

- 对应的 HTML 会被高亮显示。

-

识别规律:

- 找找有没有独特的标签、class 或 id。比如:

<h2 class="product-title">Laptop XYZ</h2>。 - 注意数据是在列表(

<ul>、<div class="item">等)还是表格里。

- 找找有没有独特的标签、class 或 id。比如:

-

检查分页:

- 看 HTML 里有没有“下一页”按钮或页码。如果有

?page=2这种链接,脚本可以循环抓多页。

- 看 HTML 里有没有“下一页”按钮或页码。如果有

-

判断内容是否动态加载:

- 如果在页面源码(

Ctrl+U)找不到数据,可能是 JavaScript 动态加载。这种情况可以用 Selenium,或者直接找 API 接口。

- 如果在页面源码(

想看详细演示, 很值得一看。

用 Requests 获取网页内容

是 Python 抓网页的首选库。基本用法如下:

1import requests

2url = "https://www.bbc.com/news"

3headers = {"User-Agent": "Mozilla/5.0"}

4response = requests.get(url, headers=headers)

5response.raise_for_status() # 检查响应状态

6html = response.text小贴士:

- 一定要设置真实的

User-Agent,不然很容易被封(参考 )。 - 检查

response.status_code(200 表示成功,404 没找到,403 被禁止,429 请求太多)。

用 BeautifulSoup 解析 HTML,提取所需数据

拿到 HTML 后,就可以用 解析并提取内容:

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, "html.parser")

3titles = [h.get_text(strip=True) for h in soup.select("h3")]常用操作:

- 提取文本:

element.get_text(strip=True) - 获取链接:

[a['href'] for a in soup.select('a')] - 按 class 查找:

soup.find_all('span', class_='price') - 提取图片:

[img['src'] for img in soup.select('img')] - 处理表格: 用

soup.select('table')遍历行和单元格。

应对杂乱 HTML 的小技巧:

- 用

soup.select_one()只取第一个匹配项。 - 字段可能缺失时,先判断是不是

None。 - 布局不统一时,可以用正则表达式或者自定义逻辑处理。

Scrapy 框架:高效大规模网页爬虫

如果你要抓成百上千个页面, 就特别好用。Scrapy 是一个功能强大的爬虫框架,支持自动请求、跟踪链接、数据导出等。

Scrapy 优势:

- 速度快: 支持异步并发抓取,多页面同时处理。

- 内置功能丰富: 自动重试、缓存、导出 CSV/JSON。

- 可扩展性强: 适合大项目或定期批量抓取。

Scrapy 基本流程:

- 安装:

pip install scrapy - 新建项目:

scrapy startproject myproject - 定义 Spider 类,设置

start_urls和parse方法。 - 用

yield跟踪链接或提取数据。 - 运行:

scrapy crawl spidername -o output.csv

想快速上手可以参考 。

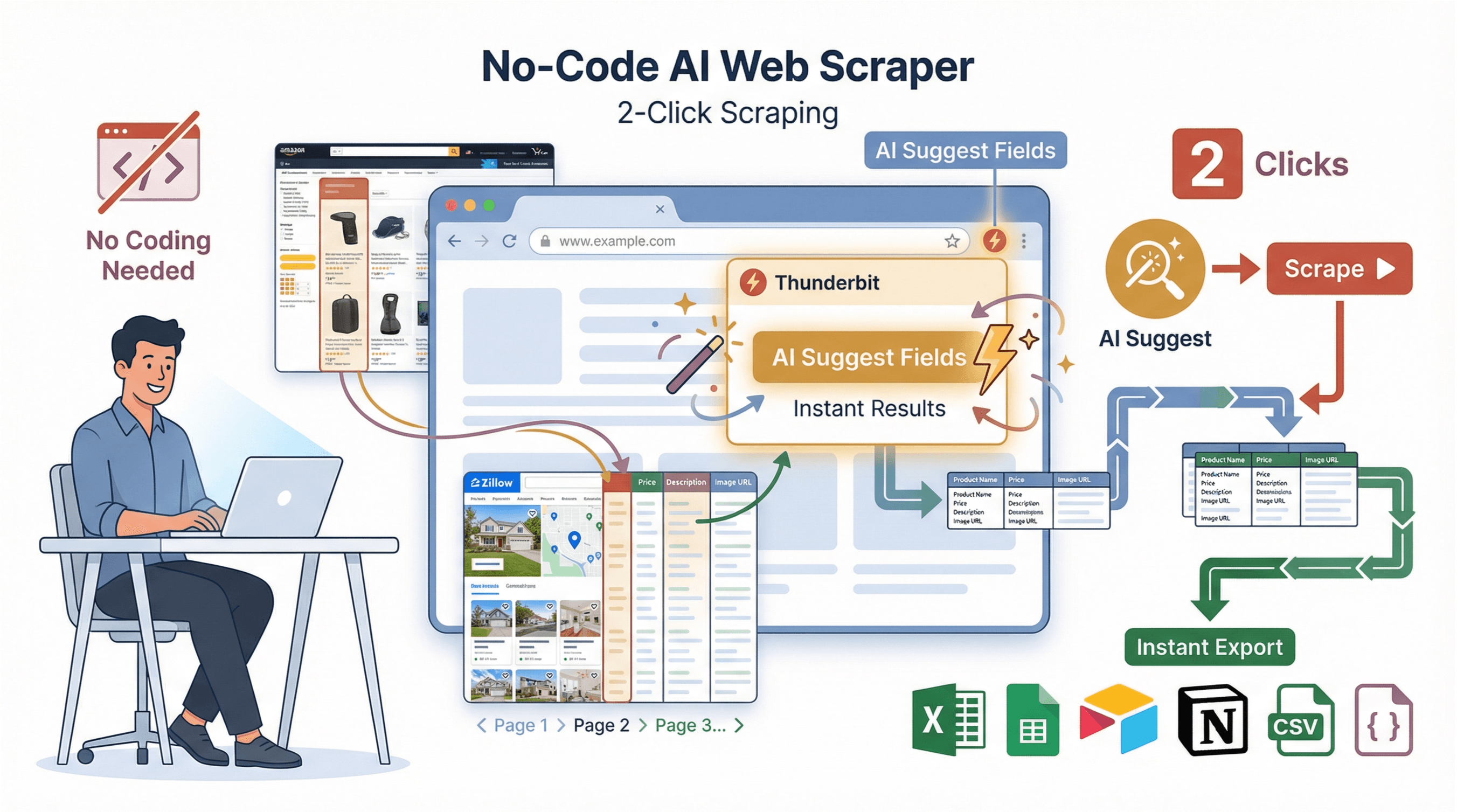

无需代码的替代方案:Thunderbit AI 网页爬虫,极速出结果

说实话,不是每个人都喜欢折腾代码、依赖和调试。为此我们打造了 :一款专为企业用户设计的 AI 网页爬虫 Chrome 插件,两步即可完成数据抓取。

说实话,不是每个人都喜欢折腾代码、依赖和调试。为此我们打造了 :一款专为企业用户设计的 AI 网页爬虫 Chrome 插件,两步即可完成数据抓取。

Thunderbit 的亮点:

- AI 智能字段推荐: 一键“AI 推荐字段”,Thunderbit 自动识别页面并建议最佳提取列。

- 两步抓取: 点击“抓取”即可,分页、子页面、复杂布局全自动处理。

- 子页面采集: 需要更详细信息?Thunderbit 可自动访问每个子页面(如商品详情、个人资料)并补全数据表。

- 即用模板: 针对热门网站(如 Amazon、Zillow、Instagram、Shopify)提供一键导出模板。

- 免费数据导出: 支持导出到 Excel、Google Sheets、Airtable、Notion、CSV、JSON,无需付费,无门槛。

Thunderbit 与 Python 对比一览

| 功能 | Python(手动) | Thunderbit(零代码) |

|---|---|---|

| 环境搭建时间 | 30–60 分钟 | 2 分钟 |

| 是否需要编程 | 需要 | 不需要 |

| 分页处理 | 需自定义代码 | 自动支持 |

| 子页面采集 | 手动循环 | 一键完成 |

| 数据导出 | 需编写导出代码 | 一键导出到 Sheets/Excel/Notion |

| 维护成本 | 网站变动需手动更新代码 | AI 自动适配 |

| 适用场景 | 复杂逻辑、深度集成 | 快速出结果、无编程基础用户 |

想了解更多,可以看看 。

数据清洗与存储:让抓取数据更有价值

原始抓取的数据通常比较杂乱。用 可以高效清洗和保存:

1import pandas as pd

2# 假设你有一个字典列表 scraped_data

3df = pd.DataFrame(scraped_data)

4# 去重

5df = df.drop_duplicates()

6# 过滤缺失值

7df = df.dropna(subset=['title', 'price'])

8# 价格转为浮点数(去除 $ 和逗号)

9df['price'] = df['price'].str.replace('$', '').str.replace(',', '').astype(float)

10# 保存为 CSV

11df.to_csv('results.csv', index=False)最佳实践:

- 检查并处理缺失或异常数据。

- 统一数据格式(比如日期、价格)。

- 推荐用 CSV 存储,方便分享;协作可以用 Excel/Google Sheets。

- 数据量大可以用数据库(比如 SQLite、PostgreSQL)。

Python 网页爬虫实战教程:全流程演示

下面以抓取电商网站商品标题和价格为例,完整演示流程。

1. 分析网页结构

以 为例,页面结构如下:

- 书名在

<article class="product_pod">里的<h3>标签中。 - 价格在

<p class="price_color">标签中。

2. 获取网页内容

1import requests

2url = "http://books.toscrape.com/"

3headers = {"User-Agent": "Mozilla/5.0"}

4response = requests.get(url, headers=headers)

5response.raise_for_status()

6html = response.text3. 解析并提取数据

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, "html.parser")

3books = []

4for article in soup.select("article.product_pod"):

5 title = article.h3.a["title"]

6 price = article.select_one("p.price_color").get_text(strip=True)

7 books.append({"title": title, "price": price})4. 数据清洗与保存

1import pandas as pd

2df = pd.DataFrame(books)

3df['price'] = df['price'].str.replace('£', '').astype(float)

4df.to_csv('books.csv', index=False)

5print(f"已保存 {len(df)} 本书到 books.csv")5. 常见问题排查

- 如果

books为空,检查 CSS 选择器是否写对了。 - 编码报错时,用 UTF-8 打开 CSV。

- 多页抓取时,循环处理如

http://books.toscrape.com/catalogue/page-2.html。

进阶建议: 动态网页或复杂流程可以用 Selenium、Scrapy,或者直接交给 Thunderbit 处理。

总结与要点回顾

用 Python 做网页爬虫,能为企业带来无限可能,从客户挖掘到市场情报都能轻松搞定。本文主要内容回顾:

- Python 是网页爬虫首选,因为简单易用、库强大。

- Requests 和 BeautifulSoup 是抓取和解析 HTML 的基础工具。

- Scrapy 适合大规模、复杂的爬虫项目。

- Thunderbit 提供了无需编程、AI 驱动的极速抓取方案,非常适合想直接拿到数据的业务用户。

- 数据清洗与存储 是把原始数据变成有用洞察的关键。

如果你想进一步实践,不妨在练习网站上动手写个爬虫,或者,体验一键获取结构化数据的高效。更多技巧和教程,欢迎访问 。

祝你抓取顺利,数据干净、结构清晰、随时可用!

常见问题解答

1. 网页爬虫合法吗?

只要抓取的是公开数据,网页爬虫一般是合法的。但一定要遵守目标网站的服务条款、robots.txt 和相关隐私法规(比如 GDPR)。不要抓取个人隐私数据,也不要试图绕过登录或安全机制(参考 )。

2. Requests、BeautifulSoup 和 Scrapy 有什么区别?

- Requests 用来获取网页内容。

- BeautifulSoup 用来解析和提取 HTML 数据。

- Scrapy 是支持大规模抓取和多页面导出的完整爬虫框架。

3. 如果网站用 JavaScript 加载数据怎么办?

如果数据不在初始 HTML 里,可以用 或 Playwright 自动化浏览器,或者分析网络请求直接调用 API。

4. 如何避免爬虫被封?

设置真实请求头(尤其是 User-Agent)、请求间隔加点随机延迟、避免高频访问。大规模抓取时可以用代理或轮换 IP(参考 )。

5. 不会编程也能抓取数据吗?

当然可以。 支持 AI 智能抓取,无需写代码。只要装个 Chrome 插件,描述下需求,就能一键导出数据。

更多进阶技巧和教程,欢迎关注 。

延伸阅读