说真的,到了2025年,整个互联网就像一张巨大的、每天都在变的电子表格——只不过没人给你配个“导出到Excel”按钮。(要是真有就太爽了!)我做SaaS和自动化工具这些年,深刻体会到销售、市场、运营团队对新鲜、精准网页数据的渴望——不管是客户名单、竞品价格,还是房产趋势分析。现在,网页爬虫的需求比以前更火,但“怎么搞”这事儿也在飞速变化。

Java一直是大型、严肃网页爬虫项目的老大哥。但说实话,除非你是那种把大括号当摇篮曲的程序员,用Java写爬虫的体验就像拼IKEA家具,没说明书还多出几颗螺丝。这也是为啥我对新一代AI网页爬虫特别感兴趣——比如我们团队做的,让数据提取变得像点两下鼠标一样简单,完全不用写代码,也不用懂HTML。今天就带你看看这两种世界:Java为什么还很重要、怎么用Java搭爬虫,以及AI工具怎么让网页爬虫人人都能玩转。

为什么2025年Java网页爬虫依然有一席之地

虽然零代码和AI工具越来越多,Java依然是全球很多大型网页爬虫项目的中流砥柱。原因很简单:Java性能稳、可靠性高,还能实现企业级数据采集需要的各种细致控制。

Java的强势场景

- 客户线索和销售拓展: Java的并发能力超强,一晚上就能从目录或LinkedIn抓下百万级信息。想象下,睡觉时线索自动进账,根本不用熬夜。

- 竞品价格监控: 电商团队靠Java爬虫实时盯着成千上万个SKU的竞品价格,随时调整自家售价。比如Target用数据驱动定价后,)。

- 房产数据采集: 经纪人和投资人用Java整合多渠道房源、历史价格和人口数据,轻松发现投资机会()。

- 金融市场调研: 投资机构靠Java的稳定性,全天候抓股票价格、新闻和社交情绪——金融圈,哪怕延迟几秒都可能亏大钱。

权衡:灵活性和易用性

Java给你极致的控制权:每个细节都能自定义,特殊情况都能搞定,还能和后端系统无缝集成。但问题也很明显——得有扎实的编程功底。对非开发者来说,学习曲线陡峭,后期维护也很折腾。所以,虽然Java撑起了重型项目,越来越多业务用户更喜欢用AI驱动、零代码的网页爬虫来搞定日常数据采集()。

基础扫盲:Java网页爬虫到底是啥?

简单点说,别整术语。

用Java做网页爬虫,就是写个程序,让它像机器人一样访问网页、读内容、提取你想要的数据。你可以把它当成一个数字实习生,帮你飞快复制粘贴信息(而且不会喊累要喝奶茶)。

基本流程:

- 发送请求: Java程序获取网页的原始HTML,就像浏览器一样。

- 解析HTML: 程序分析页面结构(各种

<div>、<span>、<table>标签)。 - 提取数据: 你告诉它要找啥(比如“抓所有

<span class='price'>里的价格”)。 - 导出数据: 把结果保存成CSV、Excel或数据库。

静态网站很简单,遇到动态网站(内容靠JavaScript加载),就得用额外工具模拟浏览器,后面会细说。

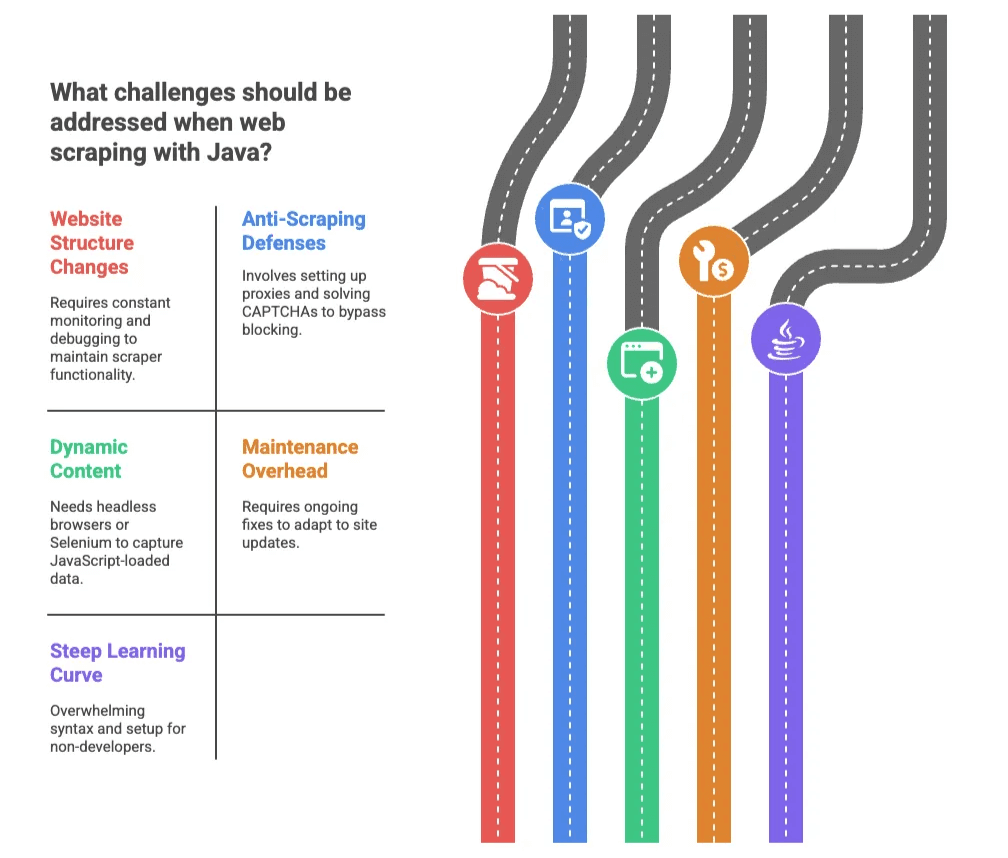

Java网页爬虫的主要难点

Java很强,但用起来真不总是省心——除非你觉得验证码、IP封禁和每周变一次的HTML结构很有趣。主要难点有:

1. 网站结构老变

网站总喜欢在你爬虫刚调好时改版。哪怕只是CSS类名小改动,也能让你的代码全失效。结果就是爬虫抓到一堆“空气”,你只能半夜调bug()。

2. 反爬机制

网站会用验证码、IP封禁、限速等手段对付爬虫。最近有调查显示,觉得被封禁是最大难题。用Java搞定这些,要配置代理、破解验证码,感觉像在玩永无止境的数字打地鼠。

3. 动态内容

现在的网站经常用JavaScript在页面加载后才显示数据。普通Java爬虫看不到这些内容,需要用无头浏览器或Selenium等工具,难度和复杂度都上升不少。

4. 维护成本高

爬虫写好后,还得持续维护。每次网站更新都可能让爬虫失效,你(或者你的开发同事)得随时修补。

5. 学习门槛高

对非开发者来说,Java的语法和环境配置很容易让人劝退。哪怕小失误也可能报一堆莫名其妙的错。就像学手动挡开车——只不过车在着火,路还是HTML铺的。

传统Java网页爬虫:全流程一览

如果你还想亲自上手写爬虫,通常流程是这样的:

| 步骤 | Java编程方式 | AI/零代码工具方式 |

|---|---|---|

| 环境搭建 | 安装JDK、IDE、添加库(新手可能要花数小时) | 安装浏览器插件或注册账号(几分钟搞定) |

| 确定数据字段 | 检查HTML、写选择器(需懂HTML/CSS) | AI自动识别字段,或直接点选 |

| 处理动态内容 | 用Selenium或HtmlUnit(复杂且慢) | 工具自动处理,无需操心 |

| 调试与修复 | 阅读报错、反复改代码 | 工具自动处理大部分问题,用户只需微调字段 |

| 数据导出 | 写代码保存CSV/数据库,需手动集成 | 一键导出到Excel、Google Sheets、Airtable、Notion |

| 维护 | 监控网站变动,持续改代码 | AI自动适应变化,用户几乎不用管 |

常用Java网页爬虫库

- Jsoup: 适合静态HTML,简单好用,但搞不定JavaScript动态内容()。

- HtmlUnit: 模拟浏览器,可执行JavaScript,但速度慢,对新技术兼容性一般。

- Selenium: 驱动真实浏览器(Chrome、Firefox),适合动态网站。功能强大,但对非程序员来说太复杂。

一句话总结: 这些库对开发者很友好,但对业务用户来说,感觉像是造火箭去买披萨。

AI网页爬虫:让数据采集变得人人都能玩

这才是最让人兴奋的地方。像这样的AI网页爬虫,正在彻底改变游戏规则,让不会写代码的人也能轻松采集网页数据。

Thunderbit怎么玩

- AI智能识别字段: 一键点击,AI自动分析页面,推荐要提取的列和数据类型,完全不用看HTML。

- 两步操作: 只需“AI智能识别字段”和“开始爬取”两步,剩下的全交给AI。

- 子页面采集: 需要更详细信息?Thunderbit能自动访问每个子页面(比如商品页或个人资料页),让你的数据表更丰富。

- 一键导出: 数据直接导出到Excel、Google Sheets、Airtable或Notion。

- 云端/本地采集任选: 云端采集速度快(可同时处理50页),本地采集适合需要登录的网站。

真的就是这么简单。我见过很多非技术用户,从“完全不懂选择器”到“10分钟内抓取500个竞品商品”,轻松搞定。

Thunderbit和传统Java爬虫对比一览

| 功能 | 传统Java | Thunderbit AI 网页爬虫 |

|---|---|---|

| 搭建时间 | 数小时到数天 | 几分钟(安装Chrome插件) |

| 技能要求 | Java、HTML、CSS、调试 | 无需编程(只需会用网页) |

| 维护 | 手动、持续维护 | AI自动适应,无需操心 |

| 数据导出 | 需写代码 | 一键导出到Excel、Sheets、Airtable、Notion |

| 动态内容 | 复杂(需Selenium/HtmlUnit) | 自动处理,无需配置 |

| 子页面采集 | 需自写爬虫逻辑 | 内置功能,一键搞定 |

| 扩展性 | 需多线程、代理配置 | 云端并发采集 |

| 成本 | 开发者时间、服务器 | 价格亲民,有免费版 |

对大多数业务用户来说,Thunderbit的体验就像从手动挡换成自动驾驶。

Java网页爬虫实操简明流程

还想试试Java?这里有一份超简明流程:

-

环境搭建: 安装Java开发工具包(JDK)和IDE(如IntelliJ或Eclipse),加上Jsoup等HTML解析库()。

-

确定目标: 浏览器打开目标网站,检查HTML,找到你要的数据元素(比如商品名、价格)。

-

写代码: 用Jsoup抓页面并选数据。例如:

1Document doc = Jsoup.connect("http://example.com/page").get(); 2Elements prices = doc.select("span.price"); 3for (Element price : prices) { 4 System.out.println(price.text()); 5} -

处理分页: 改URL或跟“下一页”链接循环抓多页。

-

导出数据: 把结果写进CSV文件,方便Excel或Google Sheets打开。

-

测试和优化: 跑爬虫,调bug,调整选择器。

Java爬虫维护小技巧

- 监控输出: 定期检查结果,防止数据丢失。

- 集中管理选择器: 把所有HTML选择器集中管理,方便后续改动。

- 应对封禁: 被封时用代理、切User-Agent。

- 写好注释: 代码多写注释,记录每部分作用。

- 合规合法: 爬之前一定看清网站服务条款和robots.txt。

如果觉得这些太麻烦……确实,这也是越来越多团队转向AI工具的原因。

什么时候选AI网页爬虫如Thunderbit

到底怎么选?多年实战给你点建议:

适合用Java的场景:

- 需要高度定制逻辑、深度集成或大规模采集。

- 公司对安全或合规有严格要求。

- 有开发资源和时间维护代码。

适合用Thunderbit(或其他AI网页爬虫)的场景:

- 不会编程,或者不想写代码。

- 需要快速拿到数据,搭建门槛低。

- 网站结构经常变,或者要采集很多不同网站。

- 想直接导出到Excel、Google Sheets、Airtable或Notion。

- 更看重效率和省心。

Thunderbit特别适合销售、电商、房产等团队,自动化重复数据采集,无需IT支持。也适合临时项目、快速获客或竞品监控——只要你追求高效和简单。

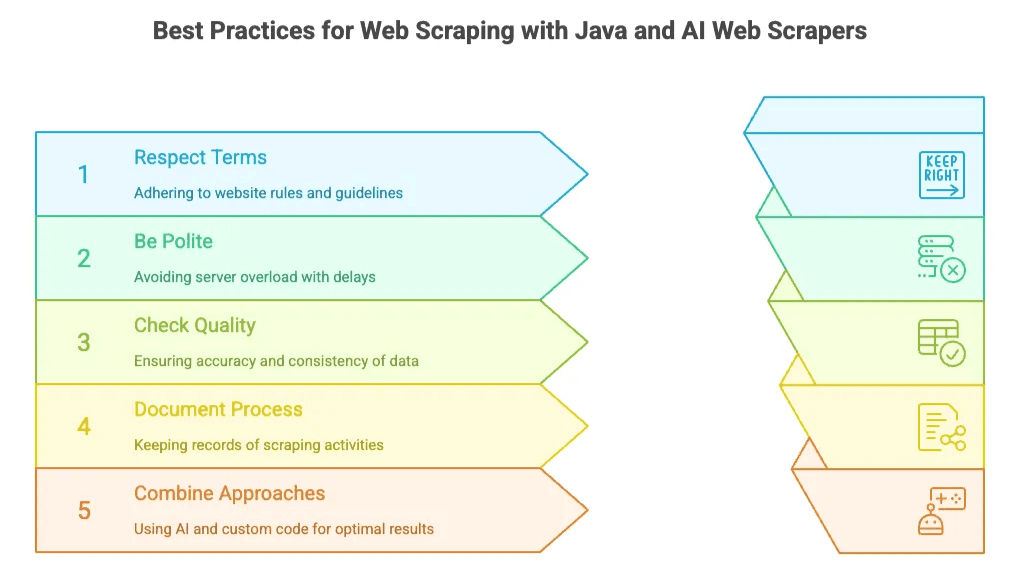

Java与AI网页爬虫的最佳实践

不管你选哪种方式,都有一些通用黄金法则:

- 遵守网站规则: 一定要看robots.txt和服务条款,别采集隐私或敏感数据。

- 礼貌抓取: 别高频请求服务器——写代码时加延迟,AI工具自带限速。

- 检查数据质量: 定期核查输出数据的准确性和完整性。Thunderbit的“字段AI提示”能实时清洗和结构化数据。

- 记录流程: 记下采集了哪些数据、来源和频率。

- 灵活结合: 有时候先用AI工具快速采集,再用自定义代码做深度处理,是最优解。

总结:2025年业务用户的网页爬虫新格局

2025年的网页爬虫,选择更多样。Java依然是企业级、高度定制项目的主力。但对绝大多数业务用户——销售、市场、运营——AI网页爬虫如的崛起,意味着你不用开发技能也能轻松搞定网页数据。

市场前景也很猛:全球网页爬虫软件市场预计到2030年能到,将在2028年前用上自动化分析工具。结论很明确:数据驱动决策已成主流,工具只会越来越强大。

还在犹豫?不如试试,免费上手,几次点击就能完成你想象不到的工作量。(如果你是热爱Java的开发者也别担心——大项目、复杂需求依然离不开你的专业能力!)

想了解更多?欢迎访问,深度教程、实用技巧全都有,包括和。

祝你爬虫顺利,数据永远新鲜、准确、触手可得。要是生活中一切都这么简单就好了!

常见问题

1. 为什么2025年还有人用Java做网页爬虫?

Java依然是大规模、企业级爬虫的首选,速度快、稳定性高、灵活性强。适合金融数据监控、竞品价格追踪、超大线索库采集等需要精细控制或后端集成的场景。

2. 用Java爬虫有哪些缺点?

虽然功能强大,但Java爬虫也有不少挑战:学习门槛高、维护成本大、HTML变动频繁导致易失效、难以处理JavaScript动态页面、还要配置代理、验证码、分页等复杂流程。

3. Thunderbit等AI工具如何简化爬虫流程?

Thunderbit全自动化采集流程:AI识别字段、处理动态内容、自动跳转子页面、数据一键导出到Excel或Notion。无需写代码、无需懂HTML,零配置,非技术用户也能轻松上手。

4. 什么时候该用Thunderbit而不是Java?

Thunderbit适合需要快速、可靠数据、又不想写代码的业务用户。非常适合销售拓客、电商监控、临时调研等场景,追求高效和简单优先于极致定制。

5. Java和AI爬虫工具能结合用吗?

当然可以。很多团队会先用Thunderbit等AI工具快速采集,再用Java做更复杂或大规模的任务。灵活组合,兼顾易用性和定制化。

了解更多: