还记得我第一次用 JavaScript 写网页爬虫,想给销售团队搞个线索名单的时候,心里还挺自信:“我会写 JavaScript,这活儿能有多难?”结果没几个小时就被各种奇葩选择器、动态消失的内容和反爬机制折磨得头大。后来才发现,这种情况其实很普遍——都觉得数据对业务越来越重要,而网页爬虫正是这个趋势的核心工具。但随着网页技术越来越花哨,使用 JavaScript 网页爬虫既是利器,也是挑战。

这篇教程我会结合自己的踩坑经历,带你从入门到进阶,系统梳理如何用 JavaScript 网页爬虫搞定数据采集,还会介绍像 这样的 AI 网页爬虫工具,帮你轻松解决选择器混乱等头疼问题。不管你是做电商商品信息整理,还是帮销售团队搭建线索库,这里都能找到实用的解决方案。咱们一起看看怎么用 JavaScript(加点 AI 助力)高效搞定网页数据抓取。

用 JavaScript 网页爬虫:基础玩法和局限

先说说基本原理:用 JavaScript 网页爬虫,就是写脚本自动从网站提取数据,可以直接在浏览器里跑,也能用 Node.js 在后端执行。JavaScript 作为网页的“母语”,用它来爬数据特别顺手,尤其是有一堆好用的库,比如 Cheerio(解析静态 HTML)、Puppeteer 和 Playwright(无头浏览器自动化)。

为啥大家都爱用 JavaScript?

- 直接操作 DOM: 在浏览器里,像用户一样随便折腾页面结构。

- 生态丰富: Node.js 有超多 HTTP 请求、解析和自动化的库。

- 灵活性高: 登录、点击、滚动……你在 Chrome 里能做的,脚本都能搞定。

但问题也不少:现在的网站更新快,内容经常用 JavaScript 动态加载,DOM 结构说变就变,还会有各种反爬机制。你今天写的爬虫脚本,明天可能就废了。你会一直在修选择器、处理弹窗、追着异步加载的数据跑。感觉就像打地鼠游戏,只不过多了很多大括号。

为什么复杂网页让 JavaScript 网页爬虫头大

以前,爬网页只要拿到 HTML,解析出需要的数据就行。但现在的网站完全变样了。像 Facebook Marketplace、亚马逊,甚至本地房产网站,都是用 JavaScript 框架动态渲染内容,数据藏在无限滚动、嵌套的 DOM 结构里。

传统的 HTML 解析已经不够用了。比如,想抓商品评论或嵌套留言,不只是找到 <div> 就完事了,还得理解元素之间的关系、每个字段的上下文,甚至要明白数据背后的意思。

这时候,智能预处理就很重要了。与其盲目抓 HTML,不如用语义理解的方式识别页面内容:哪里是商品名,哪里是价格,哪里是用户评价。这对普通 JavaScript 脚本来说很难,但 AI 驱动的工具却能轻松搞定。

传统 JavaScript 网页爬虫方案

说到工具,经典的 JavaScript 网页爬虫技术栈一般包括:

- Cheerio: 适合解析静态 HTML,像服务器端的 jQuery。

- Puppeteer/Playwright: 无头浏览器自动化,可以模拟真实用户操作,执行 JavaScript,适合处理动态页面。

常见的流程大致是这样:

- 请求页面(可以用无头浏览器,也可以不用)。

- 等待内容加载(比如用

waitForSelector等待元素出现)。 - 解析 DOM,提取目标数据。

- 整理和输出结果。

听起来很简单?但现实是:只要网站改了布局,选择器就失效;多了个弹窗,脚本就卡住;字段顺序一变,数据就乱套。维护脚本成了无休止的体力活。

主流 JavaScript 网页爬虫库对比

| 功能 | Cheerio | Puppeteer | Playwright |

|---|---|---|---|

| 适用场景 | 静态 HTML | 动态页面 | 动态页面 |

| 浏览器自动化 | 否 | 是 | 是 |

| 支持 JS 内容 | 否 | 是 | 是 |

| 速度 | 快 | 较慢 | 较慢 |

| API 简单度 | 简单 | 中等 | 中等 |

| 反爬能力 | 有限 | 一般 | 一般 |

| 多浏览器支持 | 否 | 仅 Chrome | Chrome、Firefox、WebKit |

| 典型用途 | 简单网站、API | 交互型网站 | 交互型网站 |

Cheerio 适合处理静态页面或返回 HTML 的 API,速度快但不能执行 JavaScript。Puppeteer 和 Playwright 适合动态内容,但更重、配置更复杂。它们能自动化登录、点击、滚动等操作,但每次页面一变都得重写逻辑。

Thunderbit 上场:为 JavaScript 网页爬虫加点 AI

这时候,Thunderbit 就特别有用了。我们发现,网页爬虫的难点不仅仅是抓 HTML,更在于像人一样理解页面。所以我们开发了 ,一款AI 网页爬虫 Chrome 插件,让网页爬取具备语义理解能力。

它是怎么做到的?

- Thunderbit 会把网页转成Markdown 格式,让页面结构更清晰、易分析。

- AI 会分析 Markdown,自动识别字段、关系和上下文——比如区分价格、评论和装饰性表情。

- 最终,你拿到的是结构化、带标签的数据,不怕页面布局变化、内容动态加载或 DOM 结构调整。

对企业来说,这意味着更少的数据清洗、更少脚本维护、更多时间专注于数据洞察。对开发者来说,你可以专注于自动化浏览(登录、点击、滚动),数据提取的繁琐部分交给 Thunderbit。

实操演示:用 JavaScript 网页爬虫抓数据(传统 VS Thunderbit)

下面来点实战:以抓电商网站商品列表为例,先用 Puppeteer 传统方式搞一遍,再看看用 Thunderbit 怎么提升效率。

步骤 1:搭建 JavaScript 网页爬虫环境

首先,你得装好 。装好后,执行下面的命令装 Puppeteer:

1npm install puppeteer如果你更喜欢 Playwright(支持更多浏览器),可以用:

1npm install playwright不懂技术也没关系,直接复制代码用就行,后面我会详细讲每一步。

步骤 2:自动化操作动态页面

现在的网站经常把数据藏在登录、弹窗、无限滚动后面。用 Puppeteer 可以自动化这些操作:

1const puppeteer = require('puppeteer');

2(async () => {

3 const browser = await puppeteer.launch({ headless: true });

4 const page = await browser.newPage();

5 // 进入登录页

6 await page.goto('https://example.com/login');

7 await page.type('#username', 'your_username');

8 await page.type('#password', 'your_password');

9 await page.click('#login-button');

10 await page.waitForNavigation();

11 // 跳转到商品列表页

12 await page.goto('https://example.com/products');

13 // 滚动加载更多商品

14 await page.evaluate(async () => {

15 for (let i = 0; i < 5; i++) {

16 window.scrollBy(0, window.innerHeight);

17 await new Promise(resolve => setTimeout(resolve, 1000));

18 }

19 });

20 // 等待商品加载完成

21 await page.waitForSelector('.product-card');

22 // ...(下一步提取数据)

23})();这个脚本会自动登录、跳转到商品页并滚动加载更多内容。关键是要等元素加载出来,不然抓到的就是一片空白。

步骤 3:用 JavaScript 提取数据

现在来抓数据。假设每个商品都在 .product-card 里:

1const products = await page.$$eval('.product-card', cards =>

2 cards.map(card => ({

3 name: card.querySelector('.product-title').innerText,

4 price: card.querySelector('.product-price').innerText,

5 link: card.querySelector('a').href,

6 }))

7);

8console.log(products);常见问题:

- 选择器容易失效。 比如

.product-title改成.title,脚本就挂了。 - 数据被隐藏。 有些价格或评论是页面加载后通过 AJAX 动态获取的。

- 反爬机制。 请求太频繁容易被封。

步骤 4:用 Thunderbit AI 提升数据提取效率

这时候就可以用 Thunderbit 了。你不用再为选择器和复杂逻辑头疼,只要把渲染后的 HTML(甚至截图)交给 Thunderbit,AI 就能帮你提取数据。

实际操作流程:

- 用 Puppeteer 或 Playwright 自动化浏览、登录、导航。

- 到目标页面后,获取 HTML 内容:

1const pageContent = await page.content();- 把 HTML 交给 Thunderbit(通过 )进行 AI 提取。

Thunderbit 会:

- 把页面转成 Markdown,方便语义解析。

- 用 AI 自动识别字段、关系和上下文。

- 输出结构化数据,可一键导出到 Excel、Google Sheets、Airtable 或 Notion。

再也不用追着变动的选择器和脏数据跑了。

动态内容与异步加载的破解思路

动态内容是所有爬虫的噩梦。很多网站喜欢在初次渲染后再加载数据,比如无限滚动、“加载更多”按钮、AJAX 评论等。

传统做法:

- 用

waitForSelector等待元素出现。 - 等待“网络空闲”状态(没有新请求时再抓取)。

- 手动模拟滚动或点击加载更多。

但这些方法都很脆弱,网站一改加载逻辑,脚本就失效。

Thunderbit 的优势: 通过把页面转成 Markdown,让 AI 分析结构,Thunderbit 不依赖具体的 DOM 层级或 ID。只要内容还在,AI 基本都能找到并提取出来。这样维护成本更低,数据更稳定可靠。

构建可持续的数据管道:从脚本到业务洞察

网页爬取不是一次性的活儿,而是数据管道的起点。我的建议是:

- 用 JavaScript(Puppeteer/Playwright)自动化浏览和数据抓取。

- 交给 Thunderbit 进行 AI 结构化和标签化处理。

- 导出结果到你常用的工具:Excel、Google Sheets、Airtable、Notion。

- 用 Thunderbit 的 定期自动抓取——只需描述时间(比如“每周一上午 9 点”),输入网址,其余交给 Thunderbit。

- 数据回流业务流程,无论是销售跟进、价格监控还是市场调研。

这种组合——JavaScript 负责自动化,Thunderbit 负责 AI 提取——让你轻松搭建可复用、低维护的数据管道,让企业始终拥有最新、准确的数据。

总结:怎么选适合你的网页爬虫方案

那到底用 JavaScript 网页爬虫哪种方式最好?我的建议是:

- 传统 JavaScript 网页爬虫(Cheerio、Puppeteer、Playwright)适合简单静态页面,或者你需要完全控制自动化流程时。但维护成本高——选择器容易坏,页面常变,反爬越来越难。

- AI 驱动的 Thunderbit 增加了语义理解层,更抗变化,数据清洗更省心,让你专注于数据洞察而不是修脚本。

什么时候用哪种?

- 简单页面、一次性抓取:用 Cheerio 或 Puppeteer 就够了。

- 复杂动态网站,或者想让流程更稳健:用 JavaScript 脚本配合 Thunderbit AI 提取。

- 不想写代码的业务用户:Thunderbit Chrome 插件两步就能把网页变成表格。

想看更多案例?欢迎访问 ,深入了解、等实战技巧。

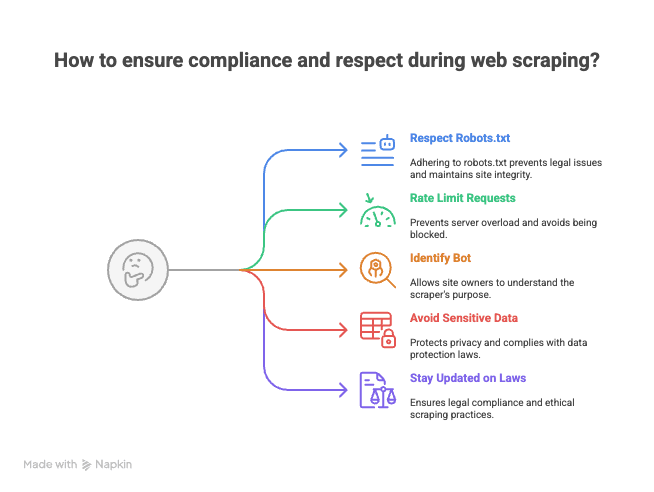

彩蛋:网页爬取合规与礼仪小贴士

在你放飞爬虫脚本之前,给你几点建议(来自一个曾经收到过“友好”警告邮件的同行):

- 遵守 robots.txt 和网站服务条款。 不是每个网站都欢迎被爬取。

- 控制请求频率。 别猛刷服务器,适当间隔,避免被封(甚至拉黑)。

- 标识你的爬虫。 设置自定义 User-Agent,让站长知道你是谁。

- 避免抓取敏感或个人数据。 只采集公开信息,尊重隐私。

- 关注法律法规和最佳实践。 网页爬虫在部分地区属于法律灰区。

记住:爬虫虽强,责任更大(偶尔还会收到律师函)。

用 JavaScript 网页爬虫既是技术活,也是艺术。选对工具,加上 AI 助力,你就能把互联网变成自己的结构化数据宝库。如果遇到难题,欢迎来找我——我大概率正一边调试选择器,一边喝咖啡,一边开着 Thunderbit。

祝你爬虫顺利!

常见问题解答

1. 什么是使用 JavaScript 进行网页爬取?为啥它这么流行?

用 JavaScript 网页爬虫,就是通过浏览器脚本或 Node.js 后端自动提取网站数据。它流行的原因在于可以直接操作 DOM,拥有丰富的 HTTP 请求和自动化库,还能灵活模拟登录、点击、滚动等操作。

2. 抓取现代动态网站的主要难点有哪些?

现代网站大量用 JavaScript 框架动态加载内容,数据常常藏在无限滚动或弹窗后,页面结构也经常变化。这让传统爬虫方法很脆弱,选择器一变或数据异步加载,脚本就容易失效。

3. Cheerio、Puppeteer、Playwright 这些传统爬虫工具有啥区别?

- Cheerio 适合静态 HTML,速度快,但不能处理动态内容或自动化浏览器。

- Puppeteer 和 Playwright 适合动态页面,支持浏览器自动化和 JS 内容,但速度较慢、配置更复杂。Playwright 支持多浏览器,Puppeteer 主要针对 Chrome。

4. Thunderbit 相比传统爬虫方法有哪些优势?

Thunderbit 利用 AI 把网页转为结构化 Markdown,再自动提取带标签的数据字段。这种方式更抗页面变化,减少手动清洗和维护,远比传统选择器爬虫省心。

5. 网页爬取时怎么合规、尊重网站?

- 一定要查看并遵守网站的 robots.txt 和服务条款。

- 控制请求频率,别给服务器添麻烦。

- 用自定义 User-Agent 标识你的爬虫。

- 不要抓取敏感或个人数据,只采集公开信息。

- 关注相关法律法规和行业最佳实践。

延伸阅读: