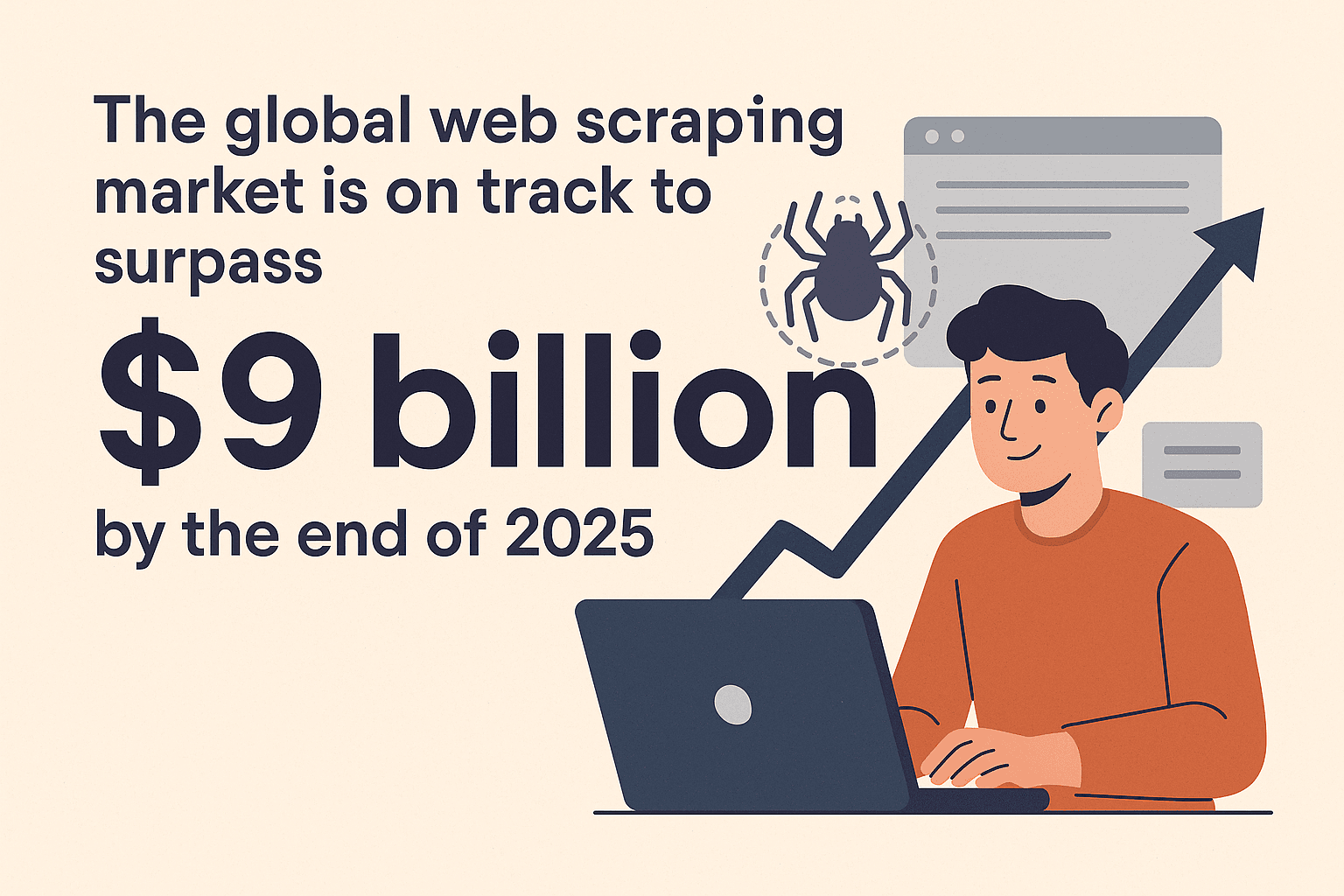

在这个数据爆炸的时代,谁能把数据用得溜,谁就能抢占先机。每天有数十亿个网页被爬取,这些数据被用来做洞察分析、价格监控、商机挖掘和学术研究——不管是电商价格战还是 AI 创新,背后都离不开网页数据的支持()。全球网页爬虫市场预计到2025 年底会突破 90 亿美元,如果你还没用上高效的网页爬虫工具,可能已经错过不少机会了()。

作为一个长期混迹在 SaaS 和自动化圈子里的老玩家,我太清楚选对爬虫工具对项目成败有多关键了。最近,Rust 在网页爬虫领域的表现真让我眼前一亮。这篇指南就带你看看 Rust 为什么适合做网页爬虫,怎么一步步上手,还会教你如何把 Rust 和 这样的 AI 工具结合起来,体验速度、安全和高效的三重暴击。

为什么用 Rust 写网页爬虫?

直接上干货:为啥选 Rust?很多习惯用 Python 或 Node.js 抓数据的朋友都问过我。Rust 的优势主要有:

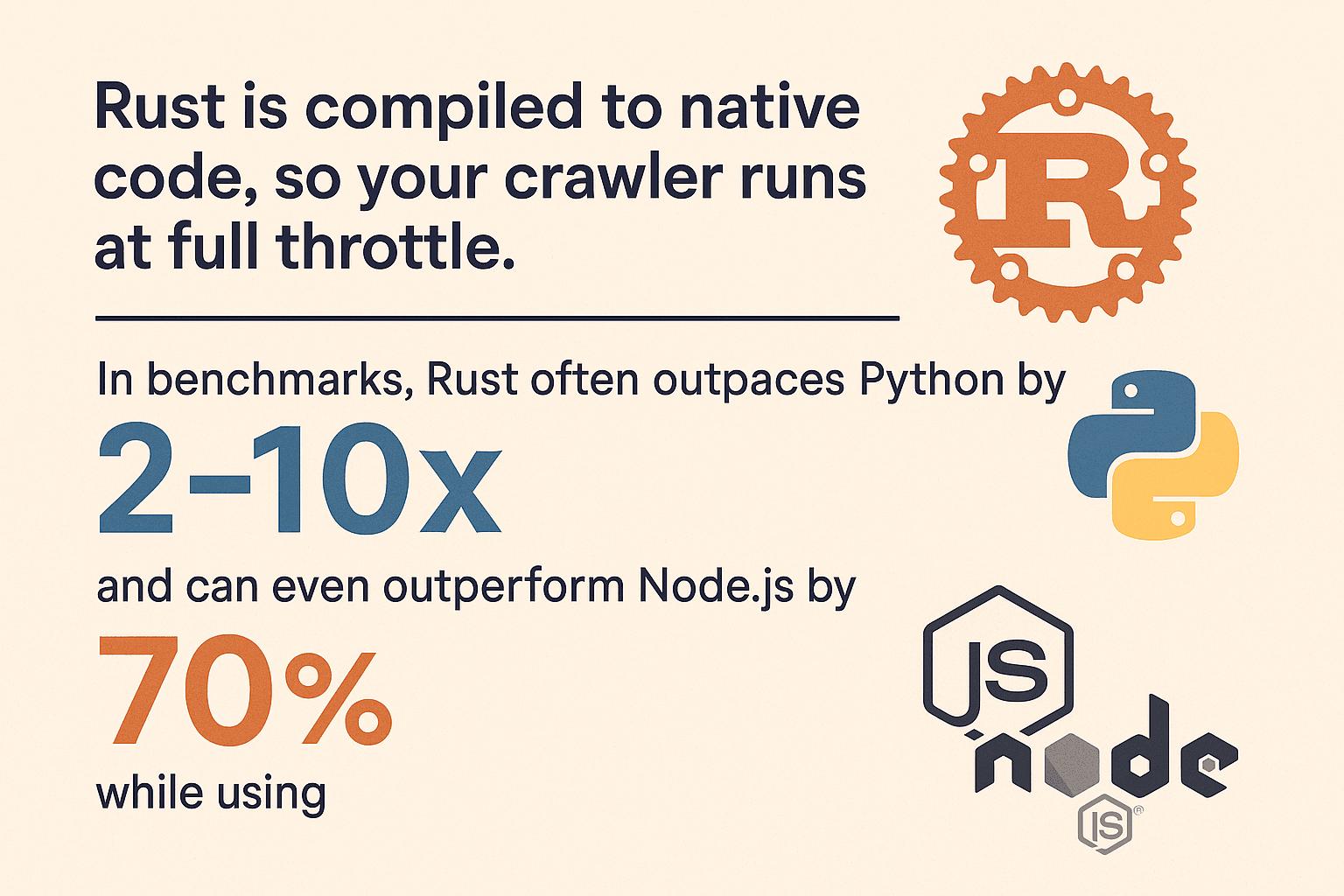

- 性能爆表:Rust 编译出来就是本地代码,爬虫跑起来飞快。各种基准测试里,Rust 在计算密集型任务上通常比 Python 快2–10 倍,比 Node.js 还快70%,内存占用低到90%(, )。

- 内存安全:Rust 独有的所有权机制,直接把神秘崩溃和内存泄漏扼杀在摇篮里,编译器上线前就能帮你抓出大部分 bug。

- 并发无压力:Rust 天生支持并发,想同时爬 100 个页面?没问题,类型系统帮你守住线程安全,远离数据竞争。

- 高可靠性:Rust 的错误处理(

Result和Option)让你必须认真对待异常,爬虫不会因为一个请求挂掉就全线崩溃。 - 安全性强:没有缓冲区溢出、没有空指针,Rust 的安全保障让你的爬虫更不容易被恶意或异常网页内容攻击。

和 Python(简单但慢、吃内存)或 Node.js(I/O 快但单线程、内存高)比起来,Rust 在大规模爬取时能带来更高的性能和稳定性()。

rust 网页爬虫环境搭建

准备好了吗?跟我一步步搭建 Rust 开发环境:

1. 安装 Rust 和 Cargo

Rust 用 管理版本和 cargo 构建工具。下载对应系统的安装包,按提示操作就行。Windows 用户如果提示要装 Visual C++ Build Tools,按需装一下。

验证安装:

1rustc --version

2cargo --version能看到版本号就说明搞定了。

2. 新建项目

打开终端,输入:

1cargo new rust_web_crawler

2cd rust_web_crawler这样你就有了一个带 Cargo.toml 和 src/main.rs 的新项目。

3. 添加核心依赖

开发网页爬虫常用这些依赖:

- (HTTP 客户端)

- (CSS 选择器解析 HTML)

- (异步运行时,支持高并发)

- (数据导出)

添加依赖:

1cargo add reqwest scraper csv tokio --features full或者手动编辑 Cargo.toml:

1[dependencies]

2reqwest = { version = "0.11", features = ["blocking"] }

3scraper = "0.16"

4csv = "1.1"

5tokio = { version = "1.28", features = ["full"] }4. 选择开发工具

我个人推荐 VS Code 搭配 插件,代码补全、文档、Lint 都很全。大型项目也可以用 JetBrains CLion 或 IntelliJ + Rust 插件。

5. 常见问题排查

- 找不到

cargo?确认 Rust 的.cargo/bin已加到 PATH。 - Windows 下有提示就按需装 C++ 构建工具。

- 依赖报错可以试试

cargo update或检查Cargo.toml拼写。

rust 网页爬虫开发实战

下面我们来写个简单爬虫:抓网页、解析商品数据、导出 CSV。你可以在这基础上随意扩展。

Rust 抓取网页内容

先导入 reqwest:

1use reqwest::blocking::get;

2fn main() {

3 let url = "https://www.scrapingcourse.com/ecommerce/";

4 let response = get(url);

5 let html_content = response.unwrap().text().unwrap();

6 println!("{}", html_content);

7}生产环境建议用更健壮的错误处理:

1let response = match reqwest::blocking::get(url) {

2 Ok(resp) => resp,

3 Err(err) => {

4 eprintln!("Request failed for {}: {}", url, err);

5 return;

6 }

7};解析与提取数据

用 scraper 解析 HTML,提取商品信息:

1use scraper::{Html, Selector};

2let document = Html::parse_document(&html_content);

3let product_selector = Selector::parse("li.product").unwrap();

4for product in document.select(&product_selector) {

5 let name = product

6 .select(&Selector::parse("h2").unwrap()).next()

7 .map(|e| e.text().collect::<String>());

8 let price = product

9 .select(&Selector::parse(".price").unwrap()).next()

10 .map(|e| e.text().collect::<String>());

11 let url = product

12 .select(&Selector::parse("a").unwrap()).next()

13 .and_then(|e| e.value().attr("href"))

14 .map(|s| s.to_string());

15 let image = product

16 .select(&Selector::parse("img").unwrap()).next()

17 .and_then(|e| e.value().attr("src"))

18 .map(|s| s.to_string());

19 println!("Name: {:?}, Price: {:?}, URL: {:?}, Image: {:?}", name, price, url, image);

20}这种写法参考自 ,适合大多数电商或目录类页面。

管理 URL,避免重复抓取

实际项目里,通常要跟踪已访问页面,避免重复爬。常见做法如下:

1use std::collections::{HashSet, VecDeque};

2let mut to_visit = VecDeque::new();

3let mut visited = HashSet::new();

4to_visit.push_back(start_url.to_string());

5visited.insert(start_url.to_string());

6while let Some(url) = to_visit.pop_front() {

7 // Fetch and parse page...

8 for link in extracted_links {

9 let abs_link = normalize_url(&link, &url); // 推荐用 `url` crate

10 if !visited.contains(&abs_link) {

11 visited.insert(abs_link.clone());

12 to_visit.push_back(abs_link);

13 }

14 }

15}记得用 crate 规范化链接,处理相对路径、斜杠和锚点等问题。

并发抓取:让 Rust 性能全开

Rust 的并发能力真的很强。单线程爬取效率低,我们可以并行处理。

方案一:多线程

可以开多个线程,每个线程处理一部分队列。用 Arc<Mutex<>> 管理共享状态。适合小规模爬取。

方案二:Tokio 异步并发

大规模爬取推荐用异步。配合 tokio 和异步 reqwest,可以同时发起数百个请求,内存压力也小。

1use reqwest::Client;

2use futures::future::join_all;

3let client = Client::new();

4let urls = vec![/* ... */];

5let fetches = urls.into_iter().map(|url| {

6 let client_ref = &client;

7 async move {

8 match client_ref.get(url).send().await {

9 Ok(resp) => {

10 let text = resp.text().await.unwrap_or_default();

11 // Parse text...

12 }

13 Err(e) => eprintln!("Error fetching {}: {}", url, e),

14 }

15 }

16});

17join_all(fetches).await;异步 Rust 不仅快,还安全。没有数据竞争、没有莫名其妙的 bug,只有高吞吐()。

数据导出与存储

数据爬完后,通常要导出。用 crate 很方便:

1use csv::Writer;

2use std::fs::File;

3let file = File::create("products.csv").expect("could not create file");

4let mut writer = Writer::from_writer(file);

5writer.write_record(&["Name", "Price", "URL", "Image"]).unwrap();

6for prod in &products {

7 let name = prod.name.as_deref().unwrap_or("");

8 let price = prod.price.as_deref().unwrap_or("");

9 let url = prod.url.as_deref().unwrap_or("");

10 let image = prod.image.as_deref().unwrap_or("");

11 writer.write_record(&[name, price, url, image]).unwrap();

12}

13writer.flush().unwrap();也可以用 直接序列化结构体,或者导出为 JSON。

用 Thunderbit 提速网页数据采集

说到高效爬取,必须提一下 。虽然自己写代码很有成就感,但有时候你只想快速拿到数据。Thunderbit 是一款 AI 网页爬虫 Chrome 插件,几步点击就能爬数据,完全不用写代码。

Thunderbit 是一款 AI 网页爬虫 Chrome 插件,帮企业用户用 AI 从网页抓数据。它能大大提升效率,自动化网页上的重复性工作。

Thunderbit 有哪些亮点?

- AI 智能字段识别:Thunderbit 自动扫描页面,智能推荐可提取的字段,比如姓名、邮箱、价格等()。

- 一键抓取:点一下“抓取”按钮,数据自动整理成结构化表格。

- 子页面抓取:需要详情页数据?Thunderbit 能自动访问每个链接,丰富你的数据表()。

- 分页与无限滚动支持:自动识别并处理分页或无限滚动页面。

- 免费数据导出:支持导出到 Excel、Google Sheets、Notion、Airtable 或 CSV,操作超简单。

- AI 自动填表:自动填写表单或登录,轻松爬取登录后数据。

Thunderbit 对企业用户和开发者来说都是省时利器,尤其适合应对动态、复杂或大量 JavaScript 的网站。

什么时候用 Thunderbit,什么时候用 Rust?

- Thunderbit:适合快速原型、一次性爬取,或者让非技术同事也能参与数据采集。

- Rust:适合大规模、高度定制或需要深度集成的场景,追求极致性能和可控性。

其实,二者结合才是最强方案。

rust 网页爬虫与其他技术对比

来点技术流:Rust 和主流爬虫技术比起来怎么样?

| 语言/框架 | 速度 | 内存占用 | 并发能力 | 稳定性 | 生态 |

|---|---|---|---|---|---|

| Rust | 🚀🚀🚀 | 🟢 低 | 🟢 极佳 | 🟢 高 | 中等 |

| Python (Scrapy) | 🚀 | 🔴 高 | 🟡 一般 | 🟡 中等 | 🟢 丰富 |

| Node.js | 🚀🚀 | 🔴 高 | 🟢 良好 | 🟡 中等 | 🟢 丰富 |

| Go | 🚀🚀 | 🟢 低 | 🟢 极佳 | 🟢 高 | 中等 |

- Rust 通常比 Python 快2–10 倍,内存占用不到10%(, )。

- Node.js I/O 性能不错,但 JS 执行单线程,遇到复杂解析容易卡顿。

- Go 也是强劲对手,但 Rust 的内存安全和零成本抽象让它在高并发、长时间运行场景更胜一筹。

如果你追求大规模爬取或极致性能,Rust 绝对是首选。

Thunderbit + Rust:效率最大化的组合

我最喜欢的工作流:Thunderbit 搭配 Rust。

- 快速原型:用 Thunderbit 快速摸清网站结构,采集样本数据,为后续开发打好基础。

- 分工协作:让 Thunderbit 处理动态、登录等复杂页面(AI 自动填表、子页面抓取),Rust 负责静态或 API 驱动页面的批量爬取。

- 定时爬取:Thunderbit 支持定时任务,定期采集数据,Rust 后端再做处理或合并。

- 赋能非开发者:让运营、市场同事用 Thunderbit 自助采集,开发专注于复杂需求。

- 弹性应对变化:Rust 爬虫因页面结构变化失效时,Thunderbit 的 AI 能快速适应,无需改代码。

这种混合方案兼顾了 Thunderbit 的灵活高效和 Rust 的强大可控。

rust 网页爬虫常见问题与最佳实践

想让爬虫更稳健,除了写好代码,还要应对真实网络环境的各种挑战。

常见难题

- 反爬机制:用真实 User-Agent,遵守

robots.txt,合理限速,必要时用代理()。 - 验证码与登录:遇到验证码或复杂登录,可以用 Thunderbit 的 AI 自动填表,或者用 、 等无头浏览器(只在必要时用)。

- JS 动态页面:数据通过 AJAX 加载时,优先找 API 接口;必须渲染 JS 时,建议用 Thunderbit 或无头浏览器。

- 错误处理:始终用

Result、Option处理异常,设置超时,记录日志方便排查。 - 并发陷阱:用线程安全结构(如

Arc<Mutex<>>或DashMap),避免共享状态成瓶颈。 - 内存管理:大规模爬取时,及时把数据写盘,避免内存爆掉。

- 合规与道德:遵守网站协议,别恶意刷,注意数据隐私法规。

最佳实践

- 模块化设计:抓取、解析、存储分离,便于维护。

- 参数可配置:用配置文件或命令行参数管理 URL、并发数、延迟等。

- 日志记录:用

logcrate 做结构化日志。 - 单元测试:用样例 HTML 测试解析逻辑。

- 监控健康:关注 CPU、内存、错误等指标,尤其是长时间运行的任务。

更多排查技巧可以参考 和 。

总结与核心要点

用 Rust 写网页爬虫,不只是技术挑战,更是数据时代的竞争利器。记住这些:

- Rust 是网页爬虫神器:速度快、安全性高、并发能力强。

- 循序渐进很重要:环境搭建、抓取解析、URL 管理、并发优化、数据导出,每一步都值得打磨。

- Thunderbit 是你的秘密武器:不用写代码,轻松搞定复杂或动态页面。

- 二者结合效率更高:Thunderbit 适合原型和难啃页面,Rust 适合大规模和定制化。

- 务实为王:有时候,几次点击比写几百行代码更高效。

如果你想提升网页爬取能力,不妨试试 Rust,也别忘了让 帮你省时省力。想了解更多爬虫和自动化技巧?欢迎关注 。

祝你爬取顺利,数据又快又干净,还能更智能一点!

常见问题解答

1. 为什么用 Rust 开发网页爬虫,而不是 Python 或 Node.js?

Rust 性能更强,内存安全,并发支持好。Python、Node.js 适合写脚本,Rust 更适合大规模、长时间或对稳定性要求高的场景()。

2. rust 网页爬虫常用哪些库?

推荐用 reqwest 处理 HTTP 请求,scraper 解析 HTML,tokio 实现异步并发,csv 导出数据,url crate 规范化链接。

3. Rust 如何爬取 JS 动态或需登录的网站?

JS 动态页面优先找 API 接口,或者用 fantoccini 等无头浏览器。登录页面可以用 reqwest 管理 Cookie,或者用 Thunderbit 的 AI 自动填表功能。

4. Thunderbit 和 Rust 结合有什么优势?

Thunderbit 用 AI 实现无代码爬取,适合原型、动态页面或非开发者。Rust 适合定制化、高性能爬虫。二者结合,既快又能扩展。

5. 如何避免爬虫被封禁?

遵守 robots.txt,用真实请求头,限速,必要时用代理。始终合规爬取,尊重网站协议和数据隐私法规()。

想体验 Thunderbit 的强大功能?,开启高效网页爬取之旅。更多自动化干货,欢迎访问 。

延伸阅读