你有没有想过,为什么 Google 能把互联网上的每个角落都“翻”出来——甚至连你 2012 年写的那篇冷门博客都能搜到?其实,这背后既不是魔法,也不是一群实习生熬夜刷网页。真正的幕后主角是爬虫:这些数字化“侦查员”24 小时不间断地扫描、整理和索引全球的网站。作为一个长期玩自动化和 AI 工具的老手(偶尔也“误伤”过几个网站),我太清楚这些机器人对我们日常上网体验的影响了。如果你自己有网站,了解爬虫绝对不是极客的专利——它直接决定了你的网站是被发现,还是被埋没。

接下来,我们就来揭开爬虫的神秘面纱,看看它们是怎么“看见”你的网站、为什么它们是 SEO 的核心,以及你该怎么做才能让自己的网站内容不被信息洪流淹没。作为自动化爱好者,我还会聊聊像 这样的 AI 工具,如何给网站运营和数据团队带来全新玩法。

爬虫网站基础:它们到底是什么,怎么工作的?

你可以把爬虫想象成一位数字图书管理员——或者说是一只拿了博士学位的蜘蛛——它的任务就是顺着链接,一步步探索整个互联网。从技术角度来说,爬虫(也叫 spider 或 bot)是一种自动化软件,会系统性地浏览网站,抓取页面、跟踪链接,并收集内容信息。正是靠这些爬虫,Google、Bing 等搜索引擎才能建立庞大的网页索引库。

基本流程其实很简单:

- 从一组已知网址出发(比如你的网站首页或一批“种子”站点)。

- 抓取每个页面的 HTML 内容。

- 提取页面里的超链接,把新链接加入待访问列表。

- 重复上面步骤,不断跳转、记录新页面,并更新搜索引擎的索引库。

如果你脑补出一个图书管理员在书架间飞奔、记下每本书名并交叉整理——只是速度和规模都放大到互联网级别——那你就理解对了。没有爬虫,大部分网页内容都不会被搜索引擎发现,用户也就无从访问。

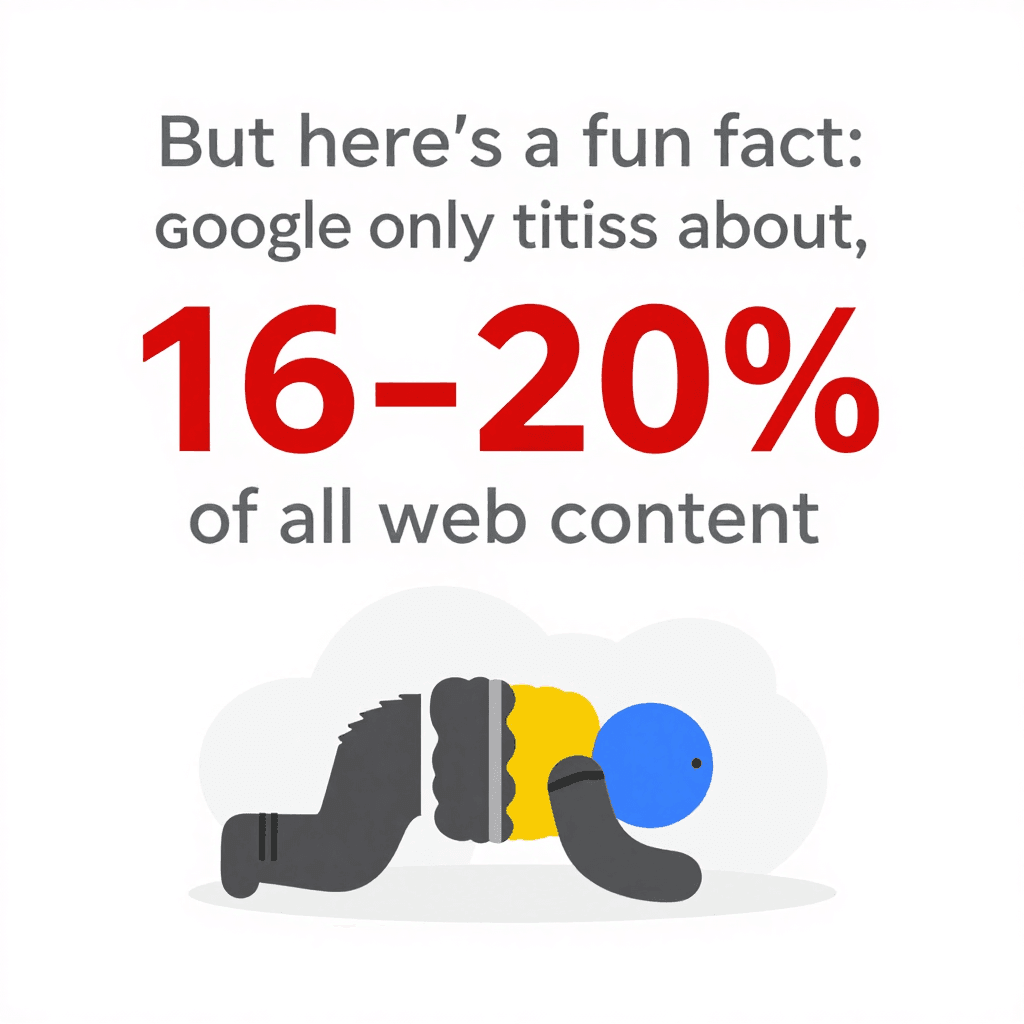

有意思的是:即使爬虫这么强,Google 实际上只索引了大约 。剩下的内容都藏在“深网”里,绝大多数爬虫根本碰不到。这也说明你的网站结构和对爬虫的友好程度,真的很关键。

有意思的是:即使爬虫这么强,Google 实际上只索引了大约 。剩下的内容都藏在“深网”里,绝大多数爬虫根本碰不到。这也说明你的网站结构和对爬虫的友好程度,真的很关键。

爬虫是怎么“看见”并理解网站内容的?

爬虫可不会像人一样欣赏你的网站。它们不关心你的字体、图片,或者你精心设计的动画。它们只会加载原始 HTML,扫描文本、读取标签、跟踪链接。就像是在看建筑蓝图,而不是亲自走进每个房间。

爬虫最关注的内容有:

- HTML 结构: 查找标题、段落、列表和链接。

- 站内链接: 这些链接就像道路,指引爬虫走遍网站的每个角落。如果某个页面没有被链接,爬虫基本上就找不到它。

- 导航和网站地图: 结构清晰的菜单和最新的网站地图就像 GPS,帮爬虫定位你最重要的内容。

- 元数据和结构化数据:

<title>、<meta description>还有 Schema.org 标记等标签,能让爬虫更好地理解页面主题,就算正文没直接写明。

如果你喜欢技术类比,可以把网站想象成一座城市,爬虫是快递员,站内链接和网站地图就是路标和地图,帮他们送达每一个地址。

网站地图和 robots.txt 对爬虫的影响

有两个文件对爬虫来说特别重要:

-

XML 网站地图: 这是你网站重要页面的机器可读清单。就像直接把所有书和位置列表交给图书管理员。一个完善的网站地图能确保爬虫不会漏掉关键内容——哪怕你的站内链接还不够完善。对于大型或结构复杂的网站,添加全面的网站地图可以 。

-

robots.txt: 这是放在网站根目录的简单文本文件,用来告诉爬虫哪些地方能进,哪些不能。比如你想让爬虫避开后台管理区或屏蔽重复页面,就可以在这里设置。但要注意:一个小小的笔误(比如

Disallow: /)就可能让整个网站都被搜索引擎屏蔽——这是 SEO 圈的经典“翻车现场”。合理用 robots.txt,可以 。

小建议:记得在 robots.txt 里指向你的网站地图,这就像告诉爬虫“从这里开始参观吧!”

为什么爬虫对你的网站这么重要:SEO 和流量的影响

说到底,如果爬虫进不去某个页面,那它就等于不存在。没被爬取 = 没有收录 = 没有搜索流量。你为内容、设计和品牌做的努力?如果 Googlebot 找不到,一切都白搭。

为什么这事儿这么重要?因为 ,而 。如果你的网站对爬虫不友好,就等于主动放弃了最大流量入口。

一个被爬虫顺利抓取的网站意味着:

一个被爬虫顺利抓取的网站意味着:

- 更多页面被收录: 增加出现在搜索结果的机会。

- 排名更高: 搜索引擎能更好地评估你内容的相关性。

- 内容更新更快: 新内容能被及时收录和排名。

- 用户体验提升: 用户能快速找到所需内容,提升网站权威和流量。

很多网站只要修复爬取问题(比如断链或误用 noindex 标签),流量就能大涨。这就是典型的“藏在明处”的问题。

爬虫对搜索排名的影响

搜索引擎会用爬虫收集的数据,判断哪些页面最适合某个搜索词。它们会关注:

- 内容质量和关键词

- 站内外链接

- 页面新鲜度和更新频率

- 移动端友好性(Google 现在是移动优先索引)

对于大型网站,还涉及 爬取预算——也就是搜索引擎在一定时间内愿意抓取的页面数量。如果你有 10 万个页面,但 Googlebot 每天只爬 5,000 个,全部收录可能要好几周。这也是为什么 (大部分页面距离首页只需几次点击)这么重要:它能让爬虫更高效地访问和重新抓取内容。

传统爬虫的局限:现代网站的挑战

问题来了。现在的网站到处都是 JavaScript、动态内容和登录墙。传统爬虫——尤其是基础型——很容易迷路、卡住,甚至直接放弃。

常见难题有:

- 动态内容和 JavaScript: 很多爬虫只能看到初始 HTML。如果你的内容是靠 JavaScript 加载的(比如无限滚动或“加载更多”按钮),基础爬虫可能啥都看不到。就算是 Google 的爬虫,虽然能渲染 JavaScript,但遇到内容加载慢或需要用户操作时,也经常只收录一部分()。

- 登录墙后的内容: 需要登录才能访问的页面,大多数爬虫都进不去。这通常是有意为之,但有时也会误把重要内容藏在登录后。

- robots.txt 或元标签配置错误: 一个小失误就可能让网站某些区域对爬虫关闭。

- 反爬虫机制: 比如验证码、频繁限流或屏蔽未知 User-Agent,都可能让爬虫“铩羽而归”。

现在 ,爬虫也不得不变得更聪明。但还是有很多内容会被遗漏。

传统爬虫难搞的场景:动态内容和 JavaScript

比如你运营一个电商网站,商品信息是随着用户滚动才加载的。传统爬虫可能只能看到前 20 个商品,剩下的全都“隐身”。又或者你的评论区需要点击标签页才显示——大多数爬虫也会错过。

结果就是:有价值的内容没被收录,搜索流量自然流失。解决办法是提供备用路径(比如分页链接或服务端渲染 HTML),并用 Google Search Console 的 URL 检查工具测试爬虫实际能看到什么。

更智能的爬虫工具:Thunderbit 如何应对复杂页面

这就是让我兴奋的地方——Thunderbit 就是为解决这些难题而生的。Thunderbit 不只是普通爬虫,它是 AI 驱动的网页数据采集助手,能像人类一样“理解”网页,提取结构化数据,轻松应对现代网页的各种复杂情况。

Thunderbit 有哪些独特优势?

- AI 智能字段推荐: 你不用自己分析 HTML 或写代码,Thunderbit 的 AI 会自动扫描页面,推荐最适合提取的字段(比如“产品名称”、“价格”或“联系邮箱”)。你可以微调,但大部分工作都自动搞定。

- 子页面采集: 需要更多细节?Thunderbit 能自动访问每个子页面(比如商品详情或用户资料),抓取补充信息,丰富你的主数据集。再也不用手动点开、复制粘贴。

- 支持 JavaScript 和登录: Thunderbit 作为 Chrome 插件运行(或在云端真实浏览器中),能执行 JavaScript、等待动态内容加载,甚至采集你已登录的页面。

- 适应网站变动: 传统爬虫遇到页面结构变化就容易“崩溃”,Thunderbit 的 AI 每次都会重新理解页面,小改动不会影响采集流程。

- 定时采集: 想每天早上自动监控价格或更新线索名单?只需用自然语言设定时间(比如“每周一上午 9 点”),剩下的交给 Thunderbit。

Thunderbit 专为业务用户设计——无论你是做销售、市场、电商还是房产,都能轻松获取所需数据,完全不需要技术门槛。导出到 Google Sheets、Notion 或 Airtable 也只需一键(而且完全免费)。

Thunderbit 的 AI 功能助力爬虫网站优化

Thunderbit 的核心亮点在于自然语言处理。它不仅仅是抓取文本,更能理解上下文。比如,它能区分电话号码、邮箱和产品价格,并在采集时自动标注、分类,甚至支持数据翻译。

用户反馈都很棒。有位用户说:“Thunderbit 是我获取网红联系方式的首选工具。以前要花钱买数据库,现在几分钟就能自己采集。”这就是我最喜欢看到的效率提升。

如果你曾经采集过那些每周都在变动布局的网站(比如某些电商平台),一定会喜欢 Thunderbit 的“免维护”体验。AI 会自动适应变化,你不用频繁修脚本。

优化你的网站以适应爬虫:结构、策略和智能工具

那怎么让你的网站成为爬虫的“天堂”?下面这些建议很实用:

- 设计合理的网站结构: 重要页面距离首页不超过几次点击。(导航广、层级浅)有助于提升爬取效率和收录率。

- 强化站内链接: 用上下文相关的链接串联相关页面,定期检查并修复断链。

- 维护最新的 XML 网站地图: 列出所有重要网址,并提交到 Google Search Console 和 Bing 站长工具。

- 优化 robots.txt: 允许爬虫访问核心内容,只屏蔽必要部分,避免误封。

- 提升网站速度: 页面加载快、无报错,爬虫抓取更高效。优化图片、用 CDN、修复服务器错误。

- 处理重复内容: 用 canonical 标签,避免爬取预算浪费在重复或近似页面上。

- 利用结构化数据和元数据: 给产品、文章、活动等加上 Schema.org 标记,合理管理 meta 标签。

- 监控爬取活动: 用 Google Search Console 的索引覆盖和爬取统计报告,及时发现问题。

- 用智能工具测试: 用 Thunderbit 或类似工具,模拟爬虫视角,保障数据采集和网站健康。

网站架构与爬虫需求的协同

合理的网站结构不仅有利于爬虫,也提升用户体验。定期用 Screaming Frog、Sitebulb 等工具审查网站,能及时发现爬取障碍、断链和孤立页面,避免影响排名。

别忘了移动端:Google 采用移动优先索引,移动站点必须包含所有重要内容和链接,否则会有页面被遗漏()。

Thunderbit 与传统爬虫工具对比

一图胜千言:

| 方面 | Thunderbit(AI 网页爬虫) | 传统爬虫/采集器 |

|---|---|---|

| 易用性 | 无需代码,AI 智能推荐字段,业务用户两步即可上手。 | 需技术配置,常常要写代码或手动设置选择器。 |

| 适应性 | AI 自动适应页面结构变化,几乎无需维护。 | 网站结构变动易导致采集失败,需手动修复。 |

| 动态内容支持 | 默认支持 JavaScript、登录和交互元素。 | 通常仅能抓取静态 HTML,难以处理 JS 或需登录内容。 |

| 子页面采集 | 内置子页面与分页采集,自动合并数据。 | 需手动设置深度,递归采集较繁琐。 |

| 数据结构化 | AI 输出结构化表格,支持多种数据类型(文本、数字、邮箱、图片、PDF 等)。 | 输出原始数据,需用户自定义结构,通常仅限 HTML,复杂需求需自写代码。 |

| 集成能力 | 一键导出到 Google Sheets、Notion、Airtable、CSV 等。 | 通常需手动导出/导入,集成有限。 |

| 反爬障碍应对 | 自动处理代理、User-Agent、重试等,采用瀑布式策略提升成功率。 | 用户需自行应对 IP 封禁、验证码等,配置复杂且成本高。 |

| 目标用户 | 非技术型业务用户:销售、市场、运营、电商、房产等。 | 开发者、IT、数据工程师。 |

| 价格模式 | 按用量计费,免费额度,按需付费。 | 订阅、按席位或服务器计费,代理和维护常有隐性成本。 |

一句话总结:Thunderbit 让强大的网页采集能力变得人人可用,不再是开发者的专属。它高效、准确,还能适应不断变化的互联网环境。

核心要点总结:让爬虫为你的网站赋能

- 爬虫是网站可见性的守门员。 如果你的网站对爬虫不友好,就会错失搜索流量和新用户。

- 结构和策略很重要。 合理的导航、站内链接、网站地图和 robots.txt 是你的好帮手。

- 现代网站需要更智能的爬虫。 JavaScript、动态内容和登录墙会难倒传统爬虫,但像 这样的 AI 工具能轻松应对。

- 持续监控不可或缺。 利用 Search Console、爬取审查和智能采集工具,保障网站健康与可见性。

- 升级你的工具箱。 无论是做 SEO 还是自建数据管道,智能爬虫都能帮你节省时间、提升准确率,助力业务决策。

想体验 Thunderbit 如何帮你抓取、索引并提取复杂网站的数据? 试试看。更多网页采集、SEO 和自动化技巧,欢迎访问 。

常见问题

1. 什么是爬虫?它对网站有啥用?

爬虫是一种自动化软件,会系统性地浏览和索引网站内容,供搜索引擎使用。如果你的网站对爬虫不友好,页面就可能无法出现在搜索结果里,用户也很难找到你。

2. 网站地图和 robots.txt 怎么影响爬虫?

网站地图能引导爬虫抓取你最重要的页面,robots.txt 则用来指定哪些区域能不能被访问。两者都是高效爬取和收录的关键。

3. 传统爬虫在现代网站上会遇到哪些问题?

传统爬虫难以处理大量 JavaScript、动态元素、需登录页面和反爬机制,导致重要内容被遗漏或只被部分收录。

4. Thunderbit 如何应对复杂网站?

Thunderbit 利用 AI 像人类一样“理解”页面,支持 JavaScript 和登录,能采集结构化数据,包括子页面和动态内容。无需写代码,自动适应网站变化。

5. 怎么让网站更适合爬虫抓取?

保持清晰的网站结构,合理设置站内链接,及时更新网站地图和 robots.txt,优化加载速度,定期监控爬取情况。用 Thunderbit 等智能工具测试和提升网站可爬性。

想深入了解?欢迎阅读更多 指南,或订阅我们的 ,获取最新网页自动化与 AI 采集资讯。

延伸阅读