互联网的版图正在以惊人的速度不断扩展。如果你在做生意、搞科技,或者像我一样是个数据控,你一定会发现:真正的价值,其实藏在你能收集到的数据里,而不仅仅是你眼前能看到的信息。现在,越来越多的公司都在加速自动化网页数据采集,全球网页爬虫行业预计到。更有意思的是,超过已经在用网页爬虫或爬虫工具为他们的 AI、数据分析和业务流程提供数据支持。

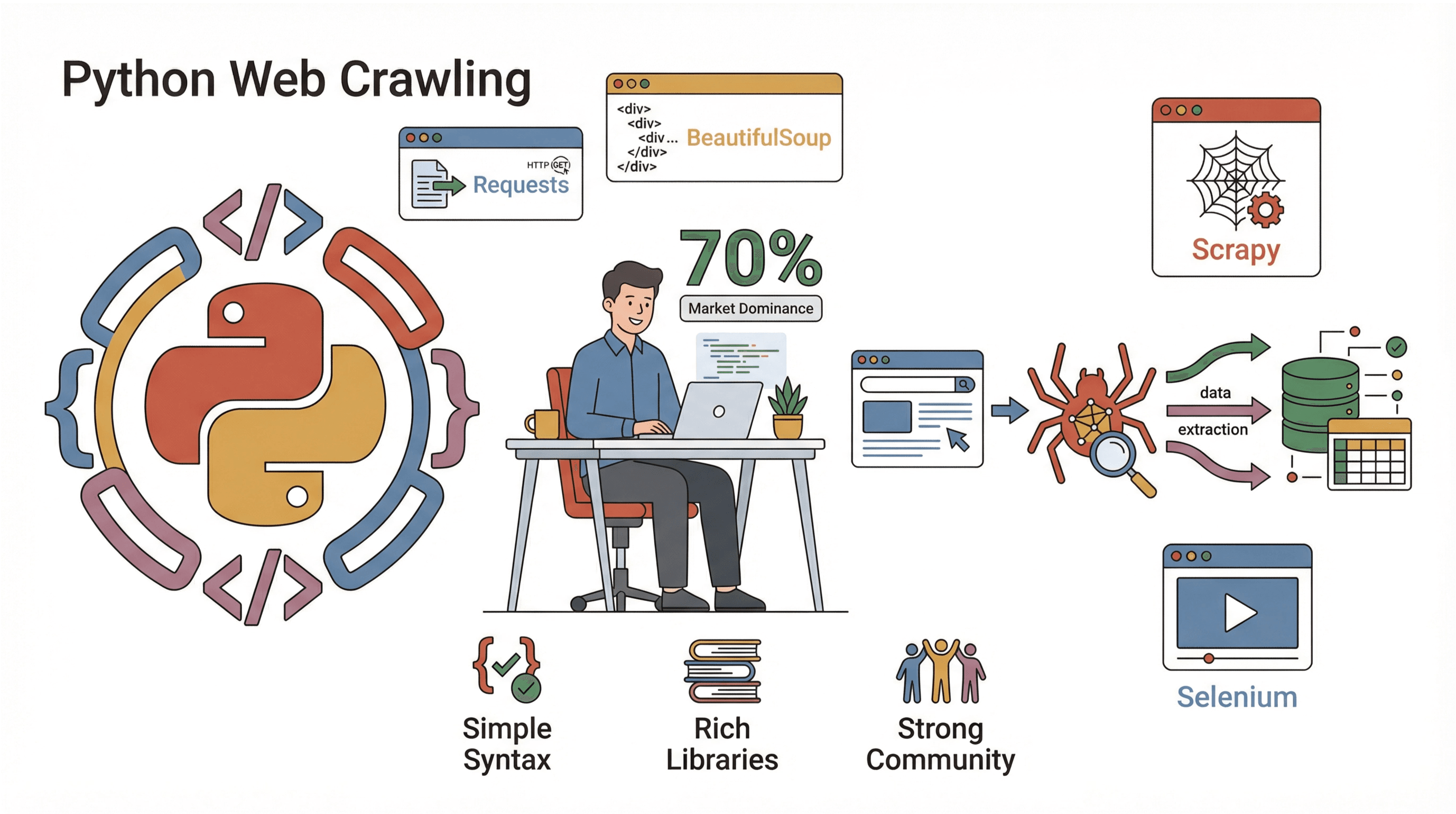

那怎么才能加入这场数据争夺战?对大多数人来说,答案就是 Python。它是开发网站爬虫的首选语言——简单好上手,功能又强大,还有一堆现成的库让你轻松搞定爬取和抓取。在这篇指南里,我会带你搞清楚什么是网站爬虫、为什么 Python 是最佳选择、怎么一步步搭建自己的爬虫,以及像 这样的工具如何让整个流程变得超级简单(尤其适合不想写代码、只想点点鼠标的你)。不管你是开发者、数据驱动的市场人,还是想自动化繁琐任务的普通用户,这里都能帮你提升你的网页数据能力。

什么是网站爬虫?(以及你为什么要关心它?)

简单来说,网站爬虫就是一种自动浏览网页的程序,它会自动访问页面、跟着链接走,并在需要的时候把数据采集下来。你可以把它想象成一个永远不会累、不会分心、也不会误关标签页的超级网络冲浪手。爬虫是搜索引擎(比如 Googlebot)的核心,但企业也会用它来做价格监控、市场调研等各种任务。

不过,爬取和抓取到底有什么区别?爬取(Crawling)是发现和遍历网页(就像画一张城市地图),而抓取(Scraping)是从这些页面里提取你想要的数据(比如收集全城的餐厅菜单)。实际项目里,通常是两者结合:先爬取页面,再抓取你需要的数据(参考 )。

爬虫在商业中的常见用法:

- 线索收集: 自动从目录或社交媒体获取联系方式。

- 价格监控: 实时追踪竞争对手的价格和库存。

- 内容监控: 你的品牌在新闻、博客或论坛被提及时自动提醒。

- SEO 审核: 扫描自己的网站,查找死链或缺失的元数据。

- 市场调研: 聚合房产、招聘或产品评论等大规模数据。

如果你曾经想过“要是能分身做网络调研就好了”,那爬虫绝对是你的好帮手。

网站爬虫为何对业务自动化至关重要

说点实际的。为什么企业愿意花钱和精力搞爬虫和抓取工具?因为回报真的很大。下面简单看看不同团队怎么用爬虫,以及他们都得到了什么:

| 应用场景 | 核心价值 | 典型用户 |

|---|---|---|

| 线索收集 | 自动构建潜在客户名单,节省大量时间 | 销售、招聘 |

| 价格追踪 | 实时掌握竞争对手动态,灵活定价 | 电商、产品团队 |

| 内容监控 | 品牌保护,发现行业趋势 | 市场、公共关系 |

| SEO 网站审核 | 提升网站健康度和排名 | SEO、站长 |

| 市场调研 | 获取最新、海量数据用于分析 | 分析师、研究团队 |

有实际案例显示,仅仅自动化每周抓取 5-7 个网站的数据,就能为一个员工每年省下 50 多小时——如果全团队都用,难怪。

Python:构建网站爬虫的首选语言

那为什么 Python 能成为网页爬虫领域的“王者”?主要有三大原因:

那为什么 Python 能成为网页爬虫领域的“王者”?主要有三大原因:

- 简单易学: Python 语法直观,适合新手,几行代码就能写出可用的爬虫。

- 库生态丰富: 不管是抓取页面、解析 HTML、处理 JavaScript,Python 都有现成的库帮你搞定。

- 社区庞大: 近都用 Python,教程多、问题好查,遇到难题总能找到答案。

主流 Python 爬虫库:

- Requests: 最简单的网页请求库(支持 HTTP GET/POST)。

- BeautifulSoup: 解析 HTML、查找元素的利器。

- Scrapy: 适合大规模项目的全功能爬虫框架。

- Selenium: 自动化浏览器,专治 JavaScript 动态页面。

和 Java、C# 这些语言比起来,Python 能让你从想法到成品爬虫的时间大大缩短。如果你是数据分析师,还能直接把爬虫结果导入 Pandas,省去繁琐的数据导出导入。

解析方式对比:正则、BeautifulSoup、Scrapy

提取网页数据时,你有不少选择。下面是主流方法的对比:

| 方法 | 工作原理 | 优点 🟢 | 缺点 🔴 | 适用场景 |

|---|---|---|---|---|

| 正则 | 匹配原始 HTML | 简单场景下速度快,适合已知结构 | HTML 结构变动易失效 | 快速提取、抓取链接等简单任务 |

| BeautifulSoup | 解析 HTML 树,按标签查找 | 易用灵活,能处理杂乱 HTML | 大页面速度慢,需手动编写爬取逻辑 | 大多数中小型抓取脚本 |

| Scrapy | 完整爬虫框架,支持 CSS/XPath 解析 | 高效可扩展,爬取与解析一体化 | 学习曲线陡峭,配置较多 | 大型、生产级爬虫项目 |

- 正则就像在沙滩上用金属探测器——快,但沙子一变就找不到目标。

- BeautifulSoup像拿着地图和铲子——哪里都能挖,但得自己走遍全场。

- Scrapy则像带着团队和卡车——小场面有点大材小用,但大项目无可替代。

新手建议先用 Requests + BeautifulSoup 入门,基础打牢后再升级到 Scrapy。

实战演练:用 Python 搭建简单网站爬虫

准备好动手了吗?我们来写一个基础爬虫,能访问页面、跟踪链接并采集数据。每一步都有代码示例,直接照着来就行。

第一步:搭建 Python 环境

先确保你装了 Python 3.10 及以上版本(用 python --version 检查)。建议为项目建个虚拟环境:

1python -m venv venv

2source venv/bin/activate # Windows 用 venv\Scripts\activate然后装好需要的库:

1pip install requests beautifulsoup4搞定!打开你喜欢的代码编辑器,准备写爬虫吧。

第二步:编写第一个爬虫脚本

先抓取一个页面,代码如下:

1import requests

2def crawl_page(url):

3 response = requests.get(url)

4 response.raise_for_status() # 非 200 状态会报错

5 print(response.text[:500]) # 预览前 500 个字符

6crawl_page("https://www.scrapingcourse.com/ecommerce/")你会在控制台看到一段 HTML,说明你已经成功访问网页。

第三步:跟踪链接,采集更多页面

让爬虫自动跟踪链接,访问多个页面。我们用列表保存待访问 URL,用集合记录已访问 URL,避免死循环:

1from bs4 import BeautifulSoup

2start_url = "https://www.scrapingcourse.com/ecommerce/"

3urls_to_visit = [start_url]

4visited_urls = set()

5max_pages = 20 # 安全限制

6while urls_to_visit and len(visited_urls) < max_pages:

7 current_url = urls_to_visit.pop(0)

8 try:

9 resp = requests.get(current_url)

10 resp.raise_for_status()

11 except Exception as e:

12 print(f"Failed to retrieve {current_url}: {e}")

13 continue

14 soup = BeautifulSoup(resp.text, "html.parser")

15 print(f"Crawled: {current_url}")

16 for link_tag in soup.find_all("a", href=True):

17 url = link_tag['href']

18 if not url.startswith("http"):

19 url = requests.compat.urljoin(current_url, url)

20 if url.startswith(start_url) and url not in visited_urls:

21 urls_to_visit.append(url)

22 visited_urls.add(current_url)这个脚本会在同一站点内最多爬取 20 个页面,并打印每个已访问的 URL。

第四步:从页面提取数据

比如你想抓取每个页面的商品名称和价格,可以这样做:

1product_data = []

2while urls_to_visit and len(visited_urls) < max_pages:

3 # ...(同上)

4 soup = BeautifulSoup(resp.text, "html.parser")

5 if "/page/" in current_url or current_url == start_url:

6 items = soup.find_all("li", class_="product")

7 for item in items:

8 name = item.find("h2", class_="product-name")

9 price = item.find("span", class_="price")

10 link = item.find("a", class_="woocommerce-LoopProduct-link")

11 if name and price and link:

12 product_data.append({

13 "name": name.get_text(),

14 "price": price.get_text(),

15 "url": link['href']

16 })

17 # ...(后续爬取逻辑)

18# 保存为 CSV 文件

19import csv

20with open("products.csv", "w", newline="") as f:

21 writer = csv.DictWriter(f, fieldnames=["name", "price", "url"])

22 writer.writeheader()

23 writer.writerows(product_data)

24print(f"Scraped {len(product_data)} products.")现在你就有了一个包含所有商品信息的 CSV 文件,可以直接分析、上传,或者和朋友炫耀。

第五步:调试与优化爬虫

写好爬虫是一回事,让它稳定运行又是另一回事。以下是我的一些经验和建议:

- 设置 User-Agent: 有些网站会屏蔽“Python-requests”,伪装成浏览器就行:

1headers = {"User-Agent": "Mozilla/5.0"} 2requests.get(url, headers=headers) - 异常处理: 用 try/except 跳过打不开或被封的页面。

- 防止死循环: 记录已访问 URL,并设置最大页面数。

- 请求限速: 每次请求间加

time.sleep(1),避免被封。 - 遵守 robots.txt: 尊重网站爬虫规则()。

- 记录进度: 每爬一个页面就打印或记录,方便排查问题。

如果发现爬虫被封、内容异常或数据缺失,先检查请求头、降低频率,并确保没有触发反爬机制。

Thunderbit:用 AI 让网站爬取更简单

说到“傻瓜式”网页爬取,必须得提 。虽然我很喜欢用 Python,但有时候你只想要数据,不想折腾环境、调试或维护。Thunderbit 是一款基于 AI 的网页爬虫 Chrome 插件,只需几步点击就能从任意网站抓取数据。

Thunderbit 有哪些亮点?

- AI 智能字段推荐: AI 自动识别页面可提取的数据,无需手动查 HTML 或写选择器。

- 零代码、浏览器运行: 直接在浏览器操作,支持登录后页面和 JavaScript 动态内容。

- 子页面抓取: 需要更详细信息?Thunderbit 可自动访问每个子页面(如商品详情),丰富你的数据表。

- 一键导出: 数据可直接导出到 Excel、Google Sheets、Airtable 或 Notion,无需手动处理 CSV。

- 云端/本地双模式: 公共网站可用云端极速抓取,登录或复杂页面可用本地浏览器模式。

- 定时任务: 支持自动定时抓取,无需自己搭建服务器或写定时脚本。

对于企业用户来说,Thunderbit 极大提升了效率。从“我需要这些数据”到“表格已到手”,只需几分钟。如果你是开发者,Thunderbit 也能作为脚本的补充——快速应急或在代码维护期间顶上。

想体验一下?,试着抓取你常用的网站。免费版可抓取少量页面,付费版每月仅需 $15 起,含 500 积分。

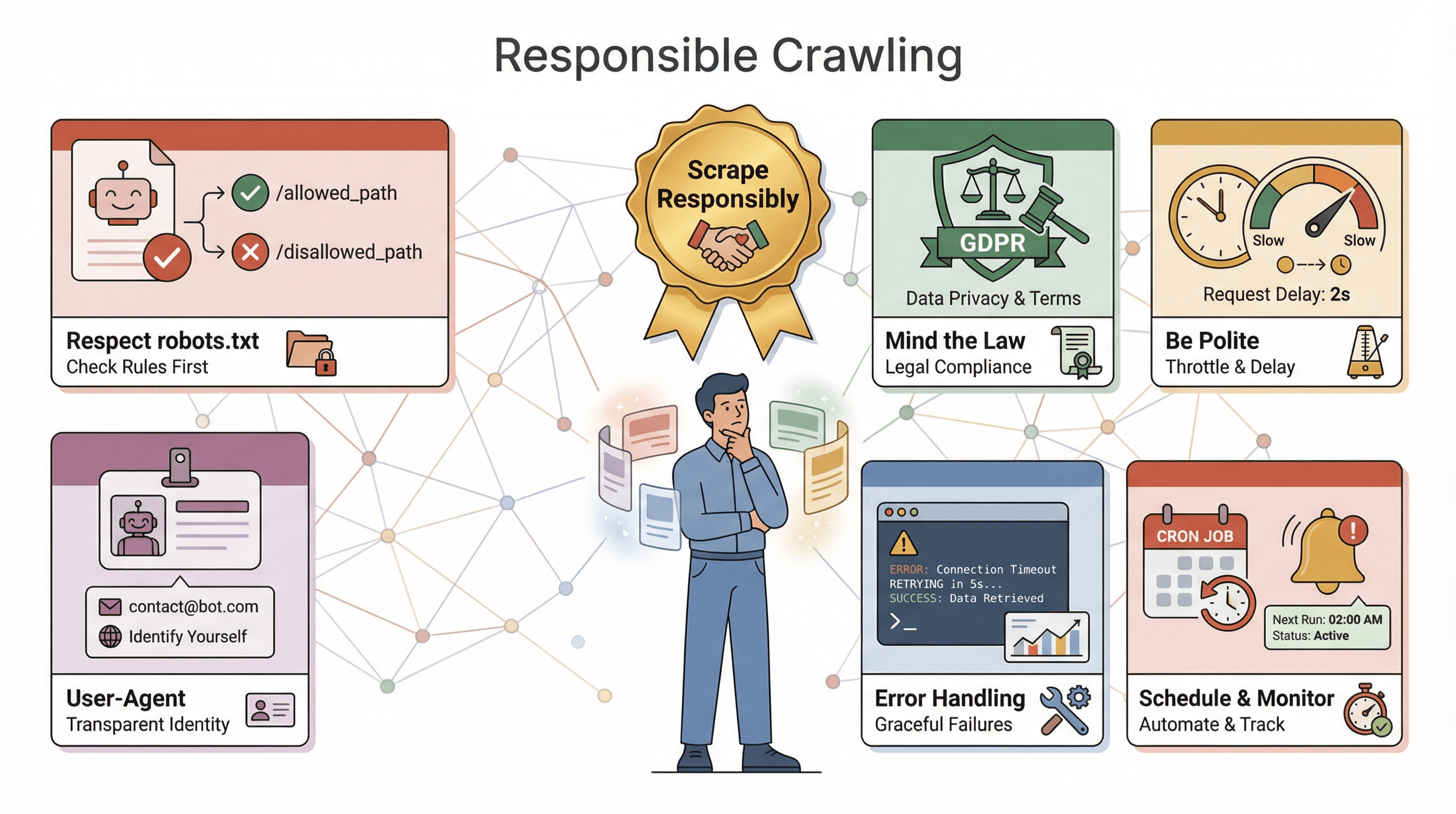

用 Python 构建网站爬虫时的注意事项

在让你的爬虫“驰骋网络”之前,务必注意以下几点:

在让你的爬虫“驰骋网络”之前,务必注意以下几点:

- 遵守 robots.txt: 大多数网站会有

robots.txt文件,规定爬虫的访问权限。无视规则可能被封,甚至涉及法律风险。务必查阅并遵守()。 - 合规合法: 有些网站禁止抓取,涉及个人数据时还要遵守 GDPR、CCPA 等隐私法规(参考 )。不确定时,建议只抓取公开、非敏感数据。

- 礼貌抓取: 不要高频请求,适当限速、随机延迟,避开高峰时段。

- 标识身份: 使用自定义 User-Agent,批量抓取时可加上联系方式。

- 异常与日志: 网站结构会变、页面会失效、数据会出错。务必加好异常处理、日志和监控,方便及时修复。

- 定时与监控: 定期抓取建议用定时工具(如 cron 或 Thunderbit 内置定时),并设置告警,防止爬虫失效或数据异常。

黄金法则:负责任地抓取。网络是大家的资源,别做“扰民的爬虫”。

进阶技巧:让 Python 网站爬虫更强大

基础掌握后,你可能想让爬虫更强大。下面这些进阶玩法可以试试:

- 处理 JavaScript: 用 Selenium 或 Playwright 抓取动态加载的数据。

- 扩展规模: 大项目可用 Scrapy 或异步库(如

aiohttp)实现并发抓取。 - 代理轮换: 大量抓取时用代理池切换 IP,降低被封风险。

- 自动化数据流: 直接写入数据库,或集成云存储,处理大数据量。

- 监控与告警: 长时间运行的爬虫要加日志、健康检查和通知。

如果你的爬虫已经成了关键业务,建议考虑托管服务或 API,减轻维护压力。多站点抓取时,代码要模块化,方便后续维护和升级。

总结与核心要点

用 Python 构建网站爬虫,是当今数据时代最值得掌握的技能之一。本文要点回顾:

- 网站爬虫能自动访问和提取网页数据,是业务自动化、调研和竞争情报的利器。

- Python因语法简洁、库强大、社区活跃,成为爬虫开发首选。

- 解析方式有讲究: 简单场景用正则,常规脚本用 BeautifulSoup,大型项目用 Scrapy。

- 按步骤操作, 从抓取单页到全站爬取、结构化存储,人人都能上手。

- Thunderbit让抓取更进一步,AI 智能、零代码、即刻导出,适合企业和追求效率的用户。

- 负责任抓取很重要:遵守规则、处理异常、注重合规和道德。

- 想扩展规模, 可用 Selenium、Scrapy 或 Thunderbit 等工具实现高效自动化。

最好的学习方式就是动手实践——写个脚本、试试 Thunderbit,看看你能挖掘出哪些数据。网络就是你的数据宝库。

想深入了解?推荐这些资源:

- 获取更多技巧、教程和进阶方法。

祝你爬虫顺利,数据干净,咖啡不断!

常见问题解答

1. 网站爬虫和网页爬虫有什么区别?

爬虫负责系统性地发现和遍历网页(类似绘制网站地图),而网页爬虫则专注于从页面中提取特定数据。实际项目通常两者结合:先爬取页面,再抓取数据。

2. 为什么用 Python 开发网站爬虫这么流行?

Python 易学易用,拥有强大的 Requests、BeautifulSoup、Scrapy、Selenium 等库,还有庞大的社区。近 70% 的网页抓取项目都用 Python,已成行业标准。

3. 解析网页时,何时用正则、BeautifulSoup 或 Scrapy?

正则适合简单、结构固定的场景。BeautifulSoup 适合大多数脚本,灵活易用。Scrapy 适合需要高效并发、功能全面的大型或生产级爬虫。

4. Thunderbit 和用 Python 写爬虫有何不同?

Thunderbit 用 AI 实现零代码抓取,只需点击、选择字段、导出,适合企业用户和快速需求。Python 则更灵活可定制,但需要编程和维护。

5. 爬取网站时有哪些法律或道德风险?

务必查阅并遵守 robots.txt,遵循网站服务条款,避免抓取敏感或个人数据,合理限速,避免给服务器带来压力。负责任的抓取有助于维护开放的网络环境。

想亲自试试?,或者打开你喜欢的 Python 编辑器,开启你的爬虫之旅。数据就在那儿,等你来挖掘!

了解更多