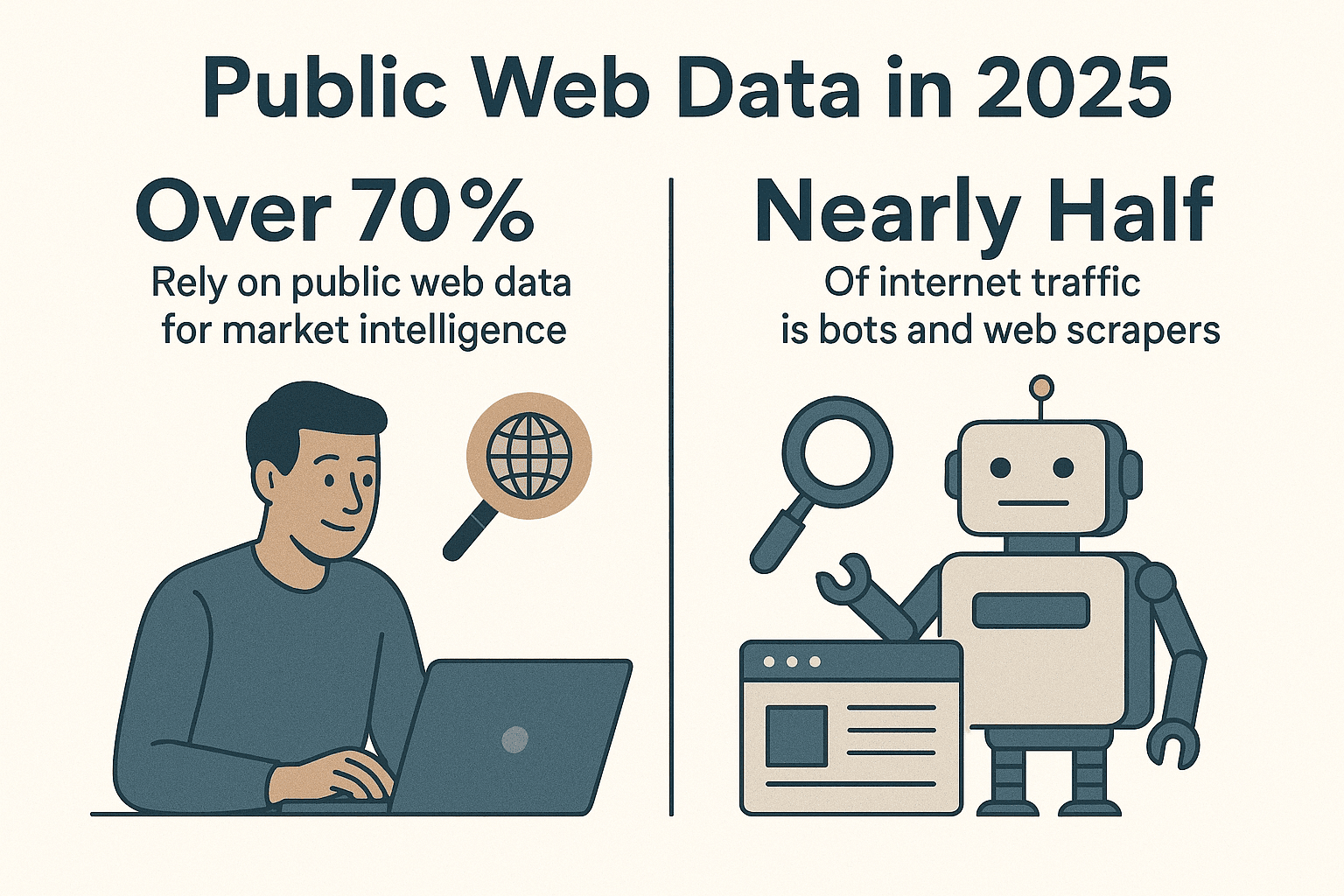

互联网的数据量大到让人眼花缭乱,企业都在拼命把这些杂乱的信息变成有用的洞察。其实,现在有超过,而且如今将近一半的网络流量其实都是机器人和网页爬虫在跑,而不是人类用户()。作为一个多年专注自动化工具开发的程序员(说真的,我写的爬虫访问过的网站比我自己还多),我可以很负责任地说:如果你还没用 Python 网页爬虫来自动采集数据,那你真的错过了提升效率的绝佳机会。

Python 之所以能成为网页爬取的首选语言,绝不是偶然。不管你是做销售、市场、运营还是研究,只要用好 Python 网页爬虫,就能省下大把时间,挖到那些人工很难发现的深层信息。接下来我会带你从零开始搭建高效的 Python 网页爬虫,分享我常用的库和实战经验,还会介绍像 这样的工具,帮你轻松搞定那些让老手都头疼的动态网页。

为什么用 Python 构建网页爬虫?

直接说结论:Python 在网页爬虫领域几乎是无敌的。根据最新行业数据,差不多,远远甩开 JavaScript 和其他语言。2024 年,Python 甚至在 GitHub 上超越了 JavaScript,成了最受欢迎的编程语言(),这很大程度上是因为它在数据科学和自动化领域的统治地位。

Python 适合做爬虫的理由有哪些?

- 语法简单易懂: Python 代码看着就舒服,新手上手快,老手开发效率高。

- 库生态超级丰富: 、、、 等库能满足你从网页请求、HTML 解析到浏览器自动化的各种需求。

- 社区活跃: 遇到问题,网上一搜就是一堆教程、代码片段,还有热心网友帮你解答各种爬虫难题。

- 灵活性强: 不管是一次性的小脚本,还是大规模分布式爬虫,Python 都能轻松搞定。

和其他语言比起来,Python 在易用性和强大功能之间找到了最舒服的平衡。JavaScript(Node.js)虽然适合处理动态内容,但异步编程对新手来说有点绕。Java 和 C# 虽然很稳,但开发门槛高。Python 让你专注于数据本身,不用被复杂语法拖后腿。

Python 网页爬虫环境搭建

在正式“织网”之前,先把开发环境整好。我的标准流程如下:

1. 安装 Python 3

去 下载最新版 Python 3.x,或者用系统自带的包管理器装。装好后,终端能直接运行 python 或 python3 就行。

2. 创建虚拟环境

用虚拟环境隔离项目依赖,避免包冲突:

1python3 -m venv .venv

2# Unix/Mac

3source .venv/bin/activate

4# Windows

5.venv\Scripts\activate这样项目更干净,后续维护也方便。

3. 安装常用库

激活虚拟环境后,装上核心依赖:

1pip install requests beautifulsoup4 lxml scrapy selenium pandas sqlalchemy各库的作用简单说下:

- Requests: 负责发 HTTP 请求,拿网页内容。

- BeautifulSoup: 解析和提取 HTML 数据。

- lxml: 高效的 HTML/XML 解析器(BeautifulSoup 可以调用它提升速度)。

- Scrapy: 功能强大的爬虫框架,适合大规模抓取。

- Selenium: 浏览器自动化,专治 JavaScript 动态页面。

- pandas: 数据清洗和处理。

- SQLAlchemy: 数据库存储。

现在你已经可以从简单脚本到大型爬虫项目随意切换了。

如何选择合适的 Python 爬虫库?

Python 的爬虫工具多到让人挑花眼,怎么选?我的经验如下:

| 库/工具 | 易用性 | 速度与规模 | 适用场景 |

|---|---|---|---|

| Requests + BeautifulSoup | 非常简单 | 一般(单页处理) | 新手、静态页面、快速小任务 |

| Scrapy | 学习曲线略高 | 极快(异步并发) | 大规模爬取、整站抓取 |

| Selenium/Playwright | 中等 | 较慢(浏览器开销) | JS 动态页面、登录后内容 |

| aiohttp + asyncio | 中等(异步) | 极快(多 URL 并发) | 批量静态页面高效抓取 |

| Thunderbit(零代码) | 最简单(AI 驱动) | 快速(本地/云端) | 无需编程、动态网页、快速获取结果 |

我的选型建议:

- 静态页面数量不多时,Requests + BeautifulSoup 就够用。

- 需要批量抓取、自动跟进链接时,Scrapy 是首选。

- 动态内容或需要模拟登录时,用 Selenium 或 Playwright。

- 想要“点点鼠标就能用”, 是救星。

Python 网页爬虫实战:基础版

下面用抓取 Hacker News 头条举个例子,演示基础爬虫流程。

1. 获取网页内容

1import requests

2from bs4 import BeautifulSoup

3url = "https://news.ycombinator.com/"

4response = requests.get(url)

5if response.status_code == 200:

6 html_content = response.content2. 解析 HTML

1soup = BeautifulSoup(html_content, "html.parser")3. 提取数据

1articles = soup.find_all("tr", class_="athing")

2for article in articles:

3 title_elem = article.find("span", class_="titleline")

4 title = title_elem.get_text()

5 link = title_elem.find("a")["href"]

6 print(title, "->", link)4. 翻页处理

Hacker News 底部有“More”链接,代码如下:

1import time

2page_url = url

3while page_url:

4 resp = requests.get(page_url)

5 soup = BeautifulSoup(resp.text, 'html.parser')

6 # (提取文章同上)

7 next_link = soup.find("a", class_="morelink")

8 if next_link:

9 page_url = requests.compat.urljoin(resp.url, next_link["href"])

10 time.sleep(1) # 礼貌爬取

11 else:

12 page_url = None5. 错误处理与爬虫礼仪

- 一定要检查

response.status_code。 - 用

time.sleep()控制请求频率,别给服务器添麻烦。 - 设置自定义 User-Agent:

1headers = {"User-Agent": "MyWebSpider/0.1 (+your_email@example.com)"}

2requests.get(url, headers=headers)这个基础爬虫能适配大多数静态网站。更复杂的需求,可以用 Scrapy 进阶。

用 Scrapy 进阶你的爬虫

当简单脚本搞不定时,Scrapy 就是升级利器。入门流程如下:

1. 新建 Scrapy 项目

1scrapy startproject myspider2. 创建爬虫文件

在 myspider/spiders/quotes_spider.py 里:

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["http://quotes.toscrape.com/"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 'text': quote.css("span.text::text").get(),

9 'author': quote.css("small.author::text").get(),

10 'tags': quote.css("div.tags a.tag::text").getall()

11 }

12 next_page = response.css("li.next a::attr(href)").get()

13 if next_page:

14 yield response.follow(next_page, callback=self.parse)3. 运行爬虫

1scrapy crawl quotes -o quotes.jsonScrapy 会自动爬所有页面,支持并发、自动跟进链接,还能把数据导出成 JSON(也能导出 CSV、XML 等格式),代码量很少。

我喜欢 Scrapy 的理由:

- 内置并发、限速、礼貌爬取等机制

- 自动遵守 robots.txt

- 数据导出和清洗管道简单好用

- 能扩展到百万级页面抓取

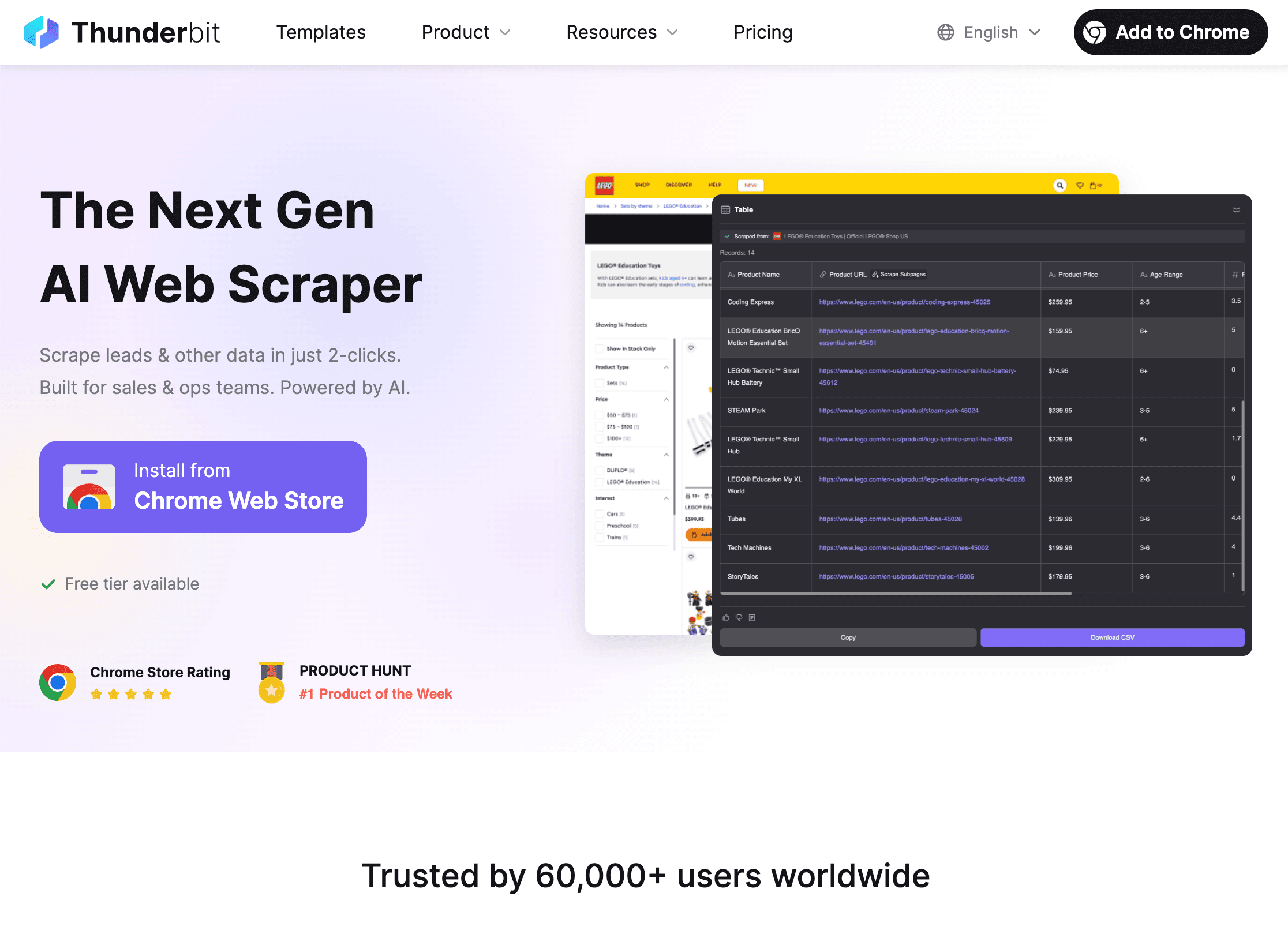

用 Thunderbit 扩展 Python 爬虫能力

说到网页爬虫,动态网站往往是最大难题。再强的 Python 脚本,有时候也会被 JavaScript、反爬机制或者频繁变动的页面结构难住。这时候, 就能派上大用场。

Thunderbit 有哪些独特优势?

- AI 智能字段识别: 打开 ,点“AI 智能推荐字段”,AI 会自动识别页面可提取的数据,不用你手动查 HTML 或写选择器。

- 子页面抓取: Thunderbit 能自动跟进详情页(比如商品页、个人资料页),把数据合并到主表。

- 动态内容无压力: Thunderbit 在真实浏览器里运行,能抓取 JavaScript 动态加载、无限滚动,甚至能用 AI 自动填表。

- 零代码,自然语言操作: 只要用自然语言描述需求(比如“提取所有职位名称和地点”),Thunderbit 自动帮你搞定剩下的事。

- 一键导出数据: 支持导出到 CSV、Excel、Google Sheets、Airtable、Notion,免费还不限量。

- 定时爬取: 可以设置定时任务(比如“每天早上 9 点”),自动获取最新数据。

Thunderbit 如何和 Python 配合?

我最常用的流程:

- 用 Thunderbit 抓取复杂或动态网页,尤其是需要快速拿数据或者不想维护代码时。

- 导出数据 成 CSV 或 Excel。

- 用 Python(pandas) 做数据清洗、分析或自动化处理。

这样既能让 Thunderbit 解决数据采集难题,又能用 Python 发挥数据处理的强大能力。

什么时候用 Thunderbit,什么时候用 Python?

- Thunderbit: 适合不会编程的用户、动态网页、临时采集,或者让业务同事自己动手拿数据。

- Python: 适合需要高度自定义逻辑、大规模或定时爬取,或者和其他系统深度集成的场景。

- 两者结合: Thunderbit 负责采集,Python 负责分析和自动化。我觉得这就像“花生酱配果酱”——单用也行,搭配更强。

想了解混合工作流,推荐看看 。

合规与网站规则:爬虫也要讲规矩

网页爬虫很强大,但“能力越大,责任越大”(有时候还会收到管理员的警告邮件)。怎么合法合规地爬数据?

1. 遵守 robots.txt

大多数网站会用 robots.txt 文件声明哪些页面允许被爬。Python 检查方法如下:

1import urllib.robotparser

2rp = urllib.robotparser.RobotFileParser()

3rp.set_url("http://www.example.com/robots.txt")

4rp.read()

5if not rp.can_fetch("*", "http://www.example.com/target-page"):

6 print("robots.txt 禁止抓取该页面")Scrapy 默认遵守 robots.txt(ROBOTSTXT_OBEY=True)。

2. 礼貌爬取

- 设置请求间隔(

time.sleep()或 Scrapy 的DOWNLOAD_DELAY),别高频刷服务器。 - User-Agent 要写明身份和联系方式。

- 不要抓取个人隐私或受保护的数据。

- 如果网站明确拒绝爬取或封禁,记得及时停止。

3. 应对限流与验证码

- 遇到 429(请求过多)错误时,降低频率或用代理池。

- 不要强行破解验证码,遇到验证码就该收手了。

更多合规和道德建议,见 。

用 Python 整理与存储数据

数据采集下来,通常要清洗、转换和存储,方便后续分析。我的常用方法如下:

1. 用 pandas 清洗和转换

1import pandas as pd

2df = pd.DataFrame(scraped_data)

3df['price'] = df['price'].str.replace('£', '').astype(float)

4df = df.dropna()2. 导出为 CSV 或 Excel

1df.to_csv('output.csv', index=False)

2df.to_excel('output.xlsx', index=False)3. 用 SQLAlchemy 存入数据库

1from sqlalchemy import create_engine

2engine = create_engine('sqlite:///scraped_data.db')

3df.to_sql(name='products', con=engine, if_exists='replace', index=False)这样就能轻松搭建从爬虫到数据看板的完整流程。

数据管道自动化

定期任务可以自动化:

- 定时任务(cron): 定时运行 Python 脚本。

- Apache Airflow: 复杂流程可以用 Airflow 协调爬取、清洗、报表等环节。

- Thunderbit 定时爬取: 让 Thunderbit 定时采集数据,再用 Python 处理。

更多内容见 。

Python 网页爬虫常见问题与优化

再厉害的爬虫也会遇到各种问题,下面是我的排查清单:

- 请求被封(403/429): 换 User-Agent、降低频率、用代理,记得检查 robots.txt。

- 数据缺失: 检查选择器,页面结构可能变了。

- 动态内容抓不到: 用 Selenium 或 Thunderbit 处理 JS 页面。

- 性能瓶颈: 用异步(aiohttp)或 Scrapy 并发提升速度,分批写入数据避免内存爆掉。

- 调试技巧: 打印日志、用浏览器开发者工具、检查输出数据。

更多排查技巧,见 。

总结与核心要点

高效的 Python 网页爬虫能大大提升数据采集效率,帮你拿到更有价值的信息。本文主要内容回顾:

- Python 是网页爬虫首选语言, 简单易用、库多、社区活跃。

- 环境搭建要规范, 用虚拟环境和主流库(Requests、BeautifulSoup、Scrapy、Selenium、pandas、SQLAlchemy)。

- 按需选工具, 小任务用脚本,大规模用 Scrapy,动态页面用 Selenium,零代码/AI 用 Thunderbit。

- 写合规、礼貌的爬虫, 遵守 robots.txt 和网站规则。

- 用 pandas 和 SQLAlchemy 管理数据, 自动化数据管道。

- Python + Thunderbit 组合最灵活, 让 AI 负责采集,Python 负责分析和自动化。

如果你想让网页爬取更高效,,体验一键抓取复杂网页的爽感。想深入学习,欢迎访问 ,获取更多实用教程和案例。

祝你爬虫顺利,数据满载而归(也别被验证码卡住哦)。

常见问题解答

1. 为什么 Python 是构建网页爬虫的最佳语言?

Python 语法简单,爬虫库丰富(如 Requests、BeautifulSoup、Scrapy),社区活跃,既适合新手入门,也能搞定大规模、专业级项目。

2. 什么时候该用 Thunderbit,而不是自己写 Python 爬虫?

Thunderbit 适合不会编程的用户、动态或 JS 网页,或者需要快速采集数据又不想维护代码的场景。对于高度定制、大规模或深度集成需求,Python 依然是最佳选择。很多团队会两者结合:Thunderbit 采集,Python 分析。

3. 如何确保我的爬虫合法合规?

一定要检查并遵守网站的 robots.txt,合理设置请求频率和 User-Agent,别抓个人隐私或受保护数据。如果被网站拒绝或封禁,记得及时停止。更多建议见 。

4. 抓取到的数据如何存储和处理?

用 pandas 做数据清洗和转换,导出为 CSV/Excel 方便分享,或者用 SQLAlchemy 存入数据库(如 SQLite、PostgreSQL)方便管理和定期更新。

5. 如何自动化我的网页爬取流程?

用 cron 定时运行 Python 脚本,或者用 Apache Airflow 管理复杂流程。Thunderbit 也支持定时爬取,可以和 Python 结合实现全自动数据管道。

想获取更多实战技巧?欢迎阅读 ,并订阅 获取视频教程。