2026 年的网页爬虫圈,简直就像早上七点的热闹菜市场——大家都在抢最新鲜的数据,谁用对了工具,谁就能在一片混乱中轻松拿下好货。现在,企业越来越依赖网页爬虫来搞定销售线索、市场情报等,选对 Python 爬虫库不仅是技术选择,更直接影响业务能不能跑得快、跑得远。面对市面上一堆“终极指南”和五花八门的工具,选个趁手的库,感觉比考研还难。

我在 SaaS 和自动化这行混了不少年,深知选对 Python 网页爬虫工具能让一周的体力活变成半天就能搞定。不管你是开发者要搭建高效数据管道,还是业务同学只想把干净数据导进表格,这份榜单都帮你梳理了 2026 年最值得用的 12 个 Python 网页爬虫库——外加一个正在颠覆行业的 AI 解决方案,哪怕你不会写代码也能轻松上手。

为什么选对 Python 网页爬虫库这么关键

网页爬虫的核心不是“抓到数据”,而是“高效、准确地抓到你想要的数据”,还能让你省心省力。2026 年,美国有超过 都在用自动化网页爬虫搞销售、市场调研和运营,每天被爬取的网页量级已经 。选错工具,可能错失商机、脚本频繁出错,甚至浪费大量时间在调试上。

选 Python 网页爬虫工具时,重点关注这些:

- 性能: 能不能高效处理大规模任务?

- 易用性: 写代码多还是出结果快?

- 浏览器和 JavaScript 支持: 能不能搞定现代动态网站?

- 可扩展性: 需求变大能不能灵活扩展?

- 集成能力: 能不能无缝对接你的数据管道或业务流程?

常见业务场景有:销售线索挖掘、价格监控、竞品追踪、自动化数据录入等。选对库,销售团队能快人一步,选错了只能在表格里苦苦挣扎。

我们怎么评测最佳 Python 网页爬虫库

这份榜单主要从以下几个维度来评测:

- 性能和可扩展性: 能不能搞定大规模、复杂网站?

- 易用性: 新手友好还是得 Python 大佬才能玩转?

- 浏览器和 JavaScript 处理: 能不能搞定动态内容和现代 Web 应用?

- 安全和维护: 是否持续更新、用起来放心?

- 社区和支持: 文档、教程、社区活跃度怎么样?

- 集成潜力: 能不能和其他工具(比如 Thunderbit 这类 AI 方案)协同作战?

我们也充分考虑了实际业务需求——毕竟,代码再酷,最后还是要看能不能交付有价值的数据。

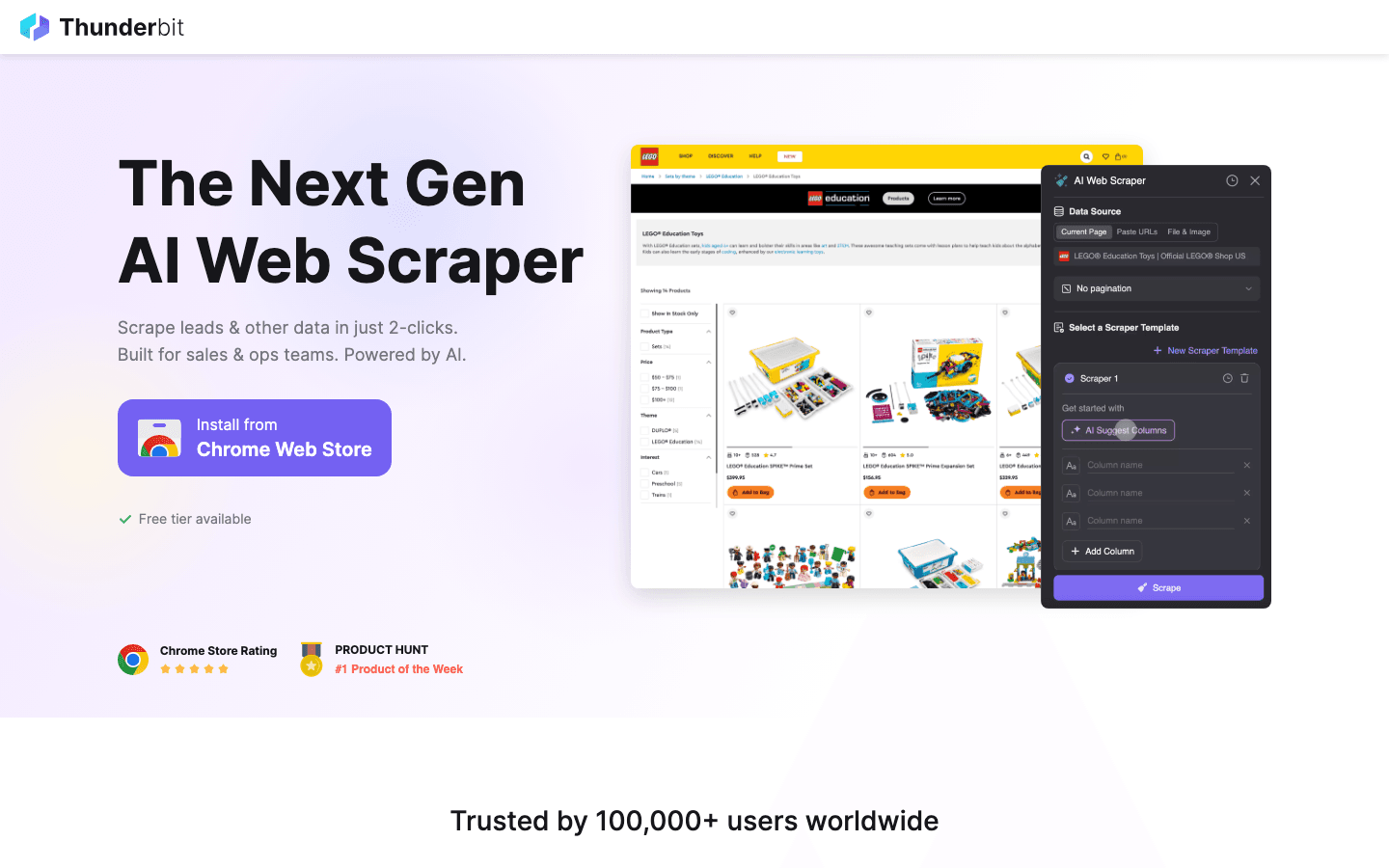

1. Thunderbit

虽然不是传统意义上的 Python 库,但它是一款 ,正在彻底改变 2026 年开发者和业务用户的数据采集方式。它能上榜,理由很简单:

虽然不是传统意义上的 Python 库,但它是一款 ,正在彻底改变 2026 年开发者和业务用户的数据采集方式。它能上榜,理由很简单:

主要功能:

- AI 智能字段识别: 只要描述需求,AI 自动识别你要的数据和字段类型。

- 子页面自动爬取: 自动访问并提取子页面(比如商品详情、领英个人页等)数据。

- 一键模板: 针对热门网站(亚马逊、Zillow、Shopify 等)一键爬取。

- 免费数据导出: 支持导出到 Excel、Google Sheets、Airtable、Notion、CSV、JSON,完全免费。

- 零代码操作: 不会编程也能用,同时支持和 Python 工具集成,进阶玩法也不在话下。

最佳应用场景: 销售线索采集、电商价格监控、房产信息抓取、运营数据整理等,任何需要快速结构化数据的场景。

优点:

- 不用写代码,点选+描述就能搞定

- AI 自动适应网页结构变化

- 轻松应对杂乱、长尾网页数据

- 能和 Scrapy、Beautiful Soup 等 Python 库组合,打造混合工作流

不足:

- 不是纯 Python 库(但能和 Python 流程无缝衔接)

- 更适合业务用户或作为代码爬虫的补充

实用建议: 用 Thunderbit 快速原型设计爬虫或处理一次性、复杂网页。大规模自动化时,可以先导出结构化数据,再交给 Python 脚本深度处理。

2. Beautiful Soup

是解析和处理 HTML/XML 的首选 Python 库。无论你遇到多么混乱的网页结构,这个工具都能帮你轻松搞定,新手老手都爱用。

是解析和处理 HTML/XML 的首选 Python 库。无论你遇到多么混乱的网页结构,这个工具都能帮你轻松搞定,新手老手都爱用。

主要功能:

- 语法直观,方便搜索、遍历和修改 HTML/XML

- 能优雅处理格式混乱或损坏的网页

- 和 配合抓取网页特别顺手

最佳应用场景: 快速爬取、数据清洗、中小型网页解析。

优点:

- 学习门槛极低

- 擅长处理“脏”HTML

- 灵活且容错性强

不足:

- 处理大文档时速度不如

- 不支持 JavaScript

实用建议: 结合 lxml 解析器能提升速度。遇到复杂动态网页,可以和 Selenium 或 Pyppeteer 搭配用。

3. Selenium

是自动化浏览器的“重磅选手”,能控制 Chrome、Firefox、Edge 等主流浏览器,非常适合爬取动态、JavaScript 密集型网站。

是自动化浏览器的“重磅选手”,能控制 Chrome、Firefox、Edge 等主流浏览器,非常适合爬取动态、JavaScript 密集型网站。

主要功能:

- 自动化真实浏览器(Chrome、Firefox 等)

- 支持无头模式,运行更快更省资源

- 能模拟表单、按钮等用户操作

最佳应用场景: 需要登录、点击、渲染大量 JavaScript 的网站。

优点:

- 几乎能搞定所有类型网站

- 支持多浏览器多平台

- 测试和爬取一体化

不足:

- 速度慢于纯无头方案

- 占用资源较高

- 网页结构变动时脚本容易失效

实用建议: 只有其他工具搞不定时再用 Selenium。追求速度和规模时,优先考虑 Scrapy 或 Pyppeteer。

4. Requests

是 Python 最基础的 HTTP 库,很多爬虫流程都离不开它。用它发 GET/POST 请求、处理响应特别简单。

是 Python 最基础的 HTTP 库,很多爬虫流程都离不开它。用它发 GET/POST 请求、处理响应特别简单。

主要功能:

- 简洁的 Python 风格 API 处理 HTTP 请求

- 支持 cookies、会话、认证

- 和 Beautiful Soup、LXML 等解析器配合超顺滑

最佳应用场景: 抓取静态网页、API,或自定义爬虫的基础模块。

优点:

- 极易上手

- 稳定可靠

- 适合快速脚本和原型开发

不足:

- 不自带 HTML 解析

- 无法处理 JavaScript 渲染内容

实用建议: 搭配 Beautiful Soup 或 LXML,打造经典轻量级爬虫方案。

5. LXML

是 Python 解析 HTML/XML 的速度之王。处理大文档或复杂 XPath 查询时,LXML 表现特别出色。

是 Python 解析 HTML/XML 的速度之王。处理大文档或复杂 XPath 查询时,LXML 表现特别出色。

主要功能:

- 基于 C 的后端,解析速度极快

- 完全支持 XPath 和 CSS 选择器

- 同时支持 HTML 和 XML

最佳应用场景: 大规模解析、复杂文档结构、对速度有高要求的项目。

优点:

- 处理大任务时远快于 Beautiful Soup

- 选择器功能强大

- 错误处理健壮

不足:

- 对格式错误的 HTML 容错性较低

- 学习曲线略高

实用建议: 作为 Beautiful Soup 的解析器,兼顾易用性和高性能。

6. Pyppeteer

是 Puppeteer 的 Python 版本,能控制无头 Chrome,专为处理现代 JavaScript 网站而生。

是 Puppeteer 的 Python 版本,能控制无头 Chrome,专为处理现代 JavaScript 网站而生。

主要功能:

- 全面控制无头 Chrome(或 Chromium)

- 出色的 JavaScript 渲染和用户行为模拟

- 支持复杂导航、截图、PDF 生成等

最佳应用场景: 动态 JS 网站、自动化用户流程、绕过反爬机制。

优点:

- 顶级 JavaScript 支持

- 可模拟真实用户操作

- 擅长爬取单页应用(SPA)

不足:

- 比 Requests 或 Scrapy 更重更慢

- 维护状态需关注

- 配置略复杂

实用建议: Selenium 搞不定的动态站点,Pyppeteer 往往能解决。业务流程中,可以用 Thunderbit AI 预设字段,再交给 Pyppeteer 导航。

7. Splash

是专为大规模 JavaScript 渲染设计的轻量级浏览器引擎,常和 Scrapy 搭配爬取动态网页。

是专为大规模 JavaScript 渲染设计的轻量级浏览器引擎,常和 Scrapy 搭配爬取动态网页。

主要功能:

- 无头浏览器,提供 HTTP API

- 渲染 JavaScript,返回 HTML、截图或 HAR 文件

- 通过中间件和 Scrapy 集成

最佳应用场景: 批量处理 JS 网页、可扩展的爬虫管道、服务端渲染。

优点:

- 大规模渲染高效

- API 易于集成

- 资源消耗低于全功能浏览器

不足:

- 交互性不如 Selenium、Pyppeteer

- 配置和脚本有一定学习门槛

实用建议: 批量爬取动态网页时,Scrapy + Splash 是强力组合。

8. MechanicalSoup

是基于 Requests 和 Beautiful Soup 的轻量级库,专注于自动化表单和简单网页导航。

是基于 Requests 和 Beautiful Soup 的轻量级库,专注于自动化表单和简单网页导航。

主要功能:

- 自动提交表单和网页导航

- 自动维护会话和 cookies

- API 简单易用,适合新手

最佳应用场景: 网站登录、表单填写、静态或轻度动态网页爬取。

优点:

- 配置极简,适合快速自动化

- 内置 cookies 和会话管理

- 适合简单登录或搜索表单

不足:

- 不支持 JavaScript

- 不适合大规模或高度动态爬取

实用建议: 用于登录流程,后续数据抓取可以交给 Requests + Beautiful Soup。

9. Twisted

是 Python 的事件驱动网络引擎。虽然不是专门的爬虫库,但它是构建高并发自定义爬虫系统的基础。

是 Python 的事件驱动网络引擎。虽然不是专门的爬虫库,但它是构建高并发自定义爬虫系统的基础。

主要功能:

- 支持 HTTP、TCP 等异步网络通信

- 可扩展到数千并发连接

- 常用于自定义分布式爬虫系统

最佳应用场景: 构建高并发自定义爬虫,与其他异步框架集成。

优点:

- 可扩展性极强

- 支持多种协议

- 适合高级用户

不足:

- 学习曲线陡峭

- 对大多数常规爬虫任务来说有点“大材小用”

实用建议: 需要大规模(百万级页面)爬取时,值得深入学习。

10. Scrapy

被称为 Python 网页爬虫的“瑞士军刀”,专为大规模、生产级项目设计,异步架构让你轻松爬取成千上万网页。

被称为 Python 网页爬虫的“瑞士军刀”,专为大规模、生产级项目设计,异步架构让你轻松爬取成千上万网页。

主要功能:

- 异步事件驱动引擎,高吞吐量

- 内置数据管道、中间件、数据导出(JSON、CSV、XML)

- 集爬取、解析、清洗于一体

- 插件丰富,支持代理、UA 等扩展

最佳应用场景: 企业级爬取、结构化数据提取、对速度和稳定性有高要求的项目。

优点:

- 大规模任务表现极佳

- 高度可定制、可扩展

- 社区活跃、文档完善

不足:

- 新手上手有一定难度

- 原生不支持动态 JS 网页(可通过 Splash 扩展)

实用建议: Scrapy + 能搞定 JS 渲染页面,或者和 搭配实现 AI 字段识别和数据结构化。

11. PyQuery

给 Python 带来了 jQuery 风格的选择器。如果你用过 jQuery,会觉得用起来特别顺手。

给 Python 带来了 jQuery 风格的选择器。如果你用过 jQuery,会觉得用起来特别顺手。

主要功能:

- jQuery 式 API,方便选择和操作 HTML

- 基于 lxml,速度快

- 支持 CSS 选择器和 DOM 操作

最佳应用场景: jQuery 用户、快速原型开发、需要灵活选择器的项目。

优点:

- 高效快速

- jQuery 用户易上手

- 适合解析和修改 HTML

不足:

- 社区规模小于 Beautiful Soup、LXML

- 对格式错误的 HTML 支持有限

实用建议: 喜欢 lxml 性能又偏爱 CSS 选择器时,PyQuery 是理想选择。

12. Parsel

是专为 HTML/XML 数据提取设计的强大库,支持 XPath 和 CSS 选择器,也是 Scrapy 解析引擎的核心。

是专为 HTML/XML 数据提取设计的强大库,支持 XPath 和 CSS 选择器,也是 Scrapy 解析引擎的核心。

主要功能:

- 高级 XPath 和 CSS 选择器支持

- 简洁 API,方便数据提取和清洗

- 可独立使用或集成到 Scrapy

最佳应用场景: 复杂数据提取、需要强大选择器逻辑的项目、和 Scrapy 集成。

优点:

- 灵活强大

- 擅长处理复杂网页结构

- 文档完善、持续维护

不足:

- 需掌握选择器用法

- 不是完整爬虫框架,适合作为解析组件

实用建议: 用于自定义 Scrapy 爬虫或独立解析脚本中的数据提取核心。

Python 网页爬虫工具对比一览

| 库 | 主要功能 | 性能 | 易用性 | JavaScript 支持 | 最佳用途 | 集成选项 |

|---|---|---|---|---|---|---|

| Thunderbit | AI 驱动、零代码、子页面爬取 | ⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | 支持(基于浏览器) | 业务用户、混合工作流 | Excel、Sheets、Notion、Python |

| Beautiful Soup | HTML/XML 解析,容错性强 | ⭐⭐ | ⭐⭐⭐⭐⭐ | 不支持 | 数据清洗、小型任务 | Requests、LXML、Thunderbit |

| Selenium | 浏览器自动化,动态内容 | ⭐⭐ | ⭐⭐ | 支持 | 动态网站、用户交互 | Beautiful Soup、PyQuery |

| Requests | HTTP 请求、会话管理 | ⭐⭐⭐ | ⭐⭐⭐⭐⭐ | 不支持 | 静态网页、API 抓取 | Beautiful Soup、LXML |

| LXML | 高速解析、XPath、CSS 选择器 | ⭐⭐⭐⭐ | ⭐⭐⭐ | 不支持 | 大文档、复杂解析 | Beautiful Soup、PyQuery |

| Pyppeteer | 无头 Chrome、JS 渲染 | ⭐⭐ | ⭐⭐ | 支持 | 现代 JS 网站、SPA | Thunderbit、Pandas |

| Splash | JS 渲染、API 调用 | ⭐⭐⭐ | ⭐⭐ | 支持 | 批量 JS 爬取、管道 | Scrapy、Thunderbit |

| MechanicalSoup | 表单处理、网页导航 | ⭐⭐ | ⭐⭐⭐⭐ | 不支持 | 简单表单、登录 | Requests、Beautiful Soup |

| Twisted | 异步网络、自定义管道 | ⭐⭐⭐⭐⭐ | ⭐ | 不支持 | 高并发自定义爬虫 | Scrapy、自定义框架 |

| Scrapy | 高性能、异步、数据管道 | ⭐⭐⭐⭐⭐ | ⭐⭐ | 有限(通过 Splash) | 企业级、结构化数据 | Splash、Parsel、Thunderbit |

| PyQuery | jQuery 风格选择器、高效 | ⭐⭐⭐ | ⭐⭐⭐⭐ | 不支持 | jQuery 爱好者、快速原型 | LXML、Requests |

| Parsel | XPath/CSS 选择器、灵活解析 | ⭐⭐⭐⭐ | ⭐⭐⭐ | 不支持 | 复杂提取、Scrapy 用户 | Scrapy、独立使用 |

如何选最适合你的 Python 网页爬虫库

决策速查:

-

只抓静态网页或 API?

用 Requests + Beautiful Soup 或 LXML。 -

要大规模、高速爬取?

Scrapy 是首选。异步网络可以考虑 Twisted。 -

要爬动态、JS 密集型网站?

试试 Selenium、Pyppeteer 或 Scrapy + Splash。 -

喜欢 jQuery 选择器?

PyQuery 很适合你。 -

需要自动化表单或登录?

MechanicalSoup 简单高效。 -

不会写代码,或者想省事?

Thunderbit 支持自然语言描述需求,导出结构化数据到常用工具。 -

混合方案?

用 Thunderbit 快速原型和结构化数据,再交给 Python 脚本深度处理。

选型清单:

- 网站复杂度(静态/动态)?

- 需要抓取的数据量有多大?

- 是否涉及表单或登录?

- 你对 Python 和选择器的熟悉程度?

- 是否需要导出到 Excel、Sheets、Notion 等业务工具?

- 后期维护是否重要?

总结:2026 年 Python 网页爬虫的无限可能

Python 网页爬虫比以前更强大、更好用。不管你用 Scrapy 扩展规模、用 Beautiful Soup 清洗数据、用 Selenium 或 Pyppeteer 搞定 JS,还是只想零代码把数据导进表格,总有一款工具适合你。

秘诀其实很简单:别怕混搭。每个 Python 爬虫库都有自己的绝活,合理组合(或者引入 Thunderbit 这类 AI 方案)能大大节省时间、减少出错、挖掘更多业务价值。

2026 年,赢家不再是写代码最快的人,而是会用对工具、自动化繁琐流程,把网页数据真正变成业务成果的人。

常见问题

1. 新手用哪个 Python 爬虫库最合适?

Beautiful Soup 因为语法简单、容错性强,非常适合新手。如果不会编程,Thunderbit 提供了 AI 驱动的零代码替代方案。

2. 哪些 Python 工具适合动态或 JS 密集型网站?

Selenium、Pyppeteer 和 Splash 都很适合处理动态内容,Pyppeteer 尤其擅长现代 JS 应用。

3. Thunderbit 能和 Scrapy、Beautiful Soup 等 Python 库配合吗?

当然可以!Thunderbit 可以快速结构化并导出数据,后续可以用你喜欢的 Python 库进一步处理。

4. 解析大体量 HTML 文档时,哪个 Python 库最快?

LXML 通常是大规模解析的速度之选,尤其适合用 XPath 或 CSS 选择器。

5. Scrapy 和 Selenium 如何选择?

大规模、结构化静态网页推荐用 Scrapy;需要和动态元素、登录、JS 页面交互时选 Selenium。

想体验 Thunderbit 如何提升你的网页爬虫效率?,或者访问 获取更多实用指南。祝你爬虫顺利!

延伸阅读