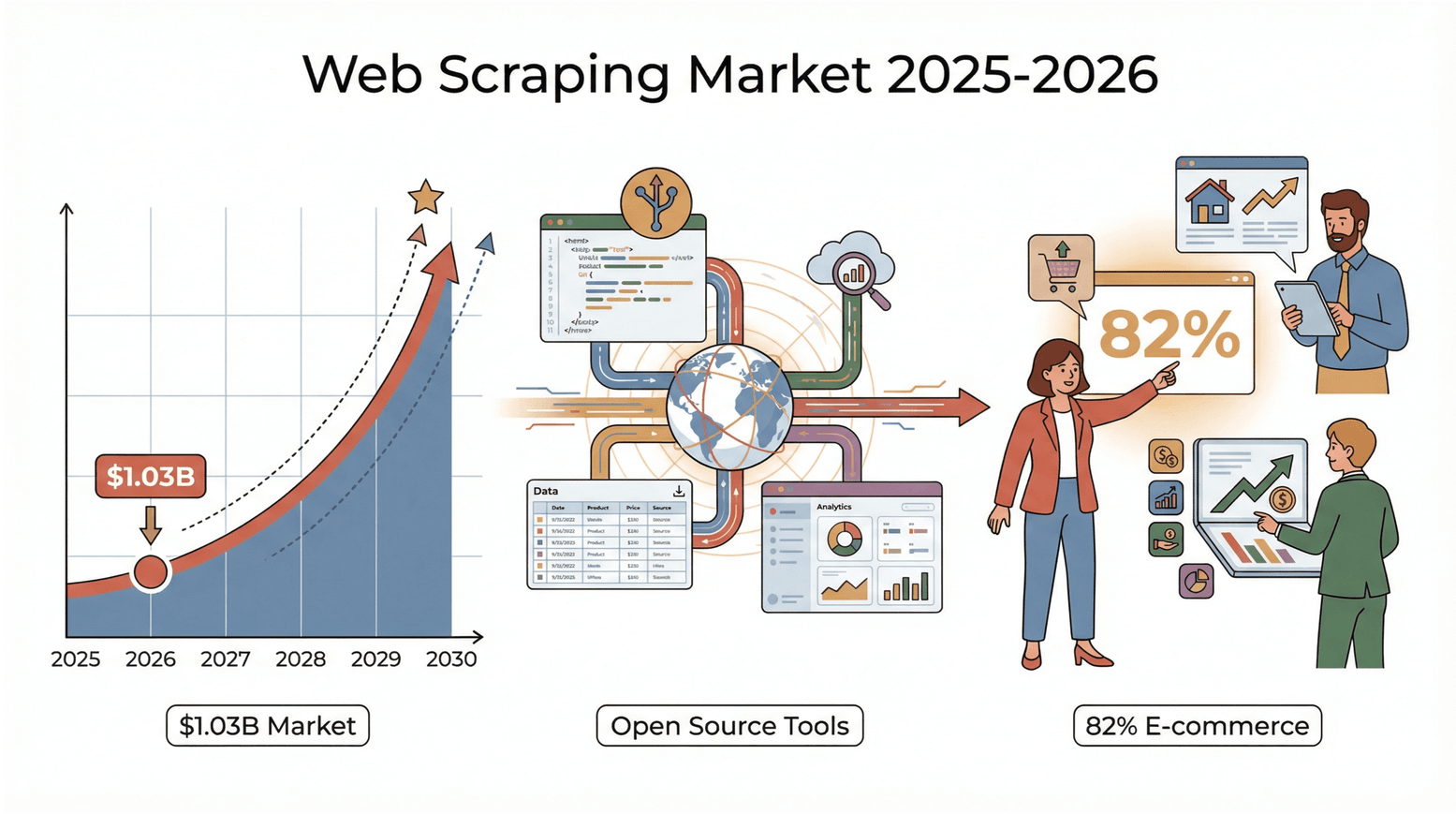

互联网数据量正在以惊人的速度膨胀,到了2026年,谁能高效把这些杂乱无章的信息转化为有价值的洞察,谁就能在竞争中抢占先机。不管你是做销售、跨境电商、房产,还是像我一样热爱数据,你肯定发现,传统的“复制粘贴”早就跟不上需求了。有个数据很震撼:全球网页爬虫市场在,预计到2030年还会翻一倍。不只是科技大厂——82%的电商企业和超过三分之一的投资公司都在用网页爬虫搞线索、定价和市场情报()。说白了,如果你还没用上网页爬虫工具,可能已经错过了不少商机和数据红利。

好消息是:现在的开源网页爬虫工具越来越强大、越来越好用,社区氛围也超级活跃。不管你是Python大佬、JavaScript开发者,还是只想轻松搞定数据的业务小伙伴,总有一款适合你。作为一个长期关注SaaS和自动化的从业者,我亲眼见证了这个生态的飞速成长。接下来,咱们就来盘点一下2025年最值得一试的10款开源网页爬虫工具,顺便聊聊怎么选到最适合自己的那一款。

为什么要选开源网页爬虫工具?

开源网页爬虫工具就像数据圈的瑞士军刀。它们不用花钱买授权,灵活可定制,代码完全透明(你随时能看懂它怎么跑的)。但最核心的优势,其实是背后的社区。开源工具有成千上万的开发者和用户一起维护,插件、教程、答疑啥都有——遇到难题,总有人能帮你一把()。

和商业工具比,开源方案让你真正掌握主动权。你不会被厂商的产品路线或价格卡脖子,网站结构变了也能灵活调整爬虫。其实,很多商业爬虫服务本身就是基于这些开源引擎开发的——既然如此,何不直接用开源原版?

我们怎么筛选最佳开源网页爬虫工具

市面上选择太多,我主要看这几个维度:

- 易用性: 非技术用户能不能快速上手?有没有可视化或AI辅助?

- 可扩展性: 能不能支持大项目,还是只适合小任务?

- 语言与平台支持: Python、JavaScript、浏览器插件、桌面应用等,能不能满足不同技术栈?

- 社区活跃度与维护: 有没有持续更新?文档、插件、讨论区丰富不丰富?

- 独特功能: 比如AI字段识别、子页面抓取、定时任务、云端支持等。

另外,我还结合了真实用户反馈和实际业务场景——毕竟,最好的工具就是能帮你解决问题的那一个。

2026年值得关注的五大开源网页爬虫工具

下面这份榜单,是我精挑细选出来的,从AI驱动的易用型到开发者专属的强大工具全都有。

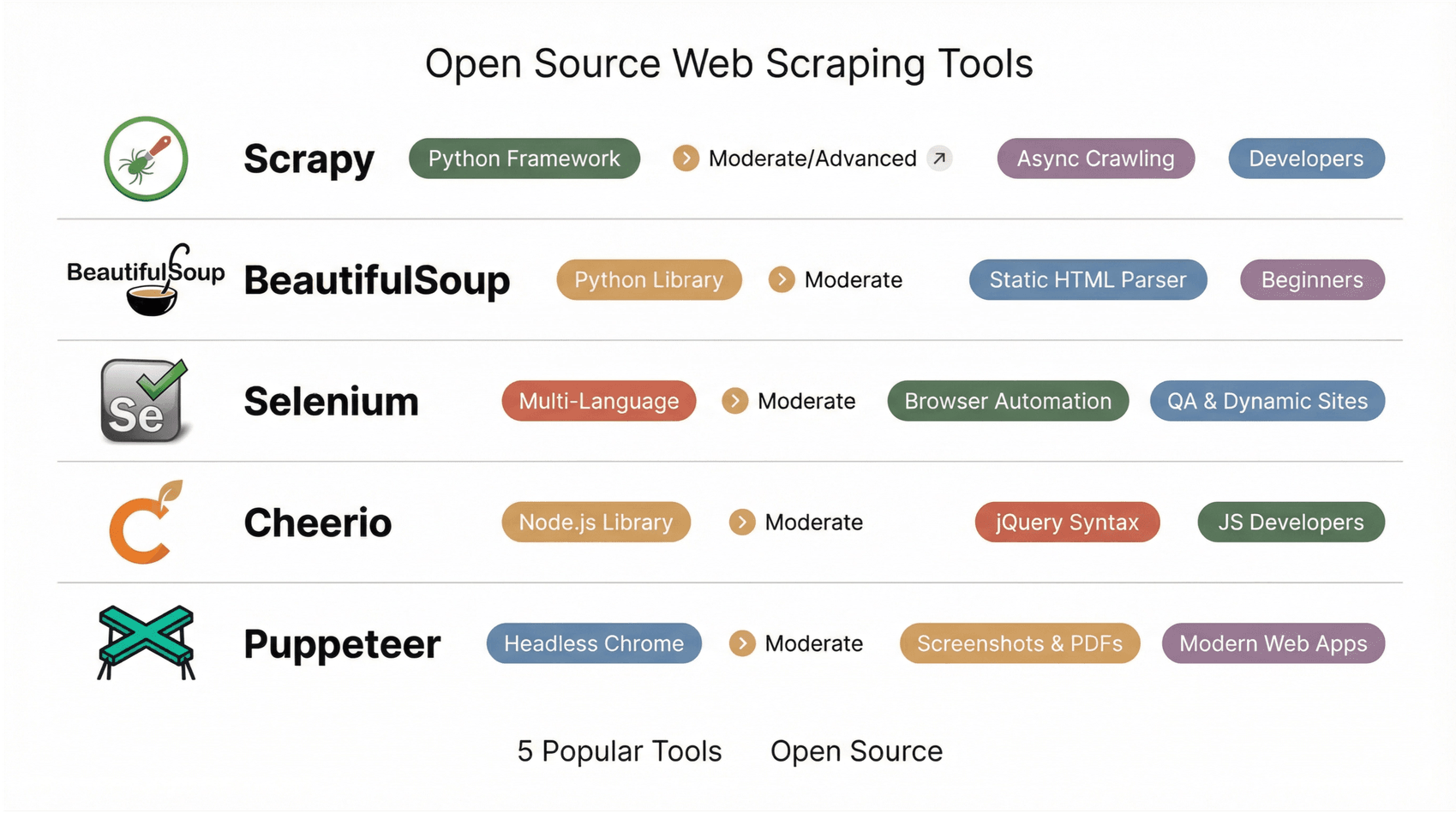

1. Scrapy

是Python开发者的首选。它是一套成熟的框架,专门用来搭建可扩展、可定制的爬虫和数据管道。Scrapy基于异步网络架构,能高效抓取成千上万甚至上百万网页。你只需要用Python写个“蜘蛛”,Scrapy会自动帮你处理队列、限速、数据导出(支持JSON、CSV、XML等格式)。

它的插件生态非常丰富,支持代理、中间件、Cookie管理,甚至能集成无头浏览器抓取动态网站。Scrapy特别适合大规模项目,比如全站商品采集或新闻聚合。对非技术用户来说学习曲线有点陡,但如果你追求强大和灵活,Scrapy绝对值得一试()。

2. Beautiful Soup

是Python圈最经典的HTML解析库。它上手特别简单,容错性也很强(HTML结构再乱都能解析)。一般会和requests库配合用,先拿到网页,再用Beautiful Soup提取你想要的内容。

非常适合小型项目、原型开发和教学。唯一的限制是:Beautiful Soup不能执行JavaScript,只能处理静态HTML。遇到动态网站时,需要和Selenium或requests_html等工具搭配用()。

3. Selenium

是最早的浏览器自动化工具之一。最初是做自动化测试的,现在已经成了抓取动态、JavaScript密集型网站的神器。Selenium可以启动真实浏览器(比如Chrome、Firefox等),模拟用户操作——点击、滚动、登录都不在话下。只要人眼能看到的,Selenium基本都能抓。

支持多种编程语言(Python、Java、JS、C#),尤其适合需要登录或交互流程的网站。缺点是速度慢点、资源占用高,浏览器驱动管理也稍微麻烦。但遇到复杂网页,Selenium往往是救命稻草()。

4. Cheerio

是Node.js生态里的“jQuery解析器”。它让你用熟悉的jQuery语法在服务器端解析HTML,速度非常快,特别适合静态页面。只要用Axios或Fetch拿到HTML,再用Cheerio选择器提取数据就行。

Cheerio不支持JavaScript渲染,适合静态内容。但和其他Node.js工具集成很顺,是JavaScript开发者处理网页数据的首选()。

5. Puppeteer

是一款Node.js库,可以无头控制Chrome或Chromium浏览器。可以理解为Selenium的“原生JS版”,更轻量、API更现代。Puppeteer特别适合抓取现代Web应用、单页应用(SPA)等需要真实浏览器渲染的场景。支持截图、生成PDF、拦截网络请求等高级功能,API基于async/await,开发体验非常棒。

更适合有开发经验的用户。如果你要抓取大量依赖JavaScript的网站,Puppeteer绝对是必备()。

快速对比表:最佳开源网页爬虫工具

| 工具 | 易用性 | 平台/语言 | 动态内容支持 | 适用场景 | 独特优势 |

|---|---|---|---|---|---|

| Scrapy | 中等/进阶(需编程) | Python 框架 | 部分支持 | 开发者、数据科学家 | 异步抓取、插件丰富、社区庞大 |

| BeautifulSoup | 中等(简单代码) | Python 库 | 不支持 | 新手、快速解析 | 容错性强,适合静态HTML |

| Selenium | 中等(脚本编写) | 多语言支持 | 支持 | 测试、动态网站抓取 | 真实浏览器自动化,支持登录和用户操作 |

| Cheerio | 中等(JS代码) | Node.js 库 | 不支持 | JS开发者、静态页面 | jQuery语法,HTML解析速度快 |

| Puppeteer | 中等(JS代码) | Node.js(无头Chrome) | 支持 | 开发者、现代Web应用 | 截图、PDF、SPA抓取、async/await API |

怎么选适合你的开源网页爬虫工具

选型小建议如下:

- 技术水平: 零基础?推荐Thunderbit、Octoparse、ParseHub或WebHarvy。开发者可以选Scrapy、Cheerio、Puppeteer或Apify。

- 项目规模: 一次性或小型任务?用Beautiful Soup、Cheerio、WebHarvy。大规模或持续性项目?选Scrapy、Apify、Thunderbit(支持定时)。

- 数据类型: 静态HTML?用Cheerio、Beautiful Soup或WebHarvy。动态/JS复杂页面?选Puppeteer、Selenium、Thunderbit、Octoparse。

- 集成需求: 需要导出到Sheets、Notion或数据库?Thunderbit和Octoparse最方便。需要API或自定义管道?Scrapy和Apify更合适。

- 社区与支持: 看论坛活跃度、更新频率和教程数量。Scrapy、Cheerio、Selenium社区庞大;Thunderbit和Octoparse用户群体增长快,教程也多。

建议先用小项目试试几款工具,找到最适合自己工作流和习惯的那一款。有时候,最快的办法是先用可视化工具快速采集,再用代码框架做深度抓取。

开源爬虫的社区与持续支持价值

开源工具最大的优势之一,就是社区。活跃的论坛、GitHub仓库、Stack Overflow标签,意味着你遇到问题时总能找到答案。社区驱动的工具更新快、功能多,教程、插件和最佳实践层出不穷()。

像Thunderbit、Octoparse这些可视化工具,用户社区和模板分享就是宝藏。开发者工具则以GitHub、Discord/Slack群组为主。选择开源工具,就是加入了一个全球协作、共同进步的网络,这种价值真的无法用钱衡量。

Thunderbit:人人都能用的零代码网页爬虫方案

开源工具虽然好,但有时候你并不想为了抓点数据反复搭建、调试和维护爬虫。并且,并不是所有抓取需求都适合用代码搞——这就是Thunderbit的用武之地。如果你看到这里,觉得“这些工具都很强,但我只想要数据,不想折腾爬虫”,Thunderbit就是你的理想选择。

是一款专为业务用户设计的AI网页爬虫Chrome插件,关注结果而不是技术细节。无需写选择器或脚本,只要点一下AI智能识别字段,AI会自动理解页面结构、推荐表头,二次点击就能完成抓取。分页、子页面、列表-详情等复杂流程都能自动处理。

Thunderbit最大亮点就是把用户意图和结构化数据无缝衔接。你可以用自然语言描述需求(比如“采集商品名称、价格和评分”),Thunderbit会自动转成清晰表格。子页面抓取功能让你轻松采集详情页数据。支持一键导出到Excel、Google Sheets、Notion、Airtable,数据立刻可用。

Thunderbit特别受销售、市场、电商、房产等团队欢迎,尤其适合需要高效数据但不想维护开源管道的用户。支持多语言,动态网站表现也很棒,免费额度也很友好。虽然不是开源,但和开源工具互补——是快速验证想法、处理重复性业务抓取的高效利器,无需工程投入。

总结:用最佳开源工具释放网页数据价值

网页爬虫早就不是程序员或大公司的专属。现在的开源工具,让任何人都能把网页变成结构化、可用的数据——不管是做客户名单、监控价格,还是给AI项目喂数据。关键是根据自己的需求选对工具:AI驱动和可视化工具追求速度和易用,代码框架则适合复杂和大规模场景。

下一步?从榜单里挑一款工具,试着解决实际问题,感受省下的时间和精力。如果想要快速体验,直接,体验网页爬虫的高效与便捷。互联网数据触手可及,快去挖掘属于你的“数据珍珠”吧。

想看更多实用教程和深度解析,欢迎访问 。祝你抓取顺利!

常见问题

1. 开源网页爬虫工具相比商业工具最大的优势是什么?

开源工具成本低、灵活性强,还有活跃社区支持。你可以根据需求自定义,避免被厂商锁定,还能享受社区带来的知识共享和持续更新。

2. 哪款开源工具最适合非技术业务用户?

Thunderbit、Octoparse、ParseHub和WebHarvy都很适合零基础用户。Thunderbit凭借AI驱动的两步操作和便捷导出功能尤其突出。

3. 开源工具能不能抓取动态、JavaScript复杂的网站?

当然可以!Thunderbit、Selenium、Puppeteer、Octoparse和ParseHub等工具都能通过真实或无头浏览器渲染页面,抓取动态内容。

4. 怎么判断一个工具是否持续维护和有支持?

可以看GitHub上的最新提交、活跃的issue和贡献者数量。还可以关注论坛、博客更新和用户分享的插件或模板。

5. 新手怎么入门网页爬虫?

建议从Thunderbit或Octoparse等可视化、AI驱动工具入手。先尝试抓取小型数据集,导出到Excel或Sheets,慢慢熟悉流程。等有经验后,再探索代码型工具应对更复杂项目。

想亲自体验Thunderbit?,和3万+用户一起轻松把网页变成数据,无需编程。

延伸阅读