Artık internet sadece bir dijital oyun alanı değil—dünyanın en büyük veri kaynağına dönüştü ve satış ekiplerinden pazar analistlerine kadar herkes bu hazineye ulaşmak için yarışıyor. Ama dürüst olalım: Web verisini elle toplamak, IKEA’dan mobilya alıp kurulum kılavuzu olmadan monte etmeye çalışmak gibi; sonunda elinizde fazladan birkaç vida kalıyor. Şirketler anlık pazar içgörüsü, rekabetçi fiyatlandırma ve potansiyel müşteri bulma gibi konularda giderek daha fazla web verisine güveniyor. Bu yüzden pratik ve güvenilir veri toplama araçlarına olan ihtiyaç hiç olmadığı kadar arttı. Hatta ve küresel web scraping pazarı gibi görünüyor.

Kopyala-yapıştır işlerinden sıkıldıysan, yeni potansiyel müşterileri kaçırmak istemiyorsan ya da otomasyonun neler yapabileceğini merak ediyorsan, tam yerindesin. Yıllardır web veri çıkarım araçları geliştiriyor ve test ediyorum (ve evet, ekibinin başındayım), bu yüzden doğru aracın saatler süren angaryayı iki tıkla nasıl çözdüğünü çok iyi biliyorum. Kod bilmeyenler için anında sonuç, geliştiriciler için tam kontrol arıyorsan, bu en iyi 10 veri toplama aracı listesi tam sana göre.

Neden Doğru Veri Toplama Aracını Seçmek Önemli?

Gerçekçi olalım: İyi bir veri toplama aracı ile sıradan bir araç arasındaki fark sadece kolaylık değil—doğrudan işinin büyümesine etki ediyor. Web veri çıkarımını otomatikleştirdiğinde sadece zaman kazanmazsın (bir G2 kullanıcısı ), aynı zamanda hataları azaltır, yeni fırsatların önünü açar ve ekibinin her zaman güncel ve doğru verilerle çalışmasını sağlarsın. Elle araştırma yapmak yavaş, hataya açık ve çoğu zaman işin bittiğinde veriler zaten güncelliğini yitirmiş olur. Doğru araçla rakipleri izlemek, fiyatları takip etmek veya potansiyel müşteri listeleri oluşturmak dakikalar alır—günler değil.

Mesela: Bir kozmetik perakendecisi, rakiplerinin stok ve fiyatlarını web scraping ile izleyerek . Bunu sadece Excel ve manuel emekle başarmak neredeyse imkânsız.

En İyi Veri Toplama Araçlarını Nasıl Değerlendirdik?

Piyasada bu kadar çok seçenek varken, doğru aracı seçmek teknoloji fuarında hızlı tanışmaya benziyor. İşte en iyileri ayırmak için kullandığım kriterler:

- Kullanım Kolaylığı: Başlamak için Python uzmanı olman gerekiyor mu? Kod bilmeyenler için görsel arayüz veya yapay zeka desteği var mı?

- Otomasyon Yeteneği: Sayfalandırma, alt sayfalar, dinamik içerik ve zamanlama gibi özellikleri destekliyor mu? Büyük işler için bulutta çalışabiliyor mu?

- Fiyatlandırma ve Ölçeklenebilirlik: Ücretsiz veya uygun fiyatlı bir başlangıç planı var mı? Veri ihtiyacın arttıkça maliyet nasıl değişiyor?

- Özellik Seti ve Entegrasyon: Excel, Google Sheets veya API ile dışa aktarım mümkün mü? Şablonlar, zamanlama veya yerleşik veri temizleme özellikleri var mı?

- Kimler İçin Uygun: Araç kimler için tasarlanmış—iş kullanıcıları, geliştiriciler veya kurumsal ekipler?

Her aracın öne çıkan özelliklerini karşılaştırabileceğin bir tabloyu da yazının sonunda bulabilirsin.

Şimdi, 2025 için en verimli web veri çıkarımı sağlayan en iyi 10 veri toplama aracına göz atalım.

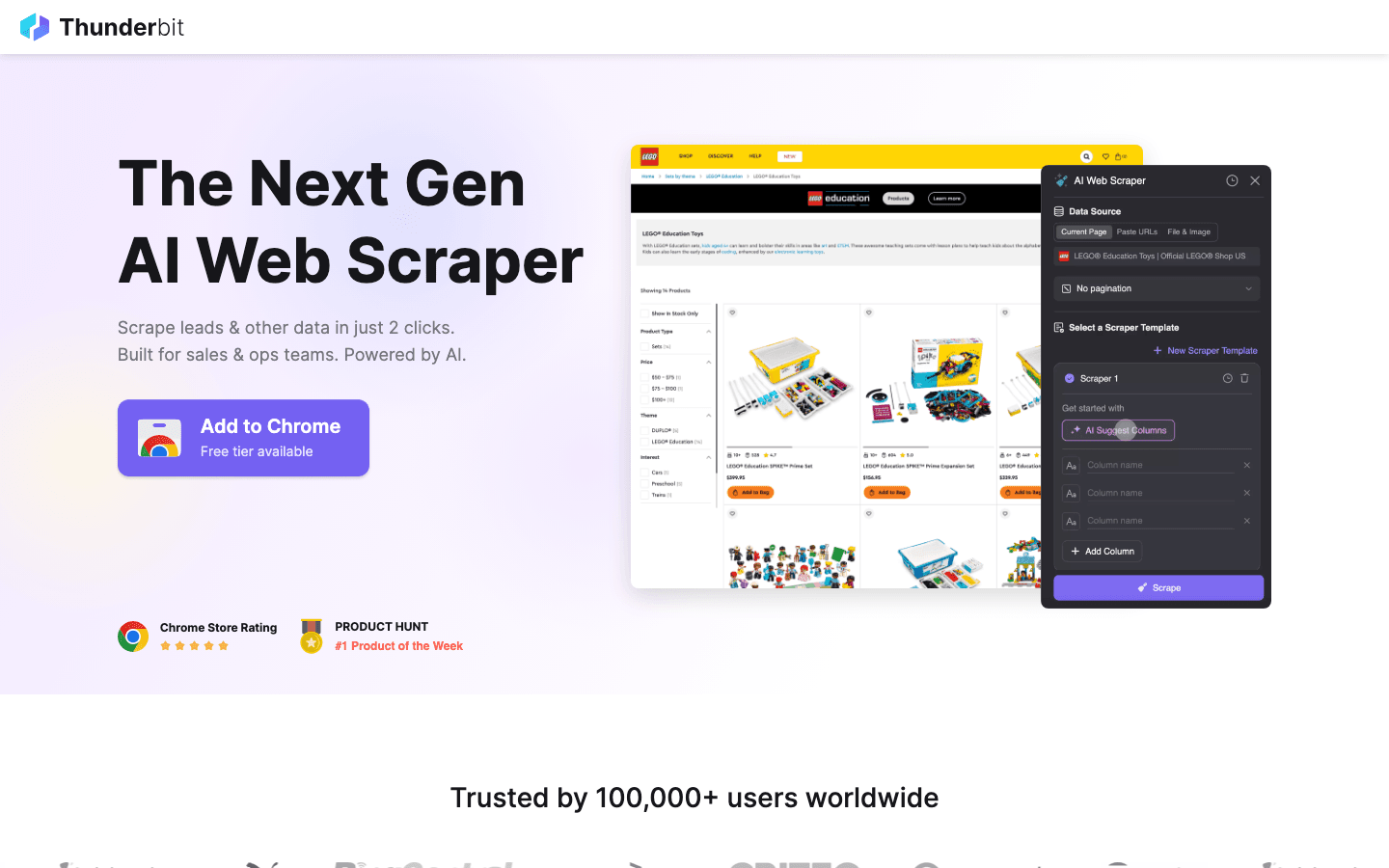

1. Thunderbit

, veri toplama işini yemek siparişi vermek kadar kolay hale getirmek isteyenler için ilk önerim. Yapay zeka destekli bir Chrome eklentisi olarak tasarlanan Thunderbit, 2 tıkla veri çekme mantığıyla çalışıyor: “AI Alanları Öner”e tıkla, yapay zeka sayfadaki verileri algılasın, ardından “Veri Çek”e bas ve verilerin hazır. Kod yok, karmaşık ayarlar yok—anında sonuç.

, veri toplama işini yemek siparişi vermek kadar kolay hale getirmek isteyenler için ilk önerim. Yapay zeka destekli bir Chrome eklentisi olarak tasarlanan Thunderbit, 2 tıkla veri çekme mantığıyla çalışıyor: “AI Alanları Öner”e tıkla, yapay zeka sayfadaki verileri algılasın, ardından “Veri Çek”e bas ve verilerin hazır. Kod yok, karmaşık ayarlar yok—anında sonuç.

Thunderbit’i satış, pazarlama ve e-ticaret ekipleri için öne çıkaran özellikler:

- AI Alanları Öner: Yapay zeka sayfayı analiz edip en uygun sütunları (isim, fiyat, e-posta vb.) otomatik önerir.

- Alt Sayfa Veri Çekme: Daha fazla detay mı lazım? Thunderbit, ürün detayları veya LinkedIn profilleri gibi alt sayfalara otomatik gidip tablonu zenginleştirir.

- Anında Dışa Aktarım: Verilerini doğrudan Excel, Google Sheets, Airtable veya Notion’a aktar. Tüm dışa aktarımlar ücretsizdir.

- Tek Tıkla Şablonlar: Amazon, Zillow, Instagram gibi popüler siteler için hazır şablonlarla daha hızlı sonuç al.

- Ücretsiz Veri Aktarımı: Verini almak için ek ücret yok.

- Zamanlanmış Veri Çekme: “Her Pazartesi 09:00’da” gibi doğal dilde tekrarlayan işler ayarlayabilirsin—fiyat takibi veya haftalık müşteri güncellemeleri için birebir.

Thunderbit, kredi sistemiyle çalışır (1 kredi = 1 satır) ve ile 6 sayfaya kadar (veya deneme ile 10 sayfa) veri çekebilirsin. Ücretli planlar 500 kredi için aylık 15$’dan başlar, bu da her büyüklükte ekip için ulaşılabilir kılar.

Thunderbit’in nasıl çalıştığını görmek için veya göz atabilirsin. Keşke manuel veri girişiyle uğraştığım zamanlarda böyle bir araç olsaydı diyorum.

2. Octoparse

, özellikle büyük ölçekli veri ihtiyacı olan kurumsal kullanıcılar için güçlü bir araç. Windows ve Mac’te çalışan görsel masaüstü arayüzü sayesinde kod yazmadan veri çıkarım akışları oluşturabilirsin. Ama kullanıcı dostu arayüzüne aldanma: Octoparse, giriş işlemleri, sonsuz kaydırma, proxy rotasyonu ve CAPTCHA çözme gibi gelişmiş özellikleri de destekliyor.

, özellikle büyük ölçekli veri ihtiyacı olan kurumsal kullanıcılar için güçlü bir araç. Windows ve Mac’te çalışan görsel masaüstü arayüzü sayesinde kod yazmadan veri çıkarım akışları oluşturabilirsin. Ama kullanıcı dostu arayüzüne aldanma: Octoparse, giriş işlemleri, sonsuz kaydırma, proxy rotasyonu ve CAPTCHA çözme gibi gelişmiş özellikleri de destekliyor.

- 500+ Hazır Şablon: Amazon, Twitter, LinkedIn ve daha fazlası için hızlı başlangıç.

- Bulut Tabanlı Veri Çekme: İşlerini Octoparse sunucularında çalıştır, zamanla ve büyük projelerde ölçeklendir.

- API Erişimi: Çekilen verileri doğrudan iş uygulamalarına veya veritabanına entegre et.

- Gelişmiş Otomasyon: Dinamik içerik, sayfalandırma ve çok adımlı akışları yönetir.

10 göreve kadar destekliyor, ama çoğu iş kullanıcısı Standart (~83$/ay) veya Profesyonel (~299$/ay) planı tercih edecektir. Thunderbit’e göre öğrenme eğrisi biraz daha dik, fakat binlerce sayfayı güvenle çekmek istiyorsan Octoparse güçlü bir aday.

3. Scrapy

, veri toplama projelerinde tam kontrol isteyen geliştiriciler için altın standarttır. Açık kaynaklı bir Python framework’ü olan Scrapy ile istediğin her site için özel “örümcekler” (crawler) kodlayabilirsin. Hayal edebiliyorsan, Scrapy ile inşa edebilirsin.

, veri toplama projelerinde tam kontrol isteyen geliştiriciler için altın standarttır. Açık kaynaklı bir Python framework’ü olan Scrapy ile istediğin her site için özel “örümcekler” (crawler) kodlayabilirsin. Hayal edebiliyorsan, Scrapy ile inşa edebilirsin.

- Tam Programlanabilirlik: Python kodu ile herhangi bir siteyi nasıl tarayacağını ve verileri nasıl çıkaracağını tanımla.

- Asenkron ve Hızlı: Büyük projelerde binlerce sayfayı paralel olarak işler.

- Genişletilebilir: Proxy, headless browser veya özel mantık için middleware ekleyebilirsin.

- Güçlü Topluluk: Zorlu scraping senaryoları için bolca eğitim, eklenti ve destek var.

Scrapy ücretsiz ve açık kaynaklıdır, ama programlama bilgisi gerektirir. Teknik bir ekibin varsa veya özel bir veri hattı kurmak istiyorsan, Scrapy rakipsizdir. Kod bilmeyenler için ise öğrenmesi zordur.

4. ParseHub

, karmaşık sitelerle uğraşan kod bilmeyenler için görsel, kodsuz bir web scraping aracıdır. Nokta-tıkla arayüzüyle veri öğelerini seçebilir, işlemleri tanımlayabilir ve dinamik içerikli ya da karmaşık navigasyonlu siteler için veri çekme akışları oluşturabilirsin.

, karmaşık sitelerle uğraşan kod bilmeyenler için görsel, kodsuz bir web scraping aracıdır. Nokta-tıkla arayüzüyle veri öğelerini seçebilir, işlemleri tanımlayabilir ve dinamik içerikli ya da karmaşık navigasyonlu siteler için veri çekme akışları oluşturabilirsin.

- Görsel Akış Oluşturucu: Veriyi seçmek, sayfalandırma ayarlamak ve pop-up/menüleri yönetmek için tıkla.

- Dinamik İçerik Desteği: JavaScript ağırlıklı ve etkileşimli sayfalarda çalışır.

- Bulutta Çalıştırma & Zamanlama: Çekimleri bulutta çalıştır ve tekrarlayan işler planla.

- CSV, Excel veya API ile Dışa Aktarım: Favori araçlarınla kolay entegrasyon.

ParseHub ücretsiz plan (5 proje) sunar, ücretli planlar ise seviyesinden başlar. Rakiplerine göre biraz pahalı olsa da, görsel yaklaşımı analistler, pazarlamacılar ve araştırmacılar için erişilebilir kılar.

5. Apify

, hem bir platform hem de web veri çekme için bir pazar yeridir. Popüler siteler için binlerce hazır “Actor” (hazır scraper) sunar, ayrıca kendi özel crawler’ını bulutta oluşturup çalıştırabilirsin.

, hem bir platform hem de web veri çekme için bir pazar yeridir. Popüler siteler için binlerce hazır “Actor” (hazır scraper) sunar, ayrıca kendi özel crawler’ını bulutta oluşturup çalıştırabilirsin.

- 5.000+ Hazır Actor: Google Maps, Amazon, Twitter ve daha fazlası için anında veri çek.

- Özel Kodlama: Geliştiriciler JavaScript veya Python ile gelişmiş crawler’lar oluşturabilir.

- Bulut Ölçeklendirme: İşleri paralel çalıştır, görevleri zamanla ve verileri bulutta yönet.

- API & Entegrasyon: Sonuçları uygulamalarına, iş akışlarına veya veri hatlarına entegre et.

Apify, esnek bir sunar, ücretli planlar ise aylık 29$’dan başlar (kullandıkça öde modeli). Öğrenme eğrisi biraz var, ama hem hazır hem de tam özelleştirilebilir bir çözüm arıyorsan Apify güçlü bir tercihtir.

6. Data Miner

, hızlı ve şablon tabanlı veri çekimi için geliştirilmiş bir Chrome eklentisidir. Tablo veya listelerden veri almak isteyen iş kullanıcıları için idealdir, üstelik kurulum gerektirmez.

, hızlı ve şablon tabanlı veri çekimi için geliştirilmiş bir Chrome eklentisidir. Tablo veya listelerden veri almak isteyen iş kullanıcıları için idealdir, üstelik kurulum gerektirmez.

- Geniş Şablon Kütüphanesi: LinkedIn, Yelp gibi popüler siteler için binlerce hazır şablon.

- Nokta-Tıkla Çıkarım: Şablonu seç, veriyi önizle ve anında dışa aktar.

- Tarayıcı Tabanlı: Mevcut oturumunla çalışır—giriş gerektiren sitelerde de veri çekebilirsin.

- CSV veya Excel’e Aktarım: Verini saniyeler içinde tabloya aktar.

ayda 500 sayfaya kadar destekler, ücretli planlar ise 20$/ay’dan başlar. Küçük, tek seferlik işler veya acil veri ihtiyaçları için idealdir—ama büyük ölçekli işler veya karmaşık otomasyon bekleme.

7. Import.io

, sürekli ve güvenilir web veri entegrasyonuna ihtiyaç duyan kurumlar için kurumsal düzeyde bir platformdur. Sadece bir crawler değil—temiz ve yapılandırılmış veriyi doğrudan iş sistemlerine teslim eden yönetilen bir hizmettir.

, sürekli ve güvenilir web veri entegrasyonuna ihtiyaç duyan kurumlar için kurumsal düzeyde bir platformdur. Sadece bir crawler değil—temiz ve yapılandırılmış veriyi doğrudan iş sistemlerine teslim eden yönetilen bir hizmettir.

- Kodsuz Veri Çekme: Hangi verinin çekileceğini görsel olarak tanımla.

- Gerçek Zamanlı Veri Akışı: Verileri panolara, analiz araçlarına veya veritabanlarına aktar.

- Uyumluluk & Güvenilirlik: IP rotasyonu, anti-bot önlemleri ve yasal uyumluluk sağlar.

- Yönetilen Hizmetler: Import.io ekibi, scraper’larını kurar ve yönetir.

Fiyatlandırma , SaaS platformu için 14 günlük ücretsiz deneme sunar. İşin sürekli güncel web verisine bağlıysa (perakende, finans, pazar araştırması gibi), Import.io’yu değerlendirebilirsin.

8. WebHarvy

, abonelik gerektirmeyen, Windows kullanıcıları için masaüstü tabanlı bir scraper’dır. Özellikle tek seferlik ödeme tercih eden küçük işletmeler ve bireysel kullanıcılar arasında popülerdir.

, abonelik gerektirmeyen, Windows kullanıcıları için masaüstü tabanlı bir scraper’dır. Özellikle tek seferlik ödeme tercih eden küçük işletmeler ve bireysel kullanıcılar arasında popülerdir.

- Görsel Desen Algılama: Veri öğelerine tıkla, WebHarvy tekrar eden desenleri otomatik algılar.

- Metin, Görsel ve Daha Fazlası: E-posta ve URL dahil tüm yaygın veri türlerini çeker.

- Sayfalandırma & Zamanlama: Çok sayfalı sitelerde gez ve zamanlanmış çekimler ayarla.

- Excel, CSV, XML, JSON veya SQL’e Aktarım: Her iş akışına uygun esnek çıktı.

Tek kullanıcı lisansı ve düzenli kullanım için ekonomik bir seçenek—ama sadece Windows’ta çalışır.

9. Mozenda

, iş operasyonları ve sürekli veri ihtiyacı için bulut tabanlı bir veri toplama platformudur. Windows’ta çalışan masaüstü tasarımcısı ile güçlü bulut otomasyonunu birleştirir.

, iş operasyonları ve sürekli veri ihtiyacı için bulut tabanlı bir veri toplama platformudur. Windows’ta çalışan masaüstü tasarımcısı ile güçlü bulut otomasyonunu birleştirir.

- Görsel Ajan Oluşturucu: Nokta-tıkla arayüzle veri çıkarım rutinleri tasarla.

- Bulut Ölçeklendirme: Birden fazla ajanı paralel çalıştır, işleri zamanla ve verileri merkezi olarak yönet.

- Veri Yönetim Konsolu: Çıkarılan verileri birleştir, filtrele ve temizle.

- Kurumsal Destek: Büyük ekipler için özel hesap yöneticileri ve yönetilen hizmetler.

Planlar seviyesinden başlar, daha fazla kullanıcı ve işlem gücü için üst paketler mevcuttur. Mozenda, günlük operasyonlarında güvenilir ve tekrarlanabilir web verisine ihtiyaç duyan şirketler için idealdir.

10. BeautifulSoup

, HTML ve XML ayrıştırmak için klasik bir Python kütüphanesidir. Tam bir crawler olmasa da, geliştiriciler tarafından küçük ölçekli ve özel scraping projeleri için çok sevilir.

, HTML ve XML ayrıştırmak için klasik bir Python kütüphanesidir. Tam bir crawler olmasa da, geliştiriciler tarafından küçük ölçekli ve özel scraping projeleri için çok sevilir.

- Basit HTML Ayrıştırma: Statik web sayfalarından kolayca veri çıkar.

- Python Requests ile Çalışır: Veri çekme ve tarama için diğer kütüphanelerle birleştirilebilir.

- Esnek & Hafif: Hızlı betikler veya eğitim projeleri için idealdir.

- Geniş Topluluk: Bolca eğitim ve Stack Overflow desteği var.

BeautifulSoup , ama kod yazman ve tarama mantığını kendin oluşturman gerekir. Geliştiriciler veya scraping’in temellerini öğrenmek isteyenler için uygundur.

Karşılaştırma Tablosu: Veri Toplama Araçları Genel Bakış

| Araç | Kullanım Kolaylığı | Otomasyon Seviyesi | Fiyatlandırma | Dışa Aktarım Seçenekleri | En Uygun Kullanıcılar |

|---|---|---|---|---|---|

| Thunderbit | Çok kolay, kodsuz | Yüksek (AI, alt sayfa) | Ücretsiz deneme, 15$/ay’dan | Excel, Sheets, Airtable, Notion, CSV | Satış, pazarlama, e-ticaret, kod bilmeyenler |

| Octoparse | Orta, görsel arayüz | Çok yüksek, bulut | Ücretsiz, 83–299$/ay | CSV, Excel, JSON, API | Kurumlar, veri ekipleri, dinamik siteler |

| Scrapy | Düşük (Python gerek) | Yüksek (özelleştirilebilir) | Ücretsiz, açık kaynak | Her türlü (kod ile) | Geliştiriciler, büyük ölçekli özel projeler |

| ParseHub | Yüksek, görsel | Yüksek (dinamik siteler) | Ücretsiz, 189$/ay’dan | CSV, Excel, JSON, API | Kod bilmeyenler, karmaşık web yapıları |

| Apify | Orta, esnek | Çok yüksek, bulut | Ücretsiz, 29–999$/ay | CSV, JSON, API, bulut depolama | Geliştiriciler, işletmeler, hazır veya özel actor |

| Data Miner | Çok kolay, tarayıcı | Düşük (manuel) | Ücretsiz, 20–99$/ay | CSV, Excel | Hızlı, tek seferlik çekimler, küçük veri setleri |

| Import.io | Orta, yönetilen | Çok yüksek, kurumsal | Özel, hacme göre | CSV, JSON, API, doğrudan entegrasyon | Kurumlar, sürekli veri entegrasyonu |

| WebHarvy | Yüksek, masaüstü | Orta (zamanlama) | 129$ tek sefer | Excel, CSV, XML, JSON, SQL | KOBİ’ler, Windows kullanıcıları, düzenli scraping |

| Mozenda | Orta, görsel | Çok yüksek, bulut | 250–450$+/ay | CSV, Excel, JSON, bulut, VT | Sürekli, büyük ölçekli iş operasyonları |

| BeautifulSoup | Düşük (Python gerek) | Düşük (manuel kodlama) | Ücretsiz, açık kaynak | Her türlü (kod ile) | Geliştiriciler, öğrenenler, küçük özel betikler |

Ekibiniz İçin Doğru Veri Toplama Aracını Nasıl Seçersiniz?

En iyi veri toplama aracını seçmek, “en güçlüsünü” bulmak değil—ekibinin becerilerine, ihtiyaçlarına ve bütçesine en uygun olanı bulmak demektir. Kısa önerilerim:

- Kod bilmeyenler veya iş kullanıcıları: Thunderbit, ParseHub veya Data Miner ile anında sonuç ve kolay kurulum elde edebilirsin.

- Kurumsal veya büyük ölçekli ihtiyaçlar: Octoparse, Mozenda veya Import.io otomasyon, zamanlama ve destek sunar.

- Geliştiriciler veya özel projeler: Scrapy, Apify veya BeautifulSoup tam kontrol ve esneklik sağlar.

- Bütçe dostu veya tek seferlik işler: WebHarvy (Windows) veya Data Miner (tarayıcı) ekonomik ve pratiktir.

Her zaman favori araçlarını gerçek hedef sitelerinde ücretsiz deneme ile test et—bir sitede çalışan, diğerinde çalışmayabilir. Ayrıca entegrasyon ihtiyacını unutma: Verini Sheets, Notion veya bir veritabanına aktarman gerekiyorsa, aracın bunu desteklediğinden emin ol.

Sonuç: En İyi Veri Toplama Araçlarıyla İşini Güçlendir

Web verisi artık yeni petrol; ama onu çıkarmak ve işlemek için doğru makinelere ihtiyacın var. Modern veri toplama araçları sayesinde saatler süren manuel araştırmayı dakikalar içinde otomatik içgörüye dönüştürebilirsin—daha akıllı satışlar, daha etkili pazarlama ve daha çevik operasyonlar için. İster potansiyel müşteri listeleri oluştur, ister rakipleri takip et, ister kopyala-yapıştırdan bıkmış ol, bu listedeki araçlardan biri işini çok daha kolaylaştıracak.

Ekibinin ihtiyaçlarını gözden geçir, birkaç aracı dene ve otomasyonun yükünü ne kadar hafiflettiğini gör. Eğer yapay zeka destekli, 2 tıkla veri çekmenin nasıl bir şey olduğunu merak ediyorsan, . Keyifli veri toplamalar—verin her zaman taze, düzenli ve kullanıma hazır olsun.

Sıkça Sorulan Sorular

1. Veri toplama aracı nedir ve neden ihtiyacım var?

Veri toplama aracı, web sitelerinden bilgi çekme sürecini otomatikleştirir. Zaman kazandırır, hataları azaltır ve satış, pazarlama, araştırma ve operasyonlar için güncel verileri manuel kopyala-yapıştırdan çok daha verimli şekilde toplamanı sağlar.

2. Teknik bilgisi olmayanlar için en iyi veri toplama aracı hangisi?

Thunderbit, ParseHub ve Data Miner kod bilmeyenler için en iyi seçeneklerdir. Thunderbit, 2 tıkla yapay zeka destekli akışıyla öne çıkarken, ParseHub daha karmaşık siteler için görsel bir yaklaşım sunar.

3. Veri toplama araçlarında fiyatlandırma modelleri nasıl farklılık gösterir?

Fiyatlar çok değişkendir: Thunderbit ve Data Miner gibi araçlar ücretsiz planlar ve uygun aylık paketler sunarken, Import.io ve Mozenda gibi kurumsal platformlar özel veya hacme dayalı fiyatlandırma uygular. Aracın maliyetinin veri ihtiyacına uygun olup olmadığını mutlaka kontrol et.

4. Bu araçlarla düzenli, zamanlanmış veri çekimi yapabilir miyim?

Evet—Thunderbit, Octoparse, Apify, Mozenda ve Import.io gibi araçlar zamanlanmış veya tekrarlayan veri çekimini destekler; bu da fiyat takibi, müşteri bulma veya pazar araştırması gibi sürekli işler için idealdir.

5. Veri toplama aracı seçerken nelere dikkat etmeliyim?

Ekibinin teknik becerileri, çekmek istediğin sitelerin karmaşıklığı, veri hacmi, entegrasyon ihtiyaçları ve bütçeni göz önünde bulundur. Ücretli bir plana geçmeden önce gerçek işlerinizde birkaç aracı test et.

Daha fazla rehber ve pratik ipucu için göz atabilirsin.

Daha Fazla Bilgi