Il web di oggi è diventato un vero e proprio caos—ma anche una miniera di opportunità—rispetto ai tempi in cui bastava un semplice “tasto destro, salva con nome” per portarsi a casa quello che serviva. Oggi i siti sono dei veri labirinti: tra contenuti che si aggiornano al volo, link nascosti, pop-up che spuntano ovunque e menu a più livelli, raccogliere dati non è più una passeggiata. Se hai mai provato a tirare fuori tutti i dati di prodotto da un e-commerce moderno o a recuperare ogni annuncio da un portale immobiliare, sai già che gli estrattori web classici non bastano più. Ed è qui che entrano in scena i deep crawler: strumenti di nuova generazione pensati per andare a fondo, esplorare ogni angolo e restituire solo le informazioni che davvero contano.

Ma cosa sono esattamente i deep crawler? Perché stanno conquistando aziende di ogni settore, dal commerciale al marketing? E come fa uno strumento come a rendere il deep crawling facile come bere un bicchier d’acqua, anche per chi non ha mai scritto una riga di codice? Scopriamo insieme le basi, l’impatto sul business e perché i deep crawler stanno diventando l’asso nella manica per chi vuole davvero sfruttare i dati online.

Cos'è un Deep Crawler? Le Basi da Sapere

In parole semplici, un deep crawler è un tipo di estrattore web super specializzato, pensato per navigare e raccogliere dati da siti complessi, pieni di livelli e spesso ricchi di contenuti che si aggiornano dinamicamente. Diversamente dai crawler tradizionali—che si limitano a prendere quello che vedono sulla pagina principale—un deep crawler segue i link, si infila nei menu e nelle sottosezioni, gestisce pagine che si aggiornano e recupera anche i dati nascosti dietro tab o sezioni che si aprono solo dopo un click.

Immagina un crawler classico come qualcuno che entra in biblioteca e si limita a leggere i titoli sugli scaffali vicino all’ingresso. Un deep crawler, invece, è quello che si addentra tra i corridoi, sfoglia ogni libro, legge le note a piè di pagina e magari sbircia pure dietro la porta “Solo personale” (sempre che non sia chiusa a chiave).

Nel mondo dell’estrazione dati, questo significa che un deep crawler può:

- Navigare tra più livelli di un sito (categorie, sottocategorie, pagine di dettaglio)

- Estrarre contenuti dinamici caricati con JavaScript o nascosti dietro interazioni dell’utente

- Gestire paginazioni complesse e scroll infiniti

- Seguire i link interni per non lasciarsi sfuggire nessuna informazione importante

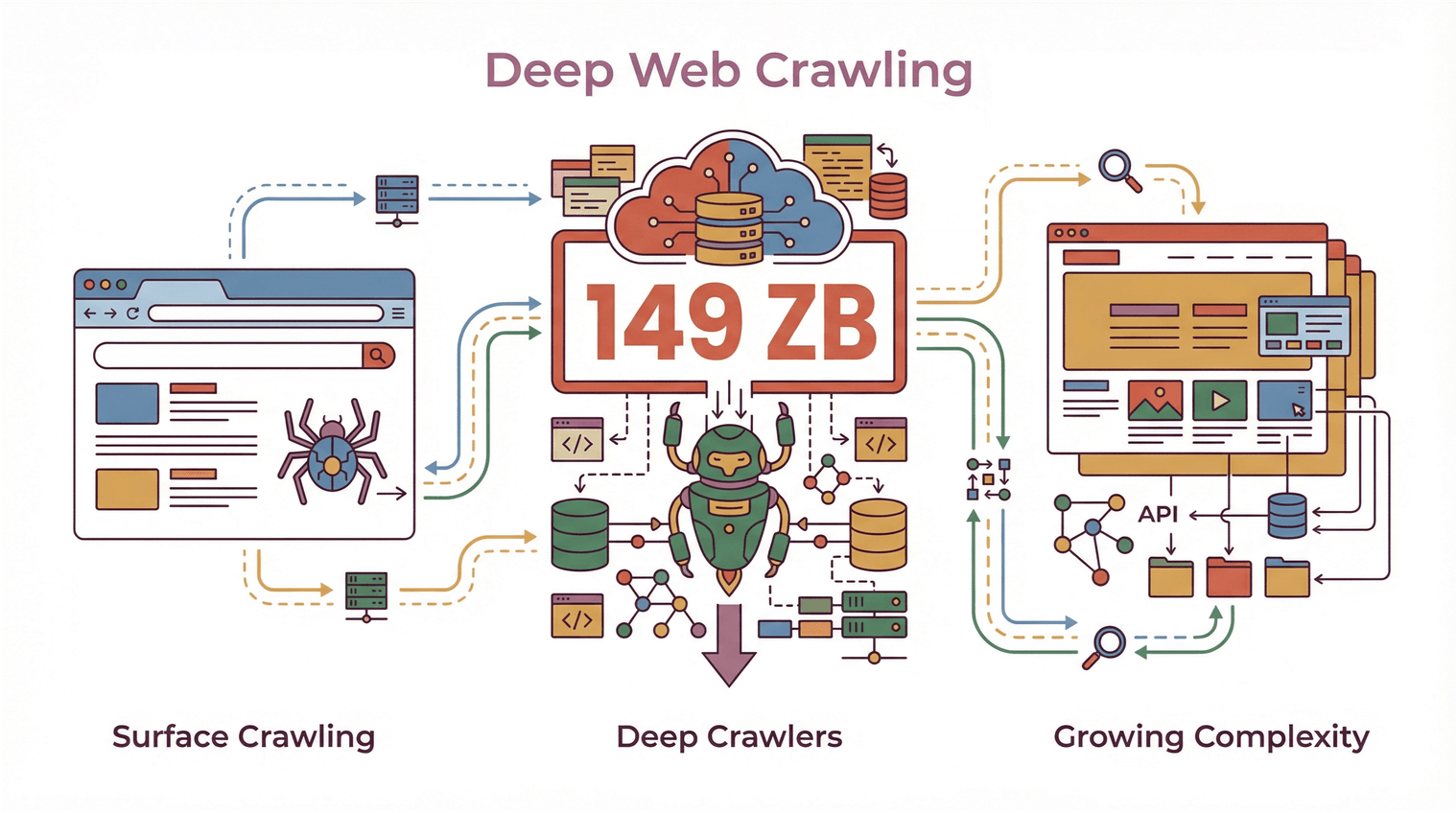

Con il volume dei dati web che ha toccato i e la complessità dei siti che cresce a vista d’occhio, i deep crawler sono ormai indispensabili per chi vuole andare oltre la semplice superficie.

Con il volume dei dati web che ha toccato i e la complessità dei siti che cresce a vista d’occhio, i deep crawler sono ormai indispensabili per chi vuole andare oltre la semplice superficie.

Deep Crawler vs. Crawler Tradizionale: Le Differenze Che Contano

Vediamo nel concreto: cosa rende davvero diverso un deep crawler rispetto ai “normali” crawler di cui magari hai già sentito parlare?

Crawler Tradizionali: Solo la Superficie

I crawler tradizionali (detti anche “shallow crawler”) puntano tutto su velocità e quantità. Sono perfetti per scansionare rapidamente un sito, raccogliere quello che c’è sulle pagine principali e passare oltre. È il metodo usato dai motori di ricerca: vogliono indicizzare più pagine possibile, il più in fretta possibile, ma non vanno a fondo in ogni sezione.

I limiti dei crawler tradizionali:

- Spesso saltano dati nascosti dietro menu, tab o elementi dinamici

- Fanno fatica con siti pieni di JavaScript o contenuti che si caricano dopo l’apertura della pagina

- Non gestiscono navigazioni a più passaggi o strutture complicate

- Rischiano di restituire dataset incompleti o frammentari

Deep Crawler: Oltre la Superficie

Un deep crawler, invece, è pensato per andare a fondo: segue ogni link utile, attraversa liste paginabili, estrae dati da sottopagine, pop-up e contenuti che si caricano solo dopo un’interazione. Qui la priorità non è la velocità, ma la completezza e la precisione.

Le caratteristiche chiave dei deep crawler:

- Navigazione avanzata: Segue i link in modo ricorsivo, gestisce strutture a più livelli e evita pagine duplicate o senza uscita ().

- Estrazione di contenuti dinamici: Interagisce con JavaScript, espande sezioni nascoste ed estrae dati che compaiono solo dopo azioni dell’utente ().

- Efficienza migliorata: Si concentra sulle aree che contano davvero, riducendo dati doppi o inutili e assicurando che nulla di importante venga perso ().

- Completezza dei dati: Raccoglie tutte le informazioni—dalle liste principali alle pagine di dettaglio e documenti collegati—in un colpo solo.

Se hai mai provato a estrarre tutte le recensioni da una pagina prodotto, o a raccogliere ogni annuncio da un portale immobiliare (compresi i dati dell’agente su una sottopagina), avrai sicuramente sbattuto contro i limiti dei crawler classici. Qui i deep crawler fanno davvero la differenza.

Come i Deep Crawler Raggiungono la Completezza dei Dati e una Navigazione Avanzata

Ma come funzionano, in pratica, i deep crawler? Tutto ruota attorno a seguire i link, navigare in modo ricorsivo e gestire i contenuti dinamici.

Estrazione da Sottopagine e Navigazione Multi-Livello

Un deep crawler non si ferma alla prima pagina. Ecco come si muove:

- Individua i link interni (tipo “Vedi dettagli”, “Pagina successiva” o “Mostra altro”)

- Segue questi link verso sottopagine, viste di dettaglio o anche pop-up

- Estrae i dati da ogni livello, unendo tutto in un unico dataset ordinato

Questo metodo, chiamato anche “crawling ricorsivo” o “estrazione multi-livello”, è perfetto per siti dove le informazioni sono sparse su più pagine—ad esempio, annunci con dettagli su pagine separate o directory dove i contatti si trovano solo dopo aver cliccato.

Gestione di Paginazione e Contenuti Dinamici

I siti moderni spesso nascondono i dati dietro pulsanti “Carica altro”, scroll infiniti o tab gestiti da JavaScript. I deep crawler sono pensati per:

- Riconoscere e interagire con i controlli di paginazione

- Scorrere o cliccare su elementi dinamici

- Aspettare che i contenuti si carichino prima di estrarre i dati

Così ottieni un dataset completo, non solo quello che era visibile al primo caricamento della pagina ().

Tracciamento dei Link e Estrazione Multi-Livello

Uno degli aspetti più delicati del deep crawling è non perdere dati nascosti o annidati. I deep crawler usano algoritmi per:

- Tenere traccia dei link già visitati (così eviti duplicati o giri a vuoto)

- Dare priorità alle pagine importanti (come viste di dettaglio o documenti scaricabili)

- Gestire casi particolari (pop-up, sezioni espandibili, contenuti caricati via AJAX)

Questo è fondamentale soprattutto in ambito business: perdere anche solo un contatto o una specifica di prodotto può significare occasioni perse o analisi incomplete ().

Thunderbit: Deep Crawling Semplificato con l’AI

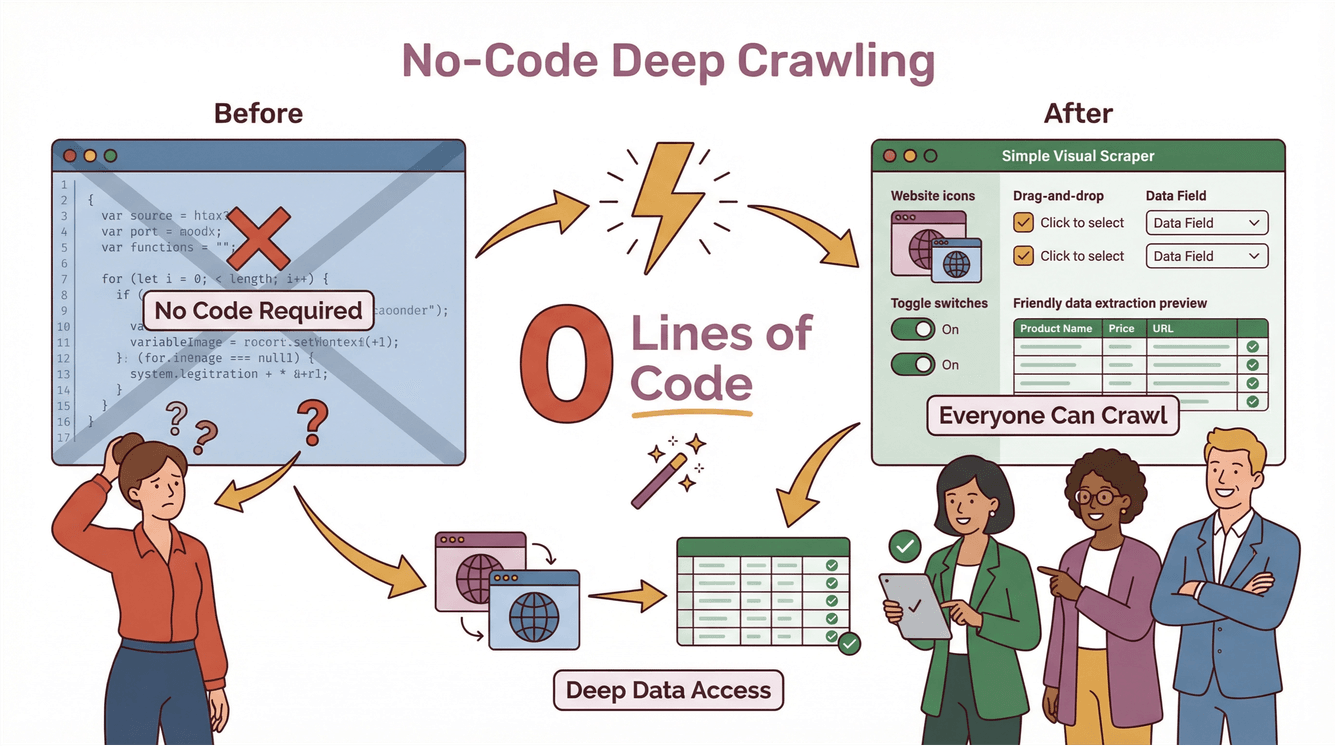

Fino a poco tempo fa, il deep crawling era roba da sviluppatori e data engineer. Bisognava scrivere script su misura, gestire casi particolari e aggiornare il codice ogni volta che un sito cambiava. Con , invece, il deep crawling diventa alla portata di tutti—anche di chi non ha mai programmato.

Le Funzionalità Deep Crawler di Thunderbit in Pratica

Ecco come Thunderbit rende il deep crawling davvero semplice:

- AI Suggerisci Campi: Basta cliccare su “AI Suggerisci Campi” e l’AI di Thunderbit analizza la pagina, suggerisce le colonne migliori da estrarre e crea prompt per ogni campo.

- Estrazione da Sottopagine: Vuoi più dettagli? Thunderbit può visitare automaticamente ogni sottopagina (come dettagli prodotto, profili agenti o tab recensioni) e arricchire la tua tabella con dati aggiuntivi.

- Gestione dei Contenuti Dinamici: Thunderbit interagisce con paginazione, scroll infiniti ed elementi dinamici—senza bisogno di configurazioni manuali.

- No-Code, Due Passaggi: Descrivi cosa ti serve, clicca su “Estrai” e Thunderbit fa tutto il resto. Puoi esportare i dati direttamente su Excel, Google Sheets, Notion o Airtable—senza costi extra o limiti ().

Esempio Pratico: Deep Crawling con Thunderbit

Mettiamo che tu voglia estrarre tutti gli annunci immobiliari da un sito, compresi i contatti degli agenti nascosti nelle sottopagine:

- Apri la pagina degli annunci su Chrome.

- Clicca sull’estensione Thunderbit.

- Usa “AI Suggerisci Campi” per far suggerire a Thunderbit colonne come “Titolo annuncio”, “Prezzo”, “Indirizzo” e “Link agente”.

- Clicca su “Estrai”. Thunderbit raccoglie tutti gli annunci principali.

- Clicca su “Estrai Sottopagine”. Thunderbit visita ogni profilo agente, recupera numeri di telefono, email e altro, e unisce tutto nella tabella principale.

- Esporta i dati su Google Sheets o Excel—pronti per il tuo team commerciale o operativo.

Nessun codice, nessun template, nessun mal di testa. E se il sito cambia, l’AI di Thunderbit si adatta da sola ().

Vantaggi per il Business: Come i Deep Crawler Cambiano le Regole per Vendite e Marketing

Ok, i deep crawler sono interessanti—ma che vantaggio portano davvero al business? Ecco dove fanno la differenza.

Scopri Nuove Opportunità su E-commerce, Immobiliare e Siti Competitor

Per i team commerciali e marketing, i deep crawler sono una vera miniera d’oro. Permettono di:

- Estrarre ogni prodotto, prezzo e recensione da siti e-commerce—anche se i dati sono nascosti dietro più livelli o tab

- Aggregare annunci immobiliari (inclusi dettagli e contatti degli agenti nascosti)

- Monitorare i siti dei competitor per nuovi prodotti, cambi di prezzo o tendenze di mercato ()

- Costruire liste di lead più ricche raccogliendo contatti da directory, eventi o portali di nicchia

Con il deep crawling non ottieni solo più dati—ma dati migliori e più utili per guidare davvero le tue strategie.

Deep Scraping per l’Intelligence Competitiva

Immagina che il tuo team commerciale voglia puntare su aziende che hanno appena lanciato un nuovo prodotto. Un deep crawler può:

- Scansionare i siti dei competitor per nuove pagine prodotto

- Seguire i link verso comunicati stampa o aggiornamenti per investitori

- Estrarre dettagli chiave (date di lancio, prezzi, caratteristiche)

- Importare questi dati nel tuo CRM o strumenti di analisi

Il risultato? Decisioni più rapide e intelligenti—e un vantaggio concreto rispetto a chi si limita a una raccolta superficiale.

Compliance e Best Practice: Cosa Tenere a Mente Quando Usi un Deep Crawler

Un grande potere di crawling comporta anche grandi responsabilità. I deep crawler possono accedere a tantissimi dati—ma non vuol dire che sia sempre giusto raccoglierli tutti. Ecco cosa ricordare:

Privacy dei Dati e Copyright

- Rispetta i termini di servizio dei siti: Molti siti specificano cosa è permesso nei loro TOS. Ignorarli può portare a problemi legali ().

- Evita di estrarre dati personali o riservati senza autorizzazione esplicita.

- Attenzione al copyright: Non ripubblicare o vendere contenuti estratti senza aver verificato i diritti.

Crawling Responsabile

- Modera le richieste: Non sovraccaricare i siti con troppe richieste tutte insieme.

- Controlla il robots.txt: Anche se non è legge, è buona norma rispettare le preferenze di crawling dei siti.

- Tieniti aggiornato sulle normative: Regolamenti come GDPR e CCPA possono influire su quali dati puoi raccogliere e come li usi ().

Per saperne di più, leggi .

Come Scegliere il Deep Crawler Giusto per la Tua Azienda

Come scegliere il deep crawler più adatto? Ecco cosa conta davvero:

- Facilità d’uso: Anche chi non è tecnico può configurarlo in pochi minuti? (Thunderbit: sì.)

- Scalabilità: Gestisce siti grandi, tante pagine e contenuti dinamici?

- Strumenti per la compliance: Aiuta a restare in regola con le normative?

- Integrazione: Puoi esportare i dati nei tool che già usi (Excel, Sheets, Notion, Airtable)?

- Manutenzione: Si adatta automaticamente ai cambiamenti dei siti o dovrai correggere script ogni settimana?

Thunderbit è stato pensato proprio per questo. È scelto da , dai freelance alle grandi aziende, e ha prezzi accessibili anche per le piccole imprese: si parte da soli 15$/mese.

In Sintesi: Il Futuro del Deep Crawling nella Strategia Dati Aziendale

Ecco i punti chiave:

- I deep crawler sono indispensabili per estrarre dati completi e precisi dai siti moderni, sempre più complessi e dinamici.

- Vanno oltre i crawler tradizionali gestendo navigazione multi-livello, contenuti dinamici e dati nascosti.

- I team aziendali usano i deep crawler per ottenere insight, aumentare le vendite, monitorare i competitor e prendere decisioni più rapide.

- La compliance è fondamentale: Estrai dati in modo responsabile, rispetta la privacy e le regole.

- Thunderbit rende il deep crawling accessibile a tutti, grazie a funzionalità AI, interfaccia no-code ed esportazione dati senza limiti.

Se vuoi andare oltre la semplice estrazione superficiale e iniziare a scavare davvero a fondo, e scopri quanto può essere facile il deep crawling. Per altri consigli, visita il per guide, best practice e tutte le novità sull’estrazione dati con l’AI.

Domande Frequenti

1. Cos’è un deep crawler e in cosa si differenzia da un normale estrattore web?

Un deep crawler è uno strumento per l’estrazione dati pensato per navigare tra più livelli di un sito, recuperando informazioni da sottopagine, contenuti dinamici e sezioni nascoste. A differenza dei crawler tradizionali, che si fermano alla superficie, i deep crawler garantiscono una raccolta dati completa seguendo i link e gestendo strutture complesse.

2. Perché le aziende hanno bisogno dei deep crawler nel 2025?

I siti web sono sempre più intricati, con dati spesso nascosti dietro menu, tab o elementi dinamici. I deep crawler aiutano le aziende a estrarre dataset completi per vendite, marketing, ricerca e analisi competitiva—cosa che i crawler di base non possono fare.

3. Come Thunderbit semplifica il deep crawling per chi non è tecnico?

Thunderbit usa l’AI per suggerire i campi, gestire l’estrazione da sottopagine e i contenuti dinamici—tutto tramite un’interfaccia semplice e senza codice. Basta descrivere ciò che serve, cliccare su “Estrai” ed esportare i risultati nei propri strumenti preferiti.

4. Quali aspetti di compliance devo considerare usando un deep crawler?

Rispetta sempre i termini di servizio dei siti, evita di estrarre dati personali o riservati senza permesso e resta aggiornato sulle normative privacy come GDPR e CCPA. Un uso responsabile dei dati è fondamentale per ridurre i rischi legali.

5. I deep crawler possono aiutare il mio team commerciale e marketing a ottenere risultati migliori?

Assolutamente sì. I deep crawler permettono di accedere a dati più ricchi e utili da e-commerce, portali immobiliari e siti dei competitor—alimentando la generazione di lead, l’analisi di mercato e decisioni più rapide. Con strumenti come Thunderbit, anche i team non tecnici possono ottenere gli insight necessari per crescere.

Scopri di più