Ti sei mai domandato come fanno le aziende a trasformare una valanga di dati grezzi e sparsi in dashboard chiare e analisi AI che sembrano quasi magiche? Tranquillo, non sei l’unico! Il segreto sta tutto nella data ingestion: l’eroe silenzioso che mette in moto ogni progetto data-driven. In un mondo dove si stima che nel 2025 produrremo (sì, sono 21 zeri!), riuscire a spostare i dati dal punto A al punto B — in modo veloce, preciso e in un formato subito utilizzabile — è diventato più importante che mai.

Dopo anni passati nel mondo SaaS e dell’automazione, ho visto con i miei occhi quanto una strategia di data ingestion ben fatta possa cambiare le carte in tavola per un’azienda. Che tu stia gestendo lead, monitorando trend di mercato o semplicemente cercando di ottimizzare i processi, capire il significato di data ingestion (e come si sta evolvendo) è il primo passo per ottenere vero valore dai dati. Scopriamo insieme: cos’è la data ingestion, perché è così fondamentale e come strumenti moderni — come — stanno rivoluzionando il settore per analisti, imprenditori e non solo.

Cos’è la Data Ingestion? Il Fondamento di Ogni Azienda Data-Driven

In parole semplici, la data ingestion è il processo con cui si raccolgono, importano e caricano dati da più fonti in un sistema centrale — che sia un database, un data warehouse o un data lake — per poi analizzarli, visualizzarli o usarli per prendere decisioni. Immaginala come la “porta d’ingresso” della tua pipeline dati: è il modo in cui porti tutte le materie prime (fogli Excel, API, log, pagine web, sensori) nella tua cucina prima di iniziare a cucinare insight.

La data ingestion è la prima tappa di qualsiasi pipeline dati (), abbatte i silos e garantisce che dati freschi e di qualità siano sempre disponibili per analisi, business intelligence e machine learning. Senza di lei, le informazioni restano bloccate in sistemi isolati — “invisibili a chi ne ha bisogno”, come dicono gli esperti.

Ecco come si incastra nel puzzle:

- Data ingestion: Raccoglie dati grezzi da varie fonti e li porta in un repository centrale.

- Data integration: Unisce e allinea i dati da fonti diverse, rendendoli coerenti.

- Data transformation: Pulisce, formatta e arricchisce i dati per renderli pronti all’analisi.

Pensa alla ingestion come al trasporto di tutte le tue spese a casa dai negozi. L’integrazione è l’organizzazione in dispensa, la trasformazione è la preparazione e la cottura del pranzo.

Perché la Data Ingestion è Così Importante Oggi

Diciamolo chiaramente: avere dati aggiornati e ben gestiti è un vero superpotere. Le aziende che sanno padroneggiare la data ingestion abbattono i silos, ottengono insight in tempo reale e prendono decisioni più rapide e informate. Al contrario, una cattiva ingestione porta a report lenti, occasioni perse e decisioni basate su dati vecchi o incompleti.

Ecco qualche esempio concreto di come una data ingestion efficiente fa la differenza:

| Caso d'Uso | Come Aiuta una Data Ingestion Efficiente |

|---|---|

| Generazione Lead Commerciali | Unifica i lead da form web, social e database in un unico sistema quasi in tempo reale, permettendo ai team di vendita di rispondere più velocemente e aumentare i tassi di conversione. |

| Dashboard Operative | Alimenta costantemente i dati dai sistemi produttivi alle piattaforme di analisi, offrendo KPI aggiornati e consentendo azioni correttive rapide. |

| Vista Cliente a 360° | Integra dati da CRM, supporto, e-commerce e social per creare profili unificati utili a marketing personalizzato e servizio proattivo (Cake.ai). |

| Manutenzione Predittiva | Ingesta grandi volumi di dati da sensori e IoT, permettendo ai modelli analitici di rilevare anomalie e prevedere guasti prima che si verifichino, riducendo i fermi e i costi. |

| Analisi del Rischio Finanziario | Flussi di dati transazionali e di mercato alimentano i modelli di rischio, offrendo a banche e trader una visione in tempo reale delle esposizioni e consentendo il rilevamento istantaneo delle frodi. |

E i numeri parlano chiaro: , ma questi investimenti portano risultati solo se i dati vengono davvero raccolti e resi affidabili.

Data Ingestion, Data Integration e Data Transformation: Facciamo un po’ di Chiarezza

Facile confondersi tra questi termini — mettiamo ordine:

- Data Ingestion: Il primo step, raccogliere e importare dati grezzi dai sistemi di origine. Pensa: “Porta tutto in cucina.”

- Data Integration: Unire e allineare dati da fonti diverse, per una visione unica e coerente. Pensa: “Organizza la dispensa.”

- Data Transformation: Convertire i dati da grezzi a utilizzabili — pulizia, formattazione, aggregazione e arricchimento. Pensa: “Prepara e cucina il pranzo.”

Un errore comune è pensare che ingestion ed ETL (Extract, Transform, Load) siano la stessa cosa. In realtà, l’ingestion è solo la parte di “estrazione” — cioè il prelievo dei dati grezzi. Integrazione e trasformazione vengono dopo, per rendere i dati pronti all’analisi ().

Perché è importante? Se ti serve solo un dataset veloce da una pagina web, può bastare uno strumento di ingestion leggero. Ma se devi combinare e pulire dati da più sistemi, servono anche integrazione e trasformazione.

I Metodi Classici di Data Ingestion: ETL e i Suoi Limiti

Per anni, il metodo standard per la data ingestion è stato l’ETL (Extract, Transform, Load). Gli ingegneri dati scrivevano script o usavano software specializzati per estrarre periodicamente i dati dalle fonti, pulirli e caricarli in un data warehouse. Tutto spesso in modalità batch — aggiornamenti notturni, ad esempio.

Ma con l’esplosione dei dati per volume e varietà, l’ETL tradizionale ha iniziato a mostrare la corda:

- Setup Lento e Complesso: Costruire e mantenere pipeline ETL richiedeva tanto codice e competenze tecniche. I team non tecnici dovevano aspettare l’IT ().

- Collo di Bottiglia nei Processi Batch: I job ETL giravano a lotti, ritardando la disponibilità dei dati. Oggi, dove servono insight immediati, aspettare ore o giorni non è più accettabile ().

- Problemi di Scalabilità e Velocità: Le pipeline legacy spesso faticano con i volumi attuali, richiedendo continui aggiustamenti.

- Rigidità: Aggiungere nuove fonti o cambiare lo schema era complicato e rischiava di rompere la pipeline.

- Manutenzione Alta: Le pipeline potevano fallire per mille motivi, richiedendo costante attenzione degli ingegneri.

- Limitato ai Dati Strutturati: L’ETL classico era pensato per dati ordinati — non per quelli destrutturati (come pagine web o immagini) che oggi rappresentano .

In breve: l’ETL era perfetto per un’epoca più semplice, ma oggi fatica a stare al passo con la velocità, la scala e la varietà dei dati moderni.

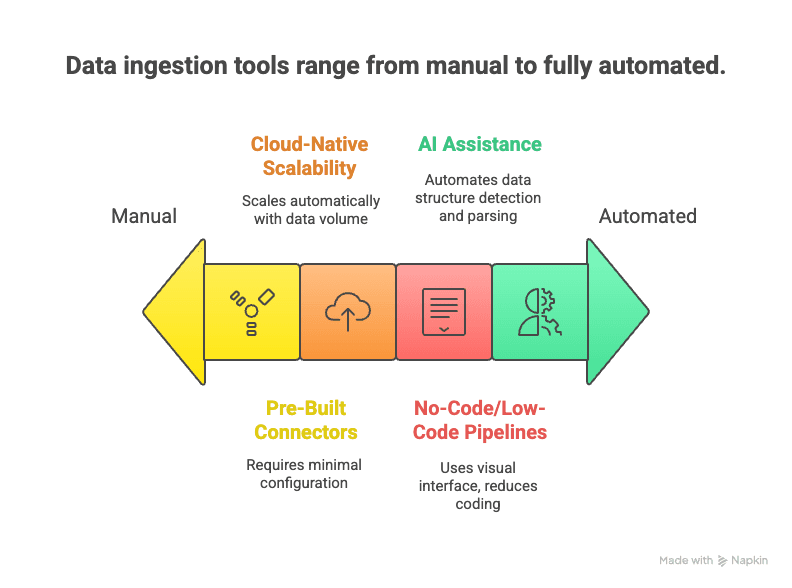

L’Evoluzione della Data Ingestion: Soluzioni Moderne, AI e Automazione

Siamo entrati in una nuova era: strumenti di data ingestion moderni che sfruttano automazione, cloud e intelligenza artificiale per rendere la raccolta dati più veloce, semplice e flessibile.

Cosa cambia davvero?

- Pipeline No-Code/Low-Code: Interfacce drag-and-drop e assistenti AI permettono di configurare i flussi dati senza scrivere codice ().

- Connettori Preconfigurati: Centinaia di connettori già pronti per le fonti più diffuse — basta inserire le credenziali e si parte.

- Scalabilità Cloud-Native: Servizi elastici in cloud gestiscono flussi di dati enormi in tempo reale ().

- Supporto Real-Time e Streaming: I tool moderni gestiscono sia ingestion batch che streaming, così puoi scegliere ciò che serve ().

- Assistenza AI: L’AI può riconoscere automaticamente le strutture dati, suggerire regole di parsing e persino controllare la qualità dei dati in tempo reale ().

- Gestione Dati Non Strutturati: Tecniche NLP e computer vision trasformano pagine web, PDF o immagini in tabelle strutturate.

- Manutenzione Ridotta: I servizi gestiti si occupano di monitoraggio, scalabilità e aggiornamenti — così puoi concentrarti sull’uso dei dati, non sulla pipeline.

Il risultato? Data ingestion più rapida da configurare, facile da modificare e capace di gestire la complessità dei dati di oggi.

Data Ingestion nella Pratica: Applicazioni e Sfide nei Settori

Vediamo come la data ingestion si applica davvero e quali ostacoli si incontrano nei vari settori.

Retail & E-Commerce

I retailer raccolgono dati da POS, e-commerce, app fedeltà e sensori in negozio. Unendo transazioni, clickstream e log di magazzino, ottengono una visione aggiornata di scorte e trend di acquisto. La sfida? Gestire grandi volumi di dati in tempo reale (soprattutto nei picchi) e integrare fonti online e offline.

Finanza & Banche

Banche e società di trading ingestano flussi di dati da transazioni, mercati e interazioni clienti. L’ingestion in tempo reale è vitale per rilevare frodi e gestire i rischi. Ma con requisiti di sicurezza e compliance stringenti, ogni intoppo può avere conseguenze serie.

Tecnologia & Internet

Le aziende tech raccolgono enormi flussi di eventi in tempo reale (ogni click, like o condivisione) per analizzare i comportamenti e alimentare i motori di raccomandazione. La sfida è distinguere il segnale dal rumore, garantendo qualità e coerenza dei dati.

Sanità

Gli ospedali ingestano dati da cartelle cliniche elettroniche, laboratori e dispositivi medici per creare profili paziente unificati e abilitare analisi predittive. Le difficoltà principali? Interoperabilità tra sistemi diversi e tutela della privacy.

Real Estate

Le agenzie immobiliari raccolgono dati da portali, siti di annunci e registri pubblici per costruire database completi. La sfida è unire fonti spesso destrutturate e mantenere i dati aggiornati mentre gli annunci cambiano rapidamente.

Le sfide comuni includono:

- Gestione della varietà dei dati (strutturati, semi-strutturati, non strutturati)

- Equilibrio tra real-time e batch

- Garanzia di qualità e coerenza

- Rispetto di sicurezza e compliance

- Scalabilità per volumi crescenti

Superare questi ostacoli è fondamentale per ottenere analisi più accurate, decisioni in tempo reale e maggiore conformità normativa.

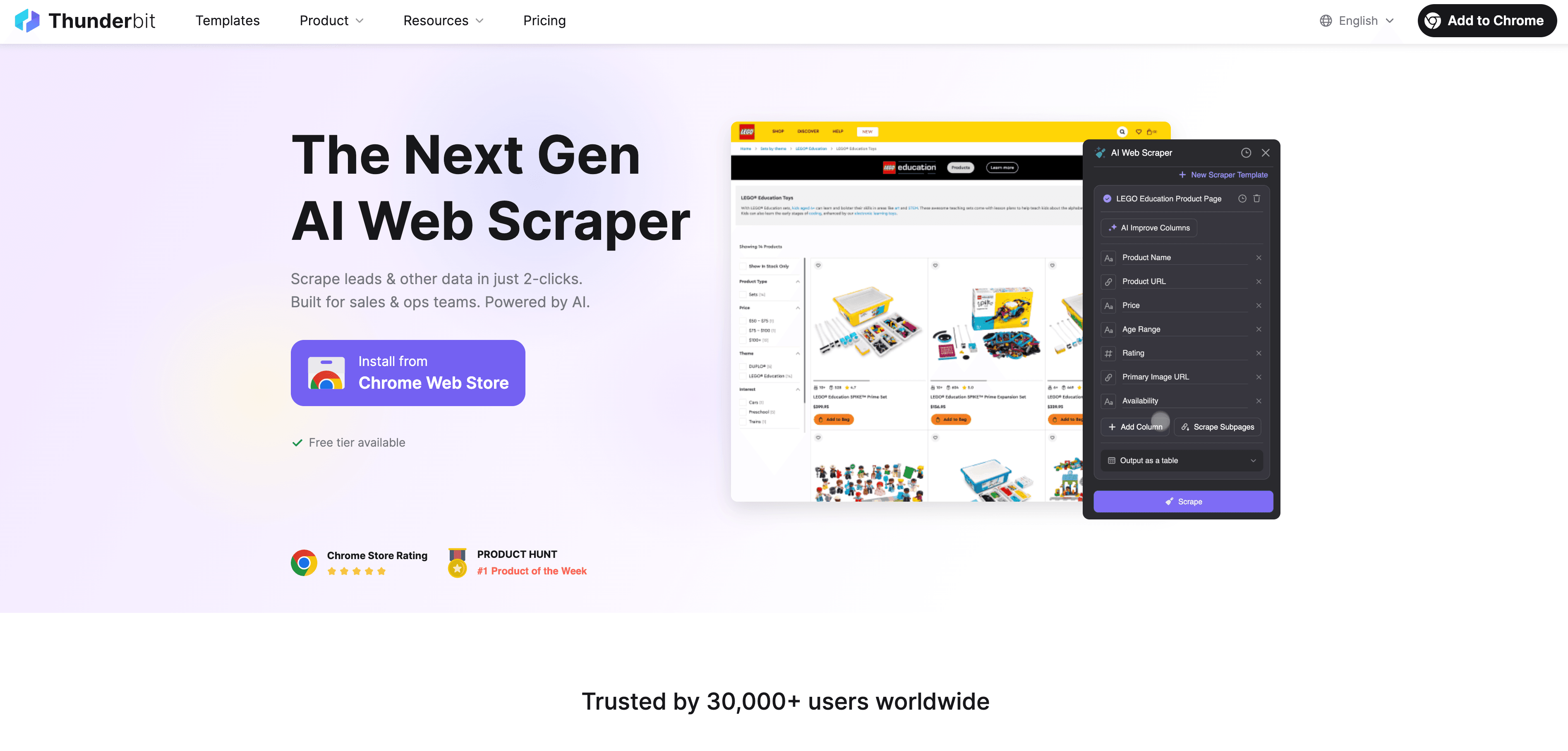

Thunderbit: Data Ingestion Semplificata con Estrattore Web AI

Ecco come Thunderbit si inserisce in questo scenario. è un’estensione Chrome di estrattore web AI pensata per rendere la data ingestion da web accessibile a tutti — anche a chi non sa programmare.

Perché Thunderbit è una svolta per chi lavora con i dati?

- Web Scraping in 2 Click: Da una pagina web caotica a un dataset ordinato in due click. Premi “AI Suggerisci Campi”, poi “Estrai” — fatto.

- Suggerimenti AI per i Campi: L’AI di Thunderbit legge la pagina e ti suggerisce le colonne migliori da estrarre, che tu sia su un elenco aziende, prodotti o profili LinkedIn.

- Estrazione Automatica da Sottopagine: Vuoi più dettagli? Thunderbit può visitare ogni sottopagina (es. dettagli prodotto o profili) e arricchire la tabella in automatico.

- Gestione della Paginazione: Supporta liste paginati e infinite scroll, così non perdi nessun dato.

- Template Preconfigurati: Per siti come Amazon, Zillow o Shopify, Thunderbit offre template 1-click — nessuna configurazione necessaria.

- Esportazione Gratuita dei Dati: Esporta direttamente su Excel, Google Sheets, Airtable o Notion — senza costi aggiuntivi.

- Estrazione Programmata: Imposta job di scraping automatici a intervalli regolari (es. monitoraggio prezzi concorrenti giornaliero).

- AI Autofill: Automatizza anche la compilazione di form e attività web ripetitive.

Thunderbit è perfetto per team commerciali che raccolgono lead, analisti e-commerce che monitorano prezzi o agenti immobiliari che aggregano annunci. L’obiettivo? Trasformare dati web destrutturati in insight utili — in tempi record.

Vuoi vedere Thunderbit in azione? Dai un’occhiata al nostro o esplora il per altre guide.

Confronto tra Soluzioni di Data Ingestion: Classiche vs Moderne

Ecco una panoramica comparativa:

| Criterio | Strumenti ETL Tradizionali | Strumenti Moderni AI/Cloud | Thunderbit (Estrattore Web AI) |

|---|---|---|---|

| Competenze Richieste | Alte (serve coding/IT) | Medie (low-code, un po’ di setup) | Basse (2 click, nessun codice) |

| Fonti Dati | Strutturate (database, CSV) | Ampie (database, SaaS, API) | Qualsiasi sito web, dati non strutturati |

| Velocità di Implementazione | Lenta (settimane/mesi) | Più veloce (giorni) | Immediata (minuti) |

| Supporto Real-Time | Limitato (batch) | Ottimo (streaming/batch) | On-demand & programmato |

| Scalabilità | Difficile | Alta (cloud-native) | Media/Alta (cloud scraping) |

| Manutenzione | Alta (pipeline fragili) | Media (servizi gestiti) | Bassa (AI si adatta ai cambiamenti) |

| Trasformazione | Rigida, upfront | Flessibile, post-caricamento | Base (prompt AI per i campi) |

| Miglior Utilizzo | Integrazione batch interna | Pipeline analitiche | Dati web, fonti esterne |

Morale: scegli lo strumento giusto per il lavoro. Per dati web o fonti destrutturate, Thunderbit è spesso la soluzione più rapida e semplice.

Il Futuro della Data Ingestion: Automazione e Cloud-First

Guardando avanti, la data ingestion sarà sempre più smart e automatizzata. Ecco cosa ci aspetta:

- Real-Time come Nuova Normalità: Il vecchio modello batch sta scomparendo. Sempre più pipeline sono progettate per dati in tempo reale, guidati da eventi ().

- Cloud-First e “Zero ETL”: Le piattaforme cloud semplificano la connessione tra fonti e destinazioni senza pipeline manuali.

- Automazione AI-Driven: Il machine learning avrà un ruolo sempre più centrale nella configurazione, monitoraggio e ottimizzazione delle pipeline — rilevando anomalie, correggendo errori e arricchendo i dati in tempo reale.

- No-Code e Self-Service: Sempre più strumenti permetteranno agli utenti business di configurare i flussi dati con linguaggio naturale o interfacce visuali.

- Ingestion Edge e IoT: Con la crescita dei dati generati all’edge, l’ingestion avverrà sempre più vicino alla fonte, con filtri e aggregazioni intelligenti.

- Governance e Metadata: Tagging automatico, tracciamento della provenienza e compliance saranno integrati in ogni fase.

In sintesi: il futuro punta a una data ingestion più veloce, accessibile e affidabile — così potrai concentrarti sugli insight, non sull’infrastruttura.

Conclusioni: Cosa Ricordare se Lavori con i Dati

- La data ingestion è il primo passo fondamentale per qualsiasi progetto data-driven. Se vuoi insight, devi prima raccogliere i dati — in modo rapido e affidabile.

- Strumenti moderni e AI come Thunderbit rendono la data ingestion accessibile a tutti, non solo agli esperti IT. Con scraping in 2 click, suggerimenti AI e job programmati, puoi trasformare dati web disordinati in valore per il business.

- Scegli lo strumento giusto: usa ETL tradizionale per dati interni stabili e strutturati; strumenti cloud moderni per analisi ampie; Thunderbit per dati web e fonti destrutturate.

- Resta aggiornato: automazione, cloud e AI stanno rendendo la data ingestion sempre più smart e semplice. Non restare indietro — esplora nuove soluzioni e rendi la tua strategia dati a prova di futuro.

Domande Frequenti

1. Cos’è la data ingestion, in parole semplici?

La data ingestion è il processo di raccolta e importazione di dati da varie fonti (come siti web, database o file) in un sistema centrale, così da poterli analizzare o usare per decisioni aziendali. È il primo passo di ogni pipeline dati.

2. In cosa differisce la data ingestion da integrazione e trasformazione dati?

La data ingestion serve a portare dentro i dati grezzi. L’integrazione li combina e allinea da fonti diverse, la trasformazione li pulisce e formatta per l’analisi. In breve: ingestion = raccogli, integration = organizza, transformation = prepara e cucina.

3. Quali sono le principali difficoltà dei metodi tradizionali di data ingestion?

I metodi classici come l’ETL sono lenti da configurare, richiedono molto codice, faticano con dati non strutturati e non sono adatti alle esigenze real-time di oggi. Inoltre, sono poco flessibili e richiedono molta manutenzione se cambiano le fonti.

4. Come semplifica Thunderbit la data ingestion?

Thunderbit usa l’AI per permettere a chiunque di estrarre e strutturare dati web in due click — senza bisogno di programmare. Gestisce sottopagine, paginazione e può programmare job ricorrenti, esportando direttamente su Excel, Google Sheets, Airtable o Notion.

5. Qual è il futuro della data ingestion?

Il futuro è fatto di automazione, strategie cloud-first e pipeline guidate dall’AI. Vedremo sempre più flussi dati in tempo reale, gestione intelligente degli errori e strumenti che permettono agli utenti business di configurare la data ingestion con linguaggio naturale o interfacce visuali.

Per Approfondire: