Il web è davvero una miniera d’oro di dati: che tu sia nel commerciale, nell’ecommerce o nella market research, estrarre dati online è la chiave per trovare nuovi clienti, monitorare prezzi e tenere d’occhio la concorrenza. Ma c’è un ostacolo: più aziende si buttano sullo scraping, più i siti si difendono con sistemi sempre più avanzati. Oggi, oltre , e sono ormai all’ordine del giorno. Se ti è mai capitato che il tuo script Python andasse alla grande per 20 minuti e poi solo errori 403, sai bene quanto sia snervante.

Dopo anni passati tra SaaS e automazione, ho visto progetti di scraping passare da “facilissimo” a “bloccato ovunque” in un attimo. Ecco perché voglio raccontarti come fare web scraping senza blocchi con Python: ti spiego le best practice, ti mostro esempi di codice e ti dico quando conviene affidarsi a soluzioni AI come . Che tu sia un ninja di Python o alle prime armi, qui trovi una vera cassetta degli attrezzi per estrarre dati senza farti bloccare.

Cosa Vuol Dire Fare Web Scraping Senza Blocchi con Python?

In pratica, fare web scraping senza blocchi significa raccogliere dati dai siti senza far scattare i loro sistemi anti-bot. In Python, non basta lanciare un semplice ciclo requests.get(): bisogna sapersi mimetizzare, imitare il comportamento degli utenti veri e anticipare i controlli.

Perché proprio Python? : è semplice, ha librerie potenti (requests, BeautifulSoup, Scrapy, Selenium) e si adatta a tutto, dal mini-script al crawler distribuito. Ma questa popolarità ha un prezzo: ormai molti sistemi anti-bot riconoscono subito i pattern tipici degli script Python.

Se vuoi estrarre dati in modo affidabile, devi andare oltre le basi. Serve capire come i siti scovano i bot e come puoi aggirare questi controlli—sempre rispettando le regole e la legge.

Perché Evitare i Blocchi è Cruciale nei Progetti di Web Scraping con Python

Essere bloccati non è solo una seccatura tecnica: può mandare all’aria interi processi aziendali. Ecco qualche esempio concreto:

| Caso d'Uso | Conseguenze del Blocco |

|---|---|

| Generazione Lead | Liste di potenziali clienti incomplete o obsolete, opportunità perse |

| Monitoraggio Prezzi | Cambiamenti dei prezzi dei concorrenti non rilevati, decisioni errate |

| Aggregazione Contenuti | Mancanza di notizie, recensioni o dati di ricerca |

| Analisi di Mercato | Dati parziali su competitor o settore |

| Annunci Immobiliari | Informazioni non aggiornate, occasioni perse |

Quando uno scraper viene bloccato, non perdi solo dati: sprechi tempo, rischi problemi di compliance e potresti prendere decisioni sbagliate su dati incompleti. In un mondo dove , l’affidabilità è tutto.

Come i Siti Web Riconoscono e Bloccano gli Estrattori Web Python

I siti sono diventati davvero bravi a scovare i bot. Ecco le difese anti-scraping più diffuse (, ):

- Blacklist degli IP: troppe richieste dallo stesso IP? Bloccato.

- Controllo User-Agent e Header: richieste con header generici o mancanti (tipo il classico

python-requests/2.25.1) fanno scattare l’allarme. - Limitazione della frequenza: troppe richieste in poco tempo = rallentamenti o ban.

- CAPTCHA: quei puzzle “dimostra che sei umano” che i bot non risolvono facilmente.

- Analisi comportamentale: i siti osservano pattern robotici, come click sempre uguali e a intervalli regolari.

- Honeypot: campi o link nascosti che solo i bot compilano o cliccano.

- Browser fingerprinting: raccolta di dettagli su browser e device per beccare gli automatismi.

- Gestione cookie e sessioni: i bot che non gestiscono bene cookie o sessioni vengono subito sgamati.

Pensa ai controlli in aeroporto: se ti comporti come tutti, passi liscio. Se invece fai qualcosa di strano, ti fermano subito.

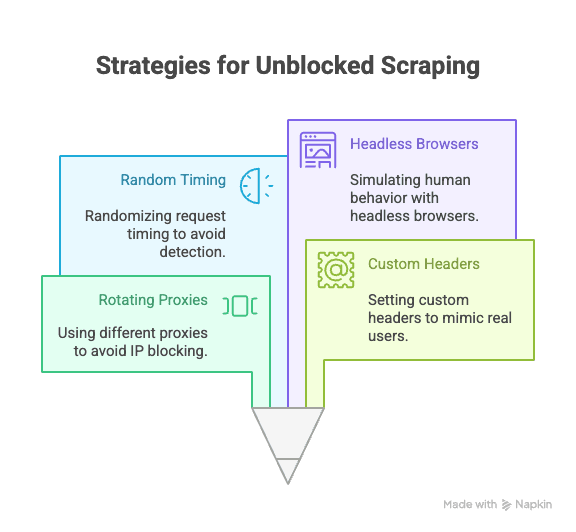

Tecniche Chiave in Python per Evitare Blocchi durante il Web Scraping

Ecco le strategie fondamentali per non farsi bloccare durante lo scraping con Python:

Rotazione di Proxy e Indirizzi IP

Perché serve: Se tutte le richieste partono dallo stesso IP, sei un bersaglio facile. Usare proxy rotanti distribuisce le richieste su più IP, rendendo il blocco molto più difficile.

Come si fa in Python:

1import requests

2proxies = [

3 "<http://proxy1.example.com:8000>",

4 "<http://proxy2.example.com:8000>",

5 # ...altri proxy

6]

7for i, url in enumerate(urls):

8 proxy = {"http": proxies[i % len(proxies)]}

9 response = requests.get(url, proxies=proxy)

10 # processa la rispostaPer una marcia in più, puoi usare servizi proxy a pagamento (residenziali o rotanti) ().

Impostare User-Agent e Header Personalizzati

Perché è fondamentale: Gli header di default di Python sono facilissimi da riconoscere. Simula un browser vero impostando user-agent e altri header.

Esempio di codice:

1headers = {

2 "User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/124.0.0.0 Safari/537.36",

3 "Accept-Language": "en-US,en;q=0.9",

4 "Accept-Encoding": "gzip, deflate, br",

5 "Connection": "keep-alive"

6}

7response = requests.get(url, headers=headers)Per essere ancora più invisibile, ruota diversi user-agent ().

Randomizzare Tempi e Pattern delle Richieste

Perché è importante: I bot sono veloci e prevedibili, gli umani sono lenti e casuali. Aggiungi ritardi e varia il percorso di navigazione.

Suggerimento Python:

1import time, random

2for url in urls:

3 response = requests.get(url)

4 time.sleep(random.uniform(2, 7)) # Attendi tra 2 e 7 secondiSe usi Selenium, puoi randomizzare anche click e scroll.

Gestione di Cookie e Sessioni

Perché è fondamentale: Molti siti richiedono cookie o token di sessione per accedere ai contenuti. Ignorarli porta al blocco.

Come gestirli in Python:

1import requests

2session = requests.Session()

3response = session.get(url)

4# la sessione gestisce i cookie automaticamentePer flussi più complessi, usa Selenium per acquisire e riutilizzare i cookie.

Simulare il Comportamento Umano con Browser Headless

Perché serve: Alcuni siti usano JavaScript, movimenti del mouse o scroll come segnali di utenti veri. Browser headless come Selenium o Playwright possono imitare queste azioni.

Esempio con Selenium:

1from selenium import webdriver

2from selenium.webdriver.common.action_chains import ActionChains

3import random, time

4driver = webdriver.Chrome()

5driver.get(url)

6actions = ActionChains(driver)

7actions.move_by_offset(random.randint(0, 100), random.randint(0, 100)).perform()

8time.sleep(random.uniform(2, 5))Così puoi superare controlli comportamentali e contenuti dinamici ().

Strategie Avanzate: Superare CAPTCHAs e Honeypot in Python

I CAPTCHA sono fatti apposta per fermare i bot. Alcune librerie Python risolvono i CAPTCHA più semplici, ma per quelli tosti si usano servizi esterni (come 2Captcha o Anti-Captcha) a pagamento ().

Esempio di integrazione:

1# Pseudocodice per usare l’API di 2Captcha

2import requests

3captcha_id = requests.post("<https://2captcha.com/in.php>", data={...}).text

4# Attendi la soluzione, poi invia la richiestaGli honeypot sono campi o link nascosti che solo i bot compilano o cliccano. Evita di interagire con elementi non visibili in un browser vero ().

Come Costruire Header di Richiesta Efficaci con le Librerie Python

Oltre allo user-agent, puoi ruotare e randomizzare altri header (Referer, Accept, Origin, ecc.) per confonderti tra gli utenti veri.

Con Scrapy:

1class MySpider(scrapy.Spider):

2 custom_settings = {

3 'DEFAULT_REQUEST_HEADERS': {

4 'User-Agent': '...',

5 'Accept-Language': 'en-US,en;q=0.9',

6 # Altri header

7 }

8 }Con Selenium: Usa profili browser o estensioni per impostare gli header, oppure iniettali via JavaScript.

Aggiorna spesso la lista degli header: copia quelli veri dalle richieste del browser tramite DevTools.

Quando lo Scraping Python Tradizionale Non Basta: L’Evoluzione delle Difese Anti-Bot

La verità è che, più lo scraping si diffonde, più le difese anti-bot diventano furbe. . Rilevamento tramite AI, soglie dinamiche e fingerprinting rendono sempre più difficile passare inosservati anche agli script Python più avanzati ().

A volte, anche con il codice più raffinato, ti scontri con un muro. In questi casi, meglio cambiare approccio.

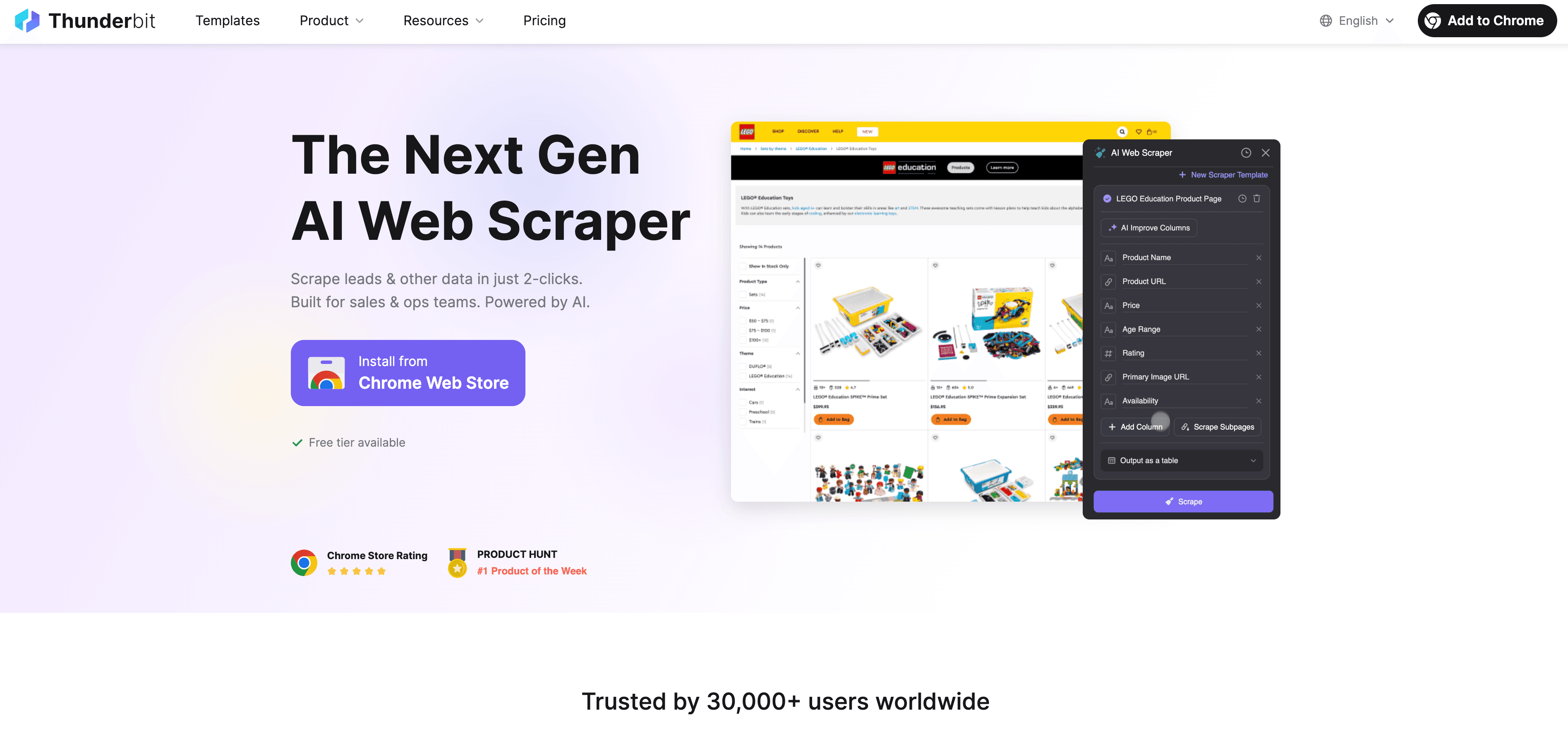

Thunderbit: L’Alternativa AI all’Estrattore Web Python

Quando Python non basta più, entra in campo come Estrattore Web AI senza codice, pensato per chi lavora nel business e non solo per sviluppatori. Dimentica proxy, header e CAPTCHA: l’agente AI di Thunderbit legge la pagina, suggerisce i campi da estrarre e si occupa di tutto, dalla navigazione all’esportazione.

Cosa rende Thunderbit speciale?

- Suggerimento AI dei campi: Con “AI Suggerisci Campi”, Thunderbit analizza la pagina, propone colonne e genera le istruzioni di estrazione.

- Scraping di sottopagine: Thunderbit visita in automatico ogni sottopagina (tipo dettagli prodotto o profili LinkedIn) e arricchisce la tabella.

- Scraping in cloud o browser: Scegli la modalità più veloce: cloud per siti pubblici, browser per pagine protette da login.

- Scraping programmato: Imposta una pianificazione e Thunderbit aggiornerà i dati in automatico.

- Template istantanei: Per i siti più popolari (Amazon, Zillow, Shopify, ecc.), Thunderbit offre template già pronti.

- Esportazione gratuita dei dati: Esporta in Excel, Google Sheets, Airtable o Notion senza costi extra.

Thunderbit è già usato da oltre , e non serve scrivere una riga di codice.

Come Thunderbit Aiuta a Evitare Blocchi e Automatizzare l’Estrazione Dati

L’AI di Thunderbit non si limita a imitare il comportamento umano: si adatta in tempo reale a ogni sito, riducendo il rischio di blocchi. Ecco come:

- L’AI si adatta ai cambi di layout: Niente più script rotti quando il sito cambia grafica.

- Gestione automatica di sottopagine e paginazione: Thunderbit segue link e liste paginati come un utente vero.

- Scraping cloud su larga scala: Fino a 50 pagine contemporaneamente, in tempi rapidissimi.

- Zero codice, zero manutenzione: Dedica il tempo all’analisi, non al debug.

Se vuoi approfondire, leggi .

Python vs Thunderbit: Quale Scegliere per il Web Scraping?

Ecco un confronto diretto:

| Caratteristica | Scraping con Python | Thunderbit |

|---|---|---|

| Tempo di configurazione | Medio–Alto (script, proxy, ecc.) | Basso (2 click, fa tutto l’AI) |

| Competenze tecniche | Richiesto saper programmare | Nessuna competenza richiesta |

| Affidabilità | Variabile (facile da rompere) | Alta (l’AI si adatta ai cambiamenti) |

| Rischio di blocchi | Medio–Alto | Basso (l’AI imita l’utente e si adatta) |

| Scalabilità | Serve codice/cloud personalizzato | Cloud e batch integrati |

| Manutenzione | Frequente (cambi sito, blocchi) | Minima (l’AI si regola da sola) |

| Esportazione dati | Manuale (CSV, DB) | Diretta su Sheets, Notion, Airtable, CSV |

| Costo | Gratis (ma richiede tempo) | Piano gratuito, a pagamento per grandi volumi |

Quando usare Python:

- Vuoi controllo totale, logiche personalizzate o integrazione con altri workflow Python.

- Devi estrarre dati da siti con poche difese anti-bot.

Quando usare Thunderbit:

- Vuoi velocità, affidabilità e zero configurazione.

- Devi estrarre dati da siti complessi o che cambiano spesso.

- Non vuoi gestire proxy, CAPTCHA o codice.

Guida Pratica: Come Fare Web Scraping Senza Blocchi con Python

Ecco un esempio pratico: estrarre dati prodotto da un sito di esempio, seguendo le best practice anti-blocco.

1. Installa le Librerie Necessarie

1pip install requests beautifulsoup4 fake-useragent2. Prepara lo Script

1import requests

2from bs4 import BeautifulSoup

3from fake_useragent import UserAgent

4import time, random

5ua = UserAgent()

6urls = ["<https://example.com/product/1>", "<https://example.com/product/2>"] # Sostituisci con i tuoi URL

7for url in urls:

8 headers = {

9 "User-Agent": ua.random,

10 "Accept-Language": "en-US,en;q=0.9"

11 }

12 response = requests.get(url, headers=headers)

13 if response.status_code == 200:

14 soup = BeautifulSoup(response.text, "html.parser")

15 # Estrai i dati qui

16 print(soup.title.text)

17 else:

18 print(f"Bloccato o errore su {url}: {response.status_code}")

19 time.sleep(random.uniform(2, 6)) # Ritardo casuale3. Aggiungi la Rotazione dei Proxy (Opzionale)

1proxies = [

2 "<http://proxy1.example.com:8000>",

3 "<http://proxy2.example.com:8000>",

4 # Altri proxy

5]

6for i, url in enumerate(urls):

7 proxy = {"http": proxies[i % len(proxies)]}

8 headers = {"User-Agent": ua.random}

9 response = requests.get(url, headers=headers, proxies=proxy)

10 # ...resto del codice4. Gestisci Cookie e Sessioni

1session = requests.Session()

2for url in urls:

3 response = session.get(url, headers=headers)

4 # ...resto del codice5. Consigli per la Risoluzione dei Problemi

- Se ricevi molti errori 403/429, rallenta le richieste o prova nuovi proxy.

- Se incontri CAPTCHA, valuta Selenium o un servizio di risoluzione CAPTCHA.

- Controlla sempre il

robots.txte le condizioni d’uso del sito.

Conclusioni e Consigli Finali

Il web scraping con Python è potente, ma il rischio di blocchi cresce con l’evoluzione delle difese anti-bot. Il modo migliore per evitarli? Unisci le best practice tecniche (proxy rotanti, header intelligenti, ritardi casuali, gestione delle sessioni e browser headless) a un approccio etico e rispettoso delle regole dei siti.

Ma a volte, anche le strategie Python più avanzate non bastano. In questi casi, strumenti AI come fanno la differenza: nessun codice, resistenza ai blocchi e facilità d’uso per il business.

Vuoi vedere quanto può essere semplice lo scraping? e provala subito—oppure visita il nostro per altri consigli e tutorial.

Domande Frequenti

1. Perché i siti bloccano gli scraper Python?

I siti bloccano gli scraper per proteggere i propri dati, evitare sovraccarichi e impedire abusi da parte di bot automatici. Gli script Python sono facili da individuare se usano header di default, non gestiscono i cookie o inviano troppe richieste in poco tempo.

2. Quali sono i metodi più efficaci per evitare blocchi durante lo scraping con Python?

Usa proxy rotanti, imposta user-agent e header realistici, randomizza i tempi delle richieste, gestisci cookie/sessioni e simula il comportamento umano con strumenti come Selenium o Playwright.

3. In che modo Thunderbit aiuta a evitare blocchi rispetto agli script Python?

Thunderbit sfrutta l’AI per adattarsi ai layout dei siti, imitare la navigazione umana e gestire automaticamente sottopagine e paginazione. Riduce il rischio di blocchi adattando la strategia in tempo reale—senza bisogno di codice o proxy.

4. Quando conviene usare Python rispetto a uno strumento AI come Thunderbit?

Usa Python se hai bisogno di logiche personalizzate, integrazione con altri script o devi estrarre dati da siti semplici. Scegli Thunderbit per uno scraping veloce, affidabile e scalabile—soprattutto su siti complessi, dinamici o che bloccano facilmente gli script.

5. Il web scraping è legale?

Il web scraping è legale se si estraggono dati pubblici, ma è fondamentale rispettare le condizioni d’uso, le policy sulla privacy e le leggi vigenti. Non estrarre mai dati sensibili o privati e agisci sempre in modo etico e responsabile.

Vuoi fare scraping in modo più smart? Prova Thunderbit e dimentica i blocchi.

Scopri di più:

- Google News Scraping con Python: Guida Passo Passo

- Crea un Price Tracker per Best Buy con Python

- 14 Strategie per il Web Scraping Senza Blocchi

- 10 Consigli per Non Essere Bloccato durante il Web Scraping