Il web scraping è ormai un vero jolly per chi lavora in team aziendali e vuole restare sempre un passo avanti—che tu sia nel commerciale, nelle operations, nell’ecommerce o nel settore immobiliare. Il web è una fonte inesauribile di dati, ma tirarli fuori—soprattutto da siti pieni di elementi dinamici e interattivi—non è mai una passeggiata. Si prevede che entro il 2025 il mercato globale del web scraping sfiorerà i , e ormai si affida ai dati per prendere decisioni strategiche. Ma c’è un intoppo: più i siti diventano complessi—scroll infinito, pop-up, contenuti caricati via JavaScript—più gli strumenti classici di scraping rischiano di non bastare.

Ed è qui che Selenium fa la differenza. Selenium è il vero coltellino svizzero dell’estrazione dati: ti permette di automatizzare le azioni di un browser reale e di raccogliere dati anche dai siti più tosti e dinamici. Se ti sei mai detto “vorrei solo cliccare come un utente e prendere le info”, Selenium è quello che fa per te. In questa guida ti spiego tutto quello che ti serve per diventare pratico con il web scraping con Selenium—senza dover essere un programmatore esperto.

Cos’è il Web Scraping con Selenium? Una panoramica semplice

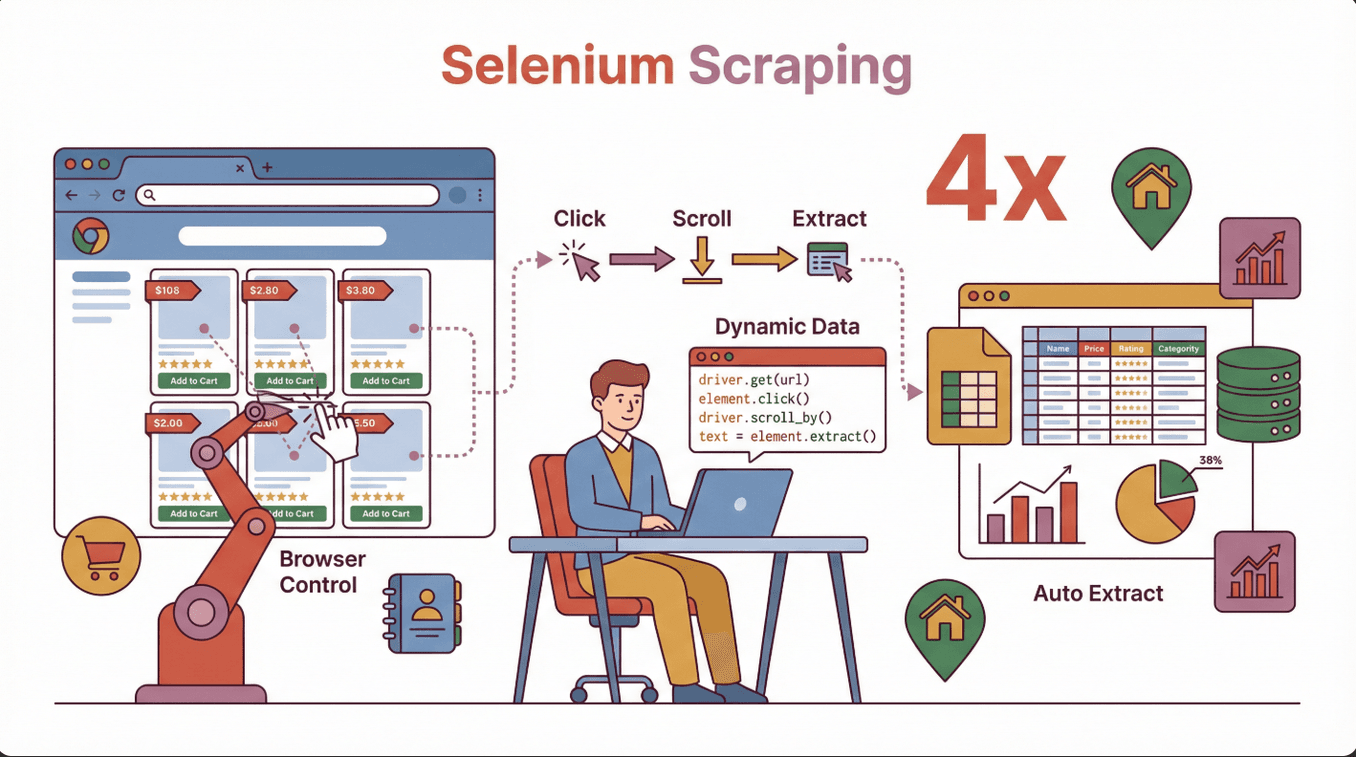

In parole povere, fare web scraping con Selenium vuol dire usare la libreria Selenium per comandare un browser vero e proprio (tipo Chrome o Firefox) tramite codice, simulando le azioni di una persona: cliccare, compilare form, scorrere la pagina e molto altro. A differenza degli scraper tradizionali che leggono solo l’HTML statico, Selenium può interagire con i siti proprio come faresti tu, rendendolo perfetto per estrarre dati da pagine che caricano contenuti dinamici via JavaScript.

In parole povere, fare web scraping con Selenium vuol dire usare la libreria Selenium per comandare un browser vero e proprio (tipo Chrome o Firefox) tramite codice, simulando le azioni di una persona: cliccare, compilare form, scorrere la pagina e molto altro. A differenza degli scraper tradizionali che leggono solo l’HTML statico, Selenium può interagire con i siti proprio come faresti tu, rendendolo perfetto per estrarre dati da pagine che caricano contenuti dinamici via JavaScript.

Quando Selenium fa la differenza in azienda:

- Ecommerce: Estrai prodotti, prezzi e recensioni da siti che caricano dati mentre scorri.

- Vendite & Lead Generation: Raccogli contatti da directory che richiedono login o più passaggi.

- Immobiliare: Raccogli dettagli su immobili da mappe interattive o annunci dietro pop-up.

- Ricerche di mercato: Analizza i competitor su siti moderni e interattivi.

Se hai provato a estrarre dati e ti sei accorto che mancava metà delle informazioni, probabilmente era perché i dati venivano caricati dopo l’apertura della pagina—Selenium risolve proprio questo, aspettando e interagendo come un vero utente ().

Perché scegliere Selenium per il Web Scraping? Confronto tra strumenti

Gli strumenti per il web scraping sono tanti—BeautifulSoup, Scrapy, e altri. Ma perché puntare su Selenium? Ecco il perché:

| Strumento | Ideale per | Gestisce JavaScript? | Interattività | Velocità | Facilità d’uso |

|---|---|---|---|---|---|

| Selenium | Siti dinamici e interattivi | Sì | Completa | Più lento | Media |

| BeautifulSoup | Pagine HTML semplici e statiche | No | Nessuna | Veloce | Facile |

| Scrapy | Siti statici o semi-dinamici su larga scala | Limitata (con plugin) | Limitata | Molto veloce | Media |

| Thunderbit | Estrazione rapida e no-code per aziende | Sì (con AI) | Limitata | Veloce | Molto facile |

I punti forti di Selenium:

- Gestisce siti pieni di JavaScript, scroll infinito e pop-up.

- Può fare login, cliccare pulsanti e compilare form—proprio come una persona.

- Perfetto per estrarre dati che compaiono solo dopo azioni dell’utente.

Quando usare Selenium:

- I dati che ti servono vengono caricati dopo l’apertura della pagina (es. via JavaScript).

- Devi interagire con il sito (login, click, scroll).

- Il sito usa layout complessi o framework SPA (Single Page Application).

Quando preferire altro:

- Il sito è statico e semplice—BeautifulSoup o Scrapy sono più veloci.

- Vuoi uno strumento no-code e immediato—Thunderbit è perfetto per lavori rapidi ().

Installazione e configurazione di Selenium: guida pratica

Partire con Selenium sembra complicato, ma in realtà è più semplice di quanto pensi. Ecco come iniziare senza stress.

1. Installa Python (se non l’hai già fatto)

La maggior parte delle guide Selenium usa Python, ma puoi usarlo anche con Java, C# e altri. Scarica Python da .

2. Installa Selenium tramite pip

Apri il terminale o prompt dei comandi e digita:

1pip install selenium()

3. Scarica il driver del browser

Selenium ha bisogno di un “driver” per comandare il browser. Per Chrome è ChromeDriver, per Firefox GeckoDriver.

- Trova la versione del browser: Su Chrome, vai su

chrome://settings/help. - Scarica il driver giusto: Prendi .

- Estrai e posiziona il driver: Metti il driver in una cartella e aggiungi il percorso alle variabili d’ambiente del sistema.

Tip locale: La versione del driver deve essere uguale a quella del browser. Se non coincidono, avrai errori come chromedriver executable needs to be available in the path ().

4. Testa la configurazione

Prova questo codice in Python:

1from selenium import webdriver

2driver = webdriver.Chrome() # O Firefox()

3driver.get("https://www.google.com")

4print(driver.title)

5driver.quit()Se il browser si apre e stampa il titolo, sei a cavallo!

Errori tipici:

- PATH non impostato bene—controlla le variabili d’ambiente.

- Versione driver/browser non corrispondente—aggiorna entrambi insieme.

- Permessi—su Mac/Linux potresti dover usare

chmod +x chromedriver.

Il tuo primo script di Web Scraping con Selenium: passo dopo passo

Vediamo come scrivere uno script semplice per estrarre i nomi dei prodotti da una pagina ecommerce di esempio. Ecco i passaggi:

1. Importa Selenium e configura il driver

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3driver = webdriver.Chrome()2. Apri la pagina target

1driver.get("https://example-ecommerce.com/products")3. Attendi il caricamento dei contenuti (se serve)

Per contenuti dinamici, usa un’attesa esplicita:

1from selenium.webdriver.support.ui import WebDriverWait

2from selenium.webdriver.support import expected_conditions as EC

3wait = WebDriverWait(driver, 10)

4wait.until(EC.presence_of_element_located((By.CLASS_NAME, "product-title")))4. Estrai i dati

1products = driver.find_elements(By.CLASS_NAME, "product-title")

2for product in products:

3 print(product.text)5. Chiudi il browser

1driver.quit()Cosa succede qui? Selenium apre il browser, aspetta che i prodotti siano caricati, trova tutti gli elementi con la classe product-title e ne stampa il testo.

Consigli pratici per estrarre contenuti dinamici con Selenium

I siti dinamici sono ormai la regola—scroll infinito, pop-up, contenuti che appaiono solo dopo un click. Ecco come gestirli:

1. Attendere gli elementi

I siti non caricano tutto subito. Usa le attese esplicite per aspettare che i dati compaiano:

1wait.until(EC.presence_of_element_located((By.ID, "dynamic-content")))2. Scroll per caricare altri dati

Per pagine con scroll infinito:

1driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")Ripeti più volte per caricare altri dati.

3. Gestire i pop-up

Trova e chiudi i pop-up:

1try:

2 close_button = driver.find_element(By.CLASS_NAME, "close-popup")

3 close_button.click()

4except:

5 pass # Nessun pop-up trovato4. Interagire con form e pulsanti

Compila moduli di ricerca o clicca su “avanti”:

1search_box = driver.find_element(By.NAME, "search")

2search_box.send_keys("laptop")

3search_box.submit()Esempio pratico: Estrazione di annunci immobiliari che si caricano mentre scorri, o recensioni di prodotti che appaiono solo dopo aver cliccato su una scheda.

Come evitare errori comuni: troubleshooting con Selenium

Anche i più esperti inciampano ogni tanto. Ecco i problemi più frequenti—e come risolverli:

| Problema | Soluzione |

|---|---|

| Elemento non trovato | Usa le attese, controlla i selettori o prova strategie diverse |

| Timeout | Aumenta il tempo di attesa, verifica se i contenuti sono lenti |

| CAPTCHA o blocco bot | Rallenta le richieste, randomizza le azioni, usa proxy |

| Driver/browser non compatibili | Aggiorna entrambi alle versioni più recenti |

| Cambi layout del sito | Aggiorna regolarmente selettori e script |

| Prestazioni lente | Riduci le azioni del browser, usa la modalità headless se possibile |

Tip locale: Selenium è più lento di altri strumenti perché simula le azioni di un utente vero (). Se hai bisogno di grandi volumi, valuta alternative o suddividi il lavoro.

Esportare e utilizzare i dati estratti

Una volta che hai i dati, ti servirà salvarli per usarli in azienda. Ecco come fare:

1. Salva i dati in una lista o DataFrame

1import pandas as pd

2data = []

3for product in products:

4 data.append({"name": product.text})

5df = pd.DataFrame(data)2. Esporta in CSV o Excel

1df.to_csv("products.csv", index=False)

2# Oppure

3df.to_excel("products.xlsx", index=False)()

3. Integra con strumenti aziendali

- Importa il CSV in Google Sheets o Airtable.

- Usa Zapier o API per automatizzare i flussi di dati.

Consiglio locale: Pulisci formati strani e valori mancanti prima di importare ().

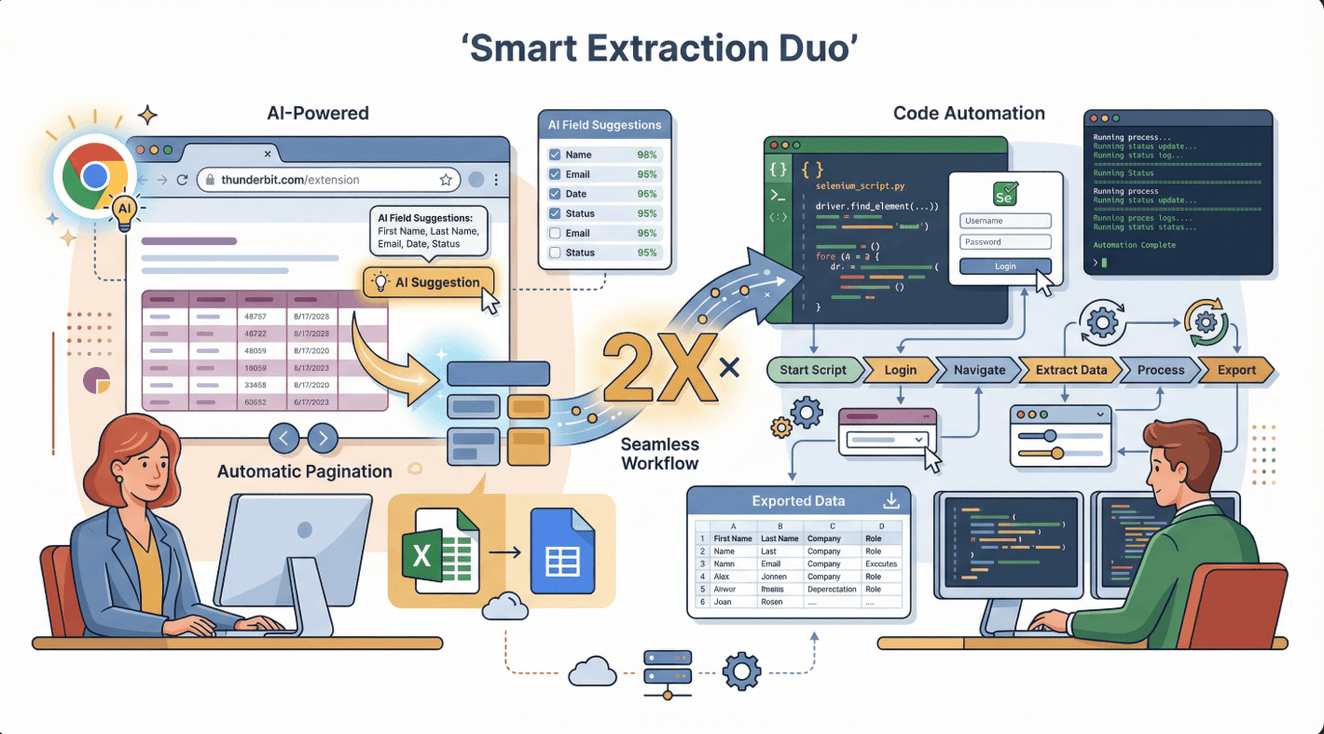

Selenium e Thunderbit: la combinazione perfetta per l’estrazione avanzata

Diciamolo chiaro—Selenium è potente, ma non sempre è la soluzione più veloce o semplice. Qui entra in gioco : un Estrattore Web AI come estensione Chrome che ti permette di estrarre dati dalla maggior parte dei siti in pochi click—senza codice, senza sbattimenti.

Diciamolo chiaro—Selenium è potente, ma non sempre è la soluzione più veloce o semplice. Qui entra in gioco : un Estrattore Web AI come estensione Chrome che ti permette di estrarre dati dalla maggior parte dei siti in pochi click—senza codice, senza sbattimenti.

Come usarli insieme?

- Thunderbit è perfetto per estrazioni rapide e strutturate da tabelle, elenchi o pagine semplici. Ideale per team di vendita, ecommerce o ricerca che vogliono risultati subito.

- Selenium è la scelta giusta quando serve automatizzare interazioni complesse—login, flussi multi-step, o dati che compaiono solo dopo azioni dell’utente.

Workflow consigliato: Parti con Thunderbit per le estrazioni semplici. Se incontri ostacoli (come login o contenuti interattivi), passa a Selenium per quella parte. Puoi anche esportare i dati da Thunderbit e usarli nei tuoi script Selenium per elaborazioni avanzate.

I vantaggi di Thunderbit:

- Suggerimenti AI per i campi—clicca su “AI Suggerisci Campi” e lascia fare tutto all’AI.

- Gestisce paginazione, sottopagine ed esporta direttamente su Excel, Google Sheets, Notion o Airtable.

- Nessuna manutenzione—l’AI si adatta automaticamente ai cambiamenti dei siti ().

Rispettare le regole: scraping legale ed etico con Selenium

Il web scraping è uno strumento potente, ma va usato con responsabilità. Ecco come restare dalla parte giusta della legge ed evitare grane:

1. Controlla i Termini di Servizio del sito

Leggi sempre i termini prima di estrarre dati. Alcuni siti vietano lo scraping; altri lo permettono solo per uso personale ().

2. Rispetta il file robots.txt

Il file robots.txt dice cosa può essere esplorato o estratto. Lo trovi su https://website.com/robots.txt ().

3. Evita dati sensibili o personali

Non estrarre dati sanitari, finanziari o privati—potresti finire nei guai ().

4. Sii rispettoso: limiti di frequenza e identificazione

Non stressare i server—metti delle pause tra le richieste e identifica il tuo scraper se puoi.

5. Preferisci le API ufficiali quando ci sono

Se il sito offre un’API pubblica, usala—è la soluzione più sicura e affidabile.

Checklist per uno scraping a norma:

- [ ] Leggi e rispetta termini e robots.txt del sito.

- [ ] Estrai solo dati pubblici e non sensibili.

- [ ] Limita la frequenza delle richieste e non disturbare il sito.

- [ ] Attribuisci la fonte dei dati se richiesto.

- [ ] Rimani aggiornato sulle normative locali ().

Quando andare oltre Selenium: scalare lo scraping

Selenium è ottimo per lavori piccoli e medi, ma ha dei limiti:

Limiti:

- Più lento rispetto ad altri strumenti (perché usa un browser vero).

- Consuma molte risorse—avere più browser aperti può rallentare il PC.

- Non ideale per estrarre migliaia di pagine in poco tempo.

Quando fare un upgrade:

- Devi estrarre dati su larga scala (migliaia o milioni di pagine).

- Vuoi automatizzare lo scraping nel cloud o pianificarlo.

- Hai bisogno di funzioni avanzate come rotazione proxy, retry o scraping distribuito.

Alternative:

- Thunderbit: Per chi vuole estrarre dati velocemente e senza codice, grazie all’AI ().

- Scrapy: Per sviluppatori che costruiscono scraper distribuiti e scalabili ().

- API gestite: Servizi come ScraperAPI o Apify per scraping scalabile e senza pensieri ().

| Strumento | Ideale per | Pro | Contro |

|---|---|---|---|

| Selenium | Siti complessi e interattivi | Gestisce qualsiasi sito, controllo totale | Lento, consuma molte risorse |

| Thunderbit | Utenti business, lavori rapidi | No code, AI, esportazione facile | Meno controllo per usi avanzati |

| Scrapy | Team di sviluppo, grandi volumi | Veloce, scalabile, personalizzabile | Richiede codice, meno interattivo |

| API gestite | Enterprise, automazione | Scalabile, senza manutenzione | Costi, meno flessibilità |

Conclusioni e punti chiave

Il web scraping con Selenium è una risorsa preziosa per chiunque abbia bisogno di dati da siti dinamici e interattivi. È lo strumento ideale quando serve simulare le azioni di un utente reale—clic, scroll, login e altro. Ecco cosa ricordare:

- Selenium è perfetto per: Siti dinamici, contenuti JavaScript e flussi interattivi.

- Consigli per l’installazione: Abbina le versioni di browser e driver, imposta bene il PATH e usa le attese per i contenuti dinamici.

- Combina con Thunderbit: Usa Thunderbit per scraping veloce e no-code; passa a Selenium per flussi complessi.

- Rispetta le regole: Controlla sempre termini, robots.txt ed evita dati sensibili.

- Scala in modo smart: Per grandi volumi, valuta API gestite o strumenti cloud.

Se sei alle prime armi, prova a scrivere uno script Selenium per estrarre nomi o prezzi di prodotti. Poi sperimenta Thunderbit per il tuo prossimo progetto di dati aziendali—è gratuito e può farti risparmiare ore di lavoro manuale ().

Vuoi approfondire? Dai un’occhiata al per altre guide sul web scraping, oppure iscriviti al nostro per tutorial passo passo.

Domande frequenti

1. Cosa rende Selenium diverso dagli altri strumenti di web scraping?

Selenium controlla un browser vero, quindi può interagire con siti dinamici e pieni di JavaScript—cosa che strumenti come BeautifulSoup non possono fare. È ideale per siti che richiedono azioni come click o login.

2. Quali sono gli errori più comuni nell’impostare Selenium?

I problemi principali sono versioni non corrispondenti tra browser e driver, driver non aggiunto al PATH e mancanza di attese per i contenuti dinamici. Controlla sempre le versioni e usa attese esplicite.

3. Posso usare Selenium e Thunderbit insieme?

Assolutamente sì. Thunderbit è ottimo per scraping rapido e senza codice, mentre Selenium gestisce flussi complessi e interattivi. Molti team usano Thunderbit per i dati semplici e Selenium per le attività avanzate.

4. Lo scraping con Selenium è legale?

Il web scraping è legale se rispetti i termini del sito, il robots.txt, eviti dati sensibili e non sovraccarichi i server. Controlla sempre le leggi locali e usa lo scraping in modo responsabile.

5. Quando dovrei passare oltre Selenium per il web scraping?

Se devi estrarre migliaia di pagine rapidamente o automatizzare lo scraping nel cloud, valuta strumenti come Thunderbit, Scrapy o API gestite. Selenium è ideale per lavori piccoli/medi e interattivi.

Pronto a diventare esperto di web scraping? Prova Selenium per il tuo prossimo progetto—e non dimenticare di scoprire per estrarre dati aziendali dal web in modo rapido.

Approfondisci