Oggi l’estrazione di dati dal web è diventata la carta vincente di tantissime aziende, anche se spesso passa inosservata. Che tu sia nel commerciale, nelle operations o semplicemente voglia tenere d’occhio i competitor, saper raccogliere informazioni dai siti è ormai una skill imprescindibile. Ma cosa è cambiato di recente? Il web è diventato super dinamico: dashboard interattive, scroll infinito, contenuti che spuntano solo dopo un click. E il protagonista di questa rivoluzione è proprio JavaScript, il linguaggio che fa muovere quasi tutto quello che vedi (e che non vedi) online.

Dopo anni nel mondo SaaS e dell’automazione, ho visto JavaScript e Node.js passare da “optional” per sviluppatori a veri e propri motori per l’estrazione di dati aziendali. I dati parlano chiaro: e il mercato globale dell’estrattore web continuerà a crescere a doppia cifra fino al 2030 (). In questa guida ti racconto cosa significa davvero fare web scraping con JavaScript e Node.js, perché è così importante e – soprattutto – come anche chi non sa programmare può sfruttare questa tecnologia grazie a strumenti come . Che tu sia tecnico o meno, non c’è mai stato un momento migliore per trasformare il caos del web in valore concreto per il tuo business.

Cos’è il Web Scraping con JavaScript? Le Basi da Sapere

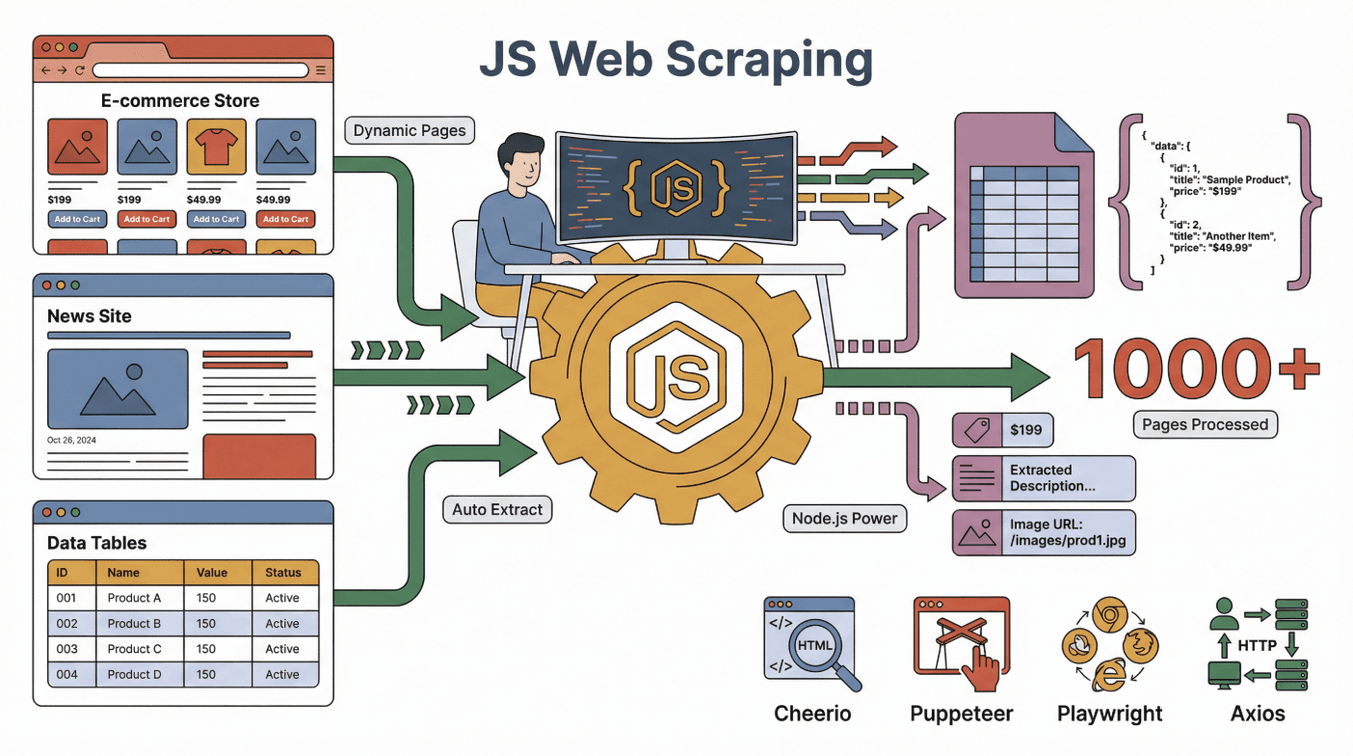

Partiamo dalle basi. Fare web scraping con JavaScript vuol dire usare JavaScript (spesso insieme a Node.js) per estrarre in automatico dati dai siti web. Immagina di avere un assistente digitale che visita un sito, legge la pagina e copia le informazioni che ti servono in un foglio Excel – solo che il tuo assistente può gestire migliaia di pagine, non si stanca mai e può anche cliccare pulsanti e compilare moduli.

Partiamo dalle basi. Fare web scraping con JavaScript vuol dire usare JavaScript (spesso insieme a Node.js) per estrarre in automatico dati dai siti web. Immagina di avere un assistente digitale che visita un sito, legge la pagina e copia le informazioni che ti servono in un foglio Excel – solo che il tuo assistente può gestire migliaia di pagine, non si stanca mai e può anche cliccare pulsanti e compilare moduli.

JavaScript è super efficace perché è il linguaggio che i browser usano per costruire e aggiornare le pagine web. Node.js ti permette di far girare JavaScript anche fuori dal browser, così puoi automatizzare attività come:

- Caricare una pagina web (anche se è dinamica o interattiva)

- Cliccare pulsanti, scorrere la pagina o aspettare che i contenuti compaiano

- Estrarre testi, immagini, prezzi, email o qualsiasi altro dato visibile

Gli strumenti più usati per lo scraping con JavaScript sono:

- : Perfetto per analizzare ed estrarre dati da pagine HTML statiche (è come jQuery ma lato server).

- : Automatizza un vero browser Chrome, ideale per siti dinamici che richiedono interazione.

- : Simile a Puppeteer, ma ancora più potente per l’automazione su più browser.

- : Fa richieste HTTP per recuperare pagine web o API.

La vera forza arriva quando combini questi strumenti: Axios o Puppeteer recuperano la pagina, Cheerio analizza l’HTML e Node.js orchestra tutto il processo.

Pagine Statiche vs Dinamiche: Perché JavaScript è Fondamentale

- Pagine statiche: Il contenuto è fisso e si carica subito. Facili da estrarre con strumenti semplici.

- Pagine dinamiche: I contenuti si caricano dopo, spesso grazie a JavaScript. Serve l’automazione di un browser (come Puppeteer) per vedere ed estrarre questi dati ().

Con la maggior parte dei siti che oggi usano contenuti dinamici (pensa ad Amazon, LinkedIn, Zillow), lo scraping basato su JavaScript è diventato lo standard per ottenere i dati che contano davvero.

Perché Scegliere JavaScript per il Web Scraping? I Vantaggi Rispetto agli Altri Linguaggi

Se bazzichi nei forum di sviluppatori, troverai discussioni infinite: JavaScript vs Python vs Ruby vs Go per lo scraping. Ecco la mia opinione, dopo anni di esperienza:

I Superpoteri di JavaScript

- Gestione nativa dei contenuti dinamici: Essendo il linguaggio del browser, JavaScript è perfetto per interagire con siti moderni pieni di script ().

- Automazione del browser: Strumenti come Puppeteer e Playwright possono cliccare, scorrere e compilare moduli – proprio come farebbe una persona.

- Familiarità con il front-end: Se il tuo team già lavora con JavaScript, puoi riutilizzare queste competenze anche per lo scraping ().

- Velocità e concorrenza: Node.js gestisce tante operazioni in parallelo, perfetto per estrarre dati da molte pagine in poco tempo ().

- Ecosistema vastissimo: Migliaia di librerie, tutorial e una community super attiva.

JavaScript a Confronto con Python, Ruby e Go

| Linguaggio | Contenuti Dinamici | Automazione Browser | Community | Velocità | Ideale per |

|---|---|---|---|---|---|

| JavaScript | Eccellente | Eccellente | Enorme | Veloce | Siti interattivi, team front-end |

| Python | Buono (con Selenium/Playwright) | Buono | Enorme | Veloce | API, siti statici, data science |

| Ruby | Discreto | Limitato | Di nicchia | Media | Scraping semplice su siti statici |

| Go | Limitato | Limitato | In crescita | Molto veloce | Scraping su larga scala, backend |

Per estrarre dati da siti moderni e interattivi, JavaScript (con Node.js) è spesso la scelta migliore (). Python è un’ottima alternativa, ma se la pagina è piena di JavaScript, niente batte JavaScript stesso ().

Gli Strumenti Chiave per il Web Scraping con JavaScript e Node.js

Ecco i protagonisti della cassetta degli attrezzi per lo scraping in JavaScript:

- Node.js: Il motore che fa girare JavaScript fuori dal browser. È la tua centrale operativa.

- Cheerio: Analizza l’HTML e ti permette di selezionare elementi (tipo “dammi tutti i nomi dei prodotti di questa pagina”).

- Puppeteer/Playwright: Automatizzano un browser vero per gestire contenuti dinamici, login e interazioni complesse.

- Axios/Fetch: Recuperano pagine web o API direttamente.

- Altri strumenti: Librerie per esportare dati (CSV, Excel), gestire proxy o pianificare scraping automatici.

Come lavorano insieme? Immagina Puppeteer come il tuo browser-robot, Cheerio come il detective dei dati e Node.js come il project manager che orchestra tutto.

Come Funziona il Web Scraping con JavaScript: I Passaggi Fondamentali

Facciamo chiarezza sul processo. Ecco come si svolge di solito uno scraping con JavaScript:

- Invio della richiesta: Usi Axios o Puppeteer per caricare la pagina web.

- Attesa dei contenuti: Se la pagina è dinamica, aspetti che JavaScript abbia finito di caricare tutto (Puppeteer “vede” la pagina finale).

- Estrazione dei dati: Con Cheerio o le API del browser selezioni e copi i dati che ti servono.

- Gestione di paginazione/sottopagine: Clicchi su “Avanti” o segui i link per raccogliere più dati.

- Esportazione: Salvi i risultati in CSV, Excel, Google Sheets o un database.

Un esempio pratico: È come mandare uno stagista super-efficiente a visitare ogni pagina, prendere appunti e organizzarli in un foglio di calcolo.

Contenuti Statici vs Dinamici: Qual è la Differenza?

- Esempio di sito statico: Un blog dove tutti gli articoli sono già nell’HTML. Cheerio + Axios sono perfetti.

- Esempio di sito dinamico: Un e-commerce dove i prezzi compaiono solo dopo lo scroll. Serve Puppeteer o Playwright per “vedere” i prezzi finali ().

Consiglio: Se durante lo scraping ottieni una pagina vuota, probabilmente è dinamica – è il momento di usare Puppeteer.

Thunderbit: Estrattore Web No-Code con la Potenza di JavaScript

Qui le cose si fanno davvero interessanti, soprattutto se non sei uno sviluppatore. Con abbiamo voluto rendere l’estrattore web di livello JavaScript accessibile a tutti, non solo ai programmatori.

La nostra filosofia: Il tuo estrattore web dovrebbe “capire i compiti come uno stagista” – tu descrivi cosa vuoi, l’AI capisce come ottenerlo.

Come Thunderbit Porta lo Scraping JavaScript a Tutti

- AI Suggerisce i campi: Un click e l’AI di Thunderbit analizza la pagina, suggerisce quali dati estrarre e configura tutto per te.

- Scraping di sottopagine: Vuoi più dettagli? Thunderbit può visitare ogni sottopagina (come pagine prodotto o profili) e arricchire la tua tabella in automatico.

- Template pronti: Per siti popolari (Amazon, Zillow, Shopify), scegli un modello e parti subito – nessuna configurazione.

- Esportazione gratuita: Invia i dati direttamente su Excel, Google Sheets, Airtable o Notion – senza costi aggiuntivi.

Esempio reale: Ho visto team commerciali usare Thunderbit per raccogliere centinaia di lead da una directory dinamica, completi di email e numeri di telefono, in pochi click – senza scrivere codice. È come avere uno sviluppatore JavaScript nel team, ma senza doverlo assumere.

Casi d’Uso: Web Scraping con JavaScript per Vendite e Operations

Lo scraping con JavaScript non è solo per i tecnici. Ecco come viene usato ogni giorno da veri team:

| Team | Caso d’uso | Risultato |

|---|---|---|

| Vendite | Generazione lead da directory | 10x più lead, pronti per l’import in CRM |

| Ecommerce | Monitoraggio prezzi concorrenti | Prezzi dinamici, risposta rapida al mercato |

| Operations | Aggregazione inventario | Vista unificata degli SKU tra fornitori |

| Immobiliare | Aggregazione annunci immobiliari | Dati di mercato aggiornati in un unico file |

| Marketing | Analisi recensioni e sentiment | Insight rapidi, campagne più mirate |

Esempio: Un team ecommerce ci ha raccontato di aver risparmiato oltre 20 ore a settimana estraendo i prezzi dei concorrenti con Thunderbit, così da poter aggiornare i propri prezzi quasi in tempo reale ().

Aspetti Etici e Legali nello Scraping con JavaScript

Affrontiamo la domanda spinosa: Lo scraping è legale? In breve: di solito sì, se estrai dati pubblici e rispetti le regole del sito (). Ma ci sono regole importanti:

- Rispetta robots.txt: Se un sito vieta lo scraping, ascolta.

- Segui i Termini di Servizio: Alcuni siti lo proibiscono esplicitamente.

- Proteggi la privacy: Non raccogliere o usare impropriamente dati personali.

- Non sovraccaricare i server: Procedi a velocità ragionevole.

Le sentenze recenti tendono a favorire lo scraping di dati pubblici, ma le leggi su copyright e privacy restano valide (). In caso di dubbi, consulta un esperto legale.

Buona pratica: Estrai solo dati che condivideresti pubblicamente e cita sempre le fonti.

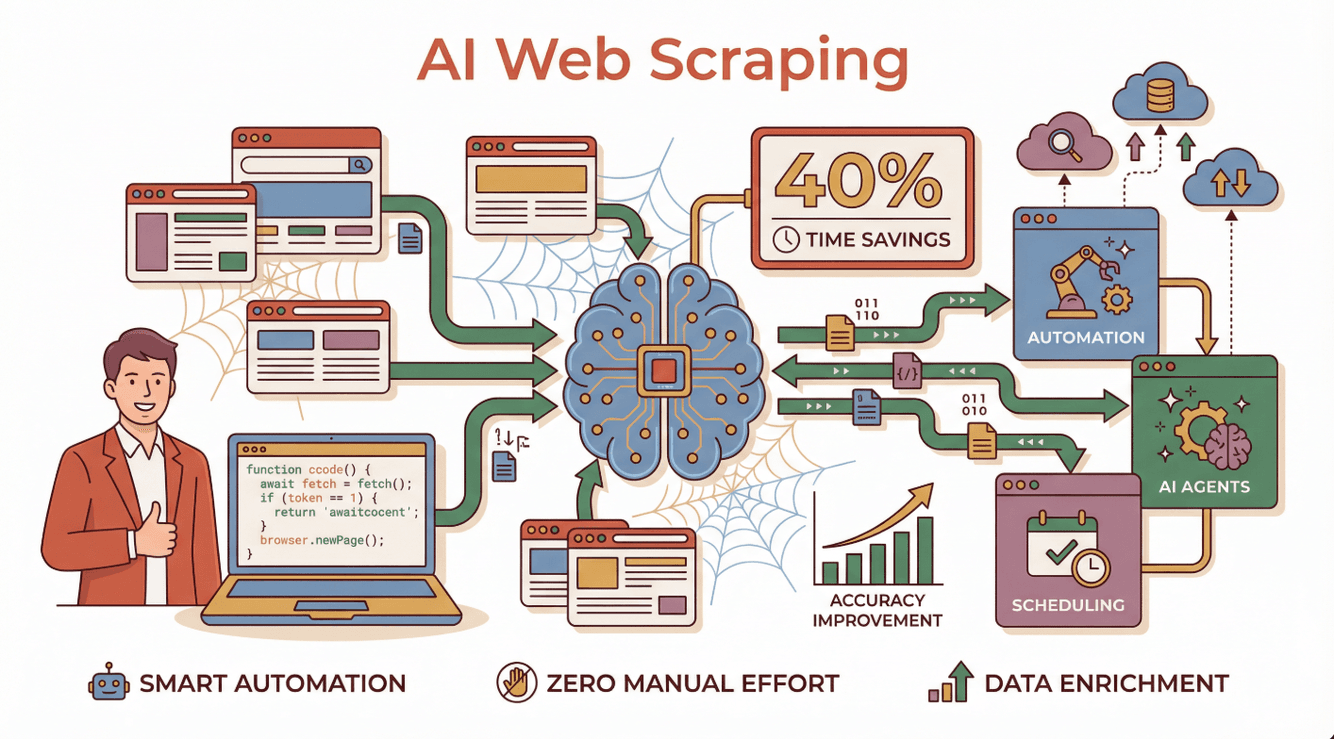

Il Futuro del Web Scraping con JavaScript: AI e Automazione

Qui si apre un nuovo scenario. L’AI sta rivoluzionando lo scraping, trasformandolo da attività manuale e complessa a processo intelligente e automatizzato. Le aziende che usano estrattori AI riportano , maggiore precisione e la capacità di gestire anche i siti dinamici più complessi ().

Qui si apre un nuovo scenario. L’AI sta rivoluzionando lo scraping, trasformandolo da attività manuale e complessa a processo intelligente e automatizzato. Le aziende che usano estrattori AI riportano , maggiore precisione e la capacità di gestire anche i siti dinamici più complessi ().

Cosa significa in pratica?

- Agenti AI che leggono istruzioni in linguaggio naturale, si adattano ai cambiamenti dei siti e gestiscono gli errori ().

- Pianificazione automatica: ricevi dati aggiornati ogni giorno, senza interventi manuali.

- Arricchimento dati: l’AI può categorizzare, riassumere e persino tradurre i dati estratti in tempo reale.

Thunderbit è all’avanguardia in questa evoluzione, permettendo a chiunque di creare ed eseguire estrattori web AI – senza codice e senza manutenzione.

Vuoi approfondire il futuro dello scraping AI? Scopri la nostra guida su .

Da Dove Iniziare: Consigli Pratici per le Aziende

Vuoi provare lo scraping con JavaScript (o con l’approccio no-code di Thunderbit)? Ecco come partire:

- Definisci l’obiettivo: Quali dati ti servono e perché?

- Scegli lo strumento: Se sei tecnico, prova Node.js con Puppeteer o Cheerio. Altrimenti, e lascia che l’AI faccia il lavoro pesante.

- Inizia in piccolo: Testa su poche pagine prima di scalare.

- Esporta e analizza: Invia i dati su Google Sheets, Excel o Notion per l’analisi.

- Resta etico: Rispetta sempre privacy, termini d’uso e limiti di dati.

Vuoi saperne di più? Trova tutorial per principianti sul o partecipa a community come Stack Overflow o r/webscraping su Reddit.

Conclusione: Sblocca il Valore del Web Scraping con JavaScript

In sintesi: JavaScript e Node.js sono diventati la spina dorsale dello scraping moderno, soprattutto per siti dinamici e interattivi. Che tu sia sviluppatore o business user, grazie all’automazione del browser, a un ecosistema ricchissimo e ora agli strumenti AI, puoi estrarre i dati che ti servono – più velocemente e con maggiore precisione che mai.

E con soluzioni no-code come , non serve scrivere una riga di codice per sfruttare la potenza dello scraping JavaScript. Basta descrivere ciò che vuoi, cliccare e vedere i dati pronti per analisi, lead generation o qualsiasi esigenza aziendale.

Se vuoi trasformare il caos del web in informazioni strutturate e utili, questo è il momento giusto per iniziare. Buono scraping – e che i tuoi dati siano sempre puliti, conformi e un passo avanti rispetto alla concorrenza.

Domande Frequenti

1. Cos’è il web scraping con JavaScript e Node.js?

Fare web scraping con JavaScript e Node.js significa usare codice JavaScript (spesso eseguito su Node.js) per estrarre automaticamente dati dai siti. Questo approccio è particolarmente efficace per siti dinamici che caricano contenuti tramite JavaScript.

2. Perché JavaScript è meglio di Python o Ruby per lo scraping di siti dinamici?

JavaScript è il linguaggio che i browser usano per visualizzare e aggiornare le pagine, quindi può interagire con i contenuti dinamici in modo più naturale. Strumenti come Puppeteer e Playwright permettono di automatizzare browser reali, facilitando lo scraping di siti che si basano su JavaScript.

3. Anche chi non è tecnico può fare web scraping con JavaScript?

Assolutamente sì. Strumenti no-code come portano la potenza dello scraping JavaScript a tutti. Basta dare istruzioni in linguaggio naturale e lasciare che l’AI gestisca la parte tecnica.

4. Lo scraping è legale?

In generale, estrarre dati pubblici è legale, ma bisogna rispettare i termini d’uso del sito, il file robots.txt e le leggi sulla privacy. Evita di raccogliere dati personali o protetti da copyright senza permesso.

5. Come sta cambiando lo scraping con JavaScript grazie all’AI?

L’AI rende lo scraping più intelligente e accessibile. Si adatta ai cambiamenti dei siti, gestisce errori e può anche elaborare e arricchire i dati estratti – risparmiando tempo e aumentando la precisione. Thunderbit è un esempio di questa nuova generazione di scraping AI.

Per altre guide e consigli, visita il o iscriviti al nostro .

Scopri di più