Se hai mai smanettato con il terminale, di sicuro ti sei imbattuto in cURL. È un po’ come il coltellino svizzero del web: silenzioso, presente ovunque, sempre pronto a recuperare, inviare o testare qualsiasi cosa abbia un URL. Secondo il suo creatore, cURL gira su in tutto il mondo. Non è uno scherzo. Venti miliardi.

Ma allora, perché nel 2025 sviluppatori (e, diciamolo, anche tanti professionisti non tecnici) continuano a scegliere cURL, nonostante l’esplosione di strumenti di scraping con AI? La risposta è semplice: a volte serve solo uno strumento veloce, scriptabile e senza troppi fronzoli. In questa guida ti spiego perché il web scraping con cURL è ancora attuale, quando conviene usarlo, come sfruttarlo al meglio e come puoi portare il tuo flusso di lavoro a un altro livello con , il nostro Estrattore Web AI che porta lo scraping nell’era moderna.

Perché il Web Scraping con cURL è Ancora Attuale nel 2025

Lo ammetto: cURL mi piace un sacco. C’è qualcosa di soddisfacente nel lanciare un comando e vedere arrivare i dati grezzi. E non sono l’unico. Il ha visto un aumento del 28% dei partecipanti lo scorso anno, e su Stack Overflow ci sono con il tag “curl”. Gli sviluppatori lo definiscono “affidabile”, “potente” e “la lingua franca delle richieste web”. Anche con l’arrivo di nuovi strumenti, cURL continua a evolversi: ora supporta HTTP/3 e molto altro.

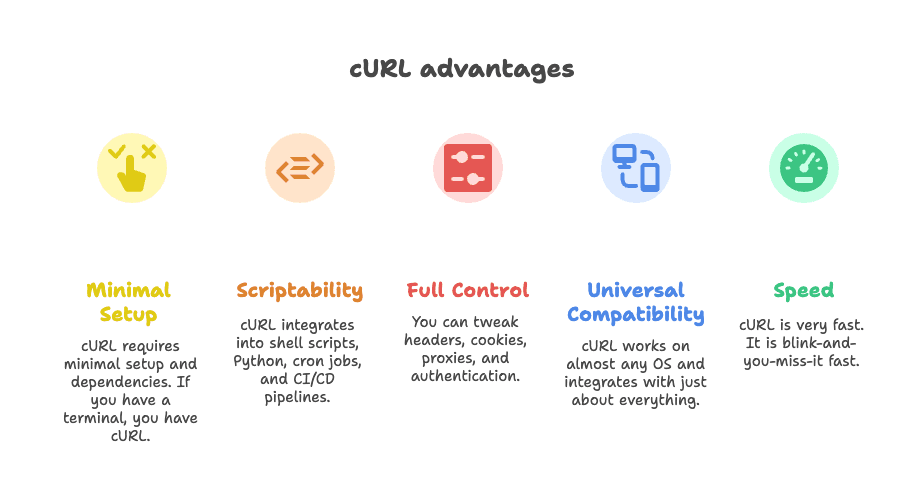

Ma cosa rende cURL così insostituibile per lo scraping?

- Configurazione minima: Non servono mille dipendenze. Se hai un terminale, hai già cURL.

- Scriptabilità: Si integra facilmente in shell script, Python, cron job e pipeline CI/CD.

- Controllo totale: Puoi personalizzare header, cookie, proxy e autenticazione come vuoi.

- Compatibilità universale: Funziona praticamente ovunque e si collega a qualsiasi cosa.

- Velocità: È fulmineo. Letteralmente, un battito di ciglia.

Come ha detto uno sviluppatore: “Qualsiasi cosa tu voglia fare, cURL può farla.” ()

I Migliori Scenari per il Web Scraping con cURL: Quando Usarlo

Diciamolo chiaro: cURL non è la soluzione a tutti i problemi di scraping. Ma in certi casi è imbattibile. Ecco dove dà il meglio:

1. Estrazione di Dati JSON da API REST

Tantissimi siti moderni caricano i contenuti tramite chiamate API in background. Se individui l’endpoint giusto (dai un’occhiata alla scheda Network del browser), cURL può recuperare il JSON con un solo comando. Perfetto per estrazioni rapide, test API o automazioni.

2. Estrazione da Pagine Statiche o Ben Strutturate

Se i dati che ti servono sono già nell’HTML (articoli, elenchi, pagine di categoria), cURL li recupera in un attimo. Puoi poi abbinarlo a strumenti come grep, sed o jq per una prima analisi.

3. Debug e Replica di Richieste HTTP Complesse

Vuoi simulare un login, testare un webhook o analizzare una chiamata API? cURL ti dà accesso diretto a header, cookie e payload. È la scelta ideale per chi vuole vedere cosa succede “sotto il cofano”.

4. Integrazione Rapida in Script

cURL è perfetto da inserire in shell script, Python o anche webhook di Zapier. È la colla che tiene insieme tante automazioni.

Ecco una tabella riassuntiva su dove cURL è adatto e dove invece mostra i suoi limiti:

| Caso d'Uso | Perché cURL è Adatto | Limiti | Alternative |

|---|---|---|---|

| Estrazione da API JSON | Veloce, scriptabile, supporta header/token | Nessun parsing JSON integrato, autenticazione complessa manuale | Python Requests, Postman, Thunderbit |

| Pagine HTML statiche | Leggero, facile da integrare con strumenti CLI | Nessun parsing HTML, non gestisce JavaScript | Scrapy, BeautifulSoup, Thunderbit |

| Scraping autenticato via sessione | Gestisce cookie, header, autenticazione base | Login multi-step complicati, no supporto JS | Requests sessions, Selenium, Thunderbit |

| Integrazione in shell/Python | Universale, funziona in ogni script | Parsing ed error handling manuali | Librerie HTTP native, Thunderbit |

Per approfondire questi scenari, dai un’occhiata a .

Tecniche Fondamentali di Web Scraping con cURL nel 2025

Passiamo alla pratica. Ecco come sfruttare cURL al meglio nel 2025, con qualche trucchetto utile.

Impostare Header e User-Agent

Molti siti bloccano le richieste cURL “pure”. Per “mimetizzarti”, imposta un User-Agent realistico e gli header necessari:

1curl -A "Mozilla/5.0 (Windows NT 10.0; Win64; x64)" -H "Accept: application/json" https://api.example.com/dataOppure, per più header:

1curl -H "User-Agent: Mozilla/5.0" -H "Accept: application/json" https://api.example.com/dataFalsificare gli header spesso fa la differenza tra ottenere i dati o essere bloccati. Per approfondire, leggi la .

Gestione di Cookie e Sessioni

Devi fare login o mantenere una sessione? Usa il cookie jar di cURL:

1# Login e salvataggio cookie

2curl -c cookies.txt -d "username=me&password=secret" https://example.com/login

3# Usa i cookie per richieste successive

4curl -b cookies.txt https://example.com/dashboardPuoi anche passare i cookie direttamente:

1curl -b "SESSIONID=abcd1234" https://example.com/pageSe segui redirect (ad esempio dopo il login), aggiungi -L per mantenere i cookie.

Utilizzo di Proxy per Evitare Blocchi

Se ti becchi un ban IP, instrada le richieste tramite un proxy:

1curl --proxy 198.199.86.11:8080 https://target.comPer proxy rotanti, puoi far leggere a cURL una lista e alternarli. Occhio: i proxy gratuiti spesso sono inaffidabili—non dare la colpa a cURL se ricevi un “connection refused”.

Salvataggio e Parsing delle Risposte

cURL restituisce dati grezzi. Per interpretarli, abbinalo a strumenti da linea di comando:

-

Per JSON: Usa

jqper formattare o estrarre campi.1curl -s https://api.github.com/repos/user/repo | jq .stargazers_count -

Per HTML: Usa

greposedper pattern semplici.1curl -s https://example.com | grep -oP '(?<=<title>).*?(?=</title>)' -

Parsing più complesso: Prova strumenti come

htmlq(per selettori CSS) o passa a Python con BeautifulSoup.

Per una guida dettagliata su cURL e jq, leggi .

Gestione di Autenticazione e Rate Limit con cURL

Autenticazione:

-

Basic Auth:

1curl -u username:password https://api.example.com/data -

Bearer Token:

1curl -H "Authorization: Bearer <token>" https://api.example.com/data -

Cookie di sessione: Usa le opzioni

-ce-bcome sopra.

Per flussi più complessi (come OAuth), dovrai scriptare la procedura—cURL può farlo, ma serve un po’ di esperienza.

Rate Limit e Retry:

-

Aggiungi ritardi:

1for url in $(cat urls.txt); do 2 curl -s "$url" 3 sleep $((RANDOM % 3 + 2)) # ritardo casuale tra 2-4 secondi 4done -

Retry:

1curl --retry 3 --retry-delay 5 https://example.com/data

Rispetta i server: non sovraccaricarli e controlla sempre le risposte 429 Too Many Requests.

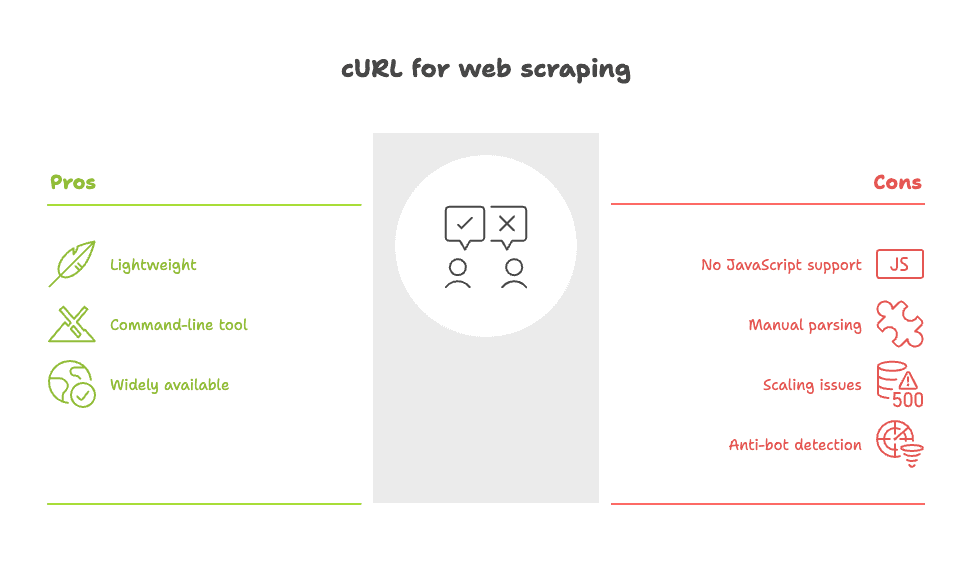

Limiti di cURL per il Web Scraping: Cosa Sapere

È il momento di essere sinceri. Per quanto sia potente, cURL non è sempre la scelta giusta. Ecco dove mostra i suoi limiti:

- Nessun supporto JavaScript: cURL non esegue script né visualizza contenuti dinamici. Se i dati vengono caricati dopo il rendering della pagina, cURL non li vede. Devi trovare l’API sottostante o usare uno strumento basato su browser.

- Parsing manuale: Ricevi solo HTML o JSON grezzo. La strutturazione dei dati è a carico tuo—spesso con

grep,sedo script personalizzati. - Problemi di scalabilità: Se devi estrarre dati da centinaia o migliaia di pagine, gestire errori, retry e pulizia dati diventa complicato.

- Facilmente rilevabile dai sistemi anti-bot: Molti siti riconoscono la “firma” di cURL e la bloccano, anche se modifichi gli header.

Come ha scritto un utente Reddit: “Curl o wget bastano per scraping semplici, ma per siti complessi avrai vita dura.” ()

Per un’analisi completa dei limiti di cURL, leggi .

Potenzia lo Scraping con cURL grazie a Thunderbit

E se volessi la velocità e il controllo di cURL, ma senza la fatica manuale? Qui entra in gioco .

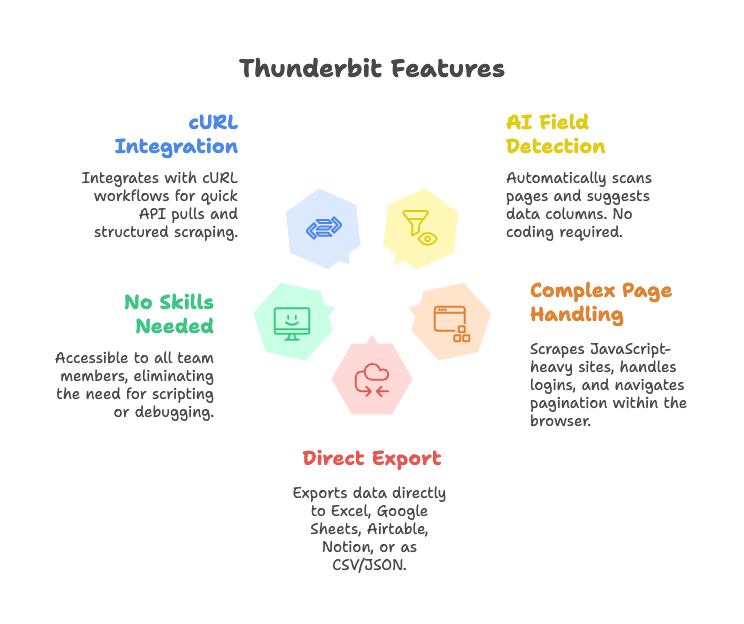

Thunderbit è un’estensione Chrome per lo scraping web basata su AI che semplifica l’estrazione dei dati. Ecco come si integra con cURL:

- Rilevamento AI dei campi: Basta cliccare su “AI Suggerisci Campi” e Thunderbit analizza la pagina, suggerisce colonne e struttura i dati—senza selettori né codice.

- Gestione di pagine complesse: Thunderbit lavora direttamente nel browser, quindi può estrarre dati anche da siti con JavaScript, gestire login e navigare tra sottopagine o paginazione.

- Esportazione diretta: Puoi inviare i dati direttamente su Excel, Google Sheets, Airtable, Notion o scaricarli in CSV/JSON.

- Nessuna competenza tecnica richiesta: Chiunque nel team può usarlo—niente script o debug di header.

- Integrazione con workflow cURL: Gli sviluppatori possono continuare a usare cURL per estrazioni rapide o prototipi, poi passare a Thunderbit per scraping strutturato e ripetibile.

Vuoi vedere Thunderbit in azione? Prova la nostra o visita il nostro per altri casi d’uso.

Thunderbit + cURL: Esempi di Workflow per Team Aziendali

Vediamo come i team possono combinare cURL e Thunderbit per ottenere risultati concreti:

1. Ricerche di Mercato Veloci

- Usa cURL per verificare rapidamente se il sito di un concorrente offre un’API pubblica o HTML statico.

- Se sì, esegui un’estrazione rapida per uno snapshot.

- Per analisi più approfondite (ad esempio scraping di prodotti su più pagine), passa a Thunderbit: l’AI rileva i campi, gestisce la paginazione ed esporta su Sheets per l’analisi immediata.

2. Generazione di Lead

- Usa cURL per recuperare contatti da una directory API semplice.

- Per siti più complessi (come profili stile LinkedIn o annunci immobiliari), Thunderbit estrae nomi, email, numeri di telefono e immagini—senza parsing manuale.

3. Monitoraggio di Prodotti o Prezzi

- Pianifica script cURL per controllare le variazioni di prezzo tramite API REST.

- Se il sito non offre API, lascia che Thunderbit si occupi dello scraping, strutturi i dati e aggiorni Airtable o Notion per il tuo team operativo.

Ecco uno schema di workflow (immagina omini stilizzati e frecce):

1[Browser/Terminale] --(test con cURL)--> [Estrazione Rapida]

2 |

3 v

4[Estensione Chrome Thunderbit] --(AI extraction)--> [Dati Strutturati] --> [Sheets/Airtable/Notion]Vantaggi Chiave: Thunderbit vs. Script cURL Manuali

Ecco un confronto diretto:

| Caratteristica | Thunderbit (Estrattore Web AI) | cURL (CLI Tool) |

|---|---|---|

| Tempo di setup | Punta e clicca, AI rileva i campi | Script manuali, serve conoscenza HTML |

| Facilità d’uso | Per tutti, feedback visivo | Solo CLI, curva di apprendimento ripida |

| Output strutturato | Sì—tabelle, colonne, export su Sheets/CRM | HTML/JSON grezzo, parsing manuale |

| Gestione pagine dinamiche | Sì—funziona nel browser, supporta JS, sottopagine, paginazione | No—solo HTML statico |

| Manutenzione | Bassa—l’AI si adatta ai cambiamenti | Alta—gli script si rompono se il sito cambia |

| Integrazione | Export integrati verso strumenti business | Serve codice personalizzato |

| Multilingua/Traduzione | Sì—AI traduce e normalizza i campi | No—solo manuale |

| Scalabilità | Ottimo per lavori medi, non per scraping massivo | Buono per grandi volumi se scriptato |

| Costo | Piano gratuito, versioni a pagamento da ~9$/mese | Gratis, ma richiede tempo sviluppatore |

Per dettagli, leggi il nostro .

L’approccio AI di Thunderbit ti permette di dedicare meno tempo agli script e più ai risultati. Che tu sia sviluppatore o business user, è il modo più rapido per trasformare i dati web in valore aziendale.

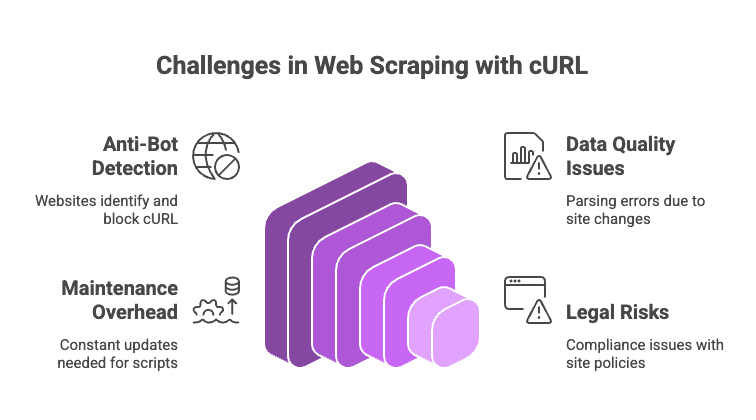

Sfide e Rischi nel Web Scraping con cURL

Fare scraping nel 2025 non è sempre una passeggiata. Ecco cosa tenere d’occhio (e qualche dritta per evitare problemi):

- Sistemi anti-bot: Soluzioni come Cloudflare, Akamai e DataDome riconoscono cURL facilmente. Anche se modifichi gli header, controllano l’esecuzione JS, le impronte TLS e altro. Se incontri un CAPTCHA, cURL non può risolverlo.

- Qualità e coerenza dei dati: Analizzare HTML grezzo con regex o grep è fragile. Basta un piccolo cambiamento nel sito e lo script si rompe.

- Manutenzione: Ogni volta che il sito cambia, devi rimettere mano al codice, ai selettori o al parsing.

- Rischi legali e di compliance: Controlla sempre termini di servizio e privacy policy. Solo perché puoi fare scraping, non significa che devi.

Consigli pratici:

- Alterna user agent e IP se vieni bloccato.

- Inserisci ritardi casuali tra le richieste.

- Usa strumenti come

jqper JSON ehtmlqper HTML. - Per siti dinamici o protetti, valuta strumenti browser-based come Thunderbit o scraping API.

Per una lista completa di rischi (e come evitarli), leggi .

Conclusione: Scegliere il Giusto Approccio al Web Scraping nel 2025

Il mio consiglio: cURL resta imbattibile per scraping rapidi e mirati—soprattutto su API, pagine statiche o per debug. È il modo più veloce per testare un sito e capire cosa si può fare.

Ma se ti serve un output strutturato, contenuti dinamici o workflow aziendali, è il momento di passare a strumenti più avanzati. ti permette di saltare la fatica manuale, gestire siti complessi e ottenere i dati dove ti servono—subito.

Scegli lo strumento giusto per il compito giusto. Per lavori piccoli e scriptabili, cURL è il tuo alleato. Per tutto il resto, lascia che Thunderbit faccia il lavoro pesante.

Domande Frequenti: Web Scraping con cURL nel 2025

1. cURL può gestire contenuti generati da JavaScript?

No. cURL recupera solo l’HTML iniziale. Se i dati vengono caricati via JavaScript, devi trovare l’API sottostante o usare uno strumento browser-based come Thunderbit.

2. Come posso evitare di essere bloccato facendo scraping con cURL?

Imposta header realistici (User-Agent, Accept), alterna IP e user agent, inserisci ritardi tra le richieste e riutilizza i cookie. Per sistemi anti-bot avanzati (come Cloudflare), prova o passa a un browser headless o a una scraping API.

3. Qual è il modo migliore per trasformare l’output di cURL in dati strutturati?

Per JSON, usa jq. Per HTML, grep, sed o parser HTML da linea di comando come htmlq. Per casi complessi, passa a Python con BeautifulSoup o usa Thunderbit per l’estrazione AI.

4. cURL è adatto a progetti di scraping su larga scala?

Può esserlo, ma dovrai gestire manualmente retry, errori, proxy e pulizia dati. Per grandi volumi, framework come Scrapy o strumenti browser-based sono spesso più efficienti.

5. In cosa Thunderbit migliora lo scraping tradizionale con cURL?

Thunderbit automatizza il rilevamento dei campi, gestisce pagine dinamiche, sessioni e sottopagine, ed esporta dati strutturati direttamente negli strumenti aziendali. Niente script, niente selettori, niente manutenzione.

Se vuoi semplificare lo scraping, prova —oppure scarica la nostra e scopri come l’AI può rivoluzionare il tuo workflow.

E se ami ancora il terminale e il cursore lampeggiante? Tranquillo, cURL non sparirà. Ricordati solo di trattare bene i server—e magari offri un caffè al tuo sysadmin preferito.

Vuoi altri consigli su web scraping, automazione e produttività con l’AI? Dai un’occhiata al per guide e approfondimenti sempre aggiornati.