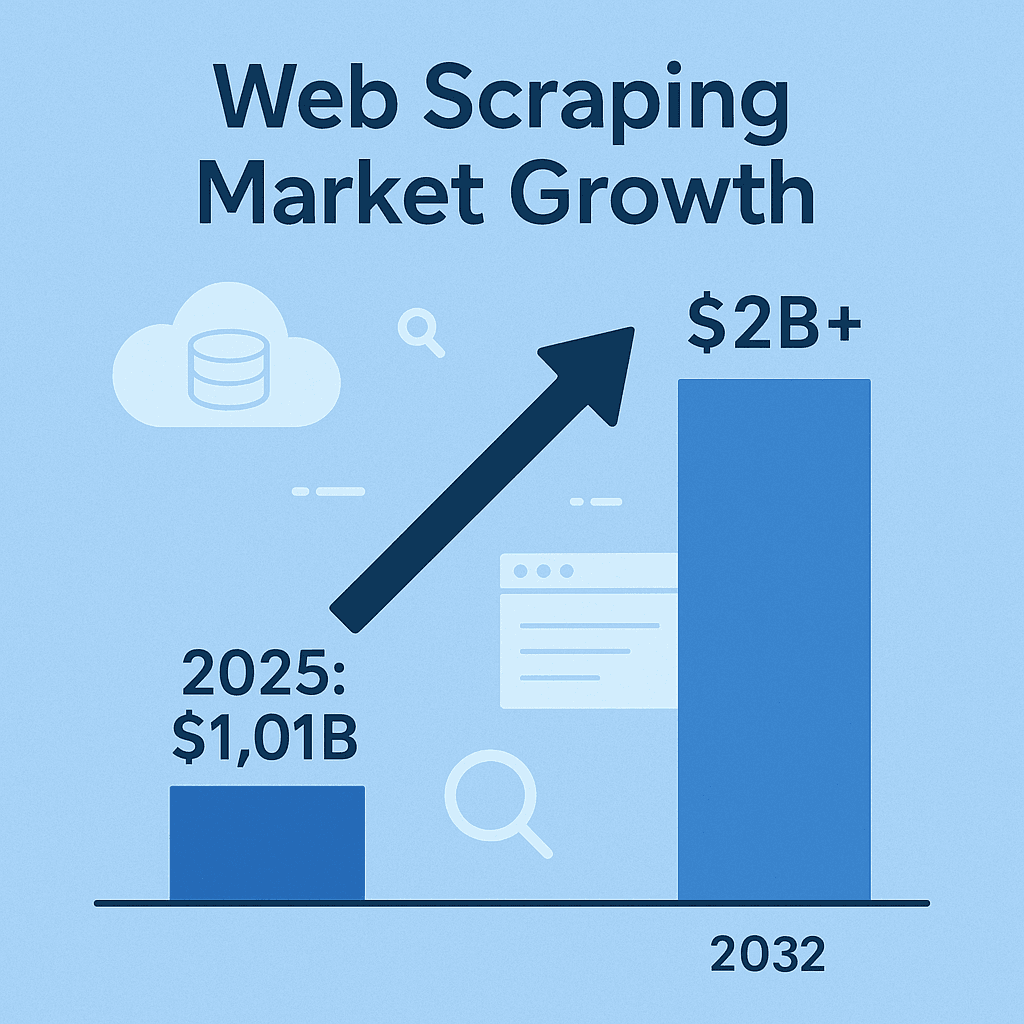

Il web scraping è ormai diventato la carta vincente per chi lavora con l’intelligence aziendale, le vendite e le analisi di mercato. Oggi, se non raccogli dati dal web—che siano prezzi dei concorrenti, cataloghi prodotti, opinioni degli utenti o lead—rischi davvero di restare indietro rispetto a chi già sfrutta queste informazioni. Il mercato dei software per l’estrazione dati dal web ha raggiunto e si prevede che raddoppierà entro il 2032. Non è solo una moda tech: è una vera rivoluzione. E anche se Python è sulla bocca di tutti, Java resta la scelta top per chi cerca affidabilità, velocità e integrazione a livello enterprise.

Dopo anni nel mondo SaaS e dell’automazione, posso dirlo con certezza: il web scraping in Java è più attuale che mai, soprattutto nelle aziende dove contano stabilità, multithreading e integrazione con sistemi di big data. Ma attenzione: estrarre dati non basta. Bisogna farlo in modo efficiente, pulito e—se non vuoi grane legali—seguendo le regole. Rimbocchiamoci le maniche e vediamo insieme le strategie migliori per dominare il web scraping in Java, sia che tu voglia creare un estrattore web su misura sia che tu preferisca velocizzare tutto con strumenti AI come .

Web Scraping in Java: Le Basi da Sapere

In poche parole, l’estrattore web serve per tirare fuori automaticamente informazioni dai siti. Il flusso è semplice: il tuo codice manda una richiesta HTTP a una pagina, riceve l’HTML, lo analizza per trovare i dati che ti servono (prezzi, nomi prodotti, recensioni) e li esporta in un formato che il tuo team può usare—CSV, JSON o direttamente in un database ().

Perché Java? Se Python è perfetto per script veloci, Java è il cavallo di battaglia per progetti di scraping su larga scala, affidabili e di lunga durata. Offre tipizzazione forte, robustezza e una vasta scelta di librerie per networking, parsing HTML e concorrenza. E se la tua pipeline dati o il tuo stack analitico è già in Java, l’integrazione è immediata—senza dover impazzire tra linguaggi diversi ().

In sintesi: gli estrattori web Java possono lavorare per giorni, gestire enormi volumi di dati e integrarsi alla perfezione con il resto dei sistemi aziendali. Ma è fondamentale scegliere gli strumenti giusti per ogni situazione.

Le Principali Librerie e Strumenti Java per il Web Scraping

Ecco i tool Java più usati per il web scraping, ognuno con i suoi punti di forza e limiti:

| Strumento | Ideale per | Punti di forza | Limiti |

|---|---|---|---|

| Jsoup | Pagine HTML statiche, estrazione rapida | Leggero, API semplice, veloce, perfetto per compiti semplici | Non gestisce JavaScript o contenuti dinamici |

| Selenium | Siti dinamici e interattivi | Automatizza browser reali, gestisce JS, supporta azioni utente, grande community | Consuma molte risorse, più lento, fragile se cambia l’interfaccia, richiede driver browser |

| HtmlUnit | Navigazione headless, JS moderato | Tutto Java, esegue un po’ di JS, non richiede browser esterni | Più lento di Jsoup, supporto limitato per JS moderno, nessuna protezione anti-blocco integrata |

| Playwright | Siti moderni ricchi di JS, automazione | Veloce, efficiente, supporta più browser, gestisce pop-up e flussi multi-pagina, auto-waiting | Ecosistema più recente, richiede risorse browser, meno nativo per Java rispetto a Selenium |

(, )

Jsoup: Il Must per l’Estrazione da HTML Statico

è la scelta ideale per chi deve estrarre dati da pagine web statiche. È come avere jQuery in Java: basta Jsoup.connect(URL).get() per ottenere la pagina, poi si usano i selettori CSS per recuperare i dati che ti servono. Vuoi tutti i titoli <h1>? Fatto. Ti servono i nomi dei prodotti in <div class="product-name">? Bastano poche righe.

Esempio: Estrazione dei nomi prodotto da una pagina e-commerce

1Document doc = Jsoup.connect("https://example.com/products").get();

2Elements products = doc.select("div.product-name");

3for (Element product : products) {

4 System.out.println(product.text());

5}Jsoup è veloce, intuitivo e perfetto per blog, cataloghi o articoli di news—ma non esegue JavaScript. Se i dati non sono nell’HTML, Jsoup non li troverà.

Selenium e HtmlUnit: Per i Contenuti Dinamici

A volte i dati sono caricati da JavaScript o nascosti dietro azioni utente (come “Carica altri”). Qui entra in gioco : permette al tuo codice Java di avviare un browser reale (Chrome, Firefox, ecc.), interagire con la pagina e recuperare i contenuti proprio come farebbe una persona.

HtmlUnit è un’alternativa più leggera, tutta in Java, che gestisce un po’ di JavaScript, ma fatica con i siti moderni ricchi di JS. Ottimo per contenuti dinamici semplici, ma per siti in React o Angular meglio Selenium o Playwright.

Quando usare un browser headless: Se devi effettuare login, cliccare pulsanti o estrarre dati che appaiono solo dopo l’esecuzione di script, l’automazione browser è la soluzione. Ma preparati a velocità inferiori e più manutenzione: i siti cambiano spesso struttura.

Playwright: L’Automazione di Nuova Generazione

è la novità del settore, sviluppato da Microsoft per offrire velocità e affidabilità. È fino al 40–50% più rapido di Selenium, supporta diversi motori browser e gestisce scenari complessi come pop-up, infinite scroll e flussi multi-pagina con meno codice. Se devi estrarre dati da siti moderni e dinamici, Playwright merita attenzione.

Come Scegliere lo Strumento Giusto per il Tuo Progetto Java

Non serve sempre un cannone per colpire un bersaglio. Ecco come valutare la scelta:

- Complessità del sito: HTML statico? Vai di Jsoup. JS dinamico? Meglio Selenium o Playwright. Un po’ di JS ma niente di complicato? HtmlUnit può bastare.

- Volume e frequenza dei dati: Estrazione una tantum? Scegli la semplicità. Grandi volumi o attività ricorrenti? Servono strumenti con supporto al multithreading e gestione robusta degli errori.

- Facilità d’uso vs. flessibilità: Jsoup si impara in fretta. Selenium/Playwright sono più potenti, ma richiedono più configurazione e manutenzione.

- Requisiti e budget: Le librerie open source sono gratuite, ma tutto il lavoro è sulle tue spalle. API a pagamento o servizi cloud fanno risparmiare tempo, ma hanno un costo.

Tabella di confronto:

| Criterio | Jsoup | Selenium | HtmlUnit | Playwright |

|---|---|---|---|---|

| HTML statico | ✔️ | ✔️ | ||

| JS dinamico | ✔️ | (parziale) | ✔️ | |

| Velocità | ✔️ | ✔️ | ||

| Facilità d’uso | ✔️ | |||

| Gestione login/click | ✔️ | (base) | ✔️ | |

| Grandi volumi/Parallelo | ✔️ | (più difficile) | (ok) | ✔️ |

| Economico | ✔️ | ✔️ | ✔️ | ✔️ |

Parti semplice, aumenta la complessità solo se serve. E non aver paura di combinare più strumenti: spesso la soluzione migliore è ibrida.

Thunderbit: Web Scraping Semplificato per Sviluppatori Java

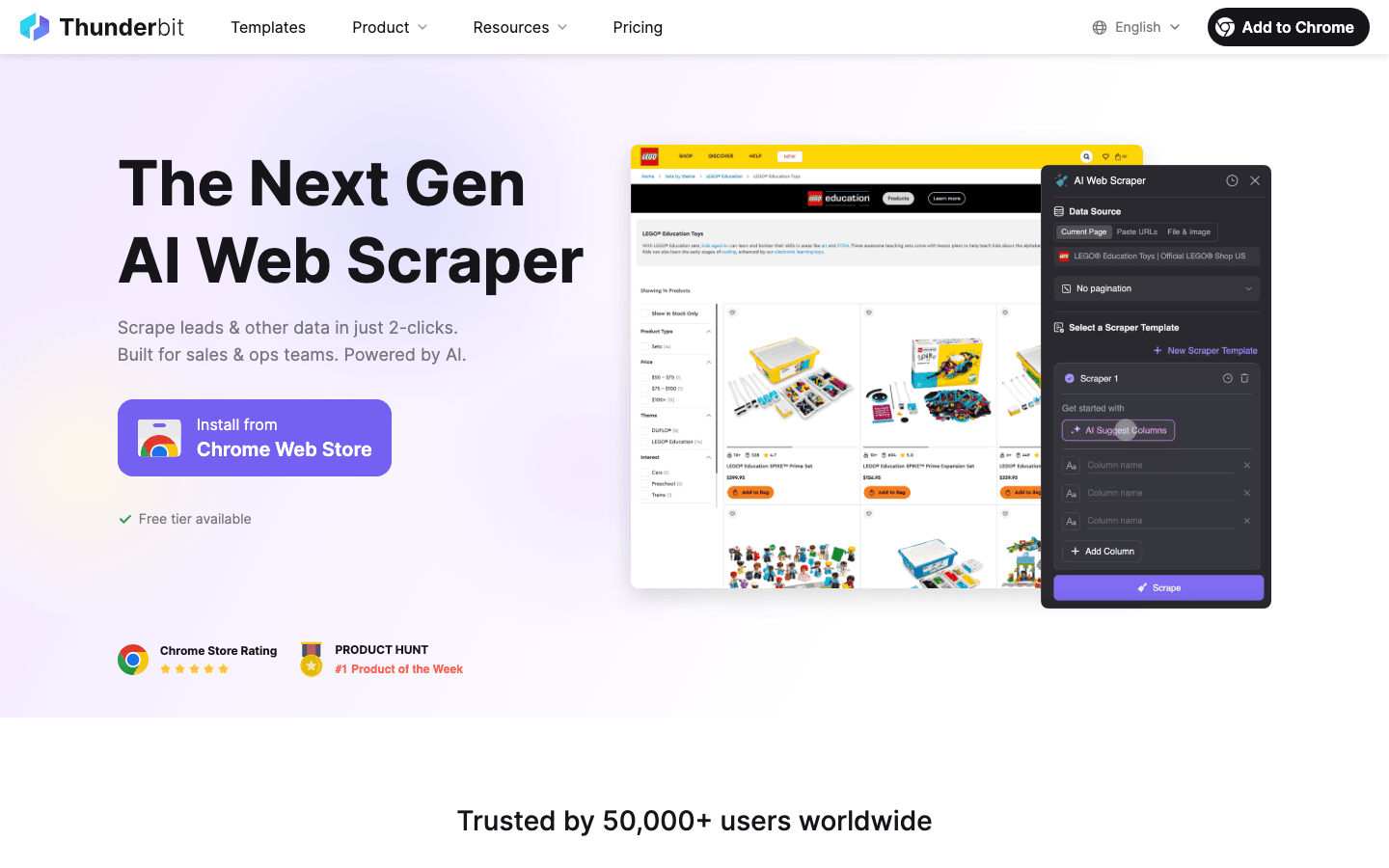

Parliamo ora di ciò che ha rivoluzionato il lavoro di tanti team: . Thunderbit è un Estrattore Web AI come estensione Chrome che ti permette di estrarre dati strutturati da qualsiasi sito in pochi click—senza codice, senza template, senza complicazioni.

Come Thunderbit aiuta sviluppatori Java e utenti business:

- Campi suggeriti dall’AI: L’intelligenza artificiale di Thunderbit analizza la pagina e suggerisce le colonne migliori da estrarre. Niente più ricerca di selettori CSS o parsing fragile.

- Navigazione tra sottopagine: Hai bisogno di dettagli da pagine collegate? Thunderbit può cliccare automaticamente sui link e arricchire il tuo dataset—ideale per cataloghi con pagine di dettaglio.

- Gestione di paginazione e infinite scroll: Thunderbit scorre, clicca su “Avanti” e continua finché non ha raccolto tutti i dati.

- Esportazione strutturata: Esporta direttamente su Excel, Google Sheets, Airtable o Notion. Oppure scarica in CSV/JSON e integra nel tuo progetto Java.

- Scraping in cloud o browser: Esegui scraping nel cloud (fino a 50 pagine alla volta—veloce!) o nel browser per siti che richiedono login.

- Schedulazione: Imposta scraping giornalieri, settimanali o su misura. L’AI di Thunderbit capisce anche la programmazione in linguaggio naturale (“ogni lunedì alle 9”).

Per chi sviluppa in Java, Thunderbit è un enorme risparmio di tempo per prototipi, raccolte rapide o anche flussi produttivi—soprattutto se vuoi dare autonomia ai colleghi non tecnici.

Thunderbit: Un Ponte tra Sviluppatori e Team Operativi

Thunderbit non è solo per sviluppatori. Team di vendita, marketing, e-commerce e immobiliare lo usano ogni giorno per:

- Generare lead: Estrai contatti da elenchi, LinkedIn o liste di eventi—senza scrivere codice.

- Monitorare la concorrenza: Tieni d’occhio prezzi, cataloghi o strategie dei competitor con scraping programmati.

- Aggregare annunci: Raccogli offerte di prodotti, immobili o lavoro da più siti in una tabella strutturata.

Ho visto team passare da “ci servirebbero questi dati” a “ecco il file Excel” in meno di 10 minuti. E con scraping di sottopagine e rilevamento AI dei campi, anche i siti più caotici diventano accessibili.

Garantire la Qualità dei Dati nei Progetti di Web Scraping Java

Raccogliere dati è solo metà del lavoro. Se i dati sono sporchi, incompleti o vecchi, rischi di prendere decisioni sbagliate. Ecco come tengo sotto controllo i miei estrattori web (e la mia sanità mentale):

- Valida e pulisci: Controlla accuratezza, completezza e coerenza. Sfrutta la tipizzazione di Java per intercettare valori anomali (es. prezzo “N/A” invece di un numero). Normalizza formati—date, valute, numeri di telefono—per dati pronti all’analisi ().

- Elimina i duplicati: I dati estratti sono spesso pieni di doppioni. Usa chiavi univoche (URL o ID) e le collezioni

Setdi Java per filtrarli. - Automatizza i controlli qualità: Dopo ogni scraping, verifica: hai ottenuto il numero atteso di elementi? Ci sono campi improvvisamente vuoti? Registra anomalie e imposta alert se qualcosa non torna.

- Archivia i dati in modo intelligente: Per grandi volumi, salva i dati in un database (Postgres, MongoDB, ecc.) invece che in memoria. I database aiutano a mantenere lo schema e a deduplicare facilmente ().

Gestione Errori e Robustezza: Estrattori Web Affidabili

Il web scraping è una disciplina “da contatto”. I siti vanno giù, l’HTML cambia, scattano misure anti-bot. Ecco come evitare che il tuo estrattore web si blocchi:

- Gestione elegante degli errori: Intercetta errori HTTP (404, 500), timeout ed eccezioni di parsing. Riprova le richieste fallite con backoff esponenziale—non martellare il server ().

- Resilienza ai cambiamenti: Usa selettori robusti, controlli null e logica di fallback. Se la struttura della pagina cambia, registra l’HTML grezzo per il debug.

- Logging e alert: Registra ogni richiesta, successo e fallimento. Imposta alert per problemi critici—come zero risultati quando ne aspettavi 100.

- Checkpoint: Nei job lunghi, salva periodicamente i progressi. Se l’estrattore web si blocca, puoi ripartire da dove eri rimasto.

- Limita le richieste: Sii educato—pausa tra le richieste, limita la concorrenza e ruota gli User-Agent per evitare blocchi.

Esempio di logica di retry in Java:

1Document doc = null;

2for (int attempt = 1; attempt <= MAX_RETRIES; attempt++) {

3 try {

4 doc = Jsoup.connect(url).timeout(5000).get();

5 break;

6 } catch (IOException e) {

7 log("Tentativo " + attempt + " fallito: " + e.getMessage());

8 Thread.sleep(1000 * attempt); // Backoff esponenziale

9 }

10}()

Rispettare le Regole: Aspetti Legali ed Etici del Web Scraping

Il web scraping non è una zona franca. Ci sono regole precise—ignorarle può portare a ban, cause legali o peggio.

- Rispetta la proprietà dei dati: Estrarre dati pubblici e non sensibili è generalmente legale, ma i dati personali (nomi, email) sono protetti da normative come GDPR e CCPA. Non raccogliere dati personali senza una base legale ().

- Segui i Termini di Servizio e robots.txt: Se un sito vieta lo scraping, rispettalo—o sappi che ti assumi un rischio. Rispetta sempre robots.txt e i limiti di frequenza.

- Non sovraccaricare i server: Limita le richieste, usa una concorrenza ragionevole e non estrarre dati in modo aggressivo da rallentare il sito ().

- Evita contenuti protetti o dietro login: Non estrarre e ripubblicare materiale protetto da copyright e non accedere a dati dietro login senza permesso.

- Proteggi e anonimizza i dati: Se raccogli informazioni sensibili, archiviale in modo sicuro e rispetta le richieste di cancellazione.

Consigli Pratici per uno Scraping Etico

- Leggi i Termini di Servizio e robots.txt prima di estrarre dati.

- Usa uno User-Agent significativo (non solo “Java/1.8.0_201”).

- Limita la frequenza e la concorrenza delle richieste.

- Preferisci API ufficiali o dataset pubblici quando disponibili.

- Tieni traccia di cosa estrai e perché.

- Rimani aggiornato su leggi e best practice ().

Ottimizzare le Prestazioni: Scalare il Tuo Estrattore Web Java

Quando le esigenze crescono, le performance diventano cruciali. Ecco come scalare senza impazzire (o mandare in tilt il server):

- Parallelizza le richieste: Usa

ExecutorServiceo thread pool di Java per estrarre più pagine in parallelo. Controlla la concorrenza per non sovraccaricare il sito (). - Scrivi i dati in streaming: Salva i risultati su database o file man mano che li ottieni—non tenere tutto in memoria.

- Parsing efficiente: Usa i selettori di Jsoup per estrazioni mirate. Per grandi volumi, valuta parsing più leggero o in streaming.

- Sfrutta il cloud: Esegui gli estrattori web su server cloud per maggiore banda e affidabilità. Oppure usa piattaforme cloud di scraping (come la modalità cloud di Thunderbit) per grandi volumi.

- Ottimizza la rete: Usa compressione, esegui gli estrattori web vicino ai target e sfrutta la cache quando possibile.

Esempio di scraping multithread in Java:

1ExecutorService pool = Executors.newFixedThreadPool(10);

2for (String url : urlList) {

3 pool.submit(() -> scrapePage(url));

4}

5pool.shutdown();()

In Sintesi: I Punti Chiave per il Successo nel Web Scraping Java

Ricapitoliamo cosa serve per diventare esperti di web scraping in Java:

- Scegli lo strumento giusto: Jsoup per pagine statiche, Selenium/Playwright per siti dinamici, HtmlUnit per scraping headless in Java.

- Sfrutta automazione e AI: Usa strumenti come per velocizzare il rilevamento dei campi, lo scraping di sottopagine e l’esportazione dati—ideale per utenti business o prototipi rapidi.

- Punta sulla qualità dei dati: Valida, pulisci, elimina i duplicati e archivia i dati in modo intelligente.

- Rimani conforme: Rispetta i limiti legali ed etici—estrai solo dati pubblici, segui le regole dei siti e non trattare dati personali senza base legale.

- Ottimizza per la scalabilità: Usa la concorrenza di Java, storage efficiente e risorse cloud per gestire grandi volumi.

Il web scraping non è solo una competenza tecnica—è una vera marcia in più per il business. Che tu sia uno sviluppatore Java o un professionista sales/ops che usa Thunderbit per automatizzare la raccolta dati, seguire queste best practice ti porterà al successo.

Vuoi provare lo scraping AI? e scopri quanto è facile trasformare qualsiasi sito in un dataset strutturato. E se vuoi approfondire, visita il per guide, confronti e casi reali.

Domande Frequenti

1. Perché Java è ancora una scelta valida per il web scraping?

Java offre affidabilità, multithreading avanzato e integrazione perfetta con i sistemi enterprise. È ideale per scraping su larga scala, job di lunga durata o ad alte prestazioni—soprattutto se la pipeline dati è già in Java ().

2. Qual è la differenza tra Jsoup, Selenium, HtmlUnit e Playwright?

Jsoup è perfetto per HTML statico; Selenium e Playwright gestiscono siti dinamici e ricchi di JS; HtmlUnit è un browser headless tutto Java per JS moderato. Scegli in base alla complessità del sito e alle esigenze del progetto ().

3. Come aiuta Thunderbit sviluppatori Java e utenti business?

Thunderbit sfrutta l’AI per automatizzare il rilevamento dei campi, la navigazione tra sottopagine e la strutturazione dei dati—senza codice. È perfetto per utenti business o sviluppatori che vogliono prototipare o dare autonomia ai colleghi non tecnici ().

4. Quali sono le best practice per garantire la qualità dei dati nello scraping?

Valida e pulisci i dati, elimina i duplicati, automatizza i controlli qualità e archivia i risultati in database per grandi volumi. Considera sempre i dati estratti come materia grezza da lavorare ().

5. Come rimanere conformi ed etici nello scraping di dati web?

Estrai solo dati pubblici e non sensibili; rispetta robots.txt e i termini dei siti; non sovraccaricare i server; non raccogliere dati personali senza base legale. Rimani aggiornato su normative come GDPR e CCPA ().

Pronto a portare il tuo web scraping al livello successivo? Prova gratis Thunderbit o crea il tuo estrattore web Java seguendo queste best practice. Buon scraping—e ricorda: programma con responsabilità, rispetta l’etica e verifica sempre i dati prima di prendere decisioni importanti.

Per Approfondire