Immagina la scena: hai appena messo online il tuo sito, pronto a conquistare nuovi clienti, e invece ti accorgi che metà delle visite... sono fatte da robot. Non quelli dei film, ma crawler digitali: motori di ricerca, bot AI, spider di analytics—tutti che girano sul tuo sito 24 ore su 24, come ospiti invisibili che non se ne vanno mai. Nel 2026, questa non è più una stranezza nei log del server: è la nuova normalità. Capire chi (o cosa) sta scansionando il tuo sito, quanto spesso e perché, è diventato fondamentale per chiunque lavori online.

Dopo anni nel mondo SaaS, automazione e intelligenza artificiale, ho visto il web crawling passare da dettaglio tecnico a questione centrale per le aziende. I numeri parlano chiaro: oggi i bot generano quasi metà del traffico globale, e in certi settori superano addirittura gli utenti reali. Con l’arrivo dei crawler AI che raccolgono dati per addestrare modelli linguistici avanzati, le conseguenze sono enormi—per la tua infrastruttura, il budget e la reputazione del brand. Vediamo insieme le statistiche più fresche sul web crawling, i benchmark di settore e cosa significano per il tuo business nel 2026.

Web Crawling nel 2026: Uno sguardo d’insieme

Il web crawling ha raggiunto una scala e una complessità mai viste prima. Ogni giorno, miliardi di richieste automatiche attraversano la rete, generate da una varietà sempre più ampia di crawler. Prima i protagonisti erano i bot dei motori di ricerca come Googlebot e Bingbot, che indicizzavano le pagine per renderle trovabili dagli utenti. Oggi, però, si sono aggiunti nuovi attori: crawler AI, scraper dei social, bot di analytics e molti altri.

Il dato che colpisce di più: , e in alcune zone il traffico dei bot supera quello umano. Sulla rete Cloudflare, . Il punto? Questa crescita non è solo colpa dei motori di ricerca, ma sempre più dei crawler AI che raccolgono dati per alimentare chatbot e strumenti generativi.

Il panorama è più vario che mai:

- Bot “buoni”: Indicizzatori di ricerca, monitor di uptime, scraper legittimi.

- Bot “cattivi”: Spam, tentativi di hacking, scraping non autorizzato.

- Crawler AI: I nuovi arrivati, che raccolgono contenuti per addestrare l’AI e fornire risposte in tempo reale.

I crawler AI si comportano in modo diverso rispetto ai classici bot dei motori di ricerca. Spesso scaricano l’intero contenuto delle pagine per analisi semantiche, non solo per indicizzare parole chiave, e operano a volumi altissimi—fino a milioni di richieste in pochi giorni. Il risultato? , fondendo l’indicizzazione classica con la fame di dati dell’AI.

Statistiche chiave sul Web Crawling che ogni azienda dovrebbe conoscere

Entriamo nei numeri che stanno cambiando il web nel 2026. Queste statistiche non sono solo curiosità: sono parametri che dovrebbero guidare le tue scelte su infrastruttura, contenuti e investimenti.

Bot vs. Umani: chi domina il traffico?

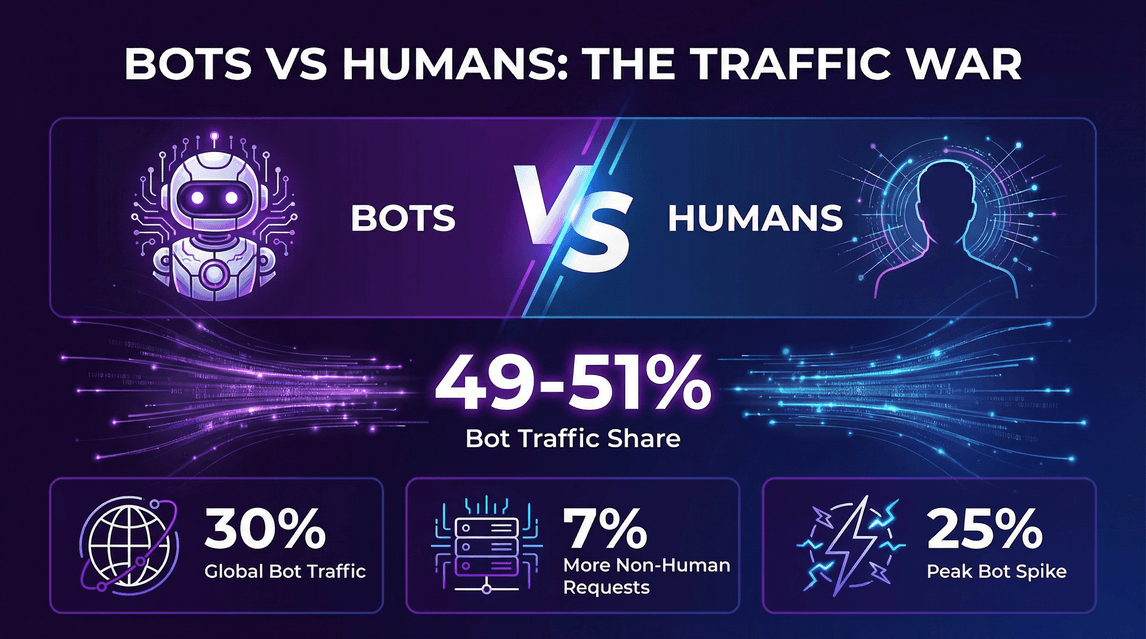

- Il 49–51% di tutto il traffico internet è ora generato da bot, con richieste automatiche che eguagliano o superano quelle degli utenti reali ().

- Dati Cloudflare: .

- Le richieste non umane alle pagine HTML sono state circa il 7% in più rispetto a quelle umane ().

- In certi momenti, il traffico dei bot .

L’ondata dei crawler AI

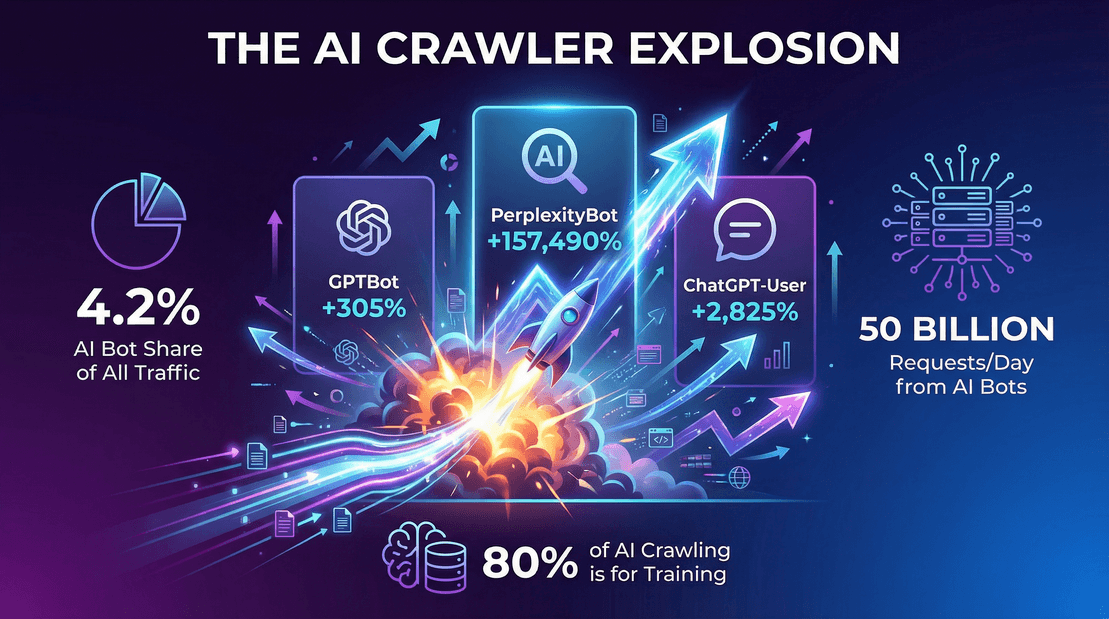

- I bot orientati all’AI hanno generato il 4,2% di tutte le richieste alle pagine HTML nel 2025 ().

- GPTBot di OpenAI: Da zero a , con una crescita del 305% in un anno.

- Bot di Perplexity.ai: .

- Googlebot: , rappresentando circa il 50% di tutte le richieste dei crawler di ricerca/AI.

Il traffico dei crawler in pratica

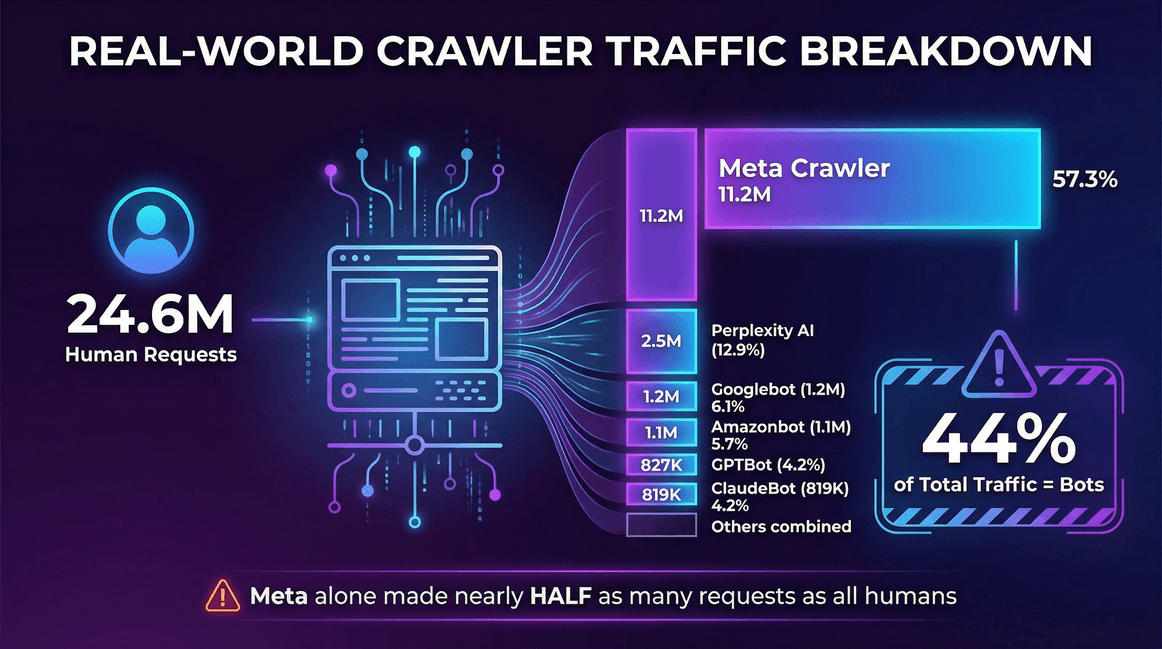

Ecco un esempio reale dai log server di un :

| Fonte traffico | Richieste (mensili) | Quota crawler |

|---|---|---|

| Utenti reali (umani) | 24.647.904 | -- |

| Meta Crawler (Facebook) | 11.175.701 | 57,3% |

| Perplexity AI | 2.512.747 | 12,9% |

| Googlebot | 1.180.737 | 6,1% |

| Amazonbot | 1.120.382 | 5,7% |

| OpenAI GPTBot | 827.204 | 4,2% |

| ClaudeBot (Anthropic) | 819.256 | 4,2% |

| Bingbot | 599.752 | 3,1% |

| ChatGPT-User (OpenAI) | 557.511 | 2,9% |

| Ahrefs Crawler | 449.161 | 2,3% |

| ByteDance Spider | 267.393 | 1,4% |

In questo caso, i bot hanno generato il 44% del traffico totale—e solo il crawler di Meta ha fatto quasi la metà delle richieste rispetto a tutti gli utenti reali messi insieme.

Il quadro generale

- Il traffico dei crawler (ricerca + AI) è cresciuto del 18% tra maggio 2024 e maggio 2025 su un campione costante di siti ().

- I bot per l’addestramento LLM hanno rappresentato quasi l’80% di tutto il traffico “bot” su alcune grandi CDN ().

- Sulla rete Cloudflare, a fine 2025 si sono registrate circa 50 miliardi di richieste giornaliere da parte dei soli bot AI ().

L’ascesa dei crawler AI: come l’intelligenza artificiale sta cambiando il web crawling

Parliamo dell’elefante (o meglio, del robot) nella stanza: i crawler AI. Questi bot non si limitano a indicizzare il tuo sito per la ricerca, ma ne assorbono i contenuti per addestrare modelli linguistici o fornire risposte istantanee basate sull’AI. E lo fanno a una scala che mette in ombra anche i motori di ricerca più ambiziosi.

Cosa alimenta il boom dei crawler AI?

- Modelli AI affamati di dati: I LLM moderni hanno bisogno di dataset enormi e vari. Il web è il loro buffet, e i tuoi contenuti sono nel menu.

- Addestramento vs. risposte in tempo reale: , non solo per rispondere a domande live.

- Nuovi pattern di crawling: I bot AI possono colpire i siti con ondate di richieste, anche milioni di pagine in pochi giorni, specie durante aggiornamenti o retraining.

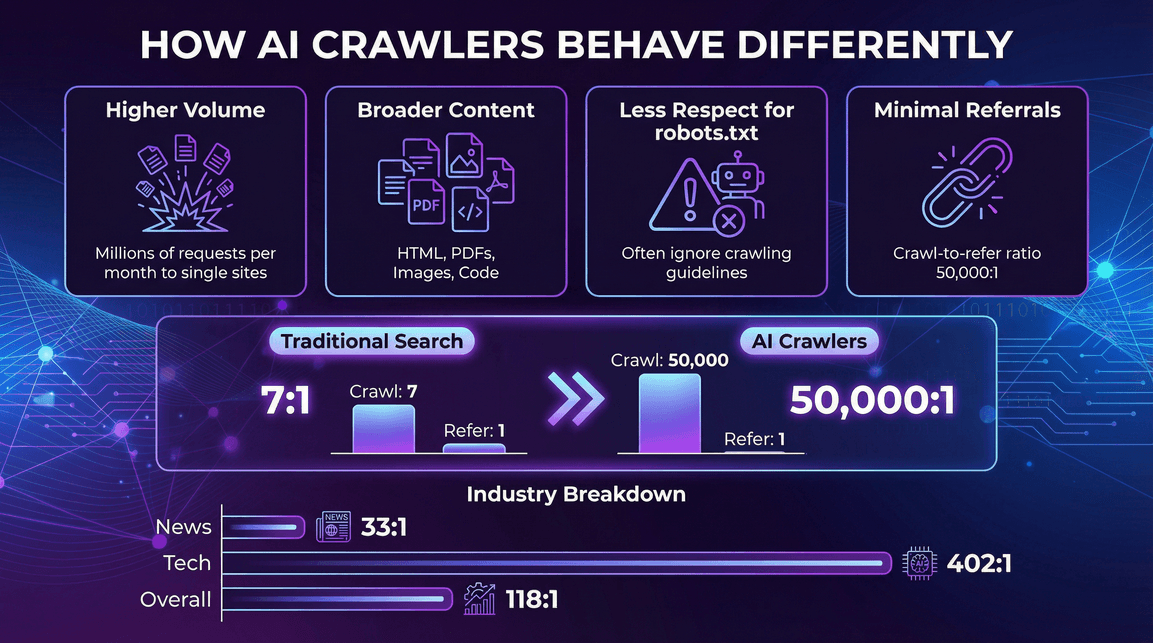

Come si comportano diversamente i crawler AI

- Volume molto più alto per singolo bot: Un solo crawler AI può generare milioni di richieste mensili verso un sito ().

- Tipologie di contenuti più ampie: Non solo HTML, ma anche PDF, immagini, codice e altro.

- Rispetto limitato per robots.txt: Alcuni crawler AI ignorano o seguono solo parzialmente le regole di crawling ().

- Referral quasi nullo: Diversamente dai motori di ricerca, i crawler AI raramente portano traffico di ritorno. .

Traffico dei crawler AI per settore

Non tutti i settori sono colpiti allo stesso modo. Ad esempio:

- News & Editoria: Forte attività dei crawler AI, ma rapporti referral leggermente migliori (es. Perplexity ha un rapporto crawl-to-refer di 33:1 sulle news, contro 118:1 generale) ().

- Tecnologia & Elettronica: Dominano GPTBot e Amazonbot, con rapporti referral comunque alti (es. OpenAI arriva a 402:1 nel tech) ().

- Finanza, accademia e altri: Ogni settore ha la sua combinazione di bot e referral, ma la tendenza è chiara: i crawler AI sono ovunque e raramente portano traffico di ritorno.

I principali crawler del web nel 2026: chi domina la scena?

Chi sono i protagonisti di questa corsa al crawling? Ecco la classifica, secondo i dati Cloudflare di metà 2025:

| Crawler (Proprietario) | % di crawling (Maggio 2025) | Crescita YoY richieste |

|---|---|---|

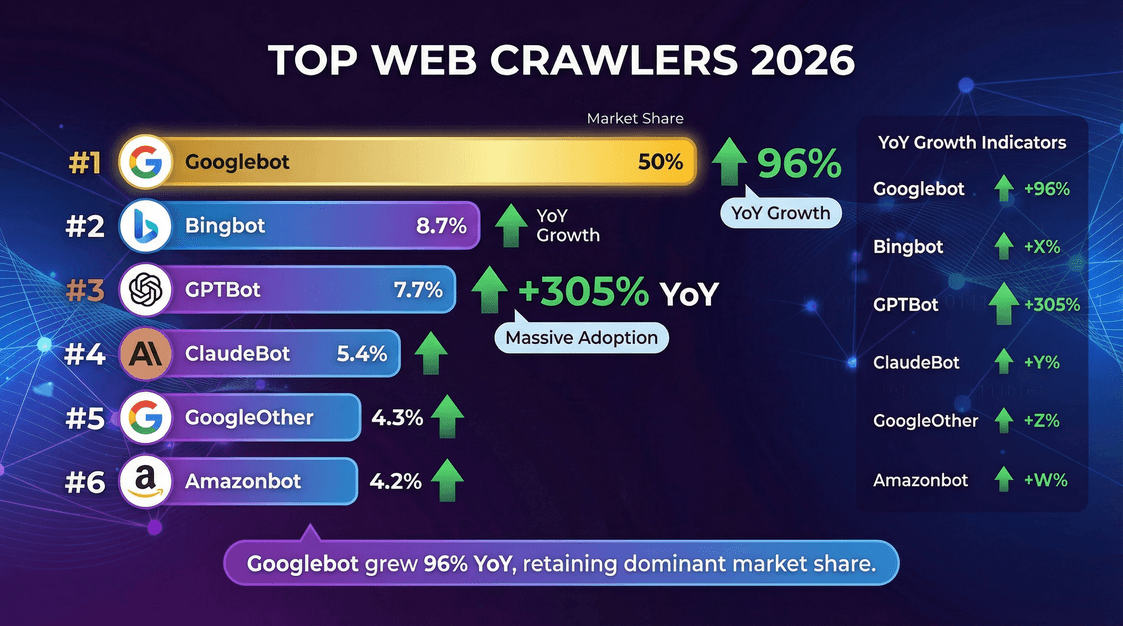

| Googlebot (Google) | 50,0% | +96% |

| Bingbot (Microsoft) | 8,7% | +2% |

| GPTBot (OpenAI) | 7,7% | +305% |

| ClaudeBot (Anthropic) | 5,4% | –46% |

| GoogleOther (Google) | 4,3% | +14% |

| Amazonbot (Amazon) | 4,2% | –35% |

| Googlebot-Image (Google) | 3,3% | –13% |

| Bytespider (ByteDance) | 2,9% | –85% |

| YandexBot (Yandex) | 2,2% | –10% |

| ChatGPT-User (OpenAI) | 1,3% | +2825% |

| Applebot (Apple) | 1,2% | –26% |

| PerplexityBot | 0,2% | +157.490% |

Qualche spunto interessante:

- Googlebot resta il leader assoluto, responsabile della metà di tutta l’attività di crawling.

- GPTBot e il crawler di Meta sono quelli che crescono più in fretta, con GPTBot che ha triplicato la sua quota in un anno.

- PerplexityBot e ChatGPT-User sono ancora piccoli come quota, ma crescono a ritmi impressionanti.

Parametri di riferimento del Web Crawling: velocità, throughput e performance

Il web crawling non è solo questione di volume, ma anche di efficienza e rapidità. Ecco cosa sapere su velocità di crawling e benchmark nel 2026.

Il web crawling non è solo questione di volume, ma anche di efficienza e rapidità. Ecco cosa sapere su velocità di crawling e benchmark nel 2026.

Crawl rate: quanto sono veloci i crawler?

- Crawl rate: di solito si misura in pagine al secondo (o richieste al secondo) ().

- Thread/connessioni parallele: Più thread = maggiore velocità. Ad esempio, 200 thread con 2 secondi di attesa per sito permettono circa 100 pagine al secondo ().

- Benchmark reali: 100–200 pagine al secondo sono tipici per un crawler ottimizzato su un cluster server adeguato.

- Google e Bing: Probabilmente raggiungono migliaia di pagine al secondo a livello globale, distribuite su milioni di siti.

Fattori che influenzano la velocità di crawling

- Numero di thread/fetcher paralleli: Più thread, più velocità (fino a saturare altre risorse).

- Numero di siti attivi: Scansionare più domini in parallelo aumenta il throughput.

- Delay tra le richieste: Attese più lunghe = crawling più lento.

- Limiti di risorse: Banda, CPU, velocità di scrittura del database possono essere colli di bottiglia.

- Performance del sito target: Siti lenti o con limiti rallentano il crawling.

Ad esempio, con 100 thread e 1 secondo di attesa per sito, puoi raggiungere circa 100 pagine al secondo—ma se il database non regge, il limite sarà lo storage, non la rete.

L’impatto del Web Crawling sul business: costi, opportunità e rischi

Il web crawling non è solo una questione tecnica, ma un tema di business, con costi e opportunità reali.

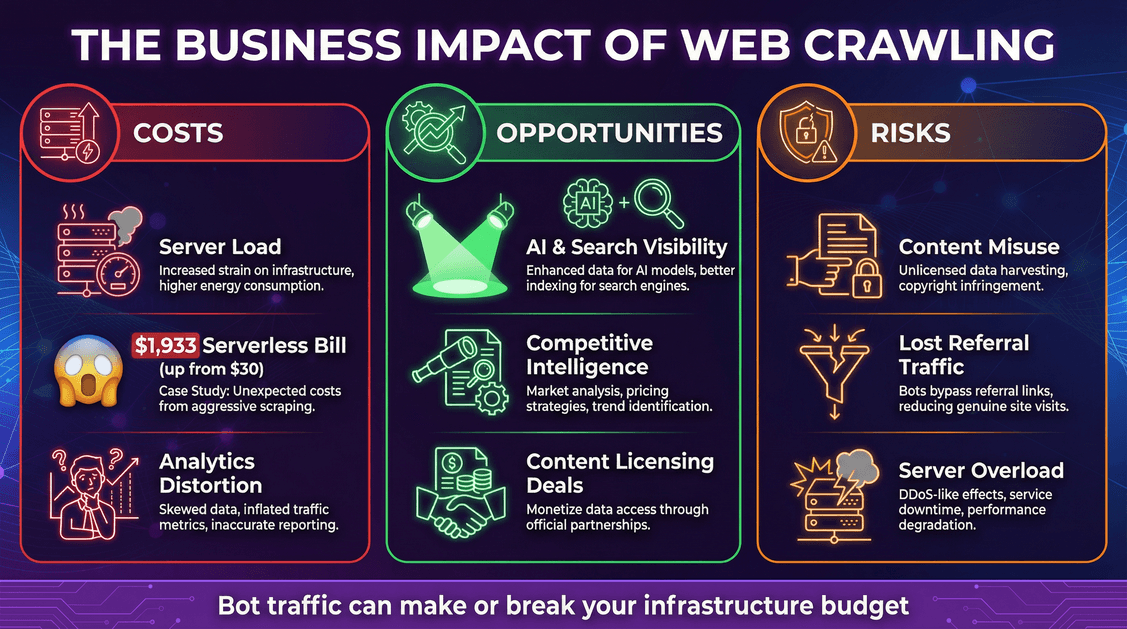

Costi: infrastruttura e spese impreviste

- Carico sui server: Ogni richiesta di bot consuma CPU, memoria e banda.

- Costi cloud: Se usi modelli pay-per-use (come serverless), i bot possono far schizzare le spese. Un developer ha visto .

- Dati analytics distorti: I bot possono falsare le statistiche web, rendendo difficile capire il comportamento reale degli utenti.

Opportunità: visibilità e valore dei dati

- Visibilità su AI e ricerca: Essere inclusi nei dati di training AI o negli indici di ricerca può ampliare la portata del tuo brand ().

- Intelligence competitiva: Le aziende usano i crawler per ricerche di mercato, monitoraggio prezzi e altro.

- Monetizzazione: Alcuni editori ora .

Rischi: abuso dei contenuti e perdita di traffico

- Abuso dei contenuti: I crawler AI possono inglobare i tuoi contenuti nei loro modelli, spesso senza permesso o compenso.

- Perdita di referral: Le risposte AI possono soddisfare gli utenti senza rimandarli al tuo sito, causando “disintermediazione”.

- Sicurezza e downtime: Crawler aggressivi possono sovraccaricare i server, causando rallentamenti o interruzioni.

Come gestire il traffico dei crawler: best practice

Come evitare che i bot prosciughino risorse (e budget cloud)?

1. Ottimizza il tuo robots.txt

- Usa

robots.txtper consentire o bloccare specifici bot. I crawler affidabili (come Googlebot) lo rispettano, molti bot AI invece no (). - A metà 2025, circa il 14% dei siti più visitati aveva inserito regole specifiche per i bot AI ().

2. Usa strumenti di gestione dei bot

- Web Application Firewall (WAF) e servizi di gestione bot possono bloccare o limitare il traffico sospetto.

- Cloudflare e altri offrono funzioni di mitigazione bot e persino strumenti “AI Audit” per i creatori di contenuti ().

3. Implementa rate limiting e caching

- Limita la frequenza delle richieste da parte di un singolo bot.

- Servi contenuti in cache ai bot quando possibile—evita che attivino funzioni serverless costose o query al database ().

4. Monitora e analizza il traffico dei bot

- Tieni d’occhio i log del server. Scopri quali bot ti colpiscono, quanto spesso e quando.

- Imposta alert per picchi di traffico insoliti.

5. Rimani aggiornato sugli standard emergenti

- Segui l’evoluzione di meta tag o header HTTP per i permessi AI (es.

<meta name="ai:allow" content="no">). - Tieni d’occhio iniziative come ) e protocolli di pagamento come .

Tendenze del Web Crawling da seguire nel 2026 e oltre

Il mondo del web crawling si sta muovendo velocemente. Ecco cosa sto tenendo d’occhio (e cosa dovresti monitorare anche tu):

- Il crawling guidato dall’AI è destinato a crescere: Aspettati ancora più bot AI, che esploreranno sempre più tipi di contenuti (testi, immagini, video).

- Standard per licenze e pagamenti dei contenuti: Il “Far West” sta lasciando spazio a e .

- Arrivano le regolamentazioni: Prevedi maggiore chiarezza legale su cosa possono (e non possono) fare i bot, soprattutto per i dati di training AI ().

- Standard tecnici per l’uso dei contenuti: Nuovi meta tag, estensioni robots.txt e dichiarazioni machine-readable per i bot.

- Collaborazione publisher-AI: Sempre più editori negozieranno feed strutturati o API per le aziende AI, invece di subire passivamente il crawling.

Conclusioni: cosa significano queste statistiche per il tuo business

Ecco il punto: il web crawling è una forza dominante nel 2026 e la sua crescita non accenna a fermarsi. I bot automatici—soprattutto i crawler AI—sono ormai responsabili di una fetta enorme del traffico, e il loro impatto su infrastruttura, budget e strategia contenuti è sempre più rilevante.

Cosa dovresti fare?

- Prevedi traffico bot elevato: Pianifica infrastruttura, budget e monitoraggio di conseguenza.

- Conosci i tuoi crawler: Non tutti i bot sono uguali—adatta la tua strategia a ciascuno.

- Monitora i tuoi dati: Tieni traccia del traffico bot come fai con quello umano.

- Proteggi contenuti e risorse: Usa controlli tecnici, accordi legali e nuovi standard.

- Sfrutta le opportunità: Essere inclusi in indici AI e di ricerca può dare visibilità—assicurati solo di ottenere valore in cambio.

- Rimani aggiornato e flessibile: Il panorama cambia in fretta. Segui nuovi standard, regolamenti e modelli di business.

Dopo anni a sviluppare strumenti di automazione e AI (e ora in ), posso dirti che le aziende che prosperano in questa nuova era sono quelle che trattano il web crawling come una priorità strategica, non solo come un fastidio tecnico. Che tu sia in vendita, ecommerce, marketing o immobiliare, conoscere le statistiche e i benchmark del web crawling è ormai indispensabile.

Quindi, la prossima volta che controlli i log del server e vedi una sfilata di bot, non limitarti a sospirare. Usa quei dati. Confronta il tuo sito. Adatta le tue strategie. E ricorda: nell’era dell’AI, i bot non stanno arrivando—sono già qui. Falli lavorare per te, non il contrario.

Resta vigile, resta curioso e che i tuoi log siano sempre dalla tua parte.

Vuoi approfondire web scraping, automazione e produttività con l’AI? Dai un’occhiata al per guide, approfondimenti e le ultime novità. E se vuoi gestire i tuoi dati in autonomia, prova la per l’estrazione web AI—senza codice, senza complicazioni, solo risultati.

Fonti e approfondimenti: