Immagina la scena: sono le 8:30, hai appena messo su il caffè e il tuo capo (o magari il capo del tuo capo) ti chiede un file Excel con i prezzi dei prodotti di tutti i concorrenti, le recensioni dei clienti e—perché no—anche la pizza preferita del loro CEO. Potresti passare ore a copiare e incollare, oppure lasciare che Python faccia il lavoro sporco. Ma se non sai programmare, o non vuoi passare la mattinata a litigare con errori HTML? Ecco perché questa guida fa proprio al caso tuo.

Mi chiamo Shuai Guan, sono co-fondatore e CEO di , e da anni mi occupo di SaaS, automazione e intelligenza artificiale, aiutando i team a trasformare il caos dei dati online in informazioni utili. In questo articolo ti presento le 10 migliori librerie python per web scraping del 2025: cosa fanno, come funzionano, pro, contro e quando usarle. E se stai pensando "Tutto interessante, ma Python non fa per me", nessun problema: ti mostro anche come ottenere gli stessi risultati con l’Estrattore Web AI di Thunderbit, senza scrivere una riga di codice—bastano due click, senza stress e senza bisogno di caffè extra.

Perché le librerie python per web scraping sono una marcia in più per le aziende

- Lead Generation & Vendite: Raccogli dati da elenchi, social o forum per creare liste di contatti mirate—nomi, email, profili social e altro. I team commerciali possono automatizzare attività che prima richiedevano ore di ricerca manuale ().

- Monitoraggio prezzi & analisi competitiva: I team e-commerce possono monitorare in tempo reale prezzi, disponibilità e promozioni dei concorrenti, adattando rapidamente le proprie strategie ().

- Ricerche di mercato & analisi trend: Analizzare recensioni, social media o siti di notizie aiuta marketing e product manager a individuare tendenze e opinioni dei clienti prima che diventino mainstream ().

- Dati immobiliari: Agenti e analisti possono aggregare annunci, prezzi e dettagli da più portali, semplificando l’analisi del mercato.

- Operazioni e-commerce: Dal controllo dei fornitori all’audit dei cataloghi, l’automazione dell’estrattore web aiuta ad avere dati precisi e libera i team da operazioni manuali infinite.

In poche parole? . Ma c’è un problema: la maggior parte delle librerie python per web scraping richiede di saper programmare. Per chi non è tecnico, può essere un ostacolo. Ecco perché strumenti no-code e AI come stanno spopolando—ne parliamo tra poco.

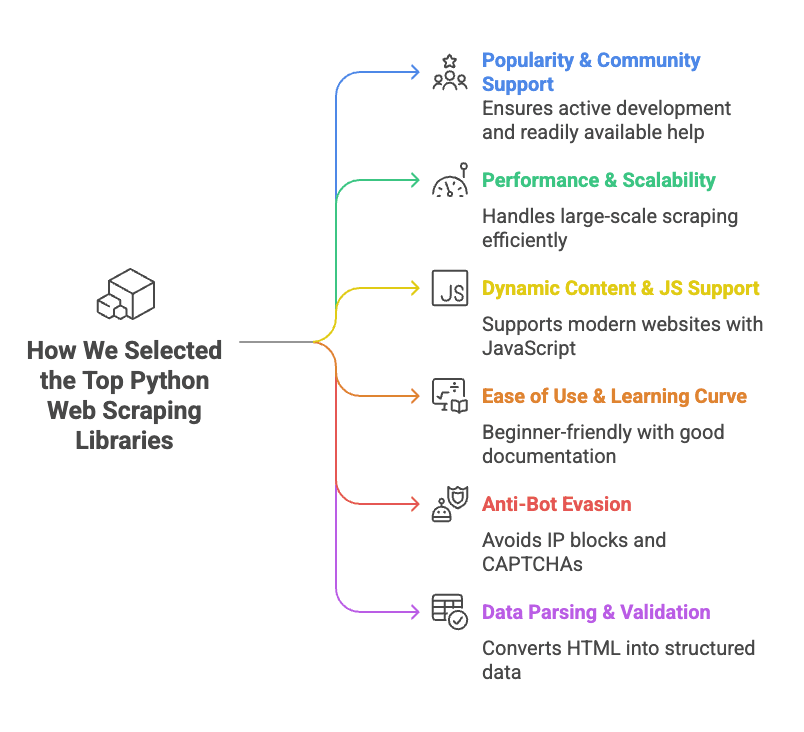

Come abbiamo selezionato le migliori librerie python per web scraping

- Popolarità & supporto della community: Abbiamo scelto librerie con tante stelle su GitHub, sviluppo attivo e documentazione abbondante. Se hai un problema, vuoi trovare risposte subito.

- Prestazioni & scalabilità: Il tool regge migliaia di pagine? Supporta richieste asincrone o parallele? È veloce o ti fa rimpiangere di non aver preso uno stagista?

- Supporto per contenuti dinamici & JavaScript: Molti siti moderni caricano dati via JavaScript. Le librerie che gestiscono contenuti dinamici (tramite automazione browser o API) hanno preso più punti.

- Facilità d’uso & curva di apprendimento: Alcuni strumenti sono plug-and-play, altri ti fanno sudare. Abbiamo dato priorità a quelli più accessibili o ben spiegati.

- Evasione anti-bot: Il tool gestisce blocchi IP, CAPTCHA o limiti di frequenza? Altrimenti rischi di essere bloccato dopo pochi minuti di scraping.

- Parsing & validazione dei dati: Non basta estrarre l’HTML—serve trasformarlo in dati puliti e ordinati. Le librerie che aiutano in questa fase hanno ricevuto punti extra.

Per ogni libreria, trovi una panoramica, come si usa, pro e contro e i casi d’uso ideali.

Tabella comparativa veloce: le principali librerie python per web scraping

Ecco una panoramica delle 10 librerie più usate, così puoi capire subito quale fa al caso tuo (e magari stupire il capo con qualche termine tech nuovo):

| Libreria | Facilità d’uso | Supporto JS | Richieste HTTP | Parsing HTML | Funzioni anti-bot | Validazione dati | Ideale per |

|---|---|---|---|---|---|---|---|

| ZenRows | Facilissima (API) | ✅ (browser) | ✅ (API) | ✅ | ✅ (proxy, bypass CAPTCHA) | ❌ | Scraping su larga scala di siti protetti |

| Selenium | Media | ✅ (browser) | ✅ (browser) | Parziale | ❌ | ❌ | Siti dinamici e interattivi |

| Requests | Facilissima | ❌ | ✅ | ❌ | ❌ | ❌ | Pagine statiche, API |

| Beautiful Soup | Facile | ❌ | ❌ | ✅ | ❌ | ❌ | Parsing HTML da pagine statiche |

| Playwright | Media | ✅ (browser) | ✅ (browser) | Accesso DOM | ❌ | ❌ | Web app moderne, supporto multi-browser |

| Scrapy | Media/Difficile | Parziale (add-on) | ✅ (async) | ✅ | ❌ | Limitata | Crawling strutturato su larga scala |

| urllib3 | Facile (basso livello) | ❌ | ✅ | ❌ | ❌ | ❌ | HTTP personalizzato, alta concorrenza |

| HTTPX | Facile/Media | ❌ (async IO) | ✅ (async) | ❌ | ❌ | ❌ | Scraping ad alte prestazioni, asincrono |

| lxml | Media | ❌ | ❌ | ✅ (veloce) | ❌ | ❌ | Parsing veloce di HTML/XML complessi |

| Pydantic | Media | N/A | N/A | N/A | N/A | ✅ | Validazione dati dopo lo scraping |

Nota: “Supporto JS” indica la capacità di gestire contenuti generati da JavaScript. “Funzioni anti-bot” si riferisce a quelle integrate, non a soluzioni personalizzate.

ZenRows: La soluzione all-in-one per web scraping in Python

Cos’è?

è un’API per estrattore web che si occupa di tutto: proxy rotanti, bypass CAPTCHA, fingerprinting del browser e rendering JavaScript. Basta una chiamata API e ZenRows ti restituisce la pagina pronta.

Come si usa:

Registrati per la chiave API, poi usa la libreria requests di Python per chiamare ZenRows:

1import requests

2url = "<https://example.com>"

3apikey = "<YOUR_ZENROWS_API_KEY>"

4params = {

5 "url": url,

6 "apikey": apikey,

7 "js_render": "true",

8 "premium_proxy": "true"

9}

10response = requests.get("<https://api.zenrows.com/v1/>", params=params)

11print(response.text[:500])Pro:

- Supera la maggior parte delle difese anti-bot (proxy, CAPTCHA, ecc.)

- Gestisce siti pieni di JavaScript

- API semplice—non devi gestire browser o proxy

- Scalabile per grandi volumi

Contro:

- Servizio a pagamento (prova gratuita, ma l’uso continuativo ha un costo)

- Dipendenza da un servizio esterno

Ideale per:

Scraping su larga scala, soprattutto su siti che bloccano i bot o richiedono rendering JavaScript. Se sei stufo di blocchi e CAPTCHA, ZenRows è da provare ().

Selenium: Automazione browser per scraping dinamico

Cos’è?

è il nonno dell’automazione browser. Ti permette di controllare Chrome, Firefox o altri browser da Python, simulando click, compilazione di form, scroll e altro. Tutto quello che può fare un utente, Selenium lo può automatizzare.

Come si usa:

Installa Selenium e un driver browser (es. ChromeDriver), poi:

1from selenium import webdriver

2from selenium.webdriver.chrome.options import Options

3options = Options()

4options.add_argument("--headless=new")

5driver = webdriver.Chrome(options=options)

6driver.get("<https://example.com>")

7html = driver.page_source

8print(html[:200])

9driver.quit()Pro:

- Gestisce qualsiasi sito accessibile da browser (contenuti dinamici, login, pop-up)

- Simula interazioni utente (click, digitazione, ecc.)

- Supporto multi-browser

Contro:

- Consuma molte risorse (ogni istanza browser usa RAM e CPU)

- Più lento rispetto allo scraping via HTTP

- Curva di apprendimento più ripida (soprattutto per la concorrenza)

- Può essere rilevato da sistemi anti-bot avanzati

Ideale per:

Scraping di siti dinamici e interattivi che richiedono azioni utente—come LinkedIn, dashboard o aree protette da login ().

Requests: Il client HTTP di riferimento in Python

Cos’è?

è la libreria "HTTP for Humans". È il modo più semplice e diffuso per recuperare pagine web o API in Python—affidabile e facile da usare.

Come si usa:

Recupera una pagina statica:

1import requests

2response = requests.get("<https://www.example.com>")

3if response.status_code == 200:

4 html_text = response.text

5 print(html_text[:300])Pro:

- API semplicissima

- Veloce e leggero

- Gestisce cookie, redirect e la maggior parte delle esigenze HTTP

- Community enorme, tantissimi tutorial

Contro:

- Non esegue JavaScript né gestisce contenuti dinamici

- Non fa parsing HTML (da abbinare a Beautiful Soup o lxml)

- Nessuna funzione anti-bot integrata (devi gestire header, proxy, ecc.)

Ideale per:

Pagine statiche, API o siti dove i dati sono già nell’HTML iniziale. Requests + Beautiful Soup è la combo classica per chi inizia ().

Beautiful Soup: Parsing HTML semplice per Python

Cos’è?

(BS4) è una libreria python per analizzare HTML e XML. Non scarica le pagine—va usata insieme a Requests o Selenium—ma rende facile trovare ed estrarre dati dall’HTML.

Come si usa:

Estrai i nomi dei prodotti da una pagina:

1from bs4 import BeautifulSoup

2import requests

3html = requests.get("<https://example.com/products>").text

4soup = BeautifulSoup(html, "html.parser")

5product_names = [tag.get_text() for tag in soup.find_all("h2", class_="product-name")]

6print(product_names)Pro:

- Facile da usare, tollera HTML "sporco"

- Ricerca flessibile (per tag, classi, selettori CSS, regex)

- Leggera e veloce per la maggior parte degli usi

- Tanta documentazione ed esempi

Contro:

- Non scarica pagine né gestisce JavaScript

- Più lenta di lxml su documenti molto grandi

- Meno potente per query complesse (usa lxml per XPath avanzati)

Ideale per:

Trasformare HTML grezzo in dati strutturati—elenchi prodotti, tabelle, link. Se hai già l’HTML, Beautiful Soup ti aiuta a estrarre ciò che ti serve ().

Playwright: Automazione browser moderna per Python

Cos’è?

è la novità nell’automazione browser, sviluppata da Microsoft. Come Selenium, controlla i browser, ma è più veloce, supporta più motori (Chromium, Firefox, WebKit) e ha un’API più moderna.

Come si usa:

Recupera il contenuto di una pagina:

1from playwright.sync_api import sync_playwright

2with sync_playwright() as p:

3 browser = p.chromium.launch(headless=True)

4 page = browser.new_page()

5 page.goto("<https://example.com>")

6 content = page.content()

7 print(content[:200])

8 browser.close()Pro:

- Gestisce siti dinamici e ricchi di JavaScript

- Supporto multi-browser (Chromium, Firefox, WebKit)

- Attende automaticamente gli elementi (meno errori rispetto a Selenium)

- Supporta asincronia e parallelismo

Contro:

- Consuma risorse (automazione browser)

- Curva di apprendimento, soprattutto per il codice asincrono

- Non immune ai sistemi anti-bot

Ideale per:

Web app moderne, siti che si comportano diversamente su browser diversi, o quando serve intercettare richieste di rete ().

Scrapy: Framework python per scraping su larga scala

Cos’è?

è un framework completo per web scraping. Ideale per crawling su larga scala, offre concorrenza integrata, pipeline di dati e opzioni di esportazione. Se devi gestire migliaia di pagine, Scrapy è la scelta giusta.

Come si usa:

Definisci uno spider:

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["<http://quotes.toscrape.com>"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 'text': quote.css("span.text::text").get(),

9 'author': quote.css("small.author::text").get()

10 }Esegui con scrapy crawl quotes all’interno di un progetto Scrapy.

Pro:

- Alte prestazioni, concorrenza integrata

- Struttura chiara (spider, pipeline, middleware)

- Esportazione facile in CSV, JSON, database

- Grande community, molti plugin

Contro:

- Curva di apprendimento ripida per chi inizia

- Richiede setup di progetto (non ideale per piccoli task)

- Supporto JavaScript limitato (servono add-on)

Ideale per:

Crawling ripetuto e strutturato—ad esempio aggregare annunci immobiliari da più siti o cataloghi prodotti ().

Urllib3: HTTP affidabile per scraping in Python

Cos’è?

è una libreria HTTP di basso livello che alimenta anche Requests. Se vuoi controllo totale su connessioni, retry o pool, urllib3 è la scelta giusta.

Come si usa:

Recupera una pagina:

1import urllib3

2http = urllib3.PoolManager()

3resp = http.request("GET", "<http://httpbin.org/html>")

4if resp.status == 200:

5 html_text = resp.data.decode('utf-8')

6 print(html_text[:100])Pro:

- Pool di connessioni veloce ed efficiente

- Thread-safe, ottimo per scraping concorrente

- Controllo dettagliato del comportamento HTTP

Contro:

- Più lavoro manuale rispetto a Requests

- Nessun parsing HTML o supporto JS

- Meno documentazione per principianti

Ideale per:

Scenari HTTP personalizzati, scraping ad alta concorrenza o quando serve la massima efficienza ().

HTTPX: Libreria python moderna e asincrona per scraping

Cos’è?

è il client HTTP di nuova generazione per Python. Simile a Requests, ma con supporto nativo per async e HTTP/2. Se vuoi fare scraping di migliaia di pagine in parallelo, HTTPX è perfetto.

Come si usa:

Sincrono:

1import httpx

2response = httpx.get("<https://httpbin.org/get>")

3if response.status_code == 200:

4 data = response.json()

5 print(data)Asincrono:

1import httpx, asyncio

2urls = ["<https://example.com/page1>", "<https://example.com/page2>"]

3async def fetch(url, client):

4 resp = await client.get(url)

5 return resp.status_code

6async def scrape_all(urls):

7 async with httpx.AsyncClient(http2=True) as client:

8 tasks = [fetch(u, client) for u in urls]

9 results = await asyncio.gather(*tasks)

10 print(results)

11asyncio.run(scrape_all(urls))Pro:

- Supporto async per scraping ad alta concorrenza

- Supporto HTTP/2 (più veloce su molti siti)

- API simile a Requests (migrazione facile)

- Gestione errori migliorata

Contro:

- Più recente, meno tutorial rispetto a Requests

- Async richiede conoscenza degli event loop

- Nessun parsing HTML integrato

Ideale per:

Scraping ad alto volume, API o quando serve velocità ().

lxml: Parsing HTML/XML veloce e potente per Python

Cos’è?

è una libreria ad alte prestazioni per analizzare HTML e XML, con supporto per XPath e selettori CSS. È il motore dietro molti altri strumenti (inclusi i selettori di Scrapy).

Come si usa:

Estrai citazioni e autori:

1import requests

2from lxml import html

3page = requests.get("<http://quotes.toscrape.com>").content

4tree = html.fromstring(page)

5quotes = tree.xpath('//div[@class="quote"]/span[@class="text"]/text()')

6authors = tree.xpath('//div[@class="quote"]/small[@class="author"]/text()')

7print(list(zip(quotes, authors)))Pro:

- Velocissimo, anche su documenti grandi

- Supporto potente per XPath (query complesse)

- Efficiente in memoria

Contro:

- Curva di apprendimento per la sintassi XPath

- Documentazione meno accessibile rispetto a BS4

- Installazione a volte complessa

Ideale per:

Parsing di HTML/XML complessi o voluminosi, o quando servono query avanzate ().

Pydantic: Validazione dati per risultati di scraping puliti

Cos’è?

non è uno scraper, ma una libreria per validare e modellare dati. Dopo lo scraping, Pydantic ti aiuta a garantire che i dati siano puliti, tipizzati e pronti per l’uso aziendale.

Come si usa:

Valida i dati estratti:

1from pydantic import BaseModel, validator

2from datetime import date

3class ProductItem(BaseModel):

4 name: str

5 price: float

6 listed_date: date

7 @validator('price')

8 def price_must_be_positive(cls, v):

9 if v <= 0:

10 raise ValueError('price must be positive')

11 return v

12raw_data = {"name": "Widget", "price": "19.99", "listed_date": "2025-02-15"}

13item = ProductItem(**raw_data)

14print(item.price, type(item.price))

15print(item.listed_date, type(item.listed_date))Pro:

- Validazione rigorosa (individua errori subito)

- Conversione automatica dei tipi (stringhe in numeri, date, ecc.)

- Modelli dichiarativi (codice chiaro e manutenibile)

- Gestisce dati complessi e annidati

Contro:

- Curva di apprendimento per la sintassi dei modelli

- Aggiunge un po’ di overhead alla pipeline

Ideale per:

Garantire che i dati estratti siano puliti, coerenti e pronti per analisi o importazione ().

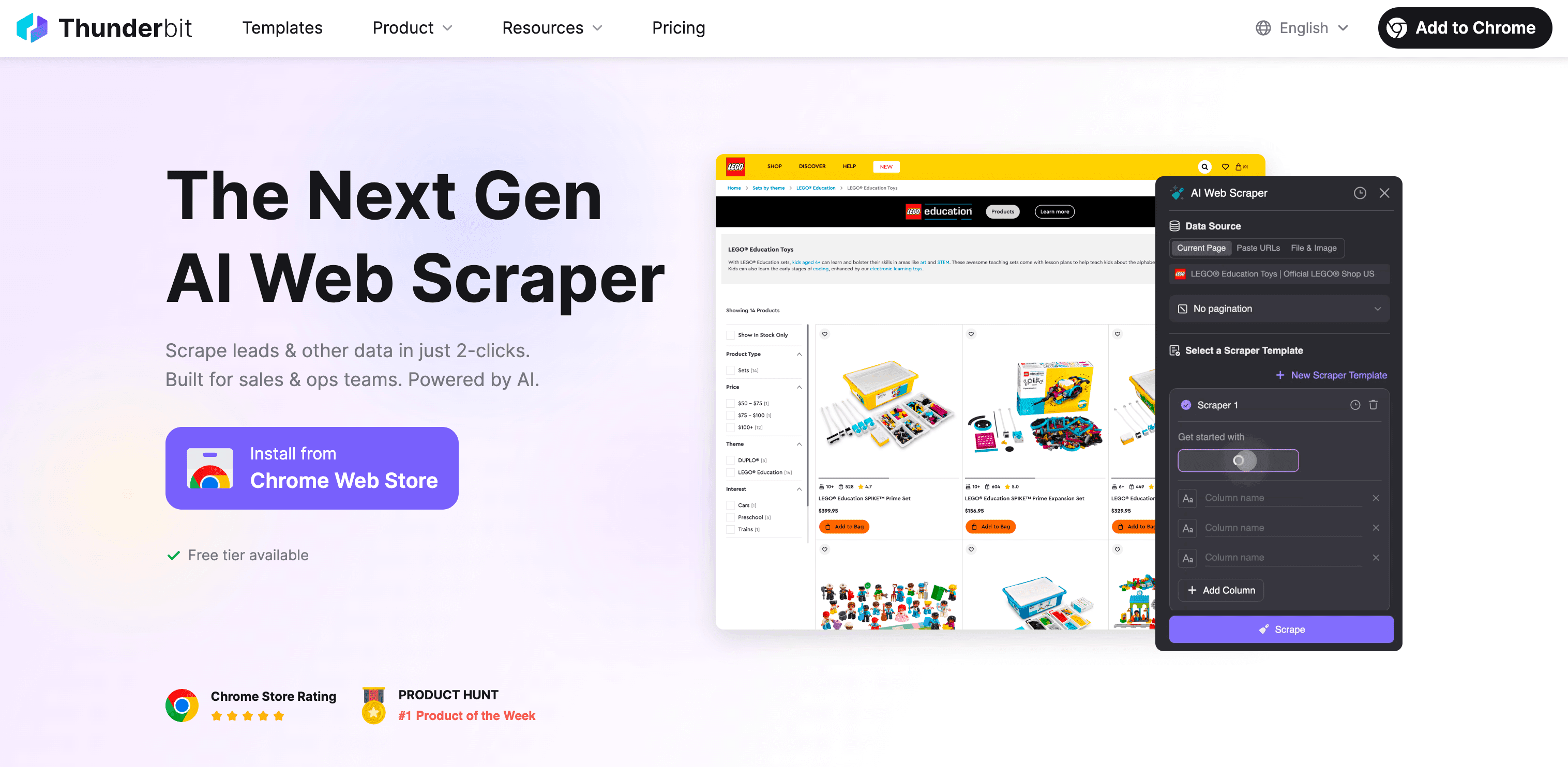

Alternativa no-code: Thunderbit Estrattore Web AI per utenti business

Parliamoci chiaro: se sei arrivato fin qui e pensi ancora "Python è potente, ma non voglio imparare XPath nel weekend", non sei il solo. È proprio per questo che abbiamo creato .

Cos’è Thunderbit?

Thunderbit è un’estensione Chrome per estrattore web AI senza codice. Pensata per utenti business—commerciali, e-commerce, marketing, agenti immobiliari—che hanno bisogno di dati dal web ma non vogliono occuparsi di codice, proxy o problemi anti-bot.

Perché Thunderbit è meglio delle librerie python per chi non programma:

- Nessuna programmazione: Basta cliccare su “AI Suggerisci Campi”, lasciare che l’AI di Thunderbit legga la pagina e premere “Estrai”. Puoi estrarre dati da qualsiasi sito, PDF o immagine in due click.

- Gestisce contenuti dinamici: Thunderbit lavora nel browser (o in cloud), quindi può estrarre dati anche da siti con JavaScript, scroll infinito o aree protette da login.

- Estrazione da sottopagine: Vuoi raccogliere dettagli da ogni pagina prodotto o profilo? Thunderbit visita ogni sottopagina e arricchisce la tua tabella in automatico.

- Strutturazione dati AI: Thunderbit suggerisce nomi dei campi, tipi di dato e persino prompt personalizzati. Puoi etichettare, formattare, tradurre e organizzare i dati in tempo reale.

- Resilienza anti-bot: Niente proxy o rischi di blocco—Thunderbit sfrutta sessioni browser reali e AI per aggirare la maggior parte delle difese anti-scraping.

- Esportazione ovunque: Scarica i dati su Excel, Google Sheets, Airtable, Notion, CSV o JSON—gratis e senza limiti.

- Template pronti: Per i siti più popolari (Amazon, Zillow, Instagram, Shopify, ecc.), scegli un template e parti subito. Nessuna configurazione.

- Funzionalità gratuite: Estrazione di email, telefoni e immagini è gratuita. Anche l’autocompletamento AI per i form online.

Come si confronta con le librerie python?

| Funzionalità | Librerie Python | Thunderbit |

|---|---|---|

| Richiede codice | Sì | No |

| Contenuti dinamici | A volte (browser) | Sì (browser/cloud) |

| Gestione anti-bot | Manuale (proxy, header) | Integrata (sessione browser, AI) |

| Strutturazione dati | Manuale (codice, parsing) | AI, automatica |

| Estrazione sottopagine | Codice personalizzato | 1 click |

| Esportazione | CSV/JSON (codice) | Excel, Google Sheets, Airtable, Notion, ecc. |

| Template | Fai-da-te o community | Pronti per i siti più usati |

| Manutenzione | A carico tuo | Aggiornamenti gestiti dal team Thunderbit |

A chi è rivolto Thunderbit?

Se lavori in vendite, e-commerce, marketing o immobiliare e ti servono dati dal web—lead, prezzi, info prodotto, annunci immobiliari—ma non hai un background tecnico, Thunderbit è pensato per te. È il modo più rapido per passare da "Mi serve questo dato" a "Ecco il file Excel", senza Python.

Vuoi vederlo in azione? e provala gratis. Oppure scopri altri consigli sul .

Conclusione: come scegliere la libreria python (o lo strumento no-code) giusto per il web scraping

Tiriamo le somme. Le librerie python per web scraping sono potenti, flessibili e adatte a quasi ogni scenario—se hai confidenza con il codice e vuoi investire tempo. Ecco un riassunto veloce:

- ZenRows: Perfetto per scraping su larga scala di siti protetti, con funzioni anti-bot integrate.

- Selenium & Playwright: Ideali per siti dinamici e interattivi, ma più complessi e pesanti.

- Requests & HTTPX: Ottimi per pagine statiche e API; HTTPX brilla per scraping asincrono e veloce.

- Beautiful Soup & lxml: I migliori per il parsing HTML—BS4 per chi inizia, lxml per chi cerca velocità e potenza.

- Scrapy: Il framework per crawling strutturato su grandi volumi.

- urllib3: Per esigenze HTTP personalizzate e alta concorrenza.

- Pydantic: Per assicurare che i dati estratti siano puliti e pronti all’uso.

Ma se non sei uno sviluppatore—o vuoi solo ottenere i dati in fretta— è la scorciatoia. Niente codice, niente manutenzione, solo risultati.

Il mio consiglio:

- Se ami Python e vuoi il massimo controllo, scegli la libreria più adatta alle tue esigenze e competenze.

- Se vuoi solo i dati (e magari dormire un po’ di più), lascia che l’AI di Thunderbit faccia il lavoro per te.

In ogni caso, il web è pieno di dati pronti a diventare insight. Che tu sia un esperto Python o un utente business che non vuole toccare codice, nel 2025 c’è lo strumento giusto per te. E se vuoi parlare di scraping, automazione o pizze preferite dai CEO, sai dove trovarmi.

Buon scraping!

Domande frequenti

1. Quali sono le librerie python più usate per il web scraping?

Tra le librerie python più popolari per il web scraping ci sono Requests per pagine statiche, Selenium per siti dinamici con JavaScript e Scrapy per crawling su larga scala. La scelta dipende dalla complessità dei dati, dalla necessità di concorrenza e dal livello di dinamicità dei contenuti.

2. Come gestire siti web ricchi di JavaScript durante lo scraping?

Per siti con molti contenuti generati da JavaScript, Selenium e Playwright sono ottime soluzioni. Permettono di simulare le azioni di un utente e caricare i dati dinamici. ZenRows è un’altra opzione, con un’API semplice che gestisce JavaScript e supera i blocchi anti-bot senza configurazioni aggiuntive.

3. In che modo Thunderbit può aiutare la mia azienda con il web scraping?

Thunderbit è un estrattore web AI senza codice che permette agli utenti business di raccogliere dati dal web senza programmare. Che tu abbia bisogno di prezzi dei concorrenti, lead o dati prodotto, Thunderbit semplifica tutto grazie all’automazione AI, gestendo contenuti dinamici, funzioni anti-bot ed esportazione in pochi click.

Scopri di più: