Lascia che ti racconti la prima volta che ho provato a tirare fuori dati di prodotto da un sito ecommerce. Avevo Python già pronto, una bella tazza di caffè e un obiettivo chiaro: creare un tracker prezzi per Amazon. Dopo qualche ora, il mio “lavoretto veloce” era diventato un casino di selettori XPath, problemi con la paginazione e sessioni infinite di debug. Se ti sei mai cimentato a raccogliere dati dal web scrivendo codice, sai bene di cosa parlo: entusiasmo misto a “ma perché deve essere così complicato?”

La verità è che oggi l’estrazione dati dal web non è più una roba da data scientist o sviluppatori. È diventata una competenza chiave anche per chi lavora in commerciale, ecommerce, marketing o per chiunque voglia trasformare il caos del web in informazioni utili per il business. Basti pensare che il mercato dei software per l’estrazione dati dal web ha toccato , e la crescita non accenna a fermarsi. Python e framework come Scrapy restano lo standard per progetti su larga scala e super personalizzati, ma non sono certo la soluzione più immediata per chi parte da zero. Ecco perché, in questo tutorial, ti porto passo passo nell’uso di Scrapy con un esempio reale su Amazon—e ti faccio vedere anche un’alternativa molto più semplice e guidata dall’AI per chi non vuole programmare: .

Cos’è Scrapy Python? Il Tuo Alleato per l’Estrattore Web

Partiamo dalle basi. Scrapy è un framework open-source in Python pensato proprio per il crawling e l’estrazione dati dal web. Immaginalo come una cassetta degli attrezzi completa per costruire “spiders” (così li chiama Scrapy) che navigano tra le pagine, seguono link, gestiscono la paginazione ed estraggono dati strutturati su larga scala.

Cosa cambia rispetto a usare solo requests e BeautifulSoup di Python? Queste librerie sono perfette per estrazioni semplici e una tantum, ma Scrapy è pensato per progetti complessi e di grandi dimensioni—quando devi:

- Esplorare migliaia di pagine (tipo tutto il catalogo di un ecommerce)

- Seguire link e gestire la paginazione in automatico

- Processare dati in modo asincrono per andare più veloce

- Strutturare, pulire ed esportare dati in modo ripetibile

In poche parole, Scrapy è il coltellino svizzero dell’estrazione web: potente, flessibile e (diciamolo) un po’ tosto per chi è alle prime armi.

Perché Scegliere Scrapy Python per il Web Scraping?

Perché sviluppatori e team dati continuano a preferire Scrapy? Ecco una panoramica dei suoi punti forti:

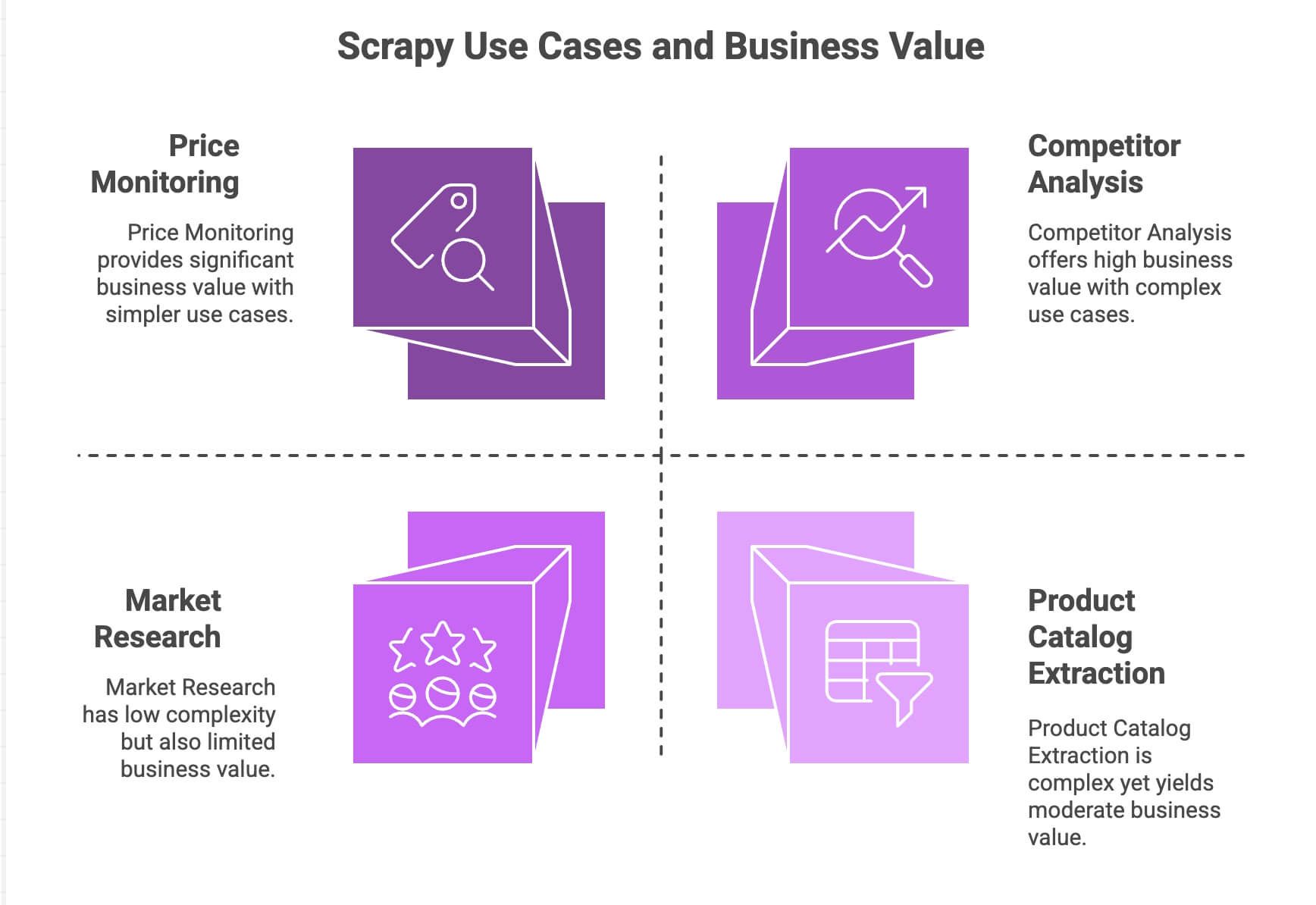

| Caso d'Uso | Punti di Forza di Scrapy | Valore per il Business |

|---|---|---|

| Monitoraggio Prezzi | Gestisce paginazione, richieste asincrone, scheduling | Rimani competitivo, prezzi dinamici |

| Estrazione Cataloghi Prodotti | Segue link, estrae dati strutturati | Crea database prodotti, alimenta analytics |

| Analisi Competitor | Scalabile, resistente ai cambiamenti dei siti | Monitora trend, nuovi lanci, disponibilità |

| Ricerche di Mercato | Pipeline modulari per pulizia/trasformazione dati | Aggrega recensioni, analizza sentiment |

Il motore asincrono di Scrapy (basato su Twisted) permette di scaricare tante pagine in parallelo, rendendolo veloce e scalabile. Il suo design modulare ti consente di aggiungere logiche personalizzate (come proxy, user-agent o step di pulizia dati). E grazie alle pipeline, puoi processare, validare ed esportare i dati come vuoi—CSV, JSON, database, ecc.

Se mastichi Python, Scrapy è davvero una bomba. Ma, diciamocelo, non è proprio “plug and play” per chi lavora in azienda e non programma.

Come Preparare l’Ambiente Scrapy Python

Pronto a metterti all’opera? Ecco come partire da zero con Scrapy:

1. Installa Scrapy

Assicurati di avere Python 3.9+ installato. Poi, apri il terminale e digita:

1pip install scrapyControlla che sia tutto ok con:

1scrapy versionSe usi Windows o Anaconda, ti consiglio di creare un ambiente virtuale per evitare casini. Scrapy gira su Windows, macOS e Linux.

2. Crea un Nuovo Progetto Scrapy

Avviamo un nuovo progetto chiamato amazonscraper:

1scrapy startproject amazonscraperTi ritroverai con una struttura di cartelle tipo questa:

1amazonscraper/

2├── scrapy.cfg

3├── amazonscraper/

4│ ├── __init__.py

5│ ├── items.py

6│ ├── pipelines.py

7│ ├── middlewares.py

8│ ├── settings.py

9│ └── spiders/A cosa servono questi file?

scrapy.cfg: Configurazione del progetto (di solito non si tocca)items.py: Qui definisci i modelli dati (es. Prodotto con nome, prezzo, ecc.)pipelines.py: Qui pulisci, validi ed esporti i datimiddlewares.py: Per funzioni avanzate (proxy, header personalizzati)settings.py: Modifica il comportamento di Scrapy (concorrenza, ritardi, ecc.)spiders/: Dove scrivi la logica di scraping vera e propria

Se già ti senti un po’ spaesato, sappi che è normale. Qui molti non-sviluppatori iniziano a sudare freddo.

Creare uno Scraper Python: Estrazione Dati Prodotti Amazon con Scrapy

Vediamo un esempio concreto: estrarre dati di prodotto dai risultati di ricerca Amazon. (Nota: i termini di servizio di Amazon vietano lo scraping e hanno sistemi anti-bot molto aggressivi. Questo esempio è solo a scopo didattico!)

1. Crea uno Spider

Nella cartella spiders/, crea un file chiamato amazon_spider.py:

1import scrapy

2class AmazonSpider(scrapy.Spider):

3 name = "amazon_example"

4 allowed_domains = ["amazon.com"]

5 start_urls = ["https://www.amazon.com/s?k=smartphones"]

6 def parse(self, response):

7 products = response.xpath("//div[@data-component-type='s-search-result']")

8 for product in products:

9 yield {

10 'name': product.xpath(".//span[@class='a-size-medium a-color-base a-text-normal']/text()").get(),

11 'price': product.xpath(".//span[@class='a-price-whole']/text()").get(),

12 'rating': product.xpath(".//span[@aria-label]/text()").get()

13 }

14 next_page = response.xpath("//li[@class='a-last']/a/@href").get()

15 if next_page:

16 yield scrapy.Request(url=response.urljoin(next_page), callback=self.parse)Cosa succede qui?

- Si parte da una pagina di ricerca Amazon per “smartphones”.

- Per ogni prodotto, si estraggono nome, prezzo e valutazione tramite selettori XPath.

- Si cerca il link alla “pagina successiva” e si dice a Scrapy di seguirlo per continuare la raccolta.

2. Avvia lo Spider

Dalla root del progetto, esegui:

1scrapy crawl amazon_example -o products.jsonEt voilà—Scrapy esplorerà i risultati, seguirà la paginazione e salverà i dati in un file JSON.

Gestire Paginazione e Contenuti Dinamici

Il supporto nativo di Scrapy per seguire link e gestire la paginazione è uno dei suoi punti forti. Ma che succede con i contenuti dinamici—quelli caricati via JavaScript? Di default, Scrapy vede solo l’HTML statico. Se devi estrarre dati caricati dinamicamente (come infinite scroll o recensioni in pop-up), dovrai integrare strumenti come Selenium o Splash. Ma questa è un’altra storia.

Pulizia ed Esportazione Dati con Scrapy Python

Dopo aver raccolto i dati, probabilmente vorrai pulirli ed esportarli dove ti servono.

- Pipeline: In

pipelines.pypuoi scrivere classi Python per pulire, validare o arricchire i dati (es. convertire prezzi in numeri, eliminare righe incomplete o chiamare API di traduzione). - Esportazione: Scrapy esporta direttamente in CSV, JSON o XML con il flag

-o. Per esportazioni più avanzate (come su Google Sheets), serve codice aggiuntivo o librerie esterne.

Vuoi fare analisi del sentiment o tradurre descrizioni? Dovrai integrare API o librerie Python esterne—non è previsto di default.

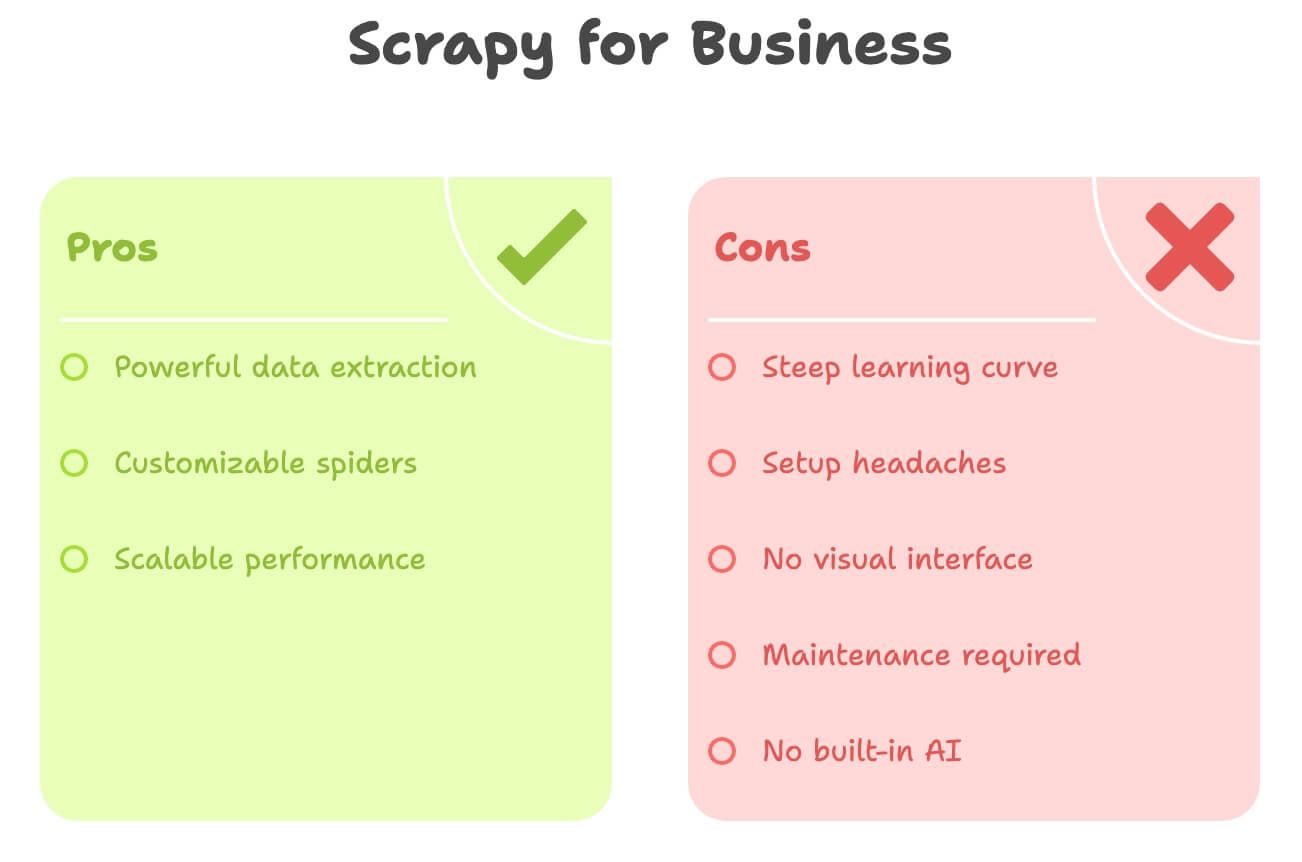

I Costi Nascosti: Le Difficoltà di Scrapy Python per Utenti Business

Diciamolo chiaro: Scrapy è potente, ma non è pensato per chi non sviluppa. Ecco dove la maggior parte degli utenti business si blocca:

- Curva di apprendimento ripida: Devi conoscere Python, HTML, selettori XPath/CSS e la struttura dei progetti Scrapy. Servono giorni o settimane per prenderci la mano.

- Setup complicato: Installare Python, gestire dipendenze e risolvere errori può essere frustrante—soprattutto su Windows.

- Nessuna interfaccia visuale: Tutto si fa via codice. Non puoi semplicemente “cliccare” per selezionare i dati.

- Manutenzione: Se il sito cambia, lo spider si rompe. Tocca a te sistemarlo.

- Nessuna AI integrata: Vuoi tradurre, riassumere o analizzare sentiment? Devi scrivere altro codice.

Ecco un confronto veloce:

| Sfida | Scrapy (Python) | Esigenze Utente Business |

|---|---|---|

| Richiesta Programmazione | Sì | Preferibilmente no code |

| Tempo di Setup | Ore (o giorni) | Minuti |

| Manutenzione | Continua (cambi sito) | Minima |

| Esportazione Dati | CSV/JSON (integrazione manuale) | Diretto su Excel/Sheets/Notion |

| Funzionalità AI | Nessuna (integrazione manuale) | Traduzione/sentiment integrati |

Se sei un marketer, commerciale o lavori nelle operations, Scrapy può sembrare come usare un bazooka per gonfiare un palloncino.

Scopri Thunderbit: L’Alternativa No-Code a Scrapy Python

Ed è qui che entra in gioco . Dopo anni a sviluppare strumenti di automazione, posso dirlo: la maggior parte degli utenti business non vuole programmare—vuole solo i dati, subito.

Thunderbit è un Estrattore Web AI disponibile come estensione Chrome. Pensato per chi non ha competenze tecniche e desidera:

- Estrarre dati da qualsiasi sito in pochi clic

- Descrivere ciò che vuole in linguaggio naturale (“Nome Prodotto, Prezzo, Valutazione”)

- Gestire paginazione e sottopagine in automatico

- Esportare direttamente su Excel, Google Sheets, Airtable o Notion

- Tradurre, riassumere o analizzare sentiment in tempo reale

Niente Python. Niente selettori. Niente manutenzione.

Thunderbit è pensato per chi vuole velocità e lasciare all’AI il lavoro pesante.

Thunderbit vs. Scrapy Python: Confronto Diretto

Mettiamoli a confronto:

| Aspetto | Scrapy (Python) | Thunderbit (AI Tool) |

|---|---|---|

| Competenze Richieste | Python, HTML, selettori | Nessuna—punta e clicca, linguaggio naturale |

| Tempo di Setup | Ore (installazione, codice, debug) | Minuti (installa estensione, accedi) |

| Strutturazione Dati | Manuale (definisci items, pipeline) | L’AI rileva colonne e suggerisce campi |

| Paginazione/Sottopagine | Serve codice | 1 clic (gestito dall’AI) |

| Traduzione | Codice personalizzato o API | Integrata—basta attivare “Traduci” |

| Analisi Sentiment | Libreria/API esterna | Integrata—aggiungi colonna “Sentiment” |

| Esportazione | CSV/JSON (import manuale) | 1 clic su Excel, Google Sheets, Airtable, Notion |

| Manutenzione | Manuale (aggiorna codice se cambia il sito) | L’AI si adatta automaticamente ai piccoli cambi |

| Scalabilità | Ideale per progetti grandi e continui | Ideale per task rapidi, scala media (centinaia/migliaia di righe) |

| Costo | Gratis (ma richiede tempo/risorse sviluppatore) | Piano gratuito + abbonamenti (da 9$/mese, ma risparmi tempo e stress) |

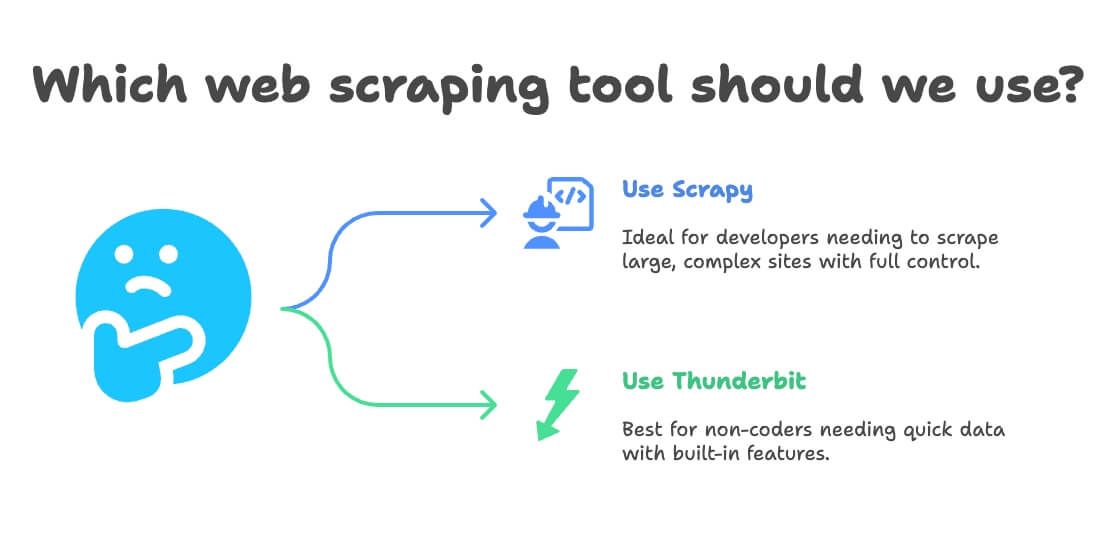

Quando Scegliere Scrapy Python o Thunderbit per il Web Scraping

Ecco la mia regola pratica:

- Scegli Scrapy se:

- Sei uno sviluppatore o ne hai uno in team

- Devi estrarre decine di migliaia di pagine o costruire pipeline personalizzate e continue

- Il sito è molto complesso o richiede logiche avanzate

- Vuoi pieno controllo (e non ti spaventa la manutenzione)

- Scegli Thunderbit se:

- Non programmi (o non vuoi farlo)

- Ti serve il dato subito, per task una tantum o ricorrenti

- Vuoi traduzione, sentiment o arricchimento dati integrati

- Preferisci velocità e flessibilità alla personalizzazione estrema

Ecco uno schema decisionale semplice:

- Sai programmare in Python?

- Sì → Scrapy o Thunderbit (per task rapidi)

- No → Thunderbit

- Il tuo progetto è enorme e continuativo?

- Sì → Scrapy

- No → Thunderbit

- Ti serve traduzione o analisi sentiment?

- Sì → Thunderbit

- No → Entrambi vanno bene

Step-by-Step: Estrarre Dati Prodotti Amazon con Thunderbit (Zero Codice)

Rifacciamo l’esempio Amazon—stavolta in modo semplice.

1. Installa Thunderbit

- Registrati (c’è un piano gratuito)

2. Vai su Amazon e Cerca il Prodotto

- Apri e cerca “laptops” (o qualsiasi prodotto)

3. Avvia Thunderbit sulla Pagina

- Clicca sull’icona Thunderbit nel browser

- Si apre il pannello laterale che riconosce la pagina Amazon

4. Usa AI Suggerisci Campi

- Clicca su “AI Suggerisci Campi”

- L’AI di Thunderbit analizza la pagina e propone colonne come “Nome Prodotto”, “Prezzo”, “Valutazione”, “Numero Recensioni”

- Aggiungi o togli colonne come preferisci (vuoi “URL Prodotto” o “Prime”? Basta scriverlo)

5. Attiva Paginazione e Sottopagine

- Attiva Paginazione: Thunderbit cliccherà su “Avanti” e raccoglierà tutte le pagine

- Attiva Sottopagine: Thunderbit visiterà ogni pagina prodotto per estrarre info aggiuntive (come descrizioni o codici ASIN)

6. Avvia l’Estrazione

- Clicca su Estrai

- Guarda Thunderbit raccogliere dati in tempo reale, pagina dopo pagina

7. Traduci e Analizza Sentiment (Opzionale)

- Vuoi tradurre le descrizioni? Attiva “Traduci” per quella colonna

- Vuoi analizzare il sentiment delle recensioni? Aggiungi la colonna “Sentiment”—l’AI di Thunderbit la compilerà

8. Esporta i Dati

- Clicca su Esporta

- Scegli Excel, Google Sheets, Airtable o Notion

- I tuoi dati sono subito pronti—niente import manuale, niente CSV da sistemare

9. Pianifica Estrazioni Ricorrenti (Opzionale)

- Imposta una pianificazione (es. ogni giorno alle 8)

- Thunderbit eseguirà l’estrazione in automatico e aggiornerà la destinazione scelta

Tutto qui. Niente codice, niente selettori, niente manutenzione. Solo dati pronti per il business.

Consigli Extra: Come Ottenere il Massimo dai Tuoi Progetti di Web Scraping

Che tu usi Scrapy, Thunderbit o altri strumenti, ecco qualche dritta che ho imparato sul campo:

- Valida i Dati: Controlla sempre valori mancanti o strani (es. prezzi a 0$ o nomi vuoti)

- Rispetta le Regole: Consulta i termini d’uso del sito, rispetta il

robots.txte non sovraccaricare i server - Automatizza con Intelligenza: Usa la pianificazione per dati sempre aggiornati, ma non esagerare con la frequenza

- Sfrutta gli Strumenti Gratuiti: Thunderbit include estrattori email, telefono e immagini—ottimi per lead generation o content curation

- Organizza per l’Analisi: Esporta direttamente su Sheets/Excel per filtrare, fare pivot e visualizzare rapidamente

Per altri consigli, dai un’occhiata al o alla loro .

Per altri suggerimenti, visita il o la loro .

Conclusione: Web Scraping Semplificato—Scegli lo Strumento Giusto per il Tuo Team

In sintesi: Scrapy è una potenza per sviluppatori, ma è eccessivo per la maggior parte degli utenti business. Se ti trovi a tuo agio con Python e vuoi costruire uno scraper su misura e su larga scala, Scrapy è la scelta giusta. Ma se vuoi velocità, niente codice e dati pronti (con traduzione e sentiment integrati), è la soluzione ideale.

Ho visto con i miei occhi quanto tempo e frustrazione Thunderbit fa risparmiare ai team non tecnici. Puoi passare da “mi servirebbero questi dati” a “sono già nel mio foglio” in pochi minuti, non ore o giorni. E con funzioni come AI Suggerisci Campi, scraping sottopagine ed esportazione con un clic, trasformare il web in business intelligence non è mai stato così facile.

Quindi, la prossima volta che devi estrarre dati prodotto, monitorare prezzi o creare una lista lead, chiediti: vuoi scrivere codice Python o vuoi risultati? Prova il piano gratuito di Thunderbit e scopri quanto può essere semplice il web scraping.

Vuoi approfondire? Visita il , o scopri le best practice di web scraping sul .

Per saperne di più:

Nota: Assicurati sempre che le tue attività di web scraping rispettino i termini d’uso dei siti e le leggi locali. In caso di dubbi, consulta un legale—meglio evitare lettere di diffida per un foglio Excel!

Scritto da Shuai Guan, Co-founder & CEO di Thunderbit. Ho anni di esperienza in SaaS, automazione e AI—così non devi farlo tu.